I. Introducción

La idea de investigar diferentes facetas de la evaluación no es nueva. Desde el mismo comienzo de la estructuración de la evaluación como una disciplina y como profesión, a comienzos de la segunda mitad del siglo XX, se percibió la necesidad de contestar, mediante estudios sistemáticos y preferentemente empíricos, diferentes preguntas sobre evaluación que permanecían sin respuesta. Muchos investigadores están de acuerdo en la necesidad de la investigación sobre las relaciones entre la teoría y la práctica evaluativa (Worthen,1990; Shadish, Cook y Leviton, 1991; Smith, 1993; Pophan, 2014; Stiggings, 2014). Los beneficios del estudio empírico de la práctica evaluativa diaria son muchos y, entre ellos, cabe destacar la generación de la información necesaria para refinar la práctica evaluativa y desarrollar enfoques alternativos de evaluación (Smith, 1993), así como el avance de las concepciones sobre la conexión entre la teoría y la práctica evaluativa y el incremento de la comprensión de la influencia del contexto en la práctica de la evaluación.

Existen estudios centrados en la relación entre ciertos aspectos teóricos específicos y la práctica evaluativa. Se han considerado facetas tales como el examen y la valoración por los evaluadores de su propia práctica (Willians, 1988), las prácticas evaluativas del gobierno federal de los Estados Unidos (Wholey et al., 1970) y el uso de la evaluación (Alkin, Daillak y White, 1979), siendo esta última faceta la estudiada con más frecuencia (Shadish, Cook y Leviton, 1991; Smith, 1993).

Tras la llamada de Shadish, Cook y Leviton (1991), Smith et al. (1993) y Alkin (2004), en pro del conocimiento empírico sobre la práctica evaluativa para su perfeccionamiento y como factor esencial para el desarrollo de teorías relevantes y útiles, sigue hoy siendo importante objeto de atención para muchos investigadores.

Una primera clasificación o taxonomía de las facetas evaluativas objeto de las preguntas del cuestionario propuesto, y que ayudaría a clarificarlas, deriva de la consideración de los componentes lógicos de los modelos sistémicos de evaluación, como el Modelo de Calidad Educativa (De la Orden, 1997; De la Orden et al., 2002, y De la Orden, 2009) o el Modelo Contexto, Insumo, Proceso y Producto (CIPP, por sus siglas en inglés) (Stufflebean, 1982), esto es, las cuatro amplias categorías de contexto (circunstancias en que la evaluación tiene lugar), entradas (recursos humanos, económicos y materiales asignados a la evaluación), procesos (procedimientos empleados en la planificación, realización, diseminación y uso de los resultados de la evaluación) y productos (resultados de la evaluación en términos de información, juicios de valor y consecuencias de la propia evaluación; es decir, las decisiones sobre el objeto evaluado), dentro de las cuales caben todas las posibles facetas evaluativas susceptibles de ser objeto de investigación.

En este estudio, sin embargo, estamos interesados en lo que denominamos tipos de evaluación, o formas diferentes de evaluar asociadas a las grandes sub-funciones en que se manifiesta la función general de la evaluación, es decir, la optimización del objeto evaluado; en nuestro caso, el rendimiento académico de los estudiantes universitarios, valorado por los docentes en términos del aprendizaje logrado (conocimientos, habilidades, actitudes, o integradamente en las competencias) como efecto de la intervención educativa. De hecho, la evaluación cumple, como manifestación diferencial de su función básica, diversas funciones específicas (sub-funciones en el contexto educativo). Así podemos hablar en educación de evaluación diagnóstica, evaluación pronóstica, evaluación de acreditación, de certificación de calidad de un producto, de rendición de cuentas, etc.

En general, se distinguen -según la función específica dominante- dos grandes categorías de uso que se han utilizando tradicionalmente, o tipos de evaluación que se conocen como evaluación sumativa y evaluación formativa (Scriven, 1967; Bloom 1971; Stufflebeam, 1971); sin embargo, recientemente se ha acuñado el término assessment for learning o evaluación para el aprendizaje (Stiggings, 2014) para hablar de la intención de la evaluación de involucrar a los estudiantes en la misma y como mecanismo de autorregulación.

Los factores determinantes de la diferenciación son, por una parte, la modalidad de las decisiones a que dan lugar, es decir, el uso que se pretende hacer de la evaluación en cada caso y, por otra, el componente sistémico en que se centra la evaluación (contexto, entrada, proceso o producto) que, a su vez, determina el momento de su aplicación en el continuo de la intervención educativa.

Las decisiones que definen la evaluación sumativa apuntan a la selección, clasificación, promoción de los alumnos y a la certificación de sus logros de aprendizaje. Este tipo de evaluación, que tiene generalmente carácter final, se centra básicamente en los resultados inmediatos, productos mediatos e impacto de la acción educativa.

Según los evaluadores de tendencia formativa, las decisiones específicas propias de este tipo de evaluación educativa apuntan directamente al incremento de la aproximación de la acción del profesor (enseñanza) de los logros de los alumnos (aprendizaje), lo que podría traducirse en un mayor logro académico, más altos estándares y un conocimiento más profundo. Este tipo de evaluación se centra más en el contexto, las entradas y en especial en el proceso de la enseñanza y el aprendizaje. En contraste con la evaluación sumativa, de carácter generalmente final, la evaluación formativa se aplica en los distintos estadios del proceso de enseñanza-aprendizaje y adopta formas muy diversas. El uso adecuado de sus resultados, a través de un feedback inmediato, directo y permanente, se convertiría en el mejor instrumento para asegurar la coherencia entre objetivos, proceso y producto de la enseñanza y el aprendizaje y, en consecuencia, para su optimización y calidad.

Por su parte, la evaluación para el aprendizaje, además de considerar los aspectos de una evaluación formativa, pone de relieve el papel activo del alumno durante todo el continuo para el logro de sus procesos autorregulativos tanto individualmente como con sus pares (Pophan, 2014; Stiggings, 2014)

Además de las decisiones, usos, componentes evaluativos en que se centran y el momento de su aplicación en el continuo educativo, citados como los principales factores que determinan la diferenciación de los tipos de evaluación, existen situaciones, procedimientos y otros elementos de la conducta evaluativa de profesores y alumnos asociados también a la diferenciación de los modos de evaluar, que resultó necesario conocer para elaborar las preguntas del cuestionario y analizar las respuestas de los profesores de modo que permitieran contestar satisfactoriamente a las cuestiones que plantea la investigación e interpretarlas correctamente como indicadores fundamentales de los distintos tipos de evaluación.

Para caracterizar más ajustadamente los tipos de evaluación, podríamos transformar los dos tipos generales evaluación sumativa y evaluación formativa, en que se manifiesta la función evaluativa general, en los siguientes cuatro tipos:

1. Evaluación sumativa total, caracterizada por:

Certificación de los aprendizajes logrados por los estudiantes y procedencia de su promoción de nivel.

Centrada en el producto final.

Evaluación terminal.

Uso de instrumentos de máxima objetividad.

2. Evaluación sumativa parcial, caracterizada por:

La evaluación del logro educativo final como integración de logros parciales y procedencia de su promoción de nivel.

Evaluación en períodos establecidos y terminal.

Uso de instrumentos objetivos, exámenes escritos y orales, para la prueba final y las parciales, y análisis de productos.

3. Evaluación Formativa, caracterizada por:

Certificación de aprendizajes y perfeccionamiento de procesos.

Evaluación continua.

Uso de instrumentos diversos: observación directa, análisis de productos, rúbricas, escalas, listas de cotejo, pautas evaluativas y preguntas orales, portafolios.

4. Evaluación para el aprendizaje, caracterizada por:

Integración de enseñanza, aprendizaje y evaluación.

Implicación de los alumnos en su propio progreso.

Feedback inmediato y permanente.

Apoyándose permanentemente en las respuestas de los alumnos, se va ajustando continuamente la instrucción.

Implica regularmente a los alumnos en autoevaluación y coevaluación, manteniendo estándares constantes, de modo que puedan seguir su propio crecimiento a lo largo del tiempo y sentirse responsables de su propio éxito.

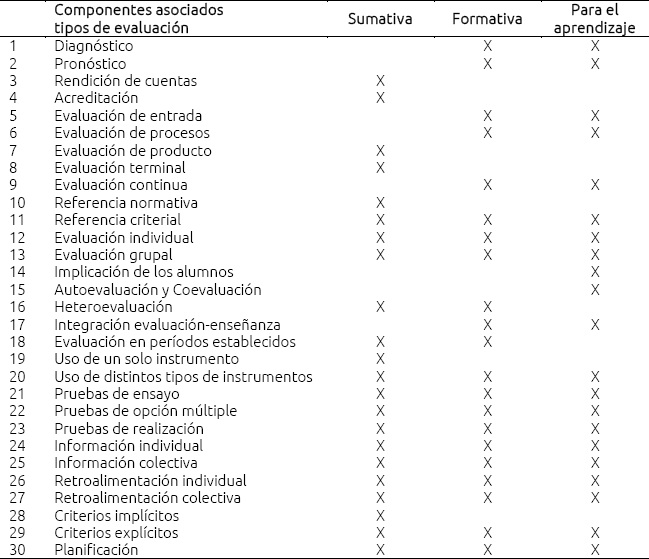

La tabla de especificaciones sobre modos y tipos de evaluación (Tabla I) sintetiza y representa el dominio del cuestionario, es decir, los contenidos de referencia utilizados para elaborar las preguntas y recolectar la información prevista en el plan de investigación y como criterio que utilizaron los expertos para valorar las preguntas en la validación de contenido del instrumento. La tabla también sirvió como base del modelo teórico con el cual se contrasta el modelo de la estructura interna del cuestionario resultante del análisis factorial confirmatorio de los resultados de la aplicación piloto.

II. Metodología

Se utilizó la encuesta como método general, mediante la aplicación de un cuestionario rigurosamente elaborado (del que daremos cuenta posteriormente), a una muestra de docentes de las disciplinas y universidades previamente seleccionadas. En principio, se invitó a responder al cuestionario vía internet a todos los profesores universitarios de México y Centroamérica cuyo correo electrónico conocíamos por haber estado involucrados en procesos comunes de capacitación. La respuesta fue masiva, 900 profesores remitieron el cuestionario cumplimentado; sin embargo, las singulares características del muestreo nos impiden utilizar los datos para responder a nuestras preguntas con el rigor y objetividad necesarios. Es evidente, también, que estos datos son suficientemente válidos como excepcional ensayo piloto y, por consiguiente, utilizables como base para la validación del instrumento mediante el cálculo de algunos índices importantes de confiabilidad y validez.

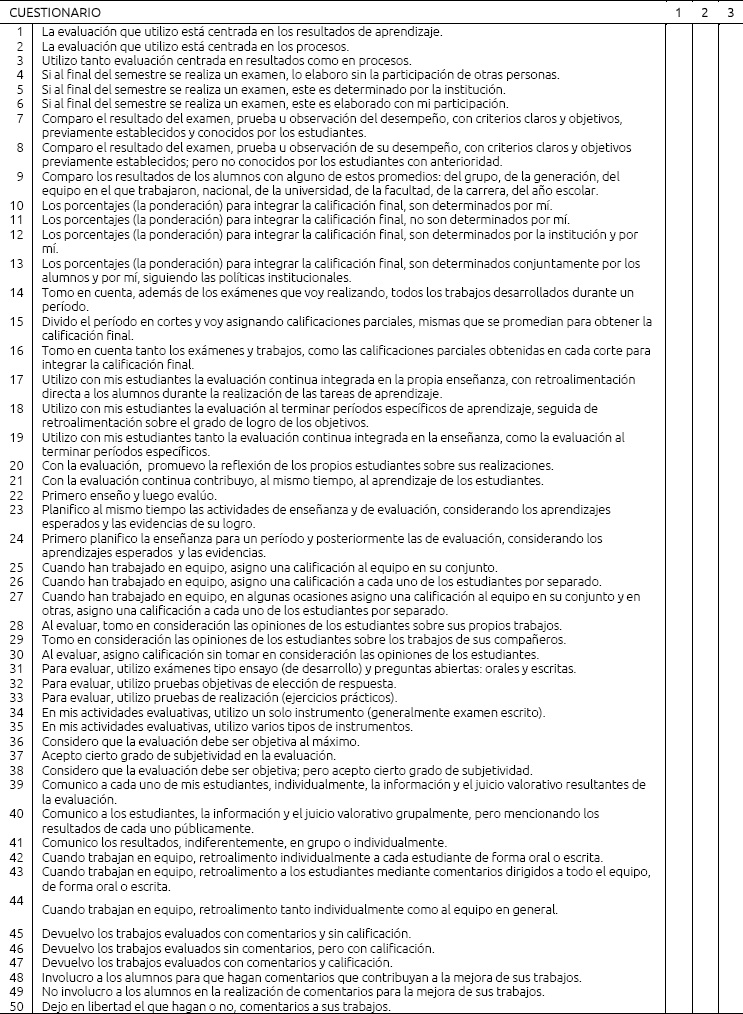

Para determinar la validez de contenido del cuestionario se recurrió al juicio de expertos. En este caso, fueron seleccionados 10 profesores universitarios con formación teórica y experiencia en evaluación del rendimiento académico de los estudiantes en instituciones de educación superior, a quienes se les solicitó valorar las 50 preguntas del instrumento (Tabla II). Para facilitar su tarea y estandarizar sus respuestas, se les remitió la matriz siguiente y las instrucciones.

Las instrucciones a los expertos fueron las siguientes:

Por favor, para cada una de las 50 preguntas del cuestionario, que aparecen en la segunda columna de la matriz, señale Ud. el tipo de evaluación a que se refiere poniendo una X en la casilla correspondiente a la intersección de la fila de la pregunta con la columna que encabeza el tipo de evaluación que Ud. ha elegido como referencia de dicha pregunta.

Solamente podrá elegir un tipo de evaluación como referencia de cada pregunta. Si Ud. opina que podría referirse a más de una, elija aquella en que le parezca más clara o frecuente dicha referencia; es decir, sólo debe clasificarse a cada pregunta en una categoría.

III. Resultados

El análisis de las valoraciones de los expertos se centró en la determinación del acuerdo entre jueces, para lo cual se aplicó el coeficiente alfa de Krippedorff tomando como criterio para mantener las preguntas en el cuestionario un nivel de acuerdo igual o mayor a 0.7. Con este criterio fueron eliminadas las preguntas correspondientes a los números 31, 32, 33, 49 y 50 del instrumento original.

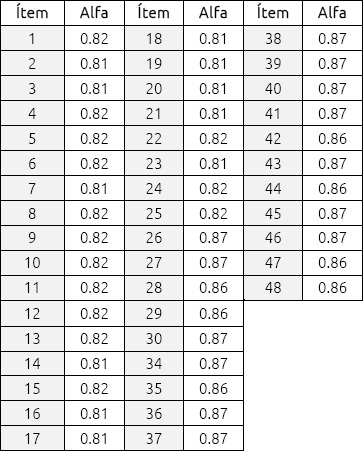

Procedimos a calcular, por un lado, la confiabilidad del instrumento y de cada una de sus preguntas aplicando a los resultados un índice equivalente del alfa para escalas ordinales; y, por otro, acercarnos a la validez de constructo del cuestionario a través de un análisis factorial confirmatorio para contrastar la congruencia de la estructura factorial de los resultados con la explícita en la teoría que sirvió de base a la justificación del instrumento y, por tanto, a la tabla de especificaciones para la elaboración de las preguntas.

El alfa global del cuestionario es aceptable: 0.87 y, como muestra la Tabla II, la confiabilidad de las preguntas varía entre 0.81 y 0.87. Por otra parte, la eliminación de alguna de las preguntas de más baja confiabilidad no se traduce en incremento significativo en la confiablidad general del instrumento.

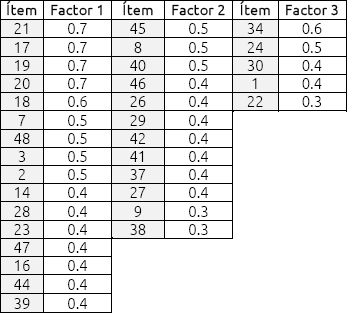

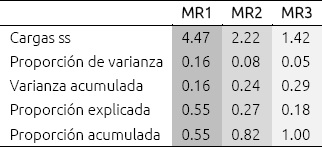

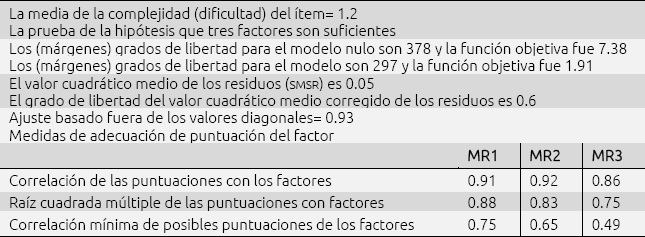

Para el análisis de componentes principales se ha utilizado el software "R" y, como los datos son producto de una medida ordinal, en lugar de aplicar el análisis basado en la correlación producto -momento de Pearson- se recurrió a un equivalente basado en la determinación de una correlación policórica, más coherente con el carácter ordinal de los datos de nuestro cuestionario. El valor de ajuste del modelo, 0.93, resulta aceptable para los propósitos del estudio.

El resultado del análisis tras rotaciones Varimax, Oblimin y Promax, identifican entre dos y tres factores que, en líneas generales, se acercan a la estructura señalada en la teoría en que se basa la construcción del cuestionario.

Se han obtenido similares ajustes para las rotaciones Varimax, Oblimin y Promax, en la Tabla VI se muestran los ajustes con rotación Promax. Del análisis confirmatorio se han obtenido con claridad tres factores (también es posible visualizarlos en la Figura 1): el primero apunta una tendencia hacia una función formativa extrema, lo que se entiende como la aceptación del nuevo movimiento conocido como Evaluación para el Aprendizaje (Assessment for learning). Sin embargo, las puntuaciones también confirman que los dos factores restantes apuntan respectivamente a las tradicionales funciones formativa y sumativa.

La estructura obtenida no se aparta significativamente de la teoría que ha servido de base en la tabla de especificaciones y por consiguiente en la elaboración de las preguntas. Lo que en última instancia supone que no se corre mucho riesgo al afirmar que la estructura factorial derivada del análisis confirmatorio y la estructura factorial explícita en la teoría previa son similares o, al menos, compatibles.

Podríamos afirmar entonces, que el instrumento presenta un nivel aceptable de validez de constructo. Producto de la aplicación del análisis factorial, se eliminan las preguntas que realizan una escasa aportación a la diferenciación de los tipos de evaluación.

IV. Conclusión

En resumen, el estudio sugiere que el cuestionario es una herramienta valida y psicométricamente adecuada para colectar información pertinente de los profesores sobre los modos/tipos de evaluación del rendimiento académico de los estudiantes en las universidades. Se advierte que la evaluación para el aprendizaje y la formativa tienen cuestiones que las diferencia claramente, esencialmente la transmisión de la función de evaluación como una responsabilidad que compartiría el profesor con los estudiantes.

text new page (beta)

text new page (beta)