Introducción

El Sistema Nacional de Investigadores (SNI) constituye uno de los principales pilares de la investigación en México; es un programa institucionalizado, de alcance nacional y de carácter transversal a las instituciones de adscripción de los investigadores que reconoce esta actividad, realizada por académicos mexicanos y extranjeros radicados en México mediante la transferencia condicionada de recursos económicos. El SNI surgió en 1984 con el objetivo de fortalecer la investigación en un contexto donde la expansión no regulada de la educación superior en México, durante las décadas de los 70 y 80, empezaba a mostrar signos de contracción, y donde la demanda gubernamental e institucional de formación superior por medio de la docencia no dejó espacio a la consolidación de las actividades de investigación, teniendo como atenuante los bajos salarios de los académicos en México (Pérez, Grediaga, Gil, Casillas, de Garay y Pizzonia, 1991; Flores, 2009). La creación del SNI representó un giro de fondo en la conducción de la educación superior y de la profesión académica en México, trasladando los incentivos económicos de la carrera académica hacia el individuo y al margen de la dimensión salarial e institucional de los investigadores (Malo, 2005; Gil, 2013: 168; Galaz y Gil, 2009: 5).

En el escenario de surgimiento del SNI, la evaluación académica institucional comenzaba a ser una práctica común en las universidades y en las Instituciones de Educación Superior (IES) en México. Sin embargo, dicha evaluación se realizaba a partir de los gremios locales, que, a juicio de cada comunidad académica e institucional, realizaban la dictaminación de productos y procesos de los académicos. Un aspecto fundamental a destacar de la evaluación académica institucional previa al surgimiento del SNI es que no tenía como propósito subyacente la asignación de recursos económicos en función de la productividad del investigador, sino que el SNI fue el primer sistema de diferenciación salarial de los investigadores en México que tuvo como eje conceptual el reconocimiento de la figura del investigador, bajo una lógica de sistematización y estandarización de productos de investigación en la búsqueda de objetividad en la evaluación (Ibarra, 2000; De Ibarrola, 1994; Aguilar, 1991; Fernández, 1991). Esta práctica se replicó en otros programas de evaluación institucional de las IES y diferentes universidades.

El éxito del SNI puede verse a partir de la evolución del padrón de investigadores beneficiarios: en 1984 se tuvo un registro de 1 396 investigadores, mientras que en abril de 2021 se registraron 35 178, lo que representa un incremento de 25.19 veces el valor inicial (SNI, 2020). Este sistema ha ejercido un tipo de gubernamentalidad específica que le ha permitido legitimarse y consolidarse en la comunidad académica mexicana, entendiendo a la gubernamentalidad como una dirección de conductas y prácticas que estructura el campo de acción de los sujetos, como sintetiza Ibarra (2001: 330-332) desde la perspectiva foucaultiana. La gubernamentalidad que ha ejercido el SNI en 37 años de operación ininterrumpida ha construido una narrativa de investigador de prestigio entre los académicos, quienes voluntariamente han asimilado en sus prácticas de investigación los estándares solicitados para obtener la distinción como investigadores pertenecientes al sistema y la retribución económica que implica a manera de beca y al margen del salario y de las obligaciones fiscales que supone (Flores, 2005). De esta forma, el incremento del padrón del SNI no sólo habla de un éxito administrativo, sino de un éxito discursivo y, principalmente, de una orientación de conductas y prácticas en el quehacer de los académicos y de cambios en la valoración de lo que se considera relevante y significativo sobre la actividad de investigación.

A partir de criterios concretos de evaluación, el SNI ha construido un perfil específico de investigador; son prescripciones que buscan conformar y construir una realidad: la del investigador internacional y de excelencia. El SNI constituye una herramienta performativa en la medida en que “al describir, prescribe” un perfil específico de investigador y de desempeño académico mediante la valoración de prácticas, hábitos y productos de investigación que se reiteran desde diversos ámbitos. El dispositivo de evaluación del SNI establece los criterios deseables u obligatorios que habrán de cumplir los investigadores para ser evaluados positivamente, constituyéndose en un dispositivo que, al cuantificar, clasificar y organizar el rendimiento de los investigadores, performativiza, incluso epistemológicamente, las conductas de los investigadores, quienes de forma voluntaria buscan pertenecer o mantenerse en él (Ramos-Zincke, 2018: 42-44). Así, cabe plantearse: ¿qué perfil de investigador promueve y, en tal sentido, construye el SNI? ¿Cómo ha evolucionado la narrativa del investigador internacional y de prestigio propuesta por el SNI? ¿Desde qué criterios y discursos opera el dispositivo de evaluación del SNI?

El presente artículo tiene como objetivo ofrecer un análisis de la transformación de la lógica de evaluación del SNI en el periodo 1984-2020, mediante el análisis de los cuatro tipos de documentación que lo sustentan y regulan oficialmente: Acuerdos de Creación, Reglamentos, Convocatorias y Criterios Específicos de Evaluación. Se hace énfasis en el análisis de los Criterios Específicos de Evaluación de las áreas IV. Humanidades y Ciencias de la Conducta y V. Ciencias Sociales en el periodo 1999-2020. La información que sustenta el estudio fue obtenida directamente del SNI, tras una solicitud explícita de la documentación oficial relativa a todos los años de operación.

Este texto se estructura de la siguiente forma: en el primer apartado se expone la adopción de un modelo evaluativo específico en el ámbito de la educación superior en Latinoamérica entre la década de los 80 y los 90, a partir del cual se institucionalizaron programas como el SNI. En el segundo se formula un análisis de la transformación de la lógica de evaluación del SNI; se dedica una sección respectiva para los análisis del área IV. Humanidades y Ciencias de la Conducta y del área V. Ciencias Sociales. El tercer apartado articula la evolución discursiva del SNI en las áreas IV y V con un contexto generalizado de performatividad académica orientada hacia el mainstream de la ciencia. Se finaliza el artículo con una serie de planteamientos críticos a modo de conclusión.

De la figura del intelectual hacia el investigador internacional en Latinoamérica y en México

Entre las décadas de los 80 y los 90 del siglo pasado, los países de Latinoamérica emprendieron la construcción de sistemas nacionales de evaluación científica y académica, que en la actualidad se encuentran articulados a una consolidada cultura global de evaluación que tiene como finalidad verificar “el buen funcionamiento” de los procesos. El contexto de evaluación que enfrentan la ciencia y la educación tiene diferentes propósitos (mejorar prácticas estandarizadas por medio de la competencia, la certificación de procesos u otorgamiento de incentivos; búsqueda de transparencia; contar con insumos de información para financiamientos, entre otros) y actúa sobre distintas aristas (estudiantes, instituciones, gobiernos, académicos, políticas públicas), desenvolviéndose en una articulación entre los ámbitos nacionales e internacional (Tiana, 2009: 27-30). El principal efecto de ello es que el dispositivo de evaluación, inicialmente una herramienta de uso exclusivo de gobiernos e investigadores, se convirtió en una herramienta incrustada en el quehacer estructural del sistema educativo y de investigación (DINIECE, 2009: 5).

El surgimiento del paradigma de la evaluación en América Latina obedeció principalmente a tres condiciones: 1) un proceso de desarrollo de la democracia en la región, 2) crisis y déficits fiscales y 3) una necesidad creciente de asignación de recursos públicos a IES. En México, la planeación en educación superior era un hecho desde la década de los 70, ejemplo de ello es la fundación en 1970 del Consejo Nacional de Ciencia y Tecnología (Conacyt). Sin embargo, la coyuntura económica de la década de los 80 llevó a una reorientación de los mecanismos de asignación de recursos tanto para instituciones como para académicos, la cual se haría a partir de entonces mediante una evaluación al desempeño. Fue de esta manera que actores como la Secretaría de Educación Pública (SEP) y la Asociación Nacional de Universidades e Instituciones de Educación Superior (ANUIES), en coordinación con el Conacyt y las IES, configuraron una diversidad de mecanismos de evaluación sobre la base de autoevaluación, planeación estratégica, financiamiento en función de resultados y evaluación a académicos, con un enfoque individualista y cuantitativo (Bensusán y Valenti, 2018: 20-29).

El modelo de dirección de la educación superior y de la investigación que se instauró en los países de Latinoamérica entre la década de los 80 y los 90, en tiempos y dinámicas propias, tiene como peculiaridad que se trata de una regulación estructural, es decir, promovida desde los mecanismos gubernamentales e institucionales, pero centrada en “el académico” como sujeto individual. Esta lógica circular, que opera desde lo estructural y lo individual, buscó incidir en los macro desempeños por país e institución, así como en las microconductas de los investigadores, cuyo desempeño constituye la base de un modelo que ha podido asegurar su funcionamiento incorporando a todos los actores que participan del ámbito académico-científico. En la búsqueda de dotar de inteligibilidad una diversidad de escenarios complejos, se diseñaron mecanismos, herramientas e indicadores que permitieran una estandarización de resultados y metas, así como establecer consensos, mediante la homologación de criterios y objetivos comunes a todas las instancias gubernamentales, universidades, IES y académicos.

El nuevo modelo de regulación de la educación superior y de la investigación introdujo nuevas discursividades sobre el quehacer de académicos e investigadores, quizá la principal de ellas es la evaluación como eje central de la actividad académica y de investigación. En este nuevo modelo de regulación, la evaluación se instauró como herramienta para medir el desempeño (institucional, individual, mensurable, cuantificable) y de esta forma determinar o acreditar la eficiencia y la productividad en un contexto de internacionalización y rendición de cuentas, no en el sentido de transparencia, sino de justificación de gasto (Torres, 2007: 62-63). Aquí, instituciones, gobiernos y académicos dotaron a la evaluación de la facultad de definir tanto el papel como la aportación de estos. Se pasó, entonces, del establecimiento de consensos y homologaciones, a un modelo de prescripción de las prácticas, es decir, un modelo altamente performativo (Ball, 1995: 260-263).

En este contexto se inscribe la creación del SNI en 1984, teniendo entre sus objetivos “fomentar el desarrollo científico y tecnológico del país fortaleciendo la investigación en cualquiera de sus ramas y especialidades, a través, del apoyo a los investigadores [...]” y “estimular la eficiencia y calidad de la investigación”, teniendo entre los criterios fundamentales para la incorporación de los investigadores “la productividad reciente del investigador [...]” (DOF, 1984). La implementación del SNI representó una nueva modalidad del trabajo académico en su carácter de política pública nodal en el desenvolvimiento de la ciencia y la tecnología en México, en la medida en que introdujo transformaciones en la cultura disciplinar y académica de las ciencias sociales (Gil y Contreras, 2017: 17-18).

De forma paralela al escenario planteado, desde el norte global -Europa y Estados Unidos- se configuró una distinción arbitraria entre ciencia periférica y ciencia mainstream, para diferenciar a la ciencia generada en el resto del mundo de aquella generada en este norte global y que circulaba en las revistas del Science Citation Index, creado en la década de los 60 por Eugene Garfield, instrumento central en la justificación de la jerarquización internacional de las revistas científicas hasta la actualidad (Guédon, 2008). A partir de la década de los 80, las agencias de financiamiento y universidades, principalmente en los países de Europa y en Estados Unidos, comenzaron a orientar la evaluación académica con base en el “factor de impacto”, lo que tuvo como consecuencia una jerarquización de instituciones y países en la medida en que el concepto de calidad fue reemplazado por el de excelencia y éste a su vez fue observado (objetivado) a partir de los rankings de revistas. Por su parte, dichos listados fueron construidos con base en dos plataformas: Web of Science y Scopus, mediante las cuales se hizo operativa esta distinción entre ciencia periférica y ciencia mainstream (Guédon, 2019).

Performatividad evaluativa en las Ciencias Sociales y las Humanidades desde el SNI, México

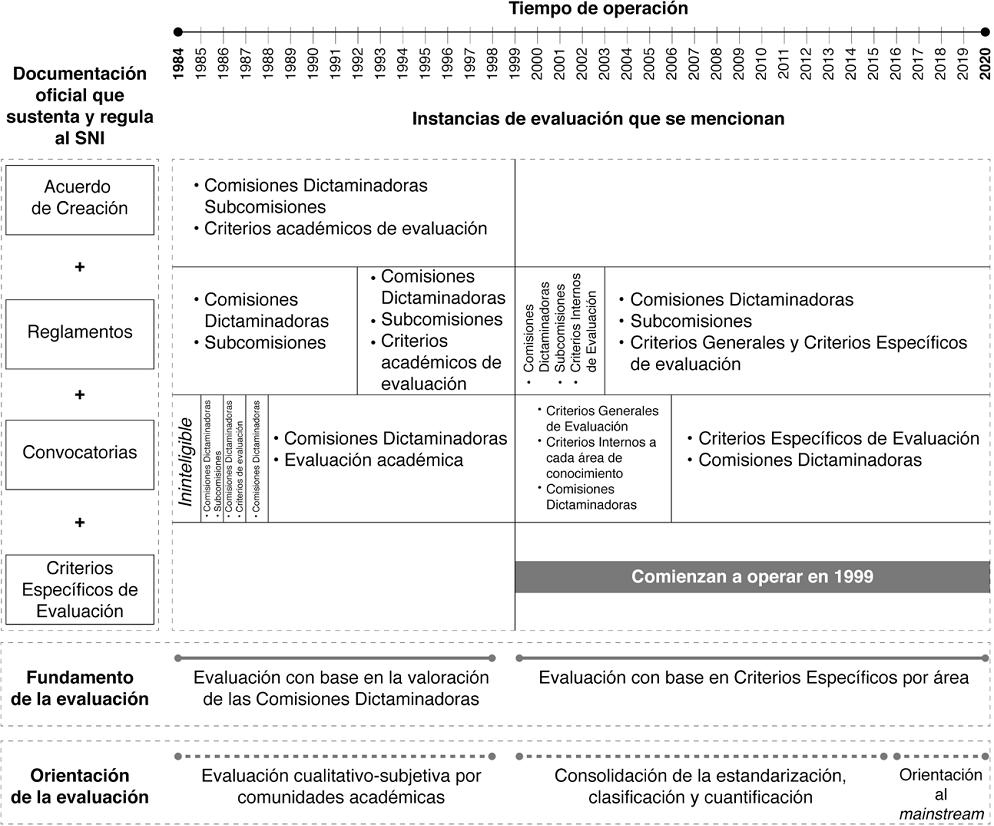

La fundamentación oficial del SNI (legal, administrativa y operativa) se encuentra en cuatro tipos de documentación: 1) Acuerdo de Creación, 2) Reglamentos, 3) Convocatorias y 4) Criterios Específicos de Evaluación. El aspecto relativo a la evaluación es abordado de diferentes formas en cada uno de ellos y se transforma a través de los años de operación del programa. En el periodo 1984-1998, las instancias de evaluación referidas en los documentos son las Comisiones Dictaminadoras y Subcomisiones, cuya tarea de evaluación se planteaba con base en “Criterios académicos de evaluación”, sin referir mecanismos de ponderación o valoración de las trayectorias o productos de investigación, de lo que puede establecerse que hasta 1998 se evaluaba a los investigadores desde una perspectiva cualitativo-subjetiva que tenía como base la valoración por consenso de las comunidades académicas, representadas en las Comisiones Dictaminadoras de cada área.

En 1999, el SNI mostró un conjunto de transformaciones, entre ellas la modificación de las áreas de conocimiento1 y la introducción de una nueva figura: los Criterios Específicos de Evaluación por área (CEE). La inclusión de este nuevo tipo de documentación supuso el establecimiento de criterios de evaluación en lo referente a la tipificación de productos de investigación y la ponderación de su valor en la evaluación de los investigadores por nivel y área. Antes de 1999, la única alusión que se hacía a los productos de investigación era en el artículo 5º del Reglamento, donde se solicitan como requisitos de ingreso al SNI la publicación de trabajos en revistas científicas o la publicación de libros. Es a partir de ese año que la evolución dio un giro hacia criterios establecidos y explícitamente documentados.

Como se representa en la Figura 1, en el periodo 1984-1998, la evaluación tuvo como fundamento la valoración subjetivo-cualitativa de las Comisiones Dictaminadoras, mientras que en el periodo 1999-2020, el fundamento de la evaluación son los CEE. El enfoque del presente análisis se realiza en el segundo periodo referido, en el cual es posible identificar dos fases de evaluación: una en la que se consolida la estandarización, clasificación y cuantificación que supuso la introducción de la figura de los CEE (1999-2015) y una de orientación hacia el mainstream de la ciencia (2016-2020).

Fuente: elaboración propia con base en la documentación oficial del SNI (Acuerdo de Creación, Reglamentos, Convocatorias y Criterios Específicos de Evaluación), 1984-2020.

Figura 1 Orientación de la evaluación del SNI, México

Área IV. Humanidades y Ciencias de la Conducta

En el primer año de estudio, 1999, se señala como imperativo general de la evaluación en el área IV. Humanidades y Ciencias de la Conducta:

Los académicos del Área IV deben mostrar una productividad integral dentro de las actividades que definen el quehacer científico y tecnológico, orientados a la generación, aplicación y transmisión de nuevos conocimientos.

Este precepto de evaluación mantiene su orientación con el paso del tiempo y no es diferente de las otras áreas que lo indican (CEE Área IV, 1999-2020). Se observa, así, una orientación hacia la productividad en los resultados de investigación.

Los elementos centrales en que se sustenta la evaluación del área IV se traducen en productos de investigación específicos, definidos y cuantificados mediante la publicación. Para el caso del periodo 1999-2002, los productos de investigación consideraron formatos tradicionales de algunas disciplinas como libros especializados, capítulos de libro y artículos arbitrados, así como formatos hasta entonces poco frecuentes en esta área de conocimiento como “desarrollos tecnológicos”. A partir de 2003, se observa una paulatina diversificación en el reconocimiento de otros productos de investigación, derivado de las negociaciones al interior de las comunidades académicas: en ese año se reconocieron como válidas las ediciones críticas, reseñas, opúsculos, antologías, compilaciones y traducciones. En 2005 se agregaron las patentes, certificados de invención, certificados de registro de nuevos productos y software registrado con derechos de autor. En 2006 se reconocieron como productos complementarios las traducciones y ediciones críticas de autores clásicos y/o lenguas clásicas, lenguas indígenas de México, muertas o escasamente estudiadas en nuestro país y la coordinación y edición de trabajos colectivos y arbitrados, formatos propios de algunas disciplinas del área que dejaron de considerarse complementarios sólo a partir de 2016. Por su parte, se reconocieron como productos complementarios “Obras de divulgación y guiones museográficos” (CEE área IV, 1999-2020).

A partir de 2018 la definición de productos de investigación del área IV muestra un giro, ya que se reconocieron otros productos como válidos, pero aumentó la restrictividad de sus características. Esto se observa, por ejemplo, en la distinción de varios tipos de libro: especializados, de autor, de coautoría, edición crítica, libro editado o coordinado, libro compilado o antología, entre otros (CEE área IV, 2018-2020). El área IV transitó hacia un reconocimiento mayor de productos de investigación, el cual se hace más complejo a partir de 2018, dado que los criterios requeridos en cada producto se vuelven sumamente específicos y restrictivos para los investigadores que comuniquen sus aportes de investigación en tales formatos. Resaltan, por ejemplo, los requerimientos de los libros publicados en editoriales de la institución de adscripción por su condicionamiento de demostrar un amplio liderazgo de la institución en la disciplina, así como en la exigencia de criterios ecdóticos rigurosos para considerar como válidas las ediciones críticas.

El imperativo de productividad integral exigido a los investigadores del área se traduce en la delimitación de productos de investigación específicos y cuantificables, una definición cambiante con el paso del tiempo que refleja la evolución en la discursividad promovida por el SNI en esta área de conocimiento. En ello hay un mayor reconocimiento de productos de investigación como válidos, pero bajo el establecimiento de características muy específicas que deben cumplir tales productos para ser considerados positivamente: en 1999 los investigadores del área IV podían ser evaluados a partir de 6 tipos de productos de investigación reconocidos, mientras que en 2020 son evaluados a partir de al menos 17, los cuales, en su mayoría, cuentan con características más rigurosas de cumplimiento (Figura 2).

Fuente: elaboración propia a partir de los Criterios Específicos de Evaluación del área IV, 1999-2020. SNI, México.

Figura 2 Marco general de evaluación y productos de investigación por año. Área IV. Humanidades y Ciencias de la Conducta, SNI, México

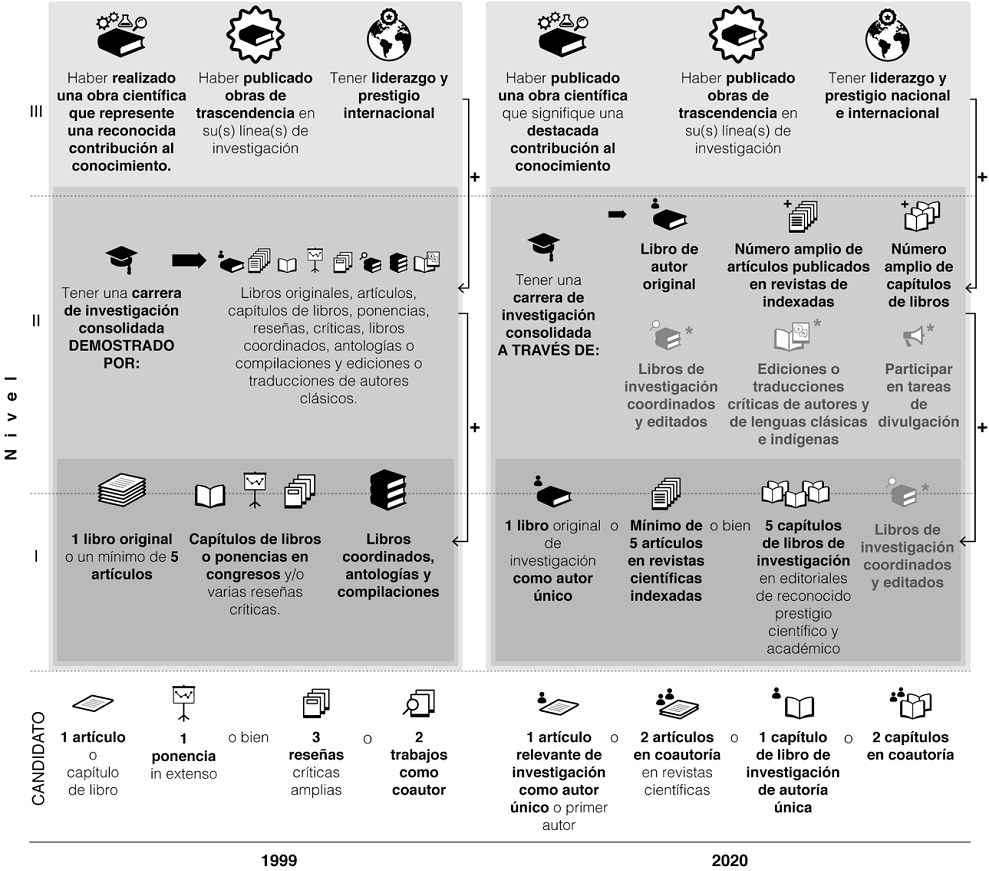

El reconocimiento de productos de investigación válidos ha sufrido cambios significativos, no así los requerimientos cuantitativos de productividad para ingresar al SNI. Para ingresar o reingresar en la categoría “Candidato”, la producción exigida se ha mantenido en torno a un artículo publicado en revista científica, un capítulo de libro o dos o “varios” trabajos como coautor, mientras las ponencias y reseñas críticas dejaron de considerarse criterio de ingreso en 2006. Por su parte, la productividad exigida a los investigadores Nivel 1 ronda en un libro original de investigación (del cual a partir de 2006 se exige autoría única), cuyo valor se equipara al de cinco artículos publicados en revistas científicas como autor único o cinco capítulos de libro como primer autor, con especificaciones propias en cada uno de los años de estudio. Asimismo, la coordinación de libros, antologías y compilaciones comenzó a considerarse complementariamente a partir de 2016. Por su parte, a las actividades de divulgación se les fue restando importancia: a partir de 2006 se consideran deseables y a partir de 2018 dejaron de considerarse entre los requisitos de ingreso.

En el Nivel II, los requisitos de ingreso y reingreso no vigente se adhieren a la cantidad exigida de productos de investigación para el nivel respectivo inferior, además de exigirse una “carrera de investigación consolidada” demostrada por obra publicada que incluya libros originales, capítulos de libro y artículos científicos, entre otros productos; de forma complementaria, se consideran las tareas de coordinación y edición de volúmenes colectivos, exigencia que no se modifica sustancialmente con el tiempo. Por su parte, la exigencia para ingresar al Nivel III es la publicación de obra científica de “reconocida contribución al conocimiento” en su campo; desde 1994, este nivel se evalúa desde categorías como “liderazgo y prestigio nacional e internacional” y “citas de calidad a la obra”, entendida como citas realizadas por autores “reconocidos internacionalmente”. En todos los años, el orden de la autoría es considerado un indicador de liderazgo en la investigación (Figura 3).

Fuente: elaboración propia a partir de los Criterios Específicos de Evaluación del área IV, 1999-2020. SNI, México.

Figura 3 Productividad científica como requisito de ingreso. Área IV. Humanidades y Ciencias de la Conducta, SNI, México

En la evaluación del área IV pueden identificarse tres etapas: la primera de ellas (1984-1998) caracterizada por una evaluación que recaía en la valoración cualitativo-subjetiva de las comunidades académicas representadas por la Comisiones Dictaminadoras, una segunda etapa (1999-2015) distinguida por una consolidación de la estandarización y la cuantificación y una tercera que inició en 2016 que pretende direccionar la actividad de investigación hacia el mainstream de la ciencia, esto es, que se caracteriza en su validación y legitimación a partir de la incorporación de las bases de datos e índices específicos en la evaluación de los investigadores. La Tabla 1 contrasta la forma de ponderación de la calidad e impacto expresada en los CEE y los índices que se consideran en la evaluación.

La evaluación por medio de la publicación en revistas científicas no exigía la presencia de éstas en ningún índice sino hasta 2005; la valoración de su calidad e impacto se definía a partir del prestigio reconocido por los evaluadores y los comentarios recibidos al artículo científico en su dictaminación. Por su parte, los criterios de 2006 introdujeron las categorías de calidad y circulación nacional e internacional de la revista, todavía sin exigirse la presencia de las revistas en índices específicos. Hasta 2015, el arbitraje ocupaba una posición central en la evaluación de la producción científica para la promoción en las categorías y niveles, lo que se modificó a partir de 2016, año en que a la definición de los productos de investigación se incorporó la nota “los evaluadores de cada disciplina podrán privilegiar las revistas que figuran en los distintos índices nacionales e internacionales”, aún sin hacer explícito ningún índice. Fue a partir de 2018 que la indexación se incluyó en los criterios para ponderar la calidad y el impacto y los índices como el Journal Citation Reports (JCR), Scimago, Scopus o Conacyt se incorporaron como criterios de evaluación (CEE área IV, 1999-2020). De forma específica, estos índices se mencionan en los siguientes segmentos de los CEE:

En las Definiciones y Consideraciones del Área IV, tales índices se describen como “particularmente recomendables”:

Los elementos en que se sustenta la evaluación de los aspirantes a ingresar en esta Área son: Haber realizado trabajos de investigación científica o tecnológica original y de calidad en forma de libros y capítulos publicados en editoriales académicas de reconocido prestigio o editoriales institucionales en donde quede claro su arbitraje, de artículos publicados en revistas especializadas que estén indexadas [los índices como JCR, Scimago, Scopus o Conacyt son particularmente recomendables] [...]. (CEE, área IV, 2020)

En los criterios de reingreso vigente para los niveles II y III, los índices se definen como imperativos en la evaluación de los investigadores, de quienes se exige:

Sustentar una sólida productividad científica de alta calidad dentro de su disciplina, mediante la publicación de trabajos de investigación como primer autor o autor de correspondencia o con sus alumnos tesistas en las revistas de mayor impacto en su área e incluidas en SCOPUS, JCR o Conacyt [...]. (CEE área IV, 2020)

Tabla 1 Ponderación de calidad e impacto y evaluación con base en índices. Área IV. Humanidades y Ciencias de la Conducta, SNI, México

Fuente: elaboración propia a partir de los Criterios Específicos de Evaluación del área IV, 1999-2020. SNI, México.

A partir de 2018, la evaluación en el área IV del SNI se encauzó hacia los canales mainstream de comunicación científica y lo hizo mediante una articulación conceptual entre calidad e impacto y circuitos específicos de comunicación científica. Esta articulación se construyó gradualmente: entre 1999 y 2005, la calidad y el impacto de las revistas se definió a partir de su prestigio y de los comentarios dados al artículo en su dictaminación. Entre 2006 y 2015 se ponderó la calidad y el impacto también por la circulación nacional e internacional de las revistas. Los criterios de 2016 y 2017 ya advertían sobre la capacidad de las comisiones para privilegiar las revistas con presencia en los distintos índices nacionales e internacionales, sin definir todavía qué podía entenderse por índice nacional e internacional. Finalmente, los criterios de 2018, 2019 y 2020 asumen explícitamente la indexación como criterio para ponderar la calidad y el impacto de la investigación; así, plantean a JCR, Scimago, Scopus o Conacyt como criterios centrales en la evaluación a los investigadores, lo que los posicionó como indicadores en sí mismos de prestigio, calidad, impacto, arbitraje riguroso y circulación nacional e internacional de las revistas y, en consecuencia, de la producción científica publicada en ellas. Una vez que el SNI consolidó un mecanismo de evaluación por medio de procesos de estandarización, organización, cuantificación y jerarquización de productos, prácticas e incluso investigadores, la evaluación pasó a un proceso orientado a acreditar el conocimiento científico generado en el campo de conocimiento de las humanidades y ciencias de la conducta en tanto sea validado y legitimado por la indexación especializada.

Área V. Ciencias Sociales

En el área V. Ciencias Sociales solamente ha habido un momento de cambio en la definición del marco general de evaluación y reconocimiento de productos de investigación, el cual tuvo lugar en 2017: a partir de ese año, el marco general que orientó la evaluación en el área fue la productividad integral de los investigadores, la cual consideraba actividades de generación, aplicación y transmisión de nuevos conocimientos. A este marco general de evaluación correspondió una serie de productos como artículos de investigación en revistas especializadas, libros y capítulos de libro, así como productos derivados del desarrollo tecnológico como patentes, certificados de registro de productos y de software con derechos de autor. Los criterios de evaluación de 2017 y posteriores mantuvieron como marco general de evaluación la generación, aplicación y transmisión de conocimientos, pero expresados en términos de “investigación básica y aplicada, desarrollo tecnológico, participación en actividades educativas, integración de grupos de investigación y desarrollo de infraestructura” (CEE V, 1999-2018).

La tipología de productos de investigación se mantuvo, siendo el cambio más significativo la introducción de la categoría “prestigio” en la definición de algunos de ellos. Tal es el caso de los artículos de investigación en revistas especializadas, libros y capítulos de libro, los cuales a partir de 2017 se evaluaron también por el prestigio de los comités y casas editoriales responsables de su arbitraje y publicación. Es de resaltar que desde 1999 se toma en cuenta la “calidad nacional e internacional” de las revistas en la evaluación de los artículos científicos, pero no se ofrecen criterios homologados o explícitos mediante los cuales medirla (Figura 4).

Fuente: elaboración propia a partir de los Criterios Específicos de Evaluación del área V, 1999-2020. SNI, México.

Figura 4 Marco general de evaluación y productos de investigación por año. Área V. Ciencias Sociales, SNI, México

En la productividad exigida como requisito de ingreso al SNI en el área V, la autoría única o primera autoría se valora a lo largo de todo el periodo, y los productos requisito se mantienen: un artículo o capítulo de libro o dos trabajos como coautor. Al igual que en el área IV, las ponencias y reseñas críticas dejan de admitirse entre los criterios de ingreso a partir de 2006. En el Nivel I, el valor de los libros originales se equipara al de otros productos editoriales como cinco capítulos de libro, así como al de productos que denotan trabajo académico en proceso de elaboración como los mapas de investigación. A su vez, a partir de 2017 se hace explícito el requerimiento de que los productos deben haber sido sometidos a arbitraje riguroso, lo que denota el peso de la valoración realizada por la comunidad académica en la evaluación del área V. Los requisitos de ingreso en el Nivel III exigen demostrar una reconocida contribución al conocimiento, demostrada a partir de “liderazgo y prestigio internacional” (no se hace mención del ámbito nacional), reconocimientos académicos y citas de calidad a su obra (por autores reconocidos “internacionalmente”). Es importante subrayar que los criterios de ingreso del Nivel III, en lo relativo a productividad científica, no se han modificado en los 22 años de estudio (CEE área V, 1999-2020).

Al igual que en el área IV, la evaluación en ciencias sociales se ha conducido por criterios de homologación de los productos de investigación que, a su vez, se cuantifican para establecer estándares que conducen los procesos de evaluación, como es el caso del ingreso. A diferencia del área IV, el área V no muestra modificaciones constantes en los productos reconocidos como válidos, ni en la cantidad u orientación de la productividad exigida como condición de ingreso o reingreso no vigente. Asimismo, no todos los productos considerados como válidos son requisito obligatorio de ingreso (Figura 5).

Fuente: elaboración propia a partir de los Criterios Específicos de Evaluación del área V, 1999-2020. SNI, México.

Figura 5 Productividad científica como requisito de ingreso. Área V, Ciencias Sociales, SNI, México

Entre 1999 y 2005, la ponderación de la calidad y el impacto consideró el prestigio de la revista y las citas bibliográficas recibidas; no es posible identificar si se trata de citas al artículo o a la revista en general. Con excepción de este periodo, las citas no volvieron a figurar como criterio de evaluación en los años posteriores. En 2006 se añade como criterio de ponderación de calidad e impacto la inclusión de la revista en el padrón de revistas Conacyt, en el caso de las revistas nacionales; no se explican los criterios de ponderación de calidad e impacto para revistas extranjeras. A partir de 2016, la valoración de los artículos científicos considera: “se da preferencia a las revistas indizadas en el caso de las internacionales, y del padrón de Conacyt en el caso de las nacionales” (CEE área V, 1999-2020).

La transformación en la manera de ponderar el impacto y la calidad de los artículos científicos incorporó como herramienta a los índices de revistas. Pero, si en 2006 se anexó este padrón de revistas a los criterios de evaluación del SNI, ¿por qué se sostiene que la tercera fase de la evaluación en el área V, orientada hacia el mainstream, comienza en 2016? La respuesta se encuentra, a su vez, en la transformación de los criterios de evaluación de este rubro de revistas, es decir, las pertenecientes al padrón Conacyt. Hasta 2006, la forma de evaluación a las revistas en el padrón era de tipo cualitativo y consideraba aspectos como el contenido, arbitraje (comité editorial, cartera de árbitros, calidad del arbitraje), edición y distribución (antigüedad, periodicidad, distribución en internet), así como aspectos formales, donde uno de los requisitos era el registro en índices o resúmenes internacionales relevantes en la especialidad de la revista (Conacyt, 2006).

Los criterios de evaluación de las revistas en el padrón Conacyt sufrieron una transformación completa en 2014, momento en que se añadió la opción de “proporcionar información generada por el Journal Citation Report, Google Scholar Metrics, SciELO Citation Index” a la exigencia de “proporcionar un análisis donde conste el número de visitas al sitio y países de origen, número de accesos y descargas a texto completo de los artículos publicados, así como el número de citas por artículo y autor” para que las revistas pudieran acreditar difusión y visibilidad (Conacyt, 2014). Un segundo momento de cambio se dio en 2016, cuando se transformó en Sistema de Clasificación de Revistas Mexicanas de Ciencia y Tecnología (CRMCyT). En esta transformación, bajo la responsabilidad del Grupo Scimago, se establece un sistema de clasificación de las revistas en ocho grupos, en el que los cuatro más altos corresponden a las revistas indexadas por Scopus y por Web of Science (WoS), las cuales se estructuran jerárquicamente según la valoración de cuartil que dichas bases de datos les asignen con base en su Factor de Impacto y Scimago Journal Rank; tal sistema es vigente hasta 2019 (Conacyt, 2016; Conacyt, 2019).

Esta transformación del CRMCyT modificó indirectamente la evaluación en las áreas V y IV, que definieron y caracterizaron el desempeño en investigación de este campo de conocimiento a partir de las métricas y canales de comunicación propios de grupos editoriales externos. Este aspecto ilustra la circularidad de los componentes de evaluación que configuran el dispositivo de evaluación científica en México en la actualidad (Tabla 2).

Tabla 2 Ponderación de calidad e impacto y evaluación con base en índices. Área V. Ciencias Sociales, SNI, México

Fuente: elaboración propia a partir de los Criterios Específicos de Evaluación del área V, de los años 1999-2020. SNI, México.

Mientras que, desde 2016, en el área V se hizo explícita la facultad de las comisiones evaluadoras de privilegiar las revistas que figuran en los distintos índices nacionales e internacionales, fue a partir de 2018 que los índices se consideraron criterio explícito de evaluación del desempeño de los investigadores en ambas áreas de conocimiento. Por su parte, la documentación existente de la forma de evaluación por área de conocimiento no permite identificar la forma en que se hace una diferenciación de los índices según la evaluación por disciplina.

Dispositivos de evaluación en las Ciencias Sociales y las Humanidades: el caso del SNI

Este análisis tiene la intención de recuperar la historicidad del SNI, eje fundamental de impulso a la investigación científica en México. La evolución de los criterios de evaluación de las áreas IV. Humanidades y Ciencias de la Conducta y V. Ciencias Sociales tuvo la finalidad de mostrar la forma en que se construyó el discurso, hoy normalizado, de la investigación de calidad e impacto. La publicación de artículos científicos y su valoración en tanto figuren en los índices del mainstream no siempre fue una práctica “natural”, sino un mecanismo implementado en momentos específicos, bajo criterios particulares, que posteriormente cobraron una legitimidad que los han convertido en regla escrita (por ejemplo, en los aparatos formales de evaluación académica como el SNI y los programas de IES y universidades) y no escrita (estándares deseados de comportamiento y desempeño por los propios investigadores y editores de revistas científicas); uno de los principales cambios de tal gubernamentalidad promovida es la publicación de artículos científicos como principal medio de comunicación, una práctica naturalizada entre las nuevas generaciones de académicos en las ciencias sociales y las humanidades.

La evaluación académica institucional a investigadores constituye un elemento central de un mecanismo más amplio y transversal de evaluación en el ámbito científico y académico, el cual incide también en espacios como las revistas científicas -a partir de los sistemas de indización-, las IES y universidades -a partir de los sistemas de acreditación y rankings para la caracterización y comparación del desempeño institucional. Tales mecanismos operan articulados como sistemas gerenciales regidos por un utilitarismo, principio central en la dirección de la actividad intelectual en la actualidad: ¿escribir para qué? ¿Publicar para qué? La actividad de investigación motivada por fines utilitaristas es, desde hace algunas décadas, el resultado de la implementación de una política pública impulsada por discursos extracientíficos de rendimiento, productividad y competencia que han erigido lo que puede denominarse una “hegemonía de la auditoría” (Guzmán, 2019: 78-84; Basail, 2019: 169-175).

Como se expuso anteriormente, la ponderación de calidad e impacto de la investigación en las áreas IV y V se hace con base en las características formales de los productos de investigación, y, en el caso de los artículos científicos, con base en características ajenas a los trabajos escritos como la indexación de las revistas científicas donde son publicados. La evolución de tales criterios de ponderación se ha orientado hacia una hiperdefinición o hiperespecificación de las características formales de publicación, dejando fuera de consideración los contenidos y la incidencia de la investigación en los contextos sociales, ambientales, políticos o económicos en los cuales fue creada o a los cuales fue dirigida la investigación en cuestión; ignora también las características intrínsecas de generación y comunicación del conocimiento científico. A partir de 2016, la evaluación de las áreas IV y V del SNI tiene como exigencia un tipo específico de productividad orientada al mainstream, donde no se considera la aportación científica por sí misma, sino a partir de su publicación en una revista con presencia en canales específicos de comunicación.

El mainstream de la ciencia se refiere a una orientación de la evaluación y del desempeño académico-científico que se estandarizó y globalizó en el presente siglo y que transformó radicalmente la evaluación de la producción del conocimiento, dado que prioriza el lugar en que se publica sobre la calidad de la publicación; la calidad se define a priori por el “factor de impacto” (JCR-WoS-Clarivate Analytics) en los dos años anteriores o por el Scimago Journal Rank (Scopus-Elsevier) con una ventana de tres años, y se distribuye en cuartiles; las citas consideradas no son las acumuladas sino las recibidas en los dos o tres años anteriores a la publicación (castigando a las ciencias sociales); las citas se restringen a dos bases de datos, que son WoS y Scopus; el sistema es recursivo y circular dado que es definido y determinado por las revistas de dichas bases de datos; implica una subvaloración de la publicación local y en idiomas que no sean el inglés; supone una subvaloración de los ecosistemas editoriales nacionales y de la prensa editorial universitaria; asocia la internacionalización con el Atlántico norte, derivando en una preocupación por “publicar o perecer” en sustitución de la intervención, contribución y diálogo.

Habrá que destacar el reconocimiento exclusivo de las citas en las revistas incluidas en dichas bases, que, por su parte, tienen sesgos conocidos y documentados: de representatividad, disciplinario, idiomático, geográfico, de formato, etc. (Guédon, 2013: 77-82; Beigel, 2013). Este modelo de evaluación distorsionó la actividad científica, afectando significativamente a las ciencias sociales y las humanidades, áreas donde tradicionalmente se publica en formatos diferentes al artículo científico (introducción, método, resultados, discusión) como el libro y el ensayo, además de la subvaloración a la investigación local, práctica predominante en la mayoría de las disciplinas de estas áreas de conocimiento. La evaluación pasó a ser circular y legitimada por los circuitos del mainstream: las revistas se reconocen en tanto estén indexadas y se pondera la calidad según el cuartil de publicación; ejemplo de ello en Latinoamérica son el CRMCyT en México (Conacyt, 2019) y el sistema Publindex en Colombia (COLCIENCIAS, 2020). Por ello, hoy no basta publicar sino que se debe publicar en el mainstream y en los primeros cuartiles, estimulando así el productivismo y alejando la investigación de las necesidades nacionales. La producción científica y de conocimiento se restringe a las publicaciones, invisibilizando los contextos de producción y estableciendo una competencia global medida en número de publicaciones y citas.

Pese a su aceptación global, esta orientación de la evaluación y del desempeño académico representa una paradoja: se tienen documentadas al menos 27 mil universidades en el mundo (Cybermetrics Lab-CSIC, 2020) y éstas producen entre el 73.6 % y el 86.5 % del conocimiento publicado (Bustos-González, 2019: 2-3), pero apenas el 11.6 % (1 492 revistas) de las 12 860 revistas incluidas en WoS son editadas por 387 universidades (Repiso, Orduña-Malea y Aguaded, 2019: 5). Así, la paradoja de este sistema consiste en que se define como global e internacional, pese a la poca inclusión y diversidad de actores representados.

Está documentado que entre 15 % y 20 % de los artículos científicos determinan los niveles de citación y prestigio de una revista (Seglen, 1992). Dicha debilidad metodológica no sería aceptada por una revisión por pares en ningún artículo científico serio, a lo que se añade la falta de reproducibilidad y transparencia del sistema (Villatoro, 2013) y, si se añade el hecho de que al publicar en dichas bases con frecuencia se ceden los derechos patrimoniales de los autores, y si la revista se apega a un modelo de Acceso Abierto Oro, el pago promedio por publicación que se realiza oscila entre 2 500 y 3 000 dólares por APC (pago por publicación o procesamiento, por sus siglas en inglés) y llega, por ejemplo, a más de 11 000 dólares en Nature, ¿por qué, pese a estas debilidades y contradicciones se ha convertido en el sistema que define el desempeño y la contribución de países, universidades, investigadores y revistas? A esta industria de prestigio nos referimos con mainstream.

La orientación del SNI hacia esta fase mainstream se dio también a un nivel técnico-operativo. En 2017, un grupo de investigadores del Centro de Investigaciones y Estudios Superiores en Antropología Social (CIESAS) en México emitió una comunicación formal al SNI donde demandaba enfáticamente el cambio de plataforma de llenado de Currículum Vitae Único (CVU), en tanto que la nueva forma de presentación de la información excluía automáticamente la diversidad de revistas que no estuvieran indexadas por Scopus y Web of Science, invalidando por defecto el trabajo realizado por los investigadores en otras revistas que no pertenecieran a estos catálogos. Asimismo, protestaban contra el nuevo énfasis economicista y tecnocrático en la valoración de las investigaciones, desdibujando la posibilidad de valorar:

los impactos en el desarrollo social y humanista, en la recuperación del patrimonio nacional, en el diseño de programas que ayuden a restablecer el tejido social, en fortalecer las instituciones de bienestar social, en la múltiple construcción de políticas públicas y un largo etcétera. (CIESAS, 2017)

Esta exigencia de cambio tuvo el respaldo de 16 000 investigadores, que representaban 60 % de los investigadores entonces vigentes (Canales, 2018). En otra arista de oposición a la orientación hacia el mainstream, cabe destacar la carta entregada a la titular del Conacyt el 8 de febrero de 2019, en la cual 326 editores de 238 revistas de 93 instituciones nacionales solicitaron una modificación en el proceso de evaluación, entre otras peticiones, en lo referente a: a) apoyos financieros diferenciados, b) un nuevo modelo de evaluación y c) participación incluyente de directores y editores de las revistas nacionales (Pilloni, 2019). A estas tensiones en torno a la gubernamentalidad o performatividad que implican las transformaciones dictadas por este Consejo y el SNI se suma el debate que supone el financiamiento, la vinculación con el Conacyt y la autonomía de organizaciones civiles de corte académico como el Foro Consultivo Científico y Tecnológico (Rosen, 2019; Díaz, 2020). Es importante resaltar también las tensiones derivadas de la desaparición de al menos 65 fideicomisos en torno a actividades de Ciencia y Tecnología articulados con el Consejo (Méndez y Garduño, 2020).

Desde las ciencias sociales y las humanidades en México, se ha señalado la necesidad de sustituir la evaluación estrictamente cuantitativa por una cualitativa y de largo alcance, la preocupación por una evaluación que conduce el desempeño de los investigadores sólo hacia algunos formatos de publicación y en idioma inglés, así como la necesidad de reconocer la diversidad de revistas científicas donde tienen lugar el debate y el intercambio al interior de tales áreas de conocimiento y que, pese a ser reconocidas como revistas de calidad en las comunidades de ciencias sociales y humanidades, no figuran en los padrones de revistas requisitados por el SNI; preocupaciones que

No solamente están distorsionando la percepción del conocimiento sociocientífico por parte de las instancias evaluadoras y de los responsables de las políticas públicas en el campo científico y tecnológico. También están tergiversando la práctica de las ciencias sociales. (COMECSO, 2015)

En torno a este último aspecto gira el presente artículo: la performatividad de los dispositivos de evaluación.

Estos aparatos de evaluación pueden ser conceptualizados a partir de la orientación positiva que propone Foucault acerca del poder, al cual concibe en términos generales desde una cualidad dinámica, constructiva y ejercido mediante la creación de discursos y patrones de conducta que pueden establecerse o no en códigos y reglas formales y escritas. Este abordaje del poder implicó colocar el enfoque de análisis en su funcionamiento y en las tecnologías por las cuales opera (Foucault, 2013a: 892-897). Este autor parte del concepto de dispositivo para explicar el funcionamiento del poder en territorios específicos de saber. Agamben sintetiza este concepto de la siguiente forma:

Está claro que el término, tanto en el uso común como en aquel que propone Foucault, parece remitir a un conjunto de prácticas y mecanismos (invariablemente, discursivos y no discursivos, jurídicos, técnicos y militares) que tienen por objetivo enfrentar una urgencia para obtener un efecto más o menos inmediato. (Agamben, 2011: 254)

Los dispositivos de evaluación académica operan desde una positividad que promueve y orienta el actuar de los académicos en un sistema estratégico de nodos articulados como los aparatos de evaluación a los investigadores (SNI) y los aparatos de evaluación a las revistas científicas (CRMCyT), que a su vez se replican en ámbitos más locales en los programas de evaluación académica a investigadores en otros ámbitos, como sus universidades de adscripción. Pensar a los programas de evaluación como dispositivos brinda la posibilidad de problematizar la orientación hacia el mainstream que ha tenido a lo largo de su historia el discurso de evaluación del SNI y del CRMCyT, partiendo de que

el poder no está, por tanto, al margen del discurso. El poder no es ni fuente ni origen del discurso. El poder es algo que opera a través del discurso, puesto que el discurso mismo es un elemento en un dispositivo estratégico de relaciones de poder. (Foucault, 2013b: 739)

A partir de los conceptos de “calidad” y de “impacto” se ha creado en el ámbito académico-científico un dispositivo de evaluación al desempeño que ha asociado estos conceptos con la presencia de la producción científica en índices del mainstream. Se trata de una lógica que se observa no sólo en aparatos formales de evaluación, sino en una cultura científica que se ha construido en donde instituciones, investigadores y revistas orientan su trabajo y actividad intelectual según los preceptos de comunicación que implica participar en el mainstream: el formato de comunicación, el estilo de exposición, el idioma, la elección de las revistas de publicación, la agenda de investigación y la planificación de su trabajo con base en la temporalidad dictada por el tiempo de arbitraje y publicación, así como de los periodos de evaluación institucional. Mediante la articulación de actos reiterados que parten de convencionalidades oficiales y culturales entre los investigadores como conjunto social, un ethos, se ha construido un sistema de prestigio académico que asume y valora positivamente per se a la producción científica que circula en el mainstream.

En América Latina se ha expuesto la problemática que representa para las ciencias sociales la adopción de políticas de evaluación enfocadas al uso de indicadores que miden la productividad científica mediante la publicación en revistas indexadas en los índices internacionales hegemónicos. Se ha expuesto que tales políticas de evaluación “han contribuido a reforzar un mercado académico y un mercado editorial altamente lucrativo a nivel mundial” y, en última instancia, para las ciencias sociales en Latinoamérica, representan un riesgo en torno a la reflexión sobre la universidad, dada la desvinculación del conocimiento científico y de los contextos en que este conocimiento es generado que implica tal esquema de evaluación (CLACSO, 2015).

Algunas categorías conceptuales tuvieron una concreción en indicadores como lo ejemplifica la codificación de nomenclaturas como “conocimiento científico de calidad” en estándares de publicación, canales de comunicación e indicadores bibliométricos determinados. A su vez, esta estandarización de las características de la publicación permitió una articulación de los ámbitos nacionales con los de otras regiones (las herramientas, acreditaciones, rankings), con lo que se abrió la posibilidad de comparación de desempeños. En lo general, las ciencias exactas y naturales fueron el referente en la implementación de los estándares de producción, circulación y validación del conocimiento científico en las ciencias sociales y las humanidades (Socolovsky, 2019: 11-12; Gil y Contreras, 2017: 17-18), área que a partir de entonces se cifró en términos evaluativos que al organizar, comprehender y representar la realidad, buscaron producirla mediante una labor regulatoria de las conductas de los académicos, ahora bajo parámetros internacionales (Ramos-Zincke, 2018: 46).

Diferentes esfuerzos organizados a una escala global han realizado críticas al paradigma actual de evaluación científica. Entre ellos, el Manifiesto de Leiden sobre Métricas de Investigación, el cual señala el uso “obsesivo” del “factor de impacto” como métrica central en la evaluación de la investigación, tanto por parte de las instituciones como de los investigadores, y propone una evaluación contextualizada, transparencia y el acompañamiento de la evaluación cuantitativa con componentes cualitativos, entre otros (Hicks, Wouters, Waltman, de Rickje y Rafols, 2015). Una segunda iniciativa es la Declaración de San Francisco sobre la Evaluación de la Investigación (DORA), la cual reconoce las limitaciones del “factor de impacto” (distribución sesgada de citas en las revistas, falta de transparencia, etc.) como métrica principal o única en la evaluación científica y hace recomendaciones a agencias de financiamiento, instituciones, sociedades académicas, editoriales, organizaciones que proporcionan métricas e investigadores que redundan en valorar a la investigación por sí misma y no por el espacio donde se publica (ASCB, 2012).

Un esfuerzo más reciente para la reivindicación de la evaluación científica en América Latina es el Foro Latinoamericano sobre Evaluación Científica (FOLEC) organizado por el Consejo Latinoamericano de Ciencias Sociales (CLACSO), que ha convocado a diversos actores gubernamentales (incluido el Conacyt), a grupos de investigación y académicos latinoamericanos que han participado en el debate y desarrollo de propuestas en torno a la política científica latinoamericana desde hace décadas. En el diagnóstico inicial se han reconocido la consolidación institucional y la consagración generalizada de los sistemas de indización del mainstream, en detrimento de una política de evaluación que, en su nivel conceptual, operacional y de aplicación no considere los contextos institucionales de generación y circulación del conocimiento científico, ni tome en cuenta las revistas nacionales (por considerarse “endogámicas”) o con dinámicas regionales o locales de circulación. Un aspecto particular que se ha señalado derivado del FOLEC es la urgencia de hacer uso de criterios de evaluación contextualizados, pluralizar los criterios en orden de reflejar las distintas prácticas académicas y una diversificación de los expertos evaluadores, enfatizando el desarrollo de una ciencia de calidad con pertinencia social (FOLEC-CLACSO, 2020); se trata de una iniciativa prometedora, aunque aún con una propuesta específica de evaluación al quehacer académico.

El viraje conceptual en la evaluación académica que se ha documentado en el presente análisis -objeto de debate entre la comunidad académica de las áreas de ciencias sociales y humanidades- ha tenido diferentes implicaciones y recepción en cada una de las disciplinas científicas, aspecto que cabe ampliar y considerar como línea de investigación para el futuro análisis y prospectiva de esta dimensión del conocimiento. Si bien el presente artículo ha podido identificar el tránsito conceptual de la evolución académica del SNI hacia los canales mainstream de comunicación de la ciencia en dichas áreas de conocimiento, se observa la necesidad de estudiar este viraje desde una perspectiva empírica, por ejemplo, a partir de la identificación de las tendencias de publicación científica de los investigadores beneficiarios del SNI en la corriente principal. Un primer aspecto se asoma del análisis, apenas general, de la producción científica publicada en Scopus: entre 1996 y 2018 la producción científica proveniente de México ha pasado de 8 721 documentos a 50 394, lo que implica un crecimiento de 477.8 % y una sumatoria de 600 339 documentos en total (SJR, 2021), donde el peso porcentual de la producción del área de ciencias sociales y humanidades se ha duplicado: pasó de representar 4.9 % en 1996 a 10.5 % en 2018. Si bien en estas tendencias no puede especificarse la proporción de documentos cuya autoría es de investigadores beneficiarios del SNI, sí se reconoce que este padrón de investigadores hace una aportación mayoritaria, significativa y central al total de la producción científica generada en México. Un acercamiento más amplio al resultado de la performatividad del SNI reflejada en tendencias de producción científica en el mainstream constituye una de las líneas que deben apuntarse para el futuro.

Para realizar un análisis más integral y pertinente de la evolución conceptual de los programas institucionales de evaluación científica como el SNI, es necesario considerar un análisis de carácter sistémico que tome en cuenta no sólo la fundamentación legal, administrativa y conceptual de los programas -como se ha hecho en este artículo-, sino la diversidad de actores que participan del ámbito y, en específico, de la evaluación, como son los integrantes de las Comisiones Evaluadoras y los investigadores quienes constituyen cada una de las áreas en sus diferentes niveles, cuya experiencia puede dar cuenta de los mecanismos de adaptación y negociación que se dan en la evaluación del desempeño académico aparte de los criterios específicos de evaluación por área.

A modo de conclusión: el futuro inmediato de la evaluación científica en el SNI y en América Latina

Desde la gubernamentalidad promovida por el SNI como dispositivo de evaluación académica, cabe preguntar ¿qué puede hacerse, desde esta política pública, para promover un nuevo tipo de performatividad académica orientada a la vinculación de la ciencia con la sociedad y respetando la libertad de investigación? La recuperación de la historicidad del principal mecanismo de evaluación a la ciencia en México ofrece la posibilidad de concebirlo como susceptible a la deconstrucción para orientarlo hacia el objetivo último de la ciencia: su vinculación con las problemáticas de cada contexto social, sin descuidar la investigación básica. El análisis invita a reflexionar y debatir en torno a los efectos de la actual política de evaluación científica promovida por el SNI, en lo relativo a los objetivos últimos a los que se debe la investigación científica y la generación de conocimiento especializado.

Por ello, se puede argumentar que la comunidad académica espera el cambio en los procesos de evaluación prometidos abiertamente por la actual administración del Conacyt (2018-2024) al inicio de su gestión, pero que a cada proceder institucional pareciera alejarse cada vez más de dicha comunidad y del reconocimiento de la forma en que tradicionalmente se genera conocimiento científico en áreas como las ciencias sociales y las humanidades. En función de ello, se esperaría un alejamiento de las prácticas comerciales en la práctica científica, lo que incluye el rescate de la evaluación de revistas de los consultores privados y un esquema de evaluación a investigadores con autonomía en sus parámetros y referentes. Si bien las decisiones tomadas por las autoridades de ciencia y tecnología en México parecen caminar en una dirección contraria al fortalecimiento de la investigación científica autónoma -a pesar del discurso que promueven-, tanto en lo referente a agendas de investigación como de los canales de circulación que se priorizan en la evaluación, se espera una reivindicación institucional en tal sentido. De no hacerlo, continuará la fractura y alejamiento entre la actual gestión del Conacyt y la comunidad académica y científica del país.

En este sentido, llama la atención la reforma de 2021 del aparato normativo del SNI, en específico, el Reglamento y los CEE por área; aparato publicado en el Diario Oficial de la Federación (DOF) el 20 de abril del presente año, fecha posterior a la aceptación del presente escrito, por lo que no pudo ser incluido en el análisis presentado. No obstante, cabe señalar algunos aspectos trascendentes de la nueva normatividad del SNI. En primer lugar, se apunta la sorpresiva derogación de los artículos 37, 38 y 39, donde se especifican los productos científicos a partir de los cuales se evaluaba el ingreso, permanencia o promoción de los investigadores beneficiarios del SNI. Asimismo, ha sido tema de debate la vinculación de la investigación promovida desde el SNI a objetivos gubernamentales que suponga una pérdida de autonomía científica (Toche, 2021; Salazar, 2021). En lo relativo a las modificaciones de 2021 de los CEE, cabe resaltar la reorganización de las áreas de conocimiento, siendo que el campo de ciencias sociales y humanidades ahora se organiza en tres áreas: área IV. Ciencias de la Conducta y la Educación, área V. Humanidades y área VI. Ciencias Sociales. En específico, en el área de ciencias sociales se modificaron aspectos sustanciales a la tradición del área como la priorización, en lo sucesivo, de la investigación, desarrollo tecnológico o innovación, mediante la autoría única en detrimento de un igual reconocimiento de los productos que reflejan el trabajo colaborativo a partir de la coautoría (CEE área VI, 2021); así, se subestima el valor del trabajo colectivo, una característica central de la forma en que se trabaja en el ámbito académico en la actualidad, siendo que, en principio, no puede darse innovación sin inserción en redes sociocientíficas nacionales e internacionales. De igual forma, se destaca la preferencia que se da a productos válidos como artículos publicados en revistas incluidas en índices internacionales reconocidos -formen parte o no de empresas extranjeras-, así como en revistas del padrón o en revistas de “alto impacto” para los niveles II y III; de lo que deriva la interrogante de qué puede considerarse un “índice internacional reconocido” o una revista “de alto impacto”. ¿Cuál es el imaginario en torno a estos referentes de evaluación? De igual forma, enfatizamos la consideración de las citas a la producción científica con base en plataformas como Scopus, Web of Science, ResearchGate, Academia.edu, ORCID y Google Académico (CEE área VI, 2021). Hablamos, por lo tanto, de algunos criterios de evaluación que cuestionan seriamente el reconocimiento de la tradición de las ciencias sociales, y representan una ruptura de la forma en que se investiga y se genera conocimiento científico en el área.

Una característica de los CEE en su última versión y de todas las áreas de conocimiento es el imperativo sobre la promoción de acceso universal al conocimiento y sus beneficios sociales mediante su difusión en plataformas o revistas. Esto representa una clara contradicción tanto conceptual como fáctica: ¿de qué forma se puede garantizar dicho acceso universal paralelamente a la promoción de la publicación en revistas científicas indexadas en canales mainstream, las cuales se caracterizan por ser, en su mayoría, revistas de suscripción, con altos costos y que generalmente exigen la cesión de los derechos patrimoniales para la publicación?

La adhesión de los diversos actores de ciencia y tecnología a iniciativas que buscan una redirección de los esquemas de evaluación académica han tomado especial fuerza en los últimos años, como es el caso de la adhesión de Conacyt a FOLEC o la firma de 17 511 investigadores y 2 232 organizaciones a la Declaración de San Francisco sobre la Evaluación de la Investigación-DORA (DORA, 2021). Incluso algunos de los principales editores comerciales como Elsevier (Plume, 2020), Springer Nature (s.f.) y Taylor & Francis (2021) se han adherido a la Declaración DORA, lo que es una contradicción de fondo. Finalmente, podemos cuestionarnos cómo combatir un modelo de evaluación académica en el que estos grupos editoriales tienen una posición central. Pese a los esfuerzos por construir modelos distintos de evaluación, la orientación al mainstream se ha afianzado como en el caso mexicano. Así, es posible plantear que, el ámbito académico (incluido el latinoamericano), es decir, instituciones, financiadores, editores, sistemas de evaluación e investigadores, no ha logrado vislumbrar la pérdida de autonomía que supone dicho sistema de evaluación y la tercerización implícita de esta tarea a los canales mainstream y, con ello, a los principales grupos editoriales privados. Se han reconocido los límites y menoscabos a la actividad académica e intelectual en las ciencias sociales bajo el esquema imperante, pero se ha optado por no modificarlo estructuralmente ni a nivel micro. Es difícil augurar un buen futuro para las ciencias sociales y el acceso universal al conocimiento (Acceso y Ciencia Abierta) sin una modificación a los actuales esquemas de evaluación.

text new page (beta)

text new page (beta)