Introducción

La trombosis es un problema mundial de salud pública. Tan sólo en México hay entre 400,000 y 500,000 casos de trombosis por año. La Enfermedad Tromboembólica Venosa (ETEV) constituye una de las mayores causas de morbilidad-mortalidad en el país (Secretaría de Salud, 2010). Debido a la importancia que reviste la trombosis, se han realizado diversos estudios respecto al riesgo de su padecimiento en general (Simioni et al., 2002), (Laporte et al., 2008), (Severinsen et al., 2009), (De Haan et al., 2012), su padecimiento durante el embarazo (Liu et al., 2009) y postparto (Heit et al., 2005), así como su reincidencia (Eichinger et al., 2010), (Vázquez et al., 2013), por mencionar algunos estudios. Dentro de las metodologías más empleadas para diagnosticar esta enfermedad se encuentra el análisis de supervivencia con estimación de Kaplan-Meier y regresión de Cox (Prandoni et al., 2007), (Eichinger et al., 2010), (Simioni et al., 2002), (Laporte et al., 2008), (Severinsen et al., 2009), (Heit et al., 2005), el modelo de regresión logística (Liu et al., 2009), (De Haan et al., 2012), (Laporte et al., 2008) y los modelos lineales generalizados (Heit et al., 2005).

El diagnóstico de la trombosis, como el de otras enfermedades, se puede tratar como un problema de clasificación binaria y, en este contexto, existen diferentes métodos estadísticos para resolver el problema, como son el método de discriminantes de Fisher (1936), el método del k-ésimo vecino más cercano de Fix et al. (1951), el método de la máquina de vector soporte propuesto por Cortés et al. (1995) y por Cristianini et al. (2000) y la regresión logística, Hosmer et al. (2000) y Escabias et al. (2007), así como el cociente de verosimilitud para el caso normal Zadora (2009).

Uno de los principales problemas en el diagnóstico clínico es clasificar correctamente a los pacientes susceptibles de padecer una enfermedad. Los profesionales de la salud requieren herramientas de diagnóstico confiable, herramientas que reduzcan el riesgo de tener falsos negativos o falsos positivos. En este sentido, el presente trabajo presenta un análisis comparativo de dos métodos de clasificación para diagnosticar a pacientes en riesgo de sufrir una trombosis. Las funciones clasificadoras se estimaron utilizando una base de datos de pacientes del Instituto Nacional de Perinatología Isidro Espinoza Reyes con Síndrome de Anticuerpos Antifosfolípido (SAAF) y pacientes con trombosis sin SAAF, característica que identifica a las personas que han sufrido trombosis.

La base de datos con la que se trabajó contiene 25 variables explicativas, que tenía datos faltantes, por lo que fue necesario realizar rutinas de imputación y selección de variables. Se hizo la comparación de dos métodos de clasificación, una basada en regresión logística y la otra en el cociente de verosimilitud para diagnosticar a los pacientes en riesgo de trombosis. Los resultados muestran que la clasificación basada en el cociente de verosimilitud clasificó mejor a los pacientes en la muestra que el método de regresión logística.

Desarrollo y métodos

La trombosis es una enfermedad de difícil diagnóstico. En virtud de ello, nos hemos dado a la tarea de desarrollar un sistema de clasificación que coadyuve a los diagnósticos realizados por los médicos. Para ello, supóngase que la población objetivo está particionada en dos conjuntos no vacíos y complementarios E y Ē; E es el conjunto de individuos que tienen alto riesgo de padecer trombosis y Ē los individuos que tienen bajo riesgo de padecerla. Se puede pensar que una serie de variables susceptibles a ser medidas en los individuos son: el nivel de colesterol, presión sanguínea, etcétera, nos pueden dar información de su estatus de riesgo. En este sentido, es razonable pensar que existe una función de las variables observadas (vector x) que nos indica la probabilidad de que el individuo pertenezca al conjunto de alto riesgo E o al de bajo riesgo Ē; a esta función se le denominará función clasificadora y nuestro interés es tener una estimación de ella. Con esta función estimada se obtienen dos conjuntos AE y AĒ = AE y AĒ = ĀE. Si el vector x está en AE al paciente se le clasifica en E, esto es, en alto riesgo de sufrir la trombosis, y si se encuentra en AĒ, al paciente se le clasifica en bajo riesgo de sufrir trombosis.

Al realizar la clasificación se observan cuatro posibles escenarios:

Que a un sujeto se le clasifique como elemento de E y realmente resida en E, lo cual es correcto. Esto ocurre con probabilidad P(AE | E).

Que a un sujeto se le clasifique como elemento de Ē y realmente se ubique en Ē, lo cual también es correcto. Esto ocurre con probabilidad P(AĒ | Ē) .

Que a un sujeto se le clasifique como elemento de E y realmente esté en Ē, lo cual no es correcto; esto lo escribiremos como P(AĒ | E) y lo llamaremos error tipo I.

Que a un sujeto se le clasifique como elemento de Ē y realmente se encuentre en E, lo cual tampoco es correcto. A este error lo llamaremos error tipo II y lo escribiremos como P(AĒ | Ē).

La efectividad de un método se mide por la frecuencia de las buenas decisiones.

Clasificación mediante regresión logística

Sea Yi la variable aleatoria definida como

Entonces Yi es una variable aleatoria binomial, por lo que

De esta manera, la probabilidad de que el individuo 𝑖 esté en riesgo de padecer una trombosis se estima con la ecuación

Para clasificar a los pacientes se define el conjunto AE = {x|̂p(x) > λ}, con el criterio de clasificación siguiente: si los datos del paciente se encuentran en AE al individuo se le diagnostica en riesgo, y si los datos del individuo se encuentran en ĀE = AĒ al individuo se le clasifica en no riesgo.

Para un valor específico de λ se tiene que los datos de la base satisfacen las relaciones K1 = # AĒ ∩ E y Ko = # AĒ ∩ Ē.

El valor de λ puede moverse; cuando λ disminuye, se reduce el valor de k1 y aumenta el valor de no - ko, si λ aumenta ocurre lo contrario. Las probabilidades de cometer una mala clasificación se estiman como

Para los efectos de este trabajo, se fijó el valor de λ en el punto donde se minimizó la suma

Clasificación mediante el cociente de verosimilitud

Podría considerarse más grave clasificar mal a una persona que está en riesgo de padecer la enfermedad, porque no se le daría tratamiento preventivo y entonces sería deseable tener menor probabilidad de cometer este error, por lo que sería conveniente controlar la probabilidad de cometerlo en un nivel que llamaremos α, es decir

Teorema. El conjunto

tal que

Esto significa que si se elige como criterio de clasificación la relación

Estimación del clasificador por cociente de verosimilitud usando una base de datos

Se parte de una base de datos donde las variables explicativas son categóricas y se identifican los individuos que han padecido la enfermedad, así como los que no la han padecido. Consideramos que si un individuo ya presentó la enfermedad es un individuo de alto riesgo. El conjunto E se forma por todos los individuos de la base, quienes ya padecieron la enfermedad mientras que el conjunto Ē se forma por los individuos de la base que no la han padecido. Es importante señalar que alguno de los individuos que pertenecen a Ē en realidad podrían estar en riesgo de sufrir trombosis, solo que no han manifestado la enfermedad y se desconoce quiénes son; mientras que con los individuos que pertenecen a E se tiene certeza de que son de alto riesgo.

En una base de datos se desconoce la función de distribución conjunta de los vectores xi, por lo que para obtener este clasificador se estiman las probabilidades de los vectores xi con la frecuencia relativa usando los datos de la base y se obtienen los cocientes.

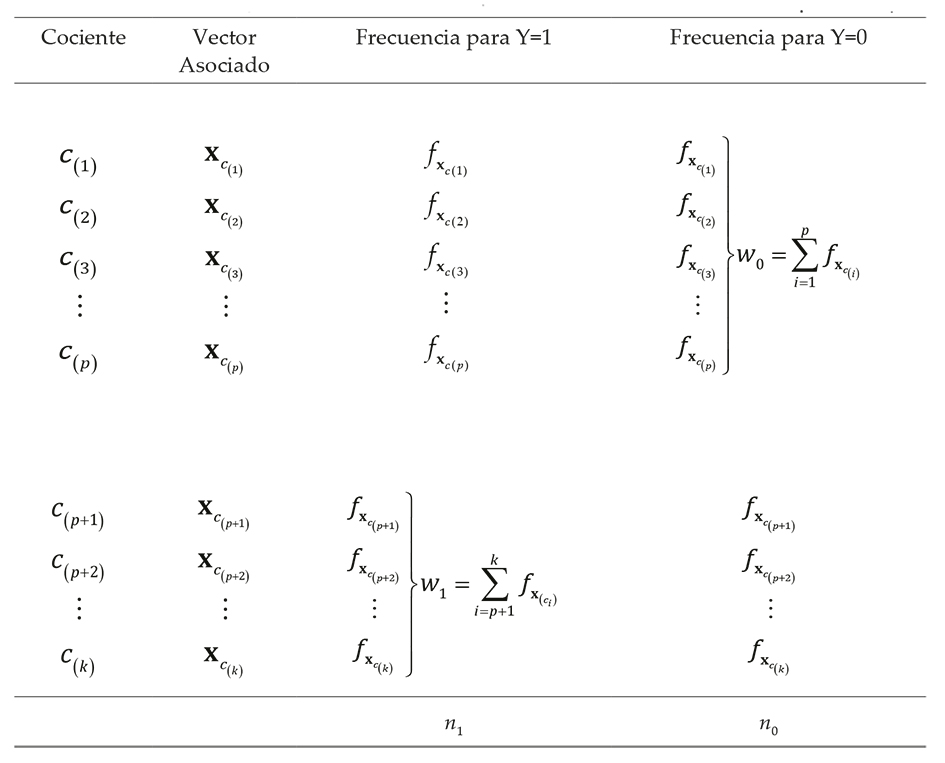

Estos cocientes se ordenan de menor a mayor y se escoge un número 𝜆 para establecer la región crítica fijando un porcentaje de malas clasificaciones. En la Tabla 1, en la primera columna se encuentran los valores del cociente ci en orden creciente, en la segunda columna se encuentra el vector xi correspondiente al cociente, en la tercera fila se encuentra,

Tabla 1 Los cocientes de probabilidades condicionales de los vectores x en orden creciente junto con las frecuencias correspondientes tanto para los individuos que han sufrido de trombosis, como para los que no lo han sufrido

De esta manera, la probabilidad estimada para clasificar mal a un individuo que se encuentra en riesgo de sufrir trombosis se estima como

Mientras que la probabilidad de clasificar mal a un individuo de no riesgo, se estima como

En este trabajo se propone seleccionar el valor de λ, con el cual la suma de las probabilidades estimadas de cometer los dos errores

Finalmente, el conjunto {xc(i) | ci < λ|} define el conjunto de pacientes que se diagnosticarán como de riesgo. El proceso de clasificación identifica un punto crítico λ, que determina un conjunto de vectores asociados a un alto riesgo de padecer la enfermedad, a este conjunto lo denotamos como R, y a su complemento denotado como NR.

Dado que R y NR no necesariamente cubren todos los posibles vectores x, puede ocurrir que se presente un paciente con un vector x asociado, el cual no esté ni en R ni en NR. En estos casos, la solución que se propone es eliminar la variable menos significativa del vector x respecto al criterio de selección a través de la devianza, concepto que se explicará a continuación, para posteriormente repetir el procedimiento de clasificación. Al quitar una variable se busca reducir el número de posibles combinaciones de las variables explicativas y con ello reducir los casos en los cuales el vector asociado a un individuo no aparezca en la base de datos. Sin embargo, si la base es suficientemente grande, se tendrán muchas posibilidades de que contenga a todos los vectores factibles de ocurrir.

Selección de variables para los métodos de clasificación

La base de datos con la que se trabajó tenía 25 variables explicativas y la primera tarea fue depurarla para que solo quedaran las variables significativas para la variable de interés o variable respuesta; además que con menos variables se logra una reducción en el trabajo computacional y, por ende, en el tiempo de ejecución, asimismo una mejor interpretación de los resultados.

Se siguieron dos procesos para excluir variables. El primero y más sencillo fue excluir las variables que tenían más de 50% de datos faltantes. El segundo proceso fue excluir las variables usando la devianza en los modelos de regresión logística anidados con una variable adicional (Dobson, 2002). En este caso, el planteamiento de la prueba fue

La hipótesis nula significa que la variable Xr+1 no es significativa en el modelo y la hipótesis alternativa significa que sí lo es. La estadística de prueba es la diferencia de las devianzas ΔD = Dr - Dr+1, que se espera sea pequeña cuando H0 es cierta y se espera que sea grande si H0 es falsa. Entonces la regla de decisión de esta prueba es:

Proceso de imputación

Debido a que la base de datos con la que se trabajó tenía datos faltantes se procedió a realizar un proceso de imputación y por cuestiones de simplicidad se eligió imputación simple a través de regresión lineal.

Resultados

Para aplicar los métodos de clasificación, la base de datos se partió en dos conjuntos, uno con 90% de las observaciones, denominado conjunto de entrenamiento para estimar la función clasificadora y otro denominado conjunto de prueba formado por 10% restante para evaluar los métodos de clasificación.

Con el conjunto de entrenamiento se obtienen los dos clasificadores, el clasificador por regresión logística y el clasificador por cociente de verosimilitud. Luego, estos clasificadores se aplican a los elementos del conjunto de prueba y se obtiene el valor predicho Ypredi , así se calcula el porcentaje de los elementos mal clasificados usando la fórmula

donde Ypredii es el estatus real del individuo i y Ypredi es el estatus asignado al mismo individuo por el clasificador.

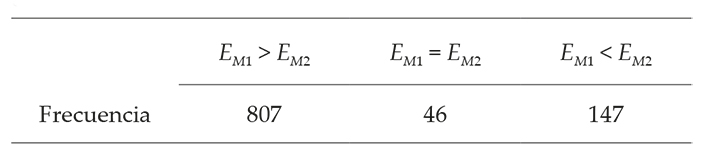

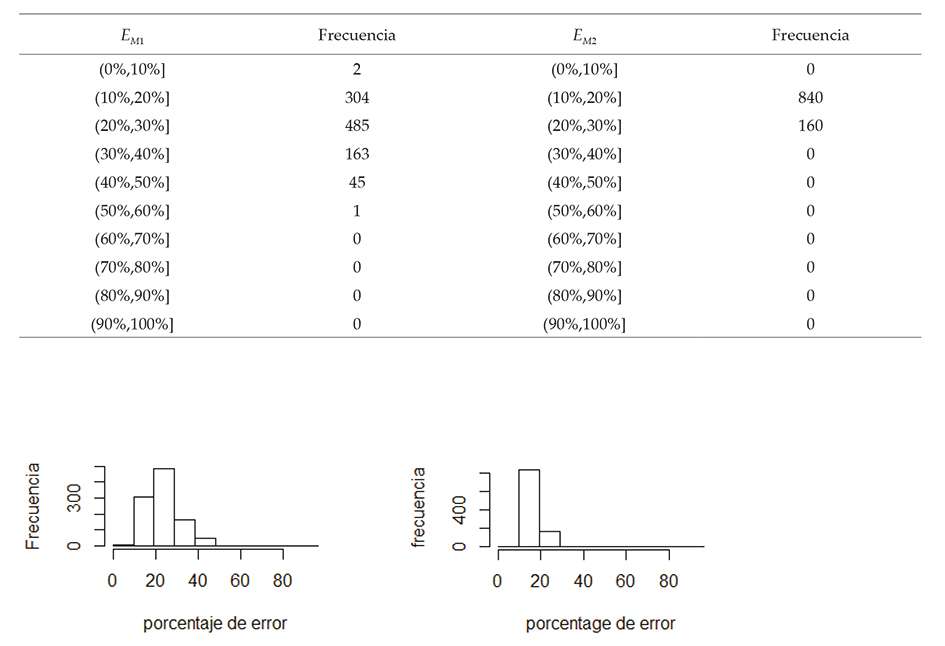

Para estabilizar la estimación del porcentaje de error, se repite mil veces el proceso de clasificación y evaluación procurando que en todos los casos el porcentaje de pacientes en riesgo y en no riesgo en los conjuntos de entrenamiento y de prueba permanezcan de manera semejante a la base de datos. Los resultados obtenidos se resumen en la Tabla 2, donde EMi denota el error del método de clasificación con el método i. Si i = 1 el error corresponde al clasificador por regresión logística; y si i = 2 y el error corresponde al clasificador por el cociente de verosimilitud.

En la Figura 1 se muestra la distribución empírica de los errores en las mil repeticiones para los dos métodos de clasificación en el conjunto de prueba. La frecuencia corresponde al número de veces en que de las mil corridas la proporción de errores estuvo dentro del correspondiente intervalo de clase. Esto es, la frecuencia en [0%,10%] indica la cantidad de ocasiones en que el número de errores estuvo entre 0 y 10%.

Conclusiones

Del análisis de los datos, se concluye que:

El clasificador por cociente de verosimilitud dio mejores resultados. Este clasificador puede programarse fácilmente, sin embargo, requiere almacenar en memoria todos los vectores del conjunto 𝑅, ya que el clasificador no se obtiene por una fórmula. De esta manera, mientras más niveles tenga cada variable, el número de posibles combinaciones (vectores x) aumentará, y en consecuencia, el almacenaje requerido será mayor.

Para la aplicación del clasificador de máxima verosimilitud a los valores de cada variable se les dividió en dos clases, el punto de corte de las dos categorías se proporcionó por el personal de la Coordinación de Hematología Perinatal del Instituto Nacional de Perinatología Isidro Espinoza Reyes; se emplearon solo dos categorías en cada variable para que el conjunto crítico ocupara menos espacio en memoria. Aun así, el clasificador por cociente de verosimilitud resultó, en promedio, ser mejor que el clasificador por regresión logística, lo que hace pensar que con una clasificación de los valores de las variables más fina, se obtendrían mejores resultados.

text new page (beta)

text new page (beta)