Introducción

La implementación de la Inteligencia Artificial (IA) en la educación latinoamericana ha generado un debate ético centrado en cinco dimensiones. Una es la integridad académica, estudios como los de Castillo Herrera (2023), Estrada-Araoz et al. (2024) y González González & González (2024), destacan riesgos como el plagio y la pérdida de originalidad, agravados por la dificultad de detectar respuestas generadas por IA. En cuanto a las relaciones pedagógicas, mientras algunos advierten que la IA podría debilitar la interacción personal, por otro lado, Alfaro Salas y Díaz Porras (2024), señalan su potencial para liberar tiempo y ofrecer apoyo individualizado. La responsabilidad profesional exige que los educadores adquieran competencias en el uso ético de la IA, con una mayoría de profesionales abogando por formación especializada (Juca-Maldonado, 2023; Mora Naranjo et al., 2023). En cuanto a la privacidad y equidad, es crucial proteger los datos y garantizar transparencia algorítmica para evitar sesgos y desigualdades. Finalmente, la falta de políticas institucionales claras, como señala Tobar Litardo et al. (2023), dificulta la integración responsable de la IA, evidenciando la necesidad de directrices sólidas.

Consideraciones éticas en el uso de la Inteligencia Artificial (IA) en educación

El uso de la IA en el ámbito educativo ha adquirido una relevancia sin precedentes en los últimos años, no solo por su potencial para transformar y enriquecer los procesos de aprendizaje, sino también por las complejas implicaciones éticas que conlleva su implementación. Entre estas, una de las más discutidas es la protección de la privacidad de los datos de los estudiantes, un aspecto crítico que requiere atención inmediata y soluciones integrales.

De acuerdo con Alali y Wardat (2024), es fundamental fomentar una colaboración multidisciplinaria entre educadores, tecnólogos y responsables de políticas públicas para garantizar que la integración de la IA en la educación esté alineada con estándares éticos rigurosos y con los objetivos pedagógicos a largo plazo. Esta colaboración debe centrarse en el diseño de marcos regulatorios que protejan los derechos de los estudiantes, aseguren la transparencia en el uso de algoritmos y promuevan la equidad en el acceso a estas tecnologías.

Jobin et al. (2019) destacan que, si bien existen numerosas directrices éticas sobre el uso de la IA, persisten debates significativos acerca de su impacto real en estudiantes, docentes y el sistema educativo en su conjunto. Estos debates subrayan la necesidad de ir más allá de las recomendaciones generales y trabajar en el desarrollo de políticas concretas y consensuadas que aborden las preocupaciones éticas de manera robusta y sistemática. Esto incluye, por ejemplo, la creación de protocolos claros para la recopilación y el uso de datos, la prevención de sesgos algorítmicos y la garantía de que la IA no exacerbe las desigualdades existentes en el acceso a la educación.

El desarrollo de la IA en educación tiene un impacto aún por determinarse en la integridad académica. Existe una preocupación creciente por cómo las tecnologías de IA pueden malinterpretarse y ser mal utilizadas, afectando la calidad del aprendizaje. Yeo (2023) resalta que los estudiantes a menudo carecen de orientación formal sobre las prácticas de escritura ética al utilizar herramientas impulsadas por IA, lo que puede llevar a la deshonestidad académica. En consonancia, Aisyah et al. (2024) mencionan que el uso de la IA puede propiciar el plagio entre los estudiantes, enfatizando la importancia de una educación sobre el uso responsable de estas herramientas en contextos académicos. Kotsis (2024) afirma que se promueve el uso ético de la IA mediante programas de albetización digital asegurando que el usuario sea consciente y asuma la responsabilidad.

Por otro lado, la formación del profesorado y la adaptación de sus roles son igualmente importantes en este contexto. Para Aghaziarati et al. (2023), es fundamental que los educadores adapten sus metodologías y enfoques a un entorno educativo enriquecido por la IA, dado que esto puede influir significativamente en la eficacia del aprendizaje. Por su parte, Arvin et al. (2023) refuerzan la noción de que los principios de transparencia y responsabilidad deben ser piedras angulares en el uso de la IA en educación para fomentar la confianza en estas tecnologías.

Según Balta (2023), se requiere una reflexión crítica sobre las implicaciones éticas del uso de la IA en la investigación educativa, lo que implica que los autores y editores deben estar conscientes de los desafíos que plantea la IA. Esta inquietud se ve respaldada por las observaciones de Karabacak et al. (2023), que resaltan la necesidad de afrontar los problemas éticos y legales relacionados con los modelos de lenguaje generativos en la educación. Estas interacciones pueden marcar la diferencia en la percepción y la experiencia de los usuarios (tanto estudiantado como profesorado) en un entorno cada vez más tecnificado.

La consideración ética también implica explorar el impacto de la IA en el aprendizaje personalizado. Gocen & Aydemi̇r (2020) afirman que la IA puede ser revolucionaria en términos de apoyo técnico para el aprendizaje personalizado, pero también advierten sobre el riesgo de prejuicios algorítmicos y la posibilidad de aumentar las desigualdades en el acceso a recursos educativos. En este sentido, la integración del aprendizaje socioemocional y la IA, como sugiere Akintayo et al. (2024), debe abordarse con cuidado para garantizar que se minimicen los riesgos y se logren resultados equitativos para todos los estudiantes.

Medición de los aspectos éticos en el uso de la IA en educación

El estudio de los aspectos éticos en el uso de la IA en el ámbito educativo ha llevado al desarrollo de varios instrumentos y marcos de referencia. Holmes et al. (2021) proponen un marco que busca establecer principios de responsabilidad y transparencia en el uso de la IA en entornos educativos, resaltando la diversidad de interpretaciones de la ética dentro de la comunidad educativa. Este enfoque enfatiza la necesidad de que cualquier marco ético sea flexible y se actualice conforme surjan nuevas tecnologías y desafíos.

Lee et al. (2024), presentan un marco de contenido educativo integrado en IA que considera factores éticos. Este enfoque busca integrar la ética en la enseñanza de la IA, resaltando la importancia de promover tanto el conocimiento técnico como una conciencia ética sobre el uso de estas tecnologías, con el objetivo de preparar a los estudiantes para enfrentar dilemas éticos en el futuro. Al combinar la alfabetización en el uso de la IA con un enfoque en la ética, se pretende fomentar al estudiantado una actitud crítica y responsable hacia el uso de la tecnología.

Khlaif et al. (2024) proponen la creación de directrices claras para el uso de herramientas de IA en la evaluación, con un enfoque en la integridad académica. Este estudio sugiere que es necesario implementar programas de desarrollo profesional que capaciten al profesorado en el uso adecuado de herramientas generativas de IA. Al establecer directrices robustas, se apunta a mejorar la comprensión y aplicación ética de la IA en contextos de evaluación.

La investigación de Hua (2023) destaca la necesidad de evaluar el impacto de las herramientas de IA en la conciencia ética de los estudiantes. Su investigación revela que, a pesar de la dependencia de los estudiantes en herramientas de IA, esto no necesariamente se traduce en una mayor conciencia ética sobre su uso, lo que subraya la necesidad de intervenciones que fomenten una comprensión más profunda de las implicaciones éticas. Esto pone de manifiesto la urgencia de incluir un componente ético explícito en los programas educativos que incorporen tecnologías de IA.

Akgün y Greenhow (2021) argumentan que las aplicaciones de IA pueden transformar la educación, pero que también es crítico abordar los desafíos éticos que surgen en este contexto. La formulación de principios éticos en la educación no solo debe centrarse en cuestiones técnicas, sino que también debe incluir consideraciones sobre la autonomía del estudiante y la equidad en el acceso a herramientas de IA. Esto refuerza la necesidad de educar a todos los involucrados -estudiantado y profesorado- sobre cómo utilizar estas tecnologías de manera responsable.

Ashok, et al. (2022), afirman que el uso de la IA en tecnologías digitales está transformando la sociedad, pero su implementación carece de guías prácticas a pesar de los principios éticos existentes. En este estudio, se identifican 14 implicaciones éticas en siete arquetipos de tecnologías digitales, utilizando un marco ontológico (físico, cognitivo, informativo y de gobernanza). Destacan la inteligibilidad, responsabilidad, equidad, autonomía y privacidad, mientras que las implicaciones de gobernanza son aplicables a la mayoría de los arquetipos. Se propone un modelo conceptual que vincula estas implicaciones con el impacto social, ofreciendo perspectivas académicas y prácticos.

Como se ha presentado existen diversos instrumentos y marcos para abordar los aspectos éticos del uso de la IA en la educación, los cuales van desde la implementación de directrices claras hasta la creación de marcos educativos que integran la ética en la enseñanza sobre IA. Estos esfuerzos son fundamentales para asegurar que la integración de la IA en educación beneficie a todos los estudiantes, al tiempo que se mitigan los riesgos asociados con su uso.

La integración de la IA en el ámbito educativo representa una oportunidad transformadora para enriquecer los procesos de aprendizaje, pero también plantea desafíos éticos significativos que requieren atención inmediata. La protección de la privacidad de los datos, la prevención de sesgos algorítmicos, la garantía de equidad en el acceso y la promoción de la integridad académica son aspectos críticos que deben abordarse mediante marcos regulatorios robustos y políticas claras. Además, la formación continua del profesorado y la alfabetización digital del estudiantado son esenciales para fomentar un uso responsable y ético de estas tecnologías. En este estudio se propone caracterizar las consideraciones éticas en el uso de la IA en procesos educativos, analizando las percepciones de estudiantes universitarios de dos universidades.

Metodología

La presente investigación es de tipo cuantitativa con enfoque mixto. Tiene alcance descriptivo, transversal y no experimental. Para medir la variable ética en el uso de la IA se propone un cuestionario que es una adaptación de la conceptualización propuesta por Ashok et al. (2022) que la asume como los principios que rigen el desarrollo y la aplicación de la IA para garantizar el respeto de los derechos y valores humanos. El análisis estadístico se realiza mediante el software JASP. La definición operacional se presenta en la tabla 1.

Tabla 1 Definición operacional de la variable Ética en el uso de la IA

| Variable | Dimensiones | Indicadores |

|---|---|---|

| Ética en el uso de la IAED | Física | Dignidad y bienestar |

| Protección | ||

| Sustentabilidad | ||

| Cognitiva | Inteligibilidad | |

| Responsabilidad | ||

| Equidad | ||

| Inclusión y prosperidad | ||

| Solidaridad | ||

| Autonomía | ||

| Informacional | Privacidad | |

| Seguridad | ||

| Gobernanza | Impacto regulatorio | |

| Individual y social | ||

| Financiero y económico |

La población son estudiantes de dos universidades mexicanas. La Coordinación Académica Región Altiplano Oeste (CARAO) de la Universidad Autónoma de San Luis Potosí (UASLP); estudiantes en programas presenciales. Así como de la Universidad Neuuni (NEUUNI), estudiantes en programas a distancia. El tamaño de la muestra es de 125 estudiantes, se utiliza un muestreo de tipo no probabilístico por conveniencia.

La consistencia interna se mide mediante los estadísticos Alpha de Cronbach y Omega de McDonald. En la tabla 2 se muestra que la variable alcanza niveles altos cuando se consideran las cuatro dimensiones.

Tabla 2 Análisis de la consistencia interna de las dimensiones de la variable Ética en el uso de la IA

| Dimensión | ω de McDonald | α de Cronbach |

|---|---|---|

| Física | 0.808 | 0.803 |

| Cognitiva | 0.802 | 0.801 |

| Informacional | 0.576 | 0.575 |

| Gobernanza | 0.615 | 0.604 |

| Todas las dimensiones | 0.898 | 0.897 |

Sin embargo, de manera individual la dimensión Informacional y Gobernanza no alcanzan niveles adecuados de consistencia interna. Por lo tanto, dichas dimensiones se descartan para ser considerados en el análisis.

Para identificar la validez del constructo se realiza un Análisis Factorial Exploratorio (AFE). En la tabla 3 se muestran las cargas de los factores. Cabe destacar que el contraste de Bartlett resulta p<0.001 y el de Kaiser-Meyer-Olkin de 0.760. Ambos indicadores validan la pertinencia del uso del AFE. Se utiliza el método de rotación promax. Los factores extraidos explican el 46.6% de la varianza.

Tabla 3 Carga de los factores

| Factor 1 | Factor 2 | Unicidad | |

|---|---|---|---|

| F6 | 0.812 | 0.445 | |

| F4 | 0.762 | 0.433 | |

| F3 | 0.761 | 0.425 | |

| F5 | 0.753 | 0.454 | |

| F1 | 0.735 | 0.530 | |

| C8 | 0.727 | 0.321 | |

| C6 | 0.678 | 0.412 | |

| C1 | 0.483 | 0.760 | |

| F2 | 0.443 | 0.717 | |

| C3 | 0.435 | 0.846 | |

| C12 | 0.933 | 0.292 | |

| C7 | 0.710 | 0.389 | |

| C5 | 0.709 | 0.579 | |

| C9 | 0.708 | 0.452 | |

| C10 | 0.678 | 0.541 | |

| C4 | 0.673 | 0.591 | |

| C2 | 0.851 | ||

| C11 | 0.581 |

Nota. El método de rotación aplicado es promax.

Como se observa, existen ítems de la dimensión Cognitiva que cargan en el factor incorrecto, así como otros que tienen un carga menor a 0.4. Dichos ítems se eliminan para proceder al Análisis Factorial Confirmatorio (AFC).

Para identificar la validez discriminante se calcula la proporción heterorrasgo-monorrasgo (HTMT), la cual se encuentra en niveles de 0.394 en el cruce Físico-Cognitivo, el cual es inferior a 0.9, lo cual es adecuado.

Por su parte, la Varianza Media Extraída (VME) alcanza los niveles de 0.514 y 0.530 en las dimensiones Física y Cognitiva respectivamente. Estos son adecuados dado que en ambas dimensiones son mayores a 0.500. En la tabla 4 se presentan los índices, cuyos niveles confirman un ajuste adecuado del modelo.

Tabla 4 Medidas de ajuste del modelo

| Índice | Valor obtenido | Valor recomendado |

|---|---|---|

| Índice de Ajuste Comparativo (CFI) | 0.969 | >0.950 |

| Índice de Tucker-Lewis (TLI) | 0.961 | >0.900 |

| Índice de ajuste no normalizado de Bentler-Bonett (NNFI) | 0.961 | >0.900 |

| Índice de bondad de ajuste (GFI) | 0.972 | >0.890 |

| Raíz del error cuadrado medio estandarizado (RECMS, SRMR) | 0.071 | <0.080 |

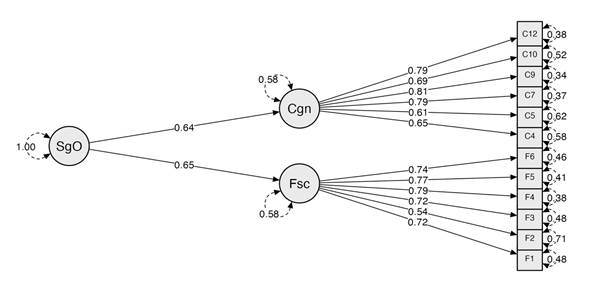

La gráfica del modelo se presenta en la figura 1. Las cargas factoriales para la dimensión Física (Fsc) varían entre 0.38 y 0.71. Por su parte, las cargas factoriales para la dimensión Cognitiva (Cgn) varían entre 0.34 y 0.62. La relación entre la variable Ética en el uso de la IA (SgO) y sus dimensiones es moderada-alta, lo que refuerza la validez del modelo.

Resultados

La proporción de la muestra se integra como sigue, la CARAO de la UASLP (42%) y la Universidad Neuuni (58%). Sus características se muestran en la tabla 4.

Tabla 4 Características de la muestra

| UASLP | NEUUNI | UASLP | NEUUNI | |||

|---|---|---|---|---|---|---|

| Género: | Edad media | 19 años | 37 años | |||

| Hombre | 38% | 69.4% | Desv. estándar edad | 1.4 años | 9.3 años | |

| Mujer | 55% | 26.4% | ||||

| Otro | 7% | 4.2% | Nivel de competencia digitales: | |||

| Básicas | 47.2% | 54.2% | ||||

| Situación laboral actual: | Intermedias | 50.9% | 37.5% | |||

| Trabajo formal remunerado | 9.4% | 91.7% | Avanzadas | 1.9% | 8.3% | |

| Trabajo informal, no remunerado y eventual | 39.6% | 5.6% | ||||

| Trabajo no remunerado | 3.8% | 1.4% | Para qué usa la IA mayormente: | |||

| No trabajo | 47.2% | 1.4% | Académicas | 60.4% | 61.1% | |

| Trabajo | 7.5% | 22.2% | ||||

| Entretenimiento | 32.1% | 16.7% | ||||

Se revelan diferencias entre los estudiantes de la UASLP y la Universidad NEUUNI, ambos grupos representan perfiles distintos en términos demográficos, laborales y de competencias digitales. La notable diferencia en la edad media (19 años en la UASLP frente a 37 años en NEUUNI). La muestra de la UASLP está compuesta principalmente por estudiantes de pregrado, mientras que en la de NEUUNI se compone de una población más adulta, con mayor experiencia laboral, como lo refleja el alto porcentaje de estudiantes con trabajo formal remunerado (91.7%).

Además, la distribución de género es notablemente contrastante: mientras que en la UASLP predomina la participación de mujeres, en NEUUNI la mayoría son hombres. Esta diferencia podría influir en las dinámicas y necesidades de cada grupo. Según Wang et al. (2023), el género puede desempeñar un papel relevante en la preferencia por ciertos tipos de herramientas tecnológicas en el aula. Por ejemplo, las estudiantes suelen mostrar mayor interés en herramientas colaborativas y de comunicación, mientras que los estudiantes varones tienden a inclinarse por herramientas más competitivas o basadas en juegos. Estas preferencias podrían influir en la forma en que ambos grupos interactúan con plataformas de aprendizaje impulsadas por IA, lo que subraya la importancia de diseñar tecnologías educativas sensibles a estas diferencias.

En cuanto a las competencias digitales, ambos grupos utilizan predominantemente la IA con fines académicos; sin embargo, NEUUNI presenta un porcentaje más alto de estudiantes con habilidades digitales avanzadas (8.3%) en comparación con la UASLP (1.9%). Esta diferencia podría asociarse al perfil laboral más activo y a la mayor edad promedio de los estudiantes de NEUUNI. No obstante, como señala la OCDE (2019), las competencias digitales están más vinculadas a la educación formal y a la formación continua en tecnologías digitales que a la edad o la experiencia laboral per se. Por ello, resulta relevante profundizar en futuras investigaciones para comprender mejor este aspecto.

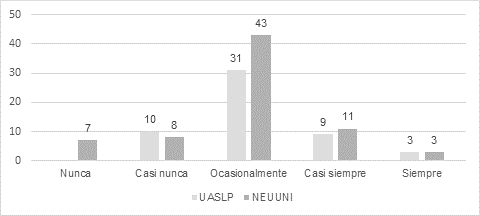

La figura 2 muestra la frecuencia de uso de herramientas digitales potenciadas por IA. Se observa que, aunque el uso de IA es más habitual en NEUUNI -posiblemente debido a su perfil laboral más activo y su mayor competencia digital avanzada-, aún existe un segmento significativo en ambas instituciones que no las utiliza con regularidad.

Brynjolfsson et al. (2022) destacan que la adopción de IA en el ámbito laboral está más relacionada con la capacidad de adaptación y la inversión en capacitación que con la edad o la antigüedad en el puesto. En la misma línea, McKinsey & Company (2021) señala que la brecha en el uso de herramientas de IA no está necesariamente ligada a la edad, sino a la exposición previa a tecnologías digitales y a la disponibilidad de recursos de formación.

Estos datos refuerzan la idea de que, a pesar de las diferencias en edad, situación laboral y competencias digitales, ambas universidades podrían beneficiarse de estrategias que fomenten una mayor adopción y aprovechamiento de estas herramientas, especialmente en el ámbito académico, principal uso declarado por los estudiantes.

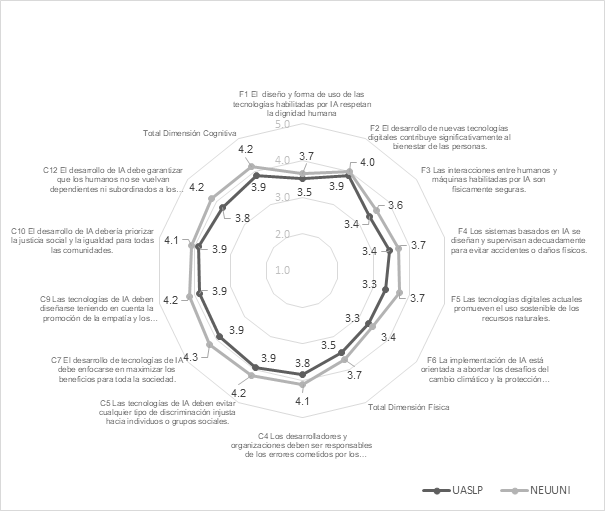

En la dimensión física (Figura 3), NEUUNI presenta medias más altas en todos los ítems (estadísticamente significativas), lo que indica que sus estudiantes tienen una percepción más positiva sobre el impacto de la IA en aspectos como la dignidad humana, la seguridad física y la sostenibilidad ambiental.

Esta tendencia podría explicarse por el perfil más adulto y con mayor experiencia laboral de NEUUNI (edad media de 37 años), que probablemente les proporciona una mayor exposición a tecnologías avanzadas y una comprensión más profunda de su potencial para mejorar el bienestar y abordar desafíos globales, como el cambio climático (Brynjolfsson, 2021; Dwivedi et al., 2021).

En contraste, la UASLP, con una población más joven (edad media de 19 años), podría tener una visión más cautelosa o menos experimentada en estos temas, lo que se refleja en sus medias ligeramente más bajas. Estas diferencias resaltan la relevancia de considerar el contexto demográfico y la experiencia previa al implementar y evaluar tecnologías de IA, especialmente en entornos educativos.

En la dimensión cognitiva (Figura 3), las diferencias son aún más pronunciadas (también estadísticamente significativas), con NEUUNI destacando una media total de 4.2 frente a 3.9 en la UASLP. Esto sugiere que los estudiantes de NEUUNI tienen una mayor conciencia y exigencia respecto a los aspectos éticos y sociales del desarrollo de la IA, como la responsabilidad de los desarrolladores, la prevención de la discriminación y la promoción de la justicia social.

Este enfoque más crítico y proactivo podría estar influenciado por su mayor participación en el mercado laboral (91.7% con trabajo formal remunerado), lo que les expone a situaciones donde la ética y la responsabilidad en el uso de tecnologías son fundamentales (Jobin et al., 2019). Además, su mayor competencia digital avanzada (8.3% frente a 1.9% en la UASLP) les permite comprender mejor las implicaciones de la IA en la sociedad. Como señalan Dwivedi et al. (2021), la exposición a entornos laborales y tecnológicos fomenta una visión más profunda y crítica de los desafíos éticos asociados a estas tecnologías.

En contraste, la UASLP, con una población más joven y menos involucrada en el ámbito laboral (47.2% no trabaja), podría estar en una etapa de formación y exploración de estas tecnologías, lo que explicaría su percepción ligeramente más conservadora.

Como señala Binns (2020), la falta de exposición a entornos laborales y tecnológicos puede limitar la comprensión crítica de la IA en poblaciones más jóvenes, que aún están desarrollando su perspectiva sobre estas herramientas. Sin embargo, ambos grupos coinciden en la importancia de aspectos como la responsabilidad ética y la justicia social, lo que refleja una conciencia compartida sobre los desafíos y oportunidades que presenta la IA. Este consenso, como destacan Floridi et al. (2021), subraya la relevancia de principios éticos universales en el desarrollo de tecnologías de IA, independientemente de las diferencias demográficas o de experiencia.

En la tabla 5 se observa que factores como el género, la edad, la institución, la ocupación y el uso principal de la IA influyen significativamente en las percepciones sobre las dimensiones física y cognitiva de la IA. NEUUNI, con su perfil más adulto, laboralmente activo y con mayor competencia digital, destaca por tener una visión más positiva y crítica sobre la IA en ambas dimensiones.

Tabla 5 Resultados de la prueba de hipótesis Kruskal-Wallis.

| Dimensión | Variable sociodemográfica | P valor | Interpretación |

|---|---|---|---|

| Dimensión Cognitiva | Género | 0.019 | Ser hombre se asocia a una percepción mayor en la dimensión cognitiva. |

| Dimensión Cognitiva | Edad | 0.020 | Tener mayor edad se asocia a una percepción mayor en la dimensión cognitiva. |

| Dimensión Física | Institución | 0.018 | Pertenecer a NEUUNI se asocia a una percepción mayor en la dimensión física. |

| Dimensión Cognitiva | Institución | 0.001 | Pertenecer a NEUUNI se asocia a una percepción mayor en la dimensión cognitiva. |

| Dimensión Cognitiva | Ocupación | 0.025 | Tener un trabajo formal y remunerado se asocia a una percepción mayor en la dimensión cognitiva. |

| Dimensión Física | Principal uso de la IA | 0.001 | Realizar actividades laborales con la IA se asocia una mayor percepción en la dimensión física. |

| Dimensión Cognitiva | Principal uso de la IA | 0.005 | Realizar actividades laborales con la IA se asocia una mayor percepción en la dimensión cognitiva. |

Por otro lado, la UASLP, con una población más joven y menos expuesta al ámbito laboral, muestra percepciones más conservadoras. Como señalan Kurup y Gupta (2022), la exposición práctica a la IA en entornos laborales y la experiencia profesional son factores clave para fomentar una comprensión más profunda y crítica de su impacto ético y social.

Estos hallazgos subrayan la importancia de considerar el contexto sociodemográfico al diseñar estrategias educativas, laborales y tecnológicas relacionadas con la IA, ya que las necesidades y perspectivas varían según estos factores (Li et al., 2022). Además, el uso práctico de la IA en el trabajo emerge como un factor clave para mejorar la percepción de su impacto, lo que sugiere que fomentar su aplicación en entornos laborales podría ser una estrategia efectiva para promover una adopción más responsable y consciente de estas tecnologías.

Los resultados subrayan la importancia de considerar el contexto y las características específicas de cada grupo al diseñar políticas, programas educativos o estrategias tecnológicas. Mientras que NEUUNI podría beneficiarse de iniciativas que refuercen la aplicación práctica y ética de la IA en entornos laborales, la UASLP podría requerir mayor formación y sensibilización sobre el potencial y los riesgos de estas tecnologías, especialmente en el ámbito académico.

En ambos casos, fomentar una visión crítica y responsable de la IA es esencial para maximizar sus beneficios y minimizar sus riesgos en la sociedad. Los estudiantes revelan preocupación por generar dependencia a la IA y con ello perder competencias para trabajar de manera autónoma (Otero Escobar, & Suárez-Jasso, 2025).

Como señalan Holmes et al. (2021), la implementación de marcos éticos flexibles y adaptables es necesario para abordar los desafíos emergentes en el uso de la IA en educación, especialmente en contextos con diferentes niveles de exposición tecnológica. Además, Khlaif et al. (2024) enfatizan la necesidad de desarrollar directrices claras y programas de capacitación docente que promuevan un uso ético y responsable de las herramientas de IA, lo que es particularmente relevante para instituciones con poblaciones menos familiarizadas con estas tecnologías. Estas perspectivas refuerzan la importancia de diseñar estrategias diferenciadas que consideren las particularidades de cada población, asegurando que la integración de la IA en la educación sea equitativa y éticamente sólida.

Conclusiones

En esta investigación se revela que factores sociodemográficos como la edad, el género, la ocupación y el nivel de competencia digital influyen significativamente en las percepciones de los estudiantes sobre las dimensiones física y cognitiva de la ética en la IA. Los estudiantes de NEUNI, con un perfil más adulto, laboralmente activo y con mayor competencia digital, mostraron una percepción más positiva y crítica de la IA, lo que sugiere que la exposición a entornos laborales y tecnológicos avanzados fomenta una comprensión más profunda de sus implicaciones éticas. Por el contrario, los estudiantes de la UASLP, más jóvenes y con menor experiencia laboral, mostraron percepciones más conservadoras, posiblemente debido a su menor exposición a estas tecnologías.

Estos hallazgos subrayan la importancia de diseñar estrategias educativas y políticas que consideren las diferencias sociodemográficas, promoviendo la formación en competencias digitales y éticas para fomentar un uso responsable de la IA.

Además, se destaca la necesidad de un enfoque colaborativo entre educadores, tecnólogos y responsables de políticas públicas para garantizar que la integración de la IA en la educación esté alineada con estándares éticos rigurosos, protegiendo los derechos de los estudiantes y promoviendo la equidad en el acceso a estas tecnologías.

Se considera que esta investigación aporta evidencia valiosa para guiar la implementación responsable de la IA en la educación, asegurando que sus beneficios se distribuyan de manera equitativa y que se minimicen los riesgos éticos asociados.

nueva página del texto (beta)

nueva página del texto (beta)