Clasificación JEL: I21, I28.

Introducción

En los últimos años muchos países han realizado inversiones significativas en los programas Una Laptop por Niño (OLPC, por sus siglas en inglés), en tanto que otros países están por implementar este tipo de intervenciones. Tal como dice su nombre, los programas OLPC proporcionan a los estudiantes una laptop diseñada para promover el aprendizaje. Se ha sostenido que el uso de computadoras puede tener una repercusión favorable en los resultados educativos al ajustar el contenido académico a las necesidades de cada estudiante (Hornbeck, 1991; Koedinger et al., 1997, citado por Bulman y Fairlie, 2015; Fullan y Langworthy, 2013). Adicionalmente, las computadoras pueden aumentar la cantidad de instrucción que reciben los estudiantes en la medida en que utilizan programas educativos asistidos por computadoras sin supervisión directa de un maestro (Cuban, 1993; Barrow, Markman y Rouse, 2009, citado por Bulman y Fairlie, 2015). Asimismo, Hornbeck (1991), Cuban (2003) y Fullan y Langworthy (2013) argumentan que, en virtud de su naturaleza interactiva, la instrucción asistida por computadora puede motivar el proceso de aprendizaje de los niños más efectivamente que los métodos tradicionales al auspiciar el aprendizaje autodirigido.1 En cambio, Belo, Ferreira y Telang (2014) han propuesto un modelo de acuerdo con el cual el lapso de tiempo transcurrido frente a una computadora bien puede ser improductivo. El presente trabajo se propone contribuir al estudio del efecto que tienen los programas OLPC en los resultados obtenidos por los estudiantes en lectura y matemáticas; para ello, utiliza un diseño cuasi experimental basado en datos de Uruguay, que es el primer país en implementar un programa OLPC a escala nacional (el Plan CEIBAL)2 y que al día de hoy es uno de los programas más grandes del mundo con cerca de un millón de equipos distribuidos.3

Si bien la literatura sobre las repercusiones del empleo de computadoras en el progreso educativo es relativamente abundante, sus hallazgos siguen siendo dispares. Fairlie y Robinson (2013) concluyen que el uso de las computadoras en el hogar no tiene efecto alguno en los resultados que obtienen los niños, mientras que Vigdor y Ladd (2010), así como Malamud y Pop-Eleches (2011), reportan un efecto negativo. De modo similar, Angrist y Lavy (2002) estudian el impacto de las computadoras en la escuela y encuentran un efecto negativo, mientras que Machin, McNally y Silva (2007) hallan lo contrario.

Banerjee et al. (2007) se concentran en el impacto de un software específico en matemáticas y hallan que los efectos son positivos. Desafortunadamente, se trata de efectos de escasa duración, que se esfuman un año después de que ha tenido lugar el tratamiento. Carrillo, Onofa y Ponce (2010), al evaluar un proyecto que proporciona instrucción asistida por computadora en matemáticas y lectura, encuentran que hay efectos positivos en matemáticas pero no existe efecto en lectura. Mediante un experimento de control aleatorio, Mo et al. (2013) examinan el impacto de una intervención en 13 escuelas para migrantes en Pekín. La intervención involucró la distribución de laptops con un software de enseñanza remedial instalado más una sesión de capacitación en el uso de computadoras. A los maestros no se les dio capacitación sobre cómo usar una computadora a fin de mejorar el proceso de enseñanza y aprendizaje. Los autores reportaron un efecto positivo en matemáticas (si bien sólo resultó significativo a 10%), pero no en lectura.

Hasta ahora, la evidencia en el campo de la evaluación de impacto de los programas OLPC proviene sólo de un estudio implementado en Perú. Cristia et al. (2012) reportan resultados basados en un experimento de control aleatorio de gran escala en 319 escuelas públicas en comunidades pequeñas y pobres de Perú. La mayoría de las escuelas tratadas no tenía acceso a internet y la distribución de laptops no estuvo acompañada con sesiones de entrenamiento para mostrar a los maestros cómo usar las computadoras en mejorar la enseñanza y el aprendizaje. Escuelas control y tratamiento fueron seguidas por 15 meses. Los autores no registraron efecto en matemáticas o en lectura, aun cuando sí se detectó un impacto estadísticamente significativo en habilidades cognitivas, medido por la prueba de matrices progresivas de Raven.4

A diferencia del estudio de Cristia et al. (2012), nuestro estudio no se propone evaluar el impacto del programa OLPC en el marco de escuelas rurales ubicadas en comunidades desfavorecidas. En contraste, nuestro trabajo se enfoca en analizar una muestra representativa de las escuelas de Uruguay, ya sea urbanas o rurales. Utilizamos una estrategia de diferencias en diferencias (DiD) para calcular el impacto del Plan CEIBAL sobre el logro académico. El análisis explota el hecho de que el plan de despliegue del programa obedeció a un criterio geográfico y no al rendimiento escolar de los estudiantes. Además, se tiene información de la fecha exacta en que cada estudiante recibió su laptop, lo cual nos permitió obtener una medida continua de tratamiento con base en el número de días que cada estudiante estuvo expuesto al Plan CEIBAL al llegar la fecha de seguimiento (normalizada a años). Se controla por diferencias sistemáticas en la trayectoria de aprendizaje a lo largo del tiempo entre escuelas en la capital, Montevideo, y el resto de Uruguay. Asimismo, dado que al interior de cada escuela existe variación en la fecha de entrega, podemos controlar -con modelos de efectos fijos individuales- por posible heterogeneidad entre centros educativos en su trayectoria de aprendizaje a lo largo del tiempo en ausencia del programa (es decir, permitimos que cada centro educativo siga una trayectoria de aprendizaje diferente en función de características inobservables a nivel escuela que varían en el tiempo).

Nuestras principales estimaciones se basan en un panel de estudiantes que fueron entrevistados por vez primera en octubre de 2006, cuando cursaban tercero de primaria, y que fueron entrevistados de nuevo en octubre de 2009, cuando casi todos cursaban sexto año (esto es, el último año de primaria). Para finales de este año, todos los estudiantes de primaria tenían en las manos sus laptops. Pero mientras que algunos habían participado en el programa durante casi dos años, otros tenían menos de un mes de haber iniciado. Esta variación en la intensidad de tratamiento es lo que nos permite identificar el efecto causal del Plan CEIBAL en los resultados obtenidos por los niños, neto de características individuales observadas y no observadas, y controlando por potenciales diferencias en la trayectoria de aprendizaje entre regiones y escuelas a lo largo del tiempo.

Nuestros hallazgos indican que el programa no tuvo impacto en los puntajes de lectura o matemáticas. Estos resultados se mantienen si la variación de tratamiento intraescuela es desechada y el impacto del programa se estima analizando un panel de escuelas que solamente explota la variación de tratamiento entre escuelas, permitiendo únicamente heterogeneidad en la trayectoria de aprendizaje entre escuelas en Montevideo y escuelas en el resto de Uruguay en ausencia del programa. El estudio provee una pista de por qué no hallamos efecto sobre los puntajes de lectura y matemáticas, ya que tenemos información sobre el uso de las laptops en clase y encontramos que los maestros solicitan a sus alumnos que usen la laptop principalmente para hacer búsquedas de información en internet. También, hasta ahora la capacitación en el uso de la laptop ha sido opcional en contrapunto de Fullanm Watson y Anderson (2013) que argumentan que el reto es entrenar al maestro para lograr el uso permanente de la laptop y su incorporación en las prácticas pedagógicas.

Este trabajo está organizado del siguiente modo: la sección I describe el programa y el conjunto de datos analizados; la sección II aborda la estrategia de identificación; la sección III presenta los resultados, y finalmente se presentan las conclusiones.

I. Antecedentes y conjunto de datos por analizar

1. El programa OLPC en Uruguay: el Plan CEIBAL

El objetivo central del Plan CEIBAL es promover la inclusión digital entre los niños uruguayos. Se propone igualmente elevar el nivel de aprendizaje tanto en la escuela como en el hogar.5 Provee a los estudiantes y maestros de las escuelas públicas de primaria (y, en fecha más reciente, a los de secundaria) de una laptop y de acceso a internet.6 Los estudiantes a quienes se les dio una laptop (XO) mientras cursaban la primaria son instados a intercambiarla por laptops de tecnología más avanzada durante la secundaria.7 Para octubre de 2013, el Plan CEIBAL había repartido un millón de laptops -cada una con un costo de alrededor de 180 dólares-, y el número de estudiantes beneficiados por esta medida se estima en aproximadamente unos 625 000.8 La cantidad de laptops distribuidas rebasa el número de beneficiarios debido precisamente al intercambio por computadoras portátiles más sofisticadas de los que hemos hablado.

El acceso a internet, que es de tipo inalámbrico, cubre no sólo las escuelas sino también otras áreas como las plazas públicas. Los estudiantes a menudo entran a la red ya sea mediante el WiFi de su centro escolar o el internet gratuito que está disponible en los lugares públicos (como ya explicamos, son libres de llevarse el equipo). El software instalado en las computadoras contiene programas estandarizados para escribir, hacer cálculos, correr programación gráfica de gestión ambiental (Tortugarte, Etoys, Scratch, Pippy), navegar por la web (Navegar), dibujar y diseñar (Tuxpaint, Pintar), estudiar geografía (Geo gebra/Dr. Geo, Conozco Uruguay), tomar fotografías y hacer videos, producir y editar sonidos musicales (Tam tam mini, Sara), aprender inglés (English for fun), participar en juegos (Laberinto) y abrir libros.

La iniciativa fue lanzada en una provincia que fungió de programa piloto en 2007.9 Durante el primer semestre de 2008 se distribuyeron laptops predominantemente en las escuelas de las provincias occidentales y en el segundo semestre de ese año el turno les correspondió a las orientales; en 2009 quedaron cubiertas Montevideo y Canelones (provincia en las inmediaciones de Montevideo). Para octubre del mismo año, se les había obsequiado una laptop a todos los estudiantes y maestros de las escuelas públicas de primaria (UNESCO, 2011: 34). El gobierno decidió comenzar por repartir laptops en las provincias y terminar en la capital a fin de efectuar un viraje en las políticas centralistas que siempre ha auspiciado (Balaguer, 2010).

Debe advertirse que CEIBAL es una institución que rinde cuentas directamente al presidente. En calidad de tal, no forma parte de la Administración Nacional de Educación Pública (ANEP), la autoridad central responsable de la educación en Uruguay. Aun cuando en virtud de este rasgo distintivo se aceleró la implementación del programa, esto también conllevó dificultades para establecer una coordinación entre los maestros con la fluidez que hubiera sido deseable. Ya desde el comienzo, los cursos que se ofrecían a los maestros (con clases tanto presenciales como en línea) eran sólo opcionales. La capacitación tenía carácter obligatorio únicamente en el caso de los inspectores y los maestros que, fungiendo de consultores externos, asistían a los centros educativos en la fase de incorporación de las laptops al proceso de enseñanza (se les conocía como “maestros dinamizadores”).10 El Plan CEIBAL no involucró formalmente la asistencia parental sino hasta 2012. A partir de entonces, algunas de las escuelas a las que se asignó un “maestro de apoyo CEIBAL” organizaron talleres para los parientes de los alumnos y la gente de su vecindario, los cuales manifestaran interés en aprender a utilizar las laptops. Por cierto, hasta la fecha dichos talleres no se han hecho realidad sino en muy pocas escuelas.

El conjunto de datos que examinamos incluye una encuesta que fue aplicada a estudiantes, familiares de éstos, maestros y directivos de los centros escolares respecto al Plan CEIBAL y que se llevó a cabo en octubre de 2009. Según los resultados obtenidos, para ese año 87% de los directivos de escuelas tenía acceso a internet, pero, debido a problemas de la conectividad, no todos los alumnos de diversos grados se podían enlazar a la red simultáneamente. De hecho, a decir de 83% de los directivos escolares, menos de la mitad de los alumnos se podía conectar a la vez. Hay que añadir que el juicio de estas autoridades sobre las repercusiones de CEIBAL era extremadamente positivo en todos los aspectos, en particular en lo referente a la motivación que mostraban los estudiantes para trabajar en clase y aprender (véase el cuadro A1). En cuanto a los maestros, 59% de ellos respondió que usaban una computadora a diario. Por su parte, 65% de los estudiantes contestó que en su casa había una computadora de escritorio o portátil (sin contar la obsequiada por el Plan CEIBAL), mientras que 47% podía acceder a internet ya sea por medio de la banda ancha o del módem inalámbrico de la escuela. Casi todos los padres observaron que los estudiantes empleaban la laptop de CEIBAL en casa, mientras que 80% de ellos señaló que también usaban otro ordenador (véase el cuadro A2).

2. Datos

Utilizamos un panel de estudiantes evaluados en 2006 y 2009. En ambas olas se incluyeron pruebas estandarizadas de matemáticas y lectura junto con cuestionarios dirigidos a los estudiantes y sus familias, así como a los maestros y directores de los centros escolares. La primera ola corresponde a la evaluación del Segundo Estudio Regional Comparativo y Explicativo (SERCE) diseñada por la UNESCO e implementada en octubre de 2006. Para entonces los alumnos analizados en este trabajo cursaban tercer año.11

La segunda ola refiere a la V Evaluación Nacional de Aprendizajes que llevó a cabo la ANEP en octubre de 2009. Ambos estudios son representativos a escala nacional. Entre las escuelas que integraban la muestra, la ANEP incluyó aquellas que habían participado en la evaluación SERCE con el objeto de construir un panel. De los 6 222 estudiantes de escuelas públicas que habían participado en la evaluación SERCE, 2645 participaron también en la Evaluación Nacional de Aprendizajes de 2009. Para esa fecha, la mayoría de los estudiantes cursaban el último año de primaria. Los estudiantes evaluados en tercer grado en 2006 que se encontraban rezagados en 2009 (en otras palabras, habían repetido uno o más grados) también participaron de la evaluación 2009.

Al realizar la evaluación de 2009 contábamos con el número de identificación y el nombre completo de los estudiantes, lo cual nos permitió vincular a 92% de los estudiantes de escuelas públicas que habían sido examinados en 2006 y 2009 con los registros administrativos del Plan CEIBAL. A partir de estos registros obtuvimos la fecha exacta en que cada alumno recibió su laptop.

El Cuadro 1 muestra la distribución de observaciones por ubicación geográfica y año y mes de recepción de la laptop. Con la finalidad de evaluar si la entrega de las laptops fue exógena, graficamos el desempeño promedio en lectura y matemáticas en 2006 (previo a la implementación del Plan CEIBAL) con la fecha en que la mayoría de los niños de cada escuela recibió su laptop. Las Gráficas 1 y 2 muestran el desempeño promedio en lectura y matemáticas, respectivamente: El eje de las abscisas representa las escuelas ordenadas según la fecha en la que sus estudiantes recibieron la laptop de CEIBAL. Asimismo, la Gráfica A1 presenta las tasas de repetición de las escuelas, según la fecha en que la mayoría de sus alumnos recibió la laptop. El análisis gráfico sugiere que el criterio para el despliegue del programa no está correlacionado con los resultados educativos previos.

CUADRO 1 Porcentaje de estudiantes según la fecha de recepción de la laptop y la ubicación geográficaa (porcentaje)

a La fecha de entrega incluye el día, el mes y el año. Para los fines de este cuadro, se asientan las observaciones por mes y año.

La logística de la entrega de CEIBAL operaba de modo tal, que en cada escuela las entregas de computadoras se realizaban un día específico, sin embargo, existe cierta variación intraescuela debido a los alumnos ausentes el día de la entrega. En la muestra, la variación intraescuela da cuenta de poco más de 2% de la variación total. A fin de verificar si el hecho de haber recibido la laptop a destiempo se correlaciona con características individuales observables, calculamos un modelo probit con efectos fijos y errores anidados a nivel de escuela (véase el Cuadro 2). Ninguna variable resulta estadísticamente significativa.

CUADRO 2 Probabilidad de recibir la laptop más tarde que el resto de los estudiantes en la escuelaª

a Se reportan errores estándar anidados a nivel escuela.

*** p < 0.01, ** p < 0.05, * p < 0.1.

El Cuadro 3 presenta los descriptivos para los estudiantes que participaron en ambas evaluaciones (lectura y matemáticas), y que poseemos información sobre la fecha de recepción de la laptop. Los resultados de matemáticas y lectura están estandarizados con media cero y desviación estándar 1.

Cuadro 3 Estadística descriptivaª

ª Las estimaciones también incluyen las siguientes variables: año de nacimiento, número de libros en el hogar, número de habitaciones, acceso a agua potable, teléfono, televisión por cable, reproductor de DVD, horno de microondas, lavadora, internet y computadora. Se incluye información sobre si el alumno trabaja y es remunerado, así como sobre el tipo de hogar. Para los casos donde no hay información sobre el número de personas que viven en el hogar, la variable “personas” ha sido recodificada a 0.

II. Metodología

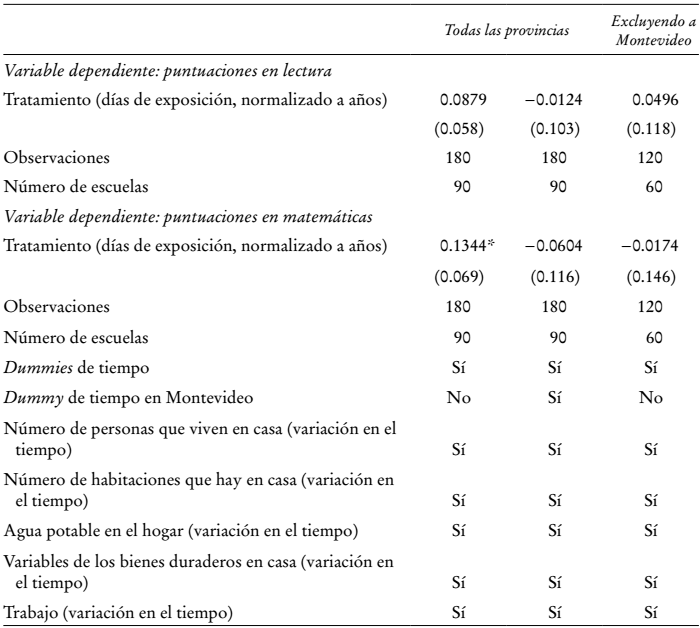

La estrategia de identificación explota el hecho de que observamos la fecha de recepción de las laptops para prácticamente todos los individuos del panel. La variable de tratamiento es el número de días de exposición al programa al momento de realizar la evaluación, reflejando la intensidad de tratamiento. A fin de facilitar la interpretación, normalizamos esta variable a años de exposición. Comenzamos por estimar el siguiente modelo:

donde Yist representa el puntaje del individuo i en la escuela s en la ola t; i= 1, …, N, s = 1, …, 90, y t = 2006, 2009. Tist es la variable de tratamiento que refleja el número de días (en términos de años) en que el estudiante ha contado con la laptop al momento t. Xist son características individuales que varían en el tiempo, δt es una variable indicadora del año 2009, ci son efectos fijos a nivel individual y uist es el término de error idiosincrático. En todos los modelos hemos considerado que las variables explicativas son exógenas. En otras palabras, damos por sentado que se cumple la condición E(uist |Xis , Tist , δt , ci ) = 0. De igual forma, en cada modelo reportamos errores estándar robustos (esto es, utilizamos el estimador White-Huber-Eiker para la matriz de covarianzas) anidados a nivel de escuela. El modelo está ajustado por efectos fijos. Trabajamos con un panel de estudiantes balanceado en virtud de que disponemos de dos olas y estamos implementando un estimador de efectos fijos.

En la ecuación (1) se supone que las escuelas siguen una tendencia común, tal como ocurre en el modelo estándar de diferencias en diferencias. Sin embargo, dado que existe cierta variación al interior de las escuelas en cuanto a las fechas de entrega, fue posible aislar tendencias escolares al momento de estimar el impacto de CEIBAL. De este modo, es posible controlar por variaciones a nivel de escuela que de otra forma hubieran sido interpretadas como un efecto del tratamiento (es decir, admitimos la posibilidad de que cada centro siga una trayectoria de aprendizaje distinta debido a factores no observados a nivel escuela). Dicha estrategia nos permite controlar por cambios específicos que afecten de forma dispar las escuelas -por ejemplo, cambios en el estilo de administración escolar que ocurran en el tiempo- y que, de otra manera, serían interpretados como efectos del Plan CEIBAL.

El modelo,

permite controlar por cambios en las escuelas en relación con el periodo base al incluir interacciones entre las escuelas y el tiempo (Wooldridge, 2002: 267) . La ecuación (2) también se estima con efectos fijos individuales.

De todos modos, la variación a nivel intraescolar en las fechas de entrega de las laptops no es demasiado grande. Puesto que hay evidencia de que existen distintas tendencias en el tiempo entre Montevideo y el resto de Uruguay (véase el cuadro 5), quisiéramos controlar por el efecto de las mismas en ausencia del programa OLPC. Para lograr dicho objetivo estimamos el siguiente modelo:

Montevideo es una variable indicadora de las escuelas localizadas en la capital. Al incluir los términos de interacción entre Montevideo y el año 2009, la ecuación (3) nos permite controlar por la heterogeneidad inobservable variante en el tiempo entre regiones, respecto al momento base. Al igual que los anteriores, este modelo se calcula con efectos fijos individuales. Los errores estándar robustos están anidados a nivel de escuela.

Por último, implementamos un chequeo de robustez mediante un estimador que no explota la variación del tratamiento intraescuelas. A saber, agregamos los datos a nivel de centros educativos a fin de conformar un panel balanceado de escuelas para los años 2006 y 2009. El modelo estimado es:

el cual se ajusta con efectos fijos a nivel de escuela. Se presentan errores estándar anidados a nivel de escuela.

III. Resultados

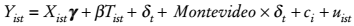

El Cuadro 4 reporta los resultados que se derivan de estimar un modelo de efectos fijos a nivel individual -véase la ecuación (1) en la sección II-, que incluye regresores que varían en el tiempo. Los errores estándar están anidados a nivel de escuela. Las variables que cambian en el tiempo incluyen el número de personas que viven en hogar, el número de habitaciones que tiene la casa, el acceso a agua potable, los bienes duraderos (teléfono, televisión de cable, DVD, horno de microondas, lavadora de ropa y lavadora de trastes) y una dummy que indica si el niño trabaja. De acuerdo con este modelo, pareciera que el Plan CEIBAL tiene un efecto significativo y positivo en matemáticas: tras un año de su aplicación, las puntuaciones en matemáticas aumentan en 0.16 desviaciones estándar. Ahora bien, si tomamos en consideración únicamente las observaciones de las provincias (esto es, excluyendo Montevideo), si bien la magnitud del coeficiente es similar, el efecto ya no resulta significativo. Adviértase que la variación en el tiempo de exposición al Plan CEIBAL se mantiene aun tras excluir a Montevideo: se da un máximo de exposición de casi dos años y un mínimo de virtualmente unos cuantos días cuando la segunda prueba tiene lugar en octubre de 2009 (véase el Cuadro 1).

CUADRO 4 Efectos fijos a nivel individual (2006-2009)a

a Se reportan errores estándar anidados a nivel escuela.

*** p < 0.01, ** p < 0.05, * p < 0.1.

El cuadro 4 no controla por la heterogeneidad potencial que haya en la tasa de avance en el rendimiento estudiantil logrado a lo largo del tiempo por las escuelas en ausencia del programa OLPC.

A fin de evaluar si preexisten diferencias entre las regiones, empleamos datos suministrados por las autoridades educativas (la ANEP) sobre la antigüedad de los maestros (el porcentaje de maestros con menos de cinco años de antigüedad) en todas las escuelas públicas de Uruguay. Para estimar el efecto de las tendencias diferenciales por región sobre la antigüedad de los docentes a nivel de escuela incluimos dos variables dummy: Montevideo X (interactuado) 2006 y Montevideo en 2007, al igual que dummies de tiempo y efectos fijos a nivel de escuela. Se reportan errores estándar robustos anidados a nivel de escuela. Se observa una evolución diferencial de la antigüedad docente en Montevideo y en el resto del país durante 2007, la cual fue significativa a 1% (véase el Cuadro 5). Esto sugiere que no deberíamos estimar la ecuación (1) sin controlar por las trayectorias divergentes que sigan las distintas regiones. De lo contrario, el tratamiento se confundiría con las diferencias preexistentes en las trayectorias de aprendizaje.

CUADRO 5 Verificación de la importancia de los cambios regionales que ocurren a lo largo del tiempo en la antigüedad docente, con base en los efectos fijos a nivel de escuelaª

FUENTE: cálculos por nuestra cuenta utilizando el Monitor Educativo (ANEP).

ª Los errores estándar están anidados a nivel de escuela.

*** p < 0.01, ** p < 0.05, * p < 0.1.

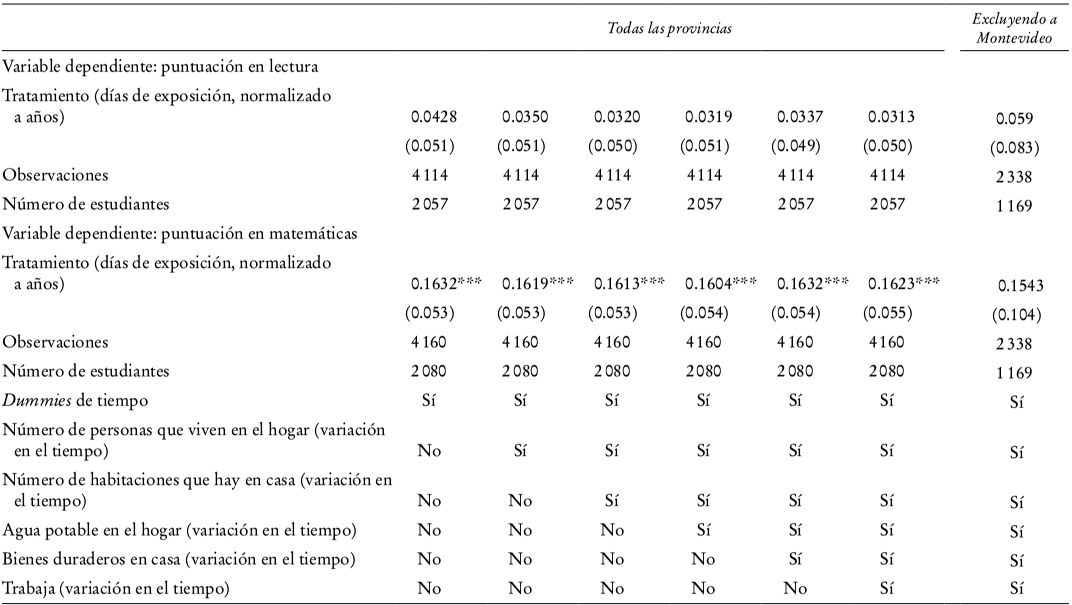

Para enfrentarnos a esta cuestión, estimamos a continuación el modelo de efectos fijos a nivel individuo, incluyendo los dummies de tiempo-escuela -ecuación (2) en la sección II, Cuadro 6-. De acuerdo con esta especificación, el efecto que habría tenido el Plan en matemáticas deja de ser significativo. Es posible incluir dummies de tiempo-escuela gracias a que existe una variación de 2% en el tratamiento al interior de las escuelas. De todos modos, dado que la variación no es muy grande y, por ende, los errores estándar se incrementan de modo significativo, en la última columna del Cuadro 6 sustituimos las dummies de tiempo-escuela por una dummy de tiempo-Montevideo -ecuación (3) en la sección II-. Bajo esta especificación, que es nuestra preferida, el efecto del tratamiento en matemáticas no es significativo. Bajo esta especificación, los errores estándar son comparables a los de Cristia et al. (2012) para matemáticas.

CUADRO 6 Efectos fijos a nivel individual incluyendo dummies de tiempo-escuela o dummy tiempo-Montevideo (2006-2009)ª

a Se reportan errores estándar anidados a nivel escuela.

*** p < 0.01, ** p < 0.05, * p < 0.1.

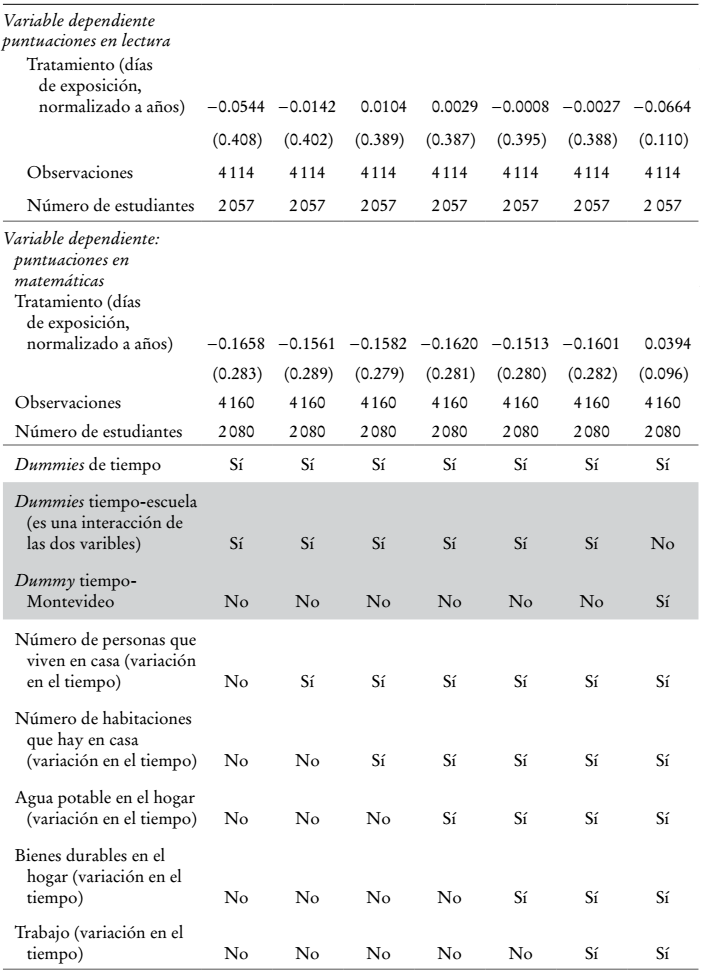

A continuación, descartamos la variación en el tratamiento al interior de las escuelas con el objeto de estimar el impacto del programa con datos a nivel de la escuela -ecuación (4) en la sección II, Cuadro 7-. Una vez que nos concentramos sólo en la variación del tratamiento a nivel escuelas y permitimos la presencia de heterogeneidad en las trayectorias de aprendizaje que se perfilan en Montevideo y en el resto de Uruguay en ausencia del programa OLPC (esto es, al incluir un dummy de tiempo-Montevideo), no observamos un impacto significativo en lectura o en matemáticas. De igual manera, si estimamos el modelo excluyendo a Montevideo (y por tanto sin incluir una dummy de tiempo-Montevideo), tampoco vemos que exista un efecto significativo en matemáticas, y la magnitud del coeficiente desciende sustancialmente.

CUADRO 7 Análisis concentrado exclusivamente en la variación entre las escuelas

a Se reportan errores estándar anidados a nivel escuela.

*** p < 0.01, ** p < 0.05, * p < 0.1.

Finalmente, indagamos si se dan efectos heterogéneos entre los niños cuyas madres tienen diferente nivel educativo, según la principal especificación del Cuadro 6 (incluyendo una dummy tiempo-Montevideo), y encontramos que no se observan efectos significativos en lectura ni en matemáticas (véase el Cuadro 8).

CUADRO 8 Efectos heterogéneos debido a la educación de la madreª

a Los errores estándar están anidados a nivel de escuela.

*** p < 0.01, ** p < 0.05, * p < 0.1.

Los Los cuadros A3 y A4 intentan proporcionar algunas pistas acerca de las razones por las que el Plan CEIBAL no parece haber causado un impacto en lectura o en matemáticas. En primer término, la utilización de las laptops en el aula no está diseminada a lo largo de todas las escuelas públicas (véase el cuadro A3) . En segundo, según lo sugiere el cuadro A4, lo cierto es que la mayor parte del tiempo los estudiantes emplean su ordenador para buscar información en internet (68% de ellos respondió que en el salón de clases lo más frecuente es usar la laptop para hacer tales pesquisas) en vez de resolver ejercicios o llevar a cabo prácticas de repetición.12 El hecho de que las laptops sean usadas en clase principalmente para bajar información del internet sugiere que no deberíamos esperar impactos en lectura y matemáticas.

Conclusiones

El presente estudio usa una estrategia de diferencias en diferencias (DiD) para estimar el impacto de Plan CEIBAL (un programa OLPC implementado en Uruguay a escala nacional) en el desempeño en pruebas de lectura y matemáticas. Tenemos información precisa sobre la fecha en que cada estudiante recibió su laptop. El estudio detecta diferencias sistemáticas en la evolución de los insumos para la educación en diferentes regiones de Uruguay a lo largo del tiempo. Por esa razón, aquí estimamos el efecto del programa OLPC neto de diferencias en variables inobservables que hacen que estudiantes en escuelas de Montevideo y estudiantes en escuelas del resto de Uruguay sigan potencialmente diferentes trayectorias de aprendizaje a lo largo del tiempo en ausencia del programa. Dado que existe variación en la fecha de entrega de la laptop dentro de cada escuela, ajustamos también una especificación que permite a cada escuela tener una trayectoria de aprendizaje (curva de aprendizaje o learning growth curve) diferente a lo largo del tiempo. Dicha curva de aprendizaje es función de características de la escuela que son inobservables y que cambian lo largo del tiempo.

Nuestros hallazgos sugieren que el programa no tuvo impacto en la puntuación alcanzada en lectura y matemáticas. Estos resultados son similares a los reportados en la literatura sobre el efecto del uso de las computadoras en el aprendizaje, donde se encuentra que no existe efecto o que hay un efecto negativo (Angrist y Lavy, 2002; Vigdor y Ladd, 2010; Malamud y Pop-Eleches, 2011; Cristia et al., 2012 y Fairlie y Robinson, 2013). Un rasgo importante del programa es que, hasta ahora, la capacitación del maestro ha sido opcional. Más aún, el análisis descriptivo de los datos revela que el uso de las laptops en clase no es generalizado en escuelas públicas. Además, el principal uso de las laptops en clase es la búsqueda de información en internet más que el entrenamiento a base de ejercicios y prácticas de repetición o drills. Ello sugiere por qué no habría de esperarse un efecto en habilidades como lectura y matemáticas.

Tanto Luckin et al. (2012) como Fullan y Langworthy (2013) hacen hincapié en que la tecnología no puede impactar el aprendizaje a menos que transforme el proceso enseñanza-aprendizaje. Para lograrlo, la tecnología tiene que dejar de ser concebida como una herramienta para reunir información y ser vista como un instrumento que cambia radicalmente la enseñanza y el proceso de aprendizaje. En este contexto, el papel del maestro deja de ser el de trasmitir conocimiento para ahora estimular actitudes de aprendizaje, apoyar el aprendizaje entre pares, y ayudar a que los niños transformen información en conocimiento (Luckin et al., 2012; Fullan y Langworthy, 2013). Fullan y Langworthy (2013) sugieren que la tecnología afecta el aprendizaje sólo cuando se usa como herramienta para estimular la motivación intrínseca y crear compromiso con la mejora continua del proceso enseñanza-aprendizaje, así como cuando se usa para mejorar la comunicación y el trabajo colectivo entre maestro y estudiantes. De acuerdo con estos autores, la tecnología juega un papel importante en estimular el aprendizaje autodirigido porque permite al estudiante construir conocimiento y significado al realizar búsquedas e investigaciones usando el internet como fuente de información. La tecnología puede asimismo brindar retroalimentación instantánea y mejorar la comunicación entre maestros y alumnos, llevando potencialmente la experiencia de aprender fuera del aula de clases. Sin embargo, a pesar de las ventajas y promesas que el aprendizaje asistido por computadora hace potencialmente disponibles, Fullan y Langworthy (2013) nos recuerdan que al final el proceso enseñanza-aprendizaje es intrínsecamente humano. Como tal, la tecnología sólo puede rendir fruto cuando tanto estudiantes como maestros interactúan con la máquina de forma continua e imaginativa para transformar el proceso enseñanza-aprendizaje con el objetivo de mejorar la comprensión y el desarrollo de habilidades.

El Plan CEIBAL ha integrado esta visión en los últimos años, incorporando muchos programas que ayudan a los maestros a utilizar la laptop en clase. Los estudiantes analizados en el presente estudio recibieron sus laptops cuando el Plan CEIBAL apenas había comenzado y, por consiguiente, durante su paso por la primaria no se beneficiaron de los cambios realizados a últimas fechas en la implementación del programa. En investigación futura sería particularmente interesante evaluar el impacto de los cambios en Plan CEIBAL sobre el aprendizaje y sobre otras variables de respuesta importantes.

Es preciso realizar una clarificación no menor. El hecho de que encontremos que el uso de computadoras no tiene efectos significativos sobre el logro escolar no implica que juzguemos fútil el empleo de computadoras para el aprendizaje en la escuela. Sin duda puede darse el caso de que el uso de computadoras contribuya a estimular el desarrollo de habilidades cognitivas distintas a las que se miden en los exámenes de matemáticas y lectura. Por ejemplo, basándose en la prueba de matrices progresivas de Raven, otros estudios han encontrado que pueden generar un impacto positivo en algunas habilidades cognitivas (Malamud y Pop‐Eleches, 2011; Cristia et al., 2012).

nueva página del texto (beta)

nueva página del texto (beta)