Clasificación JEL: B41, B52, C63.

Introducción

En la actualidad existen dos paradigmas principales del conocimiento microeconómico: el neoclásico poswalrasiano (Bowles y Gintis, 2000a) y el evolutivo (Dosi y Winter, 2000; Hodgson 1993); el primero de ellos es considerado como la ortodoxia del siglo XX dado su predominio en los campos de la enseñanza, la investigación científica y la aplicación de políticas públicas. La economía neoclásica, apegada a la mecánica newtoniana, se distingue por estar basada en cuatro pilares fundamentales: preferencias exógenas, actores representativos, racionalidad y equilibrio, en tanto que la economía evolutiva, vinculada a la biología darwiniana, rechaza estas premisas y proclama la necesidad de modelar los fenómenos socioeconómicos como sistemas abiertos caracterizados por la continua adaptación al entorno.

Mientras que el enfoque neoclásico poswalrasiano tiene un cuerpo de premisas muy claramente definido, como se observa en los libros de texto de microeconomía más respetados (Varian, 1992; Kreps, 1990, y Mass-Collell et al, 1995), el paradigma de la economía evolutiva está constituido por un conjunto disperso de tribus cuyas premisas metodológicas no son compartidas por todos sus seguidores (Tavares-Silva, 2004). La gama de enfoques es muy variada, al abarcar desde los economistas que tienen un posicionamiento posschumpeteriano à laNelson y Winter (1982), en el que el crecimiento se da en un contexto de incertidumbre y el cambio tecnológico surge del éxito de innovaciones adoptadas por empresas que buscan satisfacer ciertas metas mínimas de desempeño, hasta los economistas de corte institucionalista à laVeblen (1919) que destacan el papel de los hábitos y las normas sociales para explicar el comportamiento económico y la creación de instituciones formales que restringen el accionar humano.

Si bien algunos economistas evolutivos emplean instrumentos formales para elaborar sus teorías (simulaciones numéricas en el caso posschumpeteriano y juegos evolutivos en el caso institucionalista), pareciera que la falta de metodologías de uso generalizado ha minado las posibilidades de que este paradigma sea aceptado por un grupo más amplio de economistas. Por lo contrario, la escuela neoclásica de pensamiento ha extendido su dominio en la investigación económica gracias al uso de un sólido aparato analítico, como lo es el conformado por el cálculo diferencial e integral, las ecuaciones diferenciales o en diferencia, la topología y, más recientemente, la optimación dinámica y la teoría de juegos clásica.

Así, la debilidad metodológica del enfoque evolutivo vis à vis la concepción neoclásica tiene relación, en primer término, con la falta de una metateoría que haga explícitas sus premisas y le dé congruencia al marco teórico con que estudiar el comportamiento humano y la manera en que éste es condicionado por la estructura en la que se desenvuelve y, en segundo término, con la carencia de instrumentos formales que permitan formular y verificar hipótesis concretas del desempeño colectivo de actores cuyas acciones individuales se realizan con algún propósito. En atención a lo anterior, el objetivo de la sociomática es integrar elementos que se encuentran dispersos en la bibliografía científica para superar estas deficiencias y, con ello, darle forma a otro programa de investigación en el que el avance teórico se dé a la par de la verificación empírica.

Cabe destacar que este enfoque evolutivo no se circunscribe a la esfera económica ya que también permite explorar planteamientos que tradicionalmente han sido estudiados desde otras disciplinas sociales (historia, sociología, antropología, psicología social y ciencia política), lo que es posible gracias a la posición abierta que adopta en relación con el condicionamiento de la conducta humana. Por otra parte, los instrumentos utilizados en la sociomática son de dos tipos: la modelación de agentes de software que se desenvuelven en mundos in-silico o sociedades artificiales, y la construcción de modelos matemáticos no lineales con agentes heterogéneos que hacen uso de la simulación numérica para explorar hipótesis. En consecuencia, el término sociomática se identifica con el estudio de los procesos sociales mediante el uso de tecnologías informáticas que permiten realizar simulaciones con agentes que actúan de manera descentralizada (de abajo-arriba).

1. La construcción de una metateoría según el paraguas de la teoría de la complejidad

Con el paso de los años la economía evolutiva se ha insertado dentro de una visión científica mucho más amplia, como la que ofrece la teoría de la complejidad, y al apelar no sólo a argumentos biológicos evolutivos sino también de la física cuántica y la química del desequilibrio (Nicolis y Prigogine, 1989; Auyang, 1998). El estudio de los fenómenos socioeconómicos con el concepto de sistemas adaptables complejos (o CAS de acuerdo con sus siglas en inglés) ha hecho posible identificar principios universales que anteriormente pasaban inadvertidos y disponer de un instrumental poderoso con el que explorar una amplia gama de teorías.

En este artículo se presenta una metateoría que ayuda a formular planteamientos adaptativos para explicar lo que sucede en las arenas socioeconómicas, en el entendido de que los seres humanos se desenvuelven en distintos CAS. Si bien es cierto que la teoría de la complejidad habla de un orden universal que se manifiesta con la presencia de la autoorganización en fenómenos naturales y sociales (Waldrop, 1992; Kauffman, 1993), también es evidente que la dinámica evolutiva varía de un ámbito a otro. En particular, las capacidades cognitivas del individuo, la intencionalidad de sus acciones y el andamiaje institucional en el que se desenvuelve hacen imprescindible la construcción de una metateoría propia para modelar el comportamiento humano y la dinámica colectiva que propicia su interacción.

La creación de mundos in-silico para el estudio de los CAS socioeconómicos es poco rigurosa cuando no se cuenta con una metateoría. En particular, el investigador requiere ser muy preciso al especificar cuáles son los mecanismos de formación de expectativas y toma de decisión de los agentes. Aunque la teoría de la complejidad busca entender comportamientos colectivos complejos a partir de reglas individuales sencillas, la simplicidad de estas reglas no impide que su formulación esté basada en elementos realistas del comportamiento humano. Por esta misma razón, el concepto de interacción local que caracteriza a esta teoría resulta vacío si no se define la estructura socioeconómica en la que se desenvuelven los miembros de la comunidad en estudio.

La elaboración de esta metateoría no parte de 0, ya que las piezas principales del rompecabezas ya han sido elaboradas por distintos autores. Estas piezas se encuentran dispersas, principalmente, en la bibliografía de economía evolutiva, experimental, del comportamiento, institucional y en la sociología económica; campos que a su vez se han enriquecido con metáforas y evidencias provenientes de otras disciplinas sociales. Al marco metodológico que surge de este proceso de ensamblaje se le denomina “teoría evolutiva de la agencia humana” (o ETHA por las siglas del término en inglés). Esta metateoría de la sociomática va más allá de sencillas modificaciones al esquema neoclásico a pesar de retener la premisa de que los individuos se comportan de manera intencionada. Según la ETHA el comportamiento humano es condicionado por factores socioculturales, dado que un proceso de inserción social es el que le da forma al aparato analítico de la toma de decisiones del individuo.

2. La simulación por medio de sociedades artificiales y ecuaciones dinámicas no lineales

Aparte de la congruencia que ofrece una metateoría, el éxito relativo de un paradigma científico depende de la existencia de un conjunto de instrumentos con los que plantear y verificar hipótesis. La formalización matemática de la economía neoclásica en la segunda parte del siglo XX coadyuvó a que ésta se posicionara muy por delante de otras disciplinas sociales en términos de rigor teórico. Ejemplos de esto son el uso de la teoría de probabilidad para modelar la toma de decisiones en un contexto de riesgo, la aplicación de la optimación dinámica para incorporar la intertemporalidad de dichas decisiones, la aplicación del teorema de punto fijo para modelar la formación de expectativas, la adopción de la teoría de juegos clásica para formular decisiones estratégicas en intercambios en los que el número de actores es reducido y el vector de precios no está dado y, finalmente, el desarrollo de técnicas econométricas para verificar hipótesis cuando la base de datos no proviene de un diseño experimental.

Por ello, la teoría de la complejidad y la sociomática requieren instrumentos propios que les permitan explorar hipótesis con un enfoque diferente del neoclásico. En la medida en que no se haga uso de estos instrumentos los planteamientos teóricos que se formulen resultan ser meramente especulativos, las exposiciones narrativas tienden a apoyarse en relaciones incongruentes difíciles de detectar, y las críticas esgrimidas respecto a los supuestos neoclásicos caen en oídos sordos ante la dificultad que implica modelar matemáticamente agentes y contextos con premisas más realistas.

Por fortuna, la capacidad de cómputo ha crecido de manera exponencial en los pasados tres decenios y, con ello, se ha estimulado la construcción de sociedades artificiales que incorporan elementos no lineales inherente a los fenómenos socioeconómicos. El “dejar crecer” la actividad de los agentes en un mundo in-silico contribuye a explicar lo que ocurre en el mundo real en la medida en que los datos que se producen en la simulación concuerden con un conjunto de estadísticas calculadas a partir de la evidencia empírica. Por tanto, el desarrollo de los modelos computacionales basados en agentes (ABM) ha hecho factible detectar patrones macroscópicos (teoremas de suficiencia) con los que verificar las hipótesis formuladas. Asimismo, la computadora permite identificar patrones por medio de simulaciones numéricas con modelos de ecuaciones no lineales que implican a agentes heterogéneos (HAM) en los cuales la configuración social coevoluciona con el desempeño de variables agregadas socioeconómicas.

3. La sociomática como un programa de investigación de las ciencias sociales

La sociomática no es un nuevo paradigma sino una “tribu” más de la economía evolutiva, la que recientemente ha adquirido una visión más universal al encuadrarse en la perspectiva de la teoría de la complejidad. Tampoco se trata de una disciplina específica, ya que su objetivo es estudiar los efectos colectivos de la interacción de agentes que se desenvuelven simultáneamente en las arenas social, económica y política; descarta de esta manera la visión fragmentada del quehacer humano con la que se identificaron las ciencias sociales a lo largo del siglo XX. Más bien, la sociomática es un nuevo programa de investigación que hace uso de instrumentos capaces de estudiar fenómenos no lineales y establece una bisagra metodológica entre la concepción del mundo propia de la teoría de la complejidad y el estudio de los sistemas adaptables complejos en el entorno socioeconómico; por tanto, la sociomática constituye otra manera de apreciar el mundo socioeconómico que resulta de combinar la teoría de la complejidad con una metateoría del comportamiento humano y un aparato analítico, es decir, sociomática = CAS + ETHA + /ABM HAM.

Este artículo se estructura de la siguiente manera. En la sección I se revisa brevemente los principales conceptos de la teoría de la complejidad. En la sección II se precisa la necesidad de contar con una metateoría y premisas explícitas para que un paradigma sea coherente. En la sección III se define la toma de decisiones del homo socioeconomicus. En la sección IV se analiza el entorno de interacción social y los mecanismos de evolución de los procesos socioeconómicos. En la sección V se hace referencia a los instrumentos no lineales (algorítmicos y numéricos) basados en agentes que dan forma a las simulaciones con las que se plantean hipótesis. En la sección VI se establece la interrelación entre la evidencia empírica y la formulación de modelos basados en agentes computacionales. Finalmente, el artículo termina comentando que dicha metateoría se podrá depurar en el futuro en función de los avances que se logren en la economía experimental y del comportamiento, además de sugerir que la difusión de este programa de investigación hace imprescindible la elaboración de libros de texto que presenten todas estas ideas de manera didáctica y sistemática.

I. Un breve repaso de la teoría de la complejidad

Aunque es cierto que la especialización del conocimiento brinda los beneficios de la profundización también lo es que inhibe el desarrollo de una visión ecléctica de los fenómenos y dificulta la aplicación de metáforas a partir del conocimiento generado en otras disciplinas. La teoría de la complejidad, con su perspectiva interdisciplinaria, ha mostrado que existen determinados principios universales que son igualmente válidos en el campo de la biología, la física, la economía o la sociología, por lo que teorías e instrumentos de análisis creados en una disciplina pueden ser aplicados fructíferamente en otros ámbitos del conocimiento. El valor de las metáforas resulta innegable si se recuerda que la teoría neoclásica provino de una metáfora de la física mecánica, la economía evolutiva de una metáfora de la biología evolutiva, y la biología darwiniana se creó a partir de la teoría maltusiana de competencia en los mercados.

1. ¿Qué es un sistema adaptable complejo?

Flake (1998) resalta tres atributos que están siempre presentes en un sistema adaptable complejo (CAS): i) multiplicidad de agentes, ii) realimentación y iii) adaptación. Es decir, los sistemas complejos están formados por una colección de unidades o agentes que se desenvuelven en una estructura o en torno de interacción, por lo que a pesar de que su comportamiento individual sea muy sencillo, el resultado de su interacción da lugar a fenómenos relativamente elaborados. La realimentación es inherente a los CAS y se manifiesta con la presencia de relaciones bidireccionales agente ↔ agente o agente ↔ entorno, lo que da lugar a fenómenos no lineales y a la coevolución entre variables. La multiplicidad de interacciones hace que el sistema sea relativamente robusto, ya que cuando se produce una falla aleatoria en uno de los agentes la operación de los demás mitiga las consecuencias de dicha falla. Asimismo, la adaptación hace al sistema relativamente eficiente en la medida en que la especialización y la existencia de variantes permiten a unas especies sobrevivir o a unas empresas ser rentables en un entorno de competencia.

La presencia de estos tres atributos lleva a definir a un sistema adaptable complejo como una colectividad de agentes que al interactuar entre sí y adaptarse al entorno produce fenómenos sofisticados (o propiedades emergentes) que no son el resultado directo de las propiedades inherentes a los agentes individuales que lo conforman. Cabe aclarar que el término adaptable puede tomar diferentes matices (Tesfatsion, 2006): i) se habla de una adaptabilidad reactiva cuando las unidades o agentes del CAS exhiben diferentes atributos o acciones con las que responden a las modificaciones que experimenta el entorno; ii) se habla de una adaptabilidad por objetivos cuando, además de ser reactivos, los agentes modifican de cierta manera su estructura interna para alcanzar sus objetivos; iii) se habla de una adaptabilidad planeada cuando además de ser motivados por sus objetivos los agentes buscan tener cierto control del entorno para así mejorar la posibilidad de alcanzarlos.

A partir de estas definiciones, un ejemplo de un CAS reactivo sería el tráfico vehicular en el que los agentes modifican su manera de manejar ante la presencia de lluvia (poca visibilidad, frenos mojados y asfalto resbaloso), pero sin perturbar su estructura interna. En cambio, un ejemplo de un CAS con objetivos estaría dado por un sistema ecológico en el que la presa o el depredador modifican su composición genética al paso de varias generaciones para sobrevivir como especies. Finalmente, un ejemplo de un CAS con planeación sería una empresa cuyos actores cambian sus estrategias de negocios ante nuevos cambios tecnológicos para modificar las condiciones de competencia en el mercado.

2. Los agentes que conforman un CAS

Un agente es una unidad autocontenida (o encapsulada), que tiene sus propias reglas de comportamiento y autonomía de acción (autodeterminación y autoactivación), y cuyo desempeño se manifiesta como producto de la interacción con otros agentes y el entorno en que se desenvuelve. Los agentes pueden ser biológicos (células, organismos, especies), físico-químicos (átomos, moléculas) o sociales (individuos, empresas, organizaciones políticas), y tienen capacidades cognitivas en la medida en que pueden comunicarse socialmente (por medio del lenguaje, la segregación de químicos) y aprender social (las conductas se modifican a lo largo de generaciones) o individualmente (la reglas de comportamiento se modifican con base en la experiencia propia).

Los agentes construidos para estudiar el desempeño de una colectividad en un mundo virtual o in-silico, como los utilizados en los modelos basados en agentes (ABM), son programas de software que representan entidades físicas, sociales o biológicas y que cuentan con métodos (procedimientos para actuar y funciones objetivos por evaluar) y datos (información de su estado, el del entorno y el de sus interlocutores), en tanto que sus capacidades cognitivas se describen como reglas o programas para modificar sus propios métodos. Ejemplos refinados de estos programas de aprendizaje son los algoritmos genéticos y las redes neuronales (Holland, 1995, 1998).

Los procesos de interacción local hacen que un agente (individuo, hormiga, vehículo o empresa) incida en el comportamiento de otro; por ello, se dice que en los CAS predomina la “realimentación positiva” y la no linealidad de los fenómenos. Es decir, las consecuencias de acciones iniciales son magnificadas con el transcurso del tiempo, ya que dichas acciones influyen en el comportamiento de otros agentes. Situación que contrasta con lo que ocurre en los sistemas que se caracterizan por la “realimentación negativa”, en los cuales los efectos iniciales tienden a desvanecerse con el tiempo. Por tanto, los análisis en que el equilibrio es impuesto por el investigador como una condición de congruencia del modelo están, implícitamente, descartando la posibilidad de perturbaciones desestabilizadoras que son endémicas a los CAS.

La no linealidad de un CAS hace que periodos de cambios marginales en las variables macroscópicas se intercalen con periodos de modificaciones drásticas, lo que abre la posibilidad de que pequeñas perturbaciones originen manifestaciones muy diferentes dependiendo de cuál sea la base de atracción en la que se encamina el proceso dinámico. La no linealidad incide en la capacidad de predicción de los modelos que describen a algún CAS, dado que no es posible identificar los hechos grandes con causas grandes y a los pequeños con causas pequeñas. De igual manera, la interacción que caracteriza a los sistemas complejos hace que el aprendizaje adquiera un matiz coevolutivo en el que las acciones de unos dependen de las expectativas que se tengan del comportamiento de otros. Así en un CAS socioeconómico las variables macroscópicas dependen de cuáles sean las expectativas de los individuos que lo conforman y, a su vez, los fenómenos agregados que se observan inciden en la formación de expectativas.

3. Los procesos emergentes y el anidamiento de los CAS

Uno de los elementos más distintivos de un CAS es la presencia de patrones emergentes en los que fenómenos globales y la estructura de una colectividad se producen como resultado de la interacción de sus partes. Dichos procesos emergentes generan un patrón relativamente complejo en la medida en que éste no se puede inferir de manera inmediata a partir de las reglas de comportamiento de los agentes individuales. Asimismo, se dice que la auto-organización de un sistema se efectúa cuando el proceso emergente correspondiente produce una regularidad estadística (Krugman, 1996). De acuerdo con Flake (1998) la naturaleza es muy frugal, ya que los científicos han encontrado una y otra vez que las reglas de interacción de los agentes tienden a ser relativamente sencillas y que éstas suelen aparecer en distintos contextos, independientemente de lo complejo que sea el comportamiento del agregado y de que el CAS se conforme con agentes vivos o inanimados. Así, por ejemplo, cuando se examinan las moléculas del agua de manera aislada difícilmente se puede inferir que un millón de estas moléculas al interactuar entre sí a una temperatura templada produzcan un líquido.

Sin embargo, los patrones emergentes más relevantes son los que dan origen a una mayor complejidad. Esta refinación se genera cuando el orden emergente de un CAS produce elementos permanentes que al interactuar entre sí dan lugar a un nuevo CAS. Por ejemplo, cuando las células que forman un CAS dan origen a un organismo, éste pasa a formar parte de un nuevo CAS en el momento en que empieza a interactuar con otros organismos. De igual manera, los individuos que interactúan en un CAS forman empresas que, a su vez, crean otros CAS socioeconómicos más elaborados como serían los aglomerados industriales y las ciudades.

Un sistema dinámico puede alcanzar gran complejidad cuando surgen componentes fijos como resultado de sus procesos emergentes, los que, a su vez, permiten crear entes que se comporten como agentes. Es decir, se requiere que emerjan elementos estables como la memoria, atributos genéticos, comportamientos, nichos o especies para que se formen agentes autónomos cuya actividad sea independiente de los factores subyacentes que le dieron origen. En este sentido se dice que un CAS es autosimilar puesto que sus agentes pueden también ser considerados como CAS anidados, aunque estos últimos presenten dinámicas particulares. Así, por ejemplo, los genotipos son agentes que inciden en la conformación de los fenotipos que delinean las características físicas de una persona, pero no se puede pensar que estos mismos genotipos tengan relación con patrones culturales de una sociedad y la manera en que los individuos se organizan. Aunque el CAS sociocultural esté construido sobre los pilares del CAS biológico, y el primero no pueda existir sin el segundo, ello no implica que los genes ejerzan un control directo del fenotipo extendido (cultura, tecnología, instituciones).

II. Los fundamentos de la metateoría

Los fenómenos socioeconómicos pueden ser considerados como resultado de la autoorganización de diferentes CAS (empresas, mercados, ciudades, sistemas políticos); sin embargo, para explicarlos a partir de teorías específicas se requiere una bisagra o interfase metodológica que los vincule con el marco general de la complejidad. En sociomática dicho papel lo realiza la teoría evolutiva de la agencia humana (ETHA), la cual sostiene que la naturaleza evolutiva del CAS sociocultural hace que las preferencias, las creencias y las restricciones normativas que acotan la toma de decisiones varíen en el tiempo y en el espacio.

1. Las premisas con las que se construye la ETHA

Los fundamentos teóricos de la ETHA para describir los CAS socioeconómicos están basados en las siguientes premisas: i) el entorno se caracteriza por la existencia de incertidumbre y, en consecuencia, las contingencias que enfrentan los individuos rara vez se pueden identificar por medio de distribuciones de probabilidad; ii) los seres humanos toman decisiones guiadas por incentivos, pero su comportamiento está condicionado por el contexto social; iii) las capacidades cognitivas del individuo para procesar información y analizar deductivamente el entorno a su alrededor son limitadas, por lo que su comportamiento se describe mejor por medio de criterios de racionalidad acotada que destacan sus capacidades inductivas; iv) los sistemas sociales no están formados por agentes representativos (hogares, consumidores, empresas, organizaciones o países), sino más bien por actores socioeconómicos heterogéneos que exhiben diferentes atributos, expectativas o predisposiciones socioculturales; v) el sistema socioeconómico presenta desequilibrios endémicos ya que la novedad o las incongruencias dinámicas perturban con frecuencia el status quo, y vi) la sociedad está compuesta por una multiplicidad de agentes que interactúan de modo cotidiano en un espacio esencialmente local, lo que acota la in fluencia de la realimentación.

Dosi y Winter (2000) sostienen que las teorías que se definen como evolutivas en la bibliografía económica presentan en mayor o menor medida los elementos señalados en los puntos i)-v), en tanto que el punto vi) es una pieza central de la teoría de la complejidad. Cabe destacar, entonces, que sin una metateoría explícita y congruente es poco probable que la perspectiva evolutiva y la teoría de la complejidad puedan desplazar a la ortodoxia actual, y mucho menos sentar las bases para que en un futuro se puedan elaborar estrategias y políticas económicas o sociales con fundamentos científicos más sólidos.

2. El realismo de los supuestos y los problemas abiertos

Aunque la sociomática se identifica con la escuela “realista” del pensamiento social (Archer, 1995), según la cual la verificación de los fundamentos es tan importante como la posibilidad de refutar hipótesis, ello no implica que la complejidad observada en el entorno socioeconómico no se pueda simplificar sin caer en los excesos de un reduccionismo analítico. Así, el estudio de los CAS socioeconómicos se debe efectuar a partir de un marco teórico que destaque los procesos evolutivos, el desequilibrio y la interacción local, a pesar de que ello implique una visión abierta de los fenómenos por estudiar; entendiendo como tal la imposibilidad de describir de manera deductiva las consecuencias de cualquier perturbación en el sistema por no contar con un problema claramente definido.

Indefinición que surge como consecuencia de la falta de un cierre impuesto en el modelo por el mismo investigador con el propósito de eliminar todas las interrelaciones entre diferentes CAS. En el modelo neoclásico dicho cierre se establece matemáticamente incorporando condiciones de equilibrio, distribuciones de probabilidad conocidas ex ante por los agentes, preferencias supuestas axiomáticamente y expectativas racionales. En contraste, en la ETHA las discrepancias cronológicas de los diferentes procesos evolutivos que condicionan el comportamiento humano (biológico, sociocultural, institucional y tecnológico) hacen posible una simplificación del problema al suponer que algunos de ellos se mantienen inalterados para efectos de la explicación de un fenómeno en particular.

Esta visión cuasi abierta del mundo dificulta el uso de instrumentos deductivos para realizar pronósticos, tanto por parte del investigador como de los agentes que componen un CAS. En lugar de ello, la simulación de sociedades artificiales y las simulaciones numéricas de ecuaciones no lineales hacen factible el estudio de los fenómenos dinámicos de largo plazo que preocupan a los economistas evolutivos (crecimiento económico, difusión tecnológica, evolución social, cambio institucional), además de que permiten estudiar problemas que tradicionalmente se analizan desde un enfoque más estático (incidencia fiscal, determinación de precios, acciones colectivas, incentivos contractuales). Estas últimas problemáticas son en realidad dinámicas y se originan a partir de la continua interacción local, por lo que resulta adecuado el uso de la teoría de la complejidad para estudiarlas. Cuando una empresa elige una estrategia de mercadotecnia o un funcionario de Hacienda define una determinada política impositiva, sus consecuencias se derivan de la manera como reaccionan los agentes ante la nueva estrategia y cómo ello incide en sus interacciones cotidianas. Los patrones emergentes correspondientes se pueden observar al dejar correr el tiempo, lo que en términos experimentales sólo se aprecia con simulaciones.

III. El homo socioeconomicus

La teoría evolutiva de la agencia humana se construye sobre la idea de que el comportamiento está condicionado, más no determinado, por factores socioculturales y, en particular, por un proceso de inserción social como el sugerido por Polanyi (1957), Granovetter (1985) y Bordieu (1991). Esta concepción rechaza la definición axiomática de las preferencias y, en cambio, sugiere que las preferencias, creencias y restricciones normativas que acotan el libre albedrío (o agencia) de los individuos son producto de la evolución sociocultural de la comunidad. La ETHA adopta el marco metodológico de la escuela “realista del pensamiento social” al elaborarse sobre la base de aseveraciones ontológicas. Estas aseveraciones son los “axiomas empíricos” que le dan forma a una metateoría del comportamiento humano, los cuales son considerados como válidos mientras no sean descartados por pruebas sólidas que los contradigan.

En la ETHA se considera que varios módulos de comportamiento hacen factible la toma de decisiones y, por ello, la actividad humana se caracteriza por la búsqueda continua de soluciones a los problemas que plantea el entorno (Mantzavinos, 2001). Estos módulos (preferencias, capacidades cognitivas, restricciones normativas-emotivas e interacción social) son producto de la evolución genética y, por ende, comunes a todos los humanos; de tal manera que su naturaleza transhistórica hace posible la elaboración de una metateoría universalmente aplicable. Sin embargo, para que una metateoría sea útil en la explicación del comportamiento agregado es necesario que ésta se ajuste a la especificidad histórica de cada tiempo y lugar (Hodgson, 2001). El hecho de que la interacción social sea uno de estos módulos hace que las prácticas culturales sean específicas a cada comunidad y sociedad y, por tanto, el aparato analítico de la toma de decisiones en la ETHA es condicionado por las normas sociales, hábitos, creencias e ideología que resultan de la inserción social del individuo.

Los diferentes módulos del aparato analítico de toma de decisiones, definido aquí como el homo socioeconomicus, son afectados por tres CAS anidados: psicobiológico, sociocultural y socioeconómico; este último es el que caracteriza a los sistemas adaptables complejos de los dominios superficiales o arenas social, política y económica. Todos estos CAS son producto de la evolución e interacción entre agentes, aunque, sólo el sociocultural y el socioeconómico son pertinentes para analizar la influencia que tiene la historia contemporánea y el contexto social en el desempeño de los individuos en una determinada comunidad o grupo social. Cabe señalar que la visión de que la economía está anidada en un sistema global de la sociedad no es ajena al pensamiento económico, ya que esta formulación se encuentra en los trabajos de Hayek (1967). Para este autor existen tres niveles de evolución: el genético, la producción de la inteligencia humana y el conocimiento en el que se inserta la economía, y el cultural que tiene que se relaciona con la selección de las reglas de interacción social.

1. Los CAS subyacentes como factores condicionantes del comportamiento humano

La pertinencia de los CAS subyacentes del comportamiento humano ha sido documentada en estudios de antropología, biología y psicología (Cartwright, 2000). El CAS psicobiológico es el más profundo, ya que su conformación se realizó durante la etapa de evolución biológica del ser humano; en contraste, el CAS sociocultural se ubica en un nivel superior, porque está relacionado con los procesos cotidianos de interacción social (Dunbar, 1999; Fukuyama, 1999). Cabe destacar que como producto de la coevolución entre estos dos CAS existe una dinámica intermedia conocida como estructura biocultural. Esta dinámica evolutiva influye en los comportamientos que tienen una función biológica pero sin alterar los elementos genéticos que definen a los humanos como una especie, aunque sí ejercen un importante efecto positivo o negativo en la supervivencia de una comunidad (Durham, 1991).

De acuerdo con estudios de psicología evolutiva (Cosmides y Tooby, 1987, y Buss, 1999), la mente humana puede procesar la información que obtiene del mundo exterior, por que el cerebro se estructuró, a lo largo del periodo de evolución biológica, con diferentes funciones y módulos capaces de resolver problemas. Las capacidades cognitivas y emotivas se localizan en áreas específicas del cerebro humano de la misma manera que funciones como la visión, la motricidad y el lenguaje. La mente del humano actual reacciona a entornos que son muy diferentes a los que existían cuando el genoma fue codificado; por tanto, los psicólogos argumentan que el avance evolutivo de la mente no emergió a partir de comportamientos específicos, sino de capacidades psicológicas para procesar información; capacidades que, en consecuencia, pueden generar comportamientos que no existían en la prehistoria.

2. Módulos de toma de decisiones

La ETHA rechaza la concepción del individuo como un agente que sólo se preocupa por obtener los bienes y servicios que le generan bienestar al ser consumidos (preferencias vinculadas a resultados), que sólo realiza acciones motivadas por sus intereses personales (preferencias vinculadas al ego), y cuyos gustos y propensiones se determinan de manera ajena al sistema social (preferencias exógenas). Sin embargo, este planteamiento no rechaza el postulado de que el comportamiento humano se puede analizar mediante un modelo de toma de decisiones que implica preferencias, creencias y restricciones (Henrich et al, 2005; Gintis, 2006).

Por otra parte, la racionalidad es inherente al ser humano ya que existe evidencia empírica derivada de pruebas experimentales de “preferencia revelada” que justifica el modelo de toma de decisiones racional, al menos cuando los problemas están bien definidos (Andreoni y Miller, 2002). Asimismo, apoyado en estudios antropológicos, Gintis argumenta que el razonamiento y la toma de decisiones evolucionaron en los humanos al conferirle a sus portadores una mayor capacidad de adaptación al entorno, a pesar del alto costo que implica que un organismo disponga de cerebros complejos. Este mismo autor presenta pruebas neurofisiológicas en favor de un proceso de decisión en el cerebro humano, en el que los circuitos neuronales realizan elecciones ponderando opciones y asignando valores a cada una de ellas. Cabe señalar que si bien toda esta evidencia apunta en favor de un razonamiento en la toma de decisiones, éste puede ser de índole deductivo o inductivo según sean las circunstancias a las que se enfrenta el individuo.

a) Módulo de preferencias. Las preferencias se codifican en la mente humana tanto por la vía genética como por la cultural. Las predisposiciones genéticas hacen que los individuos guíen su comportamiento a partir de la satisfacción de necesidades básicas asociadas a los problemas de supervivencia y reproducción (Corning, 2005), que Sen (1985) identifica como “capacidades para funcionar”. Ahora bien, cabe resaltar la diferencia que hay entre una necesidad básica, que es un requisito funcional (sexo, agua fresca) que debe ser cubierto de una manera u otra por el individuo y la sociedad a la que pertenece, y un deseo o mecanismo psicobiológico de motivación (por ejemplo, sexualidad, consumo de bebidas). Por ello las preferencias del individuo se integran por dos valores: los primarios asociados a las necesidades básicas universales y los secundarios vinculados a la cultura de una sociedad.

De acuerdo con Ben-Ner y Putterman (1999), las preferencias también se pueden clasificar atendiendo al destinatario de las acciones realizadas y a la pertinencia adjudicada a la forma o fondo de las mismas, por lo que se hace referencia a tres categorías: el interés en el propio beneficio material (ego), el interés en la situación de otros (alter) y el interés en comportamientos específicos. Las preferencias vinculadas a otros agentes se manifiestan por medio del altruismo entre la parentela, el altruismo entre ajenos y la reciprocidad en el proceso de decisión. Las preferencias vinculadas a los comportamientos se relacionan con el hecho de que los individuos obtienen bienestar no sólo de los resultados y el consumo, sino también de la manera en que se llega a dichos resultados. Estas preferencias reflejan la importancia de la posición social de los individuos con respecto a los demás (status) y el interés por desempeñar diferentes papeles en la sociedad (Klüver, 2002).

En años recientes se ha acumulado una gran cantidad de pruebas de las preferencias heterogéneas de los individuos y sus actitudes prosociales (Fehr y Schmidt, 2003). En particular, diversos estudios de economía experimental han encontrado que las preferencias con reciprocidad fuerte resultan críticas para explicar el comportamiento humano (Gintis et al, 2005a; Henrich et al, 2004). De acuerdo con Gintis y sus colegas (2005b), p. 8, la reciprocidad fuerte se define como “una predisposición a cooperar con otros y a castigar (a un costo personal si es necesario) a los que violan las normas de cooperación, aun cuando es imposible esperar que estos costos serán recuperados en una fecha futura”. Aunque la existencia de preferencias heterogéneas y reciprocidad fuerte en una población de seres humanos es un hecho universal que se vincula con la influencia del CAS psicobiológico (Rilling et al, 2002), la pertinencia de estos dos factores en el comportamiento de cada población está más bien asociada al CAS sociocultural.

b) Módulo de capacidades cognitivas. En la ETHA este módulo se define a partir de la premisa de que el sistema cognitivo es racionalmente acotado, en tanto que las inferencias y decisiones del individuo se realizan con restricciones de tiempo, conocimiento y capacidades computacionales (Gigerenzer, 2002). En la bibliografía existen muchas definiciones del concepto de racionalidad acotada; por ejemplo, Simon (1955, 1957), quien acuñó el término, sostiene que la toma de decisiones es un proceso de búsqueda de opciones (escuela, vivienda, socios, proyectos, pareja) con el objetivo de alcanzar una aspiración (ganancias, participación de mercado). En una reformulación de este concepto, el término se asocia más bien al uso de una “caja de herramientas de heurísticas adaptables” en el que la búsqueda se hace mediante señales o criterios para seleccionar opciones específicas (Gigerenzer, 2002; Todd, 2002). Esta caja de herramientas se compone de una colección de reglas sobre tareas específicas que son rápidas (fáciles de calcular), frugales (basadas en información limitada) y cuya racionalidad está más vinculada a su adaptación al entorno que a un criterio de congruencia o coherencia.

El concepto de racionalidad acotada de la ETHA considera que las heurísticas frugales y las estratégicas son críticas en la toma de decisiones en tanto que le dan forma a las capacidades inductivas y deductivas del ser humano, respectivamente. La mente humana hace uso del comportamiento estratégico cuando anticipa las reacciones y consecuencias de sus decisiones, pero también actúa en términos de comportamientos aprendidos, instintos y reglas preconcebidas (hábitos) para resolver los problemas cotidianos cuando el contexto lo amerita. Estudios de psicología evolutiva y de las ciencias cognitivas muestran que los individuos usan reglas de bolsillo cuando se enfrentan a problemas familiares, por lo que no intentan encontrar soluciones analíticas en todas las situaciones (Vanberg, 1994; Todd, 2002; Boyd y Richerson, 2002). Asimismo, Conslik (1980) explica cómo los optimadores (que toman decisiones analíticamente) y los imitadores (que deciden frugalmente) pueden coexistir, por lo que una caja de herramientas que combina heurísticas frugales y estratégicas ofrece una mejor descripción de la realidad.

En este sentido, la ETHA coincide con el enfoque paradigmático de Choi (1993), quien sostiene que las decisiones y los juicios se componen de elecciones lógicas y percepciones de las situaciones que enfrenta el individuo. Debido a la incertidumbre propia de la vida misma, los individuos tienen que crear paradigmas o percepciones que les ayuden a identificar situaciones específicas y así poder emprender ciertas acciones. El uso de paradigmas por parte de los individuos en un contexto de intercambios económicos y sociales continuos produce convenciones y heurísticas sociales de cómo opera el mundo (North, 2005). Es decir, las decisiones son con frecuencia producidas mediante analogías derivadas de un proceso de encuadramiento de patrones, como lo señala la teoría de sesgos cognitivos de Kahneman, Slovic y Tversky (1982). Cuando las analogías no son evidentes y las explicaciones “científicas” están ausentes, los individuos tienen la propensión a crear teorías y paradigmas (dogmas) de acuerdo con sus normas sociales, hábitos, ideologías y creencias.

c) Módulo de restricciones normativas-emotivas. En la ETHA se destaca el acotamiento de la racionalidad impuesta por restricciones normativas. Estas restricciones incluyen instituciones formales (leyes, reglamentos, códigos legales, constituciones) e instituciones informales (normas sociales). Estas últimas instituciones tienen relación con valores morales (por ejemplo, honestidad) y hábitos sociales que inciden en el comportamiento del individuo al rechazar ciertas estrategias, independientemente de los beneficios económicos que puedan representar. Por otra parte, estudios neurofisiológicos muestran que hay circunstancias en las que las decisiones racionales no se llegan a instrumentar cuando algunas emociones no están presentes, incluso en casos en que el individuo está calificado para resolver un problema en papel y lápiz (Damasio, 1994). Las emociones no siempre obstaculizan las decisiones lógicas; por lo contrario, las emociones pueden ayudar a evaluar una determinada situación y facilitar la rápida instrumentación de las acciones (Erev et al, 2002).

Las emociones son muy importantes para la existencia de los intercambios económicos y sociales. Los contratos y compromisos son más creíbles y la reputación es más relevante cuando los individuos se sienten culpables al actuar oportunistamente, cuando están avergonzados si se les encuentra haciendo trampa, cuando se enojan al ser traicionados, cuando muestran una sed de venganza que los lleva a castigar conductas consideradas inapropiadas y cuando los oportunistas potenciales se muestran temerosos ante la amenaza de sanciones (Frank 1988; Erev et al, 2002; Fessler, 2002; Kahan, 2005). Aunque las emociones son atributos compartidos por la humanidad (Tooby y Cosmides, 1990), su relevancia también depende del contexto sociocultural subyacente. Por esta razón, el sentido de culpa no logra aflorar en la mayoría de la población a pesar de que se violen compromisos establecidos si es que prevalece una cultura generalizada de corrupción en la comunidad.

d) Módulo de interacción social. Los individuos logran coordinar sus acciones y su comportamiento se hace más predecible cuando existen convenciones (prácticas sociales recurrentes que se autovalidan). Siguiendo a Young (1996), las convenciones surgen cuando existe un proceso de aprendizaje en el que los individuos adquieren experiencia e información al interactuar con otros. De acuerdo con Schelling (1960) es posible resolver problemas de coordinación aun cuando los canales de comunicación no hayan sido abiertos para estos fines. Esto ocurre cuando existen puntos focales o elementos distintivos en ciertos tipos de acciones. La probabilidad de observar estos puntos focales se incrementa cuando los individuos tienen una cultura y experiencias comunes.

La formación de convenciones (paradigmas sociales) es necesaria para que los individuos puedan tomar decisiones en un entorno con incertidumbre. El uso del razonamiento lógico (congruencia, coherencia y heurísticas estratégicas) en el comportamiento humano sólo es viable cuando la visión del mundo se encuadra en un paradigma específico. En este sentido Choi apunta que las decisiones y las acciones no llegan a materializarse sin un paradigma formado a partir de experiencias pasadas. Dichas convenciones no se crean de manera explícita, sino más bien son producto de la interacción social y se sostienen en la comunidad en la medida en que los patrones emergentes son congruentes con las expectativas formadas a partir del paradigma correspondiente. Aunque las convenciones puedan ser desplazadas, éstas tienden a exhibir un alto grado de inercia. Su estabilidad no sólo depende de la cantidad de individuos que las sigan, sino también de la molestia que les genera a cada uno de ellos el tomar acciones cuyas consecuencias no sean predecibles.

3. La influencia de los elementos culturales en los módulos de comportamiento

Por medio de los cuatro módulos referidos líneas arriba los patrones culturales, representados por normas sociales, creencias y demás elementos emergentes del CAS sociocultural, inciden en el comportamiento de individuos insertados en comunidades específicas. Sin embargo, para identificar qué módulos en concreto son afectados por los diferentes elementos culturales es necesario clarificar el significado de cada uno de estos términos. Una norma social es una regla de comportamiento compartida por todos los actores comprendidos en una relación social y cuya existencia no intencionada proviene de la necesidad de evitar conflictos y mejorar los mecanismos de coordinación (Hechter y Opp, 2001; Knight, 1992; Basu, 2000; Mantzavinos, 2001). A pesar de ser reglas, estas normas al igual que otras instituciones pueden ser consideradas como un resultado de equilibrio ya que nacen de la interacción de los propios actores y son, en gran medida, compatibles con sus incentivos (Aoki, 2001).

Una creencia, en cambio, es una percepción de la “realidad” que los individuos construyen para entender las vicisitudes de los entornos físicos y socioeconómicos, y así esclarecer el proceso de toma de decisiones. Tanto para North como para Choi las dificultades que enfrentan los individuos para lidiar con la incertidumbre los lleva a fabricar un sistema de creencias que se generalizan de manera inconsciente en la sociedad por medio de la interacción social, sin excluir con ello la posibilidad de que determinados sectores sociales manifiesten creencias muy diversas.

En términos del aparato analítico de la ETHA las diferencias entre estos dos conceptos son más explícitas cuando se precisa en qué módulos de toma de decisiones ejercen su influencia. Las normas sociales propician determinadas acciones cuando se han internalizado en el sistema de valores del individuo (módulo de preferencias), o cuando los individuos se autolimitan a actuar de cierta manera, dado que las normas se convierten en preceptos morales (módulo de restricciones). En contraste, el sistema de creencias es un insumo que hace posible la toma de decisiones al crear un entramado de paradigmas sociales, ya sea porque las convenciones que seleccionan equilibrios ayudan a coordinar acciones (módulo de interacción social) o porque la formación de ideologías ayuda a explicar cómo opera el mundo y, con ello, es posible desarrollar modelos cognitivos de decisión (módulo de capacidades cognitivas).

4. El grado de reduccionismo y la relevancia relativa de la agencia y la estructura

Los argumentos narrativos comúnmente encontrados en sociología, historia y ciencia política suelen presentar un reduccionismo débil, en tanto que su análisis considera un sinnúmero de variables con el objetivo de no desfigurar la realidad. De igual manera la operacionalidad de los conceptos es de tipo débil, ya que el significado de éstos no es lo suficientemente acotado como para establecer relaciones causales precisas, lo que dificulta la validación empírica de las hipótesis a partir de métodos estadísticos. En contraste, en la economía neoclásica tanto el reduccionismo como la operacionalidad son de tipo fuerte. Esto es así ya que la explicación de los fenómenos agregados se realiza a partir del comportamiento de individuos atomizados con conductas racionales y preferencias exógenas, supuestos que son muy lejanos a la realidad observada; mientras que el uso de las matemáticas y los procesos deductivos para describir relaciones causales hacen imprescindible que las variables en estudio sean definidas con precisión.

En el enfoque metodológico de la ETHA la operacionalidad de los conceptos es también de tipo fuerte en la medida que se apoya en instrumentos matemáticos y algorítmicos para elaborar hipótesis a partir de la identificación de patrones en datos generados con simulaciones. Sin embargo, su reduccionismo es atenuado, ya que, por un lado, la realidad de los supuestos es una parte relevante de su enfoque y, por otro, la sencillez del modelo y la simplicidad de las reglas de comportamiento resultan ser críticas para entender el fenómeno en consideración. Por tanto, la descripción pormenorizada en la ETHA de los distintos módulos de toma de decisiones no pretende establecer requerimientos mínimos con los que modelar el comportamiento individual; más bien su objetivo es plantear que existe evidencia empírica sólida para fundamentar teorías en las que los agentes socioeconómicos siguen reglas heurísticas, o bien que sus preferencias son condicionadas por determinadas creencias o normas sociales. De esta manera, en algunos modelos es más conveniente simplificar el módulo de preferencias y ser precisos en los mecanismos de aprendizaje, mientras que en otros conviene ser más cuidadosos en la elaboración del módulo de interacción social.

Obviamente, el uso de un modelo u otro está vinculado a la naturaleza del fenómeno por estudiar y a la calidad de la información disponible. Por esta razón es que en la ETHA es común encontrar modelos en los que la estructura tiene un papel protagónico, a diferencia de lo que sucede en el planteamiento neoclásico, en el que la agencia y las restricciones de equilibrio son los únicos elementos relevantes del modelo. Por ejemplo, si el investigador estudia el número de fatalidades que pueden producirse al incendiarse un auditorio tiene más sentido utilizar un modelo en el que la estructura es más relevante que la agencia. En este panorama no tiene caso modelar el comportamiento estratégico de individuos que eligen entre dar codazos para abrirse paso o infiltrarse entre personas poco robustas, o bien considerar si su interés es salvar la vida propia o la de los demás. Resulta indudable que el modelo describirá mejor la realidad cuando plantea reglas sencillas de comportamiento individual y destaca la mecánica de la interacción, en la que se detallan la densidad de agentes en el espacio, los obstáculos que se presentan, la velocidad de propagación del fuego, la dirección de las corrientes, el número y la amplitud de las salidas, entre otras variables asociadas a la estructura.

En este mismo sentido Gode y Sunder (1993), en su estudio con agentes computacionales que comercian mediante el mecanismo de subastas dobles, muestran que la modelación de la estructura institucional es suficiente para explicar el desempeño económico de comerciantes humanos. Para aislar los efectos que en el desempeño agregado tienen la agencia (motivaciones, racionalidad, aprendizaje) y la estructura (reglas para realizar transacciones y restricciones presupuestales), estos autores realizan experimentos con tres grupos de agentes: comerciantes humanos (H), comerciantes de inteligencia cero con restricciones presupuestales (ZI-C) y comerciantes de inteligencia cero sin restricciones (ZI-U). El objetivo de estos tres conjuntos de experimentos es analizar el desempeño agregado en cuanto a la obtención de precios de equilibrio y a la eficiencia del mercado en la reasignación agregada (beneficios obtenidos por todos los oferentes y demandantes en comparación con los excedentes del productor y del consumidor).

Un agente computacional con inteligencia cero y restricción presupuestal es aquel que simplemente elige su precio de compra o de venta de manera aleatoria, siendo su única limitante el que dicho valor esté por encima del costo cuando se trata de oferentes y por debajo de su apreciación subjetiva cuando se trata de demandantes. De esta manera, las diferencias observadas en el comportamiento agregado de los experimentos con ZI-C y los experimen tos con H es imputable a la racionalidad y el aprendizaje de estos últimos; mientras que la diferencia de los experimentos entre ZI-C y entre ZI-U se puede adjudicar a la estructura ya que en ambas circunstancias la racionalidad y el aprendizaje están ausentes.

Los resultados señalan que efectivamente hay un aprendizaje cuando se trata de experimentos con H, ya que los sujetos después de un tiempo relativamente corto logran determinar el precio de equilibrio en las subastas dobles en las que las órdenes de compra y venta se establecen de manera multilateral. Los precios son sumamente volátiles cuando se trata de ZI-U, pero la convergencia al equilibrio se alcanza cuando se trata de ZI-C. Esto último no es resultado del aprendizaje sino de que conforme el tiempo transcurre se estrecha el rango factible de los precios con que se ejecutan las transacciones, ya que los excedentes asociados a las unidades marginales son más reducidos. En cuanto a la eficiencia agregada se encuentra que los valores observados con ZI-C son muy similares a los encontrados en el contexto de comerciantes H pero no así para el caso de los ZI-U, por lo que la eficiencia alcanzada en este tipo de mercados es atribuible de nueva cuenta a la estructura. No obstante, cabe señalar que en estos experimentos la distribución de los beneficios sí es imputable a las motivaciones humanas y al aprendizaje.

Estudios posteriores muestran que el desempeño similar de los ZI y los sujetos humanos es resultado de determinados elementos estructurales del mercado descrito por Gode y Saunder, como lo son las elasticidades de las curvas de demanda y oferta (véase las referencias presentadas en Duffy, 2006). De cualquier manera, el argumento esencial del artículo seminal de estos autores aún es válido, por lo que las capacidades cognitivas de los individuos pueden llegar a ser factores de segundo orden en el desempeño de mercados que se desenvuelven en ciertos entornos. En particular, Duffy sugiere que la modelación mediante actores con capacidades cercanas a los ZI es adecuada cuando se trata de mercados multilaterales y competitivos, pero dicho enfoque no es apropiado cuando el comportamiento estratégico y la formación de expectativas son importantes; en este tipo de entorno resulta más conveniente modelar los procesos de aprendizaje de manera pormenorizada.

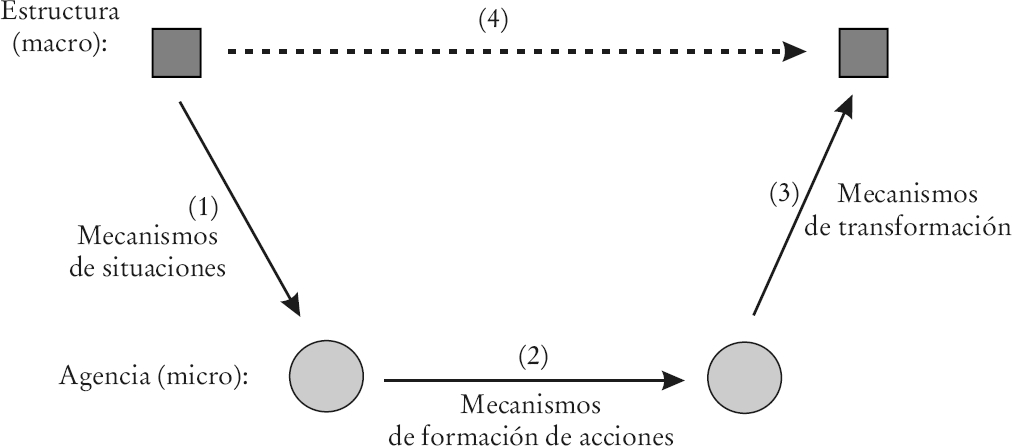

IV. El dilema agencia-estructura

En la ETHA el dilema agencia-estructura (Vromen, 2001) se aborda con módulos de toma de decisiones condicionados por factores socioculturales que, a su vez, son el legado histórico de transacciones recurrentes realizadas en los CAS superficiales (arenas económica, política y social). Por tanto, el coevolucionismo metodológico de la ETHA genera procesos sincrónicos y diacrónicos entre los distintos CAS que dan pauta a cambios continuos en la agencia y en la estructura aunque con diferentes tiempos (Aoki, 2001). Los CAS anidados del comportamiento humano y su naturaleza evolutiva explican por qué el fenómeno de causalidad acumulada es endémico a los sistemas socioeconómicos, y por qué el desempeño de los individuos, grupos sociales, organizaciones e instituciones está inexorablemente vinculado a su pasado.

1. El gobierno social de una comunidad

Para modelar el proceso de inserción social en la ETHA se hace referencia al concepto de “gobierno social” (social governance), el cual se asocia a la estructura o CAS sociocultural de una comunidad. Atendiendo a la sugerencia de Emiebayer y Goodwin (1994), el gobierno social se define en términos de un conjunto de activos relaciona les, aunque también se considera que el contenido de los mismos y la configuración de la red de interacción son relevantes para el análisis. Es decir, el gobierno social de una sociedad es el conjunto de mecanismos (relaciones sociales y jerárquicas, normas sociales, creencias e ideologías) que condicionan el comportamiento de los individuos en tanto que éstos son miembros de una comunidad o red social (Bowles y Gintis, 2000b, y Durlauf, 1999).

El gobierno social de una comunidad, como todo sistema adaptable complejo, está compuesto de un entorno de adaptación, un algoritmo evolutivo y los patrones emergentes correspondientes. El entorno de adaptación en este caso se refiere al conjunto de “elementos relacionales”, mientras que los patrones emergentes tienen relación con un conjunto de “elementos culturales” básicos o valores fundamentales. El primer grupo de elementos define la topología con la que los individuos de una comunidad se interrelacionan entre sí, ya sea por medio de vínculos verticales (jerárquicos) u horizontales establecidos entre los miembros de una red social o bien entre las redes de una sociedad. El segundo grupo de elementos se asocia a las creencias, ideologías y normas sociales que, al emerger de la interacción social, dan forma al sistema de valores y percepciones de la comunidad que condiciona las motivaciones personales, las restricciones y los mecanismos cognitivos que permiten elegir acciones.

Entre los “elementos relacionales” de la topología del CAS sociocultural se encuentran los siguientes: i) la civilidad que se vincula con las relaciones interpersonales mínimas que contribuyen a eliminar la anarquía y hacen posible la operación de la sociedad; este orden social básico depende del grado de segmentación de las redes sociales y de la centralización del poder en la estructura social (Pye, 2001); ii) la sociedad ci vil que promueve la formación de grupos con la capacidad de proponer y defender causas comunes ante las élites; este elemento se representa en la topología por medio de “puentes verticales” entre los miembros del bloque de poder y los estratos medio y bajos de la pirámide social (Burt, 2005); iii) la cohesión social que está asociada a los conceptos de confianza social, solidaridad, sentido de reciprocidad y grado de parroquianismo (Bowles y Gintis, 2003); se dice que la cohesión es estrecha cuando los cliques son densos y existen muy pocos vínculos con otras redes sociales, en contraste se considera una cohesión extensa cuando las redes sociales se conectan entre sí mediante lazos débiles (Granovetter, 1973); iv) la negociabilidad social que está presente cuando existe transparencia (fluye la información) y hay contrapesos (opciones de salida) en el entorno sociocultural; esta circunstancia es posible en la medida en que existen “puentes horizontales” que conectan a los miembros de diferentes estratos socioeconómicos o redes; v) la plasticidad social que se refiere a la movilidad de los individuos entre diferentes estratos de la pirámide social y a la aceptación de inmigrantes en la comunidad.

Entre los elementos culturales del gobierno social o sistema de valores se encuentran los siguientes: i) el status o papeles sociales que condicionan las acciones de los individuos y que les permiten diferenciarse de otros miembros de la comunidad (Klüver, 2002); el status como criterio de éxito se puede definir de manera meritocrática (depende del esfuerzo y la sagacidad), aristocrática (depende del parentesco y el bagaje social) o patrimonialista (depende de la riqueza y las posesiones materiales); ii) el sentido de identidad que le confiere al individuo un sentimiento de pertenencia a un grupo social, sensación que contribuye a definir el grado de cercanía social que se requiere para ofrecer apoyo incondicional y evaluar la equidad de una acción que afecta los intereses de otros individuos (Landa, 1994); iii) el destino que condiciona el comportamiento del individuo en función de una cosmogonía socialmente inducida, es decir, de un conjunto de ideologías y creencias relacionadas con lo sobrenatural y el papel que la persona desempeña en la vida (Platteau, 2000); iv) las valuaciones personales que establecen la importancia relativa de las motivaciones egoístas y prosociales de la persona; así, una comunidad se considera “individualista” cuando sus miembros están más inclinados a sus intereses individuales (ego), mientras que se considera “colectivista” cuando ponderan con mayor intensidad el bienestar colectivo (alter) (Hofstede, 1980; Triandis, 1995), ya sea por la presencia de una influencia paternalista o por tener una perspectiva igualitaria en la que la mayoría de los actores tienen voz y voto.

2. CAS superficiales e instituciones

La herencia histórica de una sociedad condiciona, por medio de su gobierno social, el comportamiento de sus miembros cuando éstos interactúan en las arenas económica, política o social. En estos CAS superficiales opera un conjunto de instituciones formales y organizaciones que coordinan las transacciones o comportamientos recurrentes de los individuos. De aquí que el homo socioeconomicus elija su comportamiento a partir de preferencias y capacidades cognitivas que se forman al combinar condicionamientos provenientes de cada una de estas arenas superficiales con las creencias, normas sociales e ideologías que caracterizan el gobierno social subyacente. Los dominios superficiales se componen de una diversidad de arreglos (comportamientos y patrones emergentes) como lo son las instituciones formales, rutinas establecidas (acervo del conocimiento de dominio-específico), mecanismos de coordinación y organizaciones formales.

Las instituciones formales e informales son reglas que reducen la incertidumbre y restringen el comportamiento de las personas; sin embargo, en términos analíticos es más conveniente considerar las como “equilibrios” (Aoki, 2001, y Greif, 2006) o propiedades emergentes. De acuerdo con Greif (p. 30) un marco institucional “es un sistema de factores sociales que de manera conjunta generan una regularidad en el comportamiento. Cada componente de este sistema es social en tanto que se trata de factores no físicos, hechos por el humano, y que son exógenos a cada individuo en cuyo comportamiento incide”.

3. El concepto de cultura y la autosimilitud de los CAS

Una definición de cultura para ser analíticamente útil debe identificarse con los patrones emergentes que conforman el acervo histórico de conocimientos y dan forma al contenido de los módulos de decisión. Por tanto, resulta conveniente utilizar una definición de cultura que comprende tanto la información (creencias e ideologías) como las reglas internalizadas (normas sociales) que condicionan el comportamiento humano en los CAS superficiales y que se trasmiten por medio del aprendizaje social (Richerson y Boyd, 1992; Shennan, 2002). Durham (1991), pp. 8-9, presenta una definición que, además de ser ampliamente aceptada por los antropólogos, se ajusta en gran medida a los criterios de la ETHA. Para este autor la cultura es “un sistema de fenómenos conceptuales codificados simbólicamente que son trasmitidos social e históricamente al interior y entre poblaciones”.

En la ETHA el gobierno social o CAS sociocultural sintetiza los precedentes históricos generales de una comunidad por medio del entorno de adaptación social (elementos relacionales) y los patrones emergentes (elementos culturales) que se producen a partir de la interacción social. Ahora bien, como la actividad humana se realiza a fin de cuentas en alguna de las arenas superficiales, los mecanismos de trasmisión (propagación) y los procesos de transformación (selección) de la evolución cultural se localizan en dichas arenas. De esta manera la combinación de transacciones que ocurren con frecuencia en todas estas arenas influye en la generación de patrones emergentes culturales. En este sentido se puede visualizar al CAS sociocultural como el sistema envolvente en el que los entornos económicos, sociales y políticos dan lugar a las creencias, ideologías y normas sociales que afectan el comportamiento del individuo en lo general.

Cada arena socioeconómica se considera como un CAS en sí mismo, ya que exhibe dinámicas propias que son independientes del CAS sociocultural, aun cuando éste genera propiedades emergentes que dan forma al comportamiento del individuo y el sistema en conjunto presenta una estructura autosimilar o fractal. Por esta razón en un CAS económico es posible explicar la propagación de una cierta estrategia empresarial sin que ello incida forzosamente en las otras arenas superficiales, ni tampoco en los “elementos relacionales” del gobierno social. Sin embargo, ello no impide que los comportamientos observados en las arenas superficiales puedan ejercer con el transcurso del tiempo una influencia importante en los “elementos relacionales”, propiciando de esta manera la mecánica evolutiva del CAS sociocultural.

La conectividad de todo el sistema socioeconómico de CAS anidados no produce un comportamiento caótico. Esto se debe a que, por un lado, las propiedades emergentes (energía) que se producen en un determinado CAS son empleadas para restringir la incertidumbre (entropía) en otro de los CAS; es decir, la conectividad entre los CAS contribuye a establecer efectos compensatorios que impiden que la entropía se dispare estimulada por las frecuentes reverberaciones que se producen con la interacción de agentes al interior de cada CAS. Por otro lado, la conectividad entre los CAS, en particular entre los superficiales y el envolvente, es intermitente debido a los distintos tiempos evolutivos con los que cada uno opera.

4. Evolución en el CAS sociocultural

En el proceso de evolución sociocultural las protonormas y creencias particulares están codificadas simbólicamente en los diferentes módulos del homo socioeconomicus y, por ello, el comportamiento asociado (instituciones formales, patrones de acciones y prácticas recurrentes) está sujeto a las fuerzas de selección (imitación, contagio, imposición, adoctrinamiento, competencia en los mercados) en las arenas superficiales (Durham, 1991; Voland et al, 1997). Por tanto, cuando un comportamiento particular se generaliza en la población se dice que el material cultural hereditario subyacente (“elementos cultura les”) ha sobrevivido a las vicisitudes del entorno socioeconómico. En este sentido se puede afirmar que la evolución de tipo darwiniano es también relevante en el CAS sociocultural.

Hodgson y Knudsen (2006) y Hull (1982) afirman que para distinguir entre una evolución darwiniana y una lamarckiana es necesario establecer claramente la diferencia entre el concepto de genotipo (o instrucciones a ser repetidas) y el de fenotipo (comportamiento proveniente de los genotipos), así como especificar la manera en que un genotipo se logra reproducir de un individuo a otro. En el CAS sociocultural sí es posible la recodificación de instrucciones provenientes de la adaptación del comportamiento en individuos que originalmente tenían otras creencias, como se sostendría con una posición lamarckiana. No obstante, no se puede afirmar que este proceso sea estrictamente lamarckiano, ya que en dicho esquema la reproducción de las instrucciones no está acompañada de un proceso de selección, sino que más bien se produce como respuesta única a una adaptación al entorno. En consecuencia, en la ETHA el algoritmo evolutivo puede ser estrictamente darwiniano pero también presentar una mezcla de elementos darwinianos (selección de otras instrucciones) y lamarckianos (recodificación de instrucciones en el propio individuo). A falta de un mejor término para referir a este algoritmo híbrido y con el fin de evitar confusiones se habla entonces de una evolución “darwiniana plus”.

A manera de ejemplo, considérese una comunidad en la que prevalece la confianza y la creencia de que la propiedad privada es inviolable (“genotipos”). En este contexto los individuos recurrentemente dejan el automóvil con las ventanas abiertas o sin seguro (“fenotipo”) a sabiendas de que éste no será robado o vandalizado. Supóngase ahora que, por alguna razón, las fronteras de la comunidad se tornan porosas e inmigrantes con otras creencias se incorporan, por lo que los robos de vehículos empiezan a observarse con cierta regularidad (modificación en el entorno de adaptación). Ante esta perturbación en el entorno social los individuos comienzan a preocuparse por cerrar el auto y reforzar las medidas de seguridad (modificación del comportamiento). Esta nueva práctica mina con el paso del tiempo las creencias de los pobladores originales y la confianza entre ellos mismos (recodificación de instrucciones), por lo que las nuevas actitudes culturales se propagan entre la población por medio de la socialización, educación y el adoctrinamiento de la descendencia.

5. El algoritmo evolutivo en la arena económica

El algoritmo evolutivo en el CAS económico no debe ser considerado como una simple extrapolación de la evolución biológica por dos razones principales: i) los individuos tienen importantes capacidades cognitivas que no están presentes en otras especies, lo que hace que el proceso de exploración de nuevas variantes sea muy diferente, y ii) el entorno socioeconómico fue construido por el propio ser humano, por lo que el criterio de adaptación se define a partir de la herencia cultural y socioeconómica de cada sociedad.

Beinhocker (2006), cap. 13, describe los elementos distintivos de este algoritmo evolutivo. En primer lugar menciona que en el entorno económico la unidad por ser reproducida es el conjunto de módulos que forman parte de un “plan de negocios”; es decir, al igual que en biología las unidades en las que actúa la selección no son diseños o instrucciones particulares, sino bloques de construcción o esquemas (schemas). Estos módulos o rutinas describen diseños específicos de la manera en que puede operar un negocio y la naturaleza del producto; ejemplos de módulos serían los siguientes: plan de ventas, sistema de inventarios, campaña de publicidad, nicho de mercado por abordar, tipo de tecnología por utilizar, arquitectura organizacional. Por tanto, una estrategia consiste en el conjunto de módulos quedan forma a un plan de negocios, por lo que su variedad origina el espacio de diseños en los que actúan las fuerzas evolutivas.

En cuanto al criterio de selección, Beinhocker sugiere que en sociedades cuyo umbral de supervivencia ha sido claramente superado no tiene sentido hablar de un proceso de adaptación biológico. El criterio de adaptación que rige en el dominio económico depende de la herencia cultural y socioeconómica de la sociedad en consideración. Así, por ejemplo, en las sociedades en las que las estructuras sociales son excesivamente jerárquicas y el destino de los pueblos depende de un “hombre fuerte” y su camarilla (dictador, régimen despótico, oligarcas), el criterio de selección de los planes de negocio se vincula con los intereses de dicha camarilla. En contraste, un segundo criterio de selección que opera en sociedades más democráticas y abiertas es la competencia del mercado. En este panorama la rentabilidad del plan de negocios es el factor decisivo que determina el tipo de esquemas que se generalizan en las empresas de una economía. Obviamente, en toda sociedad existen elementos jerárquicos y de mercado que inciden en la selección de planes de negocios; sin embargo, estos últimos son lo que predominan en las sociedades capitalistas contemporáneas, en contraposición con lo que ocurría en las sociedades feudales y aristocráticas.

El papel que desempeña el homo socioeconomicus en este algoritmo evolutivo es trascendental, ya que la exploración de variantes del espacio de diseños se realiza por medio de apreciaciones deductivas, en las que se eligen opciones en función del conocimiento científico y criterios lógicos, las que se combinan con un proceso inductivo de detección de patrones y analogías en el que el individuo elige propuestas con base en ensayo y error. De esta manera, empresarios, directores y gerentes de mandos medios están constantemente buscando innovar y definir esquemas que lleven a la empresa a incrementar su rentabilidad y participación en el mercado. Es indudable que, en el panorama incierto de la arena económica, en la que el conocimiento científico es todavía incipiente, el elemento inductivo tiene mucho más peso en el proceso de exploración de variantes.

6. Dinámica del gobierno social y la evolución institucional

Si bien las normas sociales, las instituciones formales y el desempeño socioeconómico son considerados en la ETHA como propiedades emergentes de un proceso dinámico, en el que una multiplicidad de agentes interactúan localmente, en un momento determinado la herencia histórica de la sociedad (reflejado en el gobierno social) es el factor condicionante de las decisiones tomadas por sus miembros en las arenas superficiales. Por ello, una ruptura institucional extensiva, entendida como un reacomodo en la coevolución de las variables del entorno socioeconómico, es más factible cuando se modifica el sustrato sociocultural. Por otra parte, la presencia de un proceso coevolutivo no quiere decir que deba existir una relación uno a uno entre el gobierno social y las instituciones formales que hacen posibles las transacciones en las arenas superficiales, sino que sencillamente existe una compatibilidad en los patrones emergentes al interior de cada arena y entre ellas.

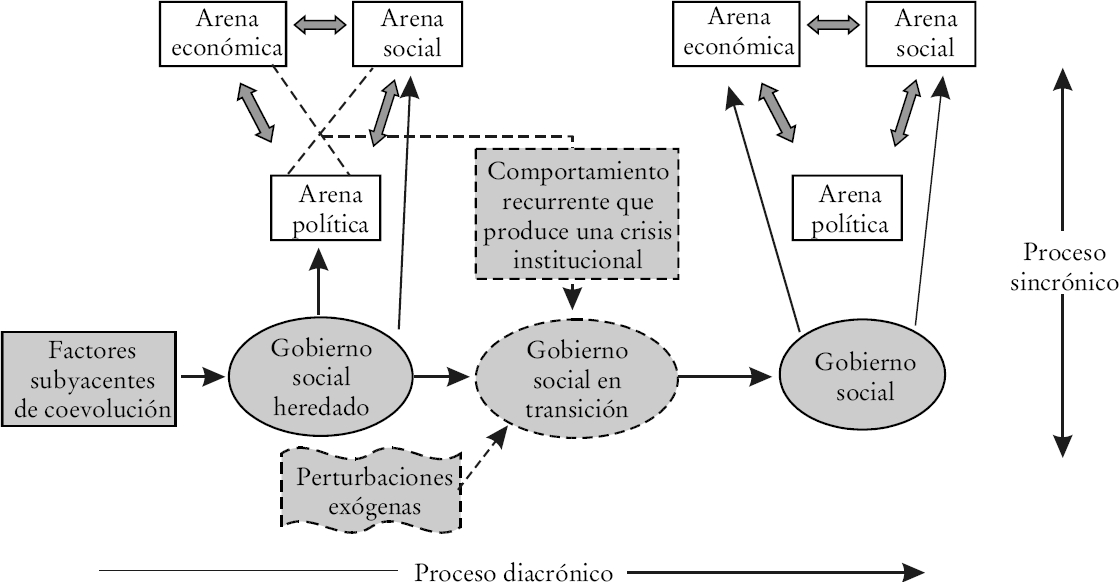

El diagrama 1 muestra esquemáticamente como en cada periodo existe una relación sincrónica entre las diferentes arenas superficiales (flechas gruesas) debido a la inserción social de la toma de decisiones. Paralelamente, un proceso diacrónico tiene lugar entre las arenas superficiales y el gobierno social. Es decir, una vez que una fractura profunda rompe el status quo, se inicia una nueva ronda coevolutiva en el que transformaciones en las arenas superficiales van a la par de las modificaciones observadas en el contexto sociocultural. Dado que el gobierno social y el “conocimiento convencional” de las arenas superficiales sintetizan la herencia histórica de la sociedad, cualquier modificación en las instituciones del ámbito socioeconómico se codifica como parte de esta herencia para las futuras generaciones de la comunidad (Pouillon, 1967, p. 8, y North, 2005).

Al ser el gobierno social un CAS, éste es susceptible de ser modificado a partir de la frecuente realimentación con los dominios superficiales; no obstante, esta estructura tiende a mantener por un tiempo prolongado componentes importantes de la herencia histórica. Algunas de estas propiedades emergentes remotas pudieron haber sido el resultado de elementos exógenos incorporados al sistema por el orden mundial establecido en un pasado distante (origen colonial o legal) o, quizá, provenientes de valores culturales e instituciones formales creadas como consecuencia de consideraciones geográficas (clima, dotación de factores, enfermedades propias del nicho ecológico). La relevancia de esta herencia histórica-remota, definida como factores subyacentes de coevolución (UFC por sus siglas en inglés), se representa en el diagrama resaltando que estos patrones son los factores causales últimos de los gobiernos sociales contemporáneos.

En la bibliografía de la teoría general de sistemas y sinergética los físicos hablan de un “principio de autoconsistencia” en el que cada partícula contribuye a la generación de un campo colectivo (electromagnetismo) y éste, a su vez, incide en la manera en que se mueven las partículas, por lo que la relación cíclica entre causas y efectos puede ser mutuamente congruente haciendo que el sistema se estabilice. Weidlich (2000) afirma que este principio es también válido en el ámbito social, lo que explicaría la inercia institucional. Por ejemplo, en la arena política la democracia es el resultado de la participación activa de los agentes de una sociedad, pero una vez que este sistema se asienta en la vida comunitaria la actividad política se acentúa y con ello se fortalecen los valores democráticos. De igual manera, puede darse una incongruencia dinámica en la medida en que la libertad de expresión y la falta de candados institucionales hacen posible que accesen al poder individuos o partidos con ideologías antidemocráticas.

V. Los instrumentos operacionales de sociomática

Los modelos basados en agente (ABM), también llamados sistemas multi-agente, fueron desarrollados originalmente por expertos de cómputo en el área de inteligencia artificial distribuida (DAI) (Gilbert y Terna, 2000). Estos investigadores encontraron que la interacción entre una multiplicidad de agentes genera soluciones que difícilmente se podrían encontrar con algoritmos que operan de manera aislada. Dado que este enfoque descentralizado es congruente con la premisa básica de la teoría de la complejidad, la comunidad científica apreció con rapidez las bondades del uso de agentes de software para el estudio de sistemas adaptables complejos y, en particular, para explicar fenómenos socioeconómicos (Epstein, 2006, y Epstein y Axtell, 1996).

Si bien en la ETHA la agencia humana se describe a través del homo socioeconomicus, en la que la toma de decisiones se produce a partir de un sistema modular que combina emociones con capacidades inductivas y deductivas, la operacionalización de estos mecanismos en los agentes-objeto de un mundo artificial requiere cierta simplificación de la realidad. Dado que el objetivo principal de la construcción de sociedades artificiales no es predecir sino más bien explicar los procesos sociales, los supuestos de partida deben ser elegidos en función de su sencillez y no por su exactitud. En atención a ello, Axelrod (1997) recomienda adherirse al principio KISS (“keep it simple, stupid”) de acuerdo con el cual modelos relativamente sencillos lo gran captar la esencia del mundo real, a la vez que describen patrones emergentes complejos. Debido a que los agentes de un CAS y los mismos investigadores que lo estudian tienen carencias cognitivas, no tiene sentido incorporar supuestos demasiado elaborados que impidan entender los mecanismos sociales con los que se generan los fenómenos colectivos.