Introducción

La enseñanza y el aprendizaje en ciencias de la salud mediante entornos virtuales forma parte de los cambios que se han promovido de acuerdo con los nuevos paradigmas educativos 1,2. En este proceso la incorporación de nuevas estrategias y metodologías que han utilizado tanto educadores como estudiantes han permitido construir modelos híbridos que asocian el uso de herramientas sincrónicas como asincrónicas en dimensiones formativas y de evaluación 3,4

Sin embargo, la reciente pandemia mundial por Covid-19 forzó y exigió migrar a escenarios virtuales utilizando nuevas herramientas de aprendizaje 5 y adoptar diferentes instrumentos evaluativos 6. En este sentido, una primera etapa del desafío fue capacitar a los docentes en la adaptación de los instrumentos de evaluación mediante los recursos que disponen las plataformas virtuales que ampliamente se han utilizado en educación como Moodle, Collaborate Blackboard y/o Proctortrack 7,8.

En una segunda etapa se ha ponderado revisar el rendimiento de los estudiantes y analizar las variables que intervienen en ello 9,10. Autores mencionan que tanto docentes como estudiantes reconocen factores facilitadores como el uso de métodos digitales ágiles y la flexibilidad temporal en la revisión de recursos asincrónicos, que intervienen en la consolidación del e-learning en ciencias de la salud11,12.

En cuanto a las dificultades y barreras en el rendimiento de los estudiantes, los equipos docentes han detectado las falencias y han diseñado estrategias de mitigación y apoyo como el uso de Moocs 13,14, disponibilidad de instrumentos formativos de ejercitación previa, y herramientas asincrónicas que el estudiante realiza en forma complementaria para apoyar su proceso de aprendizaje 15.

Por otro lado, la observación del rendimiento obtenido en evaluaciones mediante plataforma virtuales se ha puesto en foco revisar dos aspectos; uno de ellos relacionado con la incorporación de estrategias que limiten la copia y el plagio online 16,17, y por otro lado necesidad de examinar la validez, y la rigurosidad en los instrumentos de evaluación18,19. En este sentido Carrillo y colaboradores (2020) han sido enfáticos en alertar y describir sobre las amenazas en la validez de los instrumentos de evaluación formados con preguntas de selección, en los que se presencian vicios como la formulación en negación, la elaboración incorrecta de los enunciados en el uso del lenguaje, el sesgo, las discordancias de dominio, y el testwiseness, con el fin de mejorar la calidad de las preguntas que apunten a ser realmente efectivas 20.

Otras conclusiones en esta temática sugieren revisar en profundidad la validez y la calidad de los instrumentos de evaluación basados en la selección múltiple mediante índice de dificultad, de discriminación, y coeficiente de consistencia interna, que en otros estudios han resultado tener diferencias significativas en la comparación de diferentes instrumentos 21.

Considerando estos indicadores, el índice de dificultad se relaciona con el índice de facilidad (IF) y busca pesquisar las diferencias entre los niveles de conocimiento de los estudiantes para los valores que oscilan entre un 30% y 70%. A modo de ejemplo, un instrumento con IF entre 21% y 34% puede considerarse difícil, mientras que un IF entre 35% y 65% es correcta para el estudiante promedio, y un IF entre 66% y 80% podría interpretarse como relativamente fácil.

Por otra parte, el índice de discriminación (ID) permite establecer la correlación entre las preguntas que dada su habilidad discriminativa es eficiente para separar a los estudiantes con mayor y menor capacidad.

Por tanto, la consistencia interna de un instrumento de evaluación denota el correcto uso de preguntas para diferenciar los grados de conocimiento en torno a una temática y la diferencia de habilidades que presentan los estudiantes. Valores cercanos a un 75% son considerados satisfactorios, mientras que valores inferiores a 64% sugiere la necesidad de someter a revisión y corregir la confección del instrumento ya que las puntuaciones obtenidas podrían deberse al azar, y/o no necesariamente estar aportando la información requerida a partir del aprendizaje y desempeño del estudiante.

Por último, las experiencias en torno a la evaluación virtual en ciencias de la salud han sido enfáticas en sugerir alcances que debiesen profundizarse en materias como: mejorar la gestión y producción de instrumentos de evaluación 22, diseñar e incluir procesos de evaluación que cautelen la seguridad, y confiabilidad del instrumento a través de bancos de preguntas prescindiendo únicamente de la honestidad del estudiante, y sistematizar la instrumentación en los diferentes escenarios de enseñanza aprendizaje en ciencias de la salud; en instrumentos de selección múltiple, destinados a evaluar dominios de primer saber ha sido requerido incluir análisis estadísticos para determinar la consistencia interna y validez 23.

Objetivo

Evaluar los instrumentos de evaluación empleados en la asignatura de Estructura y Función entre marzo y julio 2020 dictados en modalidad online durante la pandemia por COVID-19 y el rendimiento de los estudiantes.

Método

Este estudio corresponde a un trabajo cuantitativo, descriptivo, no experimental, transversal y retrospectivo que consideró el análisis de los instrumentos de evaluación utilizados durante el primer semestre en la asignatura de estructura y función, asignatura que revisa en forma integrada la anatomía y fisiología asociada a los sistemas del cuerpo humano, para las carreras de obstetricia, nutrición, fonoaudiología, kinesiología, terapia ocupacional y enfermería en la Universidad Viña del Mar, Chile. Una vez terminado el semestre el análisis incluyó la valoración mediante estadística descriptiva de la información obtenida a partir de los instrumentos de evaluación rendidos. Se consideró el índice de facilidad (IF), índice de discriminación (ID), eficiencia discriminativa (ED), coeficiente de consistencia interna, número de intentos y rendimiento. Para tales efectos se consideraron los valores de ID según a partir del trabajo de Backhoff et al, que resume el poder de discriminación de las preguntas examinadas según su valor, además incluye una categoría cualitativa y recomendaciones sugeridas. Un ID >0.39 corresponde a una pregunta excelente por tanto debiera conservarse. A su vez, un valor entre 0.30 -0.39 se considera como un reactivo bueno, pero con posibilidades de mejorar. Un reactivo que obtenga un valor entre 0.20 -0.29 corresponde una pregunta de calidad regular que requiere ser revisada. Valores entre 0.00 - 0.20 son consideradas como pregunta pobre que debe ser descartada o revisada en profundidad. Por último, valores negativos corresponden a preguntas de pésima calidad que se sugiere sean eliminadas definitivamente.

Se realizó el análisis de las evaluaciones aplicadas en la asignatura de Estructura y Función, correspondiente a los certámenes I, II, III, IV y el examen formulado mediante un banco de preguntas de selección única. En cuanto a la confección y formulación de los instrumentos de evaluación tanto los certámenes y el examen disponen de la misma estructura y principalmente las diferencias entre los certámenes y el examen radica en el número de preguntas que componen el banco, y el instrumento de evaluación.

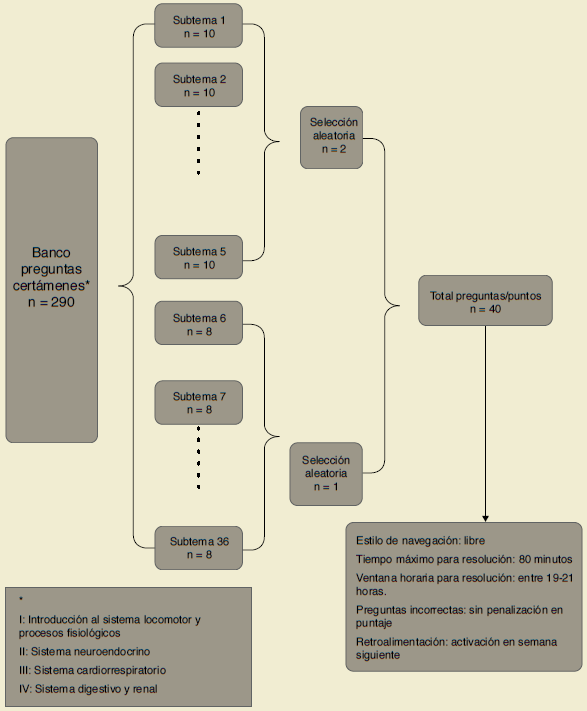

En cuanto al diseño de los instrumentos de evaluación los certámenes I, II, III y IV se configuraron mediante un banco de 290 preguntas. El banco de preguntas, a su vez, se subdivide en 35 bloques que albergan subtemas de contenidos específicos de cada unidad. Cada bloque agrupa entre 8 y 10 preguntas de las cuales se selecciona entre 1 y 2 preguntas aleatorias para la formulación de cada certamen rendido individualmente por los estudiantes. Para los certámenes I, III, IV y examen la complejidad de las preguntas se diseñó de acuerdo con la taxonomía de Bloom; un 60% de las preguntas de cada bloque aleatorio correspondió a niveles bajos de complejidad centradas en preguntas de reconocimiento o recuerdo de información, un 30% de las preguntas incluyó procesos mentales ligados a la asociación/comparación de conceptos claves, un 10% de las preguntas involucraron una complejidad mayor ligada a procesos de interpretación y aplicación. El certamen II siguió la siguiente distribución de preguntas: 50% baja complejidad, 30% dificultad media, 20% mayor dificultad. Cada certamen estuvo compuesto por 40 preguntas y un puntaje total máximo de 40 puntos. Figura 1.

El diagrama representa el proceso de confección utilizado para la creación de los certámenes I, II, III, IV y examen. Certámenes y examen presentan el mismo proceso para su formulación y las diferencias entre ellos, solo recae en el número de preguntas del banco y totales del instrumento de evaluación.

Figura 1 Esquema de formulación de instrumentos de evaluación.

El examen incluyó la evaluación acumulativa de todos los contenidos revisados durante el semestre y consideró un banco de 370 preguntas. Este banco, se compone de 42 bloques que agrupan entre 8 y 10 preguntas, de las cuales se seleccionó entre 1 y 2 preguntas aleatorias para la formulación del examen rendido al final del semestre individualmente por cada estudiante que presentara un promedio de calificaciones <5.5 o alguna calificación reprobatoria <4.0. Para todos los efectos se consideró una escala de calificaciones de 1.0 a 7.0. Cada certamen estuvo compuesto por 50 preguntas y un puntaje total máximo de 50 puntos.

Se utilizaron las siguientes consideraciones para la aplicación de los instrumentos en formato online mediante la plataforma virtual: sólo un intento por estudiante, estilo de navegación libre (el estudiante puede devolver las preguntas si lo desea), tiempo máximo para resolución del certamen y examen de 80 y 90 minutos respectivamente, ventana horaria para rendir la evaluación entre las 19 y 21 horas, sin penalización del puntaje por respuestas incorrectas y la activación de la retroalimentación de las preguntas se realizó a la semana siguiente en horario designado por el docente.

Análisis estadístico

Todos los datos fueron analizados mediante el programa GraphPad Prism 8.01. Los datos se muestran como porcentajes descriptivos y estadísticos de tendencia central. El rendimiento académico obtenido por cada certamen y el coeficiente de consistencia fueron analizados utilizando ANOVA de una vía. Los posibles cambios en el índice de facilidad, índice de discriminación y eficiencia discriminativa fueron analizados utilizando ANOVA de mediciones repetidas.

Resultados

En la Tabla 1, se resumen los antecedentes por cada certamen y/o examen. Se observa una disminución en el número de intentos rendidos entre el certamen 1 (220 intentos) al certamen 4 (189), para finalizar sólo con 162 intentos en el examen. Reducción debida al retiro de los alumnos de la asignatura. Los promedios de los certámenes indicanque las mejores calificaciones promedio fueron del certamen I y IV, siendo éstas un 4.6±0.85 y 4.7 ±0.89 respectivamente. Ambas calificaciones promedio se consideraron aprobatorias. Por el contrario, el rendimiento más bajo fue observado en el certamen II, el que correspondió a un 3.9±0.99, considerándose esta calificación como reprobatoria.

Tabla 1 Caracterización instrumentos de evaluación

| Evaluación | Cert I | Cert II | Cert III | Cert IV | Examen |

| Nº intentos rendidos | 220 | 220 | 205 | 189 | 162 |

| Subtemas (bloques) | 35 | 35 | 35 | 35 | 42 |

| Nº preguntas banco | 290 | 290 | 290 | 290 | 370 |

| Calificación Promedio | 4.6±0.85 | 3.9±0.99 | 4.1±0.83 | 4.7±0.89 | 4.2±0.92 |

| Índice de dificultad | 64% | 54% | 57% | 68% | 59% |

| Coeficiente consistencia interna | 68% | 81% | 71% | 73% | 73% |

| Índice Facilidad (IF) de las preguntas (%) | |||||

| Altamente fácil | 14 | 4 | 4 | 11 | 5 |

| Medianamente fácil | 6 | 7 | 7 | 19 | 7 |

| Dificultad media | 23 | 13 | 59 | 54 | 58 |

| Medianamente difícil | 38 | 46 | 16 | 9 | 13 |

| Altamente difícil | 19 | 30 | 14 | 7 | 17 |

| Índice Discriminación (ID) de las preguntas (%) | |||||

| Revisar y reformular con ajuste menor | 54 | 35 | 33 | 39 | 34 |

| Sugeridas de eliminar | 2 | 2 | 4 | 6 | 14 |

| Conservar | 44 | 63 | 63 | 55 | 52 |

| Eficiencia discriminativa (ED) de las preguntas (%) | |||||

| Débil discriminación | 35 | 17 | 25 | 23 | 21 |

| Inválidas | 2 | 2 | 4 | 6 | 14 |

| Adecuada discriminación | 63 | 81 | 71 | 71 | 65 |

| Rendimiento académico

global |

Obstetricia

Fonoaudiología |

Kinesiología

Terapia Ocupacional Nutrición |

Enfermería | ||

| Aprobación (4.0 | 86% | 78% | 83% | ||

| Reprobación <4.0 | 14% | 22% | 17% | ||

En general el índice de dificultad estable que todos los instrumentos, a excepción del certamen IV es considerado ligeramente más fácil.

Al revisar la consistencia interna, cabe destacar que el mejor desempeño lo obtuvo el certamen II con un 81%, seguido del certamen IV y el examen final, ambos con un 73%. Según los valores de consistencia interna obtenidos todos los instrumentos fueron considerados aceptables y satisfactorios, sin embargo, en el certamen I debieran revisarse ya que obtuvo el porcentaje más bajo (68%).

Precisando el análisis a partir de las preguntas que componen los bancos de preguntas cada instrumento de evaluación, la efectividad de una pregunta para clasificar a los estudiantes más y menos capaces fue adecuada para la mayoría de las preguntas examinadas. Esto correspondió para un 52% a 63% de éstas en los certámenes II, III, IV y examen final. En esta dimensión, para el certamen I, obtuvo un 44%, por tanto, se sugiere la revisión y/o el ajuste menor de un 54% de las preguntas.

Al contrastar con la eficiencia discriminativa, es decir que tan buena es la discriminación en relación con la dificultad de las preguntas, se consideró adecuada en la mayoría de éstas (63%-81%) (Tabla 1).

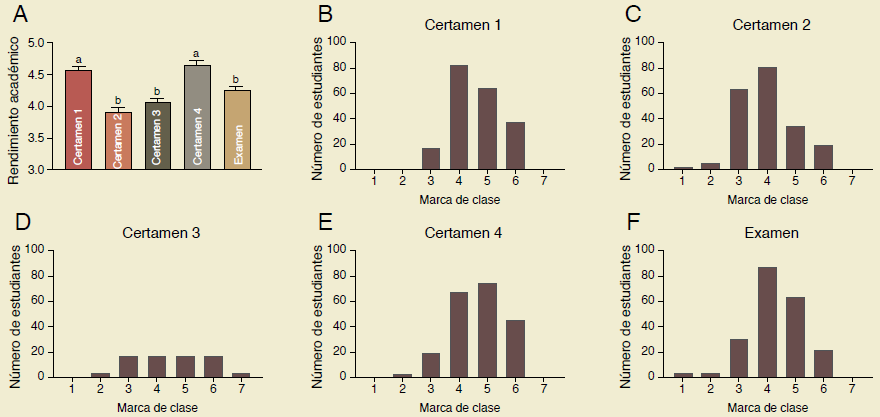

El rendimiento académico en la asignatura de estructura y función durante un entorno virtual se observa en la Figura 2a. El análisis de ANOVA de una vía, demuestra que existen diferencias significativas entre los certámenes (F(4,1009) =25.64, p < 0.0001). El certamen 1 y 4 (Certamen 1: 4.57 ± 0.05; Certamen 4:4.6 ± 0.06) obtuvieron un rendimiento académico significativo más alto en comparación con el certamen 2, 3 y examen (Certamen 2: 3.9 ± 0,07; Certamen 3: 4.0 ± 0.06; Examen: 4.2± 0.06). A partir de las notas de cada instrumento de evaluación se han generado distribuciones de frecuencias de los rendimientos académicos (Figura. 2B-F). En todos los instrumentos de evaluación, el 40.7% de los alumnos concentran sus notas entre el 3.5 al 4.5, mientras que el 17% de los alumnos concentran sus notas entre el 2.5 al 3.5. El 27.8% de los alumnos concentran sus notas entre el 4.5 al 5.5. Se destaca que el 12.8% de los alumnos obtienen notas entre 5.5 al 6.5 (Figura. 2B-F).

a) Se encontraron diferencias significativas entre el rendimiento académico entre los instrumentos de evaluación (p < 0.0001). El certamen 1 y 4 obtuvieron un rendimiento académico significativo más alto en comparación con el certamen 2, 3 y examen. b-f) En todos los instrumentos de evaluación, el 40.7% en promedio de los alumnos concentra sus notas entre el 3.5 al 4.5 (marca de clase 4), mientras que el 17% de los alumnos concentra notas entre el 2.5 al 3.5 (marca de clase 3). El 27.8% de los alumnos concentra sus notas entre el 4,5 al 5,5 (marca de clase 5). Se destaca que el 12.8% de los alumnos obtiene notas entre 5.5 al 6.5 (marca de clase 6). Los datos representan el promedio ± SEM. Letras diferentes, indican diferencias significativas.

Figura 2 Rendimiento académico y distribución de frecuencia.

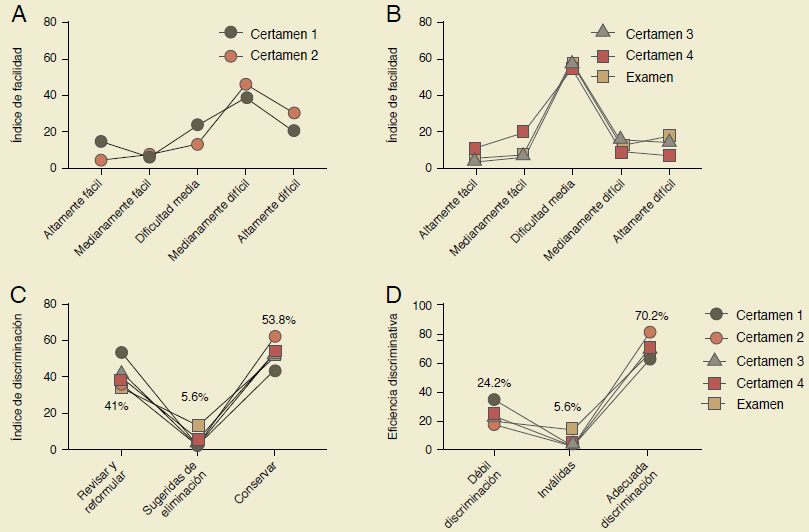

El índice de facilidad o proporción de aciertos entrega información con respecto a las diferencias entre el nivel de conocimiento y preparación de los individuos. En la Figura 3a y 3b se agruparon los certámenes de acuerdo con las características del índice de facilidad. En la Figura 3a, se muestra el índice de facilidad del certamen 1 y 2, que presentan principalmente preguntas de dificultad media, medianamente difícil y altamente difícil, mientras que, en la Figura 3b, se muestran el índice de dificultad de los certámenes 3, 4 y examen, los cuales presentan principalmente preguntas de dificultad media (Figura 3b).

a-b) Índice de facilidad. Se agruparon los instrumentos de evaluación de acuerdo con sus similitudes, porque se pudieron establecer 2 grupos. Un grupo integra a los certámenes 1 y 2 (a), mientras que el otro grupo integra a los certámenes 3, 4 y examen (b). c) Índice de discriminación. Indica qué tan efectivas son las preguntas para clasificar/separar/discernir a los estudiantes que obtuvieron un puntaje alto de los que obtuvieron un puntaje bajo. Las preguntas en todos los certámenes poseen en promedio un 53.8% la capacidad de discriminar. El 41% de las preguntas requiere un ajuste y/o edición para mejorar su capacidad de discriminación, mientras que tan solo el 5% debieran eliminarse. Los datos representan el promedio.

Figura 3 Análisis del instrumento según índices de facilidad, discriminación o eficiencia discriminativa

El índice de discriminación de una pregunta corresponde a la diferencia entre las proporciones de aciertos entre los que obtuvieron un puntaje total de la prueba alto, de los que obtuvieron un puntaje bajo. Por lo tanto, expresa hasta qué punto, la pregunta discrimina y establece diferencias entre los estudiantes de más alto y bajo rendimiento. En la Figura 3c, se observa que el 53.8% promedio de todos los instrumentos de evaluación, permiten una buena discriminación, mientras que un 41% de las preguntas se sugiere revisar y/o reformular para aumentar la discriminación y sólo el 5.6% de las preguntas en promedio se sugiere eliminar por nula discriminación.

La eficiencia discriminativa, estima que tan bueno es el índice de discriminación en relación con la dificultad de la pregunta. El 70% de las preguntas de todos los certámenes poseen una adecuada eficiencia discriminativa, el 24.2% de las preguntas de todos los certámenes poseen una débil discriminación y sólo el 5.6% de las preguntas presentan nula eficiencia discriminativa y se sugiere su eliminación (Figura 3d).

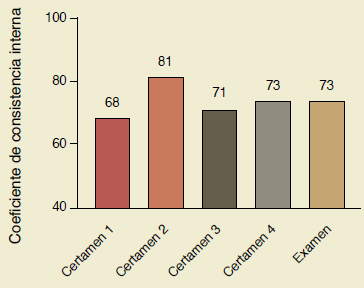

En la Figura 4, se describe el coeficiente de consistencia interna para todos los certámenes y examen, con valores que fluctúan entre el 68% al 81%. Valores inferiores al 64% del coeficiente de consistencia interna indica que el instrumento completo es insatisfactorio y se deberían realizar medidas correctivas. El promedio del coeficiente de consistencia interna para todos los instrumentos de evaluación fue del 73%, por lo que corresponden a instrumentos satisfactorios, cuyas preguntas permiten discriminar entre los estudiantes de más alto rendimiento, de los de más bajo rendimiento, por lo que las puntuaciones totales obtenidas no se deben al azar (Figura 4)

Los valores oscilan entre el 68% y 81%. Con un promedio del 73%. Los certámenes 2, 3, 4 y examen pueden ser clasificados como un instrumento satisfactorio, cuyas preguntas permiten discriminar entre los estudiantes de más alto y bajo rendimiento. El certamen 1 posee un coeficiente de consistencia interna superior al valor de corte. Sin embargo, se sugiere realizar medidas correctivas para incrementar su capacidad de discriminación.

Figura 4 Coeficiente de consistencia interna

Discusión

Considerando el contexto de educación en línea en pandemia el principal criterio ha sido examinar el rendimiento, ya que globalmente se vio incrementado en diferentes disciplinas en ciencias de la salud 24 por las ayudas que en línea los estudiantes logran disponer como apuntes, búsqueda simultánea y/o comunicación por redes sociales entre los estudiantes de mejor y menor desempeño, y plagio entre otros, sin embargo, estudios advirtieron que la educación en línea es menos efectiva que las clases en línea. Otro alcance reportado ante la mejora del rendimiento fue debatir que los procesos de educación en línea presentaban ineficiencia para mostrar integridad y rigurosidad académica 25.

En su contraparte otros estudios revelaron que la mejora del rendimiento se debió al estudio continuo mediante recursos sincrónicos 26 sin embargo, al comparar la preferencia del estudiantado entre la interacción sincrónica y asincrónica, esta última tuvo más adherencia por disponibilidad y comodidad en la flexibilidad que otorga respecto a los horarios destinados a revisar los contenidos 27.

En relación con lo anterior, este trabajo observó performance aprobatoria homogénea en las carreras, pero no registró un incremento en comparación a la modalidad presencial impartida previo a la pandemia. El análisis de los instrumentos aplicados permitió debatir de las fortalezas de este como la disponibilidad de extensos bancos de preguntas y la selección aleatoria de preguntas, lo que permitió que cada prueba/examen fuera prácticamente única y diferente para cada estudiante de la muestra estudiada.

Los hallazgos de este estudio indican que existe una relación entre el índice de facilidad y el índice de discriminación con el rendimiento obtenido en cada uno de los certámenes. Por ejemplo, al revisar el índice de facilidad, el certamen dos es el único instrumento que incluye una mayor proporción de preguntas medianamente difícil y aunque esto pareció impactar en el menor rendimiento obtenido, el certamen dos es el que presentó la mayor consistencia interna de todos los instrumentos evaluados 28. Esta condición observada permite la comprensión de que, la aprobación o resultado general de un instrumento en función del rendimiento, no necesariamente denota validez, confiabilidad y calidad 29.

Por otra parte, la revisión en detalle del certamen dos, permitió observar que las preguntas que implicaban interpretación y aplicación en torno a un caso y/o problema expresado en la pregunta tuvo mayor complejidad para los estudiantes, ya que es requerido una comprensión más acabada de los contenidos, como también de la información entregada en el enunciado (encabezado) de la pregunta 30 .

Al revisar todos los instrumentos, si bien el rendimiento global es homogéneo para todas las carreras, se observaron diferencias significativas en el rendimiento entre los certámenes 1 y 4 quienes obtuvieron una mayor calificación promedio, respecto a los certámenes 2, 3 y examen. Al respecto, el examen reúne acumulativamente todos los contenidos tratados en el semestre, pero a partir de bancos de preguntas más extensos (ochenta preguntas más), que al analizarlos en detalle denotó una mejora gradual en la construcción del instrumento concordante con el informe posterior a ser aplicado: un menor número de preguntas presentaron una débil discriminación y por tanto requieren un ajuste y/o corrección menor. Además, esto se reflejó en la distribución de calificaciones obtenidas por los estudiantes que rindieron el instrumento, ya que se observó una menor dispersión hacia calificaciones bajas o altas, por el contrario, se concentraron las calificaciones cercanas al 4.0. Lo anterior sugiere que los docentes que formularon los instrumentos comprendieron los alcances relevantes entregados posterior a cada instrumento y el proceso de mejora en la formulación de éstos fue guiada, y reveló un perfeccionamiento progresivo, similar a como indica algunos autores en sus estudios 31.

En cuanto a las limitaciones de este trabajo se encuentra el disponer de los resultados y la retroalimentación de los indicadores de las preguntas posterior a la aplicación del instrumento 32 criterio que no pudo ser subsanado, sin embargo, una fortaleza es la posibilidad de mejorar la evaluación sistemáticamente a partir del extenso banco de preguntas examinado y del conocimiento sobre las preguntas que discriminan eficientemente frente a aquellas que presentan debilidad en este ítem 33,34.

Las oportunidades de mejora de este trabajo principalmente se resumen en la obtención de información crítica a partir de los indicadores. El análisis sugiere que una de cada cuatro preguntas requiere revisión y reformulación debido a una débil discriminación. Realizar esta adecuación permite comprender el error en el diseño y perfeccionar su formulación en el banco de preguntas, lo que constituye una instancia de aprendizaje para los docentes y estudiantes 35. En este sentido el informe obtenido a partir de cada instrumento después de ser aplicado se socializó con los docentes, así como también las sugerencias y directrices generales para mejorar la construcción de los instrumentos siguientes.

Conclusiones

Considerando que los procesos evaluativos constituyen un recurso educativo y de aprendizaje a la vez, los instrumentos revisados demostraron consistencia, validez, y pertinencia. El análisis profundo de los instrumentos denotó globalmente ser adecuado, conforme a la complejidad de las preguntas utilizadas en los bancos, y la eficiencia discriminativa de éstas sobre los contenidos tratados para cada unidad temática similar a otros estudios en esta disciplina. Sin perjuicio de lo anterior, la calidad de los instrumentos puede ser superior, si la compresión del análisis es internalizada por los docentes que imparten la asignatura, y se dispone de docentes con competencias y habilidades específicas en educación médica que lideren y guíen el proceso de mejora36,37.

Se sugiere y recomienda a las unidades y/o cuerpos académicos que se encuentran en procesos de transición e implementación de educación online, velen por resguardar una evaluación auténtica; la rigurosidad del proceso metodológico que permite el diseño de un instrumento de evaluación y que éste sea pertinente y concordante en su capacidad discriminatoria, y a la vez, permita mitigar el sesgo en el incremento del rendimiento que no concuerda con un real aprendizaje.

CONTRIBUCIÓN INDIVIDUAL

• GU: Concepción y diseño de la investigación, recolección de datos, escritura del artículo, revisión crítica y aprobación de la versión final del manuscrito.

• MP: Redacción de los resultados, análisis de datos y formulación de la metodología, revisión crítica y aprobación de la versión final del manuscrito.

PRESENTACIONES PREVIAS

Ninguna.

FINANCIAMIENTO

Ninguno.

CONFLICTO DE INTERESES

Ninguno.

nueva página del texto (beta)

nueva página del texto (beta)