Introducción

Ha sido explorada la posibilidad de que el lugar en el que se desarrolla la vida de una persona, que normalmente está formado a través de las obras arquitectónicas y urbanas, juega un papel fundamental en el desarrollo de la mente de los individuos, así como el hecho de que tal papel del medio en esa formación atraviesa por etapas sucesivas y donde el nivel de complejidad de lo que se puede interiorizar del lugar en el que se vive, crece paulatinamente (Muntañola, 1974).

Exteriormente ello se atestigua en un incremento de la capacidad para construir que va desde el diseño de unas formas que son puro exterior en forma de túmulos y en donde solamente se puede tener un punto de vista (cuando uno es uno de los habitantes de ese mundo imaginario), hasta la edificación de formas abstractas que implican además la coordinación simultánea de muchos puntos de vista en un lugar que va siendo cada vez más un escenario diferenciado de los personajes que lo habitan.

Han sido también explorados los procesos a través de los cuales el lugar habitado se traduce en unas maneras de ver y en unos significados colectivamente construidos (Narváez, 2000, 2013, 2015). Estos procesos parecen tener un fondo común que como un magma, donde todo lo que es o puede llegar a ser (existente o nombrado, pensado o inimaginado), se encuentre en potencia. A ese fondo se le ha llamado “lo imaginario” (Castoriadis, 1975) y se ha demostrado que: “lo imaginario parece abarcar nuestra mirada entera. Pensamos a través de él. Vemos solamente lo que nos posibilita ver. Lo imaginario en muchos sentidos es un órgano que habilita al conocimiento, que lo envuelve y ofrece una sustancia a toda la experiencia vital” (Narváez, 2012, 20).

Lo que lleva inevitablemente a ver que esencialmente ese proceso de formación de las mentalidades a través de la incorporación paulatina de la información contenida en los lugares que habitamos, es un proceso colectivo. Este trabajo se interesa en buscar vías para pensar en los modos a través de los cuales este proceso colectivo tiene lugar.

Las ciudades que habitamos parecen proveer la información a través de la que incorporamos a la cultura, que luego se convertirá en el marco -como potenciador y como limitador- de nuestro actuar en el mundo. Es así que es muy evidente el que pensemos a los lugares habitados como un compendio de modos de ver y de comportarse (un orden moral) que se apoya en las representaciones sociales (los elementos de la cultura material e inmaterial) para convertirse (en un proceso que es esencialmente circular y autorreferente), para quien es informado, como toda posibilidad imaginable. Visto de esta manera, este orden subyacente es un lenguaje que como un andamiaje, constituye la estructura en la cual se engarzan los significados, que anclados a los simbólico, envuelve absolutamente todo el espacio y tiempo de la existencia del hombre.

Pero si se piensa que ese andamiaje funciona como un lenguaje, parece natural decantarse hacia explicaciones sistémicas, y de ahí a cuestionarse sobre la relativa independencia de las formas lingüísticas con respecto a las mentes individuales (Chomski, 1970). Popper y Eccles (1977) y Eccles (1999), en su hipótesis de los tres mundos, nos presentan la osada hipótesis de una relativa independencia del mundo de la cultura (a lo que denominan el mundo 3), con respecto a la mente (mundo 2) y al universo físico (mundo 1), que aunque para la construcción de la experiencia humana tienen por fuerza que interactuar, sus procesos de formación parecen no estar condicionados absolutamente por la necesidad de la existencia de los otros marcos de realidad.

Hay un curioso isomorfismo advertido por Narváez (2015), entre ciertos procesos del mundo 1 y del mundo 3, que revelan que los fenómenos advertidos por los defensores de la teoría de los Sistemas Complejos Adaptativos (SCA), podrían tener lugar tanto en el mundo físico como en el dominio de las formas culturales, especialmente en el del lenguaje (Holland, 2004). Por lo que este trabajo, explorando en esta explicación, plantea que los procesos de adquisición de información que proveen los lugares habitados, en la interacción social, generarán respuestas emergentes que se traducirán en estructuras socioespaciales específicas que luego modificarán a los lugares habitados. Suponemos que tales procesos son dependientes de formas específicas de interacción social y de la densidad social que interactúa en el espacio habitado.

Para poner a prueba estas hipótesis, se propone el uso de simuladores computacionales que nos permitan visualizar estos procesos. Como cualquier modelo, los simuladores computacionales tienen unos alcances y unas limitaciones. ¿Qué es un modelo? La palabra modelo proviene del Italiano “modello” término creado durante el Renacimiento en el S. XVI, que a su vez proviene de la locución latina Modŭlus, que puede traducirse como molde, es decir lo que sirve para dar forma a una materia no trabajada, lo que por extensión puede interpretarse como lo que in-forma (otorga o confiere forma), que provee la información y que explica cómo proceder. Un modelo podría ser algo parecido a un mapa. La Real Academia Española integra varias definiciones sobre el término “modelo”; para los efectos que nos interesa tratar se considera la siguiente definición:

“Esquema teórico, generalmente en forma matemática, de un sistema o de una realidad compleja, como la evolución económica de un país, que se elabora para facilitar su comprensión y el estudio de su comportamiento”1.

Como se puede observar en estas definiciones un modelo representa a la forma idealizada a través de la que un investigador o un grupo de investigadores observa a un fenómeno en la realidad. El modelo hace posible la comprensión de la realidad a través de la manipulación del mismo modelo, lo que hace ver a los investigadores aspectos no claros u ocultos a simple vista de la realidad en sí, y que puede ayudar a descubrir la clase de relaciones que existen entre los aspectos que analíticamente pueden distinguirse en el fenómeno que se observa.

Pero no hay que engañarse: todo modelo es en sí una reducción de la realidad no representa a la totalidad del fenómeno que se está tratando de comprender. Un modelo basa su fuerza explicativa en la medida en que se ancla en un paradigma. Paradigma es una palabra que proviene de la locución latina paradigma y esta a su vez del griego παράδειγμα (que puede entenderse como “sobre lo manifiesto” en un sentido de trascendencia no de posición relativa), que a su vez proviene de la locución más antigua παράδείκνιμι, que significa mostrar, manifestar.

Un paradigma puede entenderse como un conjunto de ideas previas o dogmas (no demostrables sino sostenidos per se) que explican cómo funciona la realidad. Estas suposiciones para la ciencia suscitan preguntas que deben ser respondidas por los hechos que se observan y registran, son necesariamente tamizados y escogidos en función de las ideas previas que forman al paradigma en sí. Por lo que se trata de un sistema cerrado fuertemente autorreferente. Los cambios de paradigma estarían entonces relacionados con la incompletitud de los postulados para explicar ciertos fenómenos de la realidad o con la presencia de nuevos hechos nunca antes vistos (sea por su emergencia “espontánea” o por la sofisticación de los instrumentos de observación). Un paradigma puede de esta forma ser concebido como un mapa: representa al territorio, pero nunca podrá ser lo que es el territorio en sí.

Los ABM son concebidos como abstracciones de la realidad que se está intentando reproducir, pero buscando reducir analíticamente a la realidad lo menos posible, abstrayendo las características que se busca comprender y observar sus interacciones desde una perspectiva evolutiva, en este sentido, un ABM puede ser concebido como un modelo, pero a la vez como un sofisticado instrumento de observación.

Toda vez que intenta reproducir a la realidad lo más fielmente posible, reproduciendo las relaciones que podrían darse en el seno de la misma en el tiempo y que resultarían imposibles de analizar en un tiempo razonable por medios tradicionales, se trata de una realidad robot que ayuda a ver, reiteradamente, cómo los diferentes aspectos de una situación finita pueden interactuar, dando así al investigador la posibilidad de que se dé cuenta de variables o de relaciones entre estas que de alguna otra forma no hubieran podido ser vistas antes. Era complejo para la ciencia, y sobre todo para las ciencias sociales y las humanidades, aislar un hecho observado en sus situaciones de estudio en el mundo real para reproducirlo en unas condiciones más controladas, tal y como es un proceder normal en las ciencias experimentales. Ello debido principalmente a que la cantidad de variables y sus relaciones que potencialmente pueden darse en una situación real puede ser enorme, así como lo “difusa” que puede llegar a ser una situación2 durante su observación. De esta manera, los ABM abren la posibilidad de que se introduzcan modelos experimentales en las ciencias humanas y sociales.

Cabe comentar que la definición de las variables que componen esta realidad es quizás el punto medular de cualquier simulación, ya que sí se integran variables que no sean tan significativas en el comportamiento de un fenómeno, corremos el riesgo de perdernos y no tener una claridad analítica de la complejidad a simular, de modo que el propio ABM deberá introducir la posibilidad de cambios en su estructura (modelos experimentales sucesivos) que nos permitan ver qué tanto “peso relativo” pueda llegar a tener una determinada variable en el contexto de la realidad que analizamos. Durante el desarrollo del ABM en el que se basa este artículo, fuimos aproximándonos de esta manera a las observaciones del fenómeno que reprodujimos, dándonos cuenta, por ejemplo, de que el aprendizaje no era una variable constante en el tiempo, que cabría programar en los agentes el olvido y la persistencia en la memoria, de tal modo que en el declinar del recuerdo o en su indeleble fijación a la mente, pudiéramos ver cómo ello se manifestaba en el ambiente generando patrones que repercutieran en los comportamientos individuales.

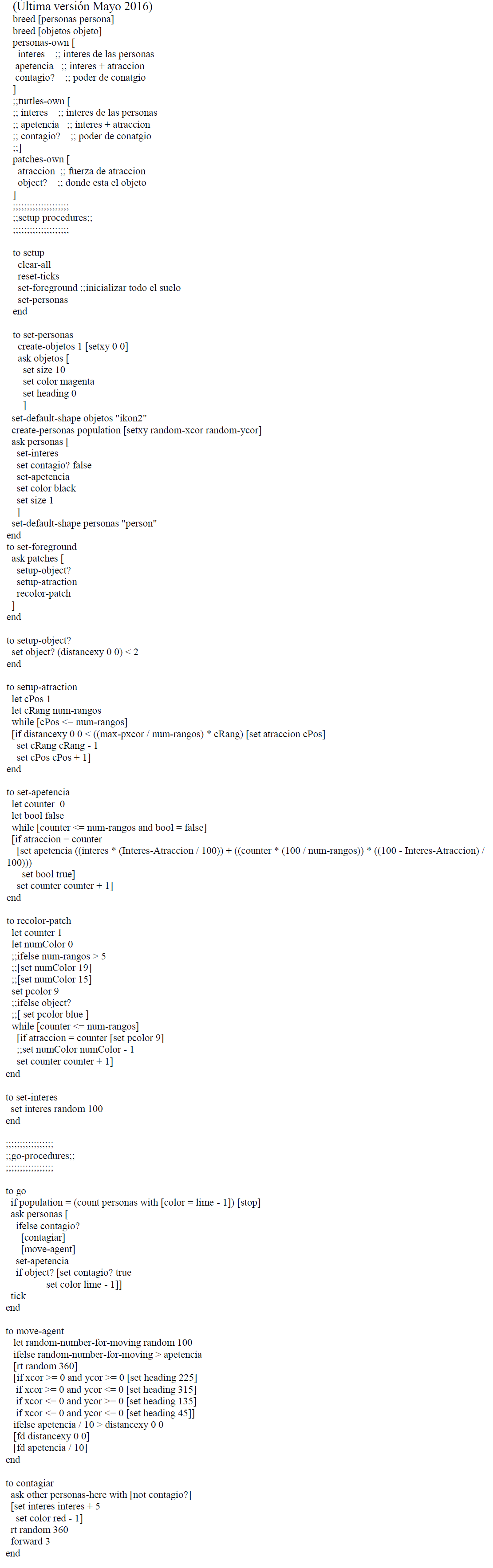

El Dr. Martin Hilbert3 expuso una interesante forma de comprender un modelo, haciendo un análisis sobre cómo ha evolucionado la forma de comprender de forma gráfica la realidad. Una buena forma de comprenderlo, es ver cómo se ha modificado la incorporación de información gráfica para la comprensión de la realidad urbana, substrayendo información que permite a los habitantes ver más claramente ciertos aspectos del funcionamiento urbano, a costa de eliminar otro tipo de información que para ese fin puedan resultar ser irrelevantes. Para los efectos de la comprensión de la línea de transporte subterráneo, por ejemplo, resulta innecesaria la exposición de otros aspectos de la carta urbana, como el callejero o los edificios y lugares emblemáticos (figura 1).

Figura 1 Un modelo frente a una representación de sus funciones. Carta urbana de Madrid (izq.) y el diagrama de la red del metro (der.). Fuente: Izquierda http://urbanity.cc/forum/espa%C3%B1a/comunidad-de-madrid/infraestructuras-mad/653-madrid-red-de-metro. Derecha. https://es.wikipedia.org/wiki/Metro_de_Madrid.

Este es un buen ejemplo que muestra la importancia que tiene el definir qué información resulta la más adecuada para la recreación de una realidad y cuáles informaciones pueden potencialmente complicar su comprensión. Para cada modelo de simulación será diferente el criterio que el diseñador debe seleccionar de la realidad, qué características deben de ser incluidas de forma abstracta, para definir las variables que intervienen en el fenómeno. Ello, cuando se usan ABM, puede ser llevado paso a paso al modelo para ponerlo a prueba. Phillip Anderson, en su discurso de aceptación del Premio Nobel en 1977, describe los problemas que luego suscita el ver a los resultados observados como una visión de la realidad en sí: “El arte en la construcción de modelos es la exclusión de partes reales del problema, pero irrelevantes, e implica riesgos para el constructor y para el lector. El constructor puede dejar de lado algo realmente relevante, el lector, armado con un instrumento demasiado sofisticado o con un cálculo demasiado preciso, puede tomar literalmente a un modelo esquematizado, cuyo principal objetivo es ser una demostración de las posibilidades” (Mitchell, 2009, 224).

Un modelo que pueda ser un referente de investigación adecuado para nuestros fines, tiene que partir de la noción de que la ciudad debe ser pensada como una realidad compleja, que se expresa siempre como formas, y que es a través de la forma, que la complejidad subyacente se expresa, es así que “la causa formal es la que unifica a las demás causas. (…) La parte que lleva la carga de inteligibilidad es la forma, y la que limita la cognoscibilidad es la materia. (…) lo que podamos conocer de la materia siempre será posible por virtud de la forma y por relación con ella. Así, la causa formal o forma es, justamente, el principio de inteligibilidad y también principio de universalidad” (Aranda Anzaldo, 1997, 162).

Mercado (2012) ha propuesto que un indicador fundamental para el estudio de la construcción de los imaginarios urbanos de una sociedad, lo podemos encontrar en ciertos objetos que son depositarios de una gran carga cultural y que contribuyen abiertamente a construir la identidad reconocible de un lugar y una cultura. De acuerdo con este criterio, exploramos la relación que puede tener lo que denominamos en este trabajo “objetos urbanos icónicos” con el proceso de adquisición de la información por parte de los habitantes en la ciudad. El diseño del ABM, del que se tratará en las siguientes secciones, se basa además en la idea de que es necesario modelar ese proceso de transmisión de información, que se concentra en esa clase de objetos (contenedores y emisores de información), como el resultado de una interacción compleja. entre la urbs y la civitas.

Posibilidades para analizar la complejidad

En los últimos años el estudio de los fenómenos urbanos ha incorporado nuevas teorías y metodologías con la intención de lograr comprender los microprocesos que se crean por la relación de comportamientos individuales que se ven representados en macro comportamientos, resultado de la coevolución e interacción con el entorno de los agentes en un sistema dado.

Las ciencias de la complejidad han aportado teorías y metodologías de otras disciplinas no nativas de los estudios urbanos, con la finalidad de comprender estos fenómenos complejos. Herbert Simon (En Epstein & Axtell, 1996, 1) argumenta que las ciencias sociales son en realidad las ciencias “duras”; que los procesos complejos sociales no pueden ser separados en subprocesos para ser analizados de forma aislada. Al adicionar los subprocesos ─económicos, culturales, espaciales, demográficos, etc.─ y ser estudiados conjuntamente, podrían brindar una mejor perspectiva de análisis y obtener una comprensión más integral de estos que si se los estudiara como fenómenos independientes.

La incorporación de nuevos enfoques interdisciplinarios de distintas áreas de la ciencia que están y continuarán aportando nuevos conceptos en la investigación científica, además de los crecientes adelantos en materia de almacenamiento y procesamiento de información mediante el uso de la tecnología computacional, crean la posibilidad de “explorar” nuevas metodologías desarrolladas con teorías que no son tradicionales del estudio de los fenómenos urbanos. Recientemente algunos estudiosos de las ciencias de la complejidad han comenzado a trabajar bajo esta línea.

No existe una definición unívoca para definir a la complejidad, de hecho esto perece ser la esencia de la complejidad; ésta ha logrado establecer visones paralelas en varias disciplinas como la física, biología, sociología, economía, psicología que desde sus trincheras, han elaborado teorías y metodologías para explicar la complejidad y han dado lugar al surgimiento de lo que conocemos hoy como las ciencias de la complejidad. Complejidad del adjetivo “complejo” proviene del prefijo latín “con”, ─junto, pegado─ y del verbo “plectare” ─enlazar, trenzar, tejer─ nos da una definición más acertada, “todo enlazado…, todo junto…”4, bien podría ser este término un buen inicio para plantear lo que se le podría llamar un fenómeno complejo, tanto para su aproximación y análisis, como para su comprensión.

En líneas generales es aceptado como referencia para lograr unificar una definición de “complejidad”, un artículo publicado por Seth Lloyd “Measures of complexity A non-exhaustive list”, catedrático del Massachusets Institute of Technology (MIT) y profesor externo del Santa Fe Institute (sfi), en el que presenta 42 definiciones sobre la complejidad.

Quizás la primera definición moderna de la complejidad se encuentre en un trabajo que data de 1948, en que Warren Weaver presentó un artículo llamado “Science and Complexity”. En líneas generales, estableció tres grupos de problemas para exponer las diferentes formas en que la ciencia había tratado los problemas, sus metodologías y planteamientos:

Los problemas de simplicidad. Weaver señaló en su trabajo que durante los siglos XVII, XVIII y XIX, la ciencia estudiaba problemas de “simplicidad”. En estos intervenían básicamente dos variables, como temperatura y presión, población y tiempo, producción y comercio.

Los problemas de complejidad desorganizada. Ya avanzado el siglo XX la ciencia incorporó una gran gama de recursos metodológicos que permitió simular problemas con una mayor cantidad de variables, y estos fueron tratados con herramientas de probabilidad y estadística básicamente, se buscaba la obtención de promedios lo que Weaver denominó “la ciencia de los promedios” (estadística, regresiones, varianzas, correlaciones: en las que es necesario un promedio), y permitió el desarrollo de conclusiones para una gran variedad de variables, sin embargo estas deberían de cumplir con ciertos requisitos como el supuesto idénticamente independiente e idénticamente distribuido.

Problemas de complejidad organizada. Weaver advirtió que en los próximos cincuenta años, la ciencia debería de lidiar con problemas a los que llamó problemas de complejidad organizada; estos presentan una gran diversidad en sus distribuciones por lo que resulta sumamente difícil obtener promedios, además cuentan con más de dos o tres variables y estas son interdependientes, no son independientes y que no podrían ser manejados con las técnicas estadísticas tradicionales.

En su trabajo, mencionó algunos ejemplos de complejidad organizada, como el precio del algún producto de primera necesidad; recalcó en la interrelación de las variables que componen estos problemas de complejidad organizada, también utilizó como ejemplo, el patrón de comportamiento de un grupo social autoorganizado, como protestas, movimientos sociales, etc.

Aunque no es advertido en ese trabajo seminal, es evidente que los fenómenos de producción, transformación y crecimiento urbanos se encontrarían en la categoría 3, es desde hace muchos años evidente que esta clase de problemas están compuestos por variables que están complejamente relacionadas y que no muestran una variabilidad simple en el tiempo, tanto considerándolas por separado como en sus interacciones. Por otra parte, ha sido demostrado que las interrelaciones de las variables que pueden explicar a los fenómenos urbanos son muy numerosas.

Ante este escenario los adelantos tecnológicos en el procesamiento y obtención de datos gracias al desarrollo en tecnologías informáticas y de comunicación han abierto nuevas posibilidades de estudio, brindando la posibilidad de obtener datos de forma inmediata, lo que se le conoce como big data. Sumado a esto, el poder de procesamiento y análisis por medio de sistemas de cómputo cada vez más rápidos y potentes está dando lugar a nuevas formas de tratar de comprender y explicar los fenómenos sociales urbanos.

Para el estudio de los fenómenos urbanos queda la tarea de encontrar nuevas formas de analizarlos y comprenderlos; aceptando la dificultad en la obtención de promedios. Algunos autores han dicho que la manera en las que puede saberse si un fenómeno puede encuadrarse efectivamente dentro de la perspectiva de la complejidad, son las distribuciones de “cola larga” (long tailed plots) y la interdependencia entre variables. En sociedades hipermodernas (Lipoyevtsky, 2006) que se desarrollan en los albores del siglo XXI, existe una característica a la que se podría llamar “súper diversidad” así como una “súper interrelación” de variables que pueden llegar a componer un fenómeno social, debido a que el crecimiento de las relaciones entre los territorios, que caracteriza al mundo contemporáneo, aumenta, y en esta misma medida de diversificación, aumenta la posibilidad de que se vayan sumando nuevas interacciones entre variables y nuevas variables y por lo tanto nuevos factores entren en juego durante el desarrollo de un fenómeno urbano, que hagan difícil predecir su desenvolvimiento en el tiempo.

Sistemas complejos adaptativos

Resulta difícil definir a la complejidad, sin embargo puede decirse que existen atributos que son coincidentes en ciertos aspectos para categorizar a lo que se denomina “sistemas complejos adaptativos” (SCA).

Los SCA, son sistemas compuestos por agentes que se encuentran conectados, interdependientes, diversos, adaptativos, ─el sistema es adaptativo, los agentes pueden aprender del entorno al procesar información y evolucionar al cambiar su comportamiento ante las nuevas condiciones del entorno y de la interrelación con otros agentes─. Pueden ser dependientes del origen, es decir, que las condiciones iniciales del sistema y del entorno determinarán el comportamiento del sistema en el tiempo, dando como resultado patrones muy similares pero no idénticos, producto de las variaciones en las condiciones iniciales del sistema. El sistema es emergente esto es, que el sistema tiene un comportamiento lineal hasta un determinado punto y bajo ciertas condiciones se produce una transición de fase, lo que se conoce como emergencia del sistema, una no linealidad en un determinado punto de su historia que vuelve impredecibles los resultados de su desarrollo.

El término emergencia es utilizado en diferentes contextos. Para el estudio de los SCA, la emergencia es entendida como el comportamiento de los agentes en un nivel inferior ─micro─ que produce cambios en el sistema a un nivel superior, creando lo que se podría llamar un “ser” superior, que es referido, es decir que su existencia se encuentra en otro nivel o a una eascla superior, -macro-, que resulta de la agregación de los agentes pero que no puede ser comprendido cabalmente analizando a los agentes por separado. Nakagaki, Yamada y Tóth (2000) comprendieron esto al estudiar el comportamiento del moho del fango5. Estos microorganismos, son muy primitivos y no cuentan con un sistema nervioso como el que caracteriza a los animales superiores; se les encuentra en la naturaleza organizados en grandes colonias que se desplazan por el suelo alimentándose de materia vegetal en descomposición. Para encontrar el camino hacia el alimento, el moho que estudiaba Nakagaki se las “arregló” para recorrer el camino más corto hacia el alimento: “para ser un organismo tan simple el moho posee un nivel intelectual asombroso” (Johnson, 2004, 7).

Otros microorganismos poseen aptitudes similares para encontrar su alimento, y aún más: son capaces de realizar análisis muy precisos del medio ambiente en el que se encuentran. Reportes del comportamiento de la diminuta bacteria Esquerichia coli señalan que estas nadan hacia el jugo de carne y se alejan del alcohol como una medida que garantiza su supervivencia. Ello implica que la bacteria debe determinar cuál de las concentraciones de estas sustancias es mayor, con lo que es capaz de realizar un análisis de las pequeñas diferencias de concentración de éstas a lo largo de su longitud. Por las dimensiones de la bacteria, las diferencias son tan mínimas que los investigadores no entienden cómo las Esquerichia coli pueden realizar análisis tan precisos.

Una hipótesis alternativa supondría que la bacteria “recuerda” la concentración promedio de las sustancias de región a región mientras se mueve, esta hipótesis sugiere que no sólo la bacteria es capaz de almacenar recuerdos, sino que además los puede ordenar en un “esquema cognitivo” útil. ¿Cómo puede ser esto en ausencia de una estructura nerviosa? Quizás el recuerdo forme parte de un nivel de organización superior al microorganismo, que habría de buscarse en la colonia y no en el organismo unicelular individual. Lo cierto es que el desempeño de estas diminutas bacterias y la precisión de sus análisis, sorprende a los científicos, pues supera a las capacidades de cada microorganismo individual, dadas sus características físicas y la capacidad de procesamiento de información que potencialmente pueden llevar a cabo.

Estos son buenos ejemplos de cómo el comportamiento de los agentes en un nivel micro son capaces de crear estructuras y comportamientos muy complejos en un nivel superior, aparentemente creando una “inteligencia emergente”. Lo que en 1952 Alan Turing denominó “morfogénesis”, la capacidad de todas las formas de vida de desarrollar estructuras cada vez más complejas a partir de orígenes muy simples.

El desarrollo de las bases teóricas que nos han permitido empezar a comprender a los SCA y la posibilidad que ahora se abre de simular su evolución a través de programas computacionales, promete en los próximos años dar mucha luz en la comprensión de los fenómenos complejos.

En la era de la información, el estudio de los fenómenos urbanos se apoya cada vez más en el análisis y procesamiento de información por medios computacionales. Se ha hecho evidente que cuando se trata con las grandes cantidades de datos de las que disponemos en la actualidad a través de los sistemas de monitoreo y seguimiento de los flujos de diversas variables en nuestras ciudades, la clase de análisis que se pueden desarrollar tendrá más que ver con sistemas complejos que con relaciones simples entre variables, como advirtió Weaver hace más de 50 años. La posibilidad que se abre en la actualidad para la producción de simuladores computacionales de grandes sistemas urbanos, es prometedora.

Las sociedades procesan información y se pueden interpretar las dinámicas sociales “…a través de unos de unos lentes que nos permiten ver, que es una gran computación lo que hace la sociedad”6. Las ciencias de la complejidad se han desarrollado a partir de la formulación de metodologías y técnicas sofisticadas de varias disciplinas para abordar el estudio de sistemas complejos. Estas ciencias poseen un poderoso arsenal de tipo técnico e instrumental, sustentado en el poder de cálculo de la computación contemporánea, para abordar el estudio formal y aplicado de sistemas complejos. “En el mundo real, sin embargo, la información es algo que se analiza en la búsqueda de sentido, que se recuerda y se combina con otra información, y que produce resultados o acciones. En resumen, la información es procesada a través de la computación”. (Mitchell, 2009, 57) 7.

Diferentes disciplinas incorporan en sus metodologías el uso de los sistemas computacionales, el estudio de los fenómenos urbanos, recurren a herramientas computacionales para el procesamiento de grandes volúmenes de datos con el fin de ver y comprender los fenómenos que estudian. Esto ha posibilitado un importante cambio en la forma de analizar los fenómenos urbanos.

Las formas en las que evolucionan en un periodo dado de tiempo los SCA son potencialmente impredecibles cruzado un límite de tiempo (transisción de fase), ello hace que las herramientas tradicionales como la estadística y la probabilidad sean insuficientes y carezcan del poder suficiente para el análisis de su desarrollo. En la actualidad la capacidad de tener acceso a datos en tiempo real de las sociedades humanas, hace que crezca mucho más la complejidad, diversidad y volumen de las informaciones que podemos tener a mano, con lo que la creación de los modelos posibles que expliquen las interacciones complejas de los datos que podemos recabar de las sociedades, se vuelve una tarea que exige niveles de sofisticación crecientes para los científicos sociales, lo que dificulta el estudio de las sociedades recurriendo a métodos tradicionales: “…las ciudades son tan complejas que una buena forma de lograr comprenderlas y visualizarlas es simulando su comportamiento”8.

La simulación computacional para el estudio de los sistemas complejos: modelos basados en agentes autónomos (ABM)

Con los avances en el procesamiento, almacenamiento y producción de la información se abren nuevas posibilidades para analizar fenómenos de una forma dinámica y que permita lograr una visualización de las transformaciones de las variables y sus interacciones en el tiempo, lo que facilita el poder comprender la evolución del sistema, el desarrollo y la emergencia de estructuras complejas.

La investigadora Melanie Mitchell del SFI, indica que para el estudio de los sistemas complejos el trabajo científico se debe apoyar en otras disciplinas, entre las que destaca:

a) Dinámica, esto es, el estudio de los constantes cambios en las estructuras y en el comportamiento de los sistemas en el tiempo.

b) Información, el estudio de las representaciones y transmisión de la información en el sistema.

c) Computación, brinda elementos de cómo el sistema procesa información y responde.

d) Evolución, el estudio de cómo los sistemas se adaptan al entorno en el tiempo.

De la misma forma, propone una revisión de las metodologías y herramientas que son utilizadas para el estudio de los sistemas complejos, la combinación entre trabajo de experimentación, trabajo teórico y la nueva y creciente llamada simulación computacional.

La simulación computacional es, el crear “laboratorios” dentro de nuestras computadoras (lo que se denomina desde 1989 “in silico”) para analizar modelos que serían muy difíciles de solventar y de analizar al recrearlos con las matemáticas de forma tradicional. Además de poder observar su dinámica y su evolución en la dimensión temporal. Como se ha dicho, este tipo de simulaciones brinda la posibilidad de comprender los procesos entre los dos horizontes temporales arbitrarios que determine el investigador del fenómeno (inicio y fin).

Como veíamos en la introducción, en el tercer grupo que Weaver estableció como problemas de complejidad organizada, enfatizó en la necesidad de lidiar con problemas de más de tres o cuatro variables. Las simulaciones computacionales nos permiten simular modelos con variables que se encuentran interconectadas, interdependientes entre ellas y además nos brindan la posibilidad de ponderar una o varias de ellas en un modelo de simulación, es decir darle más peso a una o a otra variable y observar el comportamiento del sistema ante este nuevo escenario.

La simulación de modelos dinámicos computacionales se perfila como la forma más adecuada para el análisis y comprensión de los fenómenos complejos y su aplicación a la modelación de sistemas sociales es muy prometedora con el avance actual de las herramientas computacionales. Las herramientas que han sido incorporadas por las ciencias de la complejidad para el estudio de los SCA, continúan en un constante desarrollo; la construcción de modelos dinámicos, en específico para el análisis de los sistemas dinámicos sociales, abrirán nuevos canales para la producción de nuevas teorías así cómo matrices metodológicas para el análisis de este tipo de fenómenos.

Los Modelos Basados en Agentes Autónomos, (Agent-Based Models) y el Análisis de Redes Sociales (Social Network Analysis) son las herramientas más poderosas para la creación y desarrollo de lo que se le podría llamar “sociedades artificiales”. Uno de los pioneros en el uso de tecnologías de simulación computacional en México es Aguilera (2002), que utilizó autómatas celulares (AC) como herramienta para simular el desarrollo de dinámicas urbanas. Como se verá en el siguiente apartado, esta herramienta fue la clave para el surgimiento de los ABM.

Autómatas Celulares

Los ABM tienen su origen en la década de 1940 con el desarrollo de los autómatas celulares creados por John von Neumann (1966) y Stan Ulam (Mitchell, 2009,149) para probar que la autorreproducción en máquinas era posible, y utilizaron los autómatas celulares para abordar este problema. En el futuro este concepto fue absorbido por la biología y para el desarrollo de la arquitectura computacional. Los autómatas celulares son modelos idealizados de sistemas complejos.

Los AC son estudiados por las ciencias de la complejidad por sus características como sistemas dinámicos, sistemas que interactúan, procesan información y evolucionan en el tiempo. También son utilizados como herramientas para modelar procesos en diferentes disciplinas como la física, geología, química, biología, etc. En el caso del análisis de los procesos de interiorización de características propias de ciertos lugares, edificios o monumentos, por parte de los habitantes urbanos y la emergencia de comportamientos alrededor de éstos que darían (o no) lugar a la generación de patrones; esta aproximación puede ser especialmente útil como herramienta para la comprensión de los principios sobre la autoorganización y emergencia de los sistemas complejos.

Los AC se componen por una red de simples componentes. Se entiende a un componente como una célula y a la red por la conexión con sus vecinos más cercanos. Cada una de las células tiene comunicación con solo una fracción de todos los componentes del sistema ─información limitada del todo─ sin un control “centralizado”, no existe una célula con control sobre otra célula. Conforme evolucionan en el ambiente computacional, los AC pueden presentar estructuras dinámicas muy complejas partiendo de reglas muy simples. Von Neumann intentaba formalizar la lógica de la reproducción en las maquinas que desarrolló Alan Turing previamente, resultando en la década de 1970 en la creación de una “biología artificial” y con ello abriendo camino a la creación de mundos a través de algoritmos genéticos, que imitaban la forma en la que los organismos se reproducen (Holland, 1975).

Los AC desarrollados por Von Neumann allanaron el camino para que en los inicios de la década de 1970 el matemático inglés John Conway desarrollara su famoso AC “Game of Life” (Gardner, 1970) y que para muchos autores no tiene nada de juego, tal vez por la forma en que idealizó su modelo; estableciendo células prendidas como vivas y apagadas como muertas. Determinó cuatro estados del sistema como el proceso mismo de la vida: nacimiento, sobreviviente, soledad y sobrepoblado.

Cada uno de estos cuatro estados fue determinado por las condiciones de sus ocho vecinos y definió un comportamiento para cada estado en la siguiente iteración. Las mismas reglas simples son seguidas para cada una de las células del sistema y pueden crear comportamientos complejos obedeciendo estas mismas reglas.

Los AC tienen la capacidad de procesar información, pudiendo evolucionar en algoritmos genéticos. Se podría visualizar a los AC como sistemas que presentan emergencia y un elevado nivel de autoorganización a través de reglas simples con las que se programa la acción de cada célula del sistema, actuando siempre en proximidad y con un elevado margen de aleatoriedad, lo cual da pie al surgimiento de estructuras organizadas de gran escala.

Modelos basados en agentes autónomos (ABM): análisis desde el fondo hacia arriba (Bottom up)

¿Qué son los ABM? En bibliografía específica es común encontrar términos sinónimos como modelación basada en agentes (Agent-Based Modelling), simulación basada en agentes (Agent-Based Simullation), sin embargo, ABM (Agent Based Models) será el término utilizado en este texto para referirnos a los modelos basados en agentes autónomos. Quizás su mayor valor es que podemos visualizarlos en la dimensión temporal y espacial (Epstein y Axtell, 1996).

Los ABM son simulaciones dinámicas computacionales de sistemas que se construyen con la interacción entre los distintos agentes que componen el sistema, en iteraciones consecutivas en el tiempo, los agentes interactúan entre ellos y/o el entorno bajo reglas simples de comportamiento y que tienen la capacidad de modificar su comportamiento y el de otros agentes del sistema de acuerdo a las nuevas circunstancias en cada iteración.

Un agente se define como una entidad autónoma, heterogénea, aislada de los demás agentes, con su propia carga identitaria; con la capacidad de interactuar con otros agentes y el entorno. Pueden modificar su comportamiento producto de estas interacciones entre ellos y el entorno, con la capacidad “aprender y recordar” para adaptarse a las nuevas condiciones en cada iteración.

Un agente puede ser “idealizado” como una persona, una célula, una partícula o una empresa por citar algunos ejemplos.

En los últimos años se ha propuesto el análisis de los sistemas sociales desde una perspectiva diferente a la revisión habitual que va desde las estructuras de agrupamiento de los agentes del sistema (las clases sociales, los grupos étnicos, los inmigrantes, los empleados, etc.), y de ahí pronosticar los comportamientos de los individuos; llevándola hacia una revisión que va desde los agentes a las estructuras, lo que se le conoce como bottom up (del fondo hacia arriba); este enfoque consiste en comprender cómo el comportamiento individual en un nivel micro, se traduce en la emergencia de una estructura que expresa homogeneidad y coordinación en un nivel superior macro. Ello se consigue mediante la programación que atomiza el comportamiento de cada agente y su interacción con los demás para lograr comprender los patrones de comportamiento en un nivel superior, lo que Schelling (1978) desarrolló en su libro Micromotives and Macrobehavior. Cómo se señaló en líneas anteriores el término emergencia ha sido utilizado en diferentes contextos, sin embargo, el concepto de emergencia que nos ocupa en este texto podría decirse que comenzó con Aristóteles (1875), si consideramos su reflexión sobre el valor del todo y su relación con la parte, donde reconoce que el todo es mayor que la suma de sus partes.

Engels (2014), señaló algo que podría conducirnos desde la afirmación aristotélica hasta un punto de vista más cercano a los objetivos de programación de los ABM al señalar que en un determinado momento muchos cambios cuantitativos producen cambios cualitativos, lo que se conoce como la ley del tránsito de la cantidad a la calidad y que nos dice que es recíproca, es decir, que luego, cambios en la cualidad de los niveles macro pueden dar lugar a cambios en las cantidades en los niveles micro. Lo que puede ser un buen indicio para empezar a pensar en una explicación de la emergencia de fenómenos como coherencia y coordinación.

De acuerdo con la teoría y los experimentos realizados con ABM, se ha demostrado la magnitud de la repercusión que existe entre los comportamientos individuales y el sistema social, que se ha demostrado, impactan de forma determinante a todo el sistema, esto es a lo que se le ha denominado bottom up, apropiados para comprender cómo las estructuras complejas, que presentan altos grados de coherencia y coordinación y que nacen como emergencias en el sistema, son en sí el resultado de múltiples comportamientos individuales descoordinados en sus fases iniciales, pero con una tendencia a una coordinación creciente.

Consideramos que la piedra angular de los sistemas complejos sociales son la auto organización y la descentralización en la toma de decisiones. Los experimentos in silico revelan que a pesar de que no existe un control central en el sistema que coordine las acciones de los agentes individuales, se logran construir estructuras sumamente complejas y emergentes simplemente en la iteración continua de unas pocas reglas simples dirigidas a poner unos límites más o menos elásticos al comportamiento de cada agente y al grado de libertad con que estas reglas son ejecutadas por cada agente reiterada y aleatoriamente.

Simulaciones computacionales basadas en ABM

Los sistemas complejos son así, complicados de entender y de explicar, tradicionalmente los fenómenos de diferentes disciplinas son tratados de una forma más simple idealizando modelos que son relativamente más manejables por medio de la estadística. En la actualidad con el desarrollo, accesibilidad y abaratamiento en los equipos de cómputo, se abren posibilidades para la construcción de modelos para el análisis de los sistemas complejos que tomen como punto de partida la complejidad en sí y no la idealización analítica que tiende naturalmente hacia el reduccionismo. Cómo se ha dicho antes, una de las la intenciones que pudieron guiar a algunos de los pioneros en la experimentación computacional, Turing, Von Neumann, Wiener (Mitchell, 2009) y recientemente Wolfram (2002), por citar algunos, quizás fuera el deseo de usar computadoras para simular sistemas que pensaran, aprendieran y evolucionaran.

En este punto cabe señalar una cuestión que es crítica en las simulaciones computacionales, el concepto de “entendimiento mutuo”. La mayoría de los problemas en la comunicación humana nacen de este problema, la ambigüedad en el sentido de las palabras, que nubla la comprensión de los significados de los mensajes en las comunicaciones humanas, nos puede llevar a confusiones más grandes en la recreación de fenómenos cuando utilizamos herramientas computacionales. El sentido común y una receptividad al contexto son necesarios para la correcta comprensión de una simulación.

La ambigüedad en el entendimiento de la “recreación” de una realidad cobra un sentido más amplio ante la subjetividad de diferentes percepciones sobre un determinado concepto.

Las analogías han sido utilizadas por la ciencia para poder describir teorías y modelos desde hace mucho tiempo. Este ha sido uno de los principales problemas al que se han enfrentado los científicos, es muy fácil demeritar un modelo ─intencionalmente o no─ si no existe una receptividad al contexto. La construcción de analogías que son usadas para la comunicación sobre la recreación de un fenómeno (desde las etapas de la formación de la idea científica, hasta la comunicación de los resultados) se entiende en el contexto de las simulaciones computacionales como la capacidad de percibir la similitud abstracta entre dos cosas aún en presencia de diferencias superficiales. “Esta habilidad humana existe en casi todos los aspectos de lo que llamamos inteligencia” (Mitchell, 2009, 187).9

Elkin World

Elkin World, bautizado así en honor del insigne antropólogo australiano Adolphus Peter Elkin, pionero en la investigación sobre el significado simbólico de los objetos rituales usados por las tribus aborígenes nómadas de Australia y la manera en que estos objetos podrían modificar los comportamientos de sus sociedades y así materializar ciertas representaciones sociales (Elkin, 1933). Elkin World es un ABM desarrollado por los autores para tratar con el problema de las interacciones de las sociedades urbanas con objetos icónicos y los patrones de comportamientos que podrían emerger si las condiciones urbanas se llevan a cambiar.

Las intenciones que están detrás de la construcción de esta clase de modelos, están fundadas en el motivar un acercamiento por medio de simulaciones computacionales al estudio de los fenómenos sociales, que permitan profundizar en las diferentes esferas de la actividad humana, comercio, crecimiento demográfico, propagación de enfermedades, etc. Algunos de estos modelos dinámicos de simulación computacional se encuentran en desarrollo por diferentes instituciones. Nuestra propuesta, se dirige a indagar alrededor de fenómenos que impliquen la influencia de lo imaginario en la formación de patrones en el mundo físico. La percepción, la imaginación, la intención, el cambio en conductas sociales, la modificación de una norma social, la identidad, son esferas para las que Elkin World puede ser una herramienta útil de investigación. De la misma forma, desarrollar modelos en los que la espacialidad y el territorio condicionen el comportamiento del sistema, es decir, partir de modelos en los que el entorno y el ambiente puedan condicionar y modificar el comportamiento colectivo, se volvió un asunto fundamental en el diseño de Elkin World. Esta forma de programación con que empezamos a experimentar, resulta ser uno de los ABM más novedosos, y a los que nos proponemos llamar Geo-Idea Models (GIM)

La pretensión esencial del trabajo en Elkin World es descubrir los micro-mecanismos fundamentales que son esenciales para generar estructuras macroscópicas sociales y comportamientos colectivos complejos que emergen de diversas (y aleatorias) formas de concebir un objeto icónico y la relación individual de las personas con éste, así como de la evolución de la información que pueda en un momento dado transmitir el objeto a quienes entren en contacto con éste y la información sobre el objeto que circula en la sociedad.

A través del simulador es posible visualizar y comprender la conformación socio espacial y temporal de estructuras complejas de un sistema, ante un objeto icónico. Es posible ver también cómo la información sobre el objeto se distribuye en el sistema a través de su evolución en el tiempo y modifica los comportamientos individuales y colectivos de los agentes actuando en colectivo. Hace posible analizar cómo las estructuras sociales y los comportamientos de un grupo emergen de la interacción individual entre los agentes, ante un objeto simbólico y el territorio, en un ambiente artificial bajo reglas simples de comportamiento.

A continuación se expone el proceso de desarrollo utilizado para la construcción de Elkin World.

Elkin World está desarrollado en ambiente Logo, el código está escrito en logoscript. El diseño en sí mismo lo dividimos en cinco fases:

1) Idealización del modelo y del fenómeno, esto es determinar los componentes principales del sistema y sus interrelaciones, determinando los tipos de relaciones posibles entre componentes y la forma en la que se podrían cuantizar dichas relaciones.

2) Confrontación del modelo computacional con los objetivos buscados en la idealización, establecer las posibilidades reales del diseño, dados los recursos disponibles (software, hardware, tiempo, etc.).

3) Definición del comportamiento del sistema, establecimiento de las reglas de co-variación de componentes, definición general de las reglas de operación del sistema.

4) Codificar el modelo, esto es escribir el programa en código para que pueda ser ejecutado en logo.

5) Verificación y validación del modelo, se trata de la etapa de observación, el sistema es puesto a funcionar y se observan las variaciones del comportamiento de los agentes ajustando las variables para que constituyan escenarios ideales previamente identificados.

Agentes

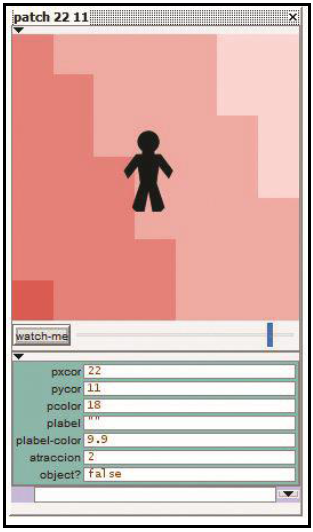

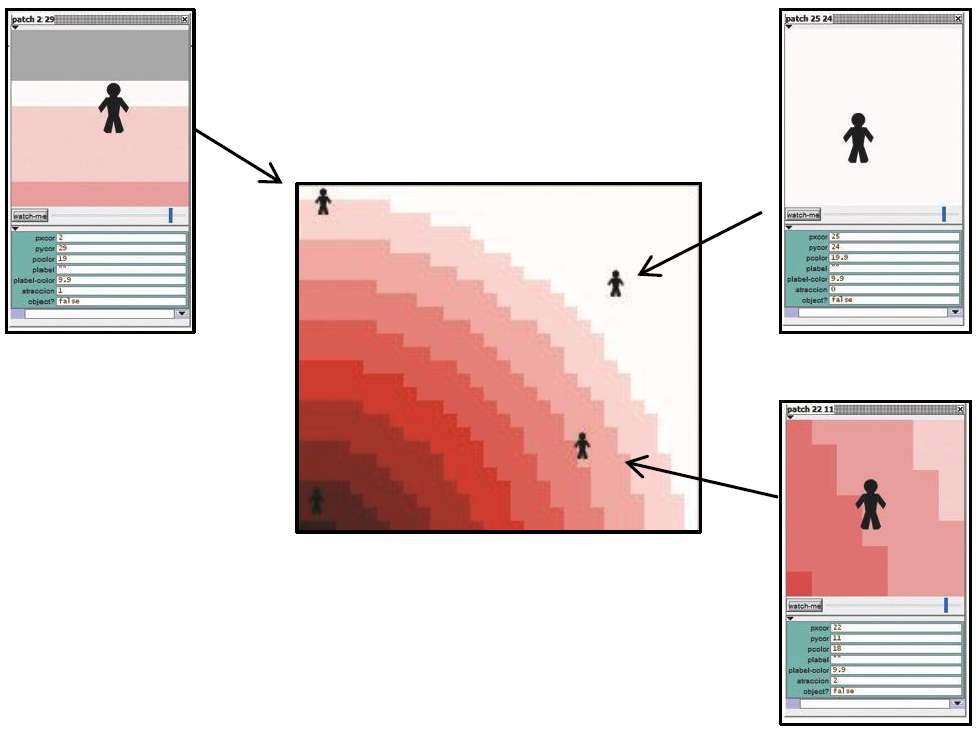

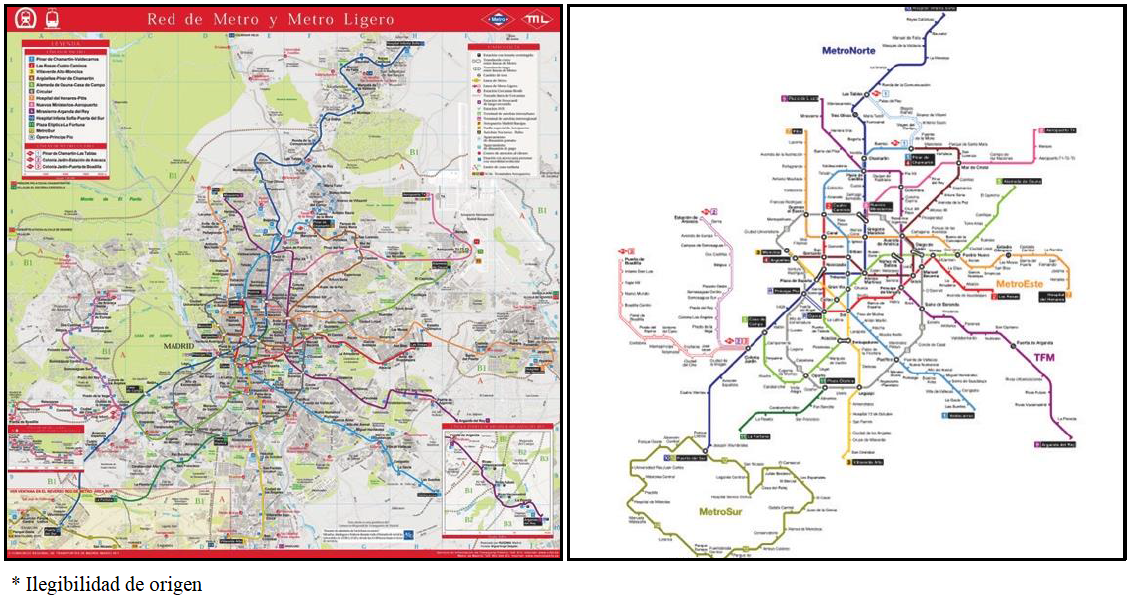

Los agentes, como se ha dicho en párrafos anteriores, son células en el sistema que pueden ser idealizados para una simulación de un fenómeno de acuerdo a las necesidades y criterios de la simulación (figura 2).

En Elkin World los agentes son personas. Cada agente tiene una “carga genética”10 y una posición diferente y excluyente en el espacio, esto quiere decir que no puede haber más de un agente ocupando el espacio asignado por el programa para éste, y ello cabe para cualquier momento del desarrollo del sistema, de modo que para que un agente se mueva por el espacio virtual, deberá éste estar vacío. En Elkin World tanto la “carga genética” inicial, como la posición inicial fueron asignadas de forma aleatoria para producir una mayor heterogeneidad en el sistema y simular una sociedad contemporánea más acorde a la realidad. El modelo tiene la posibilidad de definir la cantidad de población en el modelo (figura 3).

Figura 3 Diseño de la barra de asignación de población para los agentes de Elkin World. Fuente: Elaboración propia.

Dentro de su “carga genética”, cada agente tiene un nivel de interés sobre el objeto. El interés es idealizado como el deseo de “visitar” el objeto icónico situado en el centro del espacio de Elkin World. Cada agente tiene un nivel de interés y una posición inicial que es distinta a las de los demás agentes; las posiciones iniciales son determinadas aleatoriamente por el sistema para el tiempo 0. Los agentes tienen la capacidad de interactuar con otros agentes, modificar su comportamiento a partir de esas interacciones y modificar las variables con que están inicialmente formados otros agentes (figura 4).

Entorno

El entorno se define como el territorio virtual donde interactúan los agentes. En Elkin World el entorno por sus propiedades programadas, interactúa con los agentes. Tiene una influencia de atracción que es ejercida hacia los agentes interactuando con su comportamiento.

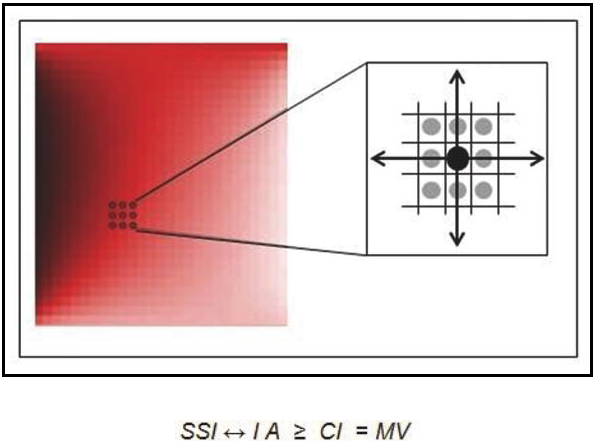

El entorno es una cuadricula sobre la que cada agente se puede desplazar durante las iteraciones sucesivas que definen al tiempo en Elkin World. Los agentes se pueden desplazar en dos direcciones (x, y), como en un espacio bidimensional teórico (figura 5). Cada cuadro (patch) tiene un valor de “atracción”, se consideró para las primeras versiones de Elkin World, establecer una gradación de valores de “atracción” que formaran un patrón simple de círculos concéntricos cuyo centro fuera el objeto icónico, de forma que el valor se incrementara conforme la distancia radial hacia el objeto icónico disminuyera, en forma de rangos discretos (variación incremental escalonada). El modelo tiene la posibilidad de definir el número de niveles de atracción mediante una barra de asignación (figura 6), de modo que puede conseguirse un territorio homogéneo simple (un solo valor de “atracción” para todo el territorio de Elkin World) o complejo (un gran número de rangos de valor en forma radial, figura 7).

Figura 6 Diseño de la barra de asignación de rangos en el entorno de Elkin World. Fuente: Elaboración propia.

Figura 7 Definición de rangos de atracción en el espacio de Elkin World. Fuente: Elaboración propia.

Reglas de comportamiento

El modelo es una “idealización” sobre cómo un objeto icónico para una determinada sociedad crea comportamientos colectivos en una población heterogénea, y cómo la información sobre un objeto, (asumiendo que cada “persona” tiene diferentes niveles de interés sobre éste) crea patrones socioespaciales en el territorio. Se determinó que el concepto “interés” podría traducirse en Elkin World como la voluntad, anhelo, apetencia de los agentes por entrar en contacto con el objeto icónico. Y cómo la cercanía hacia este objeto puede modificar el interés de los agentes hacia este, es decir se simula como la cercanía a un objeto icónico afecta o disminuye su interés en visitarlo, a lo que se le denominó “atracción”.

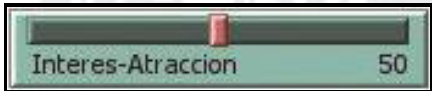

Se diseñó al territorio de Elkin World de tal manera que las condiciones del entorno pudieran elevar la “atracción” del objeto icónico sobre cada agente en forma proporcional a su cercanía: entre más cerca se pudiera encontrar un agente, más atracción ejercerá el objeto icónico sobre éste, en tanto que al alejarse, la “atracción” disminuiría; como se trata de un sistema dinámico, en el que los agentes pueden “escoger” desplazarse aleatoriamente por el espacio, este valor del territorio, altera el interés de los agentes por entrar en contacto con el objeto icónico. Los agentes se desplazarán de acuerdo a la relación matemática dinámica entre la variable “interés” y la variable “atracción” en cada momento del desarrollo del sistema, lo que motivará el desplazamiento. La relación entre estas dos variables es sumamente interesante, pues lo concebimos como la representación del indicador del grado de homogeneidad o heterogeneidad cultural que exista en una situación dada y su impacto en la emergencia de patrones socioespaciales.

Si el motivo del movimiento de los agentes está dado por la relación matemática entre “interés” y “atracción” con respecto al objeto icónico, el resultado de tal operación puede llevarles a entrar en contacto con el objeto. Cuando los agentes entran en contacto con el objeto icónico se programó un cambio cualitativo en éstos que concebimos como una transferencia de información desde el objeto icónico hacia los agentes (aprendizaje) que en la representación de pantalla se puede ver como un cambio de color de los agentes. Para las primeras versiones de Elkin World, esa cualidad lograda por cada agente se mantendría invariable por el resto de las iteraciones, en nuevas versiones hemos especulado sobre lo que significaría la programación de rangos variables de olvido en los agentes.

En Elkin World se idealizó e incorporó el concepto de “contagio”, se entiende por contagio, a que si un agente ya ha visitado el objeto (tiene una información de primer orden sobre el objeto icónico incorporada a sí mismo) podrá contagiar a otros agentes (transmisión de información de segundo orden) y aumentar su “interés” sobre este, los agentes contagiados pueden contagiar a otros agentes al encontrarse en el entorno aleatoriamente y elevar el nivel de interés sobre éstos. Decidimos que el nivel de contagio de un agente con información de segundo orden hacia otros agentes no contagiados, fuera también de segundo orden en las primeras versiones de Elkin World, para simplificar los cálculos necesarios de ajuste de interés en los agentes, dadas las posibilidades del hardware que teníamos a disposición para correr nuestro GIM.

El nivel de contagio será determinado por el interés que cada agente tenga en ese momento y que variará según la atracción y el nivel de información sobre el objeto icónico que posea en ese momento. En la representación gráfica, el “contagio” se ve como un cambio de color, diferente para las situaciones de no contagio, información de primer orden y contagio (información de segundo orden).

La interacción de los agentes, el entorno y el objeto es concebida como un proceso de aprendizaje, en donde lo que se simula es una transferencia de información (que está presente en el objeto icónico, en el entorno y en los agentes, en diversos grados y formas), que podría darnos indicaciones sobre cómo podría emerger una coordinación de acciones que revelara un sustrato comun, o bien la dispersión de la información en una situación social dada y lo que resultaría de este proceso (la coordinación, posiblemente). Esto es crucial para comprender lo imaginario, que sólo podría intuirse como un sustrato, como operando en un “segundo plano”, o bien como el resultado de la interacción compleja de unas reglas simples en un entorno y en un transcurso de tiempo. ¿Son esas reglas importantes para definir a lo imaginario como sustrato y para comprender su influencia en la morfogénesis de la realidad visible?

Movimiento de los Agentes

La premisa fundamental para el desarrollo del modelo fue recrear la mayor diversidad de escenarios para explotar el poder de procesamiento de los equipos de cómputo, para la consecución de los objetivos iniciales y abonar en el desarrollo de nuevas matrices metodológicas más acordes a las fenomenologías contemporáneas.

El modelo tiene la posibilidad de simular distintas interacciones entre las variables tanto en la cantidad de población y niveles de atracción, como en la “ponderación” entre éstas para analizar los diferentes comportamientos colectivos del sistema en el tiempo. La relación entre interés y atracción puede ser ponderada mediante una barra deslizadora; de modo que se puede recrear un escenario en el que el interés tenga una mayor ponderación sobre la atracción, estableciendo rangos decimales para que esta relación nos dé una unidad (figura 8).

Para determinar el movimiento de cada agente se estableció una proposición booleana, que después fue transcrita a líneas de código. Esta proposición es:

SSI ↔ I A ≥ CI = MV

Esto es que: Sí y sólo sí, la relación entre Interés y Atracción es igual o mayor a su Condición Inicial se moverá el número de cuadros (patches) que resulte de esta proposición. Esta relación se realiza para cada uno de los agentes y se recalcula a la siguiente iteración, ya que cada agente habrá cambiado su posición de la iteración anterior. A continuación se expone un ejemplo. Se determina en primera instancia una población de 5 000 habitantes. Se determina establecer 6 rangos de atracción. Se establece para este escenario de simulación una relación de Interés .70 y la atracción de .30 para obtener la unidad. Este escenario podría ser interpretado de la siguiente manera: que existe un gran interés en el objeto, un objeto icónico que es muy significante para esta sociedad y que la atracción en este caso su accesibilidad es relativamente buena.

Un agente tiene una carga de 20, siendo 0 el menor y 100 el mayor. En este caso el agente se encuentra en el cuarto círculo de atracción. Como se establecieron 6 rangos de atracción 100/6 = 16.66 El agente se encuentra en el cuarto 16.66 x 4 = 66.66, este es el valor de atracción. Por lo tanto el 20 de interés del agente multiplicado por .70 que es la ponderación del interés en el modelo, da como resultado. 20 x .7 = 14.

La relación de atracción resultó 66.66 multiplicado por .30 que es la ponderación del modelo 66.66 x .30 = 20; por lo tanto la suma de 14 más 20 es igual a 34 el agente se moverá 34/10 = 3.4 ≈ 3 cuadros. Lo máximo que un agente se puede mover en cada iteración son diez cuadros.

En la siguiente iteración se recalculan los valores de cada agente ya que ha cambiado su posición. El modelo continúa en proceso hasta entrar en la segunda fase, la adquisición de información de primer orden (figura 9).

Figura 9 Agentes sin información del objeto icónico (negro) y agentes con información de primer orden (verde). Fuente: Elaboración propia.

Una vez que un agente ha llegado al objeto este cambia de color (verde) y comienza a contagiar a otros agentes cada vez que de forma aleatoria se encuentra con otro agente no contagiado, este encuentro aumentará cinco unidades al agente contagiado. El modelo continúa en el mismo proceso hasta que todos los agentes hayan entrado en contacto con el objeto, en este momento el modelo se detiene, permitiendo contabilizar el número de iteraciones ─el tiempo de desarrollo del sistema─ que tomó el proceso con el balance inicial del sistema. Cada balance entre las variables implica que podrá ser llevada a cabo una nueva observación en nuestro laboratorio in silico.

Observaciones de los experimentos in silico

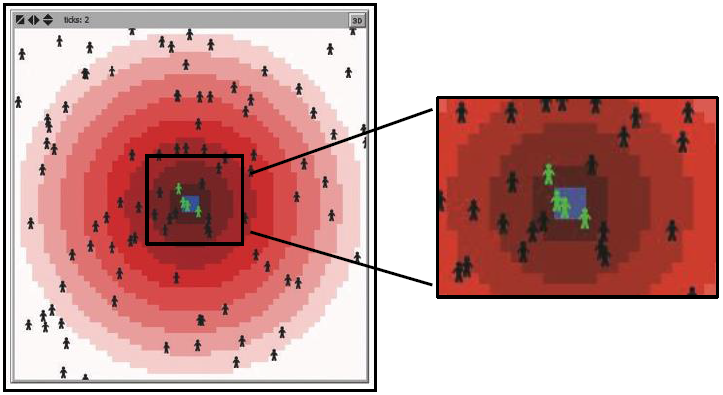

Se simularon diferentes escenarios, desde los más homogéneos hasta otros más heterogéneos. Se comenzó a correr el GIM con bajos niveles de población y ponderando las diferentes variables, gradualmente se fueron aumentando la población y empezaron a surgir ciertos patrones de configuración socio espacial. En la medida que se incrementaba la población, estos parones fueron más evidentes dando lugar formas particularmente familiares que surgieron espontáneamente conforme se presentaba una cierta masa de agentes interactuando en el espacio. Se detectó que en ciertos balances de variables había una cierta masa crítica de agentes (estrechamente relacionada con el balance elegido para correr el GIM), superada la cual hacía que emergieran ciertas organizaciones reconocibles, mientras que descendía la masa crítica, tales formas no emergían, limitándose el modelo a mostrar una evolución con formas arracimadas y crecientes en formas regulares radioconcéntricas. A continuación se muestran algunos ejemplos (figura 10).

Figura 10 Diversos momentos en la evolución del GIM, surgimiento espontáneo de organización cruciforme y crecimiento radioconcéntrico, puede observarse una paulatina reducción de la aleatoriedad en el sistema y su entrada a una etapa “determinista”. Fuente: Elaboración propia.

Al correr las primeras versiones del GIM quedó de manifiesto que los ABM resultan un poderoso instrumento de observación que facilita la comprensión del proceso de producción de patrones en la línea de tiempo, siendo observables las conformaciones socio espaciales y temporales en y durante el proceso. A partir de las observaciones logramos comprender que ciertas condiciones iniciales conducen a la formación de unas estructuras con mayor o menor grado de complejidad, La reproducción de los parámetros iniciales en experimentos sucesivos, nos brindó la posibilidad de reproducir la emergencia de unos patrones específicos repetidamente.

Logramos observar y replicar varios escenarios y pudimos comprender que mínimas variaciones en los balances iniciales de simulación conducían a comportamientos muy divergentes emergiendo múltiples patrones de conformación, entre los que destacaron las esctructuras cruciformes y las radiales- concéntricas. Siendo esto una de las grandes virtudes comprobadas al usar este tipo de herramienta computacional. De la misma forma en el proceso de definición e incorporación de las variables al modelo, los ABM resultaron ser una herramienta indulgente dada la capacidad de probar y rectificar uno u otro escenario a discreción, sólo nos detuvo el tiempo de procesamiento del hardware, ya que al incrementar la población bajo ciertos balances, el requerimiento de cómputo es muy demandante.

Del desorden visible surgió un orden aparentemente espontaneo, algo sorpresivo, producto de la dinámica entre sus agentes conducidos en la línea del tiempo. Sin embargo de este desorden inicial, la información se conduce y se transmite en el sistema permitiendo la creación de estructuras muy bien definidas; del desorden surgió “estructura”. Formando círculos concéntricos, formas geométricas reconocibles, manando de lo improbable a lo probable. Schrödinger (1944) abordó el concepto que denominó “orden a partir del desorden”, él explicó que las leyes físicas en gran escala surgen de estados de caos en las escalas subatómicas, como ejemplo, mencionó la difusión en los gases, que puede ser modelada como un proceso altamente ordenado, pero que es causado por el movimiento aleatorio de los átomos o moléculas. Observó que si el número de átomos o moléculas era reducido gradualmente, el comportamiento global del sistema térmico se volvería cada vez más aleatorio, lo que nos alienta a pensar que en la observación del surgimiento de formas en el ABM tuvo horizontes críticos, que si no eran superados, tal emergencia no se presentaba.

Schrödinger postuló que la naturaleza invierte la entropía en cada iteración -ciclos de vida -, de poca uniformidad -alta entropía-, surgen estructuras con gran uniformidad y alto grado de determinismo, dando lugar a una transición de fase -emergencia- producto de la interacción entre los agentes y la transmisión de la información de primer a segundo orden.

En nuestro GIM la mayor concentración de “actividad” observada es en la zona central, ha propiciado algunas reflexiones: de esta zona es de donde emergen patrones que “motivan” al desorden de las zonas exteriores con más ruido, a incorporarse al proceso, alimentando y robusteciendo en cada iteración la estructura central del sistema -determinismo sobre estocacidad-; donde lo inesperado se asoma a la luz. Siendo este un sistema dinámico cerrado las zonas exteriores con mayor ruido no permanecen en un comportamiento estocástico, continúan tendiendo a una dinámica determinista pese a su tendencia a conservar un comportamiento aleatorio, sustentando desde el exterior la formación de estructuras estables y rígidas formalmente hablando, en el centro del sistema.

Como fue demostrado, la masa en adición en el sistema, -horizonte crítico de la autoorganización- (Bak, 1996) alimentó la formación de patrones y estructuras centrales, inhibiendo la posibilidad de originar estructuras autónomas en las zonas exteriores. Las estructuras emergen en el punto del acontecimiento -fuente inicial de información- sobrepasando el punto crítico imposibilitan la formación de otras conformaciones y patrones en el exterior del sistema -otros imaginarios-, los imaginarios se gestan en la zona originaria de información y se ven conducidos a través del sistema, quedando en evidencia que bajo ciertas condiciones iniciales dadas, el sistema entra en una especie de “determinismo ” que logra reducir la aleatoriedad, la masa crítica juega un papel fundamental en el devenir de este proceso, parece entonces imponerse una idea por sobre otras posibles emergencias, absorbiendo la energía del sistema entero para apuntalar la construcción del esquema hegemónico, central.

Cómo la región que origina y potencia la evolución de un proceso de creación de un imaginario individual y su evolución colectiva. Las condiciones iniciales del entorno y sus eventuales transiciones de fases son determinadas por simples reglas deterministas y aleatorias que determinan la posterioridad en la construcción de un imaginario colectivo. Las zonas “silenciosas” -poca actividad- que mostraba el modelo dieron y siguen generando diversas interpretaciones.

Conclusiones

Durante el proceso de experimentación se produjeron una amplia gama de estructuras y patrones de comportamiento de los agentes en torno al objeto icónico, que emergieron a partir de la interacción de los agentes en el espacio-tiempo del GIM. Durante la experimentación ensayando con diversos balances de las variables, se hizo evidente la emergencia de macro-estructuras, reconocibles como formas geométricas familiares que surgieron del fondo hacia arriba (bottom up), a partir de las simples reglas del sistema. No se crean estructuras sin sentido, estos patrones corresponden a una lógica conductual colectiva que revela el surgimiento de una coherencia y coordinación que se sostiene en el tiempo y que no depende de los agentes en un sentido individual, sino de sus acciones colectivas. Este puede ser un camino para empezar a comprender la morfogénesis de las formas urbanas como dependientes de procesos de comunicación social que emergen de los micro-comportamientos colectivos y que revelan lo implicada que estaría la comprensión del ambiente en su evolución, de manera que es visible cómo se infiltra en la construcción de las formas concretas lo imaginario.

Hemos podido probar que el uso de ABM puede brindar información sobre la influencia de algunas variables sociales que pueden incidir en la formación de los imaginarios urbanos. Se pudieron simular situaciones de interacción social con elementos del entorno en los que reposa una carga significativa que tanto puede atraer a los agentes, como motivar el surgimiento de interés por entrar en contacto con el significado evocado por el objeto icónico, que revelaron que la densidad del grupo humano y ciertas relaciones que podrían cambiar sensiblemente la comunicación entre los agentes, que hizo emerger ciertas formas en sus relaciones.

La aparición durante las simulaciones de estructuras cruciformes, motivó que revisáramos las reglas de programación que guiaron los estados iniciales del sistema. Nos pudimos percatar que pese a las mismas reglas, al cruzar un cierto umbral de densidad de agentes en el espacio finito, era cuando las formas emergían, antes no. Lo que nos indicó la relación del comportamiento social, la emergencia de configuraciones y la cantidad de agentes por unidad de superficie. Dos personas pueden danzar, pero dos personas no hacen un baile. Nos percatamos que las reglas de la versión 4 de Elkin World, especialmente motivaron la emergencia de dicha configuración en condiciones específicas y al revisar los parámetros iniciales del movimiento de los agentes, pudimos notar una pauta en el movimiento que pudimos equiparar a situaciones sociales en donde se da una importante coordinación de grandes masas de sujetos que realizan un movimiento ritual rítmico (como en un gran número de ceremonias religiosas).

A pesar de que un cierto movimiento ritual aprendido para una ceremonia implicaría la semejanza en los movimientos de los agentes, sólo una pauta de tiempo repetitivo podría coordinar al movimiento en una coreografía que podríamos reconocer como una configuración en el espacio. Pudimos probar que ello fue una función de la densidad de agentes. Podemos especular que la exhibición de la coordinación en el movimiento fue una emergencia que se dio con independencia de las reglas de programación iniciales y que surgió como efecto de la adaptación espontánea de los agentes a través de un metanivel. ¿Es ese metanivel lo que entendemos como lo imaginario? De ser así, se abre una posibilidad interesante para el estudio de lo imaginario a través de la perspectiva teórica de los sistemas complejos adaptativos.

Por otra parte, estas observaciones nos llevan a reflexionar sobre el papel de lo imaginario en el surgimiento de las estructuras visibles. En efecto, como lo hemos apuntado en otros trabajos (Narváez, 2015), un puente que podría intuirse que conecta a lo imaginario, reconocido por Castoriadis (1975) como un “magma” donde todo yacería en potencia, pero no revelado aún como una representación, como una imaginación, lo constituyen los morfógenos, entidades que surgirían desde la pulsión como indicaciones de la sensibilidad que moverían hacia la creación de patrones de expresión (primero somáticas, luego visuales), que ulteriormente se reconocerían como formas en el entorno, que reforzadas por el diseño (acomodar, nombrar, representar, construir), crearían las condiciones suficientes para que se iniciara un proceso recursivo de ida y vuelta a lo imaginario, reforzándolo como sustrato colectivo de la mente.

Es así que quizás atestiguamos una de las vías a través de las cuales lo imaginario se manifiesta en el entorno como unas formas que emergen en apariencia espontáneamente; la mediación podría estar representada por esas reglas simples, que no son formas aún, pero que son el puente a través del cual se manifiesta lo invisible en lo visible. Podríamos especular que en el origen de la forma se encuentra la sensibilidad que al somatizarse en movimiento haría emerger algo visible. ¿Pero, qué pasa con la coordinación? Un sustrato así intuido supondría una serie de órdenes (una programación) subyacente a los agentes, que se encontraría en un “segundo plano”, de manera que su manifestación se daría en la entrada de su función en el espacio-tiempo simulado en el ABM.

Que se de la emergencia de la coordinación es un asunto fundamentalmente misterioso, que ha sido resuelto estableciendo a ésta como resultado de la interacción de reglas simples y una cierta masa crítica que se define “desde dentro” del sistema mismo y que en sí es una propiedad general de los sistemas, algo fundamental. Esa manera de plantearlo nos parece que resuelve poco la cuestión. Quizás, y esto se aventura como una hipótesis, exista una tendencia al orden que subyace a la naturaleza visible en todo. Quizás ese es el puente que se necesita para hacer surgir las formas de lo que es potencial puro. Y se aventura una hipótesis más: que sea esta emergencia una propiedad intrínseca de la mirada. El observador resultaría crucial para infiltrar el orden en un proceso estocástico.

Las simulaciones computacionales a través de ABM resultan ser eficaces para probar estos aspectos que establecen pautas para pensar en lo imaginario. La extensión de un hábito que pudiera tener un impacto decisivo en la formación de una manera de interpretar el ambiente, puede ser dependiente de una cierta masa crítica de personas que lo ejecutan y a través de esa ejecución lo elevan convirtiéndolo en una “metaejecución” y de esta manera se extiende coordinadamente en el resto del grupo. Y la forma emerge. ¿o es exactamente un proceso contrario? Podría ser que lo imaginario tuviera una fuerza coordinadora solamente cruzado cierto umbral crítico de ejecuciones, pero que la “metaejecución” existiera aún antes de que el comportamiento se manifestara materialmente en el sistema, de modo que cabría intuir a la naturaleza de lo imaginario como algo que trasciende a la realidad física, pero que establece una poderosa pauta para su coordinación (Sheldrake, 1981; Sheldrake y Bohm, 1982).

Elkin World mostró ser una buena herramienta de investigación en el ámbito de los imaginarios urbanos y pone al descubierto que en esta clase de laboratorios pueden ponerse a prueba hipótesis; que de otra forma serían imposibles de llevar a cabo de tal modo que podamos entender las condiciones específicas en que se daría el surgimiento espontáneo de comportamientos coordinados, para evitar caer en generalizaciones infundadas. Además de que se trata de una herramienta que nos permite ver las interacciones que surgen entre la realidad física y lo mental.

Sería necesario tal vez, analizar la planeación urbana entendida bajo la perspectiva bottom up y la simulación in silico. Analizar sobre cómo las regulaciones, ordenanzas, normatividad gubernamental, no descienden de un meta nivel a un nivel micro, el replantear este análisis desde atomización y la autoorganización podría ayudar a la comprensión de estos fenómenos y podría resultar útil una aproximación “computacional” para esbozar un comportamiento socioespacial a priori sobre una regulación a nivel macro.

text new page (beta)

text new page (beta)