Introducción

En el ámbito educativo, la falta de compromiso y motivación por parte de los estudiantes para participar de manera activa en su proceso de aprendizaje ha sido uno de los problemas más recurrentes, y una de las estrategias utilizada con mayor frecuencia ha sido la incorporación del juego como dinámica instruccional.

Se sabe que el juego mejora el compromiso activo de los estudiantes en la toma de decisiones; además, ver a los participantes en la dinámica de los juegos hace evidente que la participación emotiva durante estos puede resultar un factor intrínsecamente estimulante para la actividad que el individuo realiza, sin importar el tipo de entorno.

En las últimas dos décadas ha surgido una variante de esta dinámica instruccional denominada gamificación, que es descrita como el uso de metáforas, elementos e ideas del juego en un contexto distinto a este para aumentar la motivación y el compromiso, e influir en el comportamiento del usuario (Marczewski, 2013).

Nuestro objetivo es describir un proyecto de investigación que dé como resultado una propuesta de modelo instruccional configurable -por el docente en función de la interacción requerida por el discente- y computable -para utilizar en escenarios con modalidades educativas mixtas o virtuales-, basado en elementos de gamificación. Este modelo ha sido empleado en forma exploratoria por autores en el ámbito de la educación en ingeniería de software, quienes obtuvieron resultados positivos en su primera evaluación empírica.

Gamificación como estrategia en educación

La idea básica de la gamificación es aprovechar el poder motivacional de los juegos para fines no relacionados con los propósitos de entretenimiento del juego en sí. Esta idea procede originalmente del área de comercialización, la cual se extendió a diversos contextos vinculados con los negocios (Werbach & Hunter, 2012): “La gamificación se define como el uso de elementos de diseño de juegos en contextos que no son juegos” (Deterding et al., 2011, p. 10).

La motivación se refiere a la energía, la dirección y persistencia en todos los aspectos de la activación y la intención. Este tema ha sido estudiado desde hace décadas en el campo de la psicología debido a que se encuentra en el centro de la regulación biológica, cognitiva y social en el actuar de un individuo. Por lo anterior, resulta de valor para quienes desempeñan funciones como gerentes, maestros, líderes religiosos, entrenadores, proveedores de servicios de salud y padres, quienes involucran la movilización para el actuar de otros (Ryan & Deci, 2000). Cuando las personas están motivadas, tienden a ser más consistentes y, al mismo tiempo, prestan mayor atención a sucesos nuevos y posibilidades inesperadas; en ocasiones, requieren más tiempo para tomar decisiones, recopilar y procesar información, así como para apreciar los productos bien acabados e integrados, lo cual puede llevar a una mayor profundidad en el aprendizaje.

En los últimos años, la gamificación ha despertado un interés creciente entre los académicos y profesionales en diversas áreas de la sociedad (por ejemplo, medicina, negocios, milicia, educación, entre otras) y con distintos propósitos (Johnson et al., 2016; Hamari, Koivisto & Sarsa, 2014); en el caso particular de la educación superior, se ha recurrido a esta para promover la motivación en los estudiantes y, así, generar mejores condiciones para propiciar el aprendizaje (Lozada y Betancur, 2016; Prieto, 2020).

Kapp, Blair y Mesch (2014) establecen una clasificación que consiste en dos tipos de estrategias de gamificación: estructural y de contenido. Es importante considerar que esos esquemas no son mutuamente excluyentes, e incluso su combinación puede crear entornos de mayor motivación para el aprendizaje.

La gamificación estructural es la aplicación de elementos del juego para impulsar a un alumno a través del contenido sin alteración o cambios en este. Con esta estrategia, el contenido no se parece a un juego pero sí tiene la misma estructura. En este caso, el enfoque principal es motivar a los estudiantes a repasar el contenido e involucrarlos en el proceso de aprendizaje mediante recompensas. Los elementos más comunes en esta gamificación son puntos, insignias, logros y niveles; se suele incluir una tabla de clasificación y métodos de seguimiento del progreso del aprendizaje, así como un componente social, en el cual los alumnos pueden compartir los logros con otros estudiantes y enorgullecerse de lo que han alcanzado. Aunque es posible agregar distintos elementos de la historia (como son los personajes), el contenido no cambia para convertirse en un juego.

Por su parte, la gamificación de contenido consiste en la aplicación de elementos del juego, además del pensamiento en el juego, para alterar el contenido y hacer más parecida la estrategia a un juego; por ejemplo: agregar elementos de historia a un curso de cumplimientos o comenzar un curso con un desafío en lugar de una lista de objetivos; ambas son estrategias de gamificación de contenido. Sumar estos elementos hace que el contenido se parezca más a un juego pero no lo convierte en uno, simplemente proporciona el contexto o las actividades que se usan en los juegos y los incorpora al contenido que se enseña.

Werbach y Hunter (2012) proponen un esquema de organización de los elementos de gamificación en tres niveles diferentes (ver Figura 1). En el nivel más elevado se encuentran las dinámicas, las cuales determinan el comportamiento de los estudiantes y se relacionan con la motivación de nuestros alumnos. En el nivel intermedio se ubican las mecánicas, que representan el proceso básico que impulsa la acción y genera la participación del jugador. En el último nivel se sitúan los componentes, que representan las formas específicas que pueden tomar la mecánica o la dinámica o, dicho de otra manera, los recursos disponibles, así como las herramientas que podemos utilizar para diseñar una actividad basada en la gamificación.

A pesar del marco teórico existente, la mayoría de los estudios primarios disponibles se centran en experiencias ad hoc y no en procesos formales de diseño (Mora et al., 2017); por otro lado, la mayoría de esos estudios empíricos no incluyen una evaluación adecuada (Diecheva et al., 2015). Resulta importante destacar que los hallazgos antes citados alentaron, en buena medida, el desarrollo de la propuesta que presentamos en este artículo.

Metodología

Este trabajo es resultado de un estudio de investigación y desarrollo (Gall, Borg & Gall, 2003) cuyas tareas, como parte del proyecto, fueron:

Revisión sistemática de la literatura. Esta tarea tuvo como objetivo identificar, evaluar e interpretar toda la investigación disponible -estudios primarios- para responder a un conjunto de preguntas de investigación específicas en torno a la educación en ingeniería de software. Utilizamos la gamificación como estrategia pedagógica para la motivación de los estudiantes (Briceño et al., 2019).

Diseño de una propuesta instruccional. El propósito de la segunda tarea fue diseñar un modelo instruccional que pudiera ser configurable -en cuanto a la dinámica de interacción- y computable -para ser empleado en la modalidad mixta-, basado en elementos de gamificación previamente identificados, y con el cual pudieran crearse escenarios de aprendizaje.

Desarrollo de tecnología. La finalidad de esta tarea fue aplicar un enfoque sistemático disciplinado y cuantificable al desarrollo de software; es decir, utilizar el proceso de la ingeniería de software para el desarrollo de un prototipo destinado al sistema de gestión de entornos de aprendizaje.

Diseño de escenarios de aprendizaje. Con base en el dominio de aprendizaje seleccionado - temas de ingeniería de software-, diseñamos escenarios de aprendizaje para explorar la viabilidad de intervenciones educativas basadas en los principios de la gamificación para potenciar el aprendizaje en los estudiantes.

Evaluación empírica. Esta tarea se enfocó en la planeación y ejecución de una serie de pruebas piloto con estudiantes, cuya intención fue evaluar la propuesta, así como recoger retroalimentación por parte de usuarios reales, y contrastar diversas alternativas. Se desarrolló en el contexto de una carrera de ingeniería de software.

Introspección y valoración. Con base en los informes de evaluación empírica obtenidos, analizamos los resultados y reflexionamos en torno a las lecciones aprendidas al aplicar el modelo instruccional.

Modelo instruccional

Con base en una revisión del estado del arte sobre la gamificación (Llorens-Largo et al., 2016) y los hallazgos de la revisión sistemática de la literatura en la primera etapa de nuestra investigación (Briceño et al., 2019), diseñamos la propuesta de un modelo instruccional basado en los elementos de la gamificación para promover aprendizajes en un área de conocimiento particular, en ingeniería de software.

La propuesta hace uso de cuatro elementos de gamificación que dan sustento al modelo: nivel de complejidad, acumulación de puntos, obtención de insignias y retroalimentación.

Para la implementación del primer elemento, nivel de complejidad, la propuesta utiliza como referencia la taxonomía de Bloom en sus primeros cuatro niveles: conocimiento, comprensión, aplicación y análisis.

La acumulación de puntos tiene como dinámica la asignación de determinados puntos por retos cumplidos, que se van acopiando durante todo el proceso.

Como tercer elemento, el modelo incorpora, como reconocimiento al desempeño en el proceso de instrucción, la adjudicación de insignias en los casos en los que el aprendiz podrá ganarlas en el primer esquema.

Finalmente, el elemento de retroalimentación refuerza o promueve (según sea el caso) aquellos aprendizajes aún no obtenidos o alcanzados de manera parcial.

Además, el modelo incorpora otros dos elementos: la barra de progreso y la tabla de clasificación. La primera indicará el avance del aprendiz y la segunda permitirá ver el puntaje acumulado de todos los participantes en el entorno.

Para organizar el modelo, creamos tres constructos con base en los cuales es posible configurar los escenarios de aprendizaje, según convengan al docente: reto, bloque y esquema.

Reto: es implementado mediante un reactivo de respuesta estructurada en un nivel de complejidad determinado e incorpora un número limitado de respuestas posibles, cuyo logro facilita la acumulación de puntos por parte del estudiante.

Bloque: está formado por un conjunto n de retos; cabe mencionar que estos, dentro de un bloque, se encuentran en un mismo nivel de complejidad.

Esquema: está constituido por un conjunto de bloques con niveles de complejidad progresivos, así como con dinámicas de interacción diferenciadas (individual, pareja-competitivo y pareja-colaborativo).

El modelo instruccional propuesto, en su máxima configuración, se compone hasta por tres esquemas diferentes que implementan las tres dinámicas de interacción consideradas para el entorno virtual de aprendizaje (EVA).

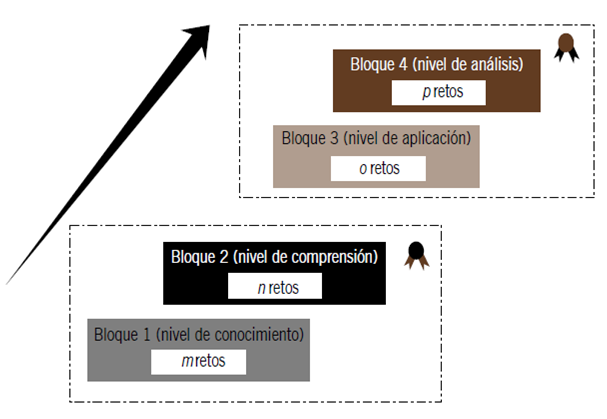

El esquema 1 (ver Figura 2) utiliza un tipo de interacción individual, y puede integrarse por dos o cuatro bloques, cada uno con un nivel de complejidad diferente, de acuerdo con la taxonomía de Bloom: en el bloque 1, el aprendiz se enfrenta a retos en el nivel de conocimiento; el bloque 2 contiene retos con el nivel de comprensión; el bloque 3, retos en el nivel de aplicación; y el bloque 4 incluye retos en el nivel de análisis. El modelo propone que en el esquema 1 el número de retos que constituye cada bloque sea distinto y en cantidades decrecientes; así, el bloque 1 estaría formado por m retos; el 2, por n retos; el 3, por o retos; y el 4, por p retos, en los cuales m>n>o>p. Cada uno de los retos deberá estar diseñado con cuatro opciones de respuesta y tendrá asignado un puntaje específico.

Respecto a la dinámica de trabajo, el aprendiz tendrá dos oportunidades para responder correctamente cada reto: si lo hace de manera acertada en la primera oportunidad, obtendrá el total de puntos asignados; en caso de equivocarse, dispondrá de una segunda oportunidad para responder las tres opciones de respuesta restantes y si la respuesta es correcta, acumulará el 50% del puntaje asignado al reto, aunque si contesta en forma errónea, podrá obtener una retroalimentación referente al reto en curso. Esta dinámica relacionada con la retroalimentación podrá ofrecerse en un máximo de dos situaciones al interior del esquema.

En caso de que el aprendiz requiera retroalimentación por tercera ocasión, recibirá una invitación para estudiar el tema correspondiente. El modelo considera que el aprendiz perderá los puntos acumulados hasta el momento en ese esquema y deberá comenzarlo desde su inicio. En este primer esquema se prevé la adjudicación de dos posibles insignias, la azul podrá ser alcanzada por el estudiante cuando responda en forma correcta en su primera oportunidad los retos de los bloques 1 y 2; en cuanto a la insignia roja, podrá conseguirse cuando supere en la primera oportunidad los retos de los bloques 3 y 4.

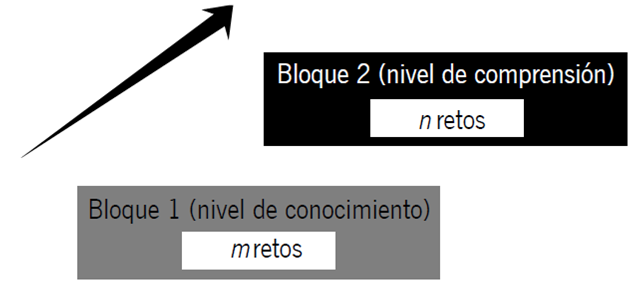

De acuerdo con el modelo instruccional propuesto, el esquema 2 implementa el tipo de interacción pareja-competitivo y se integra solo de dos bloques, con retos en los niveles de conocimiento y comprensión, respectivamente (ver Figura 3). Al igual que en el esquema 1, el número de retos de cada bloque es diferente y en cantidades decrecientes.

Con base en la dinámica de interacción propuesta para el esquema 2, el aprendiz compite con otro compañero para obtener el turno; una vez asignado este, podrá dar respuesta al reto: si responde correctamente, alcanzará los puntos de este reto, y si lo hace de modo erróneo, el entorno virtual concederá el turno al segundo estudiante, quien podrá elegir de entre las tres opciones de respuesta restantes y, de contestar en forma correcta, logrará los puntos asignados al reto. Hay que aclarar que, si ninguno supera el reto, la dinámica del esquema 2 permite el cambio de la insignia azul por una segunda oportunidad para dar respuesta al reto y seleccionar entre las dos respuestas restantes. Si ambos aprendices obtienen esa insignia, deberán competir por el turno y el cambio de esta.

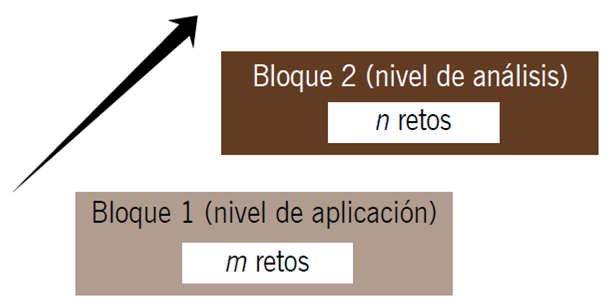

Finalmente, conforme al modelo instruccional propuesto, el tercer esquema efectúa un tipo de interacción pareja-colaborativo, y también se integra por dos bloques con retos en los niveles de aplicación y análisis (ver Figura 4). Al igual que en el esquema 2, el número de retos que contiene cada bloque es diferente y en cantidades decrecientes. Con base en la dinámica de este esquema, dos aprendices deben trabajar en conjunto para resolver los retos de los bloques correspondientes. Los estudiantes se podrán comunicar a través de una herramienta (por ejemplo, el chat) para discutir ideas y llegar a un acuerdo, con la finalidad de responder de forma correcta las preguntas. La intención es lograr un nivel de colaboración en algún momento del desarrollo del EVA.

El número de retos en ambos niveles es siempre par, debido a que los aprendices tendrán los roles -intercambiables- de representante y asistente conforme avanzan en el esquema; el representante interactúa con los retos y el asistente analiza, junto con su compañero, la respuesta correcta. En este tercer esquema, cuando el aprendiz responde de modo erróneo, se permite el cambio de la insignia roja por una segunda oportunidad para dar respuesta al reto, independientemente de quién posea el turno

La educación en ingeniería de software

La ingeniería de software es una disciplina que surgió en la segunda mitad del siglo XX, y en México es considerada como una profesión desde inicios del siglo actual (Aguilar y Díaz, 2015); no obstante, a pesar de contar con un cuerpo de conocimientos aceptado por académicos y profesionales (Bourque & Fairley, 2014), aún persisten problemáticas en cuanto a las mejores prácticas de sus procesos de desarrollo y gestión, así como de los procesos vinculados a su educación, es decir, su enseñanza y aprendizaje.

El uso de la gamificación como dinámica instruccional ha sido considerado cada vez más como una estrategia viable en la educación de la ingeniería de software (Schefer-Wenzl & Miladinovic, 2018). Esta dinámica aumenta el compromiso y la motivación de los estudiantes al permitir un aprendizaje independiente con velocidad flexible y elección de énfasis (Berkling & Thomas, 2013).

En el caso de las dinámicas de equipo, la gamificación puede motivar a los integrantes de un equipo a cumplir los objetivos de su trabajo e, incluso, en dinámicas de colaboración se podría mejorar el nivel de cohesión del equipo (Hernández et al., 2017); por lo tanto, el empleo pertinente de los elementos de gamificación para promover una mejora tanto en los procesos de formación como en los relacionados con el desarrollo de software resulta un aspecto de singular interés para la propuesta (Briceño et al., 2019).

Evaluación empírica

Con la intención de evaluar el modelo instruccional propuesto, planificamos un primer estudio empírico, para el cual generamos y configuramos un entorno virtual basado en un escenario de aprendizaje diseñado ex profeso en un tema de la ingeniería de software. Cabe mencionar que la evaluación previó algunas restricciones vinculadas a la dinámica del curso en el que sería administrada.

Restricciones

Acordamos diseñar escenarios de aprendizaje en temáticas vinculadas con la educación de la ingeniería de software; en particular, las que estuvieran incluidas en el plan de estudios de la Licenciatura en Ingeniería de Software (programa curricular ofrecido en la Universidad Autónoma de Yucatán) (Aguilar y Díaz, 2015), y en específico en cursos en los que los integrantes del grupo de investigación tuvieran participación activa. Por otro lado, con la intención de afectar lo menos posible la dinámica de los cursos en los que se brindarían las sesiones de validación empírica, diseñamos escenarios que fueran abordados por los estudiantes en sesiones de aprendizaje únicas, por lo cual configuramos espacios de aprendizaje que se implementaran en esquemas independientes del modelo.

Escenario de aprendizaje

El escenario de aprendizaje utilizó como refe-rencia el primer esquema del modelo, es decir, fue concebido para evaluar conocimientos de forma individual (tipo de interacción) en temas de la asig-natura, en particular, aspectos de las primeras cua-tro unidades. Vale la pena aclarar que el contenido de la unidad cinco no se incluyó en el estudio debi-do a que la sesión presencial en la que se ejecutaría la evaluación se intercaló con las sesiones de las últimas semanas del curso que analizan la temá-tica de esta unidad. Para ese escenario de aprendi-zaje diseñamos un conjunto de retos acordes con los temas de las primeras cuatro unidades y con los niveles de conocimiento de los cuatro bloques que integran el esquema 1. La Tabla 1 ilustra el número de retos delineados para el primer escenario.

Diseño del estudio experimental

Utilizamos como referencia el escenario descrito en la sección anterior para configurar un EVA ad hoc (ver Tabla 2) y registramos a los alumnos del grupo experimental, inscritos en el período agosto-diciembre de 2019, en uno de los grupos de la asignatura de Diseño de bases de datos. Cabe mencionar que la participación por parte de los estudiantes no fue obligatoria. La dinámica se diseñó como una actividad de aprendizaje adicional al curso y cuyo puntaje -agregado al planificado en el curso- estaría en función del resultado obtenido. La Tabla 2 ilustra la configuración del puntaje para el EVA.

Tabla 2 Configuración del entorno virtual de aprendizaje

| Bloque | # Retos | Puntos x reto | Total x bloque | |

|---|---|---|---|---|

| I | 10 | 2 | 20 | |

| II | 6 | 4 | 24 | |

| III | 4 | 6 | 24 | |

| IV | 2 | 16 | 32 | |

| Puntaje total del EVA | 100 | |||

Fuente: elaboración propia.

Los 21 estudiantes que participaron de manera voluntaria en el estudio experimental fueron asignados aleatoriamente a uno de los dos grupos: el A (grupo de control con siete estudiantes) fue evaluado con un instrumento en papel con retos seleccionados al azar de entre los retos diseñados para el estudio, y el B (grupo experimental con catorce estudiantes) fue evaluado mediante del EVA. El instrumento en papel utilizó la misma configuración que la del EVA.

Con la finalidad de explorar la bondad del modelo instruccional propuesto en comparación con métodos tradicionales, consideramos dos variables dependientes cuyas definiciones operacionales describimos a continuación:

Tiempo: se refiere a los minutos utilizados por el aprendiz para elaborar la tarea.

Puntaje: es la suma de puntos obtenida por el aprendiz en la sesión.

La Tabla 3 (página siguiente) presenta las métricas para las dos variables en cada uno de los 21 sujetos experimentales divididos en los grupos: control (grupo A) y experimental (grupo B).

En nuestro estudio el factor controlado fue el tipo de escenario usado para la actividad, y las alternativas del factor fueron prueba de desempeño en papel (PD) y EVA (software). La sesión experimental se planificó en cuatro etapas:

Descripción de la dinámica de la sesión

Descripción del EVA, orientado a los estudiantes del grupo B

Desarrollo de la actividad de aprendizaje

Administración de un instrumento que recoge opiniones de los estudiantes del grupo B

Tabla 3 Métricas de tiempo y puntaje obtenidas con los participantes asignados a los grupos

| Sujeto | Grupo A | Grupo B | Tiempo | Puntaje |

|---|---|---|---|---|

| 1 | X | 30 | 64 | |

| 2 | X | 28 | 66 | |

| 3 | X | 22 | 53 | |

| 4 | X | 35 | 66 | |

| 5 | X | 29 | 70 | |

| 6 | X | 14 | 73 | |

| 7 | X | 14 | 68 | |

| 8 | X | 19 | 93 | |

| 9 | X | 28 | 90 | |

| 10 | X | 28 | 66 | |

| 11 | X | 19 | 70 | |

| 12 | X | 44 | 48 | |

| 13 | X | 21 | 79 | |

| 14 | X | 19 | 78 | |

| 15 | X | 26 | 75 | |

| 16 | X | 23 | 53 | |

| 17 | X | 22 | 60 | |

| 18 | X | 25 | 32 | |

| 19 | X | 33 | 68 | |

| 20 | X | 27 | 0 | |

| 21 | X | 14 | 79 |

Fuente: elaboración propia.

Análisis descriptivo

Con base en las métricas obtenidas para la variable puntaje, elaboramos un resumen estadístico que puede analizarse en la Tabla 4. En esta podemos observar que los estudiantes que utilizaron el esquema tradicional para la actividad de aprendizaje (PD) lograron en promedio ocho puntos menos de calificación que los que emplearon el EVA; asimismo, este grupo reportó mucha mayor variabilidad -cerca de siete unidades- en sus puntajes. El rango de calificaciones alcanzadas con la alternativa de la prueba de desempeño fue más amplio en 18 unidades respecto de la alternativa del EVA, e incluyó valores menores. Cabe destacar que en el caso de los estudiantes del grupo B, tomamos la decisión de descartar la métrica del estudiante 20 debido a que no representaba la evaluación correcta (el EVA no la registró).

Tabla 4 Resumen estadístico para la variable puntaje

| Factor | Recuento | Promedio | Desviación estándar | Mínimo | Máximo | Rango |

|---|---|---|---|---|---|---|

| PD | 7 | 62.2857 | 18.1633 | 32.0 | 90.0 | 58.0 |

| EVA | 13* | 70.3846 | 11.1396 | 53.0 | 93.0 | 40.0 |

| Total | 20 | 67.55 | 14.0805 | 32.0 | 93.0 | 61.0 |

*Se descartó al estudiante que solicitó iniciar de nuevo por haber requerido tres retroalimentaciones.

Fuente: elaboración propia.

En cuanto a la variable tiempo, en el resumen estadístico (ver Tabla 5, página siguiente) podemos advertir que los estudiantes que se evaluaron con el esquema tradicional (PD) utilizaron en promedio casi ocho minutos más para concluir su sesión, en comparación con los que la realizaron con el EVA; no obstante, su desviación estándar fue ligeramente menor. Por otro lado, si bien el rango obtenido con la primera alternativa es menor en dos unidades de tiempo, este contiene valores más elevados.

Análisis inferencial

Con el propósito de realizar un análisis estadístico que permita evidenciar posibles diferencias entre las dos alternativas de nuestro factor controlado, para la variable puntaje planteamos un par de hipótesis estadísticas:

Para el análisis inferencial, utilizamos el análisis de varianza (ANOVA), que nos ayuda a evaluar estadísticamente la significancia de la diferencia entre los dos grupos. Este análisis descompone la varianza de la variable puntaje en dos componentes (ver Tabla 6), uno entre-grupos y uno dentro-de-grupos (Gutiérrez y De la Vara, 2012). La razón-F, que en este caso es igual a 1.55, es el cociente entre el estimado entre-grupos y el estimado dentro-de-grupos. Debido a que el valor-P de la razón-F es mayor o igual que 0.05, estaríamos en condiciones de afirmar que no existe una diferencia estadísticamente significativa entre la alternativa PD y la del EVA para la variable puntaje.

Tabla 6 Resultado del ANOVA para la variable puntaje

| Fuente | Suma de cuadrados | Gl | Cuadrado medio | Razón-F | Valor-P |

|---|---|---|---|---|---|

| Inter-grupos | 298.445 | 1 | 298.445 | 1.55 | 0.2293 |

| Intra-grupos | 3468.51 | 18 | 192.695 | - | - |

| Total | 3766.95 | 19 | - | - | - |

Fuente: elaboración propia.

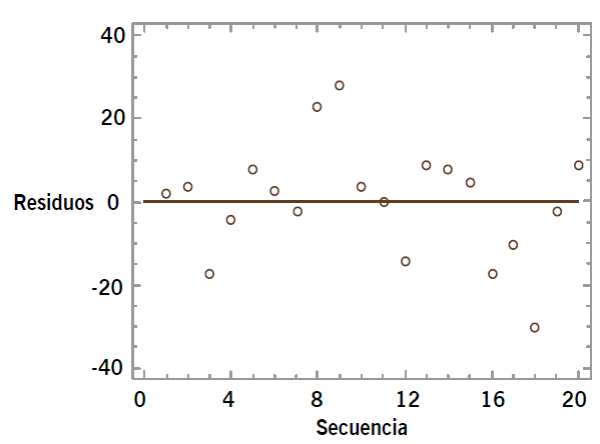

Para considerar como válido este resultado, es necesario evaluar los tres supuestos del modelo ANOVA: normalidad, homocedasticidad e independencia de los datos. En el supuesto de normalidad, aplicamos la prueba de Shapiro-Wilks a los residuos, y obtuvimos un valor de p mayor de 0.05 (0.5606), el cual nos indica que los datos se comportan de acuerdo con la distribución normal. Para validar la homocedasticidad, ejecutamos la prueba de Levene, que resultó en un p-valor de 0.3120; con base en esto, podemos afirmar que no existe una diferencia estadísticamente significativa entre las desviaciones estándar, con un nivel del 95.0% de confianza. Finalmente, para validar la independencia de los datos, optamos por un análisis gráfico, para lo cual utilizamos el gráfico de residuos por secuencia (ver Gráfica, página siguiente). En este gráfico observamos que no existe un comportamiento particular de los datos, más bien los valores se encuentran dispersos, con lo que podemos concluir el cumplimiento del tercer supuesto.

Con los supuestos del modelo ya validados, es posible afirmar que no existe una diferencia estadísticamente significativa para la media de la variable puntaje entre ambas alternativas, con un nivel del 5% de significación; es decir, estadísticamente, no es posible rechazar la hipótesis de nulidad y resulta que la hipótesis válida es:

De manera similar al análisis previo, procedimos al análisis estadístico en cuanto a las posibles diferencias entre las dos alternativas; consideramos la variable tiempo, para lo cual planteamos las siguientes hipótesis estadísticas:

Con el ANOVA obtuvimos un p-valor menor de 0.05 (0.0118), lo que nos indica una diferencia estadísticamente significativa en la media de la variable tiempo entre las dos alternativas; no obstante, al proceder con la validación del supuesto de normalidad -aplicamos la prueba estadística de Shapiro-Wilks-, el p-valor fue menor de 0.05 (0.0139), lo cual revela que los datos no cumplen con la hipótesis de normalidad.

Por lo anterior, procedimos con el uso de una prueba no paramétrica para el análisis de dos muestras independientes, en particular, la prueba de W de Mann-Whitney (Wilcoxon), y replanteamos nuestra pareja de hipótesis estadística utilizando la mediana como parámetro:

Esta prueba se construye combinando las dos muestras, ordenando los datos de menor a mayor y comparando los rangos promedio de las dos muestras en los datos combinados. La Tabla 7 ilustra los resultados de la prueba estadística.

Tabla 7 Resultado de la prueba W de Mann-Whitney para la variable tiempo

| Factor | Recuento | Rango promedio | Estadístico | Valor-P |

|---|---|---|---|---|

| PD | 7 | 16.0 | 14.0 | 0.00974341 |

| EVA | 14 | 8.5 | - | - |

Fuente: elaboración propia.

Debido a que el valor-P es menor de 0.05, podemos concluir que existe una diferencia estadísticamente significativa entre las medianas de las alternativas con un nivel de confianza del 95.0%; con lo anterior, es posible rechazar la hipótesis de nulidad y aceptar la hipótesis alternativa:

Análisis de opiniones

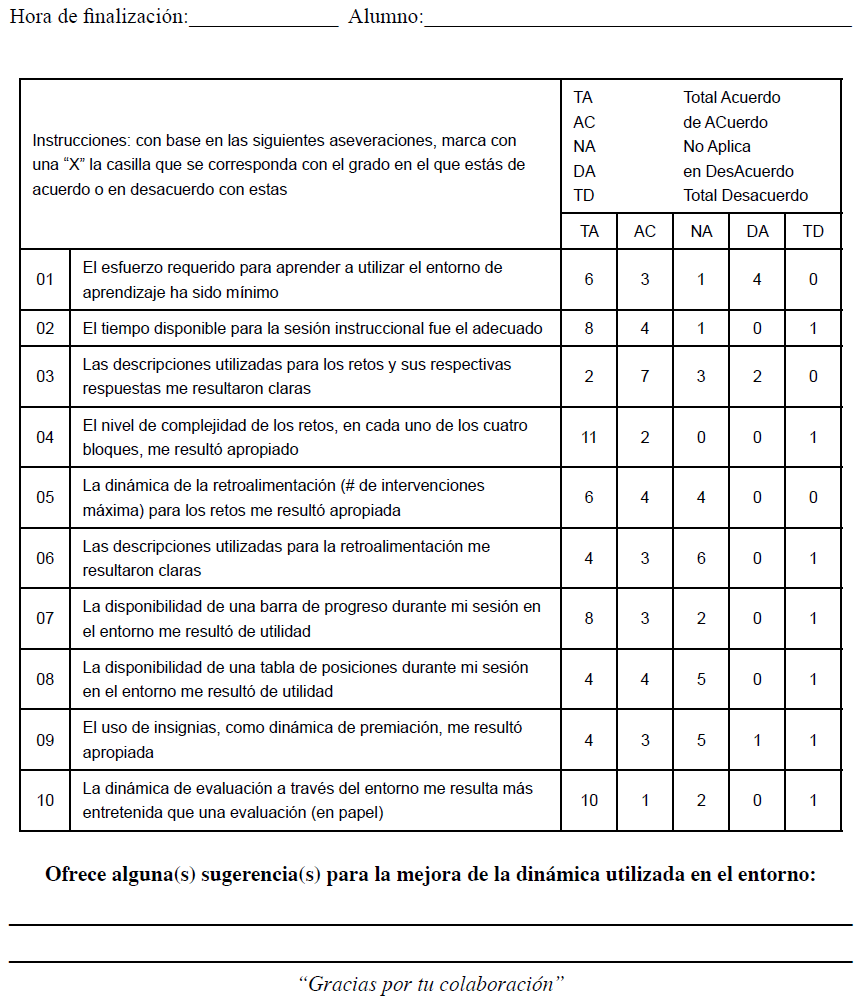

Como parte del estudio empírico con estudiantes, elaboramos un instrumento ex profeso basado en una escala Likert (ver Figura 5, página siguiente), en el cual los primeros dos ítems evalúan aspectos de usabilidad, los ítems 3-9 están orientados a evaluar la incorporación de los elementos de gamificación al EVA, y el ítem 10 recoge las opiniones de la dinámica instruccional implementada como parte del esquema 1 del modelo instruccional propuesto.

Las opiniones indican que 64% de los aprendices señaló que el esfuerzo para aprender y, en su caso, utilizar el EVA fue mínimo y 86% se manifestó en forma positiva respecto del tiempo disponible para la actividad en la sesión.

En el caso de las opiniones de los elementos de gamificación incorporados al modelo y, por tanto, implementados en el EVA, se comportaron de la siguiente manera: respecto del constructo de los retos, 67% opinó que las descripciones fueron claras y 93% que su complejidad resultó adecuada.

En el uso de retroalimentación como elemento de gamificación, 71% consideró positiva la dinámica utilizada; sin embargo, solo 50% indicó que las descripciones les resultaron claras; cabe mencionar que en este ítem 43% no emitió opinión en algún sentido.

En cuanto al elemento de gamificación barra de progreso, 79% señaló que le resultó de utilidad, y sobre el elemento tabla de posiciones, únicamente 57% dijo que le pareció útil. Por su parte, el uso de insignias como dinámica de premiación reportó 50% de opiniones positivas, y solo 7% lo consideró negativo. Finalmente, en lo referente a la dinámica generada con el EVA, a 76% de los aprendices les pareció más entretenida comparada con la tradicional.

Conclusiones

En este artículo presentamos un modelo instruccional configurable y computable basado en elementos de gamificación, evaluado empíricamente con un caso en el área de la educación en ingeniería de software. El modelo incorpora tres constructos: reto, bloque y esquema, con base en los cuales se organizó la propuesta de intervención pedagógica en escenarios de aprendizaje sobre algún dominio particular.

La metodología de investigación-acción permite un proceso continuo, en el cual el investigador, en su papel de docente, diseña escenarios de aprendizaje estructurados; en nuestro caso, asistidos por entornos virtuales para incorporar dinámicas innovadoras en las que es posible configurar la interacción con el entorno en forma individual, colaborativa con un compañero, así como bajo un esquema competitivo para el reforzamiento de competencias.

Consideramos que la propuesta de ofrecer un modelo instruccional configurable para el diseño de escenarios de aprendizaje contrasta con la mayoría de los estudios primarios en los cuales se reportan experiencias de intervención ad hoc (Mora et al., 2017), lo que resulta en una aportación al ámbito del diseño instruccional.

Por otra parte, a diferencia de la mayoría de los estudios primarios encontrados en la literatura (Diecheva et al., 2015), el artículo reporta una primera evaluación empírica al modelo. En este estudio de caso utilizamos el esquema 1 para una dinámica de reforzamiento sobre aspectos del área de la ingeniería de software, en particular, el dominio del diseño de bases de datos. Para el estudio experimental planteamos como factor controlado por el investigador el tipo de modalidad aplicado en la dinámica, con dos tratamientos: la dinámica tradicional de emplear un documento en papel para la prueba de desempeño, y el uso de un EVA configurado con base en el modelo propuesto. Las variables dependientes consideradas fueron el tiempo dedicado por el estudiante a la actividad y el puntaje obtenido al finalizar esta.

Del análisis estadístico, concluimos que, aun cuando la media del puntaje alcanzado por los estudiantes que usaron el EVA es mayor y presenta menor variabilidad que el de los estudiantes que realizaron la actividad con el método tradicional, esta variable no presenta diferencias estadísticamente significativas, lo cual indica que el aprovechamiento es similar.

En este sentido, los estudios que reportan algún tipo de evaluación, en general, se enfocan en el aspecto motivacional como aliado del aprendizaje (Da Rocha, Gomes & De Melo, 2016), sin contrastar el aprendizaje en sí. Por ello, consideramos importante evidenciar que esta estrategia instruccional, si bien no mejora de modo significativo el aprovechamiento, tampoco resulta ser un elemento distractor del proceso de aprendizaje; no obstante, aspectos como la usabilidad del EVA, los elementos de gamificación incorporados al modelo, así como la propia dinámica instruccional, generaron una apreciación positiva en el estudio de opiniones, lo cual coincide con algunas de las lecciones aprendidas (Llorens-Largo et al., 2016).

En cuanto a la segunda variable analizada (el tiempo), esta mostró diferencias estadísticamente significativas al utilizar los estudiantes menos tiempo con el EVA, en comparación con los que utilizaron la PD -con similar variabilidad en los datos-. Este hallazgo no es atribuible al componente de la gamificación, más bien al elemento computable considerado en el modelo, es decir, a la inclusión de las TIC -a través del EVA- como parte del escenario de aprendizaje creado. Vale la pena comentar que, en circunstancias como las vividas ante la pandemia del Covid-19, el uso de un EVA representa, en muchos casos, no una alternativa, sino la única vía para instrumentar los procesos educativos.

Finalmente, es importante mencionar que, al momento de escribir este artículo, hemos concluido un segundo estudio con estudiantes en un curso de fundamentos de ingeniería de software, en este caso, recurrimos al esquema 2 del modelo instruccional; para esta segunda intervención pedagógica, recabamos opiniones positivas tanto de la dinámica competitiva como de los elementos basados en la gamificación incorporados al EVA.

text new page (beta)

text new page (beta)