I. Introducción

La emergencia de las iniciativas de contenido generado por el usuario, en las que el contenido no se entrega a los estudiantes sino que lo crean ellos mismos conjuntamente, el aumento de las prácticas educativas abiertas (OEP), los cursos MOOC, y la creación de nuevos proveedores de soluciones de autoaprendizaje como los Open Educational Resources (OER) University, Peer2Peer University o University of the People están transformando escenarios conocidos en otros dominios de una naturaleza mucho más incierta. Esta tendencia plantea un reto para las instituciones conservadoras, especialmente las universidades (Vázquez-Cano, 2013). En esta misma línea, de acuerdo con las propuestas realizadas por diferentes autores (Castaño y Cabero, 2013; Vázquez-Cano, López-Meneses y Barroso, 2015), las características principales de los MOOC se pueden encuadrar en las siguientes: es un recurso educativo que tiene cierta semejanza con una clase, tienen fechas de comienzo y finalización; cuentan con mecanismos de evaluación, se desarrollan en línea, su acceso es gratuito, son abiertos a través de la web y no tienen criterios de admisión, y permiten la participación interactiva a gran escala de un grupo masivo de estudiantes.

La filosofía de esta modalidad formativa puede suponer una democratización de la educación superior (Finkle y Masters, 2014; Dillahunt, Wang y Teasley, 2015). Asimismo, la demanda de estos cursos posiciona a España entre los cinco países con más estudiantes en esta modalidad formativa, teniendo sólo por delante a nivel mundial países como Estados Unidos, Reino Unido, Canadá o Brasil (Aguaded, Vázquez-Cano y López-Meneses, 2016). Por último, como indican diferentes autores (López Meneses, Vázquez-Cano y Román, 2015) hay un incremento ascendente de artículos científicos relacionados sobre esta temática a nivel mundial desde el año 2013.

Sin embargo, este tipo de formación es utilizada por muchas organizaciones educativas sin garantizar el cumplimiento de calidad mínima exigida por los participantes. En este sentido, se hace necesario que los usuarios de formación no presencial puedan seleccionar los cursos que mejor se adapten a sus necesidades y expectativas, y que las organizaciones educativas puedan mejorar su oferta y, con ello, la satisfacción del estudiantado. En este sentido, el análisis descriptivo comparativo entre instrumentos de evaluación de cursos virtuales producirá nuevos escenarios que ayudarán al diseño de herramientas de calidad más eficientes. Estos nuevos elementos serán capaces de disminuir el posible diferencial existente entre las expectativas de los participantes y su nivel de satisfacción y, por tanto, la gran oferta de la formación virtual ganará en fiabilidad y credibilidad, mitigándose el riesgo de abandono de los usuarios y proporcionando cursos virtuales garantizados por parámetros de mayor calidad (Baldomero, Salmerón y López-Meneses, 2015).

En este estudio se diseñarán las bases de esos nuevos instrumentos a partir del análisis comparativo entre las herramientas de valoración de calidad EduTool® (Baldomero y Salmerón, 2015) y UMUMOOC (Guerrero, 2015) que pueda reducir las posibles deficiencias de la valoración de la calidad normativa de los cursos MOOC.

1.1 Antecedentes y tendencias en instrumentos de evaluación de la calidad MOOC

El volumen de investigación clave en materia de diseño de instrumentos que puedan evaluar la calidad de los cursos MOOC se inicia en el año 2012 para dar cumplimiento al apartado 6.2 de la Norma UNE-EN ISO 9001 sobre Sistemas de Gestión de la Calidad, al proporcionar la demanda necesaria a sus empleados y garantizar su competencia. En este sentido, se requiere asegurarse de que la formación virtual adquirida cumpla los requisitos de compra especificados de acuerdo con el apartado 7.4 de la norma citada. Por ello, la Norma UNE 66181:2012 pretendió servir como guía para identificar las características de las acciones formativas virtuales, de forma que los usuarios de formación virtual puedan seleccionar los cursos virtuales que mejor se adapten a sus necesidades y expectativas, y que las organizaciones educativas puedan mejorar su oferta y, con ello, la satisfacción de sus alumnos. Así pues, y en base a este estándar, las dimensiones que abarcan los factores de satisfacción de la formación virtual son: Empleabilidad, Metodología de aprendizaje y Accesibilidad.

A partir de ese momento, la línea de trabajo iniciada en la investigación “Innovación docente 2.0 con Tecnologías de la Información y la Comunicación en el Espacio Europeo de Educación Superior”, situada en el marco de la Acción 2 de Proyectos de Innovación y Desarrollo Docente de la Universidad Pablo de Olavide de Sevilla y desarrollado en el Laboratorio de Inteligencia Computacional (LIC) mediante el Grupo de Investigación de Sistemas y Tecnologías de la Información (TEP-240) liderado por el Dr. José Luis Salmerón, presenta un escenario de estudio de comparación entre la citada Norma UNE 66181:2012 y el instrumento ADECUR (Baldomero, Salmerón y López-Meneses, 2015). En esta línea, ADECUR es un instrumento de evaluación capaz de analizar e identificar los rasgos definitorios de la calidad didáctica de los cursos virtuales, desde los baremos proporcionados por el paradigma socio-constructivista, como vía para promover un desarrollo adecuado de los procesos de innovación docente (Cabero y López-Meneses, 2009).

De este estudio se concluye que se podrían acreditar a las plataformas ofertantes con cursos MOOC certificados y evitar la oferta de acciones formativas con debilidades en las metodologías de enseñanza inapropiadas desde las actuales teorías pedagógicas (Valverde, 2014) e impidiendo, en la medida de lo posible, la tendencia a la estandarización del conocimiento y los graves problemas para atender las diferencias individuales debido a la masificación, que conduce a un diseño comunicativo unidireccional, centrado en el docente y basado en el contenido. Así pues, los MOOC se podrían mostrar como una democratización de la Educación Superior, pero con unos intereses pedagógicos que primen sobre los económicos. Posteriormente, el citado LIC analiza la calidad normativa de los cursos MOOC a través del instrumento EduTool1. Este trabajo llega a las mismas conclusiones que otras investigaciones, donde se evidencia que los MOOC tienen una base pedagógica sólida en sus formatos (Glance, Forsey y Riley, 2013). De forma general se puede afirmar que la valoración de la calidad de los MOOC analizados no sólo estaba por encima de la puntuación media estimada, sino que éstos presentaban una puntuación promedio ligeramente superior a la media (Roig, Mengual-Andrés y Suárez, 2014).

En esta línea, Sánchez-Vera y Prendes-Espinosa (2015) muestran en su trabajo métodos alternativos de evaluar los MOOC. Asimismo, los autores señalan la necesidad de una complementariedad evaluativa, esto es, consensuar que se hace necesaria la investigación sobre la evaluación en los MOOC y el uso de varios métodos para ello. De esta manera, el problema que produce la masificación se encuentra cuando se considera a la evaluación que forma parte del proceso global de enseñar; es decir, cuando se entiende que evaluar es aprender y que se deben utilizar estrategias procesuales y formativas. Estos autores siguen la misma estela que Sandeen (2013), cuando plantea que la evaluación centra el desarrollo de los MOOC desde el principio, pero muy al contrario se cree que muchos MOOC centran su atención en el desarrollo de un contenido de calidad o en el aprendizaje en comunidad, dejando la evaluación y la certificación en un segundo plano.

Por otra parte, algunos estudios afirman que existe una relación inversa entre la motivación mediante insignias o acreditaciones y el aprendizaje adquirido (Daniel, Vázquez-Cano y Gisbert, 2015; Vázquez-Cano y López-Meneses, 2014). En este sentido, la acreditación abre la puerta a los ingresos de tasas por curso y, por otro lado, se hace necesario conocer cómo se evalúa el aprendizaje y cómo valoran los empleadores dichas certificaciones. Abonando a esta idea, Chen (2014) lleva a cabo un estudio donde los resultados son desalentadores respecto a la calidad de la evaluación de los MOOC. De esta manera, las universidades de élite están acometiendo cursos MOOC con el fin de ampliar el acceso a la educación superior, la comercialización y la marca, y el desarrollo de nuevas fuentes de ingreso. Sin embargo, como argumenta Daniel (2012), a pesar de que las universidades de élite que participan activamente en MOOC ganaron su reputación en la investigación, pueden no tener talento en la enseñanza, especialmente en la enseñanza en línea. En otras palabras, la investigación es diferente a la enseñanza y el hecho de que las universidades de élite alcancen grandes logros en investigación no implica que sean capaces de ofrecer cursos MOOC de calidad. Este autor cuestiona la calidad que deben mantener los MOOC sin que se tenga que pagar ninguna cuota para su inscripción (tan solo para obtener la certificación correspondiente) y que puede verse dañada por la falta de una base común de conocimientos y formación académica entre el estudiantado. Por último, aclara que la realización de evaluaciones eficaces en un MOOC es un gran reto y advierte que los métodos a la hora de engañar en las evaluaciones en línea por parte de los participantes son abundantes, trayendo como consecuencia evaluaciones ineficaces y no válidas.

Con base en lo anterior, se hace necesaria una línea de trabajo en el LIC mediante el Grupo de Investigación de EduInnovagogía (HUM-971), donde se presenta un escenario de estudio de comparación entre el instrumento EduTool® y la herramienta UMUMOOC, que pueda eliminar los posibles defectos de la valoración de la calidad de los cursos MOOC aumentando su ámbito dimensional.

II. Método

El estudio pertenece a la línea de trabajo iniciada en la investigación desarrollada en el LIC mediante el Grupo de Investigación de EduInnovagogía, donde se muestra un escenario de comparación entre diferentes instrumentos de valoración de la calidad MOOC que aumente su ámbito dimensional y reduzca, en la medida de lo posible, evaluaciones deficientes y poco válidas. Para ello, se han utilizado dos modelos de medición de calidad: EduTool® y UMUMOOC.

2.1 EduTool

EduTool es un modelo basado en un di seño de investigación cuantitativo no experimental (McMillan y Shumacher, 2005) que adapta la norma UNE 66181:2012 a los cursos MOOC. En esta adaptación no se tomó la información de los niveles de calidad de acuerdo a un sistema de representación acumulativo de estrellas, como marca el estándar normativo. Es decir, un curso MOOC podría incluir indicadores de distintas rúbricas de niveles de calidad superiores sin acumularse. De tal forma que se podría valorar la calidad MOOC cuantitativa con este instrumento diferenciándose de la calidad cualitativa de todos los cursos que contengan la suma de los indi cadores de los mismos niveles de rúbricas anteriores. El objetivo de este instrumento no es corregir la norma sino realizar una valoración de granularidad más fina que la meramente cualitativa.

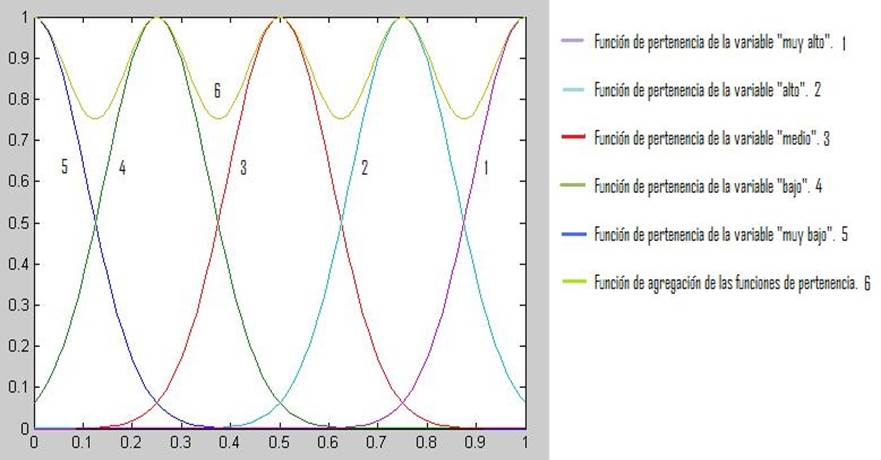

En este sentido, los MOOC podrían incluir indicadores de distintas rúbricas de niveles de calidad sin la restricción de ser acumulativos. Por tanto, este instrumento valora cualitativa y cuantitativamente las dimensiones que abarcan los factores de los mismos adaptando el estándar normativo mediante una ponderación de los subfactores de cada una de las dimensiones de la norma UNE 66181:2012 a través de Lógica difusa (Baldomero y Salmerón, 2015). Los expertos evaluaron con variables lingüísticas cada uno de los subfactores de las dimensiones del instrumento y la función de pertenencia Gaussiana asociada para cada elemento de x (opinión del experto en la escala de variables lingüísticas) un grado de pertenencia al conjunto difuso. En este escenario, la agregación de las funciones de pertenencia de las variables lingüísticas de los expertos se muestra en la figura 1.

Figura 1 Función de agregación de las funciones de pertenencia de las variables lingüísticas de los expertos

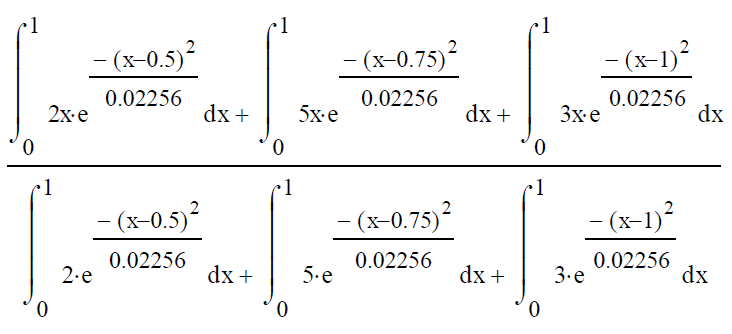

Los datos de los expertos están basados en conjuntos difusos y se originan por la utilización de calificaciones lingüísticas. De esta manera, la defusificación utilizada se centra en el método del centroide de área. A título de ejemplo para el subfactor 2.2., se devolverá un valor defusificado de una función de pertenencia asociada al valor de la variable x, como se muestra en la fórmula de la figura 2.

Subfactor 2.2=0,6632

Figura 2. Valor defusificado de una función de pertenencia asociada al valor de x

Con base en lo anterior, EduTool® posee la siguiente estructura tridimensional (Baldomero y Salmerón, 2015): 1) La dimensión del reconocimiento de la formación para la empleabilidad consta de 6 ítems; 2) La dimensión de la metodología de aprendizaje contiene 43 ítems distribuidos en 4 subfactores: el diseño didáctico-instruccional (11), los recursos formativos y actividades de aprendizaje (10), la tutoría (9) y el entorno tecnológico-digital de aprendizaje (13), y 3) La dimensión de los niveles de accesibilidad contiene 21 ítems distribuidos en 3 subfactores: accesibilidad hardware (7), accesibilidad software (7) y accesibilidad web (7).

Cada ítem es dicotómico y mide la claridad de las pretensiones de cada indicador del subfactor de la dimensión correspondiente.

2.2 UMUMOOC

Esta herramienta valora la calidad pedagógica de los cursos MOOC en el contexto de la Universidad de Murcia, por ello se denomina UMUMOOC (Guerrero, 2015). Aunque en una segunda fase se procederá a la validación del instrumento diseñado y se someterá a un proceso de validez de contenidos mediante un juicio de expertos a fin de comprobar las características de este modelo tridimensional, en esta herramienta se han establecido fundamentalmente tres dimensiones en las que se integran varias subcategorías o subfactores e indicadores de cada uno de ellos:

Planificación/gestión. Esta dimensión incluye los requerimientos formales y aspectos básicos de administración y gestión que pueda conllevar la plataforma MOOC utilizada, relacionados con el aprendizaje y en el que se aprecian, a su vez, dos subfactores: Administración/gestión y Acreditación/Certificación. Algunos de los indicadores establecidos son: Información sobre duración, cronograma, certificaciones, acreditaciones a las que da lugar, si son de pago o gratuitas.

Diseño Aprendizaje. La segunda dimensión está relacionada con aspectos de diseño educativo e integrada por cuatro subfactores: Diseño didáctico-instruccional, Contenidos, Recursos y actividades, y Evaluación. Algunos de los indicadores referenciados en estos componentes permiten valorar si los diferentes elementos que se indican en el diseño pedagógico y la elaboración de materiales de aprendizaje se orientan, por ejemplo, a la transferencia de los aprendizajes, al desarrollo y evaluación de competencias, si atienden diferencias individuales y diferentes estilos de aprendizaje, si tienen en cuenta aspectos culturales o contextuales, si fomentan la actividad o participación, la conectividad o la secuenciación del aprendizaje y el diseño modular.

Comunicación-Interacción. La tercera dimensión incluye aspectos relacionados con la implementación, el desarrollo del curso y el seguimiento, y con las herramientas de comunicación/tutorización de las plataformas: foros, blog, wikis, redes sociales, hangouts, que permitan el fomento y desarrollo de una metodología activa, colaborativa y participativa del estudiante. Los subfactores que la componen son la comunicación y la tutoría.

III. Análisis

En la investigación se analizaron los indicadores comunes de los instrumentos de evaluación y las diferencias de indicadores entre ambas herramientas. De esta forma, se realizó un análisis interno de EduTool® y UMUMOOC para conocer la situación real de ambos instrumentos, así como el riesgo y las oportunidades que brinda su utilización en la evaluación de cursos virtuales MOOC. En la figura 3 se puede observar la representación en el espacio de dos triángulos de calidad de cursos MOOC. Por un lado, se encuentra el triángulo órtico ideal de calidad suprema MOOC, que muestra un triángulo equilátero para herramientas tridimensionales, con las máximas puntuaciones en todas las dimensiones de calidad (corta a los ejes en el punto 1 de los mismos). Este triángulo ideal recibe el calificativo de órtico porque es la máxima superficie de proyección de calidad y servirá como referente para medir la “falta de calidad” de los cursos MOOC. En este sentido, también se ha representado el triángulo de calidad real (zona rayada) de un curso MOOC cualquiera en los dos instrumentos, que intersecciona con los ejes citados anteriormente en puntos inferiores a 1.

3.1 Análisis de indicadores comunes

Se ha tomado como premisa el análisis de los indicadores comunes de los subfactores de evaluación de calidad de EduTool® y UMUMOOC según las dimensiones del primero. Así pues, en la tabla I se muestran los únicos indicadores comunes de calidad de la dimensión “Reconocimiento de la formación para la empleabilidad” y “Metodología de aprendizaje”, puesto que no hay ninguna otra dimensión que tenga indicadores comunes.

Tabla I Indicadores comunes de calidad

| Dimensión 1 Reconocimiento de la formación para la empleabilidad | Indicadores |

|---|---|

| Subfactor 1.1 Reconocimiento de la formación para la empleabilidad | Los alumnos reciben un diploma de asistencia. |

| Se otorga un certificado para aquellos alumnos que superan un examen de evaluación de conocimientos adquiridos. | |

| El certificado de conocimientos está reconocido por la Administración o por una entidad externa de reconocido prestigio. | |

| Se realiza un proceso de seguimiento del reconocimiento de la formación. | |

| El título o certificado alcanzado posee validez internacional. | |

| Dimensión 2 Metodología de aprendizaje | Indicadores |

| Subfactor 2.1 Diseño didáctico-instruccional | Se describen unos objetivos generales |

| Se permite al estudiante algún grado de libertad en el itinerario formativo (en módulos, temas o actividades). | |

| Subfactor 2.2 Recursos formativos y actividades de aprendizaje | Los alumnos pueden realizar actividades de autoevaluación. |

| Se proporciona una guía didáctica con información sobre el curso (contenidos, metodología y sistemas de evaluación). | |

| Se programan sesiones síncronas para el trabajo individual o en grupo dinamizadas por el formador. | |

| Subfactor 2.3 Tutoría | Se proporciona feedback individual sobre el trabajo realizado. |

| Subfactor 2.4 Entorno tecnológico-digital de aprendizaje | Permite o tiene mecanismos o componentes que facilitan la orientación de los alumnos dentro del entorno y proceso de aprendizaje (mapas de navegación, mecanismos de búsqueda sencilla o por etiquetas, opción de volver atrás o deshacer, interfaz usable, etc.). |

| Permite o tiene foros de discusión y atención al estudiante (formales e informales). |

3.1 Análisis de indicadores no comunes

El análisis interno de indicadores no comunes conllevará, al instrumento que no los contemple, unas debilidades. De esta manera, estos aspectos limitan la capacidad del alcance efectivo de dicha dimensión de la herramienta en la evaluación de cualquier curso MOOC. Sin embargo, al instrumento que posea dichos indicadores no comunes le supondrá unas fortalezas, que llevarán consigo una ventaja en la capacidad del alcance dimensional de la evaluación, como se muestra en la Tabla II.

Tabla II Indicadores no comunes de calidad

| EduTool® | |

|---|---|

| Dimensión 2. Metodología de aprendizaje | Indicadores |

| Subfactor 2.1 Diseño didáctico-instruccional | Se explicitan los objetivos de aprendizaje generales. |

| Se explicitan los objetivos de aprendizaje específicos. | |

| Se explicita un método de aprendizaje identificable y las actividades son acordes al mismo. | |

| Se realiza una evaluación de conocimientos al finalizar el curso que permite identificar a los alumnos que han alcanzado los objetivos de aprendizaje. | |

| Las actividades y problemas se desarrollan en un contexto realista. | |

| Hay una evaluación inicial de conocimientos que permite proporcionar a los alumnos información sobre sus necesidades de aprendizaje concretas y, tras la evaluación final, el aprendizaje adquirido durante el curso. | |

| Los objetivos de aprendizaje se organizan por competencias. | |

| La metodología de aprendizaje se basa en solución de problemas y/o realización de proyectos reales con implicación directa en la sociedad. | |

| Se realiza un seguimiento post-curso del nivel de aplicación de lo aprendido. | |

| Subfactor 2.2 Recursos formativos y actividades de aprendizaje | Los recursos formativos son únicamente material de consulta para el autoestudio. |

| Los recursos formativos permiten la interacción del alumnado. | |

| Se proporcionan instrucciones para la utilización de los recursos formativos en las actividades de aprendizaje | |

| Los alumnos deben realizar actividades prácticas individuales o en grupo que forman parte de la planificación del curso. | |

| Existe variedad en los recursos formativos (textos, audios, videos, ejercicios, simulaciones) y distintos modelos de interacción (diferentes tipologías de actividades o ejercicios, como preguntas de selección, preguntas abiertas; mapas o imágenes interactivas; navegación hipertextual; animaciones interactivas, etc.). | |

| Se proponen actividades complejas de práctica individual o grupal (simulaciones de entornos reales, casos prácticos de corrección individual, dinámicas de trabajo colaborativo). | |

| Se facilita la gestión del conocimiento (aportación de los alumnos, valoración de los conocimientos aportados). | |

| Subfactor 2.3 Tutoría | Los tutores del curso responden a las preguntas de los alumnos sin tiempo preestablecido. |

| Las respuestas a las consultas sobre los contenidos del curso se realizan en un tiempo preestablecido. | |

| Existe una programación de contactos que se personalizan en función del avance de los alumnos. | |

| Los tutores, además del avance de los alumnos, realizan un seguimiento de los aprendizajes. | |

| Se considera la evolución de los alumnos en función del avance y los indicadores de aprendizaje que se hayan definido (pruebas de evaluación, realización de actividades individuales, participación en actividades en grupo). | |

| Se realiza un seguimiento personalizado e individual del aprendizaje de los alumnos. | |

| Se programan sesiones síncronas de interacción 1 a 1 alumno/a-tutor/a. | |

| Subfactor 2.4 Entorno tecnológico-digital de aprendizaje | Se dispone de información sobre los requisitos hardware y software que debe tener el equipo del alumno/a |

| Al menos se dispone de alguna herramienta de comunicación asíncrona que permite la interacción entre los participantes. | |

| Existe un entorno tecnológico-digital de aprendizaje que integra contenido y comunicación | |

| Incorpora una sección de Preguntas Frecuentes (Frequently Asked Questions) y/o Ayuda. | |

| Permite gestionar grupos de alumnos y tareas con registros de acceso e informes. | |

| Permite o tiene posibilidad de reanudar el proceso de aprendizaje donde se dejó la sesión anterior (persistencia). | |

| Permite o tiene repositorios para el intercambio de archivos digitales entre sus miembros | |

| Permite o tiene indicadores visuales de progreso de aprendizaje. | |

| Permite la gestión y reutilización de buenas prácticas en profesores y alumnos | |

| Permite uso de formatos de presentación diferentes en función de características y estilos de aprendizaje. | |

| Permite o tiene tecnología colaborativa o de participación activa (Really Simple Syndication o RSS, wiki, blog, redes sociales). | |

| Dimensión 3. Niveles de accesibilidad | Indicadores |

| Subfactor 3.1 Accesibilidad hardware | Todos |

| Subfactor 3.1 Accesibilidad hardware | Todos |

| Subfactor 3.1 Accesibilidad hardware | Todos |

| UMUMOOC | |

| Dimensión 1. Planificación/Gestión | Indicadores |

| Subfactor 1.1 Administración/Gestión | Contiene información sobre duración, cronograma, nivel de contenidos, difusión, Condiciones particulares del curso. |

| Dispone de herramientas de comunicación asíncrona. | |

| Dimensión 2. Diseño Aprendizaje | Indicadores |

| Subfactor 2.1 Diseño didáctico-instruccional | Los contenidos responden a los objetivos planteados. |

| La evaluación es coherente con la metodología planteada. | |

| Cuenta con una bibliografía bien seleccionada, etc. | |

| Se define y es adecuada la carga de trabajo que supone para el estudiante. | |

| Existen distintos tipos y niveles de contenidos en función de los estudiantes: conocimientos previos, características, condiciones, capacidades, idioma, etc | |

| Subfactor 2.2 Contenidos | Todos |

| Subfactor 2.3 Recursos y actividades | Las actividades resultan atractivas e innovadoras, incluyen material adicional como esquemas, resúmenes y síntesis. |

| Existen diferentes modalidades y tipos de actividades: de refuerzo o recursos de apoyo o ampliación (contar con materiales obligatorios y otros opcionales que refuercen las lecciones o contenidos); individuales o colectivas. | |

| Subfactor 2.4 Evaluación | Contemplan pruebas de evaluación parciales, de cada módulo y globales, o se incluye comprobación de la progresión del alumnado. |

| Se incluyen diferentes actividades de evaluación: evaluación por pares, cuestionarios, test, rúbricas, problemas. | |

| Se incorporan nuevas modalidades de evaluación, evaluación centrada en el aprendizaje, evaluación auténtica, evaluación formativa. | |

| Dimensión 3. Comunicación-Interacción | Indicadores |

| Subfactor 3.1 Comunicación | Tienen un dinamizador (content curators). |

| Subfactor 3.2 Tutorías | Todos |

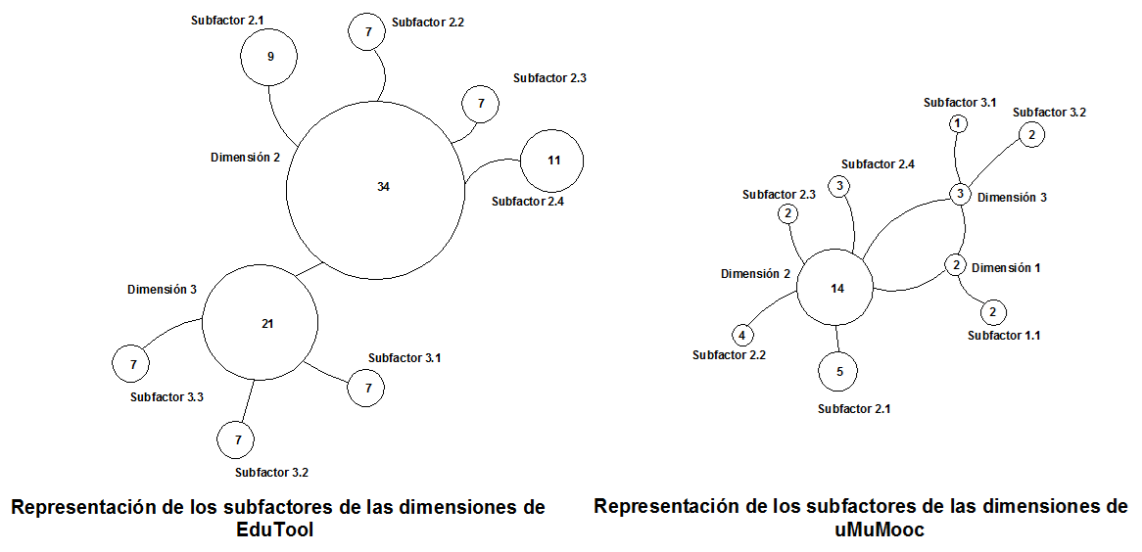

La figura 4 representa gráficamente las fortalezas de EduTool® y de UMUMOOC. Para ello, se simbolizan las dimensiones de los instrumentos como unos nodos de diferentes tamaños entrelazados. A su vez, cada dimensión está conectada a los subfactores integrantes de la misma. De esta manera, se pueden representar las fortalezas de cada herramienta como un mapa de dimensiones y subfactores no comunes. A su vez, el número dentro del nodo de cada subfactor representa los indicadores no comunes de la herramienta que lo conforman y es proporcional al tamaño del mismo. Así, el número dentro del nodo de cada dimensión representa los indicadores no comunes de todos los subfactores que lo integran y también es proporcional a su dimensión.

Fuente: Elaboración propia

Figura 4 Representación gráfica de las fortalezas de los instrumentos analizados

En este sentido, se puede deducir que EduTool® posee 34 indicadores no comunes de la dimensión 2 y 21 de la dimensión 3. En cuanto a UMUMOOC, posee 2 indicadores no comunes de la dimensión 1, 14 de la dimensión 2 y 3 de la dimensión 3.

IV. Resultados

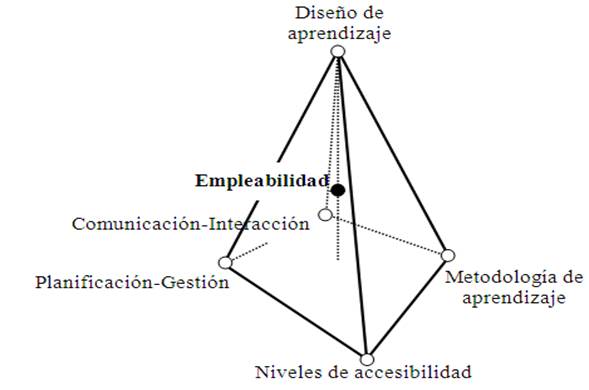

Una vez analizadas las fortalezas de los dos instrumentos, este estudio propone algunas directrices o bases de configuración de un nuevo instrumento que no conlleve las deficiencias de EduTool® y UMUMOOC, pero sí sus fortalezas. Para ello, la nueva herramienta deberá constar de cinco dimensiones: metodología de aprendizaje, niveles de accesibilidad, planificación/gestión, diseño aprendizaje y comunicación-interacción. En las tres dimensiones existentes de la herramienta UMUMOOC se añadirán los indicadores no comunes de las dos dimensiones de EduTool®. Así pues, la cuarta y quinta posible dimensión la aporta el eje de progresión didáctica “metodología de aprendizaje” y “niveles de accesibilidad” de este último instrumento, que contienen muy pocos indicadores comunes con UMUMOOC, y ello conlleva dos nuevos factores claves de eficiencia en la configuración de nuevas herramientas que contienen la dimensión común “reconocimiento de la formación para la empleabilidad”. En la figura 5 se muestra este constructo de diseño de los futuros instrumentos de evaluación de calidad de los cursos MOOC como una pirámide de cinco vértices (representación pentadimensional). En el centro de gravedad se encuentra “el reconocimiento de la formación para la empleabilidad” y algunos indicadores de la “metodología de aprendizaje”. A partir de esta base, las herramientas de evaluación se tendrían que configurar en torno a las cinco dimensiones plasmadas en la representación.

Fuente: Elaboración propia

Figura 5. Representación de los futuros instrumentos de valoración de la calidad de los cursos MOOC

Con base en lo anterior, en la tabla III se muestra la posible configuración de las nuevas herramientas de evaluación de calidad de los cursos MOOC. Estos instrumentos deberán contemplar una base de indicadores comunes de calidad (tabla I), la configuración pentadimensional de la pirámide (figura 4) y los subfactores o ejes de progresión de indicadores no comunes (tabla II).

Tabla III Bases de diseño de nuevas herramientas de evaluación de calidad de cursos MOOC

| Indicadores comunes de calidad | ||||

|---|---|---|---|---|

| Dimensión 1. Reconocimiento de la formación para la empleabilidad (herramienta EduTool®). Todos los indicadores | ||||

| Dimensión 2. Metodología de aprendizaje (herramienta EduTool®). Indicadores parcial es en los subfactores: | ||||

| Subfactor 2.1 | Subfactor 2.2 | Subfactor 2.3 | Subfactor 2.4 | |

| Configuración pentadimensional de indicadores no comunes | ||||

| Dimensión 2: Metodología de aprendizaje (herramienta EduTool®) Indicadores parciales en los subfactores: | Dimensión 3: Niveles de accesibilidad (herramienta EduTool®) Indicadores parciales en los subfactores: | Dimensión 1: Planificación/ Gestión (herramienta UMUMOOC) Indicadores parciales en el subfactor: | Dimensión 2: Diseño/Aprendizaje (herramienta UMUMOOC) Indicadores parciales en los subfactores: | Dimensión 3: Comunicación/ Interacción (herramienta UMUMOOC) Indicadores parciales en los subfactores: |

| Subfactor 2.1 Subfactor 2.2 Subfactor 2.3 Subfactor 2.4 |

Subfactor 3.1 Subfactor 3.2 Subfactor 3.3 |

Subfactor 1.1 | Subfactor 2.1 Subfactor 2.2 Subfactor 2.3 Subfactor 2.4 |

Subfactor 3.1 Subfactor 3.2 |

V. Conclusiones

Este estudio ajusta las diferencias entre los estándares de EduTool® y los indicadores del instrumento UMUMOOC a la evaluación de la acción formativa de los cursos MOOC de forma más eficiente y con la idea de representar un nuevo escenario analítico y visual para el diseño de nuevas herramientas que reduzcan las debilidades de las analizadas. En este sentido, la investigación evidencia que la dimensión del “reconocimiento de la formación para la empleabilidad” y algunos aspectos de la “metodología de aprendizaje” deben incluirse en los instrumentos de valoración de la calidad MOOC. En esta misma línea, y con base en dicha dimensión, se evidencia la necesidad de una herramienta pentadimensional que tenga como base los siguientes ejes: 1) Reconocimiento de la formación para la empleabilidad; 2) Metodología de aprendizaje; 3) Planificación/Gestión; 4) Diseño aprendizaje y 5) Comunicación-Interacción.

En consecuencia, es necesario que futuras investigaciones sobre el diseño de nuevos instrumentos modulares y multidisciplinares utilicen un enfoque multimétodo, mixto, ecléctico, holístico, sistémico e integrador, superando el monismo metodológico y la polaridad cuantitativa/cualitativa para concurrir en la simbiosis dialéctica de ambas perspectivas.

Así pues, observatorios prospectivos sobre el futuro de los MOOC, como puede ser el Observatorio de la Calidad Internacional2 (OCIMOOC), podrían matizar las dimensiones de este nuevo escenario estudiado. En esta misma línea, se avalarían y podrían ser más fiables cada una de las cinco dimensiones a considerar -y podría certificarse el nivel de calidad ofertado en dichos cursos de forma eficiente antes de emitirse, tanto cualitativa como cuantitativamente y tomando como base el reconocimiento de la formación para la empleabilidad y los aspectos considerados de la metodología de aprendizaje. Con todo esto, se podrían acreditar las plataformas ofertantes de cursos MOOC certificados y evitar la oferta de acciones formativas con debilidades en las metodologías de enseñanza, inapropiadas desde las actuales teorías pedagógicas (Valverde, 2014), y se imperdiría, en la medida de lo posible, la tendencia a la estandarización del conocimiento y los graves problemas para atender las diferencias individuales debido a la masificación que conduce a un diseño comunicativo unidireccional, centrado en el docente y basado en el contenido. Así pues, los MOOC se podrían mostrar como una democratización de la Educación Superior, pero con unos intereses pedagógicos que priman sobre los económicos, basados en evaluaciones poco fiables.

En cualquier caso, la valoración de la calidad de los cursos MOOC es una línea de investigación futura y se evidencia la necesidad de un mayor número de estudios sobre indicadores de calidad en cursos en línea, así como estudios longitudinales (Stödberg, 2012) o comparativos (Balfour, 2013). Y más concretamente, investigaciones sobre métodos que mejoren fiabilidad, validez, autenticidad y seguridad de las evaluaciones del estudiantado; sobre técnicas que ofrezcan evaluación automatizada eficaz y sistemas de retroalimentación inmediata, y cómo pueden ser integrados en ambientes de aprendizaje abiertos (Oncu y Cakir, 2011) para dar garantía de usabilidad a las herramientas pentadimensionales de calidad que se puedan desarrollar a partir de este trabajo y al futuro ensayo de relevantes plataformas MOOC.

nueva página del texto (beta)

nueva página del texto (beta)