Servicios Personalizados

Revista

Articulo

Indicadores

-

Citado por SciELO

Citado por SciELO -

Accesos

Accesos

Links relacionados

-

Similares en

SciELO

Similares en

SciELO

Compartir

Desacatos

versión On-line ISSN 2448-5144versión impresa ISSN 1607-050X

Desacatos no.28 Ciudad de México sep./dic. 2008

Saberes y razones

Hacia la complejidad por la vía de las redes. Nuevas lecciones epistemológicas

Towards Complexity via Network Theory: New Epistemological Lessons

Carlos Reynoso

Universidad de Buenos Aires, Buenos Aires, Argentina. billyreyno@hotmail.com.

Recepción: 29 de enero de 2008

Aceptación: 7 de febrero de 2008

Resumen

Este artículo revisa el impacto recíproco existente entre la teoría de redes sociales y las teorías de la complejidad y el caos, así como el surgimiento del estudio de las redes libres de escala en lo que va del siglo. El examen se realiza en el contexto de una historia de los eventos más significativos de la investigación en redes, desde Euler a Barabási, que servirán de punto de partida para indagar las cuestiones epistemológicas más serias que ellos plantean de cara a las ciencias sociales contemporáneas.

Palabras clave: antropología, redes sociales, complejidad, modelos formales, epistemología.

Abstract

This paper surveys the reciprocal impacts between Social Network Analysis and the new paradigm of complexity and chaos theories, as well as the emergence of scale-free network research in the twenty-first century. This study is embedded in the context of a history of the most momentous events in network theory and practice, from Euler to Barabási, used as a starting point to interrogate some critical epistemological issues from the viewpoint of contemporary social sciences.

Key words: anthropology, social networks, complexity, formal models, epistemology.

JUSTIFICACIÓN

En las puertas del siglo XXI las teorías de redes, ya de antigua data en sociología y antropología, al fin devinieron complejas, caóticas, dinámicas y no lineales en el sentido técnico de la palabra. En consonancia con ese escenario, este artículo tiene el objetivo de brindar una visión de conjunto de los aspectos esenciales de las teorías de la complejidad y el caos tomando como punto de mira el análisis de redes sociales, el cual —esté o no de por medio alguna variedad de paradigma complejo— constituye un tema de interés antropológico tanto más urgente cuanto menos conocido. Este artículo extiende, reformula o corrige, sobre una nueva estructura y con base en nuevos contenidos, otros ensayos más breves y circunstanciales; al lado de eso, desarrolla con más sistematicidad que pedagogía las consecuencias disciplinares específicas de una técnica contemporánea que bien podría ser otra (algoritmo genético, modelado basado en agentes, gráficos de recurrencia) pero que aquí serán las redes. Se aprovechará esta visión panorámica para identificar una serie de moralejas, desafíos o lecciones epistemológicas acarreadas tanto por la teoría de redes como por la perspectiva compleja y, sobre todo, por la complementación de ambas.

Dicha teoría y esta perspectiva se han tornado cada vez más convergentes y puede decirse que, juntas, han llegado a ser mucho más que la suma de sus partes. En cuanto a las lecciones a las que hice mención, ellas ponen en tela de juicio algunos de los estereotipos y mitos antropológicos y epistemológicos más arraigados, más allá de que el investigador que acepte leer este artículo adopte o no en el futuro un marco de complejidad o una tecnología reticular. Como en otros textos, aquí considero que la tecnología de trabajo es contingente y no un fin en sí misma; pero de lo que se aprende epistemológicamente con su uso no me parece que haya posibilidad de retorno o necesidad de negociación.

En los intersticios de la ejecución de los objetivos señalados procuraré delimitar un par de veces algunas perspectivas que pasan por ser complejas, pero que en décadas no han ofrecido herramientas de parecido nivel de compromiso y potencial de cambio. La idea es marcar un contraste entre lo que hay y lo que podría venir. También me esforzaré por vincular dos territorios (la vieja teoría de redes manchesteriana y sus derivaciones, y la nueva ciencia de las redes libres de escala) que, hasta el día de hoy, no se han integrado como debieran. Finalmente registraré algunas notas de caución y vigilancia reflexiva ante lo que se percibe como la posibilidad de un uso fetichista de las teorías y técnicas del nuevo siglo, tanto en materia de redes como de complejidad.

REDES, UNA VEZ MÁS

Se me ocurren muy pocos asuntos de posible interés en antropología cultural (y casi ninguno en antropología social) que no admitan ser tratados en términos de redes, esto es, en términos de elementos y relaciones entre ellos. En rigor, podría pensarse que los conceptos subyacentes a la teoría de redes guardan fuerte relación con principios algo más familiares para los antropólogos, como los del estructuralismo y, en particular, con la idea estructuralista de sistema, que se define casi de la misma manera. La teoría de redes es, sin embargo, más cauta que el estructuralismo en muchos aspectos; nunca se ha afirmado desde ella, por ejemplo, que toda red califique como sistema sólo por estar constituida como lo está.

Dije elementos y relaciones. Desde el punto de vista semántico los elementos pueden ser cualesquiera (personas, grupos, instituciones, piezas de música, palabras, países) y los vínculos también (relaciones de conocimiento, transacciones comerciales, influencia, afinidad, contagio, derivación, violencia, tráfico, relaciones sintagmáticas, clientelismo); éstos pueden ser además meramente nominales o finamente cuantitativos. Los modelos pueden ser estáticos o dinámicos, topológicos o cuantitativos, axiomáticos o exploratorios; las cuantificaciones de la teoría de redes son menos excursiones en una aritmética envolvente que evaluaciones de la mayor o menor fuerza de cualidades sumamente expresivas. La representación basada en la metáfora de las redes de ningún modo es más "artificial" que el tratamiento discursivo de una realidad; un poco más abstracto puede ser, pero no mucho más que eso. En todo caso, la metáfora es tentadora: en una ciencia compleja; la estructura de numerosos modelos de la cosa real puede ser, en ocasiones, algo que podemos pensar en algunos respectos como si se tratara de una red.

Como formalismo, la teoría de redes posee una cualidad analógica que la hace particularmente útil en ciencias sociales, a mi juicio más aún que (por ejemplo) los modelos de simulación. De éstos se ha llegado a decir que deben utilizarse sólo como último recurso allí donde los métodos analíticos han probado ser intratables (Friedkin, 2003). El estudio de redes constituye uno de esos métodos analíticos, una especie de modelado down to top que permite pasar de los niveles individuales a las agrupaciones colectivas menos conflictivamente que otros formalismos. Y sí, a veces puede suceder que los modelos planteados sean intratables y haya que intentar otros recursos.

En tanto modelo, el formalismo de redes selecciona ciertos aspectos de la realidad y deja de lado otros, pero en esto no hay diferencia entre un tratamiento modelado y otro discursivo; en éstas y otras técnicas de modelado la idea no es reproducir un fenómeno complejo hasta los últimos detalles, sino proporcionar resultados acordes con las suposiciones realizadas, permitiéndonos tratar reflexivamente con las implicancias de nuestras opiniones. El hecho de que el vocabulario descriptivo y la semántica de los functores y demás elementos sean públicos añade otra instancia más de reflexividad.

MOMENTO FUNDACIONAL: TEORÍA DE GRAFOS

La historia de la teoría de las redes sociales se remonta a los orígenes de la teoría de grafos en matemáticas, creada hacia 1736 por Leonhard Euler [1707-1783]. Este matemático prodigioso, uno de los escritores más prolíficos de la historia, inventó de la noche a la mañana la teoría de grafos al resolver el famoso problema de los siete puentes sobre el río Pregel en Königsberg, la ciudad que hoy se llama Kaliningrado1 (fig. 1).

El problema consistía en averiguar si se puede pasar por los siete puentes sin cruzar más de una vez por cada uno de ellos. En su planteamiento, Euler reemplazó las áreas de tierra por nodos y los puentes por vínculos, como se muestra en la figura 1 a la derecha. Lo que hizo Euler fue como lo que hizo Geertz, pero al revés: generalizar el problema. El grafo abstraído por Euler es lo que hoy se conoce como un multigrafo; es decir, un grafo que admite más de un nodo por vértice. Una red es, por cierto, una clase de grafo (Bondy y Murty, 1976; Harary, 1976).

Euler encontró que la pregunta formulada en el problema de los puentes de Königsberg debía responderse por la negativa. Definió para ello dos conceptos:

1. Se dice que un grafo tiene un camino de Euler si se pueden trazar arcos sin levantar la pluma y sin dibujar más de una vez cada arco.

2. Un circuito de Euler obedece a la misma prescripción, con la exigencia agregada de finalizar en el mismo nodo en el que se comenzó.

Y Euler halló que:

1. Un grafo con todos los vértices pares contiene un circuito de Euler, sea cual fuere su topología.

2. Un grafo con dos vértices impares y algunos otros pares contiene un camino de Euler.

3. Un grafo con más de dos vértices impares no contiene ningún camino y tampoco contiene ningún circuito de Euler.

La lección para los científicos sociales imbuidos de perspectiva idiográfica de un siglo a esta parte es que estas soluciones son universales y permanentes por cuanto derivan de propiedades inherentes a los respectivos tipos de grafos; no vale la pena pasar noches en vela intentando hallar soluciones alternativas, porque no las hay. En el deslinde de estas propiedades topológicas finca precisamente el origen de la moderna teoría de redes.

Lección n° 1: La moraleja epistemológica a sacar de este primer punto en el tratamiento de la teoría de redes es que al menos unos cuantos problemas de la investigación empírica en ciencias sociales podrían abordarse (si es que no resolverse) en función de las propiedades universales de la topología o la estructura del fenómeno, antes que en función de los detalles contingentes del caso en particular. Decía Geertz en Persona, tiempo y conducta en Bali, escrito en 1966:

En cualquier sociedad, el número de estructuras culturales en general aceptadas y frecuentemente usadas es extremadamente grande, de manera que discernir aun las más importantes y establecer las relaciones que pudieran tener entre sí es una tarea analítica considerable. Pero la tarea se ve algún tanto aligerada por el hecho de que ciertas clases de estructuras y ciertas clases de relaciones entre ellas se repiten de una sociedad a otra por la sencilla razón de que las exigencias de orientación a que sirven son genéricamente humanas (1987:301).

Por una vez, el futuro creador del enfoque hermenéutico, con el que casi nunca estoy de acuerdo, ha sabido poner el dedo en la llaga, aunque al razonamiento de Geertz puede que le falte una vuelta de tuerca. Cuando él dice que "ciertas clases de estructuras o relaciones" poseen "exigencias de orientación" universales, eso puede suceder no sólo porque ellas sean genéricamente humanas, sino porque resultan congénitas a la naturaleza estructural del problema, la cual puede que no implique "una sencilla razón". Que yo haya escogido mi ejemplo de entre las ideas geertzianas no es casual. Lo que pretendo señalar es que, como sucede en otros abordajes interpretativos, está faltando aquí una inspección genuina sobre la naturaleza hermenéutica del problema y sobre la lógica de la pregunta que en función de esa naturaleza corresponde hacer.

Aun una leve reflexión sistemática sobre los constreñimientos estructurales de un problema ayudaría a evitar problemas recurrentes de la investigación sociocultural. No se necesita llegar a la teoría de redes de última generación para soslayar lo que Jorge Miceli, tomando la idea de la arquitectura de software, ha sugerido llamar "antipatrones" del razonamiento antropológico. Tres breves ejemplos de señalamiento de inferencias incorrectas formalmente evitables vienen aquí a cuento: el principio de Condorcet, el teorema de la imposibilidad de Arrow y la falacia de la personalidad modal de las escuelas de Cultura y Personalidad.

• El principio de Condorcet se manifiesta en sistemas de votación muy simples y poco numerosos en los cuales se establece como condición que cada votante exprese sus preferencias mediante un rango. En una situación con tres votantes (A, B y C) y tres candidatos (x, y, z), si A elige x-y-z, B escoge y-z-x, mientras C prefiere z-x-y, no se podría generalizar un orden de preferencia, porque x derrota a y por 2 a 1, y vence a z por la misma cantidad; lo mismo sucede con z y x (Blair y Pollack, 1999).

• El teorema del Premio Nobel Kenneth Arrow (uno de los más distorsionados por lecturas simplistas después del teorema de Gödel) también tiene que ver con mecanismos de votación, o sea, que presenta un problema de decisión. Lo que el teorema demuestra no es que no se puede pasar de lo individual a lo general, sino que ningún mecanismo de votación puede cumplir simultáneamente con un conjunto acotado de condiciones (no-dictadura, universalidad, independencia de alternativas irrelevantes [IAI], monotonicidad, soberanía del ciudadano, eficiencia de Pareto). Lo que Arrow quiere decir con esto es que un mecanismo de votación es no lineal y no trivial y que, para predecir un resultado, se debe utilizar necesariamente una teoría de juegos o un modelo de simulación. Por último, y según lo ha probado teoremáticamente Edward McNeal discutiendo el problema de "cuál es la mejor ciudad para vivir", la condición de IAI (que impide crear una medida escalar homogénea a partir de diferentes categorías inconmensurables o sensibles al contexto) impediría, por ejemplo, llevar a la práctica el modelo de grilla y grupo de la antropóloga Mary Douglas (Arrow, 1950; McNeal, 1994).

• El concepto abstracto del "hombre promedio" de Adolphe Quetelet [1796-1874] y la "personalidad modal" de la vieja antropología psicológica son también sistemáticamente engañosas, como diría Gilbert Ryle. Muchas veces hablamos de un americano típico, un balinés típico, y construimos esa tipicidad con base en los valores intermedios de un conjunto de variables. Pero una persona construida de ese modo puede no corresponder a ningún caso real y ser una construcción intelectual simplemente ultrajante. Si tomamos, por ejemplo, un conjunto de triángulos y rectángulos de distintos tamaños, está claro que la media aritmética de cada uno de los lados y de la hipotenusa no satisface el teorema de Pitágoras; lo mismo se aplica, más dramáticamente, a los perfiles de personalidad (Bertuglia y Vaio, 2005: 7). Una vez más, mi alusión a Gilbert Ryle (filósofo favorito de Clifford Geertz) no es accidental; la objeción que he señalado (similar a la falacia ecológica) viene a cuento cuando uno, por ejemplo, generaliza lo que percibió en unos pocos a "los balineses" en general. Lo que hay que generalizar es el problema, no la ontología.

En una palabra, si logramos articular un problema de modo que tenga una estructura de propiedades bien conocida, en muchos casos es posible determinar a priori qué clase de soluciones admite, o si no admite ninguna.

Lección n° 2: Las redes son un mapa, podríamos decir con Bateson o Korzybski. Como corolario, el territorio de la sociedad o la cultura podría mapearse usando otras metáforas raíces: se lo podría pensar como jerarquías, pirámides, álgebras, árboles, campos de fuerzas, organismos, sistemas sui generis, procesos singulares. Un mapa no es un territorio. Ni una ni otra son, entonces, redes, ontológicamente hablando; éstas son sólo formas circunstanciales de representación (cf. Reynoso, 2008).

DE GRAFOS A REDES: SOCIOMETRÍA

Continuando con la historia del pensamiento reticular podríamos decir que, en la década de 1930, un alumno de Gustav Jung, Jacob Levy Moreno [1889-1974], inventó, fundando un campo que él llamo sociometría, algunos formalismos para representar relaciones sociales, como ser sociomatrices y sociogramas. Levy Moreno fue, para decir lo menos, un personaje curioso que creó, además, el role playing y el psicodrama. Admirado por unos y denostado por otros, se le considera un pensador extravagante y poco digno de confianza, aunque su idea de vincular los grafos matemáticos con las problemáticas sociales haya sido una intuición genial por donde se la mire (fig. 2, p. 22).

Hoy cuesta apreciar la magnitud de su aporte, pero no hay duda de que fue sustancial: la sociedad no es un agregado de individuos con sus características, como argüían los estadísticos, sino una estructura de vínculos interpersonales, pensaba Moreno. Más allá de su aparente obviedad, la idea de sociograma no se agota en una representación, sino que explota con inteligencia el hecho de que, al margen de las herramientas de cálculo de las que se disponga, la visión humana está adaptada especialmente al reconocimiento de patrones; no se trata sólo de la vieja leyenda que reza que "una imagen vale más que cien palabras", sino del hecho mucho más fundante de la capacidad gestáltica y sintética de la visión, capaz de percibir organizaciones difíciles de captar con tanta contundencia a través del análisis, el lenguaje o (una vez más) la interpretación.

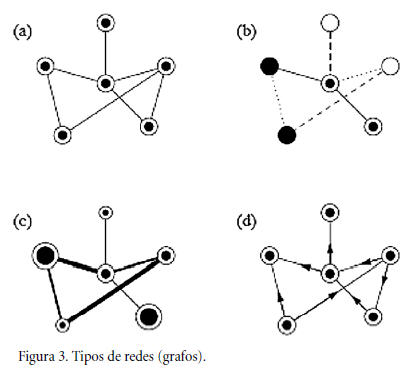

La figura 2, realizada con el programa Adit Sociogram®, muestra una sociomatriz y su sociograma correspondiente. Una continuación de la sociometría de Moreno de vida relativamente breve fue el programa del Laboratorio de Redes del MIT conducido por Alexander Bavelas desde 1948. Bavelas, seguidor fiel de Moreno y también buen conocedor de la entonces prestigiosa teoría de campo de Kurt Lewin, desarrolló en particular estadísticas de centralidad que todavía integran el repertorio de análisis de los principales modelos y de los paquetes de software más utilizados. De autores como Moreno y Bavelas, así como de las notaciones gráficas de los matemáticos, se derivó la notación que comúnmente se utiliza en la teoría de redes sociales (fig. 3).

Esta notación es harto más simple que otras convenciones gráficas, como los diagramas de UML o las redes de Petri. Ni siquiera los diagramas de parentesco que los antropólogos memoriosos tal vez recuerden y de las que hablaré luego (no muy bien) eran tan transparentes. Casi se diría que hay sólo dos clases primarias de entidades (nodos y conexiones) y que cada autor bien puede utilizar los indicadores diacríticos de tipo, peso o direccionalidad que le convengan cuando lo requiera. La figura 3 muestra: a) un grafo no dirigido con un solo tipo de vértice y una sola clase de unión; b) una red con cierto número de tipos y vínculos; c) una red con diversos pesos de nodos y nexos, y d) un grafo orientado. De más está decir que un modelo de red puede tener información conceptual asociada tan rica como se quiera y que no todas, pero muchas tareas analíticas arduas y aburridas pueden hoy resolverse en un soplo (y a costos muy bajos) poniendo en su lugar tecnologías que ya están ofreciendo más de lo que el común de los investigadores podrá llegar a demandarles.

Lección n° 3: El desafío que surge de este estado de cosas es que tenemos entre manos, después de una larga siesta interpretativa y posmoderna, un paquete de nuevas técnicas susceptibles de ser enseñadas y aprendidas. Como muy pocas, ella es un objeto óptimo de reflexión e intercambio. Si se me permite una provocación, yo diría que ante este desafío importa preguntarse si, olvidado ya hace décadas el mal llamado método genealógico, los antropólogos de hoy dominan alguna técnica disciplinariamente distintiva. Invito a revisar, incidentalmente, la totalidad de la epistemología de la complejidad de Edgar Morin o de Fritjof Capra para comprobar que en ninguna de ellas se promueve ninguna técnica. El desafío que podríamos derivar de esta lección es preguntarse hasta qué punto es razonable que existan teorías que (pasado un tiempo) no engendren directa o indirectamente alguna clase de instrumentos o alguna heurística positiva. Esta esterilidad se ha visto antes, por cierto, no sólo en el mundo humanístico, sino en la teoría de catástrofes y (obviando la metodología de Forrester) en la teoría general de sistemas. Cuando Roy D'Andrade (2000) hace el inventario, resulta que los antropólogos ya no están aprendiendo técnicas en su formación y algunas teorías que se auguraban fructuosas no resultaron serlo. ¿A alguien más le preocupa este estado de cosas? ¿Existe algún signo distintivo de las ideas fértiles?

REDES ALEATORIAS: POSIBILIDADES Y LÍMITES DEL AZAR

Más allá de los avances en teoría de redes propiamente sociales, desde la década de 1950 la teoría matemática de redes experimentó un crecimiento sostenido merced a los trabajos de dos matemáticos húngaros: Paul Erdös [1913-1996] y Alfred Rényi. Dado que cuando se trabaja con elementos reticulares, incluso con algunos muy modestos, los problemas se vuelven rápidamente intratables, estos autores propusieron considerar modelos probabilísticos, esto es, redes estructuradas aleatoriamente. Las propiedades descubiertas en estos modelos son numerosas, pero una de ellas demanda en especial nuestra atención (fig. 4).

Me refiero a lo que en la ulterior teoría de la complejidad se ha dado en llamar una singularidad, catástrofe o transición de fase. Erdös y Rényi encontraron que cuando el promedio de conectividad de los nodos de una red salta de menos de uno a uno, se pasa de un estado en el cual hay varias redes inconexas a otro estado en el cual se tiene una sola gran red. La figura 4 muestra un ejemplo de red aleatoria de 25 nodos con 18 vínculos contra una del mismo número de nodos y 25 vínculos; en el segundo caso, aunque quedan algunos elementos fuera de la red, la red misma es totalmente conexa, y hay una sola red en el conjunto. La forma de representación escogida (en el programa Pajek) es un gráfico bidimensional en función de la energía según el método de Thomas Fruchterman y Edward Reingold.

El aspecto más importante de las redes aleatorias es que ellas presuponen distribuciones normales. Una distribución normal es, por ejemplo, la de las estaturas de las personas. Esta clase de distribuciones se caracteriza por mapear en un gráfico como una curva en forma de campana, conocida como campana de Gauss, que es lo que se ve a la izquierda en la ilustración de la figura 5. La imagen de la derecha corresponde a la portada de uno de los libros más ominosos sobre la presunta distribución normal del aún más presunto coeficiente intelectual, monstruosamente traducido como la "curva de Bell" (Herrnstein y Murray, 1994)2. No se refiere a estaturas, sino a inteligencia.

A lo que voy es a que una distribución normal presenta una curva en forma de campana cuyo "pico" coincide con la media y la mediana: una estatura o IQ "normal" es, en este contexto, la estatura o IQ más común en una población; los "normales" son mayoría, como su nombre lo indica. "Todas las distribuciones son normales", reza el mito, como me dijo alguna vez el arqueólogo Hugo Yacobaccio cuando todavía no se sabía muy bien que eso (que depende de cómo se construye la muestra y cómo se establecen las escalas) es técnicamente inexacto.

Es preciso hacer notar una característica de esa distribución: como puede verse en ambas puntas de la curva, siempre hay muy pocos individuos altísimos y muy pocos también de bajísima estatura, o poquísimos genios y poquísima gente de poca inteligencia (o como se los llame). La diferencia entre los ejemplares extremos sería de menguada magnitud: cinco o seis órdenes como mucho, jamás del orden de los miles o los millones.

Gran parte de las estadísticas de las ciencias sociales presuponen erróneamente que esta clase de distribución es dominante; los científicos sociales que las usan out of the box para tratar muestras que poseen distribuciones distintas cometen una grave distorsión, empezando por la operación de muestreo misma. Después volveré sobre estas cuestiones.

Lección n° 4: La lección epistemológica a destilar de estos desarrollos no tiene tanto que ver con el hallazgo sorprendente del umbral de percolación, sino más bien con la noción de tratabilidad, dado que las primeras redes interesantes de la historia se propusieron no porque la naturaleza o la sociedad fueran así, sino porque una red aleatoria es tratable. Vaya concepto. Con todo su espíritu crítico, la antropología, con los posmodernos al frente, se las ingenia para eludir este formidable asunto. ¿Cómo podemos saber si un problema es tratable, o si es un buen problema en primer lugar? Muy a menudo el antropólogo presupone que la teoría y el aparato metodológico con que se cuenta son suficientes para el abordaje de cualquier problema, sin reflexionar sobre dos cuestiones esenciales: primero que nada, definir qué es un problema, y segundo, determinar que se trate de un problema susceptible de alguna clase de tratamiento en función de la teoría, el método y las técnicas que cada quien pone en acción3.

TEORÍAS SOCIOLÓGICAS Y ANTROPOLÓGICAS DE REDES

Aunque la historia es más compleja que eso, habitualmente se dice que, en teoría de redes tradicional, hay una corriente sociocéntrica que viene de la sociología y se remonta a Georg Simmel, y una tendencia egocéntrica que floreció en la antropología y se deriva a la larga de Radcliffe-Brown. En contemporaneidad con desarrollos matemáticos fundamentales, la escuela de Manchester lidereada por Max Gluckman constituyó durante unos veinte años (entre 1955 y 1975, digamos) una alternativa opuesta a los planteamientos macro de la antropología sociocultural inglesa, de tono estructural-funcionalista; en esta escuela se desarrollaron por primera vez las redes antropológicas. El modelo de Manchester, llamado a veces antropología interaccional, enfatizó las redes centradas en Ego (o redes personales) constituidas a nivel urbano (por ejemplo, Mitchell, 1969); el creador del concepto de red social fue el antropólogo John Barnes (1954), y la codificadora reconocida de esta clase de redes fue de Elizabeth Bott (1957). Bott pensaba que, en la medida en que Ego estuviera fuertemente ligado a otros a su vez ligados entre sí, todos tenderían a alcanzar consenso y a ejercer presión informal, pero consistente, sobre el resto para alcanzar conformidad con las normas, estar en contacto mutuo y, de ser preciso, ayudarse entre sí. En el otro extremo, si los vínculos fueran esporádicos, esa consistencia normativa resultaría más improbable. Tenemos aquí formulaciones que tienen un aire de familia con las diversas solidaridades durkheimianas o con la grilla y grupo de Mary Douglas, pero que presenta las ideas de manera más tangible.

Aunque durante un tiempo disfrutó de cierto prestigio y ejerció alguna influencia en ese campo desordenado que siempre ha sido el estudio de grupos y la antropología de las sociedades complejas, la carencia de herramientas computacionales, de máquinas comparables a las modernas PC y de hallazgos dramáticos afectó el desarrollo de este campo de investigación. Es posible que el último trabajo memorable en este sentido haya sido la investigación de Bruce Kapferer (1972) sobre el poder y la influencia en una fábrica de Zambia. Mientras que en sociología se mantuvo una especialidad viva que ha adquirido fuerza inédita en los últimos años y que ha ejercido y ejerce una influencia considerable en computación y matemáticas (Mika, 2007), en antropología los temas de investigación dejaron de lado los temas de estructura y proceso social en beneficio de la función simbólica, la interpretación, la identidad. El declive del análisis de redes en antropología entre (digamos) 1965 y 1995 es una historia tediosa y lamentable que aún no ha encontrado su cronista, pero que habrá que resignarse a contar en alguna ocasión (White, 2001).

ANÁLISIS MICRO, ANÁLISIS MACRO Y LA FUERZA DE LOS LAZOS DÉBILES

Pocos años atrás, una de las presuntas especialistas en teoría antropológica de Argentina manifestó en público que el problema de la relación entre los niveles micro y el plano macro, entre el individuo, la díada, el pequeño grupo y la sociedad, era una cuestión obsoleta, pasada de moda. Más allá de que dicha interpretación no podría jamás sustentarse de cara al estado de las disciplinas y a los datos cuantitativos de referencias cruzadas y temas de investigación que hoy se actualizan casi en tiempo real y que están al alcance de las puntas de los dedos, aquí sostendré que, por el contrario, la naturaleza de las relaciones micro/macro sigue constituyendo, cualquiera sea el marco teórico, un problema esencial de las ciencias sociales —antropología inclusive—, si es que más allá del estudio de los fundamentos biológicos y psicológicos estas ciencias tienen algún sentido y razón de ser.

En consonancia con lo que afirmo, Mark Granovetter —uno de los teóricos sociológicos hoy más reconocidos— afirmó hacia fines de la década de 1960 que una de las debilidades de la teoría sociológica radicaba en su incapacidad para vincular los niveles micro con los macro. El análisis de los procesos interpersonales —especulaba— podría proporcionar un vínculo adecuado. Ahora bien, la sociometría —precursora del análisis de redes— siempre ha sido periférica a la teoría sociológica, en parte porque se ha consolidado como perteneciente a la psicología social y en parte porque nunca ha existido una teoría para pasar del plano del pequeño grupo al de las estructuras globales.

Aunque los trabajos de la escuela de Manchester habían avanzado en esa dirección, su tratamiento de las cuestiones estructurales era escueto. Tomando como base algunas ideas del matemático sistémico Anatol Rapoport [1911-2007] —uno de los primeros en estudiar la velocidad de propagaciones y la naturaleza de las epidemiologías dentro de las redes—, Granovetter examina las características de los lazos que vinculan las díadas, las tríadas y los cliques. Encuentra así que, para que un rumor se difunda verdaderamente, éste debe evitar o trascender los nexos fuertes inmediatos y pasar a través de los vínculos débiles. Los lazos fuertes son los que uno llama amigos; los lazos fuertes, los conocidos [acquaintances]; el conjunto de Ego y de sus conocidos constituye una red de baja densidad (fig. 6).

Tras otros análisis semejantes, Granovetter concluye que la vinculación de los niveles micro y macro no es un lujo teórico del cual se puede prescindir, sino un elemento de extrema importancia para el desarrollo de la teoría sociológica. La teoría urbana de la sociología tradicional (por ejemplo, la de Louis Wirth en Chicago) sostenía que los lazos débiles eran generadores de alienación; la visión es muy distinta ahora.

La historia de Granovetter trae a colación un nuevo antipatrón de las ciencias sociales. En efecto, su hallazgo fue rechazado al principio por la prestigiosa American Sociological Review, pues se creyó que violaba el principio de sentido común que establece —porque sí— que los lazos fuertes son los más efectivos en todos los escenarios. Con unos pocos retoques que no modificaron ningún argumento clave, el artículo fue aceptado finalmente en 1973 por el American Journal of Sociology, convirtiéndose desde entonces (y hasta hoy) en una de las referencias clásicas de la sociología. A partir de allí, Granovetter quedó, como se dice en cine, typecasted. Cada vez que él (un sociólogo genérico, por otra parte) intenta hablar de sociología, todos esperan que hable de análisis de redes sociales en general y de vínculos reticulares débiles en particular (Granovetter, 1990: 13). Y cada vez que los teóricos de redes presentan propuestas innovadoras fuera de su nicho ecológico, lo común es que encuentren resistencia.

Hallazgos formales como los de Granovetter —que en principio surgieron de una corazonada tejida sobre hipótesis— han sido confirmados por los hechos a lo largo de los años. Estudios independientes como los de Carol Stack (1974), Larissa Lomnitz (1977) y E. Ericksen y W. Yancey (1977) probaron en ambientes urbanos y etnográficos que las clases pobres dependen casi exclusivamente de sus lazos fuertes, una idea sugerente que merecería ponerse a prueba. En suma, si uno quiere hacer algo importante que se sale de la rutina cotidiana como, por ejemplo, conseguir trabajo, más de una vez deberá aventurarse fuera del mundo sobre el cual tiene dominio inmediato (Granovetter, 1983). Junto a la teoría de los lazos débiles, los antropólogos han desarrollado otros métodos bien conocidos para analizar dinámicas sociales y comparar usos a través de las culturas. El más notorio gira en torno del concepto de embeddedness (Schweizer, 1997) que, por razones de espacio argumentativo, no podré hoy tratar aquí. Como sea, parece más promisoria la idea de que las clases pobres o determinados grupos raciales tengan más o menos éxito en la vida debido a las constituciones diferenciales de las redes que integran y a sus capacidades concomitantes, y no por la forma en que la inteligencia de los grupos está biológicamente distribuida.

Lección n° 5: El puente entre lo micro y lo macro no sólo es una posibilidad conceptual, sino que constituye un ingrediente clave de la experiencia cotidiana. Es justo decir que, aunque muchísimas investigaciones abonan estas hipótesis, todavía no hay una demostración exhaustiva, concluyente y axiomática. Sin embargo, la lección epistemológica implicada por esta noción hace que debamos superar la clausura operativa a que nos condena el sentido común —el cual siempre tiende a imponer la idea incluso en el corazón de las tinieblas de la etnografía exotista— de que lo mejor es lo más grande, lo más fuerte, lo más conocido.

EL ADVENIMIENTO DE LOS MUNDOS PEQUEÑOS

Entre otras propiedades interesantes, las redes ER son modelos aceptables de pequeños mundos por razones matemáticamente inevitables pero empíricamente irreales. Si alguien tiene cien o mil conocidos (un número realista) y cada uno de éstos tiene otros tantos, cualquier miembro de la población humana estará entre unos ocho y diez pasos de distancia geodésica de cualquier otro. Esta es la esencia de la idea de los mundos pequeños.

Igual que sucedió con el "efecto mariposa" entrevisto por Ray Bradbury en A Sound of Thunder (1952) algunos años antes de que se lo redescubriera en dinámica no lineal bajo la categoría apenas más austera de "sensitividad extrema a las condiciones iniciales", la idea de pequeños mundos se pensó antes en literatura que en ciencia. En 1929 el escritor húngaro Frigyes Karinthy (1887-1938) publicó una colección de cuentos titulada Minden masképpen van (Todo es diferente), que incluye uno titulado Láncszemek ("Cadenas"). Se rumora que el relato (que no he leído) no es nada del otro mundo, pero incluye este asombroso momento:

Para demostrar que la gente en la Tierra está hoy más próxima que nunca, un miembro del grupo sugirió una prueba. Apostó que podía nombrar a cualquier persona entre los mil quinientos millones de habitantes de la Tierra y, a través de a lo sumo cinco conocidos, uno de los cuales él conociera personalmente, vincularse con la persona escogida.

El episodio anticipa exactamente la clase de concepto que años más tarde habría de hacerse popular como "los seis grados de separación". El estudioso que engendró esta idea no es otro que el psicólogo Stanley Milgram (1933-1984), el mismo que diseñara un famoso experimento que comprobó lo fácil que es inducir a un ciudadano común, políticamente correcto, a que aplique castigos lindantes con la tortura por razones baladíes. La segunda gran idea de Milgram (1967) es menos horrorosa, pero no menos sorprendente. Iniciando una cadena de cartas que tenían por destinatarios finales a dos personas escogidas más o menos al azar en Boston, Massachusetts, Milgram envió 160 cartas a residentes también aleatorios de Omaha, Nebraska, en el otro extremo de la escala social. En las cartas les pedía a éstos que si conocían a alguno de los destinatarios le enviaran la carta directamente; si no los conocían, que se las remitieran a otra persona de su conocimiento que pudiera tener alguna probabilidad de conocerlos.

En cuanto a los resultados, se dice que 42 de las 160 cartas llegaron a destino; algunas de las cadenas requirieron doce pasos, pero el promedio fue de sólo 5.5 pasos. Redondeando magnánimamente hacia arriba, de allí viene lo de los seis grados de separación, aunque Milgram mismo jamás utilizó esta frase. Quien lo hizo por primera vez fue John Guare en la obra de teatro de 1991 Six Degrees of Separation, luego transformada en una película en la que el personaje —a cargo de la actriz Stockard Channing— desarrolla un razonamiento similar al que se encuentra en el relato de Karinthy. Lo que descubrió Milgram (y lo que había intuido antes el escritor) es que la longitud de camino característica de una red es de órdenes de magnitud menor que la dimensión reticular.

El producto más conocido derivado de esta idea es el Oráculo de Kevin Bacon en la Universidad de Virginia, donde se puede proponer el nombre de (casi) cualquier actor o actriz y verificar su distancia geodésica (o sus grados de separación) de aquel actor en particular. Los comportamientos notables de esta red de algunos millones de nodos ocurren a nivel de agregado, pues sucede que Bacon (junto a otros mil o dos mil actores) está a muy pocos grados distancia de cualquier otro actor. La imagen de la figura 7 muestra la red de pequeños mundos desde el improbable Luis Sandrini hasta Kevin Bacon. Contra todo pronóstico, Sandrini se encuentra sólo a tres grados de separación, o sea que tiene un "número de Bacon" igual a 3. ¿Un tío influyente? No; las redes son así, y a cualquiera le puede pasar. A todos, de hecho.

Como suele suceder, tanto el experimento de Milgram como la idea misma de los seis grados fueron puestos recientemente en tela de juicio. Judith Kleinfeld (2002), en particular, procuró degradarlos como si fueran sólo mitos urbanos, aduciendo irregularidades y lagunas de documentación en la ejecución del experimento original. Diversas experiencias con toda clase de redes, empero, confirmaron que las redes grandes —en particular las que veremos en seguida— poseen, en efecto, la propiedad de pequeños mundos, algunas de ellas en el mismo orden de magnitud que el mito urbano, otras incluso por debajo.

Los modelos de pequeños mundos comenzaron a ser tratados a partir de las elaboraciones de Duncan Watts y Steven Strogatz en la década de 1990. Ellos proponen tomar como punto de partida una grilla regular parcialmente "re-cableada"; en el camino comprobaron que si a una grilla regular como la del lado izquierdo de la figura 8 se le añaden unos poquísimos vínculos al azar, la conectividad de esa red aumenta (o su diámetro disminuye) en un número que se diría absolutamente desproporcionado, con absoluta independencia del tamaño de la red. La red de la derecha, por ejemplo, diseñada con Agna 2.1, presenta unas estadísticas de betweenness, distancia geodésica, diámetro y demás radicalmente diferentes de las del caso de la izquierda. Si se agregan algunos cientos de nodos el efecto no varía mucho. Nada por este lado es proporcional a ninguna otra cosa.

Cuando se tratan de razonar las explicaciones del caso se descubre que en la estructura de las redes al azar hay algo importante que está fallando. Si bien estas redes son modelos más aceptables de los mundos pequeños que las grillas regulares, no dan cuenta de una propiedad esencial de las redes en la vida real: los amigos de los amigos de uno tienden a ser amigos entre sí. Esta es la propiedad de clustering, que en una red aleatoriamente estructurada no sólo es improbable sino taxativamente imposible. En efecto, en un grafo al azar, la probabilidad de que dos amigos de A sean amigos entre sí no es mayor que la que tienen de ser amigos dos personas cualesquiera de la población mundial, estatal o lo que fuere.

Lección n° 6: La primera lección a sacar aquí, epistemológicamente hablando, es que el azar es un pobre modelo de las estructuras de red que se encuentran en la vida real. Más todavía, lejos de constituir una heurística útil, el azar en estos escenarios es un modelo inhibidor que impide abordar y comprender estructuraciones esenciales de la realidad.

Lección n° 7: La siguiente lección —no menos importante— consiste en haber aprendido que, en los sistemas regidos por la complejidad, las propiedades no son siempre proporcionales al número de los elementos que los componen. En dinámica no lineal los sistemas llamados caóticos son casi siempre de muy baja dimensionalidad, sumando típicamente dos o tres entre variables y parámetros. En estos sistemas existen ciertos comportamientos que no resultan más complejos si se agrega un número enorme de elementos o si se introduce aleatoriedad (Reynoso, 2006).

REDES LIBRES DE ESCALA (LE)

En todo el siglo XIX y en los primeros años del XX las redes se consideraban a veces como si fueran regulares y otras como si fueran euclideanas en aras de la simplicidad. Más tarde, durante las cuatro últimas décadas, la ciencia trató la mayor parte de las redes empíricas —siguiendo a Erdös y Rényi— como si fueran aleatorias. Podrá decirse que fue un mal necesario; la simplicidad de esta estrategia hizo que floreciera la teoría de grafos y que surgiera una rama de las matemáticas especializada en redes aleatorias (ER). Las redes ER son exponenciales: tienen un pico en un valor promedio y su caída es abrupta. En este modelo, todos los nodos tienen aproximadamente la misma cantidad de vínculos, lo que resulta en una distribución de Poisson en forma de campana, como se muestra en la figura 9 (b).

Albert-László Barabási, Eric Bonabeau, Hawoong Jeong y Réka Albert se embarcaron en 1998 en un proyecto para trazar el mapa de la Web, pensando que iban a encontrar una red aleatoria. Las mediciones, empero, refutaron esa expectativa: la totalidad de la Web se sustentaba en unas pocas páginas altamente conectadas, que en el modelo se identificaron como hubs. La gran mayoría de los nodos, que comprendían más de 80% de las páginas, tenía poquísimos vínculos: menos de cuatro. Entre ambos extremos estaban representadas todas las frecuencias posibles, o casi. Contando el número de páginas con exactamente k vínculos, resultó evidente que la distribución seguía un patrón de ley de potencia: la probabilidad de que un nodo estuviera conectado a k otros nodos era proporcional a 1/kn. Cuando hay una distribución de ley de potencia, hay también independencia de escala, como después se verá: no hay una medida típica ni hay valores promedios que describan el conjunto. Para la estadística tradicional, esos sistemas son casi intratables. Por añadidura, las redes LE obedecen leyes de escala características de los sistemas que se auto-organizan.

Era indudable que se había descubierto una nueva clase de red, menos "teórica" y mucho más conspicua en la vida real que la de Erdös y Rényi. La expresión "redes libres de escala" (scale-free networks) fue acuñada por Barabási para referirse a ella. El centro neurálgico de las investigaciones en redes LE es la Universidad de Notre Dame en Indiana, donde Barabási dirige un activo grupo de investigación, el cual participa en el desarrollo del programa The Network Workbench.

Tras la primera comprobación, comenzó a hacerse evidente que las redes de este tipo aparecían en los contextos lógicos y materiales más disímiles: relaciones sexuales, agendas telefónicas, nexos sintácticos entre palabras en un texto o discurso, citas bibliográficas entre miembros de la comunidad académica, colaboraciones en reportes de investigación, alianzas tecnológicas, relaciones entre actores de cine, sinapsis neuronales, contactos entre personas en una organización, cadenas alimentarias, conexiones entre organismos vinculados al metabolismo o proteínas reguladoras, propagación de enfermedades y virus informáticos (Barabási y Bonabeau, 2003; Liljeros et al., 2003).

Los investigadores de Notre Dame y otros que se unieron al estudio descubrieron en esta clase de redes LE un número inesperado de propiedades. Para empezar, es extraordinariamente robusta: se puede destruir 80% de los nodos y el resto seguirá funcionando. Pero también es desproporcionadamente vulnerable a ataques selectivos: una eliminación de 5 a 10% de los hubs —que son poquísimos en relación con el tamaño de la red— alcanzaría para hacer colapsar el sistema o quebrar su unidad. El modelo LE permite conciliar el hecho de que muchas redes reales presentan conglomerados o clusters jerárquicos, un factor que el modelo aleatorio ER no es capaz de tratar.

Se sabe, además, por simple observación, que las redes LE surgen cuando a una red existente se le van agregando nuevos nodos, y que éstos prefieren ligarse a otros que están bien vinculados. Esta vinculación selectiva se llama efecto de "el rico se vuelve más rico", o principio de San Mateo, bautizado así por el sociólogo Robert Merton muchos años atrás (Barabási, 2003: 79-92; Wang y Chen, 2003: 14; Watts, 2004: 108, 112). Antes se creía (Fritjof Capra todavía lo cree) que las redes que se auto-organizaban sin necesidad de un gobierno o jerarquía vertical eran democráticas y benevolentes; ahora se sabe que no es así. Como sucede a menudo en estas ciencias, los matemáticos tomaron gustosos la vieja metáfora de la sociología que describe un escenario en el cual, aunque las elecciones individuales son impredecibles, como grupo todos siguen estrictamente unos pocos patrones. Esto constituye una verificación colateral de una vieja idea de Gregory Bateson: los aspectos divergentes o singulares de un sistema complejo son impredecibles; los aspectos convergentes o universales son siempre los mismos. Pero contradiciendo a Clifford Geertz (2000: 135), no necesariamente los universales conciernen a ideas consabidas o triviales.

Otras propiedades de las redes LE vuelven a desafiar el sentido común: por razones que aún se discuten, el valor de n en el término kn de la ley de potencia tiende a caer siempre entre 2 y 3. Dada la estructura de estas redes, además, cualquier nodo está conectado con cualquier otro con muy pocos grados de separación: alrededor de seis cuando los nodos son unos cuantos cientos de miles, y no más de diecinueve entre cualesquiera de los cuatro mil millones de páginas de la Web. Por otra parte, en una red LE es posible encontrar nodos cuyo valor de conectividad supera varias veces el número promedio, lo que no es propio de las distribuciones aleatorias, como la que rige la tabla de estaturas de una población, donde nunca se encontrará una persona que sea mil o un millón de veces más alta que otra. Dada la distribución peculiar de estas redes, muchas de las técnicas estadísticas (muestreo, análisis de varianza y generalización) son inadecuadas para lidiar con ellas, puesto que presuponen distribuciones normales; esto es algo que las ciencias sociales han ignorado hasta ahora. Y cuando digo ahora intento significar exactamente eso: hasta los últimos dos o tres años del siglo XX, para ser preciso.

En estas redes LE también es irregular el comportamiento dinámico. Las teorías clásicas de la difusión, que se desarrollaron durante décadas en estudios de mercadeo y epidemiología, predicen un umbral crítico de conectividad para la propagación de un contagio, rumor o novedad a través de una población. Para que un virus, una noticia, un motín o lo que fuere se difunda debe superar ese umbral; de otro modo terminará extinguiéndose. Pues bien, hace poco se demostró que, en las redes LE, el umbral es cero, lo cual implica que cualquier elemento contagioso encontrará la forma de dispersarse y persistir en el sistema, por más que su capacidad de contagio sea débil (y sobre todo si lo es, según dicen). Esto tiene consecuencias drásticas para el planeamiento de campañas de vacunación, distribución de ayuda humanitaria en situaciones de emergencia, tácticas de represión u otros escenarios por poco que se sepa uno manejar con estas redes de manera adecuada: tomar como blanco unos pocos hubs mejor conectados es mucho más efectivo y económico que aplicar la solución a un porcentaje enorme de nodos. Inmunizando los hubs, por ejemplo, se podría impedir que se propague una epidemia. Otros objetivos y efectos los dejo librados a la imaginación.

Dado que algunas redes son aleatorias (la red eléctrica o las carreteras de un país); que otras, en apariencia análogas, son LE (la red de aeropuertos, Internet), y que otras más son mixtas o irregulares, el investigador deberá descubrir de qué clase de red se trata usando el ya familiar gráfico log-log: si la red es LE, el logaritmo del número de nodos contra el logaritmo del número de vínculos resultará en una línea recta (fig. 9, d, p. 30). La inclinación de esa línea mide la dimensión fractal y, según afirman muchos, la complejidad del sistema. La "cola" de una distribución de este tipo tiene una caída mucho más suave que la de una distribución en forma de campana, lo que quiere decir que hay en ellas mayor diversidad. Las matemáticas de las redes LE son además muy simples y sus usos parecen ser innumerables. Su marco teórico se vincula con problemáticas de auto-organización, criticalidad, percolación y hasta fractales.

LEY DE POTENCIA: LOS SIGNIFICADOS DE UNA DISTRIBUCIÓN

Tenemos entonces que la distribución del valor que fuere en el seno de las redes LE no es aleatoria. Matemáticamente —aunque simplificando un poco—, la distribución propia de estas redes es lo que se denomina distribución 1/ƒ o de ley de potencia (power law) y se encuentra entre las leyes más frecuentes que describen la invariancia de escala en muchos fenómenos materialmente disímiles. Dando un giro a lo que antes dije, la invariancia de escala se encuentra asimismo vinculada a la autosimilitud y la auto-organización, y es un rasgo característico de las transiciones de fase en las proximidades de un punto crítico. Una relación de ley de potencia entre dos magnitudes escalares x e y es una relación que se puede escribir de este modo:

y = αxk

donde α (la constante de proporcionalidad) y k (el exponente de la ley de potencia) son constantes. Puede decirse que este exponente es la característica principal de la distribución, pues describe la manera en que ésta cambia como función de la variable subyacente. Por ejemplo, si el número de ciudades de cierto tamaño decrece en proporción inversa a su tamaño, el exponente es 1. Si decrece inversamente al cuadrado el exponente es 2, y así sucesivamente.

A partir de lo que hemos visto hasta aquí, es posible ahora identificar numerosas relaciones de ley de potencia, tales como la ley de Stefan Boltzmann (la energía irradiada por un cuerpo oscuro es proporcional a la cuarta potencia de su temperatura termodinámica); la ley de mortalidad de Benjamin Gompertz, usada para cálculo de seguros desde 1825; la ley de Max Kleiber, que vincula el metabolismo de un animal con su tamaño; y hasta la ley de Newton, en la cual la fuerza gravitacional resulta ser inversamente proporcional al cuadrado de la distancia entre dos cuerpos. El antropólogo Gregory Bateson demostró tener alguna intuición de estas ideas en el extraño episodio del caballo poliploide de su libro Espíritu y naturaleza (Bateson, 1980: 49-53).

Inspirándose lejanamente en la "ley de gravitación social" de Émile Durkheim, hace poco se ha resucitado la teoría de interacción espacial de William Reilly (1931), que trasplantaba la ley de Newton al campo de las interrelaciones entre locaciones y transporte en la adquisición de mercaderías por parte del consumidor ("ley de gravitación de la compra al menudeo"); años más tarde Alan Wilson (1967,1970,1974) verificó esta temprana intuición, que hoy es un lugar común en los modelos de interacción espacial en planeamiento y estudio urbano (Bertuglia y Vaio, 2005:214-230). Muy poco de esto se ha filtrado entre los jornaleros de la estadística, y sobre lo poco que se filtró algunos han construido mitologías.

Como sea, la distribución de ley de potencia también aparece en la investigación social cuando uno se pregunta cuánta gente hay que tiene qué cantidad de dinero (ley de Pareto); en lingüística, cuando se analiza la distribución de las palabras en un texto (ley de Zipf); en criticalidad auto-organizada y en sismología (ley de Gutenberg-Richter) y, finalmente, en la música estéticamente "aceptable" (distribución 1/ƒ o ruido rosa), en el comportamiento dinámico de los públicos musicales (cuánta gente escucha qué géneros) y en la vida de los géneros estilísticos (Voss y Clarke, 1975; Bak, 1996).

Lección n° 8: En suma, los especialistas en redes sociales, circuitos de intercambio, estadística sociocultural o epidemiología de las representaciones harán bien en pensar de nuevo sus modelos tomando en cuenta lo que ahora se sabe y los avances que ha habido en multitud de disciplinas. No tenemos aquí una numerología impracticable ni un trasplante conceptual forzado de una ciencia dura a una blanda (más bien sería al contrario, Pareto, Zipf y redes sociales mediante); lo que sí tenemos es un conjunto de indicadores que podrían utilizarse como heurísticas orientadoras. Cualquier juicio sobre colectivos sociales y procesos de comunicación debe examinar, primero, caso por caso la naturaleza de la distribución en la estructura de una red, y luego conocer en profundidad las propiedades características de cada una de ellas, pues en tanto signo a interpretar, cada tipo de distribución (normal, log-normal, de ley de potencia) es, además, sintomático de ciertas clases de procesos, de correlaciones y de causas que se comienzan a comprender mejor.

Predigo, en este sentido, que si la teorías de redes LE y las teorías relacionadas continúan su proceso de expansión, alguien escribirá alguna vez un buen manual de distribuciones características en la vida social4, bien razonado, convenientemente pedagógico, análogo al manual matemático de distribuciones de Evans, Hastings y Peacock (1993). Eso ayudará, al menos, a pensar las estructuras de manera creativa, a exorcizar algunos fantasmas demasiado buenos para ser verdad (numerologías inspiradas en Feigenbaum, el filo del caos, fractals everywhere) y a limitar, como pedía René Thom, la arbitrariedad de la descripción.

CLASES DE UNIVERSALIDAD Y CLAVES DE LA TRANSDISCIPLINA

Pido al lector un ejercicio de paciencia ahora, porque incursionaremos en una física al principio distante; pero más adelante veremos cómo, dramáticamente, la teoría de redes sociales realiza una integración no reduccionista. En efecto, uno de los aspectos más interesantes de la teoría de redes LE es su vínculo con un conjunto de teorías físicas algo anteriores que luego proporcionarían fundamentos e intuiciones para las nuevas ciencias. Esas teorías se refieren a transiciones de fase de segundo orden, que son las que suceden de modo continuo. En 1965, el físico Leo Kadanoff había determinado que en la vecindad de los puntos críticos, donde ocurren transiciones del desorden al orden o viceversa, diversos sistemas físicos se comportan conforme a leyes de potencia. Ese es el principio de universalidad, que rige con independencia de la naturaleza del sistema. La palabra para designar este principio surgió en conversaciones sobre teoría de campo que Kadanoff sostuvo al borde de la borrachera en un bar de Moscú con Sasha Polyakov y Sasha Migdal.

La idea de mayor fuerza en esta teoría es que en las cercanías de los puntos críticos sólo existen unas pocas soluciones diferentes a cada problema. Muchos problemas en apariencia distintos admiten una misma solución, lo que equivale a decir que pertenecen a la misma clase de universalidad: cambiar el objeto empírico del modelo no cambia los aspectos esenciales de las respuestas. Ahora bien, lo que nos impacta más fuertemente de todo esto es que, en los fenómenos críticos, las clases se definen a nivel macroscópico describiendo el tipo de información que el sistema debe transferir sobre distancias largas (en relación con el tamaño de las unidades). En lugar de tratar el sistema en términos de sus unidades mínimas, reductivamente, lo que se hace es determinar una escala más molecular o (parafraseando a Geertz) una descripción más gruesa. Tanto la teoría como los experimentos han demostrado que este scaling es una de las claves de la universalidad y de los fenómenos colectivos tanto en las ciencias duras como en las blandas (Kadanoff, 1999: 159-160).

En dinámica no lineal se dice que los sistemas cuyas transiciones de fase posean el mismo conjunto de exponentes críticos pertenecen a una misma clase de universalidad. En la teoría de redes complejas es posible vincular, entonces, cosas tan diversas como las relaciones personales, Internet, los ferromagnetos, las citas bibliográficas, la propagación de enfermedades y la percolación (Watts, 2004: 65; Miceli, 2007). En los estudios de auto-organización se reconocen pertenecientes a la misma clase fenómenos emergentes tales como la formación de patrones ondulados en dunas de arena, las manchas en pelajes o conchas de moluscos, la sincronización de cardúmenes y bandadas, las soluciones autocatalíticas o los nidos de termitas (Camazine et al., 2001). Que objetos de ámbitos tan diversos (al nivel de abstracción y a la escala adecuada) pertenezcan todos a unas pocas clases de universalidad es lo que hace la transdisciplina posible. Sobre esta base, el físico Kenneth Wilson, de la Universidad de Cornell, propuso en 1971 una poderosa teoría unificadora de las transiciones de fase, conocida como teoría del grupo de renormalización, cuyo punto de partida es, una vez más, la invariancia de escala y la universalidad. Esta teoría afirma que las propiedades termodinámicas de un sistema cerca de una transición de fase dependen de un número muy pequeño de factores (tales como dimensionalidad y simetría) y es insensible a las características microscópicas del sistema. A la escala adecuada, es suficiente entonces considerar unos pocos grados de libertad.

Wilson recibió el Premio Nobel por ese logro e inspiró a Mitchell Feigenbaum en su búsqueda de la constante universal, la cual también describe regularidades independientes de objeto allí donde no se sospechaba que existiera ningún orden. Todo lo que tenía que ver con bifurcaciones y auto-organización quedó incorporado de este modo (en detrimento de la teoría de catástrofes, yo diría) bajo un marco amplio, conexo y elegante, aunque sólo algunos años más tarde estas ideas convergieron con la teoría de redes, la complejidad, los fractales y el caos (Kadanoff, 1983: 47; Fáth y Sarvary, 2005). Barabási lo expresa de este modo:

La universalidad se convirtió en el principio orientador para comprender muchos fenómenos dispersos. Nos enseñó que las leyes de la física que gobiernan los sistemas complejos y la transición del desorden al orden son simples, reproducibles y ubicuas. Sabemos ahora que los mismos mecanismos universales que generan la forma de los copos de nieve también gobiernan la forma de las neuronas en la retina. Las leyes de potencia y la universalidad emergen en los sistemas económicos, describiendo la forma en que surgen las compañías y cómo fluctúan los precios del algodón. Explican cómo se agrupan en bandadas y cardúmenes los pájaros y los peces, y cómo difieren los terremotos en su magnitud. Son el principio orientador detrás de dos de los descubrimientos más intrigantes de la segunda mitad del siglo XX: el caos y los fractales (Barabási, 2003:255).

Lección n° 9: Por razones de espacio debo dejar a un lado una de las propiedades de las redes LE de consecuencias más amplias y ricas: nada menos que su fractalidad, con lo que se nos escapa también gran parte de la dinámica no lineal en general y del caos determinista en particular. Ya habrá ocasión, en futuros artículos, de explorar regiones de las ciencias de la complejidad y el caos que aquí apenas se han alcanzado a insinuar (cf. Reynoso, 2006).

Lección n° 10: Ésta concierne nada menos que a una nueva definición de universalidad y a un concepto razonablemente más articulado de transdisciplina de lo que hasta ahora ha sido la norma en ciencias sociales. La transdisciplina es posible porque las estructuras de los problemas son pocas y las mismas en todas partes, y no porque los especialistas se sienten a negociar. Matemáticos abstractos y sociólogos de lo concreto pueden hablar un mismo idioma por poco que ambos planteen sus problemas, por ejemplo, en términos de redes.

Lección n° 11: Finalmente hay que hacer alguna referencia al problema de la reducción. La perspectiva transdisciplinaria que aquí se formula no tiene nada que ver con una ciencia líder o con una "teoría de todo" a cuyas unidades mínimas deban rendir tributo las ciencias de objeto más englobante o nivel de inclusión mayor. Los átomos, los componentes y las partículas elementales (sean de la física, la significación o el parentesco) son propios de los modelos mecánicos, no de los complejos. La tensa relación entre reducción y emergencia es demasiado complicada para tratarla en este punto, pero yo diría que depende en exceso de las formas de representación y no es tan sintomática de lo complejo como lo son, por ejemplo, la no linealidad y la sentividad a las condiciones iniciales.

ALCANCES Y LÍMITES DE LA TEORÍA DE REDES (Y DE LA COMPLEJIDAD)

Como reza uno de mis artículos favoritos en ingeniería de software: "No hay balas de plata" (Brooks, 1975). Cuando lo único que se tiene es un martillo, dice otro adagio, todos los problemas resultan clavos. La teoría de redes, como cualquier otro principio algorítmico, se parece demasiado a una panacea pero no garantiza resultados. Por conveniente que resulte la metáfora, algunas problemáticas resultan mejor tratadas de otras maneras, o debería decir, de un número indefinido de maneras. Recién en los últimos años los estudiosos de redes han comenzado a elaborar reflexivamente el problema de los alcances, los constreñimientos, los usos fetichistas de la tecnología, la diagramación y la publicación de matrices del tamaño de sábanas como fines en sí mismos (Granovetter, 1990; Miceli, 2008). Dado que el espacio se agota, invito a pensar en estos dilemas y a revisar la bibliografía indicada.

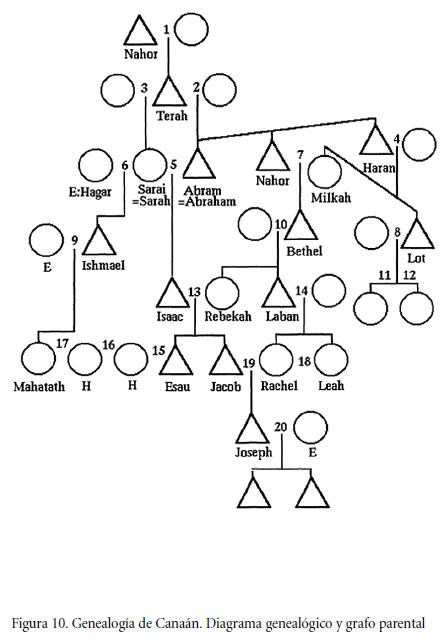

Lección n° 12: Las herramientas no son teorías, aunque puedan estar al servicio de ellas. No importa cuán seductor y fructífero parezca un instrumento, una técnica está muy bien en el lugar que le cabe pero no satisface el papel de una teoría, como aprendimos por la vía cruel en nuestra disciplina cuando se intentó la aventura del análisis componencial. Pero aun cuando ahora se sabe, por ejemplo, que los diagramas de parentesco usados durante un siglo en antropología constituyen una técnica limitada y que hay otros formalismos reticulares de recambio mucho más adecuados al objetivo (v. gr. PGRAPH, véase fig. 10, pp. 36-37), esas herramientas aún esperan que alguien haga con ellas siquiera una pequeña parte de lo que nuestros antepasados antropólogos hicieron con lápiz, papel y una notación impropia (Foster y Seidman, 1981; Collard, 2000; White y Jorion, 1992).

Las herramientas están ahí y no son poca cosa a la luz de lo que la posibilidad de su uso nos ha enseñado. Pero cualquiera que sea ahora la capacidad técnica y el aprendizaje epistemológico al que ella nos ha abierto, el verdadero trabajo teórico está todavía por hacerse.

CONCLUSIONES

Ignoro si estamos o no en presencia de un nuevo paradigma radical, como algunos han pretendido, pero es seguro que los desafíos que hasta aquí he planteado requieren, al menos, una discusión detenida. Habrá que repensar ideas tan solidificadas como las de red, sistema, modelo, problema, pregunta, elicitación, técnica, solución y estadística, y pensar de nuevo casi todas las cuestiones aparejadas por la auto-organización, la dimensión fractal, las distribuciones de ley de potencia y la no-linealidad. Una teoría reductora, como la autopoiesis (que por definición sólo debería aplicarse a cosas vivas) no sirve de mucho en este contexto. Las analogías epistemológicas se saben ahora más definitorias que las afinidades ontológicas, pues entre tanto hemos caído en la cuenta de que aun éstas son siempre conceptualmente construidas. Para emplear una metáfora cara a las concepciones interpretativas, podría decirse que lo que aquí cuenta son los verbos, no los sustantivos, pues los verbos son los operadores conceptuales que permiten activar genuinamente los modelos.

A diferencia de los viejos modelos en papel, éstos son ahora, por un lado, manejables y, por el otro, autónomos y hasta insumisos. Mientras que antes casi no había herramientas, hoy abundan más allá de lo que se podría llegar a aprender —y como aprendedor compulsivo lo afirmo—. Se las consigue, gratis, a través de una Web, que es ella misma una red concreta, vital, tangible, inmensa y, ahora, al fin, abismalmente inteligible. Los investigadores veteranos deberán aprender de qué se trata o hacerse discretamente a un lado. Ni sueñen en que esto pueda resolverse salteándose obtusamente el aprendizaje de todo lo que huela a algoritmos o citando una penosa frase de Edgar Morin en contra de la hiper-especialización: los conceptos básicos de análisis de redes se pueden aprender en un mes combinando un par de libros con Wikipedia y todos los programas existentes en un par de semanas. Estos desarrollos no son perfectos, pero no es por aquí donde impera la jerga o la ciencia oscura.

La ciencia de las redes del siglo XXI define, además, un concepto de transdisciplinariedad mucho más fructífero y concreto de lo que propusiera Morin, por ejemplo, quien si bien popularizó el término, nunca imaginó que éste denotara algo más que una reunión de científicos, cada uno de los cuales conoce un solo objeto específico y domina un solo lenguaje impenetrable a los extraños. En este espacio no hay lugar tampoco para la vieja jerarquía de las ciencias. La nueva concepción ha sido perfectamente descripta por Duncan Watts:

Las matemáticas de los físicos abren nuevos caminos hacia regiones antes inexploradas. El crecimiento aleatorio, la teoría de la percolación, las transiciones de fase y la universalidad [...] han definido un maravilloso conjunto de problemas abiertos en materia de redes. Pero sin los mapas de la sociología, la economía e incluso la biología para guiarlos, la física bien puede construir caminos que no lleven a ninguna parte (Watts, 2004: 303).

Familias enteras de algoritmos en tecnología de punta y métodos formales están esperando la inspiración de las ciencias sociales, la cual ha llegado hasta hoy bajo la forma de algoritmos culturales, ingeniería del conocimiento para la Web semántica, heurísticas de sentido común para la inteligencia artificial en estado de arte, computación existencial heideggeriana o fenomenológica, métodos de enjambres de partículas (particle swarms), códigos de la biología copiados de la lingüística, sistemas de posicionamiento global que emulan el etak nativo de Micronesia, nociones estilísticas en arquitectura de software y, por supuesto, teoría de redes sociales, entre otros muchos intercambios bien conocidos en ciencias duras que las ciencias blandas se obstinan en ignorar.

Para finalizar, no quisiera dejar de lado el tema de la importancia política del asunto. Sin ánimo de dramatizar la situación, está claro que el campo de las redes sociales es uno de los muchos en los cuales está en juego (y tiene oportunidad de manifestarse) la relevancia que podría tener la antropología en la comprensión de la dinámica del mundo actual. Saber, por ejemplo, cuál es la distancia geodésica entre George W. Bush y Osama Bin Laden (o la díada que a alguien se le ocurra), o determinar qué es lo que debe hacerse para impedir o impulsar con efectividad la difusión de un virus, un rumor, una campaña, una moda o una política de cooptación, o cómo debe actuarse para proteger un recurso o hacer que colapse un sistema de comunicación, todo esto es cualquier cosa menos trivial.

Algunos personajes emergentes difíciles de catalogar han hecho fama y fortuna en este campo, brindando servicios de consultoría cuyo valor oscila, a ojos vista, en un rango que va de la razonabilidad a la estafa, con énfasis en esto último. Uno de los más conocidos entre los gurúes del momento es Valdis Krebs, quien ha examinado a la luz de estas ideas la problemática de identificar la organización de Al Qaeda. No implico que este personaje Krebs encarne el ejemplo a seguir, ni que las ciencias sociales puedan devenir un nuevo semillero de oráculos, pero lo cierto es que estamos más cerca que antes de comprender algunas claves que pueden resultar importantes en el corto plazo. La figura 11 muestra un ejemplo incluido en Network Workbench, que ilustra la red del 11 de setiembre. Este recurso pedagógico se ha tornado habitual y no estoy seguro de saber cómo interpretarlo. Cada quien decidirá qué carácter darle y qué propósito servir con la nueva ciencia, en una dimensión que constituye, yendo un poco más allá de la docena planeada, la lección epistemológica y el desafío del conocimiento más importante de los que hemos discutido hasta ahora.

Referencias bibliográficas

Arrow, Kenneth, 1950, "A Difficulty in the Concept of Social Welfare", Journal of Political Economy, vol. 58, núm. 4, pp. 328-346. [ Links ]

Bak, Per, 1996, How Nature Works: The Science of Self-Organized Criticality, Springer, Nueva York. [ Links ]

Barabási, Albert-László, 2003, Linked: How Everything is Connected to Everything Else and What it Means, Plume Books, Nueva York. [ Links ]

---------- y Eric Bonabeau, 2003, "Scale-Free Networks", Scientific American, vol. 288, núm. 5, pp. 50-59. [ Links ]

Barnes, John, 1954, "Class and Committees in a Norwegian Island Parish", Human Relations, vol. 7, núm. 1, pp. 39-58. [ Links ]

Bateson, Gregory, 1980, Espíritu y naturaleza, Amorrortu, Buenos Aires. [ Links ]

Bertuglia, Cristoforo Sergio y Franco Vaio, 2005, Nonlinearity, Chaos, and Complexity: The Dynamics of Natural and Social Systems, Oxford University Press, Oxford. [ Links ]

Blair, D. y R. Pollack, 1999, "La Logique du choix collectif", Pour la Science, dossier: Les mathématiques sociales, julio, pp. 82-89.

Bondy, J. A. y S. R. Murty, 1976, Graph Theory with Applications, North-Holland, Nueva York. [ Links ]

Bott, Elizabeth, 1957, Family and Social Network, Tavistock, Londres. [ Links ]

Brandes, Ulrik y Thomas Erlebach (comps.), 2005, Network Analysis: Methodological Foundations, Springer Verlag, Berlín. [ Links ]

Brooks, Frederick, 1975, The Mytical Man-Month: Essays on Software Engineering, Addison-Wesley, Reading. [ Links ]

Camazine, Scott, Jean-Louis Deneubourg, Nigel Franks, James Sneyd, Guy Theraulaz y Eric Bonabeau, 2001, Self-Organization in Biological Systems, Princeton University Press, Princeton. [ Links ]

Collard, Chantal, 2000, "'Kinship studies' au tournant du siècle", L'Homme, núms. 154-155, pp. 635-658. [ Links ]

D'Andrade, Roy, 2000, "The Sad Story of Anthropology 1950-1999", Cross-Cultural Research, vol. 34, núm. 3, pp. 219-232. [ Links ]

Ericksen, E. y W. Yancey, 1977, "The Locus of Strong Ties", Universidad de Temple, manuscrito inédito. [ Links ]

Evans, Merran, Nicholas Hastings y Brian Peacock, 1993, Mathematical Distributions, 2a ed., John Wiley & Sons, Nueva York. [ Links ]

Fáth, Gábor y Miklos Sarvary, 2005, "A Renormalization Group Theory of Cultural Evolution", Physica A, núm. 348, pp. 611-629. [ Links ]

Foster, Brian y Stephen Seidman, 1981, "Network Structure and the Kinship Perspective", American Ethnologist, vol. 8, núm. 2, pp. 329-355. [ Links ]

Freeman, Linton Clarke, 2004, The Development of Social Network Analysis: A Study in the Sociology of Science, Booksurge Publishing, Londres. [ Links ]

Friedkin, Noah, 2003, "Social Influences Network Theory: Toward a Science of Strategic Modification of Interpersonal Influence Systems", en Ronald Breiger, Kathleen Carley y Philippa Pattison (comps.), Dynamic Social Network Modeling and Analysis, National Academy Press, pp. 89-100. [ Links ]

Geertz, Clifford, 1987 [1973], La interpretación de las culturas, Gedisa, México. [ Links ]

----------, 2000, Available Light. Anthropological Reflections on Philosophical Topics, Princeton University Press, Princeton. [ Links ]

Granovetter, Mark, 1973, "The Strength of Weak Ties", American Journal of Sociology, núm. 78, pp. 1360-1380. [ Links ]

----------, 1983, "The Strength of Weak Ties: A Network Theory Revisited", Sociological Theory, núm. 1, pp. 201-233. [ Links ]

----------, 1990, "The Myth of Social Network Analysis as a Special Method in the Social Sciences", conferencia magistral, Sunbelt Social Networks Conference, San Diego, 15 de febrero, Connections, vol. 13, núms. 1-2, pp. 13-16. [ Links ]

Grupo Anthropocaos (Jorge Miceli, Diego Díaz, Sergio Guerrero, Damián Castro, Mora Castro, Ramón Quinteros, Jordan Kristoff e Ignacio García), 2007, Exploraciones en antropología y complejidad, Editorial SB, Buenos Aires. [ Links ]

Harary, Frank, 1976, Graph Theory, Addison-Wesley, Reading. [ Links ]

Herrnstein, Richard y Charles Murray, 1994, The Bell Curve: Intelligence and Class Structure in American Life, Free Press, Nueva York. [ Links ]

Kadanoff, Leo, 1983, "Roads to Chaos", Physics Today, diciembre, núm. 36, pp. 46-53. [ Links ]

----------, 1999, From Order to Chaos II: Essays: Critical, Chaotic and Otherwise, World Scientific Publishing Company, Nueva York. [ Links ]

Kapferer, Bruce, 1972, Strategy and Transaction in an African Factory: African Workers and Indian Management in a Zambian Town, Manchester University Press, Manchester. [ Links ]

----------, 1973, "Social Network and Conjugal Role in Urban Zambia: Towards a Reformulation of the Bott Hypothesis", en Jeremy Boissevain y J. Clyde Mitchell, Network Analysis Studies in Human Interaction, Mouton & Co, La Haya. [ Links ]

Kleinfeld, Judith, 2002, "The Small World Problem", Society, vol. 39, núm. 2, pp. 61-66. [ Links ]

Liljeros, Fredrik, Christopher Edling y Luis Nunez Amaral, 2003, "Sexual Networks: Implications for the Transmission of Sexually Transmitted Infections", Microbes and Infection, núm. 5, pp. 189-196. [ Links ]

Lomnitz, Larissa, 1974, Networks and Marginality, Academic Press, Nueva York. [ Links ]

McNeal, Edward, 1994, Math Semantics: Making Numbers Talk Sense, Penguin, Londres. [ Links ]

Miceli, Jorge, 2007, "Modelos de percolación y difusión de ideas en ciencias sociales: Una clasificación provisoria", en Grupo Antropocaos, Exploraciones en antropología y complejidad, Editorial SB, Buenos Aires, pp. 67-104. [ Links ]

----------, 2008, "Problemas de validez en el análisis de las redes sociales: Algunas reflexiones integradoras", en C. Reynoso (ed.), Críticas y modelos heterodoxos en antropología compleja, Editorial SB, Buenos Aires. [ Links ]

---------- y Sergio Guerrero, 2007, "Redes libres de escala y su uso en el análisis de datos etnográficos: El caso de la comunidad Tehuelche del Chalía", en Grupo Antropocaos, Exploraciones en antropología y complejidad, Editorial SB, Buenos Aires, pp. 177-191. [ Links ]

Mika, Stephen, 2007, Social Networks and the Semantic Web, Springer Science, Nueva York. [ Links ]

Milgram, Stanley, 1967, "The Small World Problem", Psychology Today, vol. 1, núm. 1, pp. 61-67. [ Links ]

Mitchell, Clyde, 1969, Social Networks in Urban Situations, Manchester University Press, Manchester. [ Links ]

Reilly, William J., 1931, The Law of Retail Gravitation, G.P. Putnam & Sons, Nueva York. [ Links ]

Reynoso, Carlos, 2006, Complejidad y caos. Una exploración antropológica, Editorial SB, Buenos Aires. [ Links ]

----------, 2008, Corrientes teóricas en antropología. Perspectivas para el tercer milenio, Editorial SB, Buenos Aires. [ Links ]

Schweizer, Thomas, 1997, "Embeddedness of Ethnographic Cases: A Social Networks Perspective", Current Anthropology, vol. 38, núm. 5, pp. 739-760. [ Links ]

Stack, Carol, 1974, All our Kin, Harper & Row, Nueva York. [ Links ]

Voss, Richard F. y John Clarke, 1975, "1/f Noise in Music and Speech", Nature, núm. 258, pp. 317-318. [ Links ]

Wang, Xiao Fan y Guanrong Chen, 2003, "Complex Networks: Small-World, Scale-Free and Beyond", IEEE Systems and Circuits Magazine, primer trimestre, pp. 6-20.

Watts, Duncan, 2004, Six Degrees: The Science of a Connected Age, Vintage, Londres. [ Links ]

While, Douglas R., 2001,"Network Analysis and Social Dynamics", Universidad de California en Irvine, manuscrito. [ Links ]

---------- y Paul Jorion, 1992, "Representing and Computing Kinship: A New Approach", Current Anthropology, vol. 33, núm. 4, pp. 454-462. [ Links ]

Wilson, Alan G., 1967, "A Statistical Theory of Spatial Distribution Models", Transportation Research, núm. 1, pp. 253-269. [ Links ]

----------, 1970, Entropy in Urban and Regional Modelling, Pion, Londres. [ Links ]

----------, 1974, Urban and Regional Models in Geography and Planning, Wiley, Londres. [ Links ]

Referencias tecnológicas

Adit Sociogram. © s/fecha, Adit Limited. http://www.aditsite.co.uk/more20.htm#Adit%20Sociogram (consultado el 28 de enero de 2008).

Agna.V. 2.1.1, (Applied Graph & Network Analysis) © 20022003 A. M. Benta, 12 de diciembre de 2003 http://www.geocities.com/imbenta/agna (consultado el 26 de enero de 2008).

Network Workbench Tool, v. 0.8.0, © 2005 University of Indiana, 16 de diciembre de 2007. http://nwb.slis.indiana.edu/index.html (consultado el 26 de enero de 2008).

Pajek, v. 1.22, © 1996-2008, Vladimir Batagelj & Andrej Mrvar, 16 de enero de 2008. http://vlado.fmf.uni-lj.si/pub/networks/pajek/ (consultado el 28 de enero de 2008).

1 La vez que estuve un día calendario en Kaliningrado, enclavada en ese jirón de Rusia separada del resto del territorio por los países bálticos, quise conocer los siete puentes originales, pues no hay otra cosa que pueda hacerse allí un domingo por la tarde. Por desdicha no quedaba casi nada de ellos, aunque ahora los puentes son muchos más; en 1944 gran parte de la ciudad vieja ocupada por los nazis fue demolida por los bombardeos ingleses por necesidad imperiosa, pero sin cuidado alguno por lo que hoy llamaríamos la puesta en valor del patrimonio histórico.

2 De más está decir que no existe ninguna "curva de Bell", ni tampoco hubo un científico así apellidado que inventara esa criatura epónima. Vale la pena repetir el dato, por si alguien desea reproducir el antipatrón: una bell curve es, sencillamente, una curva en forma de campana.