Introducción

En México, como en otros países, las políticas educativas no son de largo aliento. Suelen implementarse durante el gobierno en turno y de acuerdo con los intereses del grupo político en el poder. Ello generalmente impide consolidar estrategias o estimar los efectos de los cambios realizados (World Bank, 2018). La evaluación del desempeño docente, particularmente la evaluación entre pares (EeP), surgió en México como una fase del sistema nacional de evaluación docente y estuvo vigente entre 2013 y 2019 en el marco de la Reforma Educativa de 2013. En 2019, con la cancelación de la reforma previa, se modificaron los objetivos y las funciones de la EeP, lo que representa un momento coyuntural para aprender de la experiencia evaluativa que experimentó el país y de los actores educativos involucrados. Así, en este artículo se explora el conjunto de atributos que caracterizaron a los evaluadores pares docentes, actores que se postularon voluntariamente para participar en esta reforma como revisores del trabajo de sus compañeros.

Existe literatura que apunta que la EeP tiene beneficios tanto para los evaluados como para los evaluadores. Para los primeros, ser evaluados por agentes que conocen su trabajo de primera mano se traduce en confianza en los procesos evaluativos y en retroalimentación más pertinente. Para los segundos, el ejercicio resulta en experiencias de trabajo fuera de la escuela y en aprendizajes a partir de contrastar lo que evalúan con su propia labor (Contreras, 2018). Hay también investigación sobre los elementos deseables de los actores escolares que pueden fungir como evaluadores en un sistema educativo (Ramírez Raymundo, 2016; Ortega Ávila, 2015; Moreno Olivos, 2011). Sin embargo, existe información limitada en la investigación educativa respecto del perfil y las características generales de quienes, en la práctica, se involucran en la EeP.

Este artículo contribuye al campo de la evaluación educativa aportando evidencia sobre el perfil de los actores educativos que se postularon para convertirse en evaluadores pares, realizaron el proceso de capacitación y concluyeron el proceso de certificación para desempeñarse como evaluadores pares entre 2014 y 2017. Dichos evaluadores se denominaron, de acuerdo con la normativa aplicable en México, como evaluadores certificados (EC).

Para describir el perfil de los EC se analizaron, mediante estadística descriptiva, datos obtenidos a través de una encuesta en línea respondida por 3 mil 168 evaluadores pares (74% de los que hay en el país), así como de otras dos fuentes institucionales de información. Con ello, esta investigación brinda un perfil general de los EC en tres aspectos: individual, profesional, así como de motivación y experiencia en funciones evaluativas.

Los hallazgos son relevantes porque los EC son los pioneros de la EeP en México. Resulta importante identificar el perfil de actores que responden a los cambios en política educativa de manera activa, lo cual puede enriquecer el diseño de nuevas estrategias evaluativas.

El artículo se organiza de la siguiente manera: la primera sección describe el contexto de política educativa en el que se diseñó y operó el sistema nacional de evaluación docente, el cual enmarcó a la EeP. La segunda presenta un marco teórico sobre la evaluación docente en México, la importancia de la participación de actores pares en los procesos de evaluación así como las características que, de acuerdo con la investigación educativa, deben tener quienes funjan como evaluadores pares. En el tercer apartado se describe la estrategia metodológica. La cuarta presenta los hallazgos. En la quinta sección se presentan conclusiones y en la sexta reflexiones finales sobre la EeP.

El contexto: los evaluadores pares en la reforma educativa de 2013

El sistema educativo mexicano ha instrumentado reformas desde la década de 1990. Estas incluyen el Acuerdo Nacional para la Modernización de la Educación Básica (ANMEB), en 1992, el Compromiso Social para la Calidad de la Educación, en 2002, y la Alianza por la Calidad de la Educación, en 2008 (Flores Andrade, 2017). La Reforma Educativa de 2013 modificó el artículo 3o de la Constitución Nacional, así como la Ley General de Educación (LGE), y promulgó la Ley General del Servicio Profesional Docente (LGSPD) y la Ley del Instituto Nacional para la Evaluación de Educación (LINEE). Los principales cambios en materia de evaluación docente derivados de estos ajustes normativos se resumen a continuación: el Estado asumió la obligación de garantizar que el ingreso y la permanencia en el servicio de carrera docente, así como el ascenso a puestos directivos y de supervisión en la educación obligatoria (preescolar, primaria y secundaria inferior) se realizara mediante examen (INEE, 2015a). La LGSPD indicó que cada cuatro años los miembros de la profesión docente, sin excepción, deberían ser evaluados y aprobar el proceso (Congreso General de los Estados Unidos Mexicanos, 2013).

Así, la Reforma Educativa de 2013 reguló y estructuró la Evaluación del Desempeño Docente (EDD) mediante procesos de ingreso, permanencia y promoción del personal tanto docente como aquel con funciones de dirección y supervisión, tanto en educación básica como en media superior. La EDD se conformó por tres etapas (CNSPD, 2017a): la primera, el llenado de un cuestionario estandarizado, donde la autoridad valoraba las responsabilidades del evaluado; en la segunda, este último elaboraba un diagnóstico del grupo, una planeación de actividad y una reflexión sobre su práctica docente; y en la tercera, presentaba un examen estandarizado sobre casos y situaciones educativas.

En la segunda etapa de la EDD se incorporó el factor humano como pieza fundamental en este proceso (INEE, 2014). Para ello, un evaluador par era responsable de calificar el expediente o portafolio de evidencias de los evaluados. De acuerdo con la LGSPD, los evaluadores pares debían ser servidores públicos que cumplieran con el perfil correspondiente, que se hubieran capacitado y contaran con la certificación vigente. En 2014 ocurrió la primera convocatoria para certificarlos.

Sin embargo, en 2019 se abrogó la Reforma Educativa de 2013 y se derogó la LGSPD que daba marco legal a la figura de EC. En remplazo, fue publicada la Ley General del Sistema para la Carrera de las Maestras y los Maestros (LGSCMM), que cancela todo tipo de evaluación estandarizada (Congreso General de los Estados Unidos Mexicanos, 2019). La LGSCMM establece que, para fortalecer las capacidades, conocimientos y competencias del personal de nuevo ingreso, las autoridades educativas de las entidades federativas realizarán una valoración y reconocimiento diagnóstico. Al momento no se sabe cómo se realizarán las mencionadas evaluaciones diagnósticas y, con ello, se desconoce si la figura de EC permanecerá en el sistema educativo. No obstante, ante la posibilidad de que el ejercicio diagnóstico involucre la participación de evaluadores pares, en esta investigación se presenta su perfil individual, profesional y evaluativo.

Evaluación del desempeño docente en México y la importancia de la evaluación entre pares

En México, las acciones para la evaluación docente pueden rastrearse hacia 1971 con la creación del primer cuestionario nacional de valoración docente. Más adelante, en los años ochenta las universidades comenzaron a emplear Cuestionarios de Evaluación de la Docencia (CEDA) y fueron publicados los primeros instrumentos psicométricos de evaluación docente (García Garduño, 2005). En 1992, el ANMEB y la descentralización educativa trajeron consigo el Programa Nacional de Carrera Magisterial, un sistema de estímulos por escalafón para docentes y figuras directivas. Los estudios realizados a Carrera Magisterial refieren un bajo nivel de efectividad en la mejora de la enseñanza y en el logro educativo de los estudiantes (Santibáñez y Martínez, 2010; INEE, 2015b).

Más tarde, en el marco de la Alianza por la Calidad de la Educación (2007-2012), surgieron los Estímulos a la Calidad Docente, que asignaban incentivos económicos a los profesores y directivos vinculados con los resultados obtenidos por los estudiantes en la Evaluación Nacional de Logros Académicos en Centros Escolares (ENLACE). Posteriormente, en 2013, la evaluación de profesores se convirtió en el eje central de las acciones hacia la mejora educativa. Sin embargo, este proceso estuvo caracterizado por el uso de incentivos negativos y acompañado de un entorno mediático de desconfianza a las escuelas y al ejercicio docente (Arnaut, 2014).

La evaluación del desempeño docente en el contexto nacional ha sido explorada desde distintas dimensiones y perspectivas del campo educativo. Por ejemplo, como un sistema de remuneración o incentivo económico (Martínez Rizo, 2016; Sánchez Cerón y Corte Cruz, 2015; Santibáñez, Martínez, Datar, Mcewan et al., 2006); como elemento formativo para mejorar la práctica docente (Arbesú García, 2004; Rueda Beltrán, Díaz Barriga y Díaz Polanco, 2001; Moreno Olivos, 2011; Santizo, 2014); como un mecanismo de control que genera incertidumbre y vulnerabilidad en las relaciones laborales de los docentes (Gil Antón, 2018; Díaz Cano, 2019; Guzmán, 2018) o bien, desde la dimensión de transparencia y rendición de cuentas de la actividad educativa (Martínez Rizo y Blanco, 2010; Cuevas Cajiga y Moreno Olivos, 2016).

Si bien la investigación sobre evaluación educativa y del desempeño docente tiene un desarrollo sólido en nuestro país, vale la pena profundizar en estudios sobre el componente específico de la evaluación entre pares y el perfil de quienes la desarrollan.

La evaluación docente entre pares

La EeP se define como “un arreglo en el que los individuos determinan la cantidad, el nivel, el valor, la significancia, la calidad o el éxito de los productos o resultados del trabajo realizado por gente de un status similar al suyo” (Topping, 1998:250, citado en Ashenafi, 2017). Los resultados de la EeP pueden tener efectos formativos, mediante la retroalimentación para mejorar el desempeño, o sumativos, como parte de un proceso evaluativo formal (Looney, 2011).

La literatura que analiza la participación en procesos de EeP ha explorado la aversión a la evaluación versus la motivación por generar sociedades de trabajo; así como lazos de amistad, enemistad, procesos de poder e, incluso, la popularidad de los individuos generada durante el proceso evaluativo (Ashenafi, 2017). Existen estudios que ven en este tipo de evaluación como una vía para la retroalimentación constructiva y la generación de trabajo colaborativo (Munson, 1998). Además, hay estudios que señalan que algunos ejercicios de EeP pueden derivar en mayor confianza en los procesos evaluativos y en aprendizajes para los evaluadores, quienes aprenden se instruyen sobre el trabajo de sus pares evaluados (Hawes B. y Troncoso N., 2006; Topping, 2009).

Características de los evaluadores pares

A pesar de los impactos positivos que puede tener la EeP, uno de los desafíos relevantes en su instrumentación está relacionado con los actores involucrados en las evaluaciones a docentes. En particular, importa analizar la disponibilidad -tiempo y carga de trabajo- para convertirse en EC, la apropiada capacitación para evaluar a sus pares, la reglamentación que garantice procesos justos de EeP y la selección de evaluadores con conocimiento y experiencia para la valoración del trabajo de sus colegas. A continuación se presentan estos elementos con mayor detalle, tanto para la experiencia mexicana como para la de otros lugares donde se han implementado procesos de EeP.

Respecto de la disponibilidad de tiempo y carga de trabajo para ser evaluadores pares hay, por un lado, quienes argumentan que las figuras directivas están sobrecargadas para evaluar a su colectivo docente, por lo que no representan un actor factible para sumarle esta responsabilidad (Copland, 2001; Grubb y Flessa, 2006). Algunas investigaciones sugieren que expandir la tarea de docentes pares para integrar procesos de evaluación conlleva una tensión de autoridad con las figuras directivas o líderes pedagógicos (Abbott, 1988; Little, 1982; Smylie y Denny, 1990; Goldstein, 2004).

Sobre el involucramiento de los actores educativos en los sistemas de evaluación, Moreno Olivos (2015) señala que, aunque se reconoce al evaluador como un actor clave en cualquier sistema de evaluación -porque en él recae la responsabilidad de llevar a cabo esa compleja labor y porque su formación, experiencia, credibilidad y autoridad inciden en buena medida en la calidad del proceso-, las competencias o capacidades del evaluador par son un tema importante al que los investigadores le han prestado poca atención (Moreno Olivos, 2015). El autor subraya que, históricamente, bastaba con ser par académico y desempeñar las mismas funciones, así como tener disponibilidad de tiempo para convertirse en evaluador par. Sin embargo, “dado que de los resultados de la evaluación se derivan fuertes repercusiones (promoción, certificación, reconocimiento a la calidad, prestigio e incluso ayudas económicas) que afectan los derechos de los evaluados” (Moreno Olivos, 2015:105), se debe garantizar que el perfil, formación y entrenamiento de los evaluadores sean los adecuados para que realicen sus tareas de forma eficaz y ética (Ramírez Raymundo, 2013; Ortega Ávila, 2015; Moreno Olivos, 2011).

Así, al indagar sobre el perfil de los evaluadores pares, la literatura educativa refiere elementos deseables como requisitos, conocimientos, competencias y valores; sin embargo, hay poca información del perfil general de quienes efectivamente han participado en experiencias de evaluación docente. Por ejemplo, el caso chileno, uno de los más explorados de la región, refiere como requisitos de los evaluadores pares que sean profesionales que ejercen su función en planteles distintos a los de los docentes evaluados, que no sean superiores jerárquicos y que cuenten con conocimiento del contexto (condiciones laborales, socioeconómicas, etcétera) en el que el profesor evaluado desempeña su trabajo (Assaél y Pavez, 2008). Los requisitos, en el caso mexicano, involucraron tener como mínimo un título de educación superior en algún área afín en el nivel, tipo, modalidad educativa o asignatura a evaluar; contar con experiencia docente frente a grupo mínima de tres años consecutivos en el nivel, tipo, modalidad educativa o asignatura a evaluar; tener experiencia en asesoría y apoyo pedagógico a docentes (mínima de seis meses) o haber colaborado en proyectos de formación en el ámbito educativo; así como tener habilidades para el uso de recursos tecnológicos para procesar textos, construir hojas de cálculo y elaborar presentaciones y gráficas (INEE, 2017).

Sobre los conocimientos de los evaluadores, a grandes rasgos, estos se centran en los fines, procesos e instrumentos de evaluación, así como en el conocimiento teórico-conceptual del ámbito educativo (Duitama Peña, Linares Molina y Zúñiga Monroy, 2010). Respecto de sus competencias, destacan el uso de métodos de investigación, análisis de datos cuantitativos y cualitativos, gestión de proyectos y administración de datos (Dewey, Montrosse, Schröter, Sullins et al., 2008). Igualmente, la Organización para la Cooperación y Desarrollo Económico (OECD, 2009) resalta: a) experiencia docente; b) conocimiento en teorías y métodos de evaluación educativa; c) conceptos de calidad docente; d) familiaridad con el sistema educativo; e) desarrollo de instrumentos de evaluación considerando confiabilidad y validez; f) conciencia de los aspectos psicológicos de la evaluación; g) experiencia con escalas cuantitativas de evaluación; y h) dominio de herramientas de comunicación para la retroalimentación docente.

Por último, en relación con los valores, se identifica un énfasis importante en los estándares éticos del evaluador (Dewey et al., 2008) con el fin de cumplir los principios de objetividad, pertinencia, transparencia, participación y equidad, y con esto, propiciar el desarrollo profesional de los docentes (Duitama Peña, Linares Molina y Zúñiga Monroy, 2010). Si bien los parámetros sobre conocimientos, habilidades, valores y experiencia de evaluadores pares son una guía fundamental en el diseño de la política de EeP, en la literatura aún queda pendiente información precisa sobre quiénes, de facto, integran el colectivo de actores en la EeP. Este artículo busca contribuir a la investigación educativa, caracterizando a los EC en la experiencia mexicana.

Metodología

Esta investigación se realizó en el marco de un estudio de opinión con EC, encargado y financiado por el Instituto Nacional para la Evaluación de la Educación (INEE) a finales de 2017. Este artículo tiene por objetivo describir el perfil general de los actores educativos que se postularon para convertirse en evaluadores pares, realizaron el proceso de capacitación requerido y concluyeron el proceso de certificación para desempeñarse como evaluadores pares entre 2014 y 2017. Para lograr el objetivo se utilizó análisis cuantitativo, principalmente estadística descriptiva, para caracterizar el perfil general de los EC en tres aspectos principales: individual, profesional, y de motivación y experiencia en funciones evaluativas.

Procedimiento de recolección de datos

El INEE proporcionó, al equipo de investigadoras, dos fuentes de información. La primera, una base de datos con información de la población total de EC en 2017. Dicha base concentraba información de los 4 mil 271 evaluadores certificados entre 2014 y 2017 en la cual se identifican a los EC por nombre completo, clave única de registro de población (CURP), correo electrónico registrado para el proceso de certificación, además de información de entidad donde laboran, nivel educativo y modalidad de la escuela, clave del centro de trabajo (CCT), adscripción y año de certificación. Cabe mencionar que el equipo de investigadoras construyó la variable “sexo” con base en los nombres propios de los individuos y la variable “edad” con base en los datos de la CURP; esta fue utilizada como clave de identificación de las personas y los nombres fueron borrados de la base de datos en su versión final para garantizar confidencialidad.

El INEE proporcionó una segunda base de datos con una muestra de aspirantes y evaluadores certificados1 que estuvieron en el proceso de certificación entre 2014 y 2017. La base de datos, con cerca de seis mil observaciones, fue construida por el INEE mediante la revisión manual de los expedientes de cada uno de los individuos seleccionados, utilizando un método aleatorio simple con el objetivo de analizar, de forma preliminar, los perfiles de los aspirantes a EC. La base incluye información sobre la escolaridad y resultados de las evaluaciones de desempeño de los individuos en 2015 y 2016. Así, se revisó el currículum vitae que los individuos adjuntaron a la plataforma de registro cuando iniciaron su proceso como aspirantes a evaluador, al igual que los documentos probatorios, con sus resultados en la evaluación del desempeño, que los mismos adjuntaron en la plataforma.

De la segunda fuente de información únicamente se utilizan los datos de quienes obtuvieron la certificación como evaluadores, no así de aquellos que no completaron el proceso de certificación y permanecieron como aspirantes. Esta base se combinó con la primera fuente, utilizando la CURP de los EC para realizar un pareo. Si bien la muestra no es estadísticamente representativa del universo de evaluadores, contiene información relevante que permite hacer una descripción de características académicas de los EC, así como de su trayectoria profesional.

La tercera fuente de información fue la recabada a partir de una encuesta realizada expresamente para esta investigación y que buscaba obtener información detallada acerca de las experiencias de los EC en el periodo de análisis. Se diseñó un cuestionario diagnóstico para conocer los puntos de vista, prácticas y percepciones de los EC desde el momento en que las figuras educativas consideraban la posibilidad de certificarse como evaluadores hasta que, una vez certificados, ejercían, o no, su labor de evaluadores. La encuesta se administró por las autoras desde la plataforma SurveyMonkey.2

Esta encuesta fue levantada del 7 al 14 de noviembre de 2017. Para ello, se envió una invitación al correo electrónico de los 4,271 EC (total de EC en 2017). El envío se realizó a través de SurveyMonkey desde un correo institucional de las autoras. Posterior al envió de la invitación, y transcurrida una semana, se enviaron recordatorios a aquellos que no hubiesen abierto el correo o a quienes dejaron incompleta la encuesta; con ello se logró una tasa de respuesta de 74% de la población de EC.

El análisis general se realizó exportando las bases de datos en formato de Excel al programa de análisis estadístico Stata 15 para la elaboración de cruces de información y análisis descriptivo. Se llevaron a cabo pruebas estadísticas para valorar la significancia de los resultados observados. Principalmente se emplearon dos pruebas. Por un lado, chi-cuadrada para observar si hay relación entre dos variables categóricas. Para esta prueba, se computa el valor Pearson y el valor asociado (p-value). Cuando el valor Pearson es distinto a cero, los resultados indican que no existe una relación estadísticamente significativa. Vale mencionar que la prueba de chi-cuadrada supone que el valor esperado de cada celda es cinco o más. Por ello, se realiza también una prueba Fishers, dado que para un caso de análisis se contaba con valores menores a cinco. Por otro lado, se aplica prueba de bondad de ajuste chi-cuadrada para probar si las proporciones observadas difieren de proporciones hipotéticas en donde, si el valor p es distinto a cero, se infiere que la composición en la muestra difiere significativamente de los valores hipotéticos que suministramos (UCLA, 2011).

La base de datos de la encuesta cuenta con información de 3 mil 168 evaluadores certificados. La Figura 1 muestra la tasa de respuesta por entidad federativa. Como puede observarse, hubo algunos estados con tasas de respuesta altas como Morelos, Tabasco y Yucatán con 82, 84 y 86%, respectivamente; por el contrario, las entidades con tasas de respuesta más bajas fueron los estados de Campeche (62%), Colima (60%) y Querétaro (59%).

Análisis de datos

La caracterización de los EC se presenta en tres aspectos: individual, profesional, así como de motivación y experiencia en funciones evaluativas. El perfil individual se compone de: a) entidad de procedencia, b) género y c) edad de los EC. Esta información corresponde al total de evaluadores certificados (2014 a 2017).

El perfil profesional de los evaluadores se construyó con: a) nivel educativo de la escuela donde labora, b) modalidad de la escuela donde labora, c) funciones que desempeña, d) escolaridad, e) años de experiencia en su función, f) resultados en la evaluación del desempeño docente (2015 y 2016). La información de los primeros tres incisos se obtuvo de la Encuesta con Evaluadores Certificados, en tanto que los tres últimos de la muestra de EC, con datos cotejados por el INEE.

Para construir el perfil de motivación y experiencia en funciones evaluativas se utilizaron las respuestas de los EC a la encuesta con evaluadores certificados realizada por las autoras. Las preguntas relacionadas con este aspecto fueron:

Razón principal que lo motivó a participar en la calificación de evaluaciones de desempeño.

Satisfacción con la labor realizada durante la calificación de las evaluaciones de desempeño.

Si fuera convocado nuevamente, ¿participaría en un proceso de calificación de la evaluación de desempeño?

¿Fue llamado a calificar los productos correspondientes a la función y el nivel en los que usted se certificó?

¿Qué tan preparado se sentía para participar en las jornadas de calificación de las evaluaciones?

Como evaluador certificado, ¿ha participado en algún proceso de evaluación distinto al del Servicio Profesional Docente?, ¿en cuál?

¿Cuáles son los efectos positivos a partir de convertirse en evaluador certificado?

¿Percibe alguna barrera que limite su futura participación como evaluador certificado?

Alcances y limitaciones

Las bases de datos utilizadas, tanto la que contiene una muestra de EC como aquella con los resultados de la encuesta con EC, no son estadísticamente representativas de la población total de estos evaluadores. Ello porque en la base con la muestra de EC, elaborada y proporcionada por el INEE, se utilizó un muestreo que no puede garantizar significancia estadística para la población total de individuos certificados. No obstante, contiene información relevante sobre la trayectoria y desempeño de los EC, información que no fue posible obtener mediante otra fuente.

Respecto de la encuesta de opinión con EC, y a pesar de la alta tasa de respuesta obtenida, no fue respondida por el universo de estos evaluadores. Con ello, existe la posibilidad de un sesgo de autoselección, pues la participación en la encuesta fue voluntaria.

Resultados: el perfil general de los evaluadores certificados

Perfil individual de los evaluadores certificados

La entidad con el mayor número de EC fue Veracruz, con 474, seguido por el Estado de México con 386 y Ciudad de México con 363 (Figura 2). Se requieren más exploraciones para explicar cuál es la razón de variaciones tan grandes en la representación de EC en las entidades. Sin embargo, una posible explicación tiene que ver con los distintos tamaños de los sistemas educativos estatales, las diferencias en los procesos de difusión de las convocatorias, así como las experiencias durante el proceso de certificación que vivieron los EC (Razo Pérez, Hernández-Fernández y De la Cruz Orozco, 2020).

Fuente: elaboración propia a partir de la base de datos completa de evaluadores certificados del INEE en 2017.

Figura 2 Porcentaje de evaluadores certificados por entidad federativa con respecto al total nacional en 2017

Con respecto a la participación por género, la mayoría, 63% aproximadamente (2,695), eran mujeres y 37% (1,576) hombres. Ello indica una tendencia de las mujeres a participar como evaluadoras y completar el proceso de certificación. Dicha diferencia es estadísticamente significativa identificada mediante la prueba de bondad de ajuste chi-cuadrada.3

Ahora bien, la mayoría de los EC tenían más de 30 años. Los grupos etarios con más evaluadores fueron los de 30 a 40 años, con mil 474 evaluadores (35%), y de 40 a 50 años, con mil 507 evaluadores (36%) (Figura 3). De esta manera, 70% de los EC tenían entre 30 a 50 años de edad. Una posible explicación es que los requisitos de las convocatorias para participar como EC apuntan una preferencia a que los aspirantes cuenten con experiencia en su cargo, por ello los grupos de edad referidos lograron cubrir, en mayor medida, los requisitos.

Fuente: elaboración propia a partir de la base de datos completa de evaluadores certificados del INEE en 2017.

Figura 3 Grupos etarios de los evaluadores certificados en 2017

Es importante mencionar que fueron muy pocos los evaluadores provenientes de los grupos de edad en los extremos, los más jóvenes y los de mayor edad: solo había 83 evaluadores (2%) que tenían menos de 20 años, lo cual puede relacionarse con que pocos cumplían con la experiencia considerada como necesaria por algunas entidades para ser validados con postulantes aceptables para EC.4 Asimismo, mil 47 tenían más de 50 años, es decir, 23% de la población total.

Perfil profesional de los evaluadores certificados

La Tabla 1 presenta el nivel educativo en el que laboraban los EC en 2017. El 60% de los evaluadores lo hacía en educación básica: de ellos, 8% en preescolar, 23% en primaria y 28% en secundaria; en educación media superior, mil 275 EC, que representaban 30% del total. Un 4%, de los EC en el ámbito nacional, seleccionaron la opción “no imparten nivel educativo”. Entre ellos se encontraban evaluadores que trabajaban en centros de maestros, inspecciones, coordinaciones, jefaturas, el Consejo Nacional de Fomento Educativo (CONAFE), el Instituto Nacional para la Educación de los Adultos (INEA), Misiones culturales y otras instancias. Asimismo, el 6% restante laboraba en educación especial e inclusiva, educación superior, escuelas de nueva creación y educación para adultos.

Tabla 1 Nivel educativo en que laboran los evaluadores certificados en 2017

| Nivel educativo en el que laboran | Población total | Porcentaje de representación |

|---|---|---|

| Educación preescolar | 358 | 8.45 |

| Educación primaria | 977 | 23.05 |

| Educación secundaria | 1197 | 28.24 |

| Educación media superior | 1275 | 30.08 |

| Centro de maestros, inspecciones, coordinaciones, jefaturas, CONAFE, INEA, Misiones culturales, otras | 153 | 3.61 |

| Educación especial e inclusiva | 116 | 2.74 |

| Educación superior | 63 | 1.49 |

| Escuelas de nueva creación (preescolar, primaria, secundaria, educación media superior y otras) | 54 | 1.27 |

| Educación especial e inclusiva (Centro de Atención Múltiple y otros) | 45 | 1.06 |

| Total | 4238 | 100.00 |

Fuente: elaboración propia a partir de la base de datos completa de evaluadores certificados del INEE en 2017.

Los EC en educación primaria se concentraban mayormente en la modalidad general de la educación: 79% tenía como área general principal la formación como docente y 14%, las Ciencias de la educación. Mientras que para la educación secundaria, 45% tenía como área general principal la formación docente y el resto una variedad de disciplinas. En educación media superior, la distribución la encabezaban evaluadores con área general principal de Ingeniería industrial, Mecánica, Electrónica y Tecnológica (17%), Negocios y administración (12%) y Ciencias de la computación (11%), áreas seguidas de Formación docente (5%), Ciencias físicas (25%) y Humanidades (30%).

Con respecto a las funciones educativas realizadas por los EC, la Tabla 2 muestra que 60% de los evaluadores eran docentes con plaza o contrato de base; seguidos por los directores de plantel con 13%, los supervisores con 7% y los asesores técnico pedagógicos (ATP) con 4%. Destaca una representación de actores educativos jubilados de 2% de los EC, lo que da cuenta de un grupo de profesionales que, a pesar de estar en retiro, se involucraron en actividades de evaluación y se reincorporan al sistema educativo.

Tabla 2 Funciones educativas de los evaluadores certificados en 2017

| Funciones | Porcentaje de participación |

|---|---|

| Apoyo a la educación especial | 0.30 |

| Asesoría y apoyo pedagógico a docentes, ATP o funciones análogas | 4.53 |

| Coordinador académico o coordinador de área | 1.63 |

| Director con grupo | 1.05 |

| Director con plantel | 12.93 |

| Docente con contrato temporal | 0.45 |

| Docente con funciones directivas | 2.83 |

| Docente con plaza o contrato base | 59.97 |

| Especialista (educación especial) | 1.21 |

| Formador de docentes | 0.60 |

| Jefe de enseñanza | 0.84 |

| Jubilados | 2.16 |

| Maestro de apoyo (educación especial) | 0.90 |

| Subdirector | 2.74 |

| Supervisor | 7.41 |

| Técnico docente | 0.42 |

| Trabajador social (educación especial) | 0.03 |

| Total | 100.00 |

Fuente: elaboración propia a partir de la base de datos completa de evaluadores certificados del INEE en 2017.

La encuesta con EC arrojó que 100% de los respondientes realizaban su función principal de tiempo completo; mil 362 evaluadores (32% de la población) tenían alguna adicional a su función principal de tiempo completo. Además, poco más de 8% de la población total de los EC tenía al menos dos empleos de tiempo completo. Este hecho resultó destacable en vista de las cargas adicionales de trabajo que generaba ser evaluador certificado.

En cuanto a la escolaridad de los EC, la base de datos conformada por una muestra de aspirantes y evaluadores construida por el INEE arrojó que más de 79% tenía estudios superiores a la licenciatura. Alrededor de 44% de los evaluadores contaba con maestría concluida, mientras que 16% tenía o estaba realizando un doctorado. Solo 1% de los EC contaba con estudios de licenciatura incompleta. Lo anterior informa de una población de evaluadores altamente escolarizada y sugiere una asociación entre grado de preparación académica con propensión a participar como EC.

Al analizar la información relacionándola con la convocatoria en la que se certificaron los evaluadores, la Figura 4 muestra ciertas diferencias significativas entre los dos años de certificación, identificadas mediante pruebas chi-cuadrada. Por ejemplo, la generación de 2014 tenía un porcentaje mayor de EC con nivel de doctorado (22%) respecto de la de 2015 (14%) (Pearson chi2(1)= 0.000; Pr= 0.000). Si se comparan los EC con nivel de maestría, siguen siendo los de 2014 los que tenían una mayor proporción: 60% en contraste con 57% de la generación 2015 (Pearson chi2(1)= 0.000; Pr= 0.001).

Fuente: elaboración propia con la base datos muestra de evaluadores certificados y aspirantes elaborada por el INEE.

Figura 4 Escolaridad de los evaluadores certificados en el periodo 2014-2016 (porcentaje)

Por el contrario, para el nivel de especialidad, los EC de 2015 tenían mayor porcentaje de representación, con 5%, comparado con 3% de los evaluadores en la generación 2014. Por último, para nivel de licenciatura los de la convocatoria 2015 contaban con una representación de 24%, comparado con 14% de los EC en 2014.

En relación con la experiencia de los EC se observa que cerca de la mitad de la población (48%) se constituía por trabajadores de la educación con menos de 10 años de experiencia en su ocupación principal.

La Figura 5 presenta algunas diferencias significativas en años de experiencia según la cohorte de certificación mediante prueba Fisher (variante de chi-cuadrada) y muestra que quienes se certificaron en 2016 tenían, en promedio, más años de experiencia que los evaluadores certificados en años anteriores.5 Ello se observó claramente con la diferencia en la proporción de EC que tenían entre 11 y 15 años de experiencia.

Fuente: elaboración propia con la base datos muestra de evaluadores certificados y aspirantes elaborada por el INEE.

Figura 5 Años de experiencia en función principal de los evaluadores certificados (porcentaje)

En cuanto a los resultados de los EC en su evaluación del desempeño, una cantidad considerable cumplía con todos los requisitos, incluida la suficiencia en la EDD. Sin embargo, poco menos de la mitad de los evaluadores en 2014 (370 de los 840 que cuenta la muestra, 44%) cumplía con todos los requisitos necesarios. En 2015, esta proporción fue mayor (1,606 de 2,017: 77%). No se contó con información para obtener conclusiones sobre los EC en 2016 (Figura 6).

Nota: el porcentaje sin evaluación fue calculado con respecto al total de evaluadores por convocatoria. El porcentaje de EC que se ubica en cada nivel de desempeño fue calculado con respecto al total de evaluadores de cada convocatoria que contaban con evaluación del desempeño al momento de la elaboración de la base en 2017. Los datos de 2016 no estuvieron disponibles.

Fuente: elaboración propia con la base datos muestra de evaluadores certificados y aspirantes elaborada por el INEE.

Figura 6 Resultados en la evaluación del desempeño de los evaluadores por año de certificación

De los EC en 2014, un total de mil 988 presentaron evaluación del desempeño y 12, evaluación de desempeño con trato de competencias (jubilados). De ellos, cerca de 85% obtuvo calificación de al menos nivel suficiente, mientras que el 15% restante, insuficiente. Por nivel educativo, para los EC que laboraban en primaria, 99% tuvo calificación de al menos suficiente y en secundaria casi un 100%; en media superior, 97% la obtuvo de al menos suficiente.

De las mil 958 observaciones para las cuales existía el dato sobre el nivel de aprovechamiento en la EDD, destaca lo siguiente. En primer lugar, 48% de los evaluadores estaba, en cuanto a su aprovechamiento, en el grupo “destacado” y cerca de 9% en el de “sobresaliente”. Ello contrasta con lo reportado por el Servicio Profesional Docente, respecto de que solo 7% de los docentes en el ámbito nacional obtuvo un resultado “destacado” en la EDD (CNSPD, 2017b).

El volumen de EC en el periodo analizado estuvo conformado por docentes con los niveles más altos de desempeño, ya que 77.4% obtuvo calificaciones en los niveles bueno, destacado y excelente. Más aún, en casi todas las entidades, los EC lograron en su mayoría calificaciones de los niveles “destacado” (45% en promedio) y “bueno” (49% en promedio): las únicas excepciones fueron Chihuahua, Tamaulipas, Chiapas, Guanajuato, Zacatecas, Sonora, Morelos, Baja California y Baja California Sur. Cabe destacar que estos estados no tenían la mayor cantidad de evaluadores, por lo que las calificaciones del volumen de EC se mantuvieron altas.

De igual modo, es importante destacar que la proporción de los evaluadores certificados en el grupo de desempeño “destacado” era menor conforme aumentaba su edad. Así, por ejemplo, la proporción de los evaluadores de este grupo y edad entre 20 y 30 años era de 53%, en tanto que aquellos con más de 50 años representaban 33%. Contrasta la proporción de los evaluadores en el nivel de desempeño más bajo permitido (“suficiente”): 9% de los mayores de 50 años estaba en este grupo, mientras que 0.6% de los menores de 30 años pertenecía al mismo.

En cuanto al nivel de estudios de los evaluadores, los resultados fueron contra intuitivos, ya que eran aquellos con especialidades completas, y no los que contaban con estudios de maestría y doctorado, los que integraron un grupo más grande de EC ubicados en los niveles de “excelente” y “destacado”. Aquellos con solo licenciatura completa eran los que tenían menor proporción de estudiantes en esos grupos.

Igualmente destaca que los EC con funciones de docentes obtenían mejores calificaciones en sus evaluaciones del desempeño: 52% con resultados en el grupo “destacado” y casi 10% en “excelente”. En tanto que de las figuras directivas solo 15% estaba en uno u otro de estos grupos, y 63% en el de “bueno”.

Los supervisores representan un caso interesante, ya que 63% de los EC estaba en el grupo de desempeño “destacado”, y el resto en la clasificación de “insuficiente”, lo que incluso contravenía los requisitos.

Perfil de motivación y experiencia en evaluación

La Tabla 3 muestra las respuestas de los EC a la pregunta sobre la razón principal por la que decidieron participar, 74% destacó la “posibilidad de desarrollo profesional (adquirir experiencia y desarrollar nuevas habilidades)” y, en segundo lugar, seleccionaron “oportunidad de aplicar sus conocimientos y habilidades al campo de la evaluación educativa”, con 52%. Observando los resultados por género, resaltó que no existían diferencias en las proporciones (utilizando prueba de chi-cuadrada: Pearson chi2(2)= 4.5765; Pr = 0.101). De tal manera, tanto mujeres como hombres identificaron el desarrollo profesional como mayor incentivo a participar y, en mucha menor medida, el que “la función de calificar las evaluaciones es valorada por las autoridades educativas federales”, con menos de 1% de respuestas.

Tabla 3 Motivaciones de los evaluadores certificados

| Razones para participar como EC | Porcentaje |

|---|---|

| Remuneración económica | 9.15 |

| Oportunidad de aplicar mis conocimientos y habilidades al campo de la evaluación educativa | 51.60 |

| Posibilidad de desarrollo profesional (adquirir experiencia y desarrollar nuevas habilidades | 74.22 |

| Oportunidades de mejorar mis condiciones laborales | 5.83 |

| Oportunidad para contribuir al fortalecimiento de la cultura de la evaluación | 28.56 |

| Prestigio social que me reporta el desempeño de esta labor | 1.20 |

| La función de calificar las evaluaciones es valorada por las autoridades educativas federales | 0.46 |

| La función de calificar las evaluaciones es valorada por las autoridades educativas locales | 0.85 |

| Satisfacción personal | 18.80 |

Fuente: elaboración propia con base en datos de la encuesta para evaluadores certificados 2017.

Destaca también que solo 9% de los EC seleccionaron la opción “remuneración” como la principal motivación para certificarse. Es importante mencionar que la encuesta ofrecía a los respondientes dos opciones. De tal manera que algunos optaron solamente por (30%), mientras que el resto seleccionó dos principales motivaciones. Por esta razón, los porcentajes que presenta la Tabla 3 no suman 100%.

Otras respuestas a la encuesta dan muestra de que 80% de los EC reportaron sentirse muy satisfechos con la labor que realizaron durante las jornadas de calificación de las evaluaciones de desempeño y 90% indicó que definitivamente volvería a participar como evaluador. También la mayoría percibió que los efectos positivos de convertirse en evaluador del desempeño eran “el fortalecimiento de la cultura de la evaluación” y “una aportación a la mejora educativa” (72 y 75% de los respondientes, respectivamente). Fueron pocos los que identificaron efectos positivos para sí mismos. El mayor beneficio personal que señalaron fue un incremento en sus ingresos; 10% seleccionó esta opinión.

Respecto de la pregunta de haber evaluado a pares de acuerdo con el nivel y función para el que se certificaron, 97% de los encuestados respondió haberlo hecho así. Además, 83% de los EC expresaron haberse sentido totalmente preparados para desempeñarse como evaluadores una vez que fueron invitados a participar en una jornada de evaluación; 17% se sintió medianamente preparado y solo 0.19 y 0.08% poco o nada preparado, respectivamente.

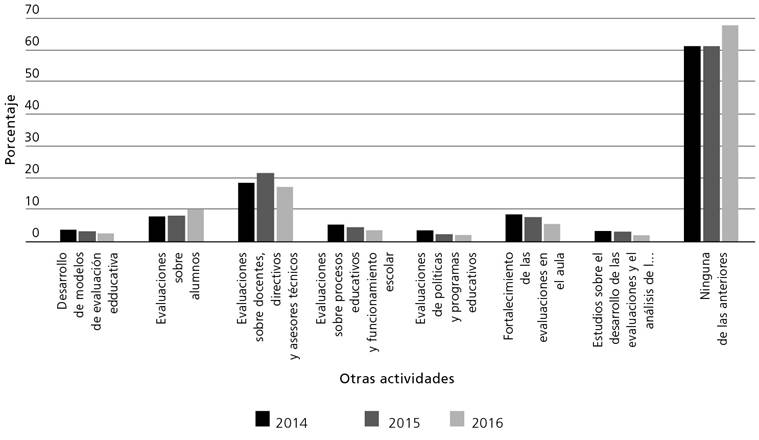

En cuanto a la participación en otros procesos de evaluación, distintos a la EDD, la Figura 7 da cuenta de que solo 20% de los EC para los cuales se tiene información en la muestra de evaluadores certificados 2017 refirió haber participado en otro tipo de acciones evaluativas. Sin embargo, la muestra sugiere que 49% tenía formación en algún otro tipo de evaluación; de ellos 83% contaba con experiencia en evaluación del aprendizaje y 86% tenía formación en evaluación docente.

Fuente: elaboración propia con base en datos de la encuesta para evaluadores certificados 2017.

Figura 7 Otras actividades de evaluación realizadas por los evaluadores certificados según año de certificación

Cabe destacar que 41% tenía experiencia previa en evaluación; de ellos, 75% en la correspondiente al aprendizaje y 38% en la de desempeño. En agregado, 31% tenía formación y experiencia en algún campo de la evaluación. Entonces, si bien una cantidad importante de los EC tenía formación y experiencia previa en la evaluación; en realidad eran menos los que habían tenido experiencias en la valoración de otros docentes.

Conclusiones

Esta investigación delinea el perfil -personal, profesional y experiencia evaluativa- de los participantes en el primer proceso de EeP que se realizó en México.

Los resultados dan muestra de un perfil individual de EC que, en promedio, residía en Veracruz (11%), Estado de México (9%) o Ciudad de México (8%), era un actor educativo con menos de 40 años (41%), trabajaba en educación básica (60%) y que, en su gran mayoría, era mujer (63%).

En cuanto al perfil profesional, el evaluador tenía estudios superiores a la licenciatura, ya sea una especialidad o de maestría. El EC promedio tenía formación en algún tipo de evaluación; sin embargo, no contaba con experiencia previa en la evaluación docente.

Respecto del perfil de motivación a participar en labores evaluativas, al EC promedio le impulsaba la posibilidad de desarrollarse profesionalmente; solo un pequeño porcentaje (9%) dijo participar motivado por una remuneración económica.

Los hallazgos del artículo son importantes en la investigación educativa no solo por ser los primeros en su tipo, o por provenir de información recabada directamente con los evaluadores pares; sino porque proporcionan evidencia de las características de los actores educativos que participaron en el primer ejercicio de EeP en México. Los hallazgos también son relevantes por otras razones. Primero, los datos reflejan la complejidad de implementar reformas en un sistema tan grande y diverso como el mexicano. La concentración de la mayoría de los EC en tres entidades en particular sugiere que el tamaño y las capacidades de los sistemas educativos estatales son elementos clave a considerar cuando se diseñan e implementan reformas educativas.

Segundo, los hallazgos sobre el perfil profesional dan cuenta de que cada nivel educativo contaba con proporciones similares de EC, salvo el preescolar, el CONAFE y educación especial e inclusiva. Este dato invita a una reflexión sobre cómo las reformas educativas siguen implementándose con importantes diferencias entre niveles y modalidades escolares, algunos considerados servicios regulares y otros compensatorios. En futuros estudios será importante analizar las razones y repercusiones de que las reformas educativas continúen dejando en el margen a modalidades, servicios y niveles educativos que requieren atención prioritaria.

Tercero, los hallazgos aquí presentados constituyen uno de los pocos registros sistematizados de una práctica evaluativa que ha dejado de existir. Como ya se ha apuntado, las reformas educativas suelen ser de corto plazo y pocas veces se cuenta con evidencia sobre su implementación antes de ser sustituidas. Estos resultados dan cuenta de las características de los participantes en una reforma educativa que, por primera vez, incluyó la EeP. Ahora sabemos que este grupo de evaluadores pares, a pesar de trabajar tiempo completo, quiso usar su experiencia, de entre 5 y 10 años, así como sus habilidades y sus conocimientos -tanto del contexto como de la práctica docente- para valorar el desempeño de sus pares. Asimismo, declaraban su voluntad para seguir participando como evaluadores pares en futuras convocatorias. En estudios posteriores será relevante conocer en qué medida estos actores y su experiencia fueron aprovechados.

Discusión

El perfil presentado en este artículo sobre el evaluador par en México debe analizarse considerando siempre el contexto en el que se diseñó y se implementó. La forma específica que tomó la EeP en México difiere de las que se han implementado en otros países. Mientras que en otros países se articula realizando entrevistas u observaciones de clase (Assaél y Pavez, 2008), aquí se constituyó como una etapa de la evaluación que determinaría la permanencia de trabajadores de la educación. La labor de los EC en México se concentró en valorar evidencias del trabajo de pares a través de una computadora, sin visitar los contextos escolares o a través de un diálogo con quienes se estaban evaluando.

Los hallazgos de este artículo complementan la literatura que establece los parámetros deseables con que deben contar estos actores a través de un punto de contraste con la realidad. Es posible afirmar que el perfil de los evaluadores pares, conocidos en México como EC, sí se apegaban a los parámetros que establecían las convocatorias. La única excepción fue con los supervisores que no habían presentado la evaluación de desempeño y fungieron como evaluadores pares.

El perfil de EC que se presenta en este artículo constituye un primer paso hacia el análisis integral de la evaluación docente en México. Ello excluye un análisis del ejercicio evaluativo de estos actores (recuento de su desempeño en las jornadas de calificación) y difiere de una valoración del sistema nacional de evaluación del desempeño, del cual la EeP era una sola etapa. Tampoco se elabora una evaluación del diseño o de resultados sobre la política de EeP. Estos temas se alejan del propósito de este artículo, aunque son, sin duda, aspectos por explorar para tener una visión completa del trabajo de los EC en México.

Por último, si bien el marco normativo que originó la EeP ha desaparecido, los nuevos lineamientos apuntan a una evaluación formativa en la que el trabajo, experiencia y disposición de los evaluadores pares podría aprovecharse. Así, los hallazgos de este artículo son relevantes para un posible rediseño de la evaluación docente en México.

nueva página del texto (beta)

nueva página del texto (beta)