Introducción

En la docencia, el método de evaluación es una cuestión fundamental pues, en teoría, debe reflejar el grado de consecución de los objetivos que se han fijado con respecto al contenido de la asignatura impartida, así como otra serie de competencias que el alumnado debe haber adquirido.

En muchas ocasiones se plantea en el ejercicio diario de la enseñanza universitaria que existen incoherencias entre lo que el profesor percibe en clase sobre el aprendizaje que va llevando a cabo el alumnado, y los resultados finales que obtiene y que se reflejan en una calificación final.

A través del proceso de implementación del Espacio Europeo de Educación Superior (EEES) se han incorporado otras técnicas de evaluación que introducen el concepto de continuidad en el proceso de formación y aprendizaje. Se supone que en la universidad española ha quedado atrás el tradicional sistema limitado a un único examen final. Así, se debe realizar una evaluación continua, para conseguir que esté orientada al aprendizaje, o formativa, con independencia de que se vayan sumando notas para luego obtener la calificación global de la asignatura.

No obstante, los antecedentes empíricos en la materia destacan que aún queda camino por recorrer en la universidad española para conseguir implantar este tipo de evaluación en la práctica. En teoría, se debería contar con un sistema mixto, en el que un porcentaje de la nota se obtenga de pruebas de evaluación continua, y otro provenga del examen final. Una característica fundamental de este proceso continuo es que se establece una retroalimentación o feedback entre profesor y estudiante, modelando su forma de estudiar, llevando a un aprendizaje continuo y entrenándolo también para el examen final.

También en teoría, se supone que esta evaluación es deseable porque tiene unos efectos positivos sobre el rendimiento académico del alumnado, de manera que se concreten en una mejor nota final de la asignatura.

Nuestra experiencia docente en la asignatura de Contabilidad financiera y el hecho de contar ya con suficientes datos para plantearnos realizar un estudio empírico, nos lleva a querer comprobar en qué medida la evaluación continua ha afectado a la nota final del estudiantado, y si efectivamente conlleva mejores resultados en el examen final. Por ello analizamos las notas obtenidas en esta última prueba, en la evaluación continua y la calificación global de la asignatura. De ahí que hayamos recopilado durante los últimos cuatro cursos académicos consecutivos 584 notas, obtenidas en un grupo de primer curso del grado en Administración y Dirección de Empresas (ADE) en las asignaturas de Contabilidad financiera de la Universidad de Murcia. Pretendemos estudiar cómo ha afectado la evaluación continua al examen final y a la calificación de la asignatura. A su vez, estas 584 notas se triplican, al contar en cada caso con la nota del examen final, la de la evaluación continua y la calificación global de la asignatura, con lo que hemos trabajado finalmente con 1,752 observaciones.

El trabajo lo estructuramos de la siguiente manera: en el próximo apartado destacamos los antecedentes sobre la materia; después describimos la muestra estudiada, la metodología y las hipótesis planteadas, detallando las distintas pruebas estadísticas e indicadores utilizados; a continuación, exponemos los resultados obtenidos, para terminar con las conclusiones que nos permite resaltar nuestro estudio.

Antecedentes

En la docencia, el proceso de evaluación es importante para el profesor, pues debe plasmar en una calificación el grado de consecución de unos objetivos de aprendizaje (Trotter, 2006).

A partir de los años ochenta y hasta nuestros días, con la implantación del EEES, la evaluación ha evolucionado desde la tradicional en el aula universitaria, el examen final, hasta el proceso continuo en el que se prima el aprendizaje permanente (Palacios Picos, 2004). Tradicionalmente “evaluar” era poner una nota final al alumno, pero no una tarea (Trigueros Cervantes, Rivera García y De la Torre Navarro, 2012:480): “cuyo objetivo es la valoración del proceso de enseñanza y aprendizaje llevado a cabo”.

La evaluación se debe configurar como un proceso (Alcaraz, Fernández Navas y Sola, 2012:27): “fundamentado en la recogida de información útil, relevante y que sirva para emprender espacios de mejora en los procesos de enseñanza-aprendizaje”. Y ha sido una de las cuestiones que más se ha visto afectada por la implantación en España del EEES (San Martín Gutiérrez, Jiménez Torres y Jerónimo Sánchez-Beato, 2016:8). Se trata de enseñar, de llevar a cabo un proceso de aprendizaje, más que de medir (Carless, 2007).

Asimismo, el método de evaluación puede condicionar sobremanera al alumno, pues dependerá de él cómo enfoca su estudio o dedicación a la asignatura en cuestión (Crooks, 1988). Existen antecedentes que demuestran que se entrena para un tipo de prueba de evaluación, con independencia de si domina o no la materia (Gibbs y Simpson, 2004).

Aunque todos los antecedentes distinguen entre evaluación formativa y sumativa, se llega a la conclusión de que no tienen por qué ser mutuamente excluyentes, sino que en la actualidad, como consecuencia de la introducción de la evaluación continua en la enseñanza universitaria, se realiza una mezcla de ambas. Al dar al alumno información sobre su aprendizaje, y a la vez obtener la nota final como suma de notas, se están mezclando las características básicas de la evaluación formativa y la sumativa (Yorke, 2003).

A su vez, dentro de la evaluación formativa podemos encontrar dos modalidades, la formal y la informal. En la primera se plantea un marco de pruebas prediseñado, de manera que los alumnos van contando con distintas notas, mientras que en la informal se va realizando esta evaluación durante el curso, pero no está específicamente detallada en el marco curricular.

Anteriormente, al realizar en los estudios universitarios un único examen final, no se aplicaba el sentido formativo de la evaluación, ya que no se cumplía con su característica principal: contribuir al aprendizaje del alumno a través del suministro de información sobre cómo va progresando (Yorke, 2003) y, por lo tanto, este solo estudiaba cuando se acercaba la fecha del examen final, con los consiguientes malos resultados (McDowell et al., 2007:4). Además, reducir las pruebas a una sola implica que no se puede dar cabida a la gran diversidad de estudiantes que deben ser evaluados (Gibbs y Simpson, 2004). Por ejemplo, centrar la evaluación en una prueba escrita, puede discriminar a aquellos con pocas habilidades para la escritura o algún tipo de dislexia (Isaksson, 2008).

La realización de pruebas intermedias en una evaluación continua se configura como un feedback que se va dando al alumno, de manera que pueda ir enfocando mejor su aprendizaje, lo que es fundamental para una evaluación formativa (Black y William, 1998). Aunque también existen inconvenientes a este retorno continuo de resultados al estudiante: puede ser “vulnerable a sentir un fracaso personal” (Yorke, 2003:489); generar una sobrecarga de evaluación y ansiedad sobre las notas que se van consiguiendo (Hernández, 2012); o incluso no animar a aprender, sino dar lugar a medidas del fracaso (Wootton, 2002).

La convergencia entre las universidades europeas ha llevado a la aplicación de un sistema de evaluación mixto (San Martín Gutiérrez, Jiménez Torres y Jerónimo Sánchez-Beato, 2016:8-9). Este supone que la nota de la asignatura va a estar compuesta por la de la evaluación continua y la del examen final, tal y como será el caso que nos ocupa en este trabajo con respecto a la asignatura de Contabilidad financiera. Se debería dejar el recurso de la tradicional evaluación a través del examen final, solo para aquellos alumnos que no asisten regularmente a clase, o los que no han realizado las pruebas intermedias previstas en la evaluación continua (San Martín Gutiérrez, Jiménez Torres y Jerónimo Sánchez-Beato, 2016:9); de otra manera, el sistema mixto les estaría penalizando.

Los antecedentes sobre la materia que han realizado estudios empíricos se han basado principalmente en la realización de encuestas y entrevistas, tanto a alumnos como a profesores. Este es el caso de Hernández (2012), que concluye que la evaluación continua tiene el potencial de servir de apoyo y motivación para el aprendizaje de los alumnos, pero para ello el docente debe dar la conveniente retroalimentación, sobre las pruebas que se vayan realizando, en tiempo y forma. Trotter (2006) afirma que aunque la evaluación continua es más trabajosa para el profesor, la función costo-beneficio resulta positiva en cuanto al aprendizaje que perciben los estudiantes; en el mismo trabajo, el autor puntualiza que se basa en dicha percepción y no en los datos sobre notas.

Otra línea de investigación, a partir del EEES, se basa en el análisis de las guías docentes de las asignaturas para analizar los sistemas de evaluación, concluyendo que el examen final sigue siendo clave, pues no es (San Martín Gutiérrez, Jiménez Torres y Jerónimo Sánchez-Beato, 2016:7): “mayoritaria la aplicación del sistema de evaluación continua” y “se emplean poco las nuevas tecnologías en el proceso de evaluación”. También a partir del análisis de las guías docentes, junto con entrevistas a profesorado y alumnado, Castejón y Santos (2011) concluyen que en cuanto a la metodología participativa en clase y la utilización de sistemas de evaluación formativa, no concuerdan lo que se establece a priori con lo que luego se hace en la práctica.

En una primera línea de trabajos que subrayan el efecto positivo de la evaluación formativa sobre el rendimiento académico, podemos citar el de Cano (2011), que estudia las notas obtenidas por más de 750 estudiantes durante siete cursos académicos, concluyendo que la evaluación continua aumenta el número de aprobados, así como mejora las notas obtenidas. El modelo implementado con el EEES lleva a la creación de una Red Interuniversitaria de Evaluación Formativa y Compartida en la Docencia Universitaria, que ya ha realizado distintas pruebas empíricas con datos obtenidos en las aulas. En ella resaltan que “estos sistemas de evaluación parecen ser muy útiles en la mejora del rendimiento académico del alumnado y en la disminución de las tasas de fracaso y abandono en los estudios superiores” (López-Pastor, 2011:167). Parkes (2010) también subraya el efecto positivo de los rendimientos académicos cuando se emplean técnicas de evaluación basadas en una retroalimentación continua. Aunque no realiza un estudio empírico propiamente dicho, analiza los antecedentes sobre la materia en el campo de la enseñanza universitaria de música. Isaksson (2008) sí obtiene una relación positiva estadísticamente significativa entre las notas y el tiempo que los estudiantes están en el curso, y por lo tanto se someten a evaluación continua. Inda, Álvarez González y Álvarez Rubio (2008) también utilizan distintos tipos de sistemas evaluativos para conocer cuál es el que más incide en los resultados de los alumnos, destacando finalmente que las metodologías más innovadoras, frente al examen tradicional, llevan a mejores resultados. El trabajo de Fraile, López-Pastor, Castejón y Romero (2013) también concluye que el rendimiento académico mejora cuando se usa el sistema continuo únicamente, o el mixto, porque conllevan un mejor proceso de aprendizaje, con respecto a la única vía del examen final.

En cambio, Poza-Luján, Calafate, Posadas-Yague y Cano (2016) cuantifican el “sobre costo” que supone para el docente la evaluación continua, entre otros sistemas, y su efecto en la nota de los estudiantes, llegando a la conclusión de que utilizar este tipo de evaluación no tiene un impacto significativo en las calificaciones. Crisp (2007) también analiza las notas y el efecto que parece tener sobre ellas la evaluación continua, pero la muestra es solo de 51 alumnos, y no puede concluir que el hecho de dar esa retroalimentación mejore las calificaciones.

En muchos de los trabajos sobre la materia se ponen de manifiesto diversas condiciones de la educación universitaria, que suponen inconvenientes para la evaluación continua (Yorke, 2003:483). Una es la posible mayor carga de trabajo para los académicos, que deben suministrar esa retroalimentación al estudiante y que luego no tiene impacto en su aprendizaje (Hernández, 2012). También las horas que los docentes emplean en esta evaluación son una pérdida de tiempo, según Crisp (2007), ya que los estudiantes no prestan atención a lo que se les dice sobre los errores cometidos, y su nota no va evolucionando porque no utilizan dicha retroalimentación para aprender. Además, el número de alumnos en el aula universitaria excede con creces al deseable para dar un correcto feedback.

Esto supone un trabajo extra para los profesores que al final tienden a fijar pruebas de evaluación sencillas de preparar y también de corregir, lejos de ser imaginativas o innovadoras (Gibbs, 2006). Gibbs y Simpson (2004:10) se plantean si “merece la pena el coste de la evaluación continua que soporta el docente”. Según Poza-Luján et al. (2016) el esfuerzo que tiene que realizar el profesor con la evaluación continua no tiene un impacto significativo en las notas. Aunque en este sentido también existen trabajos como el de Arquero y Donoso (2013), que concluyen que el síndrome de “quemarse por el trabajo” en los profesores universitarios viene más de su labor en investigación y no de la propia docencia.

Para el caso concreto que nos ocupa, que se centra en la asignatura de Contabilidad financiera, encontramos antecedentes como el de Sánchez-Martín, Pascual-Ezama y Delgado-Jalón (2017), en el que si bien analizan resultados académicos de los alumnos, además del proceso de evaluación acumulativo previo a la calificación final, lo hacen desde la perspectiva de la información de la que disponen los estudiantes. Concluyen que, cuando estos están mejor informados sobre el proceso de evaluación realizan un mayor esfuerzo y, por lo tanto, obtienen mejores resultados académicos. Pascual Ezama, Camacho Miñano, Urquía Grande y Müller (2011) también realizan un análisis empírico a partir de las notas de una muestra de alumnos de la asignatura de Contabilidad financiera y comprueban que existe correlación positiva entre las notas obtenidas en las pruebas de evaluación continua y la del examen final. Resaltan que se debería revisar este nuevo método, consecuencia del EEES, pues no permite a los estudiantes con mejores notas en el examen final obtener una mejor calificación si no lo han demostrado previamente a través de las pruebas intermedias. Jareño Cebrián y López García (2015) estudian los resultados de nueve asignaturas obligatorias en el grado en Administración y dirección de empresas, entre las que se encuentran las de Análisis contable y Contabilidad de costes, y también destacan la correlación positiva entre las calificaciones de la evaluación continua y la obtenida en el examen final. Según ellos, la nota global en la asignatura es mayor con este sistema, que si solo se hubiera tenido en cuenta la del examen final. Como datos más concretos de su estudio podemos destacar que “el porcentaje de aprobados como resultado de la evaluación continua calificativa supera notablemente al de suspensos -solo hay una asignatura en la que el porcentaje de estudiantes que suspenden (7% aprox.) supera al de aprobados (4% aprox.)” y que “el número de asignaturas en las que los estudiantes obtienen una calificación final (CF) mayor a la prueba final (PF) es mayor que el número de asignaturas en las que CF= PF o CF< PF” (Jareño Cebrián y López García, 2015:250 y 251).

Método

Muestra

Con objeto de analizar cómo ha afectado la evaluación continua a la nota final de los alumnos universitarios, recabamos las calificaciones obtenidas en los últimos cursos académicos disponibles, es decir: 2012-2013; 2013-2014; 2014-2015; y 2015-2016, en las asignaturas de Contabilidad financiera de un grupo de primer curso del grado en ADE de la Universidad de Murcia. Esto nos llevó a contar finalmente con una muestra de 584 notas (Tabla 1).

Tabla 1 Características de la muestra

| Curso académico | Asignatura y cuatrimestre | Convocatoria | Núm. pruebas parciales | ||||

|---|---|---|---|---|---|---|---|

| Núm. notas | Núm. notas | Núm. notas | Núm. notas | ||||

| 2012-13 | 132 | Contabilidad financiera I (2344) 1er cuatrimestre | 297 | 1 | 403 | 2 | 196 |

| 2013-14 | 126 | Contabilidad financiera II (2351) 2º cuatrimestre | 287 | 2 | 115 | 3 | 161 |

| 2014-15 | 130 | Total notas | 584 | 3 | 66 | 4 | 227 |

| 2015-16 | 196 | Total notas | 584 | Total notas | 584 | ||

| Total notas | 584 | ||||||

Elaboración propia.

Variables

Nuestra variable dependiente será la nota del examen final (NotaEF), que era la global de la asignatura antes de que se introdujera el concepto de evaluación continua en la Universidad de Murcia. Esta variable toma valores de 0 a 10.

En nuestro caso, el examen final representa 70% de la nota final, por encima de la media de 52%, que se obtiene en su trabajo San Martín Gutiérrez, Jiménez Torres y Jerónimo Sánchez-Beato (2016). El 30% restante se obtiene de la evaluación continua, tal y como se recoge en la memoria del grado y en la guía docente. La nota de las distintas pruebas de evaluación continua se mantiene para todas las convocatorias incluidas en la misma matrícula de la asignatura.

Como variable explicativa consideramos la nota de la evaluación continua (NotaEC), que toma valores de 0 a 10. Esta se obtiene, a su vez, de las notas de una serie de pruebas intermedias, que tienen una calificación y un porcentaje sobre la nota final, el detalle al respecto se incluye en la Tabla 2.

Tabla 2 Pruebas de evaluación continua

| Curso académico | Número de pruebas | Tipo de pruebas |

|---|---|---|

| 2012-13 | 2 | Prueba tipo test (20%) |

| Prueba de resolución de supuestos prácticos (10%) | ||

| 2013-14 | 4 | Prueba tipo test (10%) |

| Tarea sobre una charla de asistencia obligatoria incluida en el Plan de Acción Tutorial de la Facultad de Economía y Empresa (5%) | ||

| Prueba de resolución de supuestos prácticos (10%) | ||

| Prueba tipo test a realizar en el campus virtual (5%) | ||

| 2014-15 | 4 | Prueba tipo test (10%) |

| Tarea sobre una charla de asistencia obligatoria incluida en el Plan de Acción Tutorial de la Facultad de Economía y Empresa (5%) | ||

| Prueba de resolución de supuestos prácticos (10%) | ||

| Prueba tipo test a realizar en el campus virtual (5%) | ||

| 2015-16 | 3 | Prueba tipo test (10%) |

| Prueba de resolución de supuestos prácticos (15%) | ||

| Prueba tipo test a realizar en el campus virtual (5%) |

Elaboración propia.

Existe cierta flexibilidad a la hora de calificar este 30%, introduciendo distintas pruebas intermedias en el cuatrimestre. De ahí que hayamos recogido también el dato del número de estas pruebas que se han valorado en cada curso académico, ya que las mismas han cambiado, al intentar el docente buscar que la evaluación continua sea útil a la hora de conseguir el objetivo final de aprobar la asignatura (Crisp, 2007:579). Se persigue facilitar un aprendizaje continuo de la misma y, que un alumno que ha aprobado el examen final no obtenga una peor nota o un suspenso en la asignatura, como consecuencia de las calificaciones de la evaluación continua, ya que en este caso esta modalidad estaría penalizando a la nota final de la asignatura. En este sentido, Delgado y Oliver (2006) abogan claramente por la conveniencia de cambiar las pruebas de evaluación continua todos los periodos lectivos, por el enfoque práctico de las pruebas realizadas y por el hecho de que el diseño de las actividades de evaluación, y por lo tanto del número de pruebas, es un elemento clave de la modalidad continua.

Además, también se incorporan las nuevas tecnologías para la realización de alguna de las pruebas de evaluación continua, tal y como recomiendan algunos autores (Gibbs, 2006; Gibbs y Simpson, 2004).

Por otra parte, hemos incluido como variables de control los siguientes indicadores:

Número de pruebas parciales (PEC). Recoge el número de pruebas de evaluación continua realizadas en cada curso académico (ver Tabla 2).

Asignatura (Asign). Las enseñanzas de Contabilidad financiera en primer curso del grado en ADE se dividen en dos asignaturas: Contabilidad financiera I y II, que se imparten en el primer y segundo cuatrimestres, respectivamente. Cada una tiene su código, por lo que las identificaremos como 2344 (I) y 2351 (II). De este modo, tenemos una variable dicotómica que toma valor 0 para la asignatura I, y de 1 para la II.

Convocatoria (Conv). Cada asignatura cuenta con tres convocatorias de exámenes distintas que, dependiendo del cuatrimestre en el que se imparta, serán cronológicamente la primera, segunda o tercera para cada una. De ahí que para la asignatura 2344, la primera sea la de enero/febrero, la segunda de junio, y la tercera de julio. Para la 2351, la primera convocatoria es la de junio, la segunda de julio y la tercera de enero/febrero del siguiente curso. Claramente, el número de alumnos presentados dependerá considerablemente de la convocatoria de la que se trate. Normalmente, la primera es la que tiene el mayor número, pues es la natural de final de curso (se puede comprobar en la Tabla 1). La convocatoria se recoge en una variable dicotómica, que toma valor 0 si se trata de la primera, y valor 1 si se trata de alguna de las otras dos restantes.

Todas las variables analizadas las recogemos en la Tabla 3.

Tabla 3 Definición de variables

| Variable | Definición |

|---|---|

| NotaEF | Nota del examen final de cada alumno sin tener en cuenta la evaluación continua Valores: de 0 a 10 puntos |

| NotaEC | Nota de las pruebas parciales de cada alumno realizadas durante cada curso académico Valores: de 0 a 10 puntos |

| PEC | Número de pruebas de evaluación continua realizadas cada curso académico |

| Asign | Asignatura: Variable dicotómica: |

| - Contabilidad financiera I: valor 0 | |

| - Contabilidad financiera II: valor 1 | |

| Conv | Convocatoria. Variable dicotómica: |

| - 1ª convocatoria: valor 0 | |

| - 2ª y 3ª convocatoria: valor 1 |

Elaboración propia.

Modelo

El análisis empírico aplicado combina una vertiente descriptiva con otra explicativa y trata de contrastar la hipótesis que se plantea en numerosos antecedentes sobre la materia:

H: La evaluación continua tiene efectos positivos sobre el aprendizaje y por lo tanto sobre el rendimiento académico del alumno, de manera que mejora la nota que obtiene en el examen final como consecuencia de este proceso.

Se ha empleado la estadística descriptiva para el resumen de la información univariable, en concreto, medidas de posición (distribución de frecuencias y los valores medios de las valoraciones). Para las variables cualitativas se ha obtenido el número de casos presentes en cada categoría y el porcentaje correspondiente y, para las cuantitativas, los valores medios, desviación típica y tres cuartiles intermedios.

También, calculamos una tasa de variación, que se ha utilizado en contabilidad al tratar de cuantificar las diferencias entre los sistemas contables, o de medir cuantitativamente la armonización en ciertos periodos significativos; principalmente, se han usado los denominados índices tanto de medida del conservadurismo o, en grado más amplio, del grado de comparabilidad, como de concentración de prácticas contables (puede verse bibliografía al respecto en Sánchez Fernández de Valderrama, Martínez Conesa y Ortiz Martínez, 2002). En este caso, tratamos de analizar de una forma sencilla y en porcentaje, cómo ha cambiado la nota del examen, para llegar a ser la final de la asignatura teniendo en cuenta el porcentaje de calificación que se asigne a la evaluación continua, lo que en términos matemáticos se expresaría tal y como se recoge en la expresión [1].

Siendo NotaFinal la correspondiente de la asignatura, que se ha calculado como la suma del porcentaje de la evaluación continua y del examen final, y NotaEF la nota del examen final sin tener en cuenta otras pruebas.

Este índice nos indicará tanto el porcentaje cuantitativo de cambio que supone la evaluación continua en la nota del examen, que vendrá dado por su importe cuantitativo, como si la evaluación continua aumenta o disminuye la nota del examen, por lo tanto penalizando, en este último caso, si analizamos el signo del porcentaje que obtengamos.

Por último, para el análisis explicativo, hemos optado por técnicas de regresión multivariante. En concreto, modelos de regresión de mínimos cuadrados ordinarios (OLS transversales).

A la vista del objetivo de nuestro estudio, definimos un modelo que utiliza como variable dependiente la NotaEF de cada alumno (i) en cada curso académico (t), y las demás variables explicativas o de control según se incluye en la expresión [2].

Donde NotaEF es la nota del examen final sin tener en cuenta la evaluación continua; NotaEC es la nota de la evaluación continua; PEC es el número de pruebas de evaluación continua realizadas cada curso académico; Asign es la asignatura; y Conv es la convocatoria a la que se presenta el alumno.

Resultados

Análisis descriptivo

La Tabla 4 proporciona la media, la desviación típica y los tres cuartiles intermedios de las variables objeto de estudio. A fin de profundizar en la relación entre las variables, recogemos en la Tabla 5 sus coeficientes de correlación. Se observa que dichos coeficientes se encuentran dentro de lo que podríamos calificar como valores razonables, por tanto, podemos decir que la multicolinealidad no representa un problema en nuestro modelo. El factor de inflación de varianza (FIV), que se utiliza para asegurar que nuestros resultados no se hallan sesgados por la correlación entre las variables explicativas (Marquardt, 1970), en todos los casos se encuentra dentro de los límites aceptables (Gujarati, 2003).

Tabla 4 Estadística descriptiva de la muestra

| Variables continuas | Núm. obs. | Media | Desv. típica | Q1 | Mediana | Q3 |

|---|---|---|---|---|---|---|

| NotaEF | 584 | 4.32 | 2.10 | 2.75 | 4.17 | 5.82 |

| NotaEC | 584 | 5.07 | 2.40 | 3.29 | 4.94 | 6.72 |

| NotaFinal | 584 | 4.55 | 1.87 | 3.20 | 4.50 | 5.83 |

| PEC | 584 | 3.05 | 0.85 | 2 | 3 | 4 |

| Variables dicotómicas | Contab. finan I | Contab. finan II | ||||

| Asign | 584 | 51% | 49% | |||

| 1ª | 2ª y 3ª | |||||

| Conv | 584 | 69% | 31% |

Fuente: Elaboración propia.

Tabla 5 Correlaciones

| NotaEF | NotaEC | PPEC | Asign | Conv | |

|---|---|---|---|---|---|

| NotaEF | 1 | ||||

| NotaEC | 0.38** | 1 | |||

| PEC | 0.16** | 0.08 | 1 | ||

| Asign | 0.26** | -0.11* | -0.20** | 1 | |

| Conv | -0.08 | -0.21** | -0.07 | 0.00 | 1 |

* Significativo al 0.05.

** Significativo al 0.01

Elaboración propia.

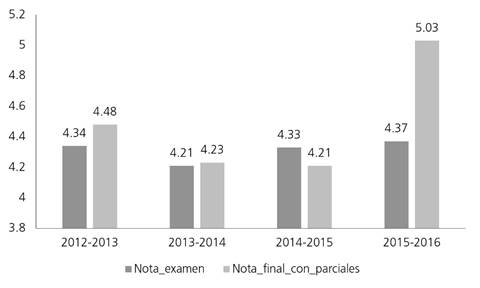

En la Figura 1 analizamos las medias de las notas por curso académico, y aunque inicialmente la nota media obtenida por los alumnos tiene un incremento al introducir la evaluación continua, este es escaso, pasando de una media de nota en el examen final de un 4.32 a un 4.55. Si continuamos analizando estas medias y el resto de variables de las que disponemos, estos resultados globales sufren ligeras modificaciones, de manera que no siempre el introducir en la nota la evaluación continua, incrementa la calificación media del alumno. De los cuatro cursos académicos analizados existe uno, el 2014-2015, en el que claramente la nota media de la asignatura se ha visto penalizada por haber tenido en cuenta la evaluación continua, siendo inferior a la que se hubiera obtenido solo calificando el examen. En cambio, en el curso más reciente, el 2015-2016, el efecto ha sido claramente el contrario y mucho más importante de forma cuantitativa sobre la nota del examen, que se ha visto incrementada con la evaluación continua. De tal manera que en los cursos analizados no existe una tendencia clara con respecto al efecto de evaluación continua en la nota del examen.

Tampoco son claros los efectos positivos de la evaluación continua sobre la nota final en función de la asignatura, ya que, si bien para la del primer cuatrimestre se obtiene una media mayor, para la del segundo apenas es escasamente inferior la media final calificando las pruebas intermedias o parciales realizadas como evaluación continua (tal y como se puede observar en la Figura 2). En cualquier caso, por asignatura la diferencia cuantitativa entre la nota final de la asignatura y la del examen apenas es apreciable.

En las medias de las notas por convocatoria, la evaluación continua penaliza a la nota final en la segunda de cada asignatura (Figura 3). En el resto de convocatorias la nota del examen se mejora cuando se le suma el efecto de las calificaciones de las pruebas parciales que forman la evaluación continua.

Finalmente, si analizamos las medias de las notas según el número de pruebas parciales o intermedias realizadas en la evaluación continua (Figura 4), con independencia del número de pruebas, es positivo el efecto de esta evaluación sobre la nota final de la asignatura. Solo para el caso de realizar cuatro pruebas parciales apenas existe diferencia entre la nota del examen final y la obtenida con la evaluación continua. En cambio, cuando se hacen tres pruebas intermedias se produce el mayor incremento en la nota global de la asignatura debido a la evaluación continua.

Si nos centramos en el análisis de los aprobados y suspensos teniendo en cuenta cada sistema de evaluación, el porcentaje de aprobados se incrementa en algo más de un punto porcentual con la modalidad continua (con la nota del examen los suspensos suman 62.7% y los aprobados, 37.3%, mientras que con la evaluación continua representan 61.6 y 38.4%, respectivamente).

El último apartado del análisis descriptivo es el que hemos destinado a las tasas de variación o índices. ¿Cuál es la variación cuantitativa de la nota del examen debido a la evaluación continua? ¿La evaluación continua incrementa o disminuye la nota del examen? Estos son los interrogantes que resolveremos a través de los índices o tasas de variación.

Para obtener conclusiones más concretas, el índice lo hemos desglosado, a su vez, en uno global y en dos índices en función del signo de las variaciones. El primero considera todas las variaciones de las notas del examen al incluir la evaluación continua. Los dos índices son, uno positivo, en aquellos casos en los que dicha evaluación incrementa la nota del examen sumando, o un índice negativo, en los casos contrarios. Los primeros resultados (Tabla 6) muestran que efectivamente la evaluación continua introduce una variación cuantitativa no despreciable en la nota final con respecto a la del examen. Por término medio puede variar la nota del examen casi 7.6% si se introduce la evaluación continua. Además, la nota final puede quedarse en la mitad de la del examen, con una variación de la de este último de -50%. También se puede doblar la nota final con respecto a la del examen al tener en cuenta las pruebas intermedias (un índice de 100%). En promedio, la evaluación continua incrementa la nota del examen en 11.86%, mientras que la disminuye en 4.3 por ciento.

Tabla 6 Estadísticos descriptivos de los índices

| N | Mínimo | Máximo | Media | Desv. típ. | |

|---|---|---|---|---|---|

| Índice global | 584 | -50 | 100 | 7.55 | 21.2386 |

| Índice positivo | 584 | 0 | 100 | 11.8557 | 16.61347 |

| Índice negativo | 584 | -50 | 0 | -4.3058 | 8.53235 |

Elaboración propia.

Si aislamos los casos en los que la evaluación continua cambia de un aprobado en el examen a un suspenso en la asignatura, o lo contrario, nos encontramos con 79 casos (13.5% de la muestra). De ellos, los que tienen un índice global negativo, es decir, la nota del examen es igual o superior a cinco, pero en cambio la nota final de la asignatura es inferior a cinco, porque la evaluación continua está penalizando sobre la nota del examen, nos encontramos con 11 casos que cumplen estas condiciones. En realidad, es apenas 2% sobre el total de la muestra, pero indica que hay casos en los que se puede dar la paradoja de que el alumno supera el examen, lo que puede demostrar que ha culminado con éxito el aprendizaje de la materia, pero debido a la nota de la evaluación continua, suspende la asignatura. Los restantes 68 casos (11.6% de la muestra) tienen un índice global positivo, con lo que al alumno le está resultando positiva la evaluación continua, pues habiendo suspendido el examen final logra aprobar la asignatura completa.

Si observamos cómo afecta la media de esta variación cuantitativa en la nota del examen por curso académico, asignatura, convocatoria o según el número de pruebas parciales realizadas, comprobamos lo siguiente:

La mayor variación en la nota del examen al introducir la ponderación de la evaluación continua se produce en el último curso académico analizado, el 2015-16, superando en término medio un 15% de incremento (Figura 5).

Mientras que en la asignatura de segundo cuatrimestre apenas hay variación media cuantitativa entre la nota del examen y la nota con evaluación continua, en la del primero, esta alcanza casi 15% (Figura 6).

Por convocatorias, aun cuando la nota de la evaluación continua se mantiene en media durante todas las convocatorias de la matrícula en curso, es en la primera y última en las que más se afecta a la nota del examen (Figura 7).

Cuando se realizan tres pruebas parciales para obtener la nota de evaluación continua, estas introducen una variación media en la nota del examen de casi 20%, lo que supone una variación de casi un quinto en la nota del examen debida a la calificación de dicha evaluación (Figura 8).

Análisis explicativo

Los resultados de la regresión OLS llevada a cabo se recogen en la Tabla 7. Se observa que lo obtenido es totalmente coherente con el análisis descriptivo.

Tabla 7 Regresión OLS

| NotaEFit = 𝛽0 + 𝛽1 NotaECit + 𝛽2 PECit + 𝛽3 Asignit + 𝛽5 Convit + ɛit | ||

| Variables | Estimated coefficient | t-statistic |

| NotaEC | 0.365 | 11.89** |

| PEC | 0.487 | 5.21** |

| Asign | 1.167 | 9.56** |

| Conv | 0.132 | 0.79 |

| C | 0.220 | 0.59 |

| N | 584 | |

| F | 59.35** | |

| R2 | 0.28 | |

| VIF | 1.06 | |

NotaEF es la nota del examen final sin tener en cuenta la evaluación continua; NotaEC es la de la evaluación continua; PEC es el número de pruebas de evaluación continua realizadas cada curso académico; Asign. variable dicotómica que toma valor 0 si es Contabilidad financiera I y 1 si es Contabilidad financiera II; Conv. variable dicotómica valor 0= 1a convocatoria y valor 1= 2a y 3a convocatorias.

*Significativo al 0.05.

** Significativo al 0.01.

Elaboración propia.

La variable NotaEC refleja una relación positiva en el cociente y valor estadísticamente significativo, por lo que podemos aceptar la hipótesis planteada. La evaluación continua efectivamente está teniendo un efecto positivo en el examen final del alumno. Estos resultados refrendan los antecedentes sobre la materia cuando abogan por un efecto formativo de la evaluación continua, que se reflejará en unos mejores resultados del examen final.

En cuanto a las variables de control observamos que PEC y Asign reflejan una relación positiva en el cociente y valor estadísticamente significativo, lo que indica que a mayor número de pruebas parciales mayor es la nota del examen final, y que en la asignatura de Contabilidad financiera I los alumnos obtienen mejor nota en el examen final. La única variable que no ha resultado significativa en el modelo ha sido la convocatoria del examen, lo que puede deberse a que la mayoría de los alumnos se presentan a la primera convocatoria, que es la que se realiza inmediatamente después de concluir la asignatura, ya sea en el primer o segundo cuatrimestre.

Conclusiones

A partir de los datos analizados podemos concluir que la evaluación continua mejora el rendimiento académico del alumno y, por lo tanto, la nota de las asignaturas de Contabilidad financiera (I y II).

Concretamente, con las pruebas de evaluación continua los alumnos consiguen tener una nota media más alta global, que si solo hubieran tenido como calificación la del examen final.

Efectivamente la evaluación continua mejora el aprendizaje, pues incrementa el porcentaje de alumnos que aprueban por encima de un punto porcentual. Este efecto positivo sobre el aprendizaje también se traduce en que la nota del examen se incrementa en promedio 7.6% debido a las notas que se obtienen de las pruebas intermedias de evaluación continua. Incluso habiendo suspendido el examen final, 11.6% de la muestra logra aprobar la asignatura completa cuando se suman las notas de las pruebas de evaluación continua. Y no solo eso, sino que en más de la mitad de las ocasiones (59.1% de la muestra), esta modalidad hace que el alumno obtenga una mayor nota en la asignatura que si solo hubiera puntuado el examen final.

Finalmente, y como principal aportación de este trabajo, indicaríamos que a través de los resultados de la regresión planteada podemos aceptar nuestra hipótesis de partida, por la que la evaluación continua efectivamente está teniendo un efecto positivo en el examen final del alumno. De tal manera, las pruebas intermedias diseñadas tienen un efecto sobre el proceso de aprendizaje del alumno. Esta conclusión refrenda los antecedentes sobre la materia, cuando defienden el efecto formativo de la evaluación continua, y que por tanto se reflejará en unas mejores notas obtenidas en el examen final. También hay una relación positiva entre mayor número de pruebas parciales y una mejor nota en el examen final; lo mismo ocurre en la asignatura básica de contabilidad financiera (I), los alumnos consiguen una mejor nota en el examen final. Ello nos indica que el diseño de las pruebas que van a formar parte de la evaluación continua es importante, porque puede determinar efectos positivos. El número de pruebas, o el tipo de asignatura, requerirán un análisis detallado de cómo se realiza el proceso de calificación de los alumnos y la retroalimentación que se les va dando en tiempo y forma.

Limitaciones del estudio y prospectiva

Con respecto a las posibles limitaciones de este trabajo, señalamos la opción de incluir más variables independientes o de control, que puedan afectar a la nota del examen final del alumno. No descartamos incluirlas en futuros trabajos en los que ampliemos la base de datos, por ejemplo, aumentando el número de asignaturas cuyas notas se analicen, los grados universitarios o los cursos académicos, e incluso intentando ver de qué manera puede influir el género del alumno en estas calificaciones. También nos planteamos completar este análisis cuantitativo con otro de tipo cualitativo, por ejemplo, a través de un cuestionario realizado a alumnos y/o profesores.

Según los propios resultados del estudio, 2% de la muestra, aprueba el examen final y luego suspende la asignatura por la nota de la evaluación continua. Ello nos lleva a querer ahondar en este aspecto en futuras investigaciones, intentar profundizar en las causas de este efecto.

nova página do texto(beta)

nova página do texto(beta)