Servicios Personalizados

Revista

Articulo

Indicadores

-

Citado por SciELO

Citado por SciELO -

Accesos

Accesos

Links relacionados

-

Similares en

SciELO

Similares en

SciELO

Compartir

Revista mexicana de investigación educativa

versión impresa ISSN 1405-6666

RMIE vol.18 no.56 Ciudad de México ene./mar. 2013

Investigación

El enfoque de la política basado en la evidencia: Análisis de su utilidad para la educación de México

The Focus of Evidence-based Policy: Analysis of Usefulness for Education in Mexico

Pedro Flores Crespo

Investigador del Instituto de Investigaciones para el Desarrollo de la Educación de la Universidad Iberoamericana-Ciudad de México. Académico visitante en el Institute for Effective Education de la Universidad de York en el Reino Unido (2011) (Conacyt 165923). Prolongación Paseo de la Reforma núm. 880, col. Lomas de Santa Fe, 01219, Ciudad de México. CE: pedroa.flores@ibero.mx.

Artículo recibido: 24 de febrero de 2012

Dictaminado: 9 de abril de 2012

Segunda versión: 5 de junio de 2012

Aceptado: 8 de junio de 2012

Resumen

Este artículo discute la metodología conocida como revisión sistemática (systematic review), que forma parte del corazón del enfoque de la política y la práctica basada en la evidencia (evidence-based policy and practice, EBPP); aunque, como toda metodología de corte pragmático, abre diversas controversias. Este texto hace un repaso de tales problemas así como de los méritos del enfoque. El argumento central es que el EBPP tiende a construir el conocimiento de manera abierta y plural y alentar el cambio de políticas, sin embargo, la adopción de estas metodologías en México parece complicada en virtud de las barreras detectadas por estudios previos sobre el uso del conocimiento en los procesos de política educativa.

Palabras clave: investigación educativa, política educativa, gestión del conocimiento, análisis crítico, metodología, México.

Abstract

This article discusses the methodology known as systematic review, which forms part of the heart of evidence-based policy and practice (EBPP); however, like any methodology of a pragmatic type, systematic review is controversial. This text discusses such problems, as well as the merits of the focus. The central argument is that EBPP tends to construct knowledge in an open, plural manner as it encourages changing policy. Yet the adoption of such methodology seems complicated in Mexico due to the barriers previous studies have detected with regard to the use of knowledge in processes of educational policy.

Keywords: educational research, educational policy, management of knowledge, critical analysis, methodology, Mexico.

Introducción

Quizá esté yo equivocado y tú en lo cierto,

quizá con un esfuerzo a la verdad nos acerquemos.

Karl Popper (2005)

Hacer que el conocimiento científico se utilice en la hechura de políticas educativas y en la práctica escolar es una larga aspiración en México (Bracho, 2010; Moreles 2009; Flores-Crespo, 2004; 2009; Latapí 2008; Maldonado, 2005; OCDE-CERI, 2004; Muñoz, 2004; Maggi, 2003) y en distintas partes del mundo (Dumond, Istance y Benavides, 2010; Reimers y MGinn, 2000). Desde esta lógica de modernidad,1 a la investigación educativa se le atribuye un poder de cambio y transformación de los asuntos públicos. Esta aspiración —por muy importante que sea— generalmente no se cumple. Hay múltiples razones por las cuales no sólo existe una brecha entre las ideas y la acción sino que se amplía.2 No es materia de este artículo explicar las que originan el desentendimiento entre investigadores, tomadores de decisión y practicantes; el objetivo, más bien, es discutir un enfoque de políticas relativamente nuevo que está tomando un creciente impulso en otros países para tratar de convertir la evidencia científica en conocimiento utilizable. Este enfoque se conoce como el de la política y práctica basada en la evidencia (EPPBE) o en inglés, evidence-based policy and practice (EBPP).

Este artículo se propone ser un aporte de discusión y está dividido en tres partes principales. En la primera se justifica el estudio del EPPBE. La consolidación de la investigación educativa en México, la aspiración de mejorar el desempeño de los gobiernos en la conducción de los asuntos públicos y la desarticulación de los esfuerzos académicos y gubernamentales en materia de evaluación de políticas y programas sustentan el análisis de enfoques de políticas basados en la evidencia.

La segunda parte describe los pasos para elaborar las revisiones sistemáticas, metodología central del EPPBE, y empieza a delinear algunos méritos y limitaciones de tales ejercicios. La tercera —y última parte— ahonda en el análisis crítico y aporta tres elementos para la discusión: qué tipo de evidencia utiliza el EPPBE, cómo se complementa este enfoque con otras posturas epistemológicas comúnmente utilizadas en el campo de la investigación educativa y si es factible que en el campo de la política educativa de México se utilice la evidencia de "alta calidad".

Este trabajo concluye invitando al debate con base en la identificación de algunas ventajas del EPPBE tales como la clara definición de objetivos y el proceso abierto y colectivo sobre el cual se genera la "evidencia". Sin embargo, como toda propuesta académica, también posee limitaciones y una de ellas es sugerir que la "evidencia" la constituyen sólo los efectos medibles originados por alguna intervención o programa educativo o que al contar con evidencia de "alta calidad", ésta será utilizada automáticamente. Los estudios sobre el uso y el impacto de la investigación educativa permiten visualizar barreras para la adopción de enfoques como el de la política basada en la evidencia. Esto constituye una lección tanto para el campo científico como para el político.

¿Qué justifica el estudio del enfoque de política basado en la evidencia?

La discusión sobre las nuevas corrientes para la utilización del conocimiento es necesaria en virtud de tres aspectos fundamentales. El primero se refiere a la necesidad de mejorar el desempeño de los gobiernos en la conducción de los asuntos públicos, como en este caso, la educación. En 1999 el gobierno británico propuso introducir una visión "ilustrada" para desarrollar políticas públicas. El entonces primer ministro, Tony Blair, sugirió que la formulación de buenas políticas dependía de contar con información de alta calidad, la cual se obtiene de diversas fuentes tales como el conocimiento especializado, la investigación existente nacional e internacional, datos estadísticos, consulta a los poseedores de interés (stakeholders),3 ejercicios previos de evaluación de políticas, investigación reciente e incluso fuentes secundarias (UK Cabinet Office, citado en Head, 2010, las cursivas son nuestras).

En México, también se ha recalcado la importancia del conocimiento especializado en la formulación de políticas públicas, especialmente referidas al campo de la educación. La Secretaría de Educación Pública (SEP, 2005), por ejemplo, afirma que la administración 2000-2006 consideró a la investigación educativa como un elemento fundamental para la toma de decisiones "informada":

[el] fomento de la investigación educativa busca promover y apoyar el desarrollo de la educación básica, sistematizar información y generar conocimientos para la innovación educativa y el diseño y la implementación de acciones dirigidas a mejorar el logro educativo (SEP, 2005: 205).

¿Es una moda de ciertos gobiernos hablar de la toma de decisiones "informada"? ¿Qué tipos de gobiernos desean impulsar enfoques como éstos? A los democráticamente electos puede interesarles aumentar la efectividad de sus políticas a través de diseños, implantaciones y evaluaciones de políticas y programas mucho más consistentes. En una democracia, si los gobiernos no dan buenos resultados pierden simpatías, y posiblemente votos; por lo tanto, su ineficiencia tiene un alto costo y, por ello, se busca la manera de mejorar el desempeño con base en la utilización del conocimiento o la evidencia.

La segunda razón para estudiar la forma en que el conocimiento es utilizado en los procesos de política y en la práctica escolar es el avance y consolidación de la comunidad de investigadores educativa en México, donde se han hecho contribuciones significativas para el entendimiento de los problemas educativos. De acuerdo con Pablo Latapí (2008), la fundación de diversos centros de investigación como el Centro de Estudios Educativos (CEE) ofreció un "novedoso enfoque pluridisciplinario" que contribuyó al desarrollo de diagnósticos cuantitativos de la cobertura y de la eficiencia de los servicios escolares en los tres niveles del sistema. Este investigador asegura que se depuraron datos sobre el financiamiento público y privado de la educación, se establecieron comparaciones internacionales, se hicieron pronósticos, se propusieron metodologías y "nomenclaturas" para abordar problemas específicos de la educación (Latapí, 2008:176).

Las observaciones de Latapí son reforzadas por académicos como Carmen García Guadilla y Fernando Reimers, quienes sostienen que dentro de los países latinoamericanos México tiene uno de los niveles más altos de desarrollo en cuanto a la institucionalización de la investigación educativa (citados en Maldonado, 2005).

La tercera y última razón para emprender estudios sobre la construcción y uso de la evidencia científica en el ámbito de la política educativa de México es la dispersión de esfuerzos para evaluar políticas y programas orientados a elevar el logro escolar de los niños y jóvenes matriculados en el Sistema de Educación Nacional.

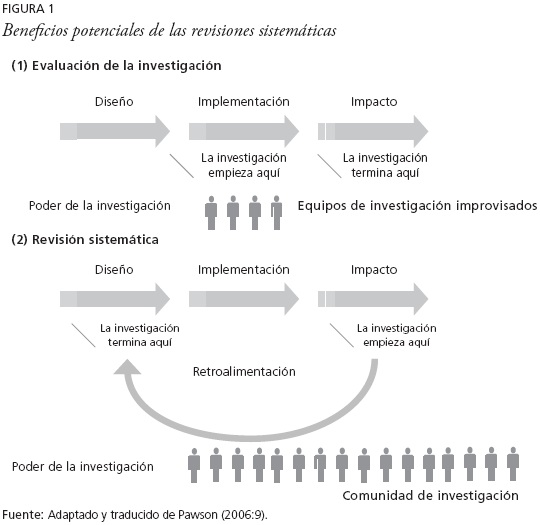

En México, la evaluación de políticas y programas ha existido desde hace varios años, ya sea como mero requisito de las agencias financiadoras, como labor independiente de los investigadores o, más recientemente, como parte de la regulación gubernamental. La pregunta es cómo se relaciona la investigación evaluativa con el enfoque de política y práctica basado en la evidencia (EPPBE). Ray Pawson (2006) ayuda a responder a esta pregunta a través de la figura 1.

Pawson (2006) observa que la investigación evaluativa ha registrado una producción de alcance industrial pero sigue manteniendo una característica "feudal" en su capacidad para impulsar el cambio. Esta fragmentación debe ser corregida por medio de una acumulación y valoración de la evidencia sobre temas comunes. La propuesta de integración o articulación de Pawson es sugestiva para el sector educativo de México por varias razones. La primera es que especialistas en evaluación de políticas sociales han observado serias limitaciones para valorar la efectividad de los programas en su conjunto (Bracho, 2011; Muñoz, Magaña y Bravo 2009). Muñoz y colaboradores lo expresan de la siguiente manera: los especialistas encargados de evaluar los programas federales orientados a mejorar la calidad de la educación básica no consideraron las "sinergias que pudieron haberse generado al aplicar, simultáneamente, varios programas en los mismos centros escolares" (2009:8).

Segundo, los esfuerzos de evaluación se han concentrado en verificar el cumplimiento de ordenamientos presupuestales o normativos bajo el esquema de planeación gubernamental conocido como la metodología del marco lógico (MML). Bracho (2011) hace notar que utilizar la MML facilita el seguimiento y la evaluación de resultados de un programa, pero también resalta la carencia de información para valorar de manera más justa al programa en cuestión. La dimensión de evaluación, que debería ser el cambio en aspectos fundamentales como el logro escolar o la "ampliación de capacidades" (Sen, 1999), no es del todo explícita en los marcos de evaluación gubernamental.

Tercero, parece haber una multiplicidad de esfuerzos institucionales para evaluar la efectividad de los programas en el campo de la educación de México. Existe, por un lado, dentro de Unidad de Planeación y Evaluación (UEPE) de Políticas de la Secretaría de Educación Pública, la Dirección General de Evaluación de Políticas que se encarga de:

Evaluar de manera sistemática y permanente, en coordinación con las unidades administrativas de la Secretaría y las entidades especializadas competentes, el desarrollo del sistema educativo nacional, el cumplimiento de las políticas, objetivos, programas, proyectos, actividades y compromisos establecidos en el Programa Nacional de Educación, así como el impacto de los mismos (disponible en: www.dgep.sep.gob.mx, cursivas nuestras).

Por otra parte, la Ley General de Desarrollo Social (LGDS) establece que la evaluación de la política social —que incluye, por supuesto, a la educativa— tiene por objeto "revisar periódicamente el cumplimiento del objetivo social de los programas, metas y acciones" de la política social para "corregirlos, modificarlos, adicionarlos, reorientarlos o suspenderlos total o parcialmente" (LGDS, artículo 72). Los encargados de realizar esta evaluación serán el Consejo Nacional para la Evaluación de la Política Social (Coneval), las universidades y organizaciones "no lucrativas", siempre y cuando sean independientes al ejecutor del programa (LGDS, 2004). En consonancia con este ordenamiento, en 2007, se crearon los Lineamientos para la Evaluación de los Programas Federales de la Administración Pública Federal con el objetivo de orientar los programas y el gasto público al logro de objetivos y metas.

Aparte de lo realizado por la SEP y el Coneval en términos de evaluación de programas, el Instituto Nacional para la Evaluación de la Educación (INEE), en su Plan Maestro de Desarrollo 2007-2014 afirma que este organismo, en 2010, "habrá incursionado en la evaluación de programas, en colaboración con instituciones e especialistas que tengan un dominio de las metodologías adecuadas para tal fin" (INEE, 2006:41). Por si esto no fuera suficiente, el Consejo Nacional de Ciencia y Tecnología (Conacyt), junto con la Subsecretaría de Educación Básica (SEB) han puesto en marcha convocatorias para apoyar proyectos de investigación educativa en distintas áreas. Una de éstas es "Diseño, resultados e impacto de programas y estrategias educativas", en donde se dice que la SEP necesita "contar con información sobre la implementación y resultados obtenidos por programas o proyectos innovadores orientados a la mejora de las condiciones para el aprendizaje [...]" (disponible en: www.conacyt.gob.mx 2011).

Como se puede ver, hay una multiplicidad de iniciativas para evaluar programas o "estrategias educativas". Muchas de estas iniciativas provienen de oficinas gubernamentales y agencias de evaluación educativa, lo que corrobora cierta aspiración del gobierno mexicano por tratar de mejorar, por medio del uso de la evidencia y el conocimiento, su desempeño en la conducción de asuntos públicos.

Construir evidencia y ligarla a los procesos de política para elevar la eficiencia gubernamental no es una tarea simple, mucho menos lineal; por ello, la siguiente sección pone a discusión una metodología que ha sido central en el Enfoque de la Política Basada en la Evidencia y se denomina revisiones sistemáticas o en inglés, systematic reviews. ¿Es aplicable y pertinente este enfoque para la política educativa de México? Esta pregunta se responderá por medio de la descripción general del enfoque y de comentarios de autores que han estudiado la relación entre investigación y la política educativa en México y en otras latitudes.

Revisiones sistemáticas. Elementos constitutivos y algunas controversias

Las revisiones sistemáticas son el corazón del EPPBE y surgieron, según Carole Torgerson (2003), para responder a la crítica sobre la falta de rigor científico, calidad y relevancia de las investigaciones desarrolladas por las comunidades académicas. Aparte de estas quejas sobre rigor y falta de relevancia práctica, Torgerson (2003) también señala que surgen con el propósito de ir más allá de lo contenido en las revisiones narrativas (narrative reviews), que son síntesis de investigación en donde se presentan los hallazgos de manera verbal.4 Las diferencias entre las revisiones narrativas y las sistemáticas las explica Chambers (2011), como se puede observar en el cuadro 1.

Las revisiones narrativas, según Torgerson (2003), tienden a introducir un sesgo en la selección de materiales y las razones para la inclusión y exclusión de investigaciones raramente se hacen explícitas. Además, se pueden incorporar referencias que solamente apoyen la "opinión del experto" cuando otras lo pueden contradecir. Con las revisiones narrativas se abre la puerta a la inclinación de ciertos autores de ser ellos los que deben estar, invariablemente, incluidos o citados.

Si de lo que se trata es de acumular el mayor número de estudios (tanto-publicados como sin publicar) para poder formular una sólida interpretación de la evidencia recolectada, una sola investigación o la "autoridad" del revisor no bastan. Las revisiones sistemáticas —tal y como afirma Torgerson— "buscan identificar toda la evidencia disponible con respecto a un tema en específico" (2003, cursivas del autor) y una vez recolectada se procede a valorarla en términos de su calidad y a resumirla. Con ello, se trata de que el conocimiento generado por los especialistas sea accesible y útil.

Una característica clave de las revisiones sistemáticas es que si se decide excluir algún material, el criterio o criterios tienen que ser explícitos para que otro autor o autores, con la misma autoridad, puedan replicar el ejercicio. Este atributo, como apunta Torgerson (2003), constituye uno de los aspectos más importantes del paradigma científico, junto con el de fiabilidad (reliability) y credibilidad. La posibilidad de refutar y de estar en completo desacuerdo indica la condición de "falibilidad" del conocimiento científico de la que hablaba Karl Popper (2005) y esto, a mi juicio, es un valor rescatable de la metodología de las revisiones sistemáticas. Nada es verdadero y todo está sujeto a revisión.

Para realizar una revisión sistemática, según Chambers, hay que establecer una serie de pasos como muestra la figura 2.

Torgerson (2003) complementa la estructura de Chambers (2011). Para la primera autora existen siete pasos para realizar una revisión sistemática. A saber:

1) Diseñar un protocolo con la finalidad de establecer las bases teóricas, empíricas y conceptuales del tema. Además de establecer la pregunta de investigación, los objetivos, los métodos de búsqueda, validación, resumen, calidad y síntesis. En esta fase, Torgerson hace una afirmación que, en apariencia, es sencilla pero que implica un determinado nivel de expertise del revisor. Torgerson (2003) sostiene que formular una pregunta clara antes de empezar la búsqueda de material evitará esfuerzos y costos inútiles. Esto implica un amplio conocimiento del campo o tema objeto de la revisión. Un investigador avezado en técnicas estadísticas —pero sin conocimiento de la teoría o de los antecedentes del fenómeno educativo— puede estar en gran riesgo de introducir un mayor sesgo en la revisión sistemática. Esto se resuelve con la exposición y discusión de los criterios de búsqueda con otros colegas, lo que posibilita la construcción colectiva del conocimiento.

2) Definir los criterios para la inclusión o exclusión de materiales en donde se debe especificar si los estudios elegidos serán solamente experimentales y escritos en un idioma determinado. En esta fase aparece el criterio esencial para elaborar los systematic reviews: la inclusión de artículos que presenten una medición "confiable" de la efectividad de un programa o intervención educativa. Esta confiabilidad la ofrecen técnicas como las pruebas de control aleatorias (randomised controlled trial, RCT) que se refiere a un ejercicio en donde dos o más grupos de individuos son formados de manera aleatoria para realizar la medición y, con ello, tratar de eliminar el sesgo en la selección de sujetos participantes y no participantes en el programa o intervención. Esta metodología en el sector médico ha evolucionado de tal manera que existe ya un estándar para saber qué estudios con RCT pueden ser incluidos en la elaboración de las revisiones sistemáticas.5

3) El protocolo, idealmente, dice Torgerson (2003), debe ser revisado por los pares para así comenzar la búsqueda de literatura en revistas especializadas clave. Los resultados de esta búsqueda deben estar sujetos a la revisión de, por los menos, dos académicos independientes y especialistas en el tema. Este ejercicio debe realizarse, en un primer momento, con base en títulos y resúmenes de los artículos y, en segundo lugar, revisando el contenido del material seleccionado. Aquí Torgerson (2003) enfatiza que tanto lo publicado como lo no publicado en revistas especializadas debe ser considerado como válido si es que utiliza una prueba de control aleatoria para realizar la medición de la efectividad de un programa o intervención. Para localizar el material no publicable, hay que echar mano de los contactos personales del investigador y de su conocimiento en el campo de especialización, cuestión que vuelve a traer a la discusión la importancia del enfoque relacional resaltado anteriormente.

Encontrar estudios cuasi experimentales o experimentales que apliquen pruebas de control aleatorias puede ser una tarea complicada. Por ello, se han desarrollado iniciativas como la Cochrane Collaboration que se ha encargado de diseñar y alimentar bibliotecas y bases de datos de estudios con investigaciones concernientes a la efectividad de las intervenciones en el área del cuidado de la salud.6 En educación, ya se pueden encontrar algunas iniciativas que buscan concentrar los trabajos que miden la efectividad de los programas de este rubro. Uno de ello es, según Torgerson (2003), el Evidence for Policy and Practice Information and Coordinating Centre (EPPI) de la Universidad de Londres, en Inglaterra. En este mismo país también se puede mencionar la Best Evidence Encyclopaedia (BEE) que mantiene el Institute for Effective Education de la Universidad de York. La BEE es un sitio de acceso gratuito que desarrolla, evalúa y difunde programas de educación efectivos; además, promueve las políticas basadas en la evidencia. Los principales temas de sus revisiones sistemáticas son: niñez temprana, matemáticas en primaria y secundaria, habilidades lectoras, lectores con problemas y tecnología de la información.7 Pareciera que el tema que, de manera general, está incluido en las revisiones sistemáticas es el mejoramiento del aprendizaje, el desarrollo de habilidades para elevar el logro educativo. Esta aclaración no es trivial pues como ya se había apuntado en secciones anteriores, las evaluaciones que propone el gobierno mexicano sobre programas e intervenciones educativos parecen no tener del todo claro cuál es núcleo primordial de la evaluación.

4) La siguiente fase es la de mapeo, en donde se describen y clasifican los estudios hallados en la primera revisión. Aquí es donde se refina la búsqueda del material bibliográfico que será definitivo para la elaboración de la revisión sistemática. Es importante destacar que si los criterios de inclusión de material son demasiado estrictos, se corre el riesgo de que quede un número muy reducido de estudios.

5) Una vez que el material se ha identificado, se debe extraer la información a partir de una hoja de datos (ver anexo 1). Este ejercicio no es aislado. De acuerdo con Torgerson (2003), hay que involucrar a investigadores independientes para determinar la calidad de los resultados de los artículos seleccionados. Esta calidad, según Torgerson, se logra por medio de la validez interna y externa. La primera se refiere a la aplicación de técnicas específicas como la evaluación aleatoria (random assignment) y el diseño experimental. Asimismo, Torgerson señala que autores como Kjaergard y colaboradores han detectado pruebas aleatorias con un amplio número de sujetos que tienden a ofrecer una mejor calidad de información. También cita los estudios de Troia, quien ha enlistado una serie de criterios de calidad relacionados con la validez interna de los estudios o investigaciones susceptibles de incluir en las revisiones sistemáticas. Como ya se dijo, uno de estos criterios es la evaluación aleatoria (RCT) y el diseño experimental en donde el grupo control sea expuesto a una determinada intervención. Además, se desea que tal intervención o tratamiento sea descrito puntualmente, que las equivalencias de tiempo entre el grupo control y experimental sean similares y que existan y hagan explícitos los criterios de la intervención (criterion-based intervention). A cada uno de estos criterios se le puede dar un peso específico, el problema —advierte Torgerson (2003)— es que al hacerlo existe el riesgo de clasificar como "bueno" un estudio que simplemente destaque en alguno de estos criterios. ¿Y por qué tanta preocupación en verificar la validez interna de un estudio que mida la efectividad de una intervención o un programa bajo una RCT? Porque simple y llanamente si esta condición no existe, el tamaño del efecto observado puede ser "incorrecto" (Torgerson, 2003:55).

Como se observa, conducir una revisión sistemática es un asunto complejo. No se trata, como bien expresa Torgerson (2003), de un ejercicio mecánico ni tampoco objetivo pues la determinación de los criterios de selección es decisión del investigador-revisor. Lo importante que hay que destacar aquí es que tal establecimiento de criterios es explícito y transparente. Así, otro investigador, con la misma autoridad, puede replicar o refutar la metodología y los hallazgos.

6) Después de extraer la información de los estudios seleccionados, se realiza una "síntesis". Ésta, como menciona Torgerson (2003), puede hacerse de manera cualitativa si los datos no permiten una síntesis numérica. Ahora, si los datos numéricos presentan una homogeneidad suficiente, pueden ser combinados y presentarlos en un meta análisis, que —dentro del enfoque de las políticas basado en la evidencia— es una técnica estadística para concentrar datos de dos o más pruebas aleatorias de control y su valor reside en que reduce el error derivado del ejercicio aleatorio de un estudio (random error). Con el meta análisis se trata de estimar de manera más "precisa" el efecto general (overall effect) de un programa o intervención educativa (Torgerson, 2003:74). El meta análisis constituye una evidencia de alta calidad pero, ¿los tomadores de decisiones lo usan para hacerlo de manera informada? Como ya lo han observado diversos autores (Muñoz, 2004; Majone, 2005; Head 2008, 2010; Moreles, 2009, Flores-Crespo, 2009), la decisión política y de políticas es intrínsecamente compleja, por lo tanto, sería ingenuo asumir que la alta calidad con que se realiza un estudio es suficiente para modificar ciertos patrones de conducta política. Esto no es para decir que no se deben emprender este tipo de enfoques, sino para subrayar que la elaboración de las revisiones sistemáticas o de los meta análisis no asegura su utilización.

7) La fase final de la elaboración de la revisión sistemática incluye la interpretación de la información sintetizada. El reporte que se realice, según Torgerson (2003) debe ser expuesto a la revisión de pares antes de que se publique. En su experiencia, Chambers (2011) afirma que el reporte puede incluir tanto los hallazgos en términos de efectividad de los programas o intervención, pero también se puede abrir una sección en donde se mencionen los principales estudios de tipo cualitativo que se hayan hecho sobre el tema. El propósito es que los practicantes (que, en general, son los maestros) y los tomadores de decisiones tengan mayores elementos para guiar mejor su práctica. Chambers (2011) también señala que es muy importante pensar en los públicos a los que está dirigido el reporte y algo que es muy útil para el campo de la investigación educativa: identificar los vacíos en la literatura.

Como vemos, las revisiones sistemáticas no sólo son un ejercicio útil para los maestros o políticos, sino también para investigadores.

Hasta aquí se ofreció una descripción de los pasos generales para elaborar una revisión sistemática, la cual es un ejercicio que forma parte del corazón del enfoque de políticas y prácticas basadas en la evidencia (EPPBE). Dentro de la descripción se resaltaron algunas ventajas y limitaciones de estos ejercicios de síntesis. A continuación, se presentan, de manera más puntual, algunas limitaciones y potencialidades del EPPBE las cuales son expuestas a partir del estudio de la relación entre investigación y políticas educativas en México.

Posibilidades y limitaciones del enfoque basado en la evidencia

¿Qué es la evidencia?

¿Un caso de estudio analizado por un investigador constituye "evidencia" para nutrir la política educativa y la práctica escolar? Philip Davies afirma que las revisiones sistemáticas están basadas en la observación de Cook y colaboradores, quienes señalan que los estudios singulares son limitados para hacer generalizaciones sobre el conocimiento que producen en relación con conceptos, poblaciones, contextos y tiempo y, frecuentemente, sólo iluminan una parte de un gran rompecabezas que busca ofrecer explicaciones (Da-vies, 2000:366). Las revisiones sistemáticas destacan la construcción de una "sapiencia colectiva" —en palabras de Ray Pawson (2000:11)— porque esto podría asegurar una interpretación de resultados no sesgada. Esta pluralidad y construcción colectiva de evidencia parece ser una ventaja del EPPBE.

Dentro del enfoque de políticas y práctica basadas en la evidencia, sí hay un tipo de evidencia que se toma como tal y ésta es el efecto que produce un programa o intervención sobre un grupo de estudiantes expuestos a tal intervención. Para medir este efecto, como ya se comentó, tienen que seleccionarse artículos o estudios (publicados o no) realizados bajo un ejercicio cuasi experimental y mediante pruebas de control aleatoria (RCT) para saber si existen diferencias estadísticamente significativas entre un grupo control y otro experimental.

Decir que la "evidencia" es aquella que se logra por medio de una sola técnica de recolección de información puede sugerir una superioridad de los enfoques cuantitativos sobre los cualitativos. Esta división entre una perspectiva y otra puede hacernos caer en discusiones estériles, por lo que valdría la pena aclarar tres cosas. La primera es que cada técnica de recolección de información tiende a responder preguntas de naturaleza diversa. Mientras la técnica cuantitativa, dentro del enfoque EPPBE, busca estimar el efecto que produce una intervención o programa educativo, la herramienta cualitativa responde a otro tipo de propósitos igualmente válidos como comprender cómo ocurre un fenómeno escolar dentro de un contexto específico. Segunda aclaración, hay metodologías que se están desarrollando para poder hacer revisiones sistemáticas con datos no estructurados8 y generar así "evidencia", aunque es claro que las síntesis de investigación cualitativa son menos comunes que los experimentos controlados, según observa Davies (2000).

Finalmente, la tercera aclaración: las críticas al EPPBE han sugerido la posibilidad de ampliar la base informativa para construir "evidencia" y no quedarse solamente con el dato duro sobre la efectividad de los programas o intervenciones educativas. Teresa Bracho, en su escrito sobre políticas basadas en la evidencia afirma que:

[...] la evidencia no se identifica con la información existente, sino que es un dato que se construye tanto desde los sistemas de información de la administración pública como desde los propios investigadores en su actividad evaluativa y que adquiere un significado argumentativo en su uso político [...] la evidencia es tal en el preciso momento en que está disponible, se difunde y es utilizada para retroalimentar a las políticas públicas (Bracho, 2010:331).

El punto de vista de Bracho es reforzado por Head (2008), quien afirma que existen por lo menos tres tipos de "conocimiento" y, por lo tanto, de "evidencia": el conocimiento político, el análisis técnico riguroso y científico y la experiencia práctica del campo profesional.

El conocimiento político, de acuerdo con Head, es construido primor-dialmente por los políticos, partidos, grupos organizados y los medios de comunicación y tiene relación con el análisis y el juicio de todos esos actores políticos. Se revela por medio de la determinación de prioridades, la formación de la agenda, el ajuste de estrategias y tácticas, la comunicación y la ideología. La política (policy), vista a través de los lentes del conocimiento político, se refiere más al ejercicio de persuasión y apoyo que a una "veracidad objetiva (Head, 2008:5). Esta posición de Head es congruente con las tesis de la argumentación y persuasión de Giandomenico Majone, quien ha sustentado que "[e]l argumento es el lazo que vincula los datos y la información con las conclusiones del análisis" (2005:103). Las políticas no surgen lineal, repentina ni mucho menos espontáneamente del dato, sea éste de tipo estructurado (cuantitativo) o cualitativo.

La segunda forma de evidencia, siguiendo con Head, es el conocimiento científico, el cual es construido por medio del análisis sistemático. Aunque Head (2008) no concede que sea producto de las revisiones sistemáticas, sí resalta una característica de éstas, que es la necesidad de asegurar la calidad y la consistencia de los datos como parte de este conocimiento.

La tercera forma de evidencia mencionada por Head es aquella que se construye por medio del proceso de implementación o lo que también llama como sabiduría práctica (2008:6). Según Head los equipos administrativos de los programas generalmente están desconectados cuando éstos son los que "batallan" con los problemas cotidianos de la puesta en marcha de los mismos. Head prosigue y menciona que este tipo de conocimiento generado en la base del sistema de entrega de servicios puede ser visto como las "buenas prácticas" (2008:7).

La literatura de "buenas prácticas" en América Latina y en países como México ha recibido una atención creciente (Zorrilla, 2005; Ornelas 2005), pero la pregunta aquí es, ¿"bueno" en comparación con qué? ¿Cuál es el criterio para realizar tal valoración? Por la forma en como se recolecta la información, esas prácticas no siempre pueden generalizarse ni tampoco parece que se busquen integrar las buenas prácticas a otro tipo de información más general como sería una revisión sistemática para inducir el cambio educativo de manera más fundada.9 Esto sugiere la necesidad de pensar cómo se podría dar la integración de dos corrientes en la literatura de la innovación educativa y que son, por un lado, el enfoque de las políticas y las prácticas basado en la evidencia y, por otro, la amplia literatura de las buenas prácticas.

Otro acierto de haber sugerido la ampliación de la base informativa para nombrar a la "evidencia" y darle espacio al conocimiento generado en la fase de operación de los programas, es que: a) refuerza la idea de que los procesos de política pública son cíclicos y b) reconoce, implícitamente, que los administradores y practicantes también son generadores de conocimiento, no sólo el investigador. Esto refiere a un enfoque plural e incluyente en donde los distintos tipos de conocimiento son utilizados en la mejora de los servicios educativos.

Diversos métodos y posturas epistemológicas para un mismo propósito

Cuestionar la calidad del conocimiento generado por algunos académicos, así como medir la efectividad de los programas o intervenciones educativas, abre la puerta a cuestionamientos desde diversos ángulos; uno de ellos es el "post modernismo". Los académicos afines a este paradigma sostendrían que ningún conocimiento, supuesto, método o teoría es superior a otra o que no existe tal cosa como la "evidencia conclusiva" (Davies, 2000:366). Con el riesgo de simplificar demasiado el aporte de Michael Foucault (1926-1984) a la teoría social contemporánea, se podría decir que para este autor —y para sus seguidores— el conocimiento o la evidencia son factores de poder y de control. Los discursos de los expertos, dirían los foucaultianos, podrían ser utilizados como una herramienta de poder para restringir formas de pensar, según explica Anthony Giddens (2006) en el repaso que hace de la obra de Foucault.

Aunado al paradigma postmodernista en las ciencias sociales y a la noción de poder, hay otras posiciones epistemológicas utilizadas en el campo educativo que pueden entrar en diálogo con el enfoque de la política basada en la evidencia. La investigación emancipatoria, según Maria Stuttaford (2004), se enfoca en la vida y experiencia de las personas "históricamente marginadas" y busca interpretar las desigualdades no sólo en términos de aporte intrínseco, sino que liga los resultados de los estudios a la acción política y social. Una especie de activismo ilustrado en donde el riesgo de reivindicar se puede anteponer a lo revelado por la evidencia científica. Bajo esta lógica, completa Pawson (2006), los problemas de las personas con capacidades diferentes, por ejemplo, son creados por un sistema social que trata la discapacidad de un modo determinado y, por lo tanto, la investigación emancipatoria, buscará priorizar soluciones que desafíen las fuerzas materiales que limitan el potencial de estas personas. El problema con este enfoque, agrega Pawson, es que cada política o cada intervención producirá desacuerdos, disputas y rivalidades entre los grupos de poseedores de interés (stakeholders), pues se resaltará que los programas o intervenciones sólo trabajan para algunos en detrimento de los otros (Pawson, 2006).

Haciendo eco con la metodología emancipatoria, en el campo de la evaluación de programas, existe un enfoque llamado empowerment evaluation, lo que se traduciría como evaluación facultativa, bajo el cual se utilizan los resultados y conceptos de los ejercicios evaluativos para promover la libre determinación y el mejoramiento de los programas (Fetterman, 1996). Este enfoque, como afirma Fetterman, no está diseñado para suplir otras formas de evaluación y busca ayudar a los participantes de los programas a evaluarse a ellos mismos y a sus programas para mejorar su práctica. Sus ventajas son que se puede echar mano de información cualitativa y cuantitativa, promueve la reflexión de los actores directamente involucrados con los programas y no se concentra solamente en los resultados (outcomes), sino en el proceso de facultar (empower) a las personas para poder inducir el cambio.

Muy relacionada con la tarea de empoderar a los sujetos y fortalecer la agencia humana, la teoría crítica es otra postura muy utilizada dentro del campo de la investigación educativa que surge, como señalan Cohen, Manion y Morrison (2007), para contraponerse al positivismo y a los paradigmas interpretativos. Lo que busca la teoría crítica es, entonces, incorporar al análisis el componente político e ideológico de los contextos en donde se desarrollan las investigaciones. Para los "teóricos críticos" los paradigmas positivista e interpretativo son esencialmente tecnicistas y no buscan cuestionar o transformar la situación analizada. En cambio, con la investigación educativa "crítica" ya no sólo se estudia la desigualdad, por ejemplo, sino cómo las escuelas pueden perpetuarla o reducirla. A partir de las posturas "críticas" se levantan cuestionamientos tales como "a qué intereses sirve la educación y que tan legítimos son éstos" (Cohen, Manion y Morrison, 2007).

Aunque hay diferencias epistemológicas y prácticas entre el enfoque de política basado en la evidencia y la teoría crítica y la investigación emancipatoria y, en parte, con la evaluación facultativa, las cuatro posturas comparten el énfasis en el cambio y en la mejora de las condiciones sobre las que operan los programas y las políticas. Tener en cuenta los propósitos del EPPBE y su posible integración a otros enfoques y metodologías es un paso para responder a la pregunta de si se deben o no promover este tipo de enfoques en países como México. ¿Funciona tan bien el sistema educativo nacional para no intentar el cambio por la vía del conocimiento? De acuerdo con la información generada por el Instituto Nacional para la Evaluación de la Educación (INEE), no. Pero sigamos con la identificación de las posibilidades y limitaciones de las revisiones sistemáticas, corazón del enfoque de la política basado en la evidencia.

¿La calidad del conocimiento asegura su utilización?

Como puede deducirse, los systematic reviews implican un fino proceso de análisis, tiempo y una gran cantidad de recursos intelectuales y materiales. Si la revisión sistemática es un proceso formal y riguroso, ¿su utilización depende de estas características? Gracias al conocimiento acumulado sobre la utilización de la investigación educativa en México, se puede responder esta pregunta.

En los estados de conocimiento del Consejo Mexicano de Investigación Educativa (COMIE), Maggi (2003) asegura que el problema de la calidad de la investigación fue una preocupación recurrente de los investigadores mexicanos y que fue, también, uno de los recursos para explicar el escaso impacto de la investigación en algunas áreas como el estudio del posgrado o la formación técnica. Los trabajos en estas áreas, de acuerdo con Valenti y Moya y Bracho, no estaban "sustentados en investigaciones amplias" y "padecieron de un bajo nivel de generalización de resultados [...], pobreza analítica y en otros casos, carecieron de "consistencia entre las teorías propuestas, los enfoques y los métodos utilizados (citados en Maggi, 2003:208).

Más recientemente, algunos autores como Moreles (2009) han asegurado que la calidad de la investigación no necesariamente está relacionada con su uso. De acuerdo con este autor, existe una tensión entre la autonomía de los investigadores, su grado de injerencia pública y la calidad de la investigación que realizan. Es decir, entre más autónoma es la investigación con respecto de las "prebendas políticas", puede haber pocas posibilidades de tener impacto pero, a la vez, la investigación podría ser de mayor calidad. Moreles concluye que en diversos países, incluyendo México, la calidad de la investigación no se asocia directamente con su utilización. Esto es una advertencia para adoptar el EPPBE. Si la evidencia que se selecciona en las revisiones sistemáticas es de "alta calidad", ¿por qué no se utiliza al grado que se espera? A través de sus estudios sobre la política educativa de México, Pablo Latapí (2008) ha mostrado que el contacto personal entre el investigador y las autoridades es central para que la política incorpore, de manera parcial, discontinua y en ocasiones, problemática, el conocimiento del experto. Carlos Muñoz (2004), por su parte, también ha observado que el impacto del conocimiento en la política es un fenómeno complejo y que, por lo mismo, no puede tratarse bajo supuestos meramente técnicos. Este autor sugiere que existen cuatro dinámicas que tienen que considerarse para analizar si las ideas impactan en la acción pública que son de "naturaleza social" (qué cambios requieren los sistemas educativos), de "índole científica" (corrección epistemológica, validez de conocimientos); de "comunicación" (interacción intra grupal), y "política" (responder a las demandas de la población).

Moreles (2009) complementa el trabajo de Latapí (2008) y de Muñoz (2004) al afirmar que el término "relación" entre investigación y políticas debe tomarse con cautela, pues puede ser artificial cuando se trata de comprobarse por medio de determinada evidencia empírica. Para Moreles, esta relación se manifiesta de formas distintas y sugiere que puede ser "sutil, indirecta e interactiva" y estar condicionada diversos factores tales como la "alternancia y expansión de roles" de los actores involucrados, las características de la investigación y las relaciones informales y contactos personales que se establecen entre los actores. En resumen, no por concentrar evidencia científica de alta calidad en las revisiones sistemáticas se asegura su utilización en los procesos de política y en la práctica escolar.

Walter, Nutley y Davies (2005) señalan que el uso de investigación es un proceso continuo que abarca desde alertar y tomar mayor conciencia sobre alguna problemática hasta la modificación de actitudes y el cambio en decisiones de política. Es decir, puede haber tanto un uso conceptual de la evidencia hasta uno netamente instrumental. Estos autores, además, identifican cinco mecanismos por los cuales se utiliza la evidencia, a saber:

• Diseminación, que consiste en la circulación o presentación básica de los hallazgos en formatos no elaborados a los usuarios potenciales.

• Interacción, que busca desarrollar vínculos y colaboraciones más estrechas entre la investigación, la política (policy) y la práctica.

• Influencia social, que se asienta en tratar de influir en otros expertos mediante la persuasión.

• Facilitación, que se produce al desarrollar apoyos de tipo organizativo, técnico, financiero e, incluso, emocional.

• Reforzamiento, que incluye el uso de recompensas aparte de la evidencia con el propósito de inducir ciertas conductas de los usuarios del conocimientos (Walter et al (2005:341).

Walter y colaboradores revelan por lo menos tres lecciones cuando tratan de responder a la pregunta: "¿Qué es lo que mejor funciona para promover las prácticas basadas en la evidencia" en las áreas de salud, justicia, protección social y educación? A través de la revisión de 93 artículos con aplicaciones empíricas, aseguran que: a) el contacto informal tiene valor en la promoción del uso de la investigación; b) las resistencias culturales son evidentes ante la sugerencia de cambiar una práctica aun cuando esté basada en la evidencia y por sí sola se justifique; y c) no hay mecanismo óptimo que asegure el uso efectivo de la evidencia, sin embargo, aclaran que en el sector educativo parece ser que los enfoques interactivos son mejor recibidos que en el área de salud, en donde el reforzamiento tiene mayores probabilidades de éxito.

Pareciera entonces que el uso e impacto de la investigación y el conocimiento especializado está profundamente mediado por una serie de relaciones humanas y personales y, por lo tanto, no basta apelar a la calidad de la evidencia para esperar su utilización.

Consideraciones finales

¿Debemos adoptar o rechazar el enfoque de la política basado en la evidencia en el campo de la política educativa de México? Si tomamos en cuenta la consolidación del campo de la investigación educativa, la necesidad de elevar la eficacia de los gobiernos en la conducción de los asuntos públicos como la educación y la desarticulación de esfuerzos en las áreas de evaluación de políticas y programas, la respuesta apuntaría al lado positivo. Habría que adoptar el enfoque. Este argumento se refuerza por algunas características que poseen las revisiones sistemáticas, que son el núcleo central del EPPBE. Una de estas características es que la evidencia se genera por medio de un proceso colectivo, abierto y con criterios explícitos para la selección de material y, por lo tanto, sujeto a constante refutación.

Asimismo, las revisiones sistemáticas son claras en su objetivo. Con estos ejercicios se desea saber qué programas o intervenciones educativas realmente funcionan en beneficio de los educandos. La dimensión de evaluación está claramente definida al momento de iniciar la elaboración de un ejercicio de este tipo.

Otro mérito observable del EPPBE es su énfasis en alentar el cambio educativo. Esta ventaja la comparte con otro tipo de epistemologías y enfoques como la evaluación facultativa (empowerment evaluation) (Fet-terman, 1996). Sin embargo, el EPPBE, como toda propuesta académica, también posee limitaciones y una de ellas es sugerir que la "evidencia" la constituyen sólo los efectos medibles originados por alguna intervención o programa educativo. Por ello, coincido con autores como Aguilar (2005); Majone, 2005; Head (2008, 2010), Moreles (2009) y Bracho (2010) en el sentido de que la evidencia científica debe ser complementada con otro tipo de información como la originada en los procesos de operación y en las esferas de la política (politics). Asimismo, es importante considerar a la evidencia científica como un incentivo para debatir cuál puede ser el instrumento de política más idóneo para hacerle frente al problema detectado. La evidencia, en este sentido, "adquiere un significado argumentativo en su uso político" (Bracho, 2010:331).

La experiencia mexicana también ha resaltado una de las limitantes a las que se pueden enfrentar enfoques como el EPPBE o metodologías como las revisiones sistemáticas. Aunque se diga que se produce evidencia de alta calidad con este tipo de ejercicios, su utilización en este país no depende de la calidad del conocimiento, sino de esquemas de interacción personal y humana mucho más complejos. Aun así, si el objetivo primordial es hacer que las políticas y los programas funcionen para lo que fueron diseñados y que el cambio de política sea fundamentado, habrá que seguir reflexionando sobre el papel de las ideas en nuestro mundo cotidiano, el cual supone "un desafío más grande para la ciencia del siglo XXI que el cosmos o el mundo de las partículas sub-nucleares" (Rees, 2003:169).

Agradecimientos

El autor agradece a los dos revisores anónimos que leyeron el texto e hicieron útiles comentarios. A los profesores Bette Chambers y Bob Slavin por haberlo recibido generosamente en el IEE de York y poder así estudiar el tema del uso del conocimiento en el ámbito educativo y escolar. A Eduardo Weiss, Jaime Moreles, Ana V. Ramírez, Luis G. Sosa Grajales y Gabriela Olmos por sus comentarios y correcciones a distintas partes del documento. A Dulce C. Mendoza por su crítica y apoyo para la recolección de material. El texto también incorporó matices y correcciones clave gracias a la discusión con los colegas del Núcleo de Investigaciones sobre Conocimiento y Política en Educación (NICPE) de Argentina y de la Red Latinoamericana de Estudios Epistemológicos en Política Educativa (RELEPE) como César Tello y Mariano Palamidessi.

Referencias

Aguilar, L. F. (2005). "Estudio introductorio", en Majone, G. Evidencia, argumentación y persuasión de la formulación de políticas, Ciudad de México: CNCPyAP/FCE. [ Links ]

Bracho, T. (2010). "Políticas públicas basadas en la evidencia. La política pública como acción informada y objeto de investigación", en Merino, M. y Cejudo, G. (comps.) Problemas, decisiones, soluciones. Enfoques de política pública, Ciudad de México: FCE/CIDE. [ Links ]

Bracho, T. (2011). "El papel de los valores en la evaluación de políticas para sistemas educativos complejos", Revista Mexicana de Investigación Educativa, 16, núm. 50, pp. 853-883. [ Links ]

Cohen, Louis; Manion, Lawrence y Morrison , Keith (2007). Research methods in education, Nueva York-Londres: Routledge. [ Links ]

Chambers, B. (2011). "Using systematic reviews to guide education policy and practice", presentación realizada en el XI Congreso Nacional de Investigación Educativa del COMIE, 10 de noviembre, Ciudad de México. [ Links ]

Davies, P. (2000). "The relevance of systematic reviews to educational policy and practice", Oxford Review of Education, vol. 26, núms. 3 y 4, pp. 365-378. [ Links ]

Dumont, H.; Istance, D y Benavides, F. (2010). The nature of learning: Using research to inspire practice, París: CERI-OCDE. [ Links ]

Fetterman, D. M. (1996). "Empowerment evaluation. An introduction to theory and practice", en Fetterman, D. M.; Kaftarian, S. J.; Wandersman, A. (cords.) Empowerment evaluation. Knowledge and tools for selfs assessment and accountability, Londres/ Nueva Delhi:SAGE. [ Links ]

Flores-Crespo, P. (2004). "Conocimiento y política educativa. Condiciones políticas y organizativas", Perfiles Educativos, volumen 26, números 105-106, pp. 73-101. [ Links ]

Flores-Crespo, P. (2009). "Investigación educativa y políticas públicas en México: una relación amorfa y elusiva", Sinéctica, 33, julio-diciembre, pp. 155-167. [ Links ]

Giddens, A. (2006). Sociology, Cambridge, Malden: Policy. [ Links ]

Green, J. y Marc Tucker (2011). Surpassing Shanghai: An agenda for American Education built on the World Leading Systems, Harvard: Harvard Education Press. [ Links ]

Head, B. W. (2008). "Three lenses of evidence-based policy", The Australian Journal of Public Administration, vol. 67(1), pp. 1-11. [ Links ]

Head, B. W. (2010). "Reconsidering evidence-based policy: Key issues and challenges", Policy and Society, 29, pp. 77-94. [ Links ]

INEE (2006). Plan Maestro de Desarrollo 2007-2014, Ciudad de México: INEE. [ Links ]

Latapí, P. (2008). Andante con brío. Memorias de mis interacciones con los secretarios de Educación (1963-2006), Ciudad de México: FCE. [ Links ]

Ley General de Desarrollo Social (LGDS, 2004). Disponible en: http://www.diputados.gob.mx/LeyesBiblio/pdf/264.pdf [ Links ]

Maggi, R. (2003). "Usos e impactos de la investigación educativa", en Weiss, E. (coord.) El campo de la investigación educativa, colección Estados de conocimiento, Ciudad de México: COMIE. [ Links ]

Majone, G. (2005). Evidencia, argumentación y persuasión de la formulación de políticas, Ciudad de México: CNCPyAP/FCE. [ Links ]

Maldonado, A. (2005). "Comunidades epistémicas: Una propuesta para estudiar el papel de los expertos en la definición de políticas en educación superior en México", Revista de la Educación Superior, vol. XXXIV (2), núm. 134, abril-junio, pp. 107-122. [ Links ]

Moreles, J. (2009). La investigación y la política. El caso de la evaluación de la educación superior en México, México: CUCSH-UAG. [ Links ]

Muñoz, C. (2004). Investigación educativa y toma de decisiones en América Latina y el Caribe, Documentos de Investigación 1, Ciudad de México: INIDE-UIA. [ Links ]

Muñoz, C.; Magaña, R.; Bravo, M. (2009). Valoración de la eficacia pedagógica de diversos programas orientados a mejorar el rendimiento escolar en las escuelas primarias y secundarias del Distrito Federal, Documento de investigación 6, Ciudad de México: INIDE-UIA. [ Links ]

OCDE-CERI (2004). National review on educational research anddevelopment. Examiners' Report on Mexico, París: OCDE-CERI. [ Links ]

Ogawa, R. y Malen, B. (1991). "Towards rigor in reviws of multivocal literaturas: Applying the exploratory case study method", Review of Educational Research, vol. 61, núm. 3, pp. 265-286. [ Links ]

Ornelas, C. (coord.) (2005). Buenas prácticas de educación básica en América Latina, Ciudad de México: ILCE. [ Links ]

Pawson, R. (2006). Evidence-based policy. A realist perspective, Londres: SAGE. [ Links ]

Popper, K. (2005). El mito del marco común. En defensa de la ciencia y la racionalidad, Barcelona: Paidós. [ Links ]

Rees, M. (2003). Nuestra hora final, ¿será el siglo XXI el último de la humanidad?, Barcelona: Drakontos. [ Links ]

Reimers, F. y McGin, N. (2000). Diálogo informado. El uso de la investigación para conformar la política educativa, traducción Maura Rubio, Ciudad de México: CEE-Ausjal. [ Links ]

Sen, A. (1999). Development as freedom, Oxford: OUP. [ Links ]

SEP (2005). Equidad, calidad e innovación en el desarrollo educativo nacional, Ciudad de México: FCE-SEP. [ Links ]

Stuttaford, M. (2004). Possibilities for and of Emancipatory Research Social Aspects of Ethnicity and Health: Research and Service Provision, presentación en la Universidad de Warwick, Inglaterra, 16 de junio. [ Links ]

Torgerson, C. (2003). Systematic reviews, Cornwall: Continuum. [ Links ]

Walter, I.; Nutley, S.; Davies, H. (2005). "What works to promote evidence-based practice? A cross-sector review", Evidence & Policy, vol. 1(3), pp. 335-63. [ Links ]

Zorrilla, M. (coord.) (2005). Hacer visibles buenas prácticas. Mientras el debate pedagógico nos alcanza, Ciudad de México: COMIE. [ Links ]

1 Tomo aquí una noción elemental de modernidad en la cual los asuntos públicos y de gobierno se nutren de un sistema abstracto y móvil como podría ser el conocimiento y no de la influencia directa y unilateral del rey o del sacerdote.

2 Si se desean conocer los determinantes del uso de la investigación en la política educativa de México, se puede consultar la revisión realizada por Rolando Maggi (2003) en los estados de conocimiento del Consejo Mexicano de Investigación Educativa (COMIE).

3 Tomo esta traducción de Maura Rubio.

4 Estoy consciente de que existe otro tipo de revisiones como las de literatura multivocal, las cuales, según Ogawa y Malen (1991), se constituyen con toda clase de escritos sobre un tema en particular y con los puntos de vista de autores diversos tales como académicos, practicantes, periodistas, centros de política o think tanks, oficinas gubernamentales, etcétera. Estos textos, prosiguen Ogawa y Malen (1991), son presentados en formatos diversos, con perspectivas y propósitos variados y están tomados de bases de datos distintas. Este tipo de revisiones, útiles para pensar en la pluralidad de información, que se utilizan al momento construir evidencia no son foco central de atención para este escrito.

5 Me refiero a Consort (Consolidated Stan-dards for Reporting Trials).

6 La Cochrane Collaboration surgió en 1993 y tiene como propósito producir y difundir revisiones sistemáticas sobre intervenciones en el área de salud. Asimismo, promueve la búsqueda de la evidencia científica en forma de pruebas clínicas y otro tipo de estudios (www.cochrane.org)

7 Para mayor información, véase, http://www.bestevidence.org.uk/index.html

8 Carole Torgerson, en una comunicación personal en 2011, refiere al EPPI del Instituto de Educación de la Universidad de Londres en el Reino Unido como una institución que está realizando este tipo de esfuerzos.

9 La falta de rigor científico en la selección de las "buenas prácticas" ha sido debatida por diversos autores, entre ellos Jay Green y Marc Tucker (2011). Agradezco al doctor Carlos Muñoz Izquierdo el haberme acercado a esta información.