Servicios Personalizados

Revista

Articulo

Indicadores

-

Citado por SciELO

Citado por SciELO -

Accesos

Accesos

Links relacionados

-

Similares en

SciELO

Similares en

SciELO

Compartir

Revista mexicana de investigación educativa

versión impresa ISSN 1405-6666

RMIE vol.17 no.52 Ciudad de México ene./mar. 2012

Investigación

Identificación de predictores para el aprendizaje efectivo en línea: Un modelo de ecuaciones estructurales

Identification of Predictors for Effective Online Learning: A Model of Structural Equations

Eduardo Peñalosa Castro*, Sandra Castañeda Figueras**

* Profesor investigador en el Departamento de Ciencias de la Comunicación de la División de Ciencias de la Comunicación y Diseño de la Universidad Autónoma Metropolitana–Cuajimalpa. Av. Constituyentes 1054, colonia Lomas Altas, 11950, México, DF. CE: eduardo.peñalosa@gmail.com

** Profesora investigadora en el Laboratorio de Desarrollo Cognitivo e Innovación Tecnológica del Departamento de Posgrado de la Facultad de Psicología, de la Universidad Nacional Autónoma de México, CE: sandra@servidor.unam.mx

Artículo recibido: 16 de febrero de 2011

Dictaminado: 30 de mayo de 2011

Aceptado: 1 de julio de 2011

Resumen:

El objetivo de este trabajo fue poner a prueba un modelo que integró una serie de predictores del aprendizaje efectivo en línea de estudiantes que realizaron un curso de licenciatura en psicología. Los constructos que integraron el modelo fueron: 1) el conocimiento previo, 2) la interactividad y 3) las habilidades de aprendizaje autorregulado. Se probó el ajuste del modelo con base en un análisis de Modelamiento por Ecuaciones Estructurales y se obtuvieron índices satisfactorios (parámetros de ajuste en la unidad final: x2=157.25; p>=0.20; CFI=.97; RMSEA=0.03). El trabajo discute la necesidad de continuar con investigaciones que agreguen elementos para la comprensión del aprendizaje en entornos mediados tecnológicamente, en un momento histórico en el cual se requieren soluciones flexibles para ampliar la cobertura educativa con calidad y eficiencia, ante la adopción irreflexiva y pragmática de soluciones no exitosas.

Palabras clave: educación a distancia, aprendizaje, conocimientos previos, interactividad, aprendizaje autorregulado, educación superior, México.

Abstract:

The objective of this study was to test a model that included a series of predictors of effective online learning in an undergraduate psychology course. The model's constructs were: 1) previous knowledge, 2) interactivity, and 3) self–regulated learning skills. The testing of the model's fit, based on Structural Equation Modeling, obtained satisfactory indexes (parameters in the final unit: x2= 157.25; p>=0.20; CFI=.97; RMSEA=0.03). The article discusses the need to continue performing studies that contribute to understanding learning in technological settings. At this moment in history, flexible solutions are needed in order to broaden educational coverage with quality and efficiency, in light of the unreflective, pragmatic adoption of unsuccessful solutions.

Key words: distance learning, learning, previous knowledge, interactivity, self–regulated learning, higher education, Mexico.

Introducción

En los últimos años el uso de tecnologías de cómputo e Internet como apoyo en la educación superior ha crecido de manera importante, especialmente en modalidades a distancia o mixtas. Sin embargo, el avance en este tipo de oferta educativa no ha tenido un desarrollo similar en la comprensión teórica de la forma en que se presentan los procesos de aprendizaje en entornos de Internet. Existen opiniones que plantean que el aprendizaje en línea podría tener condiciones especiales (Ally, 2004; Eom, y Wen, 2006), y entre éstas destacan: a) la autonomía o capacidad de aprendizaje autorregulado de los estudiantes, que es relevante para conducir su propio aprendizaje en estos entornos (Azevedo y Cromley, 2004); b) las condiciones de interactividad de los medios disponibles en entornos en línea (Taylor, 1995; García Aretio, 2001), y c) las circunstancias que permiten cimentar el conocimiento nuevo sobre la base de conocimiento previo sólido, bien fundamentado (Glaser, 1996; Castañeda, 2004b). En este trabajo se pone a prueba un modelo que explica el aprendizaje en línea a partir de la contribución de estos elementos.

Las condiciones de mediación tecnológica del aprendizaje se agrupan, históricamente, en cuatro generaciones: a) por correspondencia, b) multimedia, c) teleaprendizaje, y d) aprendizaje flexible en internet (Taylor, 1995; García Aretio, 2001). Esta última se caracteriza por la integración de todos los medios, la multimedia interactiva, el acceso a recursos de información y comunicación a través de la red Internet. Taylor (1995) plantea que en esta generación, además de la flexibilidad para el aprendizaje en tiempo, lugar y ritmo, existe una alta interactividad que puede abatir costos. La describe como "una expansión en la disponibilidad de un amplio rango de tecnologías con el potencial de mejorar la enseñanza y el aprendizaje" (p. 2), y hace énfasis en que las tecnologías tradicionales se complementan con mayor interactividad y acceso a recursos instruccionales ofrecidos por la computadora y el Internet.

Empero, a pesar de la reconocida potencialidad de los medios tecnológicos disponibles en la actualidad, existe cierta insatisfacción por parte de especialistas en el campo debido a la ausencia de investigación sistemática y de calidad como base para la elaboración de teorías maduras acerca del aprendizaje en entornos de Internet. Se reporta que esta situación ha conducido a esquemas de actuación por ensayo y error (Keegan, 1986), a la generación de investigaciones que presentan deficiencias metodológicas (Phipps y Merisotis, 1999), que no se ha dado a la tarea de proponer y demostrar teorías y constructos (Lockee, Moore y Burton, 2002; Holmberg, 2004) con preguntas de investigación que, rara vez, se basan en un marco teórico que articule conceptos y constructos fundamentales (Saba, 2000). Esta serie de críticas plantea la necesidad de una teoría del aprendizaje en Internet en función de las nuevas posibilidades de interacción y de los avances en las concepciones actuales acerca del aprendizaje (Garrison, 2000). En pocas palabras, los argumentos anteriores sugieren la necesidad de realizar esfuerzos para la construcción de teoría en el campo del aprendizaje en línea. En este trabajo se presenta un modelo que propone y prueba una estructura teórica que da cuenta de estos procesos.

Revisión de algunos elementos para una teoría del aprendizaje en línea

A pesar de las limitaciones citadas, al realizar un esfuerzo de integración de la literatura especializada podemos reconocer seis grupos de ideas teóricas que se han propuesto para explicar el aprendizaje en línea: 1) el aprendizaje en línea es un proceso activo, centrado en el aprendiz, en el conocimiento, en la comunidad y en la evaluación (Bransford, Brown y Cockings, 2004; Anderson, 2004); 2) internet reúne capacidades de todos los demás medios y podría propiciar condiciones especiales para el aprendizaje (Kozma, 1994); 3) el aprendizaje es un proceso de construcción de conocimiento sobre la base del disponible, derivado del contacto de los estudiantes con otros agentes propios de estos entornos (Glaser, 1996; Glaser y Baxter, 2000; De Corte, 1999; Castañeda, 1998; Castañeda, 2004a; 2004b; 2006); 4) la interactividad es central en este tipo de procesos (Peñalosa y Castañeda, 2010); 5) el aprendizaje en línea requiere de habilidades de autorregulación (Narciss, Proske y Kórndle, 2007; Dembo, Jung y Lynch, 2006; Azevedo, Cromley, Seibert y Tron, 2003; Azevedo y Cromley, 2004; Azevedo, Cromley, Winters, Moos y Greene, 2006); y 6) el diseño instruccional es un ingrediente fundamental que ordena las condiciones para aprender y, a diferencia de la instrucción presencial, en la educación en línea las fortalezas y debilidades de las tecnologías requieren de una mezcla diferente de métodos instruccionales (Reigeluth, 2005; Schwartz, Brophy, Lin y Bransford, 1999; Ally, 2004).

Necesidad de estructuración teórica

A pesar de que algunos autores han intentado proponer ciertos elementos para estructurar el campo teórico del aprendizaje en línea (Ally, 2004; Anderson, 2004; Reigeluth, 2005), existen críticas que plantean que, en la incipiente literatura de investigación acerca de este tema, la mayoría de los estudios han sido hipotéticos o descriptivos (Sadik, 2003) y, por lo tanto, no han contribuido de manera sustancial a una estructura teórica que explique estos procesos.

Una alternativa para la prueba de teorías es el modelamiento de ecuaciones estructurales, que ofrece una serie de procedimientos que permiten representar constructos teóricos mediante variables latentes; esto es, no observadas directamente sino inferidas a partir de la manifestación de otras variables. Un modelo de ecuaciones estructurales hace posible el contraste empírico de la estructura de los datos observados con la estructura teórica de las relaciones postuladas y, en tanto, permite al investigador utilizar una o más variables como representativas de constructos latentes independientes o dependientes, y estimar la confiabilidad. "El investigador puede evaluar la contribución de cada variable indicadora manifiesta, e interpretar la medida en la que estas variables indicadoras miden los conceptos" (Marks, Sibley y Arbaugh, 2005:533). Aun cuando existen críticas a los modelos de ecuaciones estructurales, como el riesgo de incurrir en una falta de generalidad, en general han propiciado avances en el conocimiento sustantivo de la psicología (MacCallum y Austin, 2000).

Bazán y Corral (2001) describen que el modelamiento de ecuaciones estructurales se compone por dos modelos complementarios: a) el estructural, que permite establecer el grado de relación entre variables que pueden ser latentes y/u observadas, como los análisis de trayectorias y el análisis de regresión, y b) el de medición, que especifica qué variables observadas definen a un constructo y reflejan el grado en el que éstas evalúan a las variables latentes en términos de confiabilidad y validez (Schumacker y Lomax, 1996). Ejemplos del modelo de medición son los análisis factorial exploratorio y factorial confirmatorio (Bazán, Félix y Gaviño, 2006).

El modelamiento estructural se ha utilizado extensamente en psicología, tanto en investigaciones observacionales como experimentales, donde han destacado la aplicación de casos como los análisis de senderos para medir relaciones entre variables manifiestas, y el análisis factorial, para medir las relaciones entre variables latentes y sus variables manifiestas y en tanto validar constructos teóricos que componen los diferentes modelos (MacCallum y Austin, 2000).

En relación con la temática del presente trabajo, Bazán, Félix y Gaviño (2006) describen que en México, en el estudio de interacciones y procesos educativos han sido los psicólogos que trabajan desde la perspectiva de la cognición, en grupos liderados por Sandra Castañeda, Javier Aguilar y Daniel González, quienes han aportado ya una base importante de conocimiento teórico utilizando metodologías de modelamiento de ecuaciones estructurales. Esta tradición mexicana del modelamiento estructural para el estudio del aprendizaje ha conducido al esclarecimiento teórico de procesos de interés en psicología educativa como la lectura en diferentes niveles de complejidad (Bazán, y Corral, 2001; Bazán y García, 2002; Bazán, García y Borbón, 2005; Bazán, Sánchez, Corral y Castañeda, 2005); el análisis de validez y confiabilidad en exámenes objetivos a gran escala (Castañeda, González y Várela, 2006; Castañeda, Bazán, Sánchez y Ortega, 2004) o la prueba de modelos en relación con habilidades autorregulatorias, incluidas las estrategias, la motivación y la metacognición (Castañeda y Ortega, 2004; Aguilar, Valencia, Martínez y Vallejo, 2002; González y Maytorena, 2002).

Por otro lado, en relación con el tema central de análisis en el presente trabajo, existen contados estudios que evalúan modelos estructurales del aprendizaje en línea. Reportes específicos que pueden servir como referencia de lo que se ha investigado bajo este enfoque son: un texto sobre un modelo de ecuaciones estructurales como predictores para el aprendizaje efectivo en línea (Marks, Sibley y Arbaugh, 2005); otro que evaluó un modelo para comprender la relación entre la interacción colaborativa en línea y los resultados de aprendizaje (LaPointe y Gunawardena, 2004), y un tercero que utilizó un modelo de ecuaciones estructurales para identificar determinantes de la satisfacción de estudiantes en cursos en línea (Eom y Wen, 2006).

Marks, Sibley y Arbaugh (2005) intentaron validar un modelo basado en seis hipótesis acerca de los factores que explican la satisfacción de alumnos en contextos de aprendizaje en línea, que valoraban: 1) la influencia de la flexibilidad del ambiente en línea; 2) el impacto de interacciones alumno–tutor; 3) la influencia de la colaboración; 4) la influencia de los materiales didácticos; 5) las características personales como edad, género y promedio en exámenes de ingreso, y 6) la experiencia previa en cursos en línea. El estudio se condujo con una muestra compuesta por estudiantes de diferentes cursos, por lo que la medida de desempeño no pudo ser tomada directamente. En su lugar, se desarrolló un instrumento que se aplicó a todos por igual, en el cual la variable dependiente era la satisfacción reportada por los estudiantes. El instrumento, que presentaba opciones en una escala tipo Likert de siete puntos, incluyó reactivos que se agruparon en factores que medían los aspectos relacionados con las seis hipótesis que, a su vez, fueron derivadas de una revisión de la literatura. Una vez obtenidos los datos, los autores realizaron un análisis factorial confirmatorio para identificar las cinco variables latentes: aprendizaje percibido, actividades estudiante–tutor, actividades estudiante–estudiante, ventajas del estudio en línea y satisfacción. La variable satisfacción fue eliminada del modelo por influir negativamente en el ajuste, y se dejó como única variable endógena (dependiente) el aprendizaje percibido. Los resultados demuestran que las hipótesis cuatro a seis no tienen una influencia estadísticamente significativa en el modelo, y las hipótesis uno a tres sí explican con significatividad estadística la variable endógena estudiada (aprendizaje percibido), con lo cual los autores concluyen que la flexibilidad de los ambientes en línea, la interacción con tutores y, sobre todo, con compañeros en menor medida, explican el aprendizaje en línea de manera principal.

En otro de los estudios mencionados, LaPointe y Gunawardena (2004) se propusieron identificar elementos de un modelo que explicara el aprendizaje colaborativo en línea. Partiendo de la incertidumbre acerca de si las interacciones colaborativas en línea facilitan resultados de aprendizaje profundo en los alumnos, contrastaron empíricamente un modelo con cinco constructos derivados de una revisión extensa de la literatura acerca de la interacción entre pares y sus resultados de aprendizaje. Los cinco constructos predictores fueron: 1) características individuales de los estudiantes; 2) estilo de enseñanza percibido; 3) diseño de las tareas; 4) requerimientos del curso, y 5) experiencia previa en aprendizaje colaborativo. Cada constructo se midió utilizando un instrumento especial. Las variables criterio o dependientes fueron dos: interacción percibida con compañeros, y resultados de aprendizaje reportados, ambas medidas mediante instrumentos de autorreporte. Los autores aplicaron modelos de ecuaciones estructurales siguiendo el enfoque de dos pasos de Kline (1998): estimar los modelos de medición de los constructos y sus indicadores, evaluando el ajuste de cada modelo de forma separada, y ensamblar todos los constructos y sus indicadores y probar las relaciones estructurales entre constructos.

Al ejecutar el modelo estructural se tuvieron que realizar modificaciones debido a que algunas variables latentes no permitían que el modelo se ajustara.

Se eliminaron los constructos: características individuales, debido a que la carga factorial del instrumento no coincidió con la propuesta y diseño de la tarea, por problemas de confiabilidad entre los observadores que analizaron las muestras de los contenidos de estas tareas. Aun eliminando estos constructos, después de correr el modelo se decidió eliminar uno más: requerimientos del curso. De esta manera, LaPointe y Gunawardena llegaron a un modelo que explica la interacción entre pares y el autorreporte de aprendizaje con base en el estilo percibido de enseñanza y la experiencia previa en colaboración.

Eom y Wen (2006) aplicaron un modelo de ecuaciones estructurales para identificar los determinantes de la satisfacción de estudiantes acerca de sus logros de aprendizaje en cursos en línea. Estos autores generaron un cuestionario que evaluó las siguientes variables: la estructura del curso, la retroalimentación del tutor, la motivación, el estilo de aprendizaje y la interacción como predictoras de la satisfacción y encontraron que todas las variables afectaron la percepción de resultados de aprendizaje, aunque solamente la retroalimentación del tutor y el estilo de aprendizaje resultaron significativas.

De los estudios reseñados, pueden identificarse algunos de los constructos que se han planteado en la incipiente teoría del aprendizaje en línea: la interactividad, la naturaleza del ambiente de aprendizaje, el diseño instruccional (estilo percibido de enseñanza) y la experiencia previa en aprendizaje colaborativo. Acerca de estos estudios, cabe mencionar que las estrategias de medición de los constructos limitan la validez de los mismos. Si bien podemos tener algunas medidas de autorreporte como referencia, parecería pertinente tener medidas directas del desempeño, y no sólo apreciaciones de satisfacción de los estudiantes.

Propósito

Por lo anterior, en el presente estudio proponemos evaluar un modelo que considera los siguientes constructos como responsables del aprendizaje en línea:

1) Los procesos de interactividad, medidos de manera directa, como datos del desempeño de actividades conjuntas entre agentes del entorno de aprendizaje en línea (alumno–materiales o alumno–compañeros, alumno–tutor), a partir de un análisis de las acciones recíprocas entre ellos en un curso en línea, que da como resultado un índice de interactividad derivado de la frecuencia y la calidad de las interacciones.

2) Las habilidades de aprendizaje autorregulado de los alumnos, a partir de dos medidas: a) autorreporte, obtenida mediante la aplicación de un instrumento validado que mide estrategias de aprendizaje y autorregulación (EDAOM), y b) ejecución, evaluada a partir del registro de una serie de acciones realizadas por los estudiantes en el ambiente de aprendizaje, que les permiten plantear y revisar metas, monitorear su desempeño académico, tomar notas de los temas en revisión, agendar eventos y consultar recursos.

3) El conocimiento previo. Dada la importancia de la estructura de conocimientos disponibles para la construcción de conocimiento nuevo, es importante evaluar cuál es el impacto de lo que los alumnos van aprendiendo a lo largo de un curso, ya que mientras más completa sea la estructura de conocimientos, más fácilmente se construyen nuevos significados.

Los constructos anteriores: interactividad, autorregulación (como autorreporte y como ejecución), así como el conocimiento previo, podrían contribuir a la explicación del constructo desempeño, que se compone por los indicadores derivados de evaluaciones construidas con base en una metodología fundamentada en el análisis cognitivo de tareas (Castañeda, 2002; 2004a; Peñalosa y Castañeda, 2009), validadas por jueces, piloteadas y calibradas antes de su uso en el presente estudio.

Acerca de la diferenciación entre los constructos de autorregulación como autorreporte y como ejecución, aun cuando se refieren al mismo complejo de procesos cognitivos, las mediciones son diferentes en cuanto a que en la autorregulación, como reporte, se está midiendo una aptitud puntual de los estudiantes y, como ejecución, se mide un evento concreto, según la distinción que hacen Winne y Perry (2000), quienes exponen que un instrumento que mide el aprendizaje autorregulado como una aptitud describe cualidades y atributos relativamente estables y puede permitir cierta predicción. Los instrumentos de evaluación de la autorregulación, como evento, incluyen una serie de medidas directas de los estados y procesos por los que pasa el estudiante mientras se autorregula. Para efectos de la evaluación del impacto de la autorregulación en el aprendizaje en línea, este constructo se divide en dos variables latentes, como se describe más adelante. Ambas se refieren al mismo constructo, pero toman datos de diferentes facetas del mismo: una es un reporte que permite clasificar y predecir el comportamiento del estudiante y la otra es el rastreo del proceso en sí mediante la observación de su desempeño por parte del estudiante. Ambas medidas permitirán describir de una forma más completa al fenómeno de la autorregulación de los estudiantes.

La figura 1 muestra el modelo que propone la relación entre constructos que desea evaluar en el presente estudio.

Pregunta de investigación

De esta forma, en el presente estudio se plantea el cuestionamiento: ¿existe un modelo efectivo que permita explicar el desempeño de los estudiantes en una situación de aprendizaje en línea? Y, en ese caso, ¿son los constructos representados en la figura 1 (interactividad, autorregulación percibida, autorregulación como desempeño y conocimiento previo), un modelo efectivo de las relaciones complejas que influyen a las ejecuciones de desempeño en el aprendizaje en línea?

Variables del modelo

El modelo de la figura 1 puede desglosarse para identificar sus componentes. Son cuatro constructos predictores; a) interactividad, b) autorregulación como reporte, c) autorregulación como ejecución, d) conocimiento previo; y un constructo criterio: el desempeño académico como ejecución en pruebas. Cada constructo es una variable latente, derivado de la medición de múltiples variables; a continuación se describe cada uno.

Nivel de interactividad

La interactividad, como dato, se obtiene en este estudio de las actividades conjuntas realizadas por los alumnos y otros agentes de un ambiente de aprendizaje en línea desarrollado ex profeso para la investigación de estos procesos de aprendizaje, llamado Meta–Tutor (Peñalosa y Castañeda, 2007; 2008b). Para el estudio de la interactividad instruccional consideramos fundamentales dos niveles de análisis: la estructura del diseño y la dinámica funcional de las interacciones.

La estructura instruccional es el esquema general del curso en el que el alumno participa, que establece las condiciones para las actividades dirigidas al aprendizaje. El diseño instruccional utilizado en este trabajo incluye cinco etapas que están presentes en la mayoría de estos modelos reportados en la literatura (Merrill, 2002; 2009): 1) activación del conocimiento previo; 2) planteamiento de un problema central para el aprendizaje; 3) demostración del conocimiento mediante exposiciones, lecturas, acceso a medios, indagación; 4) aplicación del conocimiento mediante actividades y ejercicios pertinentes a los niveles de complejidad que se pretenda fomentar, y 5) integración del conocimiento, mediante actividades de reflexión, creatividad o transferencia de los conocimientos.

La dinámica funcional de las interacciones se da al interior de cada una de las etapas instruccionales descritas e incluyen: a) una demanda de acción a un estudiante, derivada de una actividad de aprendizaje; b) una serie de acciones del estudiante para satisfacer la demanda, que deben ser coherentes con el nivel de complejidad de la misma; c) una o más acciones de andamiaje que pueden asumir diferente forma y complejidad, que soportan el aprendizaje, y d) el ajuste del desempeño de acuerdo con el andamiaje.

En este trabajo, y en consonancia con otro estudio (Peñalosa y Castañeda, 2010), la interactividad es un valor numérico que resultó de un cálculo expresado que se describe más adelante, en la sección de Método de este trabajo (ver ecuación 1).

Autorregulación como reporte

Se incluyó en el modelo teórico el concepto de autorregulación tal como se evalúa en el instrumento de Estrategias de Aprendizaje y Orientación Motivacional al Estudio (EDAOM, Castañeda y Ortega, 2004). Este instrumento cuenta con cuatro escalas principales: I) estilos de adquisición de la información; II) estilos de recuperación de la información; III) estilos de procesamiento, y IV) estilos de autorregulación metacognitiva y metamotivacional. Ha sido utilizado extensamente en México para evaluar el nivel de dominio de estrategias de aprendizaje y autorregulación de estudiantes del nivel superior (González y Maytorena, 2009).

Autorregulación como ejecución

Estos datos se obtuvieron de las acciones de autorregulación como ejecución por parte del alumno, disponibles en el ambiente de aprendizaje, que incluía el planteamiento, monitoreo, valoración y ajuste de metas; el automonitoreo del desempeño por parte del alumno; el almacenamiento de notas del material en revisión; el uso de una agenda para asentar y comentar actividades de aprendizaje y el acceso a recursos útiles para el proceso de estudio.

Conocimiento previo

En función de la unidad en la que se encontrara el alumno (el curso reportado en este estudio tenía tres en total), siempre existían algunas medidas de conocimiento previo, que eran los resultados de las evaluaciones realizadas en las unidades anteriores. De esta forma, cuando el estudiante se encontraba estudiando la unidad 1, el conocimiento previo era el pretest; cuando se encontraba estudiando la unidad 2, el pretest y el resultado de la unidad 1; cuando estudiaba la unidad 3, el pretest, el resultado de la unidad 1 y el resultado de la evaluación de la unidad 2.

Desempeño

Se contó con cuatro evaluaciones en el curso: pre–postest, evaluación de la unidad 1, de la unidad 2 y de la unidad 3– Las evaluaciones fueron validadas y calibradas según se reporta en otro trabajo (Peñalosa y Castañeda, 2009), y arrojaban siempre datos que estaban en una escala de 0 a 10.

Método

El modelo evaluado en este estudio fue diseñado a priori después de una revisión exhaustiva de literatura acerca del aprendizaje en línea, y se basó en algunas premisas que se consideraron fundamentales en dicha revisión, cuyas ideas centrales se resumen en la parte inicial de este estudio.

Participantes

Fueron 101 estudiantes de 5º y 6º semestres de la carrera de psicología de la Facultad de Estudios Superiores Iztacala de la Universidad Nacional Autónoma de México, 64 mujeres y 37 hombres, con edad promedio de 20–27 años.

Procedimiento

Los participantes realizaron un curso en línea de psicología clínica teórica correspondiente al 6º semestre del plan de estudios de la carrera de psicología de la FES Iztacala. Se generó el modelo teórico de la figura 1 y, posteriormente, se tomaron los datos de los diferentes instrumentos y se analizaron como se describe a continuación.

Materiales

El curso se basó en el temario autorizado por el área de psicología clínica de la facultad. Todos los contenidos se desarrollaron con base en el programa oficial, así como en una antología didáctica impresa que incluye el programa y las lecturas seleccionadas, disponible en la librería del campus. Para contrastar el modelo teórico mediante un análisis de ecuaciones estructurales, se utilizó el programa de modelamiento estructural EQS versión 6.1 para Windows (EQS, 2007), distribuido por Multivariate Software.

Instrumentos

Con base en la estructura del curso, se realizó un análisis cognitivo de tareas (Peñalosa y Castañeda, 2009), que permitió identificar los contenidos y habilidades cognitivas necesarias para cumplir con los objetivos. Este análisis fue necesario para desarrollar el diseño instruccional y las evaluaciones.

Se construyeron cuatro instrumentos de evaluación académica: 1) pre post test; 2) evaluación de la unidad 1: introducción a la aproximación cognitivo conductual en psicología clínica; 3) evaluación de la unidad 2: la evaluación cognitivo conductual, y 4) evaluación de la unidad 3: el análisis funcional. Los instrumentos se validaron en cuanto a contenidos mediante jueceo, y se calibraron utilizando los programas ITEMAN (1993) y RASCAL (1994). De esta forma se conformaron evaluaciones confiables, consistentes y válidas, que permitieron la identificación de niveles de complejidad cognitiva y de conocimientos.

El diseño instruccional se desarrolló de acuerdo con los principios propuestos por Merrill (2002; 2009), considerando: a) activar el conocimiento disponible; b) el planteamiento de problemas o casos para conducir el proceso instruccional; c) la demostración del conocimiento; d) la aplicación del conocimiento, y e) la facilitación de la integración del conocimiento, permitiendo a los estudiantes la solución de problemas equivalentes a los de la instrucción en contextos diferentes. Un documento de diseño instruccional mostraba las condiciones y actividades de aprendizaje a desarrollar en cada una de las fases mencionadas.

Las interacciones de aprendizaje propiciadas por el sistema eran de tres tipos: con materiales, con compañeros y con un tutor en línea. Cada una de estas actividades, así como materiales, ejercicios y lecturas fueron incluidos en el documento de diseño instruccional, indicando, en cada caso, los materiales a emplear.

Además de los instrumentos de evaluación del desempeño, se utilizó el inventario de Evaluación de Estrategias de Aprendizaje y Orientación Motivacional al Estudio (EDAOM) y, adicionalmente, se registraron la autorregulación como ejecución y la interactividad.

Meta–Tutor

El Meta–Tutor (Peñalosa y Castañeda, 2007; 2008b) es un ambiente de aprendizaje desarrollado por los autores de este trabajo con la finalidad de realizar investigación acerca de procesos de aprendizaje en línea en educación superior. En una sesión típica, los estudiantes ingresaban a la dirección del sistema tecleando su usuario y contraseña y, al entrar, dependiendo de la programación de actividades determinada por la condición experimental de cada participante, encontraban diversos componentes de aprendizaje como cursos, ejercicios, materiales de lectura, áreas de colaboración y áreas de tutoría en línea.

El Meta–Tutor llevaba el registro del desempeño de los estudiantes y permitía el acceso a los siguientes eventos instruccionales:

• Tutoriales interactivos. Desarrollados con Adobe Flash*, estos materiales se basaban en los objetivos derivados del análisis de tareas, e incluían presentación de contenidos, ejercicios, auto evaluaciones y retroalimentación del desempeño.

• Áreas de colaboración. El sistema presentaba algunas actividades que debían ser desarrolladas de manera colaborativa, donde de 8 a 10 estudiantes (al azar se conformaban equipos) eran expuestos a actividades guiadas por casos o problemas a resolver. Las actividades colaborativas se incluían en el ambiente de aprendizaje para promover el procesamiento grupal de la información, discusión en línea y solución de problemas colaborativa.

• Actividad tutorial. En un área diseñada para este efecto, un tutor experto se comunicaba individualmente con cada uno de los alumnos asignados a esta condición, le informaba acerca de sus actividades, supervisaba y daba andamiaje, en una situación estructurada por una serie de pasos a resolver por el alumno con su apoyo. El tutor en línea era un profesor e investigador experto en psicología clínica, con 25 años de experiencia docente en este tema.

El curso incluyó tres unidades y, en cada una, una tercera parte eran sometidos a una modalidad instruccional diferente (con materiales, con tutor y con compañeros), y en las siguientes unidades se exponían a las otras modalidades, de manera que todos los participantes se expusieron a las tres. Cabe mencionar que se ha demostrado que el efecto de exponer a los estudiantes a modalidades de aprendizaje diferentes, cuando se conserva constante el diseño instruccional, no conduce a diferencias significativas en el desempeño en línea (Peñalosa y Castañeda, 2008a).

Adicionalmente, el Meta–Tutor tenía un área en la que se permitía a los estudiantes realizar las siguientes acciones de aprendizaje autorregulado: a) establecer metas de aprendizaje; b) auto–evaluar el cumplimiento de metas; c) tomar notas en línea de las actividades realizadas; d) programar actividades en una agenda; e) consultar recursos de aprendizaje y f) auto monitorear el desempeño.

El área de aprendizaje principal del Meta–Tutor incluía, en la zona izquierda de la pantalla, actividades de aprendizaje para la unidad temática en revisión, con seis vínculos, que conducían a: 1) una guía del aprendizaje de la unidad; 2) antecedentes del tema (activación del conocimiento previo); 3) introducción al tema y planteamiento de casos o problemas (principio de aprendizaje basado en problemas); 4) explicación del tema (principio de demostración); 5) auto evaluaciones y ejercicios (principio de aplicación), y 6) actividad de integración (principio de integración).

En este contexto, se tenía acceso a los recursos de aprendizaje necesarios para el trabajo en la unidad, incluyendo todas las lecturas digitalizadas, ejercicios, acceso a áreas tutoriales, de colaboración, etcétera.

Es importante mencionar que, independientemente de la modalidad interactiva que mediara el aprendizaje de los estudiantes, las seis actividades que se enumeraron anteriormente siempre se realizaban, y en ese orden. La diferencia estribaba en que estas actividades eran realizadas por el estudiante —de acuerdo con el diseño experimental— ante un programa interactivo automatizado (modalidad de interacción estudiante–material), ante situaciones de trabajo colaborativo en línea (estudiante–estudiante) o ante un profesor en línea (estudiante–profesor).

Las interacciones con materiales se realizaron en la plataforma, en la cual se presentaban a los estudiantes objetos instruccionales interactivos (desarrollados con Flash*), que presentaban información y propiciaban la interacción, y el sistema registraba en una bitácora accesible a los investigadores las acciones realizadas. Las interacciones con compañeros y con el tutor en línea se realizaban en un espacio interactivo asincrónico, en el cual se presentaban materiales y actividades de aprendizaje y también se registraban los intercambios comunicativos textuales de los agentes. Los estudiantes realizaron en promedio 504 interacciones en cada unidad.

Las interacciones con materiales se registraban automáticamente en la plataforma, y las que se realizaban con compañeros y tutor se analizaron por parte de dos codificadores, quienes se reunieron, cada uno con las impresiones de sus hojas de registro, su hoja de participaciones y las tablas de criterios de codificación. Leían al azar 150 de las 504 interacciones de cada unidad y, en una hoja adicional, asentaban si tenían acuerdo en la codificación. Al final, se calculó el índice de confiabilidad con base en la fórmula propuesta por Haynes (1978): (acuerdos/(acuerdos+desacuerdos)).

Por otro lado, las funciones de aprendizaje autorregulado siempre eran administradas por el ambiente de aprendizaje, de manera constante. En términos generales, los participantes fueron sometidos a la solución de tareas en las siguientes etapas: pretest, unidad 1, evaluación 1, unidad 2, evaluación 2, unidad 3, evaluación 3 y postest.

Evaluación del desempeño

Para la construcción de los instrumentos, se utilizó como fuente de contenido una antología de la asignatura de psicología clínica teórica n, desarrollada por un grupo de 12 profesores del área de psicología clínica de la carrera de psicología de la FES Iztacala–UNAM. La antología incluye dos volúmenes impresos: el primero es una guía didáctica que contiene una introducción a la asignatura, así como introducciones a cada una de las tres unidades didácticas que la componen. En cada unidad se mencionan las referencias bibliográficas y se realiza una breve reseña de cada lectura. El segundo volumen es una recopilación que integra reproducciones de todas las lecturas incluidas en el curso, agrupadas por unidad. Las unidades del curso son: Introducción a la aproximación cognitiva conductual, con dos lecturas; La evaluación cognitivo–conductual, con tres lecturas, y El análisis funcional, con tres lecturas.

Todas las evaluaciones se realizaron en línea, los estudiantes tenían acceso a las mismas de acuerdo con un cronograma del curso, los vínculos para ejecutarlas aparecían en función de esta programación cuando los estudiantes firmaban su usuario y contraseña en el ambiente de aprendizaje.

Cada una de las evaluaciones se construyó siguiendo el mismo procedimiento: en primera instancia, se realizó un análisis cognitivo de tareas mediante el cual se generó una lista de contenidos a evaluar, que incluía conocimientos y habilidades cognitivas que componían el dominio académico. Este análisis inició con la identificación de los objetivos de cada tema y, a partir de estos, la detección de la complejidad de las habilidades cognitivas necesarias para cumplir con los objetivos, y la identificación de los modelos mentales que dan cuenta del tipo de conocimiento de esta unidad.

Los objetivos de las tres unidades se retomaron de la guía didáctica y de la antología del curso. Los modelos mentales incluidos en los objetivos se determinaron a partir de la propuesta de Van Merrienbóer, Clark y De–Crook (2002), que identifican tres tipos de modelos mentales: conceptual, estructural y causal, donde el conceptual, responde a la pregunta: "¿qué es esto?", y que describe el significado del fenómeno o tema, y la interrelación de los elementos que lo componen; el estructural, que responde a: "¿cómo está estructurado esto?", y que cuenta cómo es la organización del campo conceptual en cuestión; y el causal, que responde a la pregunta: "¿cómo funciona esto?", y que refiere cómo los principios se afectan entre sí y ayudan a interpretar procesos, dar explicaciones de eventos y realizar predicciones. Por otro lado, la complejidad cognitiva se clasificó en tres niveles de abstracción: 1) comprender y organizar la información (identificación, clasificación, ordenamiento, organización); 2) aplicar lo aprendido (traducción, aplicación de conceptos, principios, procedimientos, integrar y aplicar la teoría), y 3) resolver problemas (Castañeda, 2006).

Para cada objetivo se desglosó el universo de evaluación a partir de elementos como los indicados anteriormente y se generaron reactivos representativos de los temas, niveles de complejidad cognitiva y modelos mentales, de manera que se contó con instrumentos integrados por decenas de reactivos.

Cada instrumento resultante del proceso anterior fue objeto de jueceo por parte de docentes expertos en la materia, así como de calibración de los reactivos, con base en software basado en la teoría clásica de los tests (ITMAN, 1993) y en la teoría de la respuesta al ítem (RASCAL, 1994).

Como resultado de lo anterior, se contó con cuatro instrumentos de evaluación del desempeño académico: pre–postest, con 27 reactivos; unidad 1, con 40 reactivos; unidad 2, con 34 reactivos, y unidad 3, con 31 reactivos. En la figura 2 se muestra que la variable desempeño estaba integrada por las cuatro evaluaciones aplicadas. El pretest no formó parte de la evaluación del desempeño, ya que era una condición que permitía identificar el conocimiento previo de los estudiantes.

EDAOM

Con el objeto de tener datos acerca de la auto–percepción de los estilos de aprendizaje, motivación y aprendizaje autorregulado, se aplicó una versión en línea del EDAOM (figura 3).

El inventario EDAOM (Castañeda y Ortega, 2004) identifica las autovaloraciones que los estudiantes realizan sobre sus estrategias de aprendizaje y orientaciones motivacionales al estudio. Se manejó una versión de este instrumento que mide autovaloraciones de los estudiantes sobre la frecuencia con la que utilizan una extensa variedad de estrategias de aprendizaje y orientaciones motivacionales al estudio. Está constituido por 91 reactivos tipo Likert, organizados en cuatro escalas, que evalúan:

1) estilos de adquisición de la información, con estrategias en dos niveles de procesamiento: a) selectivas y b) generativas;

2) estilos de recuperación de la información aprendida, en dos contextos: a) ante diferentes tareas académicas y b) durante los exámenes;

3) estilos de procesamiento, constituidos por: a) convergente y b) divergente;

4) estilos de autorregulación metacognitiva y metamotivacional, constituidos por tres componentes: a) los de la persona (eficacia percibida, contingencia interna, autonomía percibida, orientación a la aprobación externa), b) los de la tarea de aprendizaje (orientación a la tarea en sí o al logro de metas) y c) los de los materiales de aprendizaje, en cuanto a su utilidad para propiciar el aprendizaje eficiente.

En todas las afirmaciones que constituyen las 13 subescalas, el estudiante proporciona información acerca de la frecuencia que describe la ocurrencia de cada afirmación en su caso individual. El EDAOM ha sido validado con la aplicación a 2 mil 995 estudiantes de instituciones educativas del país. Se determinó su validez concurrente: 0.67 con el promedio general de calificaciones y 0.89 en tareas académicas diversas. Su consistencia interna es de 0.94 para todo el instrumento (alfa de Cronbach). También se ha establecido la validez convergente y divergente de los constructos subyacentes mediante un análisis factorial confirmatorio (Castañeda y Ortega, 2004). La estructura general de este instrumento se muestra en la figura 3.

Registro de la autorregulación como ejecución

El ambiente de aprendizaje registraba toda la actividad de los alumnos, la almacenaba en una base de datos disponible para los investigadores, con la aplicación ubicada en un servidor web. La base de datos podía consultarse y descargarse ingresando claves de usuario y contraseña.

La figura 4 muestra la composición de la variable autorregulación como ejecución, que se conforma por una serie de variables observadas que pretenden operacionalizar los principios para el soporte del aprendizaje autorregulado en línea propuestos por especialistas en el tema (Ley y Young, 2001; Ley, 2004). Estos principios son:

1) contar con un ambiente efectivo para el estudio;

2) organizar la instrucción y las actividades para facilitar procesos cognitivos y metacognitivos;

3) promover el uso de metas instruccionales y retroalimentación para presentar al estudiante oportunidades de monitoreo, y

4) ofrecer al alumno oportunidades constantes de autoevaluación.

El ambiente de aprendizaje integra elementos que facilitan el estudio, al incluir una serie de recursos como lecturas, vínculos, acceso a compañeros, tutor; el fomento de la cognición y la metacognición se hace posible mediante la disponibilidad para los estudiantes de una serie de funciones en el ambiente de aprendizaje que les permiten organizar su tiempo y actividades, tomar notas y visualizar su nivel de desempeño; el uso de metas instruccionales se resuelve a través de funciones en el ambiente que permiten a los estudiantes: plantear metas de aprendizaje para cada unidad, verificar si estas metas se cumplen, y calificar el nivel de cumplimiento de las metas; las oportunidades de autoevaluación en el ambiente estuvieron disponibles permanentemente con diversos ejercicios automatizados que daban información al estudiante acerca de su nivel de conocimiento y habilidad.

Registro de la interactividad instruccional

Los estudiantes realizaron diversas tareas de aprendizaje interactuando con materiales, compañeros y con un tutor en línea, y sus acciones fueron registradas y almacenadas en la base de datos, a su vez, estos datos podían ser consultados y descargados para análisis.

La interactividad se registró para cada unidad de aprendizaje, a partir de cinco variables que correspondían a las etapas del diseño instruccional (activación del conocimiento previo, planteamiento de un problema, demostración, aplicación e integración del conocimiento, como se ilustra en la figura 5)– Dado que las actividades de aprendizaje podían tener un formato de interacción con materiales, con compañeros o con un tutor en línea, la interactividad asumía características diferentes en cada modalidad. En el caso de las interacciones con materiales, los estudiantes debían realizar ejercicios en cada una de las cinco etapas y el sistema daba retroalimentación y asignaba una calificación aprobatoria automática a cada actividad si ésta era resuelta con un 70% de efectividad (7 de calificación).

En el caso de la colaboración y la tutoría, se realizó una tarea de análisis de contenidos de las discusiones sostenidas por los agentes del ambiente de aprendizaje. El análisis de contenidos permitió identificar los niveles de demanda (en una escala de 1 a 4) el nivel de complejidad en la comprensión (en una escala de 1 a 4), el nivel de complejidad del andamiaje (en una escala de 1 a 5). Después de realizar el análisis de contenidos con base en una serie de rúbricas elaboradas por un profesor experto en la materia, se realizó este análisis por parte de dos observadores y, posteriormente, se obtuvo un índice de confiabilidad, en este caso se utilizó el porcentaje de acuerdos, que es el resultado de la división del número de acuerdos entre el número total de acuerdos + desacuerdos.

El análisis de contenidos permitió identificar los niveles: de demanda de cada etapa, de construcción de conocimiento del alumno y de andamiaje recibido. El índice de interactividad se calculó según la ecuación 1, que se muestra a continuación.

Análisis de modelamiento de ecuaciones estructurales

Para todos los análisis de modelamiento estructural se utilizó el programa EQS (2007). Siguiendo lo propuesto por Kline (1998), en primera instancia se obtuvieron las estimaciones de cada uno de los tipos de medición de los constructos incluidos en el modelo y, en segundo lugar, se ensambló el modelo incluyendo todos los constructos y sus indicadores.

Cabe mencionar que desde el primer paso, la valoración de cada modelo de medición, se realizaron algunos ajustes para probar el modelo teórico, éstos fueron los siguientes:

1) El constructo de autorregulación como autorreporte presentó problemas para conformar los factores predichos por el instrumento en esta aplicación, por lo que se ajustó su estructura integrando solamente dos factores, uno relacionado con el estilo de construcción de conocimiento y otro con la autonomía reportada; asimismo, el constructo de autorregulación como ejecución, dado que los estudiantes no desplegaron suficiente actividad de este tipo en el ambiente de aprendizaje —y las variables observadas tenían valores bajos— se agruparon en una sola variable observada: autorregulación como ejecución, que sumaba toda la actividad autorregulatoria en el ambiente para cada estudiante.

2) El constructo de autorregulación como ejecución no tuvo la representatividad que se esperaba, ya que a pesar de que los alumnos eran invitados a utilizar estas funciones, la frecuencia de ejecución de acciones de este tipo fue muy baja, y eso condujo a que no permitiera el ajuste estadístico del modelo, por lo que esta variable fue excluida del análisis. Los demás constructos se conservaron prácticamente iguales.

Resultados

En primer término, es preciso indicar la confiabilidad resultante del análisis de contenidos realizado por dos observadores arrojó puntajes de 78% de acuerdo entre ellos, que se consideraron adecuados para el modelamiento de ecuaciones estructurales.

Los resultados de la aplicación del modelamiento de ecuaciones estructurales se expondrán según la secuencia de contraste de modelos que se siguió en el trabajo: se contrastó un modelo estructural para cada una de las unidades, de tal manera que en la unidad 1, el conocimiento previo era el pretest exclusivamente; el desempeño era conformado por las evaluaciones 1, 2, 3 y postest; y la interactividad instruccional a incluir era la que correspondía a esta unidad de aprendizaje: la 1; la autorregulación como ejecución se incluyó en los tres modelos.

En la unidad 2, el conocimiento previo era el correspondiente a los datos del pretest y de la unidad 1, y los datos de desempeño eran los de las unidades 2 y 3 y postest. En la unidad 3, el conocimiento previo era el del pretest, el de la unidad 1 y 2, y los datos de desempeño eran los de las evaluaciones de la unidad 3 y el postest.

La figura 6 muestra el modelo estructural correspondiente a las variables de la unidad 1. Es preciso indicar que el modelo muestra un ajuste estadísticamente no significativo, a juzgar por los valores de la X2 = 159.05, con una p=0.51 (debe ser mayor que 0.05), un índice de ajuste (CFI) de 1.00 (debe ser mayor a 0.95) y un intervalo de confianza (RMSEA) de 0.00 (debe ser inferior a 0.05); lo que demuestra consistencia con los datos.

De las variables que componen el modelo, dos tienen una influencia estadísticamente significativa (p> = .05): 1) la variable latente interactividad instruccional explicó a la variable latente desempeño (0.60), y 2) la de autorregulación, si bien no tuvo impacto directo en el desempeño (0.02), sí influyó significativamente (p> = .05) en el trabajo de interactividad (.26), lo cual tiene sentido teóricamente, pues el trabajo autorregulado puede impactar en la realización de acciones diversas de interactividad instruccional. El conocimiento previo (en este caso, representado por los resultados del pretest) no influyó significativamente en el desempeño (0.17) ni en la interactividad instruccional (0.17). La máxima relación de este modelo se dio entre la interactividad instruccional y el desempeño, con un valor de 0.60.

En conclusión, en la unidad 1: el conocimiento previo no impactó significativamente en el desempeño ni en la actividad interactiva instruccional; esta última sí impactó significativamente en el desempeño, y la autorregulación impactó en la actividad de aprendizaje interactivo (y, por lo tanto, podría tener un efecto indirecto en el desempeño), pero no impactó directamente en él.

Por otro lado, en la unidad 2, que ahora incorporaba en el conocimiento previo lo aprendido en la unidad 1 y los datos del pretest y en la variable latente desempeño los resultados de la unidad 2, los de la unidad 3 y el postest, mostró un resultado interesante, que aparece en la figura 7. En ella se observa que el modelo sigue siendo estadísticamente no significativo, con un valor de la X2 = 156.40, un valor de p=0.16, un índice de ajuste (CFI) de 0.96 y un intervalo de confianza (RMSEA) de 0.03.

En este caso, el desempeño fue explicado significativamente (p>=0.05) por tres variables latentes: el conocimiento previo (0.88), la interactividad instruccional (0.45) y la autorregulación (0.14). En la unidad anterior el impacto del conocimiento previo era de 0.18 en relación con el desempeño, y ahora asume un papel fundamental en el proceso. La autorregulación impactó ahora más en el desempeño (0.14) y menos en la interactividad (0.05), y en el primer caso su contribución fue significativa.

Finalmente, en el modelo de la unidad 3, representado en la figura 8, se observan sus valores de X2 = 157.25, p=0.20, CFI= 0.97 y RMSEA de 0.03, que hicieron que el ajuste del modelo fuera estadísticamente no significativo.

En este caso, se confirmó que el desempeño fue explicado significativamente (p>=0.05) por las tres variables latentes propuestas en el modelo: el conocimiento previo (0.88), la interactividad instruccional (0.30) y la autorregulación (0.19).

Es interesante observar que el coeficiente del conocimiento previo siguió en el mismo nivel (0.88) con respecto al desempeño, y el efecto de la interactividad instruccional disminuyó aunque siguió siendo significativo (0.30); la autorregulación tuvo un coeficiente de 0.19 con respecto al desempeño. La correlación entre factores en esta unidad fue de la manera siguiente: el conocimiento previo y la autorregulación correlacionaron negativamente (–0.09), lo cual habla de que ambos factores estuvieron diferenciados, que medían cosas diferentes; entre conocimiento previo e interactividad también existió una correlación marginal (0.08) y entre autorregulación e interactividad instruccional también fue baja (0.10).

Lo anterior permite explicar que son tres factores diferentes los que se proponen en el modelo y que los tres tuvieron un impacto en el desempeño, tal como se demuestra en la influencia descrita antes de estos factores.

Explicación de la varianza en el modelo

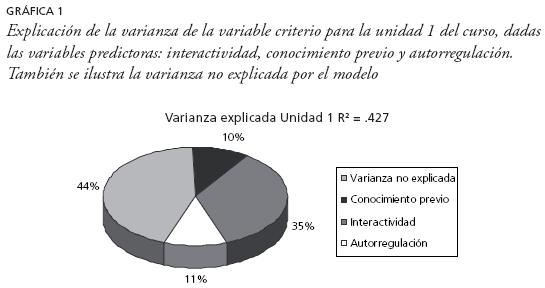

Si bien los coeficientes de trayectos explican con claridad los efectos de las variables predictoras en las variables criterio y en las tres unidades del curso se presentaron efectos de dichas variables predictoras, por otro lado existe un análisis que ofrece datos muy importantes acerca de lo adecuado del modelo al explicar el aprendizaje en línea: el nivel de explicación de varianza por parte de las variables latentes. En la gráfica 1 se presentan los datos de la varianza explicada en las unidades inicial y final del curso en línea descrito en este trabajo.

En la gráfica se muestra la varianza explicada en la unidad 1 del curso. En ella se observa que la R2 fue de .427, y de ésta, las variables predictoras del modelo contribuyeron a la explicación de la variable criterio como sigue: el conocimiento previo explicó 10% de la varianza; la interactividad el 35% y la autorregulación el 11%. El 44% de la varianza no fue explicada por el modelo en esta unidad.

En la gráfica 2 se muestra varianza explicada en la unidad 3 del curso. En ella se observa que la R2 fue de .935, y de ésta, las variables predictoras del modelo contribuyeron a la explicación de la variable criterio como sigue: el conocimiento previo explicó 54% de la varianza; la interactividad el 19% y la autorregulación el 11%. El 16% de la varianza no fue explicada por el modelo en esta unidad.

En resumen se encontró que, en términos generales, las variables: autorregulación, interactividad instruccional y conocimiento previo tuvieron un impacto significativo en la explicación del desempeño en el aprendizaje en línea en este estudio. La cantidad de varianza explicada por las variables del modelo fue bastante alta y, en la medida en que progresaba el curso, el conocimiento fue dando cuenta de la mayor parte de la varianza de la variable criterio, ya que en la última unidad fue el factor que explicó la mayor parte del desempeño en el curso, seguido de la interactividad y con menor poder explicativo la autorregulación.

Discusión

El presente estudio propone un modelo teórico que explica la dinámica del aprendizaje en línea en términos de los constructos que intervienen en dicho proceso. El modelo validado propone que las variables que explican el aprendizaje en cursos en línea, jerárquicamente, son: el conocimiento previo; la interactividad instruccional y la autorregulación.

El conocimiento previo

En las últimas unidades del curso el conocimiento previo tuvo coeficientes de trayectorias de 0.88, lo que comprueba un efecto definitivo en el aprendizaje subsecuente. Este dato coincide plenamente con modelos teóricos en psicología educativa como el propuesto por Ausubel (2002) del aprendizaje significativo, que enfatiza la forma en la que la información nueva se incorpora a la estructura cognitiva mediante la formación de significados, donde esta estructura cognitiva es una red estructurada de conceptos y proposiciones jerarquizadas, organizada por campos de conocimiento. Esta estructura de conocimientos se conforma justamente por los conocimientos previos que, a juicio de Ausubel, constituye el factor principal que influye en el aprendizaje y retención de la información novedosa. De esta forma, la estructura cognitiva está conformada por el conocimiento previo y de la disponibilidad de esta estructura, mediante la activación de los conocimientos pertinentes, dependerá la calidad en la construcción del conocimiento nuevo. Cuando existe una estructura inadecuada, desarticulada o pobre, esto conducirá a la inhibición del aprendizaje posterior.

La propuesta del aprendizaje significativo ha influido de manera determinante en las teorías contemporáneas del aprendizaje. Glaser (1996) reconoce que uno de los procesos de adquisición de pericia es la organización de conocimiento estructurado. Para el desarrollo de pericia, el conocimiento debe ser adquirido de manera que quede fuertemente conectado y articulado, para que así se habiliten la inferencia y el razonamiento y el acceso a las acciones procedimentales. Estas estructuras capacitan a los individuos a construir una representación o modelo mental que guía a la solución de problemas y al aprendizaje posterior (Glaser y Baxter, 2000). La organización resultante del conocimiento proporciona un esquema para el pensamiento y la actividad cognitiva. "El conocimiento estructurado, entonces, no es sólo una consecuencia de la cantidad de información recibida, sino refleja la exposición a un ambiente de aprendizaje donde hay oportunidades para la solución de problemas, la creación de analogías, inferencias, interpretación y trabajo en ambientes no familiares que requieren transferencia" (Glaser, 1996:306).

La estructura de conocimientos es resaltada también por Castañeda (2004b), quien argumenta que la enseñanza estratégica prescribe actividades para que las estructuras de las asignaturas y las estructuras cognitivas de los alumnos se pongan en juego para que puedan integrarse en resultados de aprendizaje. Podemos concluir que un primer supuesto básico del aprendizaje en línea es: Dado que el aprendizaje es concebido como un proceso de construcción de nuevo conocimiento sobre la base del actual, es preciso trabajar en la conformación de la estructura de conocimientos que servirá como base para el aprendizaje futuro. Si bien este supuesto no es exclusivo del aprendizaje en línea, será necesario tomar las decisiones más adecuadas para que los ambientes de aprendizaje hagan posible esta estructuración del conocimiento.

La interactividad

Los datos reseñados anteriormente muestran que el constructo que influye en segundo lugar en el aprendizaje es la interactividad instruccional, que siempre fue estadísticamente significativo (p>=0.05), con coeficientes de explicación del desempeño desde 0.60 (unidad 1), 0.45 (unidad 2) y 0.30 (unidad 3).

Bajo este constructo se engloban varios elementos. En primer lugar, incluye la estructura del diseño instruccional; en este caso sus lincamientos se basaron en principios fundamentales de la instrucción (Merrill, 2002; 2009) que, a lo largo de la historia, han demostrado tener un impacto definitivo en el aprendizaje. Tal es el caso de la introducción de problemas o casos, la activación, demostración, aplicación e integración del conocimiento, etapas que se incluyeron en el curso evaluado. El modelo instruccional empleado demostró que, en términos generales, proceder de acuerdo con estas etapas predice el aprendizaje.

Cabe mencionar otros elementos que formaron parte de este indicador. Fue calculado después del análisis de contenidos de 101 participantes en la totalidad del curso, que incluyó tres unidades y, en cada una, una tercera parte eran sometidos a una modalidad instruccional diferente (ver procedimiento). De acuerdo con lo expuesto en la sección de instrumentos de este trabajo, el índice de interactividad era una medida que resumía: el nivel de actividad efectiva del estudiante, ya que registraba el número de intentos vs los intentos efectivos, a juzgar por el cumplimiento de criterios; la relación entre el nivel de demanda y el de construcción de conocimiento, y el nivel del andamiaje ofrecido a favor de la construcción por parte del alumno. El índice de interactividad es una medida resumen del trabajo del alumno en el proceso instruccional, así como del apoyo recibido en el ambiente para este efecto. Estudiosos de la interactividad como Colomina, Onrubia y Rochera (2005), indican que su análisis implica hablar de una enseñanza centrada en los procesos interpsicológicos que subyacen a la actividad conjunta del profesor y los alumnos en torno a actividades y tareas de aprendizaje; esto es, supone abarcar en una sola unidad de análisis los efectos conjuntos del trabajo de dos agentes en el contexto del aprendizaje. En el análisis de la interactividad instruccional gravitan aspectos como el tipo de respuesta constructiva, ya que muchos estudiantes tienden a construir con niveles bajos, pero esto también puede complementarse con niveles bajos de andamiaje, que conducen a resultados de nivel inferior cognitivamente hablando.

A partir de lo anterior, podemos plantear que un segundo supuesto básico del aprendizaje en línea es que: independientemente de la modalidad interactiva, cuando se logra que haya coherencia entre: los niveles de complejidad de la demanda y la complejidad de los procesos de construcción de conocimiento, el nivel del andamiaje, y la calidad del ajuste realizado por el estudiante en cada etapa instruccional, se presentarán niveles altos de efectividad en el desempeño. En otras palabras, a niveles altos de interactividad, se registrarán niveles profundos de construcción de conocimiento. Las condiciones que impone el diseño instruccional como elemento central determinan las interacciones y los resultados de aprendizaje.

La autorregulación

Los resultados del estudio indican que el tercer constructo en importancia para explicar el desempeño académico es la autorregulación, que siempre fue estadísticamente significativo (p>=0.05), con coeficientes de explicación, en la primera unidad, de la interactividad instruccional (0.26), y en las unidades 2 y 3 del desempeño, con coeficientes de 0.14 y 0.19, respectivamente.

Se ha planteado que las habilidades que componen el constructo del aprendizaje autorregulado son especialmente útiles en ambientes de aprendizaje en línea, dado el rol que se confiere al estudiante como gestor de su propio aprendizaje, pues aun cuando tenga a su alcance una diversidad de recursos, es preciso que tenga la auto dirección necesaria para aprovecharlos a favor del desempeño. Los estudiantes autorregulados monitorean y guían su propio aprendizaje, y los que no lo son se muestran más pasivos motivacional y metacognitivamente (Zimmerman, 2000). La autorregulación implica una tendencia estratégica a la construcción de conocimiento, así como la conjunción de motivación y metacognición que favorecen la acción proactiva del estudiante (Pintrich, 2000).

Los contextos de estudio a distancia y en línea requieren de una serie de habilidades por parte de los estudiantes, entre las que se ha planteado a la autonomía o la autorregulación. Las altas tasas de deserción estudiantil en este tipo de ambientes hacen pensar que quienes tienen habilidades autorregulatorias podrían tener mejores resultados y permanencia en estos sistemas (Dembo, Junge y Lynch, 2006).

En este estudio se evaluó la participación de la autorregulación como autorreporte y tuvo que eliminarse del modelo la versión de ejecución de este constructo. Los estudiantes, en general, tienen niveles bajos de ejecución de estrategias cognitivas, metacognitivas y motivacionales, por lo que los registrados en actividades de planteamiento y revisión de metas, automonitoreo, toma de notas, fueron bajos en general. Con datos insuficientes este constructo no pudo incorporarse al modelo estructural; otro aspecto que podría argumentarse para explicar la falta de protagonismo de este constructo en el modelo es que probablemente los estudiantes ejecuten estrategias de estudio en otros contextos, como realizar resúmenes, esquemas, etcétera, en sus cuadernos y no necesariamente en el ambiente de aprendizaje. De este modo, dados los bajos niveles de autorregulación detectados y dado el carácter optativo del uso de las funciones de autorregulación en el ambiente de aprendizaje en línea, esta variable no demostró, en este estudio, tener impacto en el desempeño. Sin embargo, consideramos importante darle seguimiento, pues en la medida en que este tipo de habilidades se entrenen en los ambientes de aprendizaje en línea, podrían tenerse resultados de impacto en el desempeño, pues la teoría es consistente al plantearlo.

Un tercer supuesto teórico derivado de este trabajo plantearía que los estudiantes con autopercepciones positivas acerca de sus estrategias de aprendizaje y autorregulación tienen mejores resultados de aprendizaje en cursos en línea que quienes no reportan dichas autopercepciones.

A manera de conclusión

El entusiasmo causado por la promesa de que las tecnologías resolverían problemas actuales de la educación ha conducido a la proliferación de soluciones de aprendizaje mediado por tecnologías, pero muchas de éstas han descuidado un aspecto central: la necesidad de contar con modelos de comprensión del proceso de aprendizaje como base para construir las soluciones educativas.

El modelo teórico de este trabajo parte del supuesto de que el estudiante se involucra activamente en el procesamiento cognitivo, con el fin de construir modelos mentales basados en su experiencia individual y colectiva.

Este supuesto del procesamiento activo implica que el estudiante requiere el acceso a experiencias interactivas en el ambiente de aprendizaje, que la interactividad\c permite construir el conocimiento, y que ésta tiene lugar durante la realización de actividades de aprendizaje organizadas desde el diseño instruccional. Los modelos mentales son refinados y ampliados de manera constante y representan una importante herramienta para seguir aprendiendo. La efectividad de este cuerpo de conocimiento está garantizada por el modelo de diseño instruccional, que se basa en el fomento de aprendizaje profundo, así como por la influencia de las habilidades de aprendizaje autorregulado, que son la base donde se origina el desempeño. Haber validado un modelo del aprendizaje en línea es una aportación de este trabajo. Sus implicaciones inmediatas se relacionan con la generación de conocimiento en esta área.

Las relaciones estructurales que se encuentran en este trabajo explican el aprendizaje de los estudiantes en este ambiente de Internet y ante esto surge la inquietud de si podrían ser exclusivas de estos entornos o bien si pueden también explicar el aprendizaje en entornos presenciales. Al respecto, consideramos que dos de los tres constructos identificados son especialmente importantes en el aprendizaje en Internet: por una parte, las habilidades autorregulatorias, si bien son fundamentales en los entornos presenciales, en los ambientes de aprendizaje en línea parecen ser indispensables (Azevedo y Cromley, 2004); por otro lado, la interactividad en estos entornos podría ser central, dado que el aprendizaje es el núcleo del estudio en Internet y requiere una cantidad importante de acciones conjuntas de los estudiantes y otros agentes de los ambientes de aprendizaje (Peñalosa y Castañeda, 2010); sin embargo, el conocimiento previo es un factor igualmente importante en el aprendizaje en línea y presencial. Es pertinente probar si este modelo estructural es válido para el sistema presencial y podría, para esto, realizarse un estudio en salón de clases con un diseño instruccional equivalente al utilizado aquí, y evaluar diferencias del aprendizaje entre ambos tipos de entorno. También es recomendable realizar una investigación que verifique si este modelo puede generalizarse a otros dominios temáticos para el aprendizaje en Internet.

De esta manera, consideramos que es importante continuar con el trabajo de investigación; pero también lo es contar con lincamientos metodológicos como los planteados aquí, que han permitido la construcción y validación de instrumentos de evaluación, el ambiente y los contenidos de aprendizaje. Esto nos permite continuar la exploración empírica de este tipo de procesos en línea.

La demanda educativa en México es muy alta y, hasta el momento, los sistemas escolarizados, abiertos y a distancia no han sido suficientes para atenderla, especialmente en los niveles medio superior y superior. En este sentido, incluso con la variedad de tecnologías actualmente disponibles, no se ha llegado a una solución para este problema.

Es preciso mejorar los parámetros de calidad y eficiencia de la educación a distancia. Consideramos fundamental en este sentido tener una mejor comprensión del aprendizaje en estos ambientes. Un paso consiste en la propuesta de modelos teóricos que nos permitan entender mejor las características de este tipo de educación. El fomento de habilidades de autonomía, el trabajo en niveles altos de interactividad y el fomento de estructuras sólidas de conocimiento previo podrían ser centrales para mejorar la calidad y la eficiencia. Los costos podrían abatirse mediante el diseño de materiales didácticos interactivos a partir de fundamentos sólidos.

Concluyendo, podemos argumentar que el presente estudio, si bien podría tener limitaciones como la falta de generalidad de un trabajo que se realiza en un curso especial en un ambiente particular, sí tiene implicaciones importantes en el sentido de tomar en cuenta los factores que aquí se destacan para la construcción de futuros espacios de aprendizaje en línea. Las implicaciones teóricas parecen relacionarse con la posibilidad de iniciar con la construcción de un cuerpo coherente de constructos relacionados que permitan explicar los procesos de aprendizaje en línea, continuar su estudio y el trabajo de investigación para generar conocimiento más fino y exhaustivo y contribuir a la construcción de soluciones tecnológicas en las que el aprendizaje es el proceso central y en las que, en general, quienes se encargan de construirlas no conocen a profundidad este proceso.

Referencias

Aguilar, J.; Valencia, A.; Martínez, M. y Vallejo, A. (2002). "Un modelo estructural de la motivación intrínseca en estudiantes universitarios", en A. Bazán y A. Arce (editores). Estrategias de evaluación y medición del comportamiento en psicología, Ciudad Obregón Sonora: ITSON–UADY, pp. 165–260. [ Links ]

Ally, M. (2004). "Foundations of educational theory for online learning", en T. Anderson y F. Elloumi (Eds) Theory and practice of online learning, Athabasca: Athabasca University, pp. 6–31. [ Links ]

Anderson, T. (2004). "Toward a theory of online learning", en T. Anderson y F. Elloumi (Eds) Theory and practice of online learning, Athabasca: Athabasca University, pp. 33–58. [ Links ]

Ausubel, D. P. (2002). Adquisición y retención del conocimiento, Barcelona: Paidós. [ Links ]

Azevedo, R. y Cromley, J.G. (2004). "Does training on self regulated learning facilitate students' learning with hypermedia?", Journal of Educational Psychology, 96, 523–535. [ Links ]

Azevedo, R.; Cromley, J. G.; Winters, F. I.; Moos, D. C. y Greene, J. A. (2006). "Using computers as meta–cognitive tools to foster students' self–regulated learning", Cognition and Learning, 3, 97–104. [ Links ]

Bazán, A. y Corral, V (2001). "Aplicación del modelamiento de variables latentes en la clasificación funcional de la lectura y la escritura en niños de segundo grado de primaria", Acta Comportamentalia, 9, 189–212. [ Links ]

Bazán, A. y García, I. (2002). "Relación estructural de ingreso y permanencia, y el dominio de habilidades metodológico–conceptuales en cuatro grupos de estudiantes de educación", Revista Latinoamericana de Estudios Educativos, 32, 105–122. [ Links ]

Bazán, A.; García, I. y Borbón, J.C. (2005). "Evaluación de habilidades metodológico–conceptuales en el análisis de textos científicos: algunos hallazgos empíricos", en C. Santoyo (comp). Análisis y evaluación de habilidades metodológicas, conceptuales y profesionales en la formación del psicólogo, Ciudad de México: UNAM, pp. 109–127. [ Links ]

Bazán, A.; Félix, R. y Gaviño, H. (2006). "Variables personales relacionadas con el promedio académico, la atribución de éxito y la construcción de teorías del desempeño académico", en S. Castañeda (coord) Evaluación del aprendizaje en el nivel universitario: elaboración de exámenes y reactivos objetivos, Ciudad de México: UNAM, 121–138. [ Links ]

Bazán, A.; Sánchez, B.; Corral, V. y Castañeda, S. (2005). "Utilidad de los modelos estructurales en el estudio de la lectura y la escritura", Revista Interamericana de Psicología, 40, pp. 85–93. [ Links ]

Bransford, J.; Brown, A. L. y Cockings, R. R. (2004). How people learn: Brain, mind, experience, and school, Washington, DC: National Academy Press. [ Links ]

Castañeda, S. (1998). Evaluación y fomento del desarrollo intelectual en la enseñanza de ciencias, artes y técnicas: Perspectiva internacional en el umbral del siglo XXI, Ciudad de México: Miguel Ángel Porrúa/UNAM. [ Links ]

Castañeda, S. (2002). "A cognitive model for learning outcomes assessment", International Journal of Continuing Engineering Education and Life–long Learning, 12, 94–106. [ Links ]

Castañeda, S. (2004a). "Educación, aprendizaje y cognición", en Castañeda, S. (ed). Educación, aprendizaje y cognición: teoría en la práctica, Ciudad de México: Manual Moderno, pp. 49–74. [ Links ]

Castañeda, S. (2004b). "Enseñanza estratégica: guía abreviada para el docente y el tutor", en Castañeda, S. (ed) Educación, aprendizaje y cognición: teoría en la práctica, Ciudad de México: Manual Moderno, pp. 393–421. [ Links ]

Castañeda, S. (2006). "Evaluación del aprendizaje en educación superior", en S. Castañeda (coord) Evaluación del aprendizaje en el nivel universitario: elaboración de exámenes y reactivos objetivos, Ciudad de México: UNAM, pp. 3–27. [ Links ]

Castañeda, S. y Ortega, I. (2004). "Evaluación de estrategias de aprendizaje y orientación motivacional al estudio", en S. Castañeda (ed.) Educación, aprendizaje y cognición: teoría en la práctica, Ciudad de México: Manual Moderno, pp. 277–299. [ Links ]

Castañeda, S.; Bazán, A.; Sánchez, B. y Ortega, I. (2004). "Validez apriorística y empírica de constructos. Modelamiento estructural de porciones extensas de exámenes objetivos a gran escala", Revista Mexicana de Pensamiento y Lenguaje y Neuropsicología Latina, 12, 155–198. [ Links ]

Castañeda, S.; González, D. y Várela, C. (2006). "Validando puntajes de bancos de ítems de exámenes de egreso de licenciatura", en S. Castañeda (coord) Evaluación del aprendizaje en el nivel universitario: elaboración de exámenes y reactivos objetivos, Ciudad de México: UNAM, pp. 75–120. [ Links ]

Colomina, R.; Onrubia, J. y Rochera, M.J. (2005). "Interactividad, mecanismos de influencia educativa y construcción del conocimiento en el aula", en C. Coll, J. Palacios y A. Marchesi (compiladores) Desarrollo psicológico y educación: 2. Psicología de la educación escolar, Madrid: Alianza editorial, pp. 437–458. [ Links ]

De Corte, E. (1999). "Desarrollo cognitivo de innovación tecnológica: una nueva concepción de la enseñanza y el aprendizaje para el siglo XXI", Revista Latina de Pensamiento y Lenguaje, vol. 4, pp. 229–250. [ Links ]

Dembo, M. H.; Junge, L. y Lynch, R. (2006). "Becoming a self–regulated learner: Implications for Web–based education", en H. F. O'Neil, y S. R. Perez (Eds.) Web–based learning: Theory, research, and practice, Mahwah, NJ: Erlbaum, pp. 185–202. [ Links ]

Eom, S. B. y Wen, H. J. (2006). "The determinants of students' perceived learning outcomes and satisfaction in university online education: an empirical investigation", Decision Sciences Journal of Innovative Education, 4 (2), pp. 215–235. [ Links ]

EQS (2007). Structural Equation Modeling Software, versión 6.1, Multivariate Software. [ Links ] Garcia Aretio, L. (2001). La educación a distancia: de la teoría a la práctica, Barcelona: Ariel. [ Links ]

Garrison, R. (2000). "Theoretical challenges for distance education in the 21st century: a shift from structural to transactional issues", International Review of Research in Open and Distance Learning, 1, pp. 1–17. [ Links ]

Glaser, R. (1996). "Changing the agency for learning: Acquiring expert performance", en K. A. Ericsson (ed.) The road to excellence: The acquisition of expert performance in the arts and sciences, sports and games, Hillsdale, NJ: Lawrence Erlbaum, pp. 303–311. [ Links ]

Glaser, R. y Baxter, G. P. (2000). Assessing active knowledge, CRESST, University of Pittsburgh.http://www.cse.ucla.edu/cRESST/Reports/TECH516.PDF. [ Links ]

González, D. y Maytorena, M.A. (2002). "Influencia de la orientación motivacional, los estilos de aprendizaje y los factores de carrera sobre el desempeño escolar", en A. Bazán y A. Arce (editores) Estrategias de evaluación y medición del comportamiento en psicología, Ciudad Obregón: ITSON–UADY, pp. 201–225. [ Links ]

González, D. y Maytorena, M. A. (2009). "Perfil de estrategias cognoscitivas de aprendizaje en estudiantes universitarios de primer ingreso", trabajo presentado en el X Congreso Nacional de Investigación Educativa, Veracruz, Ver. México. [ Links ]

Haynes, S. N. (1978). Principles of behavioral assessment, Nueva York: Gardner Press. [ Links ]

Holmberg, B. (2004). Status and trends of distance–education research. Disponible en: http://www.eden–online.org/papers/rw/holmberg_article_for_web.pdf. [ Links ]

ITEMAN (1993). Conventional Item Analysis Program, (versión 3.5), St. Paul, MN: Assessment Systems Corp. [ Links ]

Keegan, D. (1986). The foundations of distance education, Londres: Routledge. [ Links ]

Körndle, H.; Narciss, S. y Proske, A. (2002). "Promoting self–regulated learning in web–based learning environments", en H. Niegemann, R. Brucken y D. Leutner (eds.) Instructional design for multimedia learning, Munster: Waxmann. [ Links ]

Kozma, R. (1994). "Will media influence learning? Reframing the debate", Educational Technology Research and Development, 42, pp. 7–19. [ Links ]

LaPointe, D. K. y Gunawardena, C. N. (2004). "Developing, testing and refining of a model to understand the relationship between peer interaction and learning outcomes in computer–mediated conferencing", Distance Education, 25, pp. 93–106. [ Links ]

Ley, K. (2004). "Motivating the distant learner to be a self–directed learner", 20th Annual Conference on Distance Learning and Teaching, Estados Unidos: Universidad de Wisconsin. [ Links ]