1. Introducción

La implementación de la tecnología de última generación como apoyo significativo de las actividades básicas del ser humano genera una indiscutible optimización de las tareas diarias y se han convertido en un elemento indispensable para el desarrollo dentro de la sociedad.

Múltiples estudios han demostrado que al integrar la tecnología en procesos tempranos de educación y como apoyo en el tratamiento de deficiencias relacionadas con los trastornos del lenguaje, visión, audición, déficit de atención y la deficiencia mental, provocan altos impactos en el mejoramiento de los resultados terapéuticos e inclusión social [1].

Lo que nos interesa en este trabajo de investigación es estimular a una persona mediante una serie de conceptos presentados de forma visual, utilizando pictogramas y después evaluar si dichos conceptos pueden ser reproducidos bajo el recuerdo de los mismos.

En ese sentido, en la literatura se ha reportado que con el desarrollo de nuevas tecnologías y la mejora de los sistemas de EEG, las investigaciones en esta área han logrado una interpretación de las ondas cerebrales que a simple vista podrían parecer totalmente aleatorias, para ello se buscó tratar las señales EEG crudas y aplicar distintos métodos matemáticos, que permiten obtener información que haga posible entender que sucede con las ondas cerebrales ante distintos estímulos externos, con el objetivo de lograr una comprensión más detallada de la actividad cerebral [2].

La decodificación de la representación visual se refiere a la tarea de descifrar lo que un sujeto está viendo o visualizando al observar el estado del cerebro a través de neuroimágenes.

Una de las áreas altamente citadas está orientadas a la identificación y categorización de objetos, en la cual, los autores analizan la áreas del cerebro que se activan al momento de que los usuarios perciben estímulos visuales, ya sea a través de imágenes a color, pictogramas o textos (verbos, sustantivos, nombres de herramientas, etc.), y a través de un proceso completo de procesamiento, es posible saber la categoría semántica a la que pertenece el estímulo que el usuario está observando en intervalos de tiempo sumamente cortos (milisegundo).

La identificación de los procesos neurales que subyacen a las representaciones semánticas es un desafío clave en la neurociencia cognitiva. Se han propuesto diferentes hipótesis sobre cómo las representaciones de conceptos particulares establecen un sistema de conocimiento conceptual. La aceptación general es que las propiedades de los objetos compartidos se reflejan en la organización del sistema semántico y que el sistema se generaliza a través de conceptos que pertenecen a una categoría particular (como animales, herramientas o edificios).

La noción de especificidad de categoría en la organización del conocimiento del objeto surgió en la década de 1980, cuando Warrington y sus colegas informaron por primera vez sobre pacientes con discapacidad selectiva para una categoría semántica en comparación con otras categorías semánticas [3, 4, 5].

La activación diferencial, que sugiere una organización funcional específica, se ha demostrado en el procesamiento de las modalidades de estímulo visual y verbal.

La mayoría de los estudios examinan solo distinciones en campos semánticos muy alejados, por ejemplo, comparando conceptos abstractos y concretos, verbos y sustantivos, o tipos naturales y artefactuales [6]. Las categorías más estudiadas han sido rostros humanos, casas, animales y herramientas [7].

Las bases neuronales del reconocimiento de objetos y del conocimiento semántico se han estudiado ampliamente, pero la elevada dimensionalidad del espacio objetual hace que tenga un alto grado de dificultad desarrollar teorías globales sobre cómo el cerebro organiza el conocimiento de los objetos.

Para ayudar a entender cómo el cerebro nos permite reconocer, categorizar y representar objetos y categorías de objetos, existe un creciente interés en utilizar bases de datos de imágenes a gran escala para experimentos de neuroimagen. Existen estudios que se han encargado de recolectar tales señales, en [8] se presenta un conjunto de datos “THINGS-EEG” que contiene respuestas de electroencefalografía humana de 50 sujetos a 1,854 conceptos de objeto y 22,248 imágenes del conjunto de estímulos THINGS [9], una base de datos de imágenes de alta calidad y cuidadosamente organizada manualmente que fue diseñada específicamente para estudiar la visión humana.

El conjunto de datos THINGS-EEG proporciona registros de neuroimagen a una colección sistemática de objetos y conceptos y, por lo tanto, puede apoyar una amplia gama de investigaciones para entender el procesamiento de objetos visuales en el cerebro humano.

Además, las técnicas de análisis de patrones han identificado distintos patrones de actividad relacionados con la categoría de objetos que discriminan entre un número relativamente grande de categorías de objetos [10, 11, 12]. Estos patrones relacionados con la categoría de objetos se analizan sobre una gran extensión de corteza occipitotemporal, son estables tanto dentro como entre los sujetos, y pueden identificarse incluso cuando los sujetos ven libremente escenas complejas.

El cerebro humano procesa entradas visuales que cambian rápidamente y puede extraer sin esfuerzo el significado abstracto cuando los estímulos se presentan en secuencias rápidas. Recientemente, se ha estudiado la dinámica temporal de la representación emergente de los objetos visuales utilizando tasas de presentación rápidas de estímulos y métodos de análisis multivariados de EEG y magnetoencefalografía (MEG). En particular, múltiples objetos visuales representados en diferentes etapas del sistema visual pueden ser decodificados a partir de la señal EEG al mismo tiempo.

Las representaciones de objetos persisten durante más tiempo cuando se presentarán a velocidades más lentas en comparación con la exposición a tasas más rápidas [12].

Además, las imágenes presentadas a tasas más lentas alcanzaron etapas más altas de procesamiento, de tal manera que la abstracción categórica de la animación fue evidente para las imágenes en la presentación visual rápida en serie de 5 Hz, pero no de 20 Hz (RSVP).

Los seres humanos son capaces de reconocer visualmente un gran número de objetos diferentes e interactuar con ellos de forma significativa, a pesar de los cambios drásticos en la proyección de la retina, la iluminación o el ángulo de visión, y de que los objetos estén situados en entornos visuales desordenados [13]. El reconocimiento de objetos y el conocimiento semántico, nuestra capacidad para dar sentido a los objetos que nos rodean, han sido objeto de una gran cantidad de investigaciones de neurociencia cognitiva. Sin embargo, las investigaciones previas de neuroimagen en este campo se han basado a menudo en una selección manual de un pequeño conjunto de imágenes.

La evidencia de la neuroimagen funcional del cerebro humano indica que la información sobre las propiedades sobresalientes de un objeto, como su aspecto, cómo se mueve y cómo se usa, se almacena en los sistemas sensoriales y motores activos cuando se obtuvo esa información. Como resultado, los conceptos de objetos que pertenecen a diferentes categorías, como animales y herramientas, se representan en redes neuronales basadas en propiedades sensoriales y motoras parcialmente distintas.

Esto sugiere que los conceptos de objeto no se representan explícitamente, sino que surgen de la actividad ponderada dentro de las regiones del cerebro basadas en propiedades.

Sin embargo, algunas regiones basadas en propiedades parecen mostrar una organización categórica, proporcionando así evidencia consistente con formulaciones específicas de dominio basadas en categorías también [13].

Esta evidencia ha implicado los lóbulos temporales, particularmente la región posterior del lóbulo temporal izquierdo, como un sitio crítico para las representaciones almacenadas, especialmente sobre objetos concretos.

Estudios recientes han proporcionado apoyo adicional para este punto de vista al demostrar que las regiones de la corteza temporal posterior izquierda, están activas durante el procesamiento conceptual de imágenes y palabras (giro fusiforme y giro temporal inferior y medio) también estaban activas durante la comprensión auditiva de las oraciones [14].

En los últimos años, existe un interés creciente en abordar esta tarea mediante el uso de enfoques de aprendizaje automático. En [15] se proporciona una evaluación extensa que sirve como base para la decodificación de representaciones visuales, mediante la exploración de una amplia gama de configuraciones de modelos, representaciones de características y configuraciones de evaluación.

En general, el sistema visual humano puede reconocer y clasificar un objeto según su categoría con facilidad. Ambas tareas consideran que el conjunto de atributos o características extraídas de las imágenes son lo suficientemente generales como para clasificar el objeto como parte de la clase mientras se mantienen en la memoria los elementos que sirven para identificar ese objeto en particular dentro de una escena dada [16].

[17] Propone un sistema que tiene como objetivo detectar y segmentar un objeto a partir de una imagen utilizando las señales cerebrales medidas del usuario en el momento de observar una región específica.

La idea es transformar las respuestas de EEG medidas en un mapa que proporcione una estimación de la probabilidad de que una región en particular vista por el usuario contenga el objeto objetivo, y luego usar este mapa para generar un algoritmo de segmentación.

La construcción de este mapa se basa en la clasificación de señales de EEG, ya que se sabe que las respuestas eléctricas del cerebro difieren cuando el usuario detecta un objetivo o un estímulo raro en un escenario mediante presentación visual rápida en serie (RSVP). Este estudio muestra que la interfaz cerebro-computadora (BCI por sus siglas en inglés) y el análisis EEG simple son útiles para localizar los límites de los objetos en las imágenes.

En [18] se analiza la posibilidad de activar dispositivos observando colores primarios, lo que se cree que es especialmente útil para las personas con problemas de control motor restringido. Tal BCI requiere una detección confiable de las características relacionadas con el color capturada en los datos del electroencefalograma (EEG).

El trabajo realizado por [19] propone un sistema de etiquetado de imágenes basado en EEG. Si bien los humanos pueden reconocer objetos en 20-200 milisegundos, la necesidad de etiquetar imágenes manualmente da como resultado un rendimiento de anotaciones bajo.

Este sistema emplea señales cerebrales capturadas a través de un dispositivo EEG de consumidor para lograr una tasa de etiquetado de hasta 10 imágenes por segundo.

La nueva tecnología EEG permite el desarrollo de nuevas formas de acceso, pensando en cubrir las necesidades de los pacientes con discapacidades cognitivas y motoras, el desafío de obtener los mayores beneficios de un EEG portátil es el enfoque de múltiples trabajos [20].

Las investigaciones en esta área han logrado una interpretación de las ondas cerebrales que a simple vista podrían parecer totalmente aleatorias. Para una correcta lectura de las señales producidas por el cerebro es necesario tener un dispositivo robusto que permita la lectura de las ondas que se requieren medir [2].

Los recientes desarrollos en visión por ordenador han producido conjuntos de imágenes muy grandes para el entrenamiento de la inteligencia artificial, pero las imágenes individuales de estos conjuntos están mínimamente curadas y, por lo tanto, a menudo no son adecuadas para la investigación en psicología y neurociencia.

Para superar estos problemas, los trabajos recientes han creado grandes conjuntos de imágenes curadas que están diseñadas para estudiar las bases cognitivas y neuronales de la visión humana. Uno de ellos es THINGS, descrito anteriormente.

El cerebro humano logra el reconocimiento de objetos visuales mediante múltiples etapas de transformaciones no lineales que operan a escala de milisegundos. Para predecir y explicar estas rápidas transformaciones, los neurocientíficos computacionales emplean técnicas de modelado de aprendizaje automático.

Sin embargo, los modelos más avanzados requieren cantidades masivas de datos para entrenarse adecuadamente, y a día de hoy se carece de vastos conjuntos de datos cerebrales que muestren ampliamente la dinámica temporal del reconocimiento de objetos visuales.

En [21] se recolecta un amplio y rico conjunto de datos de respuestas EEG de alta resolución temporal a imágenes de objetos sobre un fondo natural.

Este conjunto de datos incluye 10 participantes, cada uno con 82,160 ensayos que abarcan 16,740 condiciones de imagen. En [22] se presenta una colección de datos EEG registrados de 24 observadores donde sus resultados demuestran que los objetos del mundo real desencadenan respuestas cerebrales más fuertes y sostenidas relacionadas con la acción que las imágenes.

En el estudio descrito en [6] se estudia la relación semántica entre pares de sustantivos de objetos concretos como “caballo-oveja” y “columpio-melón” y cómo esta relación de actividad se refleja en las señales de EEG.

Los experimentos realizados fueron diseñados con el objetivo de encontrar evidencia de relación semántica entre dos palabras, en señales electroencefalográficas (EEG) tomadas con un dispositivo EEG comercial (EMOTIV Epoc).

El uso de tecnologías como el EEG portátil en campos relativamente inexplorados como aplicaciones a personas con parálisis cerebral, tienen como objetivo principal emplear recursos modernos y desarrollar una herramienta que mejore la calidad de vida de estas personas; las cuales no pueden comunicar sus ideas, necesidades y expresiones básicas, requieren de la implementación de sistemas de Comunicación Alternativa y Aumentativa (SAAC).

En [23] se desarrolla una interfaz avanzada de comunicación que permite a un individuo controlar un dispositivo externo, tal como una silla de ruedas o un ordenador, mediante señales obtenidas a partir de su propio cerebro.

Este tipo de interfaz incrementaría la independencia del individuo, lo que daría como resultado una mejora en su calidad de vida y una reducción de los costes sociales.

El autor [24] diseña un prototipo de interfaz cerebro-computador para comunicar mensajes simples basado en el paradigma de los potenciales visuales evocados de estado estacionario (SSVEP), el prototipo está destinado a ser un dispositivo de comunicación alternativo para la toma de decisiones a través de observación directa; la elección de un mensaje entre varias opciones predefinidas en una interfaz visual.

Este prototipo le permite al usuario interactuar con el entorno sin la necesidad de mover su cuerpo más allá de los ojos, los cuales son el principal medio por el cual le es posible comunicarse con otras personas sin la necesidad de terceros que le faciliten dicha tarea.

Los principales objetivos dentro del análisis de las representaciones conceptuales en el cerebro son verificar que existe un patrón neuronal identificable asociado con la percepción y la contemplación de conceptos individuales, y que, dependiendo del tipo de estímulo, parte de este patrón se comparte entre varios participantes. Este patrón neural se caracteriza por una distribución de activación a través de muchas regiones corticales, que involucra ubicaciones que codifican varias propiedades de la categoría. El análisis realizado proporciona información sobre los conceptos representados visualmente.

La investigación actual se centra en la comprensión de la codificación y procesamiento de la información en el sistema cerebral, cuantificando cómo este proceso se ve alterado ante la presencia de conceptos, y cómo se puede obtener esa información para generar alguna acción, enviar alguna señal o permitir la interacción con dispositivos artificiales.

2. Materiales y métodos

Para una correcta lectura de las señales producidas por el cerebro es necesario tener un dispositivo robusto que permita la lectura de las ondas que se requieren medir.

Para el caso particular de esta investigación, se considera el uso de una diadema Emotiv Insight, la cual basa su funcionamiento en un conjunto de sensores ubicados estratégicamente en distintas áreas de la cabeza, esto con el fin de interpretar las frecuencias producidas para detectar los pensamientos, expresiones e intenciones del usuario.

Para acceder a los registros de las señales y monitorizarlas en el equipo se hace uso de las herramientas SDK proporcionadas por el fabricante EmotivSystems SDK [25]. Cuenta con múltiples herramientas que puede usarse para simular las señales de entrada, un emulador opcional encargado de enviar la información, con estas herramientas se puede simular pruebas de comportamiento del usuario al momento de usar la aplicación.

El Emotiv Insight posee 3 Suites para la detección de las señales de entrada: Expressiv, que descifra las expresiones faciales; Affectiv, cuya descripción es el estado emocional del usuario, y Cognitiv, cuya interpretación se basa sobre el uso consciente de los pensamientos [26].

Una de las grandes ventajas que proporciona el Emotiv Insight es que posee estas y otras funciones que permiten dar inicio a nuevas propuestas para obtener resultados más completos y funcionales para un margen mayor de usuarios.

2.1. Estímulo visual

Como conjunto de estímulos visuales fue necesario trabajar con un lenguaje que simplificara los pensamientos y la comunicación humana. Para esto se realiza la investigación de cuáles son las necesidades fundamentales de las personas, y se encontró que existe la teoría de las necesidades humanas planteada por Abraham Maslow.

Maslow comprendió la obligación de conocer las necesidades del individuo, tales como; las fisiológicas, de seguridad, sociales, de estima y autorrealización; haciendo especial énfasis en percibir al hombre como un ser innovador ya que Maslow manifestaba que un “hombre autorrealizado” tiene un la capacidad de aceptarse a sí mismo y a los demás, tiene una percepción superior de la realidad, es franco, tiene la capacidad para apreciar y la habilidad para tomar distintos puntos de vista frente al mundo, ser humanizado y sobre todo manifestar su independencia [27].

Tomando como punto de partido un ambiente hospitalario, donde el personal de salud interactúa con personas enfermas o con discapacidad, se genera una nueva lista de necesidades observada por el área de enfermería, donde Virginia Henderson es una de las exponentes más importantes para la enfermería, ya que expone en su teoría que las personas tienen capacidades y recursos para lograr la independencia y la satisfacción a través de 14 necesidades básicas, con el propósito de mantener una salud integral.

En la Fig. 1 se presenta la relación de las necesidades básicas propuestas por Maslow y su asociación al trabajo de Henderson.

Con base en lo analizado sobre la asociación de este lenguaje, representa un conjunto reducido de conceptos básicos, que se puede implementar como un lenguaje de mínima expresión, donde las personas pueden transmitir o expresar sus necesidades básicas.

Por este motivo se asociará un conjunto de estímulos visuales basado en un sistema pictográfico de comunicación. Para la elaboración de tal conjunto de estímulos, se utilizan pictogramas del Portal ARASAACfn, ya que está demostrado que es más transparente en pruebas a distintas poblaciones en comparación a otros conjuntos de pictogramas por lo tanto su significado es fácil de adivinar [28].

Por consiguiente, se escogieron 56 símbolos de acuerdo con las necesidades básicas del paciente expuestas por Henderson (ver Fig. 2) [29], con el criterio de tener una base de datos de pictogramas balanceada en cada clase, en este caso, con 4 pictogramas por necesidad.

2.2. Diseño del experimento EEG

Una característica fundamental para el procesamiento de las señales EEG, es tratar de que al momento de ser recolectadas el usuario esté en un ambiente completamente aislado de elementos externos que puedan presentar ruidos a la señal, como los son distintas temperaturas, objetos visuales que representen distracción del usuario y este pierda de vista el objetivo, o que haga que el usuario se desconcentre.

Un aspecto importante para eliminar estos datos no deseados es tener un espacio con las mismas condiciones siempre, para que el experimento se pueda replicar de manera muy similar en todas las ocasiones y con todas las personas de la población previamente seleccionada.

Un elemento más que permite la correcta recopilación de las señales EEG está representada por el “paradigma” o diseño del experimento, mediante el cual se determina el proceso y los tiempos exactos en el que los estímulos serán presentados al usuario.

En este caso, al trabajar con pictogramas el estímulo es visual, y se requiere una pantalla para presentarlos ante el usuario, un tiempo determinado de presentar cada estímulo para que el cerebro sea capaz de entender y clasificar lo que está viendo, y aunado a esto, un tiempo necesario para que la recopilación de información sea adecuada.

Para diseño de un experimento apropiado es necesario definir el número de estímulos y la frecuencia con la que serán presentados a la población.

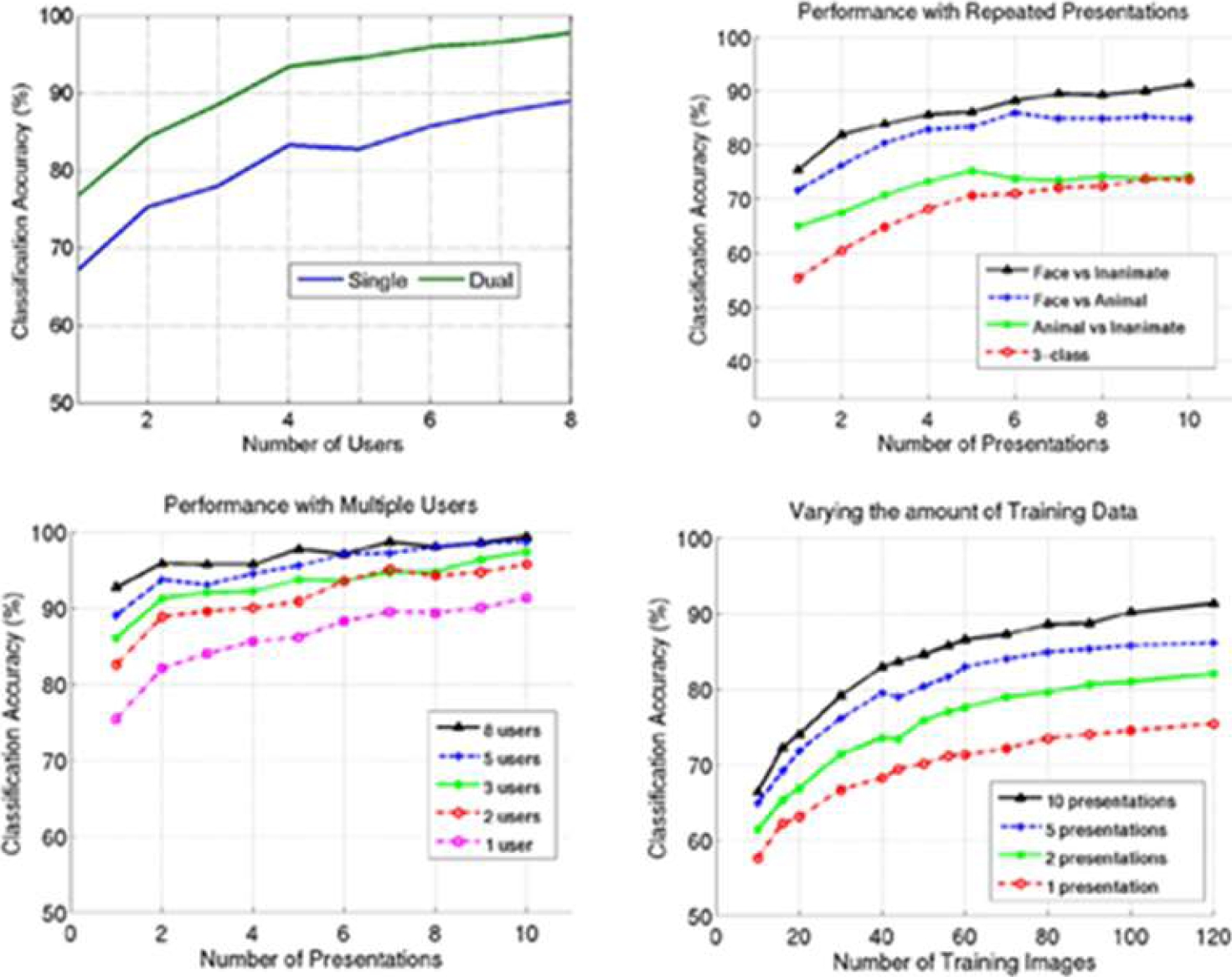

Se analiza el estado del arte, donde se demuestra que, en el diseño de experimentos, si la cantidad de estímulos visuales que se le presentan a los sujetos incrementa, o se repite más veces, genera un incremento proporcional en los resultados de exactitud en su proceso de clasificación (ver Tabla 1), así la presentación de diferentes estímulos de objetos visuales puede provocar cambios detectables en las grabaciones de EEG (ver Fig. 3)

Tabla 1 Análisis de parámetros de evaluación, que son determinados por el tiempo disponible de la muestra [30]

| Tiempo de visualización | Exactitud |

| 40–200 ms | 87.60% |

| 40–360 ms | 90.78% |

Fig. 3 Alteración en el porcentaje de clasificación de señales EEG basado en el número de presentaciones repetidas, el número de sujetos y la cantidad de datos de entrenamiento [31]

Los diseños de los experimentos estudiados en la literatura, en la que se presentan estímulos visuales, ya sea a través de imágenes o pictogramas, confirman después del procesamiento de datos, que estas presentaciones de estímulos visuales provocan un cambio potencial evocado visualmente, por lo que esta línea de estudio se basará precisamente en Potenciales evocados visualmente.

A través del estudio exhaustivo de la literatura es posible determinar el número adecuado de estímulos y la metodología que los autores implementan en caso multicategóricos.

El diseño del experimento implementado se basa en el trabajo [32]. Se realizará cada prueba con múltiples imágenes, se presenta una pantalla con fondo gris y letras negras donde se presentan las instrucciones y procedimiento del experimento, hasta presionar la barra espaciadora para comenzar con la presentación de los pictogramas.

Comienza con una pantalla gris con una duración de 1 segundo para despejar la mente de la persona, posterior a esta se presenta una cruz de fijación blanca en el centro durante 500 ms, con el objetivo de minimizar los movimientos oculares durante y entre los ensayos, cada prueba/ensayo consiste en una sola imagen, colocada sobre un fondo gris con duración de 750 ms, para un intervalo total entre pruebas de 1,250 ms.

En la Fig. 4 se presenta el diseño del paradigma propuesto como experimento inicial. La base de datos de estímulos visuales de EEG incluye 14 categorías diferentes.

Para la generación de las señales EEG se utilizarán 56 pictogramas como estímulos, donde cada categoría de imagen contiene la misma cantidad de ejemplos, específicamente, 4 imágenes de cada una de las siguientes 14 categorías: Respirar, Comer y beber, Eliminar los desechos del organismo, Moverse y mantener postura adecuada, Dormir y descansar, Vestirse y desvestirse, Mantener la temperatura corporal, Higiene corporal, Evitar los peligros del entorno, Comunicarse, Creencias y religión, Trabajar, Recreación y ocio y Aprender.

Los estímulos se presentarán utilizando el software psychopy en bloques de 56 pruebas/ensayos, en los que cada imagen se mostrará 5 veces en orden aleatorio. Se dieron breves descansos después de cada 280 pruebas/ensayo. En total, el participante completó 20 pruebas/ensayos de cada una de los 56 pictogramas, para un total de 1,020 pruebas/ensayos.

El experimento se programa en el software psychohpy, es un paquete de software de código abierto escrito en el lenguaje de programación Python principalmente para su uso en investigación en neurociencia y psicología [33] que resulta bastante versátil debido a que cuenta con un compilador de programación con bloques para diseñar los experimentos.

Otra de las ventajas de este software es que es completamente compatible con las diademas Emotiv, ya que cuenta con componentes de registro de señales de estas diademas, los cuales hacen que Psychopy se conecte a estas para poder enviar los marcadores al flujo de datos.

Este componente debe añadirse al inicio del paradigma, antes de que se presente cualquier estímulo en la parte superior del primer ensayo del experimento para comenzar la grabación. Además, es posible insertar marcadores en el flujo de datos del EEG en el momento en que se presentan los estímulos. Estos marcadores se pueden añadir con etiquetas y valores, así como especificar un intervalo de tiempo enviando un marcador de parada.

De esta manera, al grabar los datos, las señales estarán etiquetadas automáticamente dependiendo de los valores configurados, así como los marcadores ajustados al inicio y final de cada estímulo, lo que permite que en el procesamiento de las señales sea más fácil segmentar las regiones de interés de las señales, teniendo sincronizado el inicio y fin del estímulo con estos marcadores.

De esta forma tenemos diseñado el experimento de una forma rápida y con pocos elementos.

2.3. Registros de EEG y preprocesamiento

Las señales EEG se adquirieron simultáneamente. Se registraron las señales de EEG de 5 sensores continuamente desde la superficie del cuero cabelludo humano según el sistema estándar 10-20 utilizando electrodos de polímeros semi seco.

El nombre de los canales en los que se registraron las señales cerebrales fueron, respectivamente, AF3, AF4, T7, T8 y Pz. Los electrodos de referencia CMS/DRL están localizados en la apófisis mastoidea izquierda.

Los datos del EEG que se registraron con una frecuencia de muestreo de 128 Hz y se filtraron con un filtro pasa banda FIR de 0.16-40 Hz.

A través del software EmotivPro se grabaron las señales generadas al observar los estímulos, el cual nos permite exportar los datos en formatos “.csv” o “.edf”, así como un archivo adicional que contiene los marcadores del inicio y fin de los estímulos sincronizados con las marcas de tiempo.

Como ventaja de este software es su flexibilidad en el formato de información, como se menciona se puede almacenar en el formato de datos europeo (EDF), que es una norma ampliamente aceptada para el intercambio y almacenamiento de datos de electroencefalogramas, de señales biológicas y físicas multicanal entre distintos equipos y laboratorios.

Un fichero EDF estándar consta de un registro de cabecera seguido de registros de datos. El registro de cabecera identifica al paciente y especifica las características técnicas de las señales registradas.

Los registros de datos contienen épocas continuas de duración fija de las señales registradas [34], lo que permite una mejor estructuración y manipulación de los paquetes de datos al momento de procesarse, así como la generalidad de su compatibilidad con softwares de bioseñales.

Asimismo, psychopy tiene la versatilidad de adjuntar los marcadores temporales para el inicio y fin de los estímulos en un archivo externo, esto permite visualizar y segmentar los datos de una forma más sencilla, donde la trama de datos se divide en cada intervalo de tiempo definido, y se adjunta la etiqueta correspondiente al estímulo presentado.

La representación de las señales EEG obtenidas del experimento son procesadas en el software MATLAB, a través de una herramienta de código abierto denominada EEGLAB, que cuenta con múltiples paquetes que permiten examinar las señales de manera más práctica, con funciones predeterminadas que ayudan a generar procesos de filtrado, reducción de ruido y análisis de los componentes de la señal.

2.4. Implementación de filtros

Para el análisis en distintos espectros de las señales, se convierten del dominio del tiempo al dominio de la frecuencia mediante una Transformada Rápida de Fourier (FFT), pero antes de realizarla es necesario eliminar el desplazamiento de corriente continua (CC) de los datos.

Uno de los métodos de eliminación comúnmente utilizado es restar el valor medio de todo el canal de datos. Este método puede dar lugar a un aumento del ruido de baja frecuencia.

Lo ideal es aplicar también un filtro de paso alto que se ajuste a las características de los componentes electrónicos, es decir, utilizar un filtro de paso alto de primer orden de 0.16 Hz para eliminar la señal de fondo (esto también elimina cualquier desvío a largo plazo, lo que no se consigue con el método de sustracción del promedio).

La elección del filtro está basada en un análisis previo de comparación de filtros y su eficiencia, presentado en [35], mediante la medición de distintos parámetros.

Se ha calculado el error cuadrático medio, el error absoluto medio, la relación señal / ruido, la relación señal / ruido pico y la correlación cruzada.

El filtro que proporciona menor error medio absoluto y error cuadrático medio, y al mismo tiempo una relación señal / ruido, una relación señal / ruido pico y una correlación cruzada más alta, se considera un filtro eficaz para la eliminación de artefactos de las señales de EEG.

Basado en este análisis y en el estado del arte, los filtros más implementados y eficientes para el proceso de categorización de objetos con EEG con el fin de eliminar desviaciones lentas en la señal y ruido de alta frecuencia, son los filtros de respuesta finita (FIR) pasa bandas con frecuencias entre 1 y 100 Hz, con variaciones de uso de las ventanas de Hamming o Hannig.

Para eliminar el ruido externo no deseado se diseña un filtro pasa bandas de respuesta al impulso finito, que permita eliminar las frecuencias bajas provocados por el desplazamiento de CC, originado por la digitalización de las señales, y las frecuencias altas que se presentan por el ruido de la línea externa (60 Hz aproximadamente), por lo que se diseña un filtro pasa bandas con frecuencia de corte alta de 0.16 Hz y una frecuencia de corte baja de 40 Hz.

Es muy importante eliminar la señal de fondo antes de realizar una FFT, y es necesario aplicar una función de ventana de Hanning antes de ejecutar la FFT para asegurar que no hay artefactos de envoltura donde la FFT trata los datos como una secuencia que se repite infinitamente, y cualquier desajuste entre las primeras y las últimas muestras aparece como una función de paso en el análisis, inyectando ruido a través del espectro.

Se recomienda filtrar los datos continuos del EEG antes de la eliminación de los artefactos o de la generación de épocas, aunque los datos de las épocas también se pueden filtrar (cada época se filtra por separado).

El filtrado de los datos continuos minimiza la introducción de artefactos de filtrado en los límites de las épocas.

2.5. Eliminación de artefactos

Basado en la investigación, se menciona que puede ser preferible eliminar las partes de los datos que contengan artefactos importantes (mediante inspección visual), como picos grandes en los datos, antes de filtrarlos, ya que el filtrado puede "extender" el artefacto sobre los datos "buenos", lo que requiere que se rechacen más datos después del filtrado.

Cuando se eliminan artefactos importantes, un evento "límite" sustituye a los datos eliminados.

El filtrado sólo se aplica a segmentos de datos continuos, no a través de los límites.

Como parte del procesamiento de los datos, es necesario rechazar las ondas anormales de los datos. Se utiliza el algoritmo de Reconstrucción del Subespacio de Artefactos (ASR), es un método automático de rechazo de artefactos que puede eliminar eficazmente los artefactos transitorios o de gran amplitud que se encuentran en los datos de EEG [36]. El ASR puede utilizarse para corregir las partes anormales de los datos o para eliminarlas.

Para el procesamiento de EEG fuera de línea, se aconseja eliminarlas En primer lugar, ASR encuentra porciones limpias de datos (datos de calibración) y calcula la desviación estándar de los componentes extraídos del análisis de componentes principales (PCA) (ignorando las ondas alfa y theta fisiológicas del EEG al filtrarlas).

Rechaza las regiones de datos si superan 20 veces (por defecto) la desviación estándar de los datos de calibración. Cuanto más bajo sea este umbral, más agresivo será el rechazo [37].

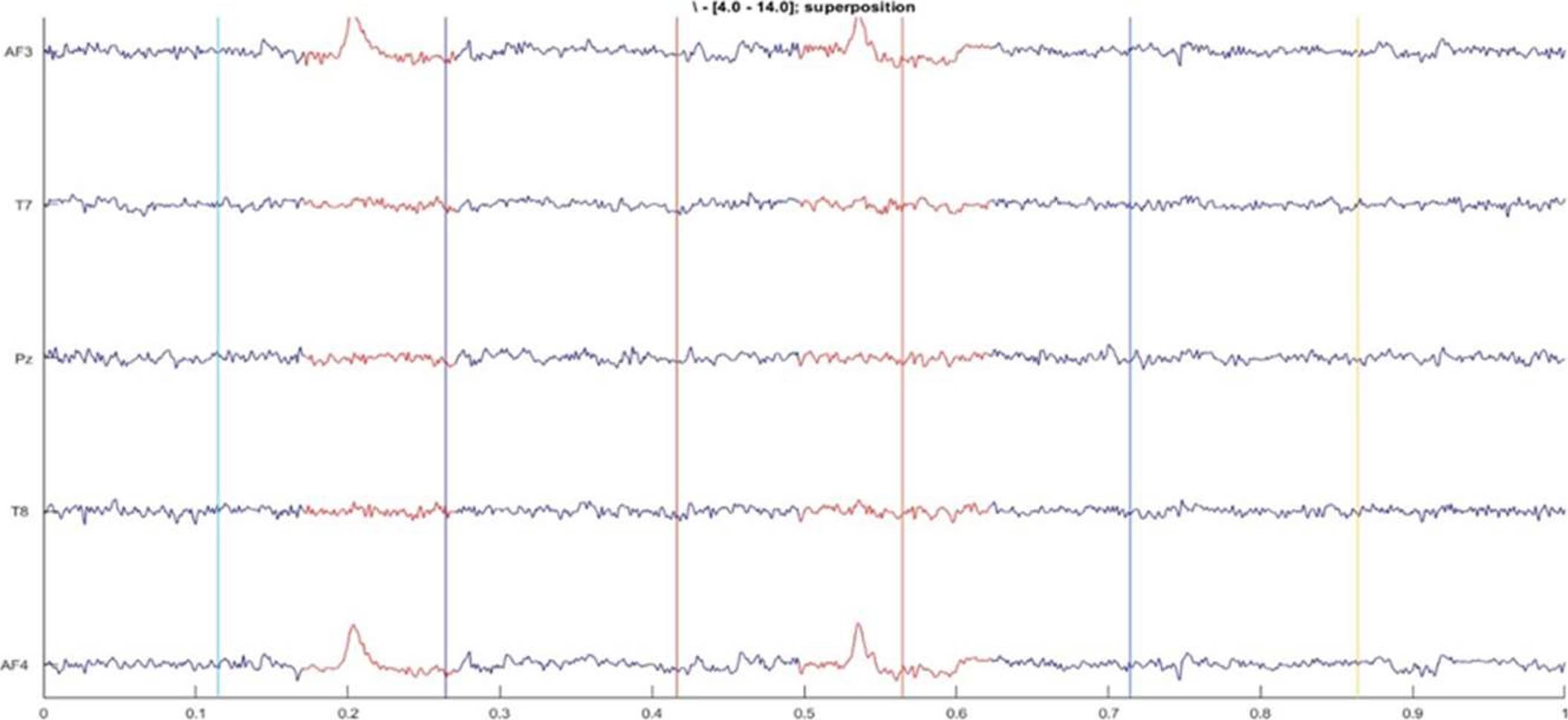

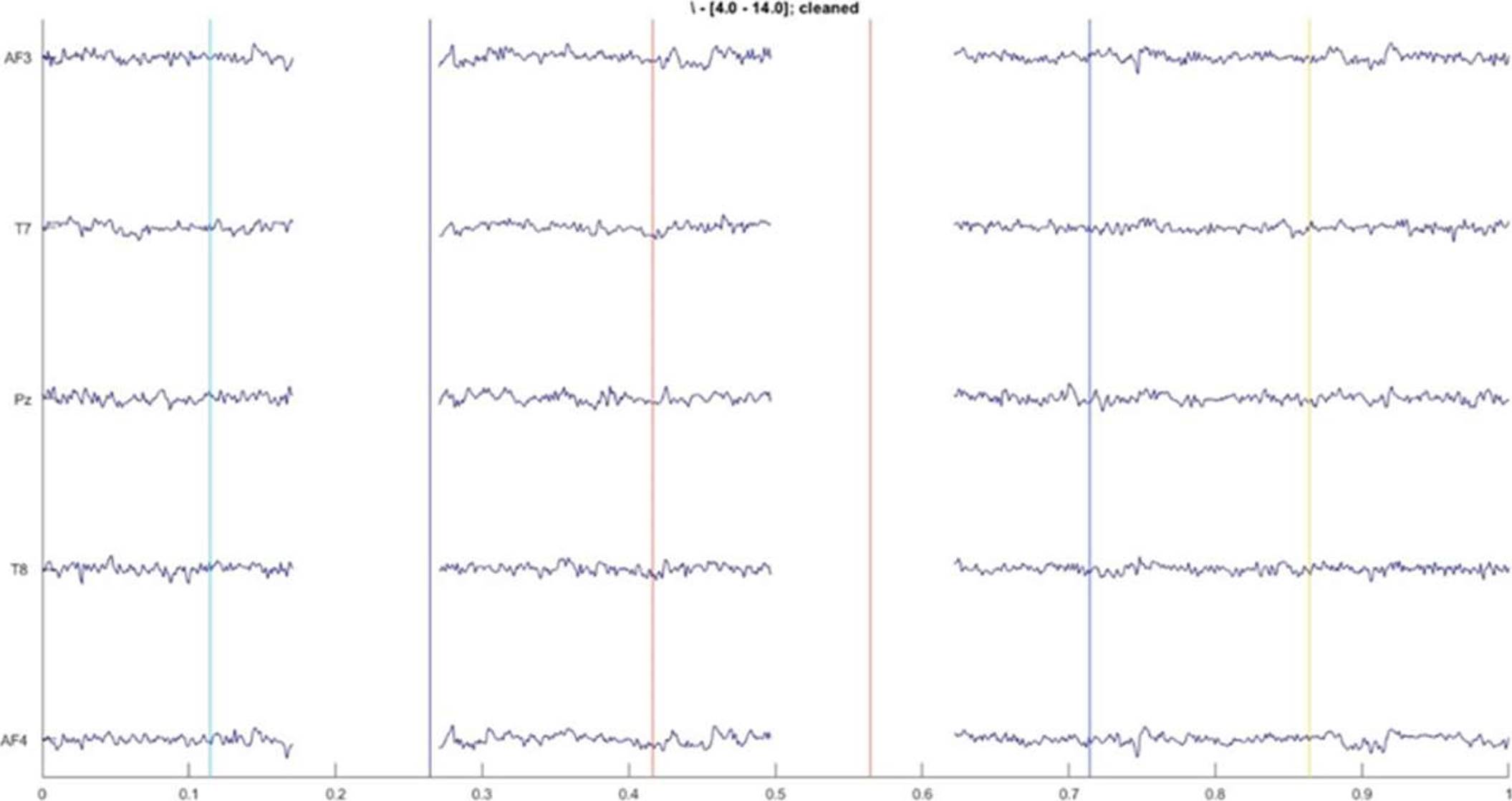

Podemos ver en la Fig. 5 se aprecia en color rojo la porción de datos rechazados en un segmento de tiempo determinado.

A continuación, se muestra el resultado del rechazo de datos en el conjunto de datos original. Estos artefactos son eliminados de manera completa en la trama de datos (ver Fig. 6), para quedarse únicamente con las señales más limpias posibles, posteriormente la señal es reconstruida.

En la literatura se ha demostrado ampliamente que el análisis de componentes independientes (ICA) desarrollado recientemente es una herramienta eficaz para la identificación y extracción de artefactos de registros EEG y uno de los algoritmos más utilizados en este proceso [38].

ICA es un método de procesamiento de señal para separar fuentes independientes mezcladas linealmente en varios sensores. Es una técnica estadística novedosa que tiene como objetivo encontrar proyecciones lineales de los datos que maximicen su independencia mutua.

Sus principales aplicaciones son la extracción de características y la separación ciega de fuentes (BSS por sus siglas en inglés). Se implementa en análisis de EEG para detectar artefactos en señales registradas originalmente.

Por lo general, los artefactos oculares, musculares, electrocardiográficos y de líneas eléctricas se rastrean con el uso de este método. Es un hecho bien conocido que en el caso de EEG multicanal, ICA mejora la calidad de la señal [39].

Para el caso particular de este artículo, se implementan las herramientas que ofrece EEGLAB para la identificación automática de artefactos. Los artefactos oculares se eliminaron del registro EEG utilizando el algoritmo extendido Infomax ICA.

Se analizaron los componentes independientes para eliminar aquellos con ruido o que representen artefactos. En la Fig. 7 se analizan los componentes resultantes al aplicar el algoritmo ICA a las señales, donde se aprecia que el primer componente representa artefactos oculares por el comportamiento de las ondas, por lo que se elimina de los datos.

3. Resultados obtenidos

Para estudiar la dinámica del EEG relacionada con los eventos de los datos grabados continuamente, es necesario segmentarlos, se requiere extraer las épocas de los datos que están vinculadas a los eventos de interés (por ejemplo, las épocas de los datos que están vinculadas a los inicios de una clase de estímulos experimentales).

Los datos se dividieron en épocas que van de los -500 a 1000 ms con respecto al inicio del estímulo.

3.1. Potencial relacionado con eventos (ERP)

El objetivo de los paradigmas de EEG relacionados con eventos es recopilar los procesos cerebrales que se desencadenan por estímulos externos, en este caso, es precisamente lo que se tiene, la respuesta ante el estímulo externo.

La forma de onda EEG media restante es el potencial relacionado con el evento, que refleja la actividad EEG media relacionada con el estímulo desencadenado por un estímulo específico. Los ERP pueden describirse por varias características: apariencia y forma, número, latencia, amplitudes de las curvas, componentes del ERP (picos positivos y negativos) y topografía (que es la distribución de voltaje en los momentos pico en todos los electrodos). Los componentes ERP como el N400, P300 o N170 representan algunos de los componentes ERP más ampliamente analizados y mejor entendidos en la investigación académica [40].

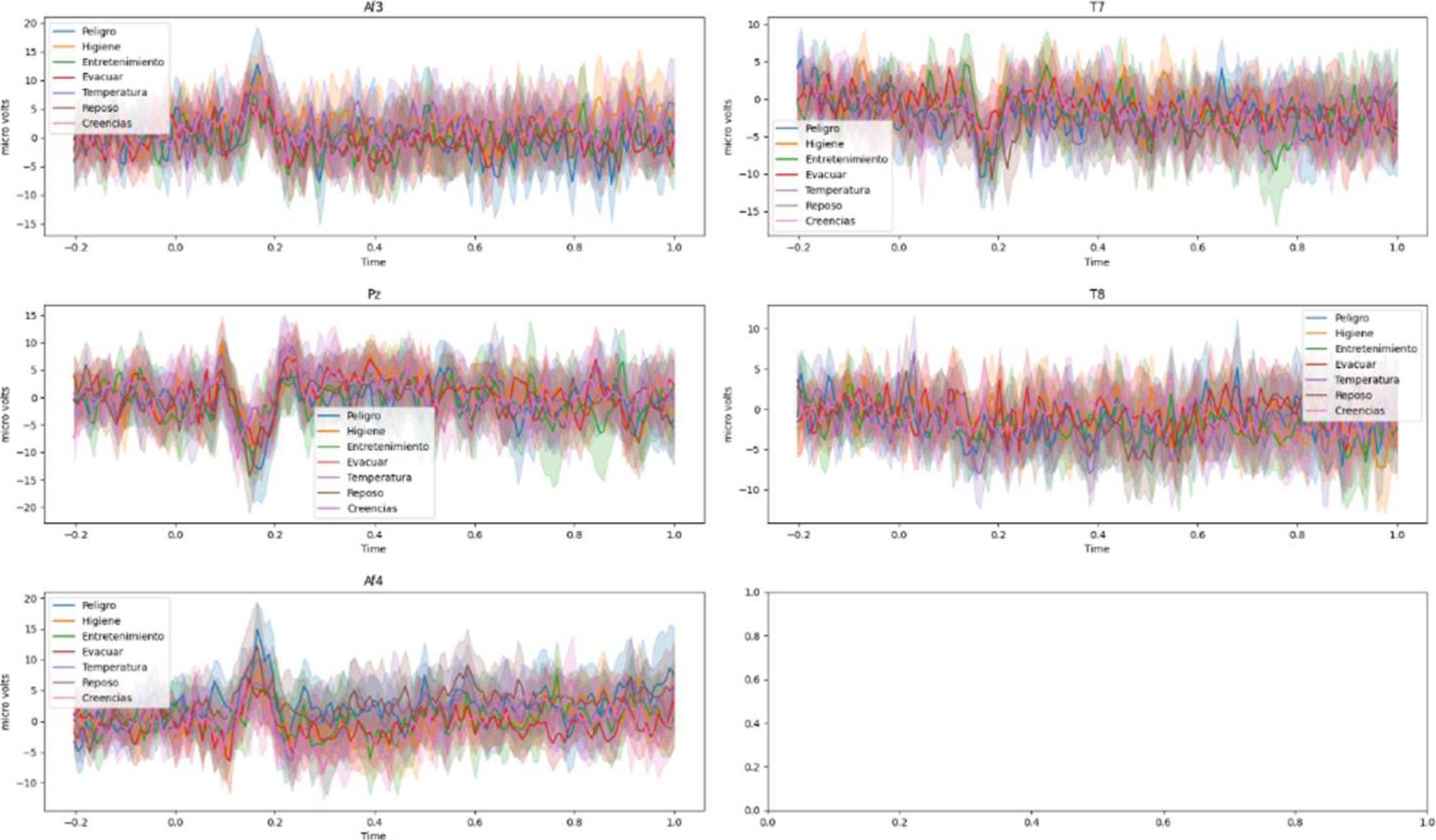

Se grafican lo potenciales relacionados con eventos de cada uno de los 5 electrodos, para cada una de las 14 clases estudiadas, con el objetivo de realizar un análisis de las formas de onda de estos, y verificar si es posible determinar algún patrón en cada categoría que ayude a su clasificación y permita su uso en sistemas de procesamiento de lenguaje natural y medios de comunicación aumentativa.

Para objetivos de visualización de los resultados, los análisis se presentan en segmentos de la mitad de la base de datos, es decir, en secciones de 7 de las 14 clases.

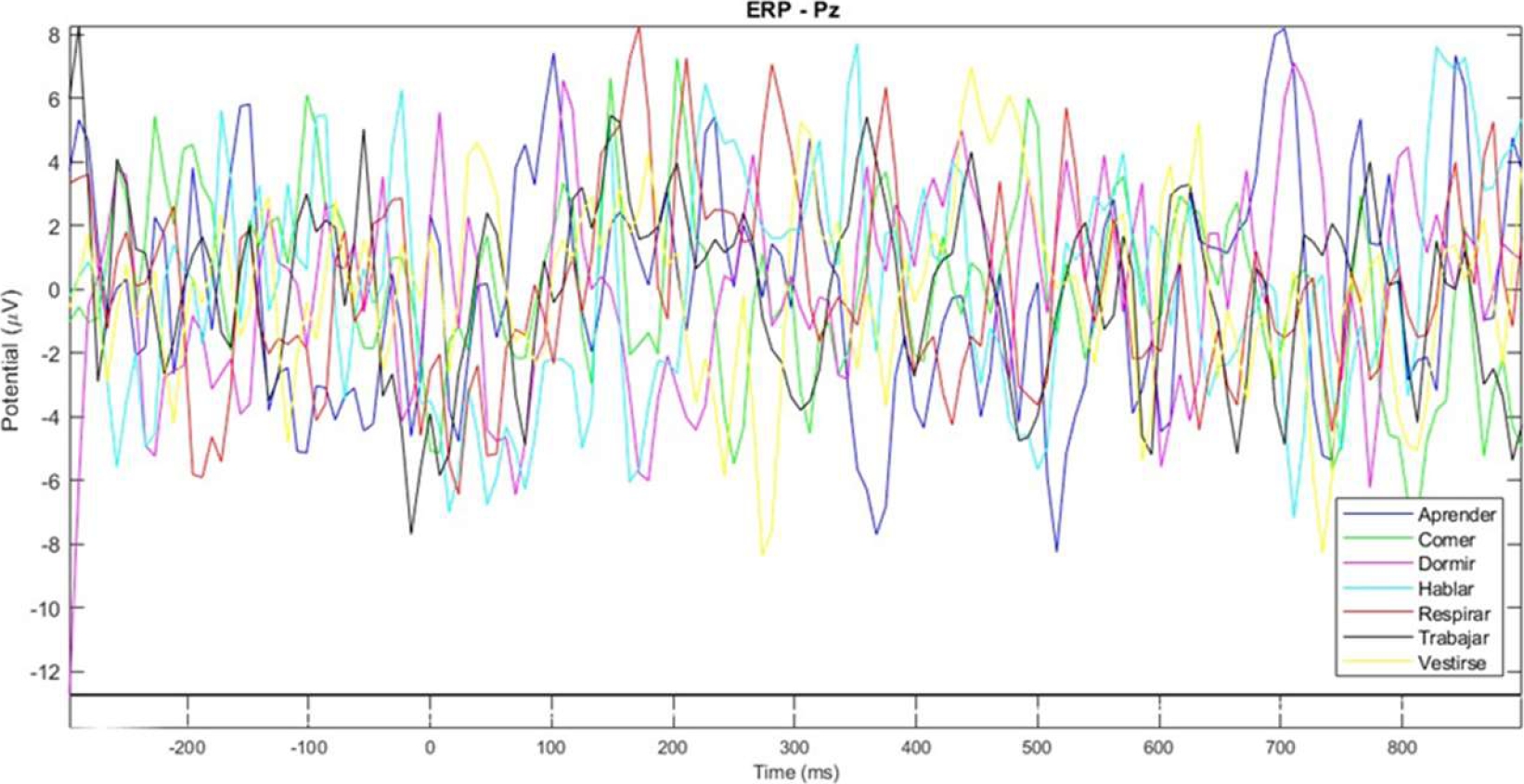

En la Fig. 8 se presentan las señales obtenidas de las 7 primeras clases presentadas, concentradas en el electrodo Pz que es el que se encuentra en la parte central, como se sabe no existe un lóbulo central únicamente se utiliza para ubicar la parte central del cráneo, la Z (zero) hace referencia a la mitad de la cabeza, y divide en el hemisferio derecho e izquierdo.

Fig. 8 Gráfica de los potenciales relacionados con eventos de las señales de 7 clases distintas, analizadas en el electrodo Pz

Al graficar la actividad de las señales en el espectro del tiempo, se presentan múltiples cambios de amplitud entre las diferentes clases, lo que representa diferentes potenciales de activación a lo largo del tiempo, esto significa que cada una está representada por su propia información, y tienen ese grado de diferencia entre ellas, para poder ser discriminadas.

Es posible observar el comportamiento de las señales de cada electrodo y la actividad correspondiente de estos, para detectar las zonas de mayor actividad cuando las personas observan un determinado concepto, y de esta manera conocer qué electrodos y en qué zonas cerebrales se presenta mayor información.

Los ERP proporcionan un medio no invasivo de medir la actividad cerebral en humanos, su resolución temporal de milisegundos y su resolución espacial aproximada complementan la resolución temporal aproximada y la resolución espacial fina de fMRI, lo que representa una ventaja en este tipo de estudios.

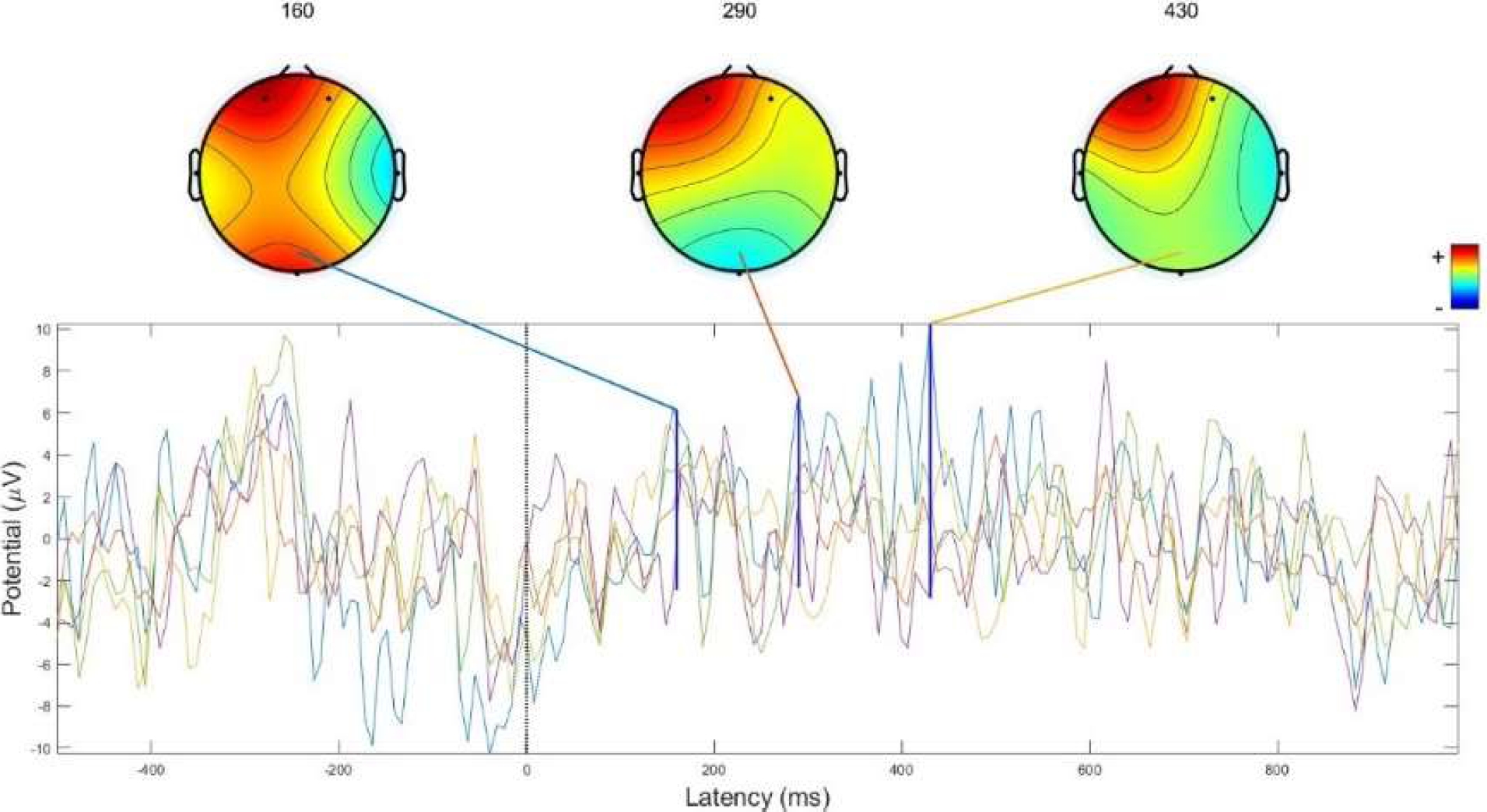

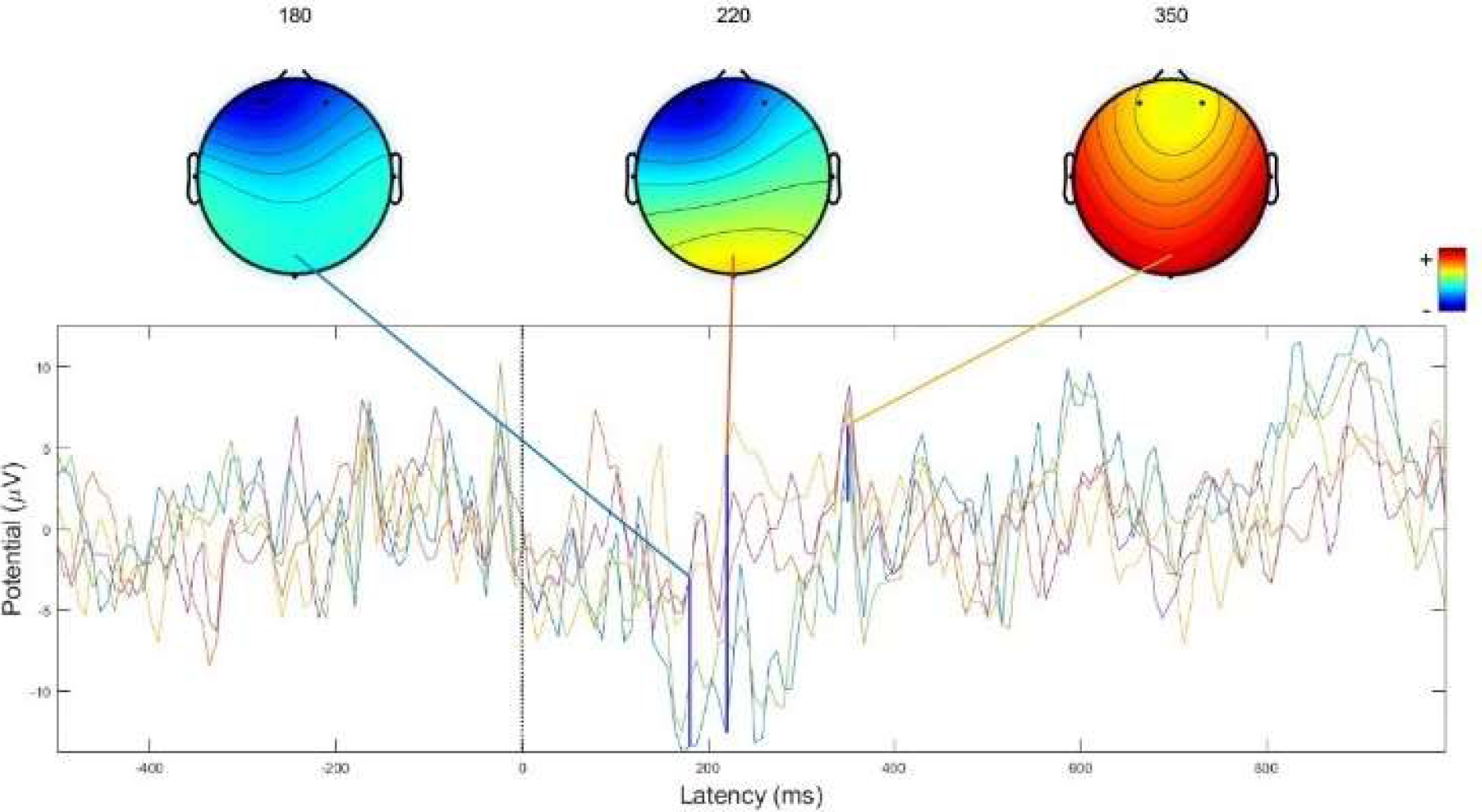

Se grafican de manera individual las clases para observar la forma de las gráficas entre clases. En la Fig. 9 se grafica la respuesta de la clase “Trabajar” y en la Fig. 10 la respuesta de la clase “Hablar”.

Fig. 9 Potencia de las señales EEG para la clase “Trabajar” donde se observan mayores cambios de amplitud

Fig. 10 Potencia de las señales EEG para la clase “Hablar” donde se observan mayores cambios de amplitud

Cada trazo representa el promedio del ERP en un canal. Los mapas del cuero cabelludo muestran la distribución topográfica del potencial promedio en las latencias de la máxima varianza de datos de ERP.

La clase “Trabajar” arroja ondas con mayor varianza en los potenciales positivos, como en P100, P300, P450 aproximadamente, mientras que en la clase “Hablar” tiene transiciones completas desde la parte negativa hasta la positiva, con variaciones en N200 y P300.

En la tabla 2 se presenta una relación entre algunas de las categorías presentadas a los usuarios y el tiempo en el cuál se presenta la máxima varianza de los potenciales relacionados a dichos eventos.

Tabla 2 Tiempo en el que se detecta el mayor cambio de potencial de cada clase

| Categoría | Latencia de máxima varianza (ms) |

| Aprender | 94 |

| Comer | 258 |

| Hablar | 173 |

| Dormir | 156 |

| Vestirse | 273 |

| Respirar | 525 |

| Trabajar | 431 |

| Peligro | 352 |

| Higiene | 145 |

| Entretenimiento | 188 |

| Evacuar | 197 |

| Temperatura | 261 |

| Reposo | 144 |

| Creencias | 108 |

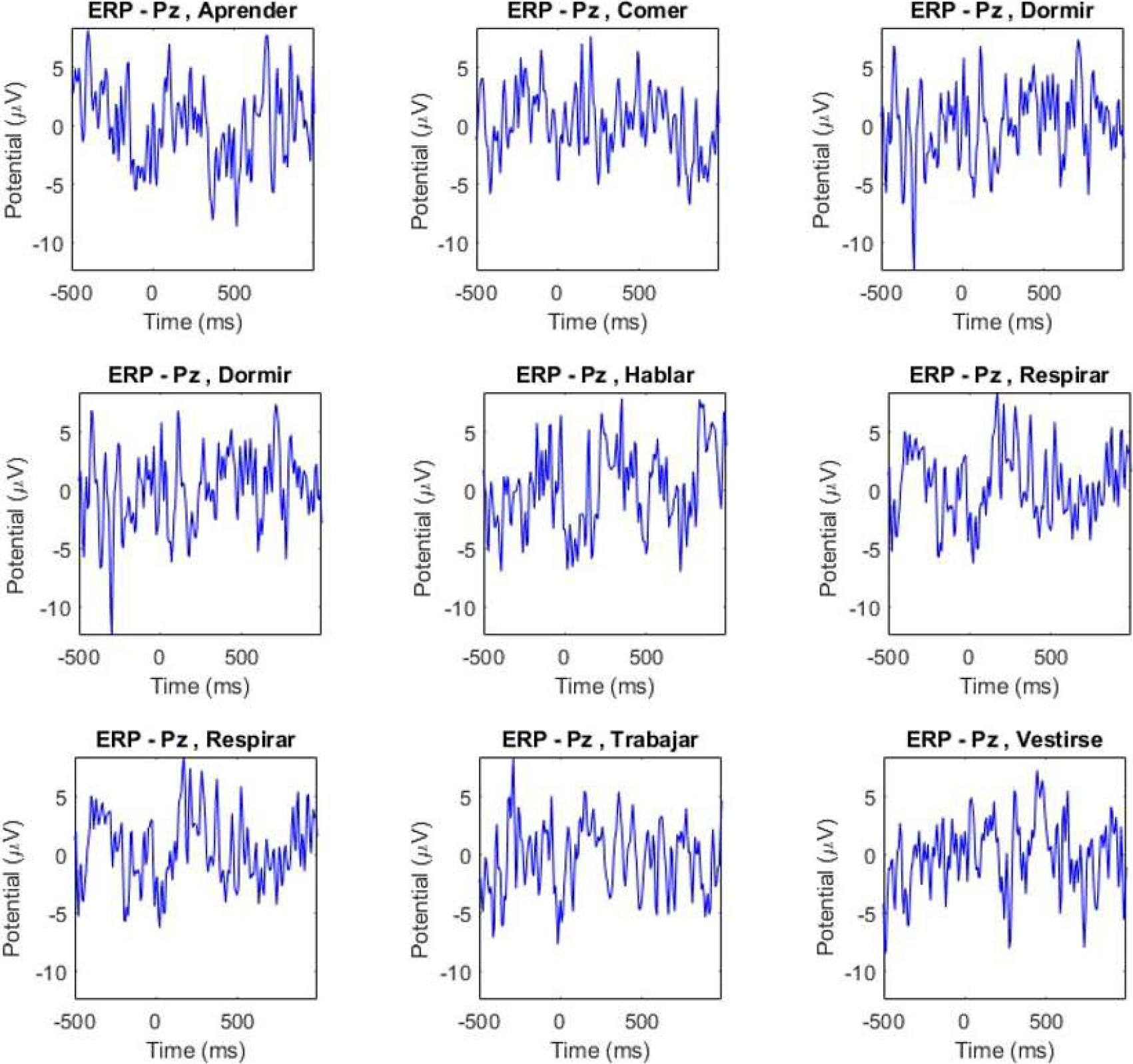

En la Fig. 11 se grafican clases distintas para analizar sus formas de onda, donde se observa que cada clase cuenta con sus propios patrones discriminativos, lo que permitirá un análisis a nivel individual.

Fig. 11 Gráfica de los potenciales relacionados con eventos de las señales de 7 clases distintas, analizadas en el electrodo Pz

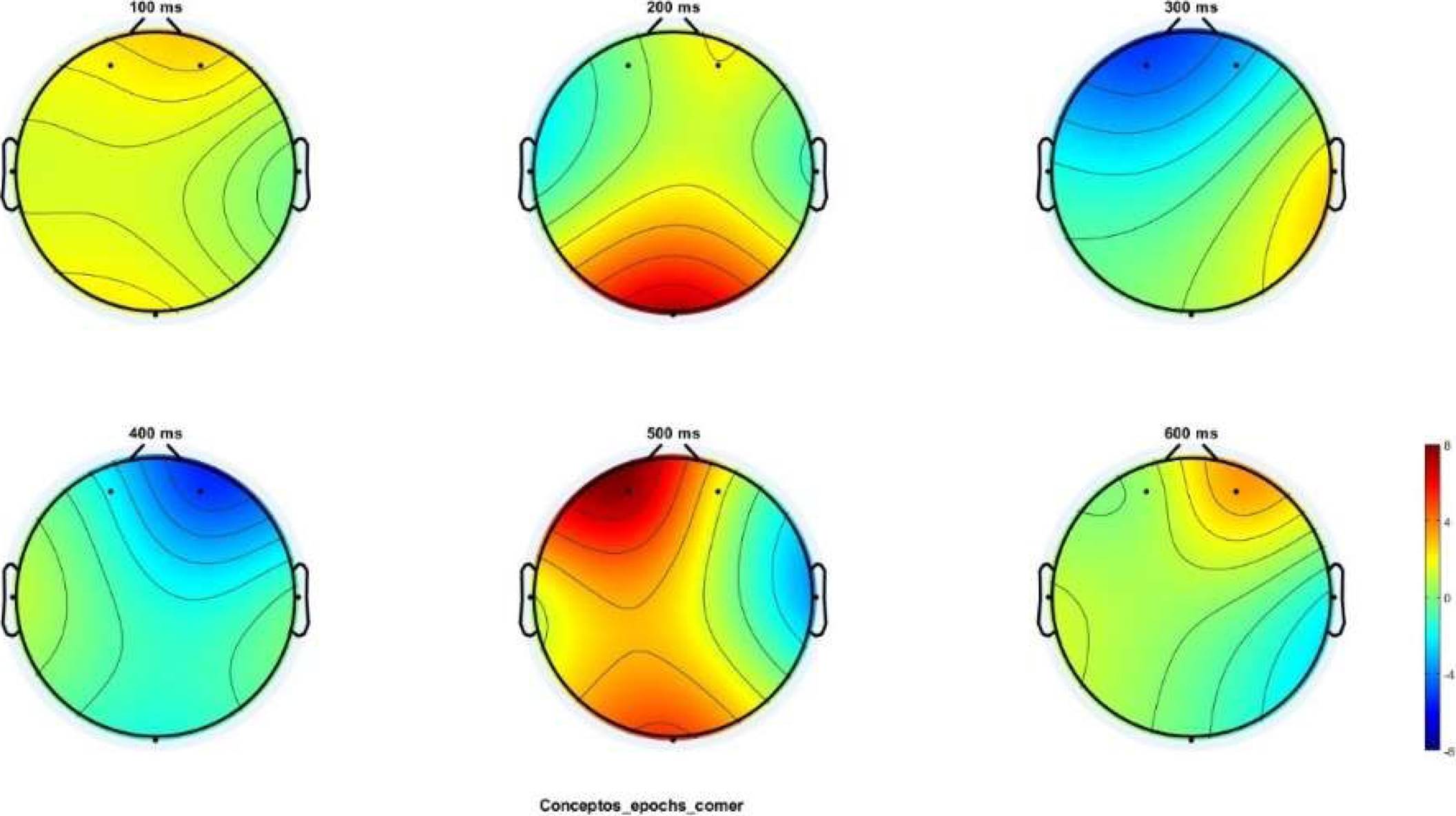

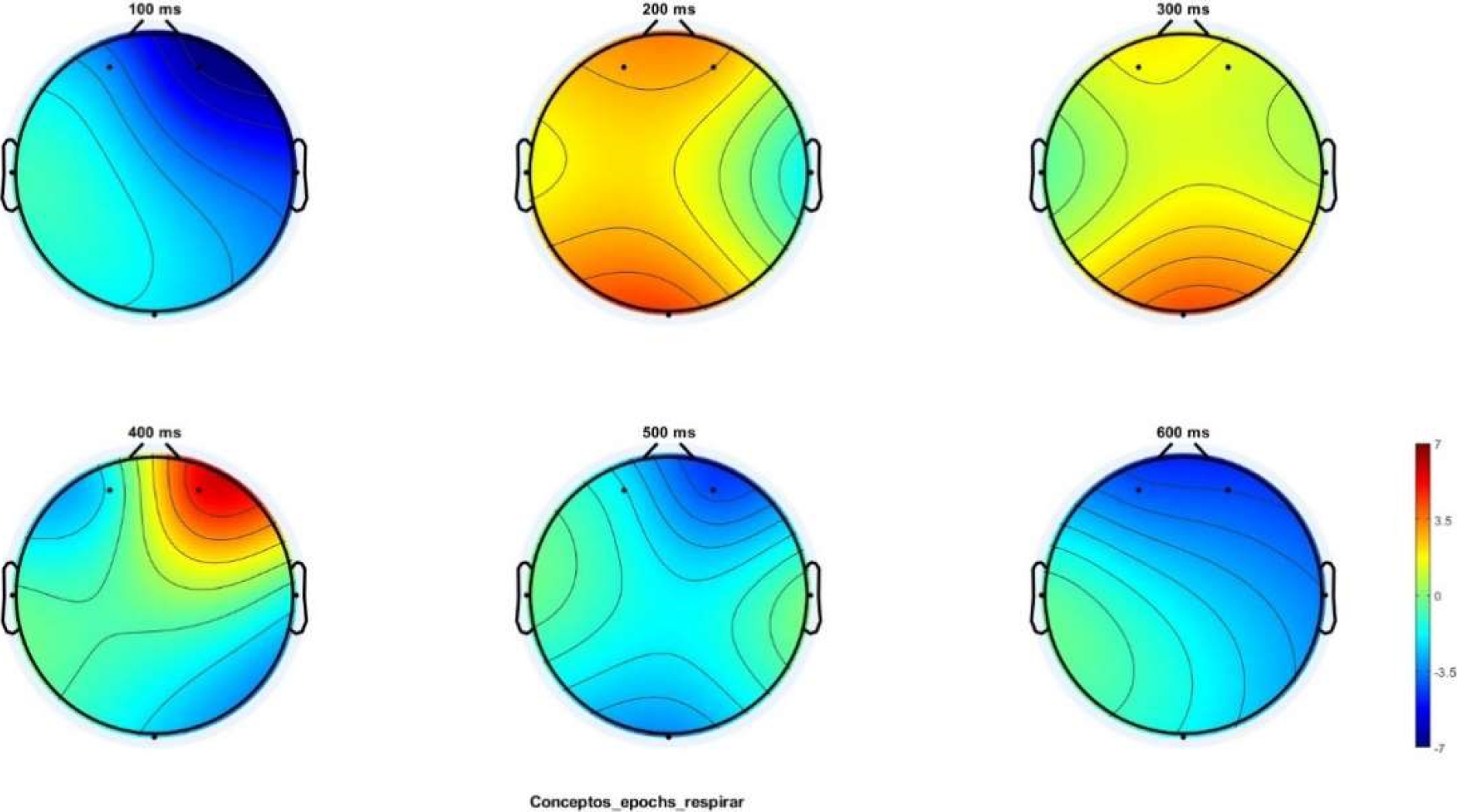

Se obtiene la intensidad de actividad cerebral en cada momento del tiempo y en las Fig. 12 y 13, que hacen referencia a la clase “Comer” y “Respirar” respectivamente, se trazan los datos de ERP para una serie de mapas del cuero cabelludo en 2-D que representan las distribuciones de potencial en una serie seleccionada de latencias de ensayo.

Fig. 12 Mapas 2D para representar las amplitudes de potencial en distintos puntos de tiempo para la clase “Comer”. La barra de colores representa el nivel de intensidad o amplitud de las señales, y si es un componente negativo (colores azules) o si es un componente positivo (colores rojos). Estas representaciones espaciales permiten analizar las zonas cerebrales de mayor actividad

Fig. 13 Potencia de las señales EEG para la clase “Respirar” donde se observan mayores cambios de amplitud

Estas representaciones demuestran las diferencias de intensidades para cada clase, en instantes distintos de tiempo, en donde para la clase “Comer” se presentan mayores intensidades positivas, es decir, en los componentes ERP predominan los potenciales positivos, mientras que en la clase “Respirar” se aprecia una mayor frecuencia de potenciales negativos a lo largo del tiempo.

Este tipo de características son elementales para los procesos de categorización de las clases.

Las secuencias de mapas de voltaje cambian sus características de distribución a lo largo del tiempo en función de las propiedades del estímulo o de los diferentes estados internos. Dependiendo de dónde sean más fuertes los voltajes (polos positivos y negativos), se puede inferir qué regiones del cerebro están activas en un momento dado.

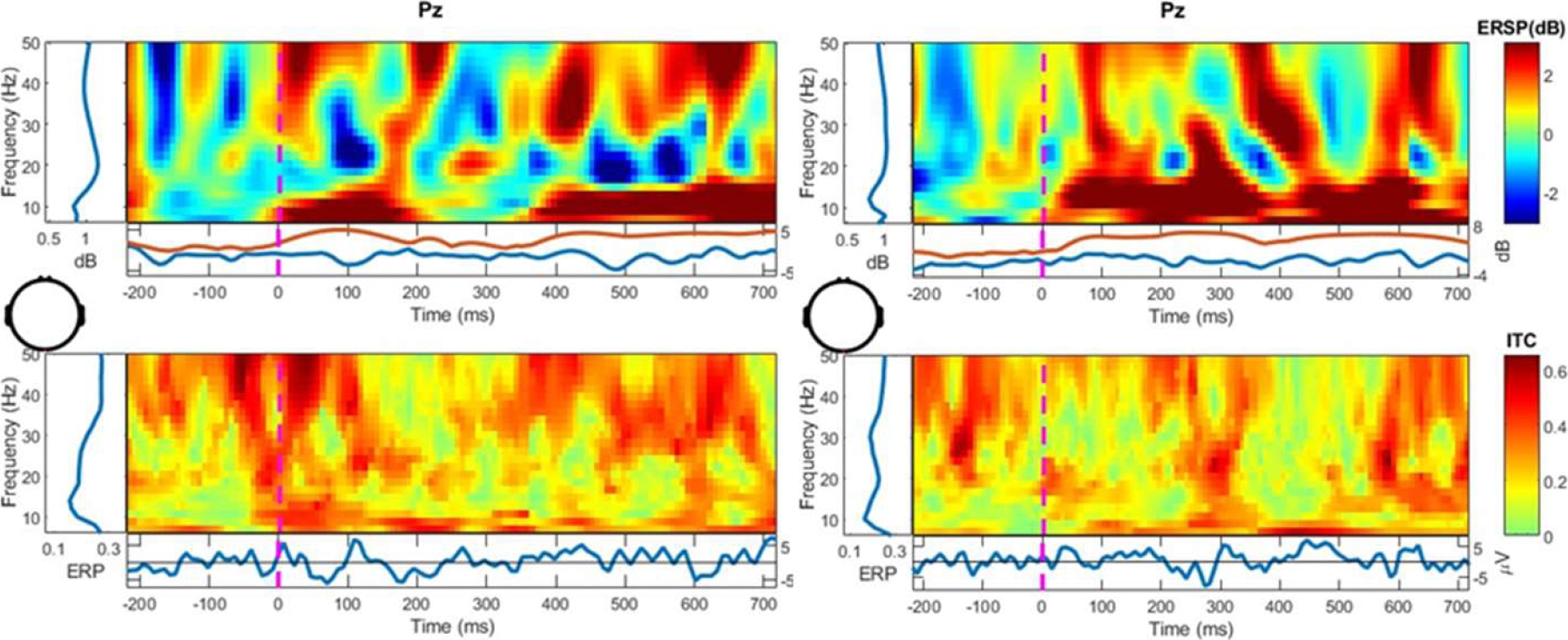

En la Fig. 14 se grafica la perturbación espectral relacionada con el evento (ERSP), esta refleja la medida en que la potencia en diferentes frecuencias en una señal se altera en relación con un punto de tiempo específico, como el inicio de la señal.

Fig. 14 Perturbación espectral relacionada con el evento (ERSP) graficada para el electrodo central Pz, para medir la potencia en diferentes frecuencias

De esta forma podemos analizar los cambios medios relacionados con el estímulo correspondiente, en la potencia espectral en el momento deseado durante la época y en cada nivel de frecuencia. Se observa que, en la gráfica del lado izquierdo, que es la representación del ERSP del estímulo “Dormir” los potenciales son más altos a frecuencias más bajas (10 Hz), justo después de comenzar el estímulo y al finalizar este. Mientras que, en la gráfica del lado derecho, que es la representación del ERSP del estímulo “Vestirse”, los potenciales positivos se presentan a mayores frecuencias (Arriba de 10 Hz) y aproximadamente después de los 100 ms y hasta terminar el estímulo.

En la parte de abajo de la Fig. 14 se presenta la coherencia intertrial (ITC) es una medida en el dominio de la frecuencia de la sincronización parcial o exacta de la actividad en una latencia y frecuencia particular para el conjunto de eventos experimentales.

Finalmente, en la Fig. 15 se grafican cada uno de los canales EEG divididos en épocas, donde se promedian todas las lecturas tomadas de cada una de las 7 clases restantes, y se grafican sobrepuestas, para analizar la diferencia de los espectros entre ellas.

3.2. Discusión

Generalmente, en los potenciales relacionados con eventos, el análisis se centra en las diferencias en la latencia, la amplitud o la distribución topográfica de la ERP en determinados puntos temporales fijados en el tiempo, al inicio del estímulo y entre las condiciones.

No todos los componentes de la ERP proporcionan la misma cantidad de información discriminativa y, por lo tanto, las características extraídas de ellos no deben tratarse por igual, y es necesario integrar y aprovechar al máximo la información discriminativa contenida en múltiples componentes de los ERP de forma adecuada para mejorar los resultados de la discriminación de objetos. Cada onda generada por una clase tiene sus propias características y estructura en el tiempo.

Dado que ciertos componentes ERP desempeñan un papel muy importante en la clasificación de los datos del EEG como el N1, para procesos posteriores de clasificación se podría comenzar con el análisis de este y posteriormente buscar componentes ERP complementarios para formar las características ERP combinadas.

Mediante todas estas métricas es posible examinar los cambios en el rendimiento de todos los ensayos, lo que permite generar un conjunto de características bastante robusto para un método de clasificación posterior.

4. Conclusiones

Este artículo demuestra que es posible generar un conjunto de pictogramas asociados al proceso de comunicación humana para su uso en experimentos de EEG, con el fin de analizar las señales generadas. Los datos actuales muestran que la categoría de un concepto visual se puede decodificar analizando sus características a partir de los primeros componentes visuales del EEG del cuero cabelludo.

Basado en los resultados expuestos, se concluye que estos conceptos en el cerebro humano tienen formas de onda y características distintas, lo que permite en un trabajo a futuro realizar una clasificación con las características obtenidas a través de los ERP, y que asimismo, mediante estos potenciales es posible identificar los tiempos en donde las señales tienen una mayor varianza en los datos y en qué componentes, ya sean positivos o negativos, para cada una de las clases presentadas, lo que permite una discriminación entre ellos, y conlleva al análisis más específico de cada clase de señal.

Aunado a esto, es posible conocer las regiones cerebrales que se activan con cada concepto a través de los mapas topográficos en 2D del cuero cabelludo, lo que representa una primera aproximación en la clasificación de conceptos de un lenguaje de comunicación de mínima expresión, sustentado específicamente en las necesidades más básicas del ser humano.

Estudios como este que demuestran que el conocimiento conceptual y el análisis de categorías semántico pueden analizarse mediante EEG, representan un área de investigación potencial, en la que se puede profundizar en el análisis de las señales adquiridas, en la combinación de metodologías existentes con el fin de crear procedimientos de análisis híbridos y evaluar su precisión.

El objetivo final del análisis de las señales EEG es lograr una respuesta razonable directamente a la intención del usuario.

Esto se ha convertido en una importante oportunidad de desarrollo en el campo del procesamiento del lenguaje natural.

Este estudio genera un camino hacia la interactividad entre personas y dispositivos encargados de la adquisición de señales EEG, para la generación de control o acciones específicas con dispositivos físicos e inteligentes, basado específicamente en conceptos asociados a la comunicación y necesidades humanas.

El estudio de los potenciales evocados relacionados a eventos es comúnmente utilizado para el análisis de las señales de EEG, ya que son fácilmente identificables y relacionables con una causa específica.

Estos potenciales se manifiestan con mayor amplitud en la corteza visual del lóbulo occipital, los cuales son generados como respuesta a un estímulo visual en determinada frecuencia, y a través del proceso aquí realizado es posible identificar sus rasgos discriminantes para cada clase.

nueva página del texto (beta)

nueva página del texto (beta)