Introducción

La evaluación de impacto de políticas y programas públicos es uno de los temas de mayor interés en los últimos años a un lado y otro del Atlántico debido a la importancia de la información que genera para la toma de decisiones, al mismo tiempo que por la complejidad metodológica que implica su realización.

El predominio del positivismo ha provocado que, al menos en Iberoamérica,1 la evaluación de impacto se vincule con el empleo de diseños experimentales (o cuasiexperimentales) e hipótesis contrafactuales, como si se tratara de las dos caras de una misma moneda. Sin embargo, un examen pormenorizado de la bibliografía2 generada en otros países pone de relieve que el panorama de la evaluación de impacto es más rico y diverso de lo que, en un principio, pudiera parecer a tenor del discurso dominante, asumido o impulsado por muchos organismos, instituciones y foros científicos y académicos.

Ya en una primera aproximación a los trabajos teóricos y empíricos realizados en este campo, se percibe que varios omiten la conceptualización de impacto (también de su evaluación) o parten de una definición que se asume como indiscutible, como si existiera al respecto un consenso universal. Clarificar el concepto es imprescindible para construir el trabajo científico sobre bases sólidas3 y permitir el debate entre diferentes enfoques teórico-metodológicos. En este caso, la dificultad se agrava por los problemas de traducción.

En consecuencia, el presente artículo tiene como objetivo presentar la situación de la evaluación de impacto reinante en las instituciones especializadas de España y de tres de los países latinoamericanos con mayores avances en la materia (Colombia, Chile y México), que se caracteriza por la presencia casi exclusiva de enfoques y métodos experimentales, para luego ofrecer una revisión documental amplia del marco teórico-conceptual-metodológico de la evaluación de impacto, recuperando especialmente los diversos enfoques y métodos no experimentales disponibles, con sus ventajas y desventajas, y señalando algunas experiencias en las que éstos han sido empleados con éxito.

Se trata fundamentalmente de analizar y compartir un abanico de posibilidades, cuya difusión es particularmente limitada en los tres países latinoamericanos seleccionados, para enriquecer sus opciones teórico-metodológicas. Por razones de espacio no es posible exponerlas detalladamente, pero se ofrecen referencias para quienes se interesen en profundizar en cada una de ellas.

La evaluación de impacto en Iberoamérica

Si bien existen evaluaciones de impacto de programas4 en diversos países de Iberoamérica (Argentina, Brasil, Ecuador, Costa Rica, Uruguay, Nicaragua, Bolivia, Perú, entre otros), como ya se mencionó, esta revisión sólo incluye el caso de España y de los tres países latinoamericanos que presentan el mayor número de evaluaciones de este tipo en los últimos años: Colombia, Chile y México. Para efectuarla, se procedió a una intensa búsqueda de información en libros, revistas, internet, así como consultas a especialistas de los países incluidos.

Como antecedente de este trabajo, en 2005 la Comisión Económica para América Latina (Cepal)5 ya había analizado evaluaciones de impacto en la región, encontrando el mismo énfasis experimental de los casos que a continuación se refieren: dos utilizaron un modelo experimental, quince cuasiexperimental, uno combinando los dos anteriores y sólo uno no experimental (en Perú).

España

En los últimos años y desde distintos frentes, en España se insiste en la necesidad de que el diseño de las políticas y los programas públicos se base en evidencias sólidas y de que la evaluación se convierta en uno de los principales instrumentos para lograrlo, poniendo en práctica las recomendaciones de evaluadores y otros expertos, en lugar de dejarse llevar por la inercia o por la ideología en programas cuya efectividad no está comprobada o que resultan demasiado costosos. Casi siempre, el reclamo ha acompañado la apuesta por los diseños experimentales (y la evaluación de impacto entendida como equivalente).6

España cuenta con tres organismos públicos de evaluación, todos de carácter generalista: la Agencia Estatal de Evaluación y Calidad (Aeval), creada en 2006, la Comisión Foral de Evaluación de las Políticas Públicas y la Calidad de los Servicios de la Comunidad Autónoma de Navarra y el Instituto Catalán de Evaluación de Políticas Públicas (Ivalua), constituidos en 2005 y 20067 respectivamente. Junto a éstos, existen unidades u organismos de evaluación sectoriales (por ejemplo, centrados en educación, cooperación al desarrollo, investigación, etcétera) tanto a nivel estatal como en algunas comunidades autónomas, lo que genera un elevado -y no siempre positivo- grado de fragmentación.8

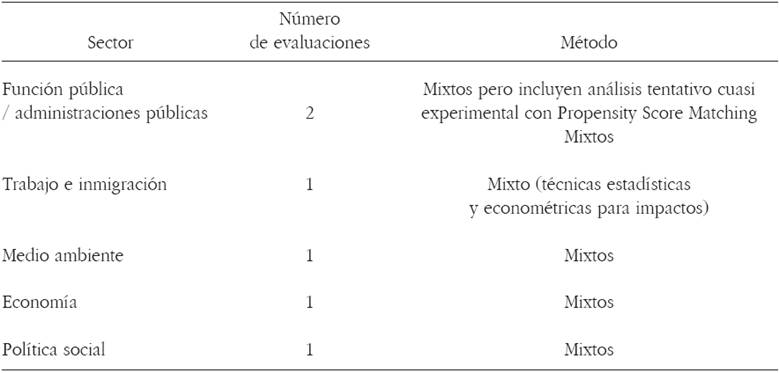

De los tres organismos, Ivalua desarrolla una actividad más destacada en materia de evaluación de impacto; de hecho, este tipo de evaluación, en su orientación cuantitativista y experimental, constituye una de sus principales señas de identidad. Las evaluaciones de impacto realizadas (15) suponen casi 33% del total (46) en el periodo 2008-2015.9 La relevancia que se otorga a ese tipo y método de evaluación se advierte también en otros detalles. Así, su definición de evaluación de impacto gira en torno a la hipótesis contrafactual, propia de los diseños experimentales. El discurso que impregna los informes, los boletines de noticias y los eventos científicos, de formación y de difusión de Ivalua -basta una rápida consulta a su página electrónica- subraya la necesidad de fomentar ese tipo de evaluación y de diseños. Es lógico, pues, que seis de las siete evaluaciones de impacto de las que tenemos información hayan seguido una perspectiva experimentalista y que, en el caso que utilizó una alternativa diferente (teoría del programa), el propio informe señale que esta perspectiva no permite evaluar los impactos de forma robusta.

Fuente: [http://www.ivalua.cat/generic/static.aspx?ID=782&], fecha de consulta: 12 de junio de 2016.

Cuadro 1 Evaluaciones de impacto realizadas por Ivàlua 2008-2015

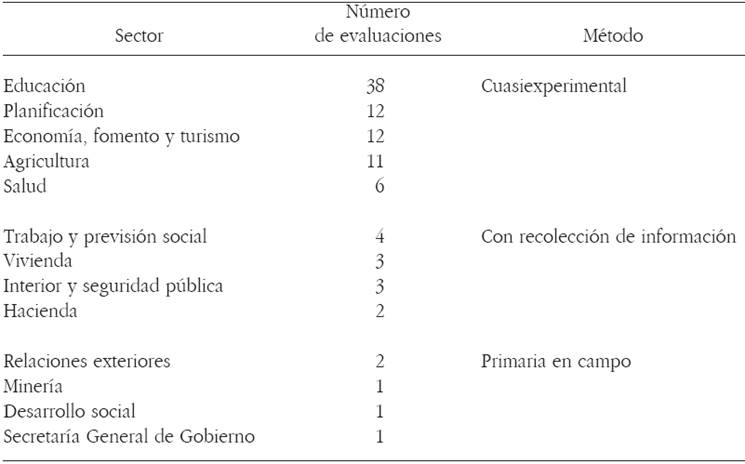

Por el contrario, la experiencia de la Aeval en evaluación de impacto es ciertamente limitada. Ninguna de las 40 evaluaciones realizadas hasta el momento se ha centrado en exclusiva en impactos, si bien en seis de ellas sí se contempló este criterio junto con otros aspectos o fases de las intervenciones públicas. A diferencia de Ivalua, la perspectiva metodológica que se adopta es abierta, en la medida en que se entiende que los métodos han de depender de la naturaleza del objeto evaluado y de los objetivos que persiga la evaluación, razón por la que en los seis trabajos mencionados han primado los métodos mixtos:

Fuente: Mapa de la Evaluación de Políticas y Programas Públicos en la AGE (2007-2011), 2012 [http://www.aeval.es/es], fecha de consulta: 12 de junio de 2016.

Cuadro 2 Evaluaciones realizadas por Aeval que incluyen impactos 2007-2015

En el caso de Navarra, encontramos una situación similar a la de Aeval. En el conjunto de las administraciones públicas de esta Comunidad Autónoma se han realizado, entre 2007 y 2015, un total de 40 evaluaciones de las cuales sólo dos incluyen el criterio de impacto, todo ello a tenor de los datos recogidos en el registro de evaluaciones. En una de esas dos evaluaciones -la única en la que se dispone del informe- se emplean métodos mixtos para conocer las percepciones sobre los impactos, pero se recuerda que con ello sólo se logra obtener una medida indirecta de los mismos.

A excepción de Ivalua, cuyo énfasis en la experimentación es notorio, las evaluaciones de impacto son aún escasas en los organismos de evaluación en España, no así las publicaciones sobre el tema, que son cada vez más frecuentes,10 en especial aquellas que apuestan por los métodos experimentales, y mucho más que en América Latina.

La oferta formativa es también limitada en España. Además de los módulos sobre evaluación de impacto que se incluyen en los másteres y/o cursos de experto de evaluación existentes (ofertados por la Universidad Complutense y la Universidad de Sevilla), se pueden mencionar el curso monográfico organizado por el Centro de Estudios de Cooperación al Desarrollo de la Universidad San Pablo-CEU (Cecod), la FIIAPP, el Banco Interamericano de Desarrollo (BID) y el Fondo Multilateral de Inversiones (Fomin), cuya segunda edición tuvo lugar en 2016, y el curso sobre métodos cuantitativos de evaluación de impacto del ICEX-CECO.

Colombia

El Sistema Nacional de Evaluación de Resultados de la Gestión Pública (Sinergia) fue creado en 1994 y encargado al Departamento Nacional de Planeación (DNP), que depende directamente de la Presidencia. Sus evaluaciones cubren los denominados eslabones de la cadena de valor, al final de la cual se ubican las relativas a impacto. No fue posible encontrar una definición específica de este tipo ni una exposición de los métodos disponibles.

En 2004, el DNP decidió iniciar con la evaluación de los programas que conforman la Red de Apoyo Social: Empleos en Acción, Familias en Acción y Jóvenes en Acción. De manera acumulada se informa que se habrían realizado 34 evaluaciones de impacto hasta 2012 (30% del total); sin embargo, muchas son sólo levantamiento de líneas de base, por lo que nuestra lista se reduce a 24 (más de dos en promedio anual) y sólo tres en los cuatro años siguientes. De todas éstas 15 fueron realizadas por una misma consultora, con especialización en técnicas microeconómicas y recolección y tratamiento de datos,11 mientras en las restantes nueve participaron organizaciones diferentes. Su desglose por sectores es el siguiente:

Fuente: reelaborado con datos de [http://sinergiapp.dnp.gov.co/#Evaluaciones/EvalFin] y [https://sinergiacp.dnp.gov.co/PortalDNP/default.aspx], fecha de consulta: 25 de mayo de 2016.

Cuadro 3 Evaluaciones de impacto colombianas 2004-2016

Como puede verse, salvo en cinco casos, las evaluaciones utilizaron metodología cuasiexperimental, sin participación de los beneficiarios ni de los funcionarios ejecutores. A diferencia de los otros países latinoamericanos revisados, en nuestra búsqueda identificamos algunos libros y artículos de investigadores o consultores que analizan la situación colombiana en la materia.12 La oferta académica colombiana no incluye posgrados en evaluación, menos aún especializados en impacto.

Chile

El Sistema de Control de Gestión se consolidó en 2006 con la creación del Sistema de Seguimiento de la Programación Gubernamental (SPG), coordinado por el Ministerio de Hacienda a través de la Dirección de Presupuestos (Dipres).

A partir de 2001 se aplican evaluaciones de impacto a los programas que ya han sido evaluados, en los que no se pudieron medir los resultados finales. Las mismas tienen por objeto cubrir ese faltante: los efectos netos de un programa en los beneficiarios. Utilizan enfoques cuasiexperimentales ampliamente expuestos en diversos documentos institucionales13 y deben ser aprobadas por la Dipres en materia metodológica y operativa. Requieren trabajo de campo y presupuestos elevados; su duración varía entre 12 y 18 meses y son realizadas por consultores externos, universidades o consultoras privadas, seleccionados en concursos públicos.

Entre 2001 y 2011 se informa la realización de 96 evaluaciones de impacto (cerca de nueve en promedio anual); sin embargo, en los años siguientes sólo se realizó una (2014). Aunque varían en tamaño y complejidad, la metodología utilizada es prácticamente la misma para todas (cuasiexperimental). En algunos casos se han presentado dificultades para aislar los impactos, debido principalmente a insuficiencias de información sobre líneas de base (datos previos al inicio del programa). En el Cuadro 4 se muestra su distribución:

Fuente: reelaborado con datos de [http://www.dipres.gob.cl/574/w3-propertyvalue-23076.html], fecha de consulta: 31 de mayo de 2016.

Cuadro 4 Evaluaciones de impacto chilenas 2001-2011

A diferencia del caso colombiano, en Chile las evaluaciones de impacto son más numerosas y muestran mayor diversificación por sectores. Su opción metodológica es claramente cuasiexperimental y su sistema de evaluación ha sido considerado robusto y muy avanzado por el Banco Mundial;14 sin embargo, este organismo recomendó que se complemente, con base en la theory-based evaluation, para poner especial atención en las relaciones causales. Sus publicaciones sobre el tema también son muy pocas,15 en cambio tiene diversas maestrías y diplomados, dos de ellos especializados en evaluación de impacto general y ambiental (Universidad de Chile y de Lagos, respectivamente).

México

El Sistema de Monitoreo y Evaluación de programas sociales federales en México16 prevé distintos tipos de evaluación (incluido impacto) que se precisan en los Lineamientos17 publicados en 2007 por su órgano rector, el Consejo Nacional de Evaluación de la Política Social (Coneval), conjuntamente con la Secretaría de Hacienda y Crédito Público (SHCP) y la Secretaría de la Función Pública (SFP).

Los Lineamientos establecen que la evaluación de impacto mide cambios en los indicadores de resultados atribuibles a la gestión del programa, con base en metodologías que serán revisadas por la Secretaría de Desarrollo Social (Sedesol), la SFP y el Coneval. Con objeto de especificarlas fue publicado un guión18 que inicia directamente con las técnicas cuantitativas, como si fueran únicas, y explica las características de las herramientas estadísticas disponibles para la aplicación del modelo experimental o cuasiexperimental, con diseño del contrafactual, que pueden incluir trabajo de campo o sólo utilizar información ya generada.

Con base en la información que cada programa interesado en realizarla presenta al Coneval, éste emite una opinión sobre su factibilidad. Existen programas que han intentado realizar evaluaciones de impacto pero no han podido cumplir los requisitos del diseño experimental o cuasiexperimental exigido (Programa de Conservación para el Desarrollo Sostenible, Sistema Nacional de Investigadores, etcétera).19 En estos casos el Coneval no las ha autorizado, ni ha reconocido las realizadas con métodos alternativos.

Según la página electrónica institucional, a la fecha se han realizado 18 evaluaciones de impacto de programas federales entre 2007 y 2012 (con un promedio anual de tres) y ninguna posterior. Se distribuyen por sectores como aparece en el Cuadro 5, donde Desarrollo Social atiende 46.2% de la población en pobreza.20

Fuente: elaboración con datos de Coneval, Evaluaciones de impacto [http://www.coneval.org.mx/Evaluacion/Paginas/InformeEvaluacion.aspx], fecha de consulta: 22 de abril de 2016.

Cuadro 5 Evaluaciones de impacto mexicanas 2007-2016

En respuesta a los Lineamientos, la metodología más utilizada ha sido la cuasiexperimental,21 en algunos pocos casos combinada con métodos cualitativos -uno de ellos el Programa de Desarrollo Humano Oportunidades (PDHO) 2009. Los únicos dos trabajos no experimentales se debieron a la falta de la información suficiente para proceder experimentalmente. Han participado diversas instituciones académicas entre las que destacan el Instituto Nacional de Salud Pública (35% de los casos).

Si bien México cuenta con más publicaciones sobre evaluación que los dos países previos, no se localizó ninguna especialmente referida a evaluación de impacto, sólo algún apartado en trabajos más amplios.22 Sus pocos programas formativos incluyen algún componente de impacto, con enfoques variados.

En síntesis, el estudio de los casos de Chile, Colombia y México muestra un fuerte énfasis en trabajos experimentales y cuasiexperimentales, que coincide con el identificado por la Cepal en 2005 para un conjunto mayor de países latinoamericanos. Esa homogeneidad metodológica se explica en buena parte por la influencia en ese sentido del Banco Mundial -a veces en colaboración con el Centro Latinoamericano de Administración para el Desarrollo (CLAD)- y de las experiencias de nueva gerencia pública de Gran Bretaña, Australia y Nueva Zelanda, a partir de sus asesorías e intercambio de profesionales. En un número importante de los casos latinoamericanos revisados por la Cepal, que han solicitado la asistencia técnica del mencionado Banco, éste aparece también como evaluador.23

Sorprende que el promedio anual de evaluaciones de impacto ha sufrido un fuerte retroceso a partir de 2012 en los tres países latinoamericanos revisados: Colombia pasa de un promedio superior a 2, a otro inferior a 1; Chile de un promedio de casi 9, a sólo 0.2, y México de 3 a 0. No se dispone de información que explique esta coincidencia pero, aunque los motivos pueden ser diversos, es probable que esté influyendo la poca factibilidad de los diseños experimentales predominantes.

En el caso español, este énfasis metodológico se presenta fundamentalmente en uno de organismos autonómicos de evaluación y en el discurso predominante en ciertos frentes a los que aludimos en páginas previas. Es probable que en ese énfasis hayan influido la crisis económica, las disciplinas de procedencia de quienes la reivindican, pero sin duda también el deseo de acortar distancias con quienes cuentan con una mayor tradición en evaluación de impacto.24

Sin embargo, la opción experimental preferida en los contextos revisados enfrenta fuertes dificultades metodológicas, económicas y éticas, razón por la que resulta muy relevante conocer otras alternativas útiles para los países analizados. Una rápida mirada a la producción mundial en el tema muestra una importante diversidad conceptual, teórica y metodológica, incluyendo estudios no experimentales poco conocidos o valorados en Iberoamérica, que puede complementar o sustituir a los trabajos experimentales, en función de las necesidades de cada caso. El resto del artículo se dedica a su exposición.

Concepto de impacto

Se ha señalado que la evaluación de impacto en los países de Iberoamérica analizados tiende a partir de una definición de este término, no siempre explicitada, que se presupone universalmente aceptada. Relaciona los impactos con el cambio producido en una población, comparado con lo que habría sucedido si no se hubiera intervenido en ella (lo que se conoce como contrafactual) e incorpora al concepto el método que considera idóneo para su cálculo numérico (experimental) en función de los efectos netos que genera un programa en ciertos indicadores predefinidos.

Sin embargo, el examen detenido de la bibliografía sobre evaluación de impacto muestra una mayor diversidad de definiciones, entre las que además existen diferencias importantes, ligadas al enfoque teórico y metodológico en que se encuadran. Dicho examen nos permite identificar los tres elementos principales que permiten su caracterización, aunque no todas les conceden la misma importancia: i) el marco temporal; ii) su diferencia respecto del término resultados; y iii) el ámbito en el que se producen los impactos.

Las definiciones que contemplan la variable “tiempo” suelen construirse en torno a la idea de que los diferentes elementos de una intervención pública están vinculados entre sí en una suerte de progresión lógica y temporal (recursos, actividades, productos, resultados e impactos), ya sea de forma lineal, ya de forma más compleja. La referencia más conocida en este caso es la proporcionada por el Development Assistance Committee (DAC) de la Organización para la Cooperación y el Desarrollo Económicos (OCDE), que define impacto como los “efectos de largo plazo positivos y negativos, primarios y secundarios, producidos directa o indirectamente por una intervención para el desarrollo, intencionalmente o no”. Los resultados, en cambio, son los efectos directos “de corto y medio plazo, logrados o probables, de los productos de una intervención”.25 En esta línea se sitúan también Rogers26 y Peersman27 al asumir la definición del DAC, puntualizando que los impactos se producen después y como consecuencia de los resultados.

Otras definiciones consideran, además de la idea de temporalidad y de su diferenciación respecto de resultados, el ámbito en el que se produce el impacto. Por ejemplo, para la Kellogg Foundation, el término resultado denota los cambios específicos en la población destinataria que se derivan de las actividades del programa y que se dan tanto en el mediano (entre 1 y 3 años) como en el largo plazo (entre 4 y 6 años); el de impacto se reserva para los cambios sociales futuros (a 7-10 años vista), previstos o imprevistos, que el programa genera.28 Cabe también incluir aquí las contribuciones de Montague29 y de Montague, Porteous y Sridharan,30 vinculadas con el enfoque de las esferas de influencia y al mapeo de resultados (outcome mapping). En éste, los impactos se conciben como los efectos que se dan en la última de las tres esferas de influencia de un programa, la de control.

En el trabajo de Leeuw y Vaessen, uno de los más interesantes del panorama actual, la denominación de impacto cubre todo el abanico de efectos de la cadena de resultados, tanto en la población destinataria como en los contextos institucionales y sociales más amplios -esto es, incorporan los tres elementos mencionados pero no asocian impacto a un ámbito concreto ni sólo al largo plazo. Esto debido a que, a veces, el impacto surge inmediatamente y también debe ser cubierto por la evaluación.31

Por su parte, la propuesta de Hearn y Bufardi32 añade nuevos elementos a los tres ya indicados: uso o aplicación que se dará al concepto (proyectiva, prospectiva o retrospectiva), alcance (si incluye o no los impactos específicos, pre-establecidos y conocibles y los indefinidos, inesperados e imprevistos), sujetos y niveles a los que afecta (población objetivo, diferentes contextos micro y macro), vinculación entre actividades e impactos (directa e inevitable; directa pero incierta; moderada; e indirecta e incierta), temporalidad (inmediatos, estacionales y de corto, medio y largo plazo) y grado de permanencia (irreversibles, reversibles, duraderos pero reversibles).

Como se observa, existe una complejidad conceptual mayor que la rescatada en los países analizados, situación que se repetirá en torno a los enfoques y métodos que se revisan a continuación.

Enfoques de la evaluación de impacto

En los países incluidos en el estudio prima el empirismo que promueve la evaluación basada en evidencias (evidence-based evaluation) y pone énfasis en el rigor científico de la medición cuantitativa y experimental. Nuevamente, no es el único enfoque posible, algunos de los enfoques alternativos más desarrollados se presentan a continuación.

a) Aunque con frecuencia se oye hablar del enfoque de la “teoría del programa” (theory-based y theory-driven evaluations), en puridad esta denominación cubre distintas aproximaciones,33 entre las que destacan las pioneras de Chen,34 Chen y Rossi35 y la teoría del cambio de Weiss, la evaluación realista de Pawson y Tilley36 y, más recientemente, los trabajos de White37 y Rogers.38

Todas estas aproximaciones buscan identificar y/o reconstruir la lógica, la cadena de resultados o las hipótesis que subyacen a la intervención, comprobar su solidez y abrir la caja negra que relaciona el programa y sus efectos, sin olvidar el papel que desempeña el contexto de la intervención. Se trata de una perspectiva totalmente abierta, que no exige ni excluye opciones metodológicas (Leeuw y Vaessen)39 y que ofrece alternativas consistentes a los métodos experimentales y cuasi-experimentales.

Destacados autores -como White40 o Leeuw y Vaessen-41 y gobiernos, organismos y redes de investigación han incorporado este enfoque a su acervo teórico y/o a su práctica evaluativa con un reconocimiento equivalente al que se ha dado a enfoques y métodos más difundidos. Es el caso del Centre of Excellence for Evaluation del gobierno canadiense, la Comisión Europea en su Guía EVALSED de 2013, la International Initiative for Impact Evaluation (3ie) o la Oficina de Investigación de UNICEF.

b) Relacionadas con la anterior, algunas otras propuestas descansan, en mayor o menor medida, en la búsqueda y el examen sistemático de la racionalidad del programa, si bien no se limitan a éstos. Entre las más conocidas se encuentran el enfoque de la complejidad, el análisis de contribución y los enfoques participativos -que se revisarán a continuación-, si bien cabe citar también el General Elimination Methodology (GEM) de Scriven (que se apoya en el principio de falsación de Popper)42 y el método de la averiguación (elicitation method).

El enfoque de la complejidad (complex evaluations)43 -que tiene en el GEM su primer antecedente- concibe a los determinantes del impacto percibido como un sistema de causas interrelacionadas, capaz de provocar efectos no lineales (por ejemplo, sinérgicos). Dada esta complejidad, en la polémica atribución-contribución se inclina por la última -que se revisa en el siguiente apartado por estar muy ligada a la discusión metodológica. Los trabajos de Mayne44 sobre análisis de contribución en contextos complejos están también entre las aportaciones más relevantes.

Los enfoques participativos constituyen otra de las alternativas más sugerentes y prometedoras en el campo de la evaluación de impacto. En sentido estricto, responden más a un principio inspirador para la realización de evaluaciones que a enfoques propiamente dichos. Su objetivo es implicar a los distintos stakeholders en el proceso evaluativo para que éstos contribuyan a enriquecer el trabajo con la pluralidad de sus puntos de vista -algo que el experimentalismo descarta e incluso rechaza.45 La participación puede buscarse por motivos éticos, prácticos o, incluso, por ambos.

No se plantea a priori ninguna exigencia respecto de cómo entender la participación, quiénes serán los que participen o de qué modo lo harán. Estas cuestiones quedan abiertas y se deciden en cada caso particular. Los enfoques participativos no se vinculan tampoco con métodos o diseños concretos, ya sean cuantitativos o cualitativos, ni con una fase determinada de la evaluación, pero resultan mucho más viables y habituales en trabajos no experimentales, de menor complejidad técnica. Se han de mencionar aquí los estudios de Guijt,46 Chambers47 o Rogers,48 en los que encontramos reflexiones teóricas, orientaciones prácticas para incluir y gestionar la participación en las evaluaciones, así como descripciones de casos en que esta perspectiva ha sido empleada con éxito.

Posturas epistemológicas y métodos para la evaluación de impacto

El debate sobre los métodos de evaluación de impacto es un reflejo de toda la discusión epistemológica generada en torno a las posibilidades y formas de acceder al conocimiento. En los últimos años ha girado en torno a dos polémicas centrales: atribución frente a contribución y experimentación frente a no experimentación.49

En líneas generales, los defensores de la idea de “atribución” se han posicionado del lado del experimentalismo, que hemos visto predominar en los cuatro países estudiados, en tanto que los partidarios de la “contribución” se han opuesto al mismo; al tiempo, encontramos enfoques intermedios y también posiciones de quienes no participan de este debate:

a) Para los primeros, el objetivo de la evaluación de impacto es averiguar si existen relaciones de causalidad entre el programa y los impactos observados50 y si éstos son atribuibles exclusivamente a la intervención y no a otros factores causales (efectos netos). El impacto es entendido como el cambio producido en una población, comparado con lo que habría sucedido si no se hubiera intervenido en ella (lo que se conoce como contrafactual). Se presupone asimismo que es posible medir sus efectos netos, para lo que es necesario recurrir a los diseños experimentales.

Es esta perspectiva sobre la evaluación de impacto -que podríamos denominar técnica, siguiendo a Bamberger-51 la que ha recibido mayor promoción en los últimos años, de la mano de organismos internacionales, fundaciones, think tanks y prestigiosos centros de investigación que la han presentado, no como una alternativa metodológica sino como la única opción válida para obtener conclusiones con validez científica.52 Un claro referente es el Abdul Latif Jameel Poverty Action Lab (J-PAL), una red internacional formada por cerca de 140 investigadores en evaluación aleatoria de impacto y cuyo centro operativo está asociado con el Massachusetts Institute of Techonology (MIT).53 Destacan también los trabajos realizados desde el Independent Evaluation Group (IEG) del Banco Mundial,54 la Government Accounting Office (GAO)55 -la agencia federal encargada de la evaluación y la auditoría fiscal y financiera en Estados Unidos-, la What Works Network (asociada con el gobierno británico), las contribuciones de Ravallion,56 Baker,57 Khandker, Koowal y Samad,58 Gertler et al.59 y las de la 3ie60 -que si bien en sus inicios no apostaba por una opción metodológica concreta, más tarde se decantó por los diseños experimentales o cuasi-experimentales, de los que nos ocuparemos en breve.

b) Por su parte, quienes ponen el acento en la idea de contribución estiman que resulta imposible (por razones ontológicas y epistemológicas) y/o injustificadamente caro, distinguir los efectos netos que se derivan de un programa de los provocados por otras causas que inciden sobre el mismo asunto y población. El trabajo del evaluador consiste entonces en examinar el cambio producido por diversas causas (impacto de ese conjunto) y aproximarse a valorar y explicar la contribución de una de ellas (la intervención evaluada) al impacto del conjunto. Ante la imposibilidad de tener una certeza absoluta sobre la atribución de los impactos al programa, este tipo de análisis pretende disminuir al menos la incertidumbre. Para ello puede apoyarse en diferentes aportes teóricos, como la evaluación basada en la teoría o el enfoque de la complejidad.

La propuesta contributiva fue desarrollada durante la década de 1990 en el seno de la Oficina del Canadian Auditor General. Actualmente se encuadran en esta posición los trabajos de Mayne,61 su más destacado exponente, Kotvojs,62 Kotvojs y Shrimpton,63 Dybdal, Nielsen y Lemire64 o el manual sobre el tema publicado por el gobierno escocés.65

c) Un tercer conjunto de aproximaciones parte de una idea menos restrictiva de atribución pero sin limitarse a una metodología experimental, como en el primer grupo; acepta que los impactos puedan tener otras causas además del programa y, por tanto, asume también el concepto de contribución. Insisten en la utilidad de los enfoques basados en la teoría, los estudios de caso o los métodos participativos para detectar y comprender los vínculos entre causas (programa) e impactos. Los trabajos de Rogers,66 Stern et al.67 o White68 serían los ejemplos más representativos. El último de los citados presenta una de las propuestas más equilibradas: considera que siempre que sea posible se debe recurrir al método experimental para atribuir los impactos a un programa; sin embargo, aboga por el uso de los enfoques basados en la teoría cuando se trata de explicar por qué una intervención genera un impacto.

d) Finalmente corresponde referir los trabajos que se desmarcan de la polémica atribución frente a contribución, algunos de los cuales ofrecen novedosas e interesantes aportaciones al tema. Cabría incluir aquí al United Nations Evaluation Group (UNEG), la red que agrupa a las unidades de evaluación de distintos departamentos, agencias, fondos, programas y organizaciones asociadas de la ONU. El propósito central de la evaluación de impacto para el UNEG es identificar las relaciones de causalidad que genera una intervención y mostrar, en su caso, cómo se han producido.69

En forma paralela al debate presentado, se desarrolla el de los métodos experimentales y no experimentales retomados por la evaluación de impacto:

a) Como se ha mencionado, los autores que optan por el enfoque atributivo suelen considerar que los diseños experimentales son los únicos que aportan la evidencia científica que se requiere para el mejor diseño de las políticas (evidence-based policy). Se trata de medir la evolución del grupo experimental (atribuible al programa y otras causas) y la del grupo de control (sólo atribuible a otras causas) para calcular el impacto neto del programa como la diferencia de ambas mediciones. Los sujetos de uno y otro grupo han de ser asignados de forma aleatoria y ambos han de ser estadísticamente equivalentes en las variables que pueden interferir si se pretende afirmar con certeza que los impactos son atribuibles sólo a la intervención. Cuando la selección aleatoria no es posible puede sustituirse por métodos menos rigurosos como la integración por pares similares, pareo o emparejamiento (matching methods), y asumen la denominación de cuasiexperimentales.70

Su ventaja comparativa es la medición rigurosa del impacto alcanzado y atribuido exclusivamente a la intervención evaluada, en aquellos casos en que este diseño es factible.71 El problema es que son pocas las situaciones (pruebas piloto o programas con lista de espera que permiten diseñar controles adecuados) en que es posible contar con un grupo de control equivalente, que éste y el grupo experimental se mantengan completos y sin contaminarse durante el tiempo que el experimento requiera y que se disponga de las cuatro mediciones necesarias para calcular el impacto.72

Además son diseños muy costosos, que predefinen los indicadores a medir con alto riesgo de no incluir los efectos inesperados, que no recuperan variables cualitativas ni explican cómo operan los nexos causales que conectan el programa y los niveles de impactos medidos (caja negra), y que enfrentan problemas éticos importantes como la exclusión de los beneficios del programa en el grupo testigo.73

Por otra parte, los experimentos que se llevan a cabo en la realidad social no cumplen, en sentido estricto, con los criterios de los que se consideran verdaderos experimentos en ciencias naturales, a las que se ha tratado de emular. El contrafactual no remite a una realidad idéntica (comparable) a la que se da con la intervención,74 desde el momento en que los mismos individuos no pueden recibir y no recibir el programa simultáneamente. Además, los destinatarios de los programas (en tanto que seres humanos con valores, creencias e intereses) introducen factores de variabilidad y particularidad que difícilmente los experimentos pueden controlar, por más que los dos grupos sean equivalentes (desde el punto de vista estadístico) en ciertas variables mensurables. Por otra parte, resulta casi imposible que, en la práctica, funcione el principio de doble ciego que ha de caracterizar a los experimentos o que no se produzca el llamado efecto Hawthorne.

b) El resto de los autores se inclina por otras alternativas metodológicas (no experimentales), que permiten identificar y explicar sólidamente las relaciones de causalidad apoyándose en la teoría del programa (theory-based y theory-driven evaluations), en enfoques participativos y en estudios de caso, que combinan técnicas cuantitativas y cualitativas como series de datos longitudinales disponibles con la recolección de datos complementarios por medio de encuestas de percepción, grupos focales o entrevistas. Es importante que se identifique el cambio con claridad, ya sea en forma contributiva o se analicen en profundidad otros factores diferentes al programa en estudio que hayan podido incidir en los resultados observados, si se busca la atribución a éste.

Las ventajas y desventajas de estas alternativas son las opuestas del anterior: la medición no es tan precisa porque su aporte no se cuantifica y parte de su información proviene de percepciones subjetivas, de ahí la importancia de su triangulación; pero son más factibles, incorporan información cualitativa con base en las percepciones de distintos actores (no sólo en las de los decisores que son las que se plasman en los objetivos de la intervención), permiten avanzar en la explicación necesaria para tomar decisiones (causas del impacto identificado), y evitan los problemas éticos. Utilizadas en sustitución de los diseños experimentales, permiten evaluar impactos cuando los requisitos de éstos no pueden cumplirse o se consideran una simplificación exagerada; empleadas como complemento de ellos, agregan información cualitativa que ayuda a identificar las causas de los impactos y permiten hacer las correcciones pertinentes.

Como apuntamos en otro lugar, “A pesar de los esfuerzos de la última década por reconciliar estas posturas, la controversia todavía muestra la presencia de comunidades científicas empeñadas en una especie de dogmatismo metodológico”;75 sin embargo, sobresalen algunas iniciativas que toman lo mejor de cada corriente y lo integran en un enfoque mixto.76

Experiencias alternativas de evaluación de impacto

La evaluación de impacto experimental y cuasiexperimental ha sido la más difundida tanto por organismos internacionales (Banco Mundial) como a nivel de los gobiernos nacionales (los casos nacionales presentados sirven de ejemplos, entre muchos más). Son también las más accesibles a través de las páginas web institucionales.

En cambio, las evaluaciones encargadas por organizaciones dispersas y especialmente las realizadas con enfoques alternativos, se vuelven mucho más difíciles de localizar y muchas veces sólo las conocemos cuando son relatadas en artículos de revistas especializadas. A pesar de esta dificultad, se han reunido algunas experiencias que ejemplifican su utilización en diferentes instancias, sectores y países.

Son muchos los ejemplos de casos exitosos reportados que se han basado en la teoría del programa. Merece la pena destacar la evaluación del Spring Sun Program, que pretendía abordar el problema del consumo de drogas entre los estudiantes de secundaria (middle schools) de Taiwan, y fue realizada por Chen;77 la que tuvo como objeto el Bangladesh Integrated Nutrition Project (BINP), un programa piloto cuyo propósito era ofrecer orientación y alimentación suplementaria a mujeres embarazadas y a niños con problemas de crecimiento y/o malnutrición;78 y la evaluación del programa conjunto de UNFPA-UNICEF sobre mutilación genital femenina.79

A su vez, entre los casos ilustrativos que recogen las perspectivas de la contribución y la complejidad se encuentran la evaluación de la estrategia libre de humo en Ontario (Canadá), la vinculada al impacto en la pobreza de la construcción de infraestructura carretera en Tanzania, contratada por la Comisión Europea (CE) a Euréval (2007) y la relativa al crecimiento y el empleo, realizada por Euréval y Ramboll Management (2008). La primera combinó Intervention Path Contribution Analysis (IPCA) con la recolección sistemática de información de campo y la revisión de la literatura. La segunda retomó la compleja cadena de causas-efectos, reconociendo como antecedentes otros dos trabajos realizados en Ruanda (2006) y Jordania (2007), relacionados con la evaluación de los apoyos de la Comunidad Europea en el desarrollo y la pobreza rural, la reconstrucción de instituciones judiciales y el acceso de las empresas medianas y pequeñas al mercado de la Unión Europea. Una tercera, con un análisis muy similar al del enfoque contributivo, fue realizada por Lawson et al. también en Tanzania (2005).80 Más recientemente se localizaron dos artículos: uno que relata el análisis contributivo realizado en el sector de salud pública australiano siguiendo el procedimiento enunciado por Mayne, y otro que lo vincula con la teoría del programa y la complejidad.81

Conclusiones y sugerencias

La evaluación de impacto realizada desde las instituciones en los casos nacionales revisados ha sido prácticamente identificada con el uso de estos modelos cuantitativos que, ante la imposibilidad de emplear el enfoque experimental, han recurrido al second best constituido por la aproximación cuasiexperimental y, excepcionalmente, la han complementado con métodos cualitativos para profundizar en la explicación de aquello que había sido simplemente medido. En el caso de España, la apuesta por la experimentación se advierte de forma clara no sólo en la práctica evaluativa regional sino también en el discurso de algunas instituciones y en foros diversos, incluidos los científicos y profesionales. En los tres casos latinoamericanos resalta también la poca presencia de programas de formación y bibliografía que difunda enfoques alternativos o complementarios, finalidad a la que el presente artículo ha intentado contribuir.

Si bien esta opción más difundida se limita a intentar medir el impacto en una relación de atribución “causa-efecto”, mediante métodos cuantitativos y diseños experimentales y cuasiexperimentales, se ha mostrado que no existe un único concepto de impacto, un solo enfoque teórico ni un método indiscutiblemente mejor en toda ocasión, sino una amplia variedad de éstos. La revisión de las principales alternativas teórico-metodológicas y de casos en que éstas se han aplicado con éxito, aunque breve por las razones ya comentadas, ha evidenciado que existen enfoques y métodos alternativos sólidos y de gran potencialidad para el contexto analizado, que son mucho menos conocidos y casi no se utilizan, pero podrían aportar a la realización de un número mayor de este tipo de evaluaciones, imprescindibles para conocer si se han logrado mejoras en la calidad de vida de los beneficiarios, incluyendo su propia percepción al respecto.

No se aboga, en modo alguno, por sustituir una hegemonía por otra: tan conveniente es superar la actual equiparación de los métodos cuantitativos y/o experimentales con la evidencia científica “verdadera” como erróneo sería querer otorgarle a lo “no cuantitativo” esa misma posición de superioridad; defendemos, en cambio, la clarificación de los conceptos, el debate sobre los distintos métodos y enfoques para reconocer y admitir sus debilidades y fortalezas, el intercambio de experiencias y la difusión de alternativas que pueden ser provechosas -y que apenas se mencionan, al menos en el contexto latinoamericano.

Se trata, en definitiva, de introducir la diversidad presentada en este artículo en los cursos de evaluación impartidos en nuestras universidades latinoamericanas y españolas y de generar una discusión abierta e informada que permita valorar en cada caso el enfoque y método más apropiado.

nova página do texto(beta)

nova página do texto(beta)