Servicios Personalizados

Revista

Articulo

Indicadores

-

Citado por SciELO

Citado por SciELO -

Accesos

Accesos

Links relacionados

-

Similares en

SciELO

Similares en

SciELO

Compartir

Política y cultura

versión impresa ISSN 0188-7742

Polít. cult. no.40 México ene. 2013

De la gestión a la metaevaluación

De la evaluación a la reformulación de políticas públicas

Myriam Cardozo Brum*

* Profesora-investigadora, Departamento de Política y Cultura, UAM-Xochimilco, México [mcardozo@correo.xoc.uam.mx].

Artículo recibido el 21-09-12

Artículo aceptado el 25-09-13

Resumen

Mucho se ha escrito sobre las etapas que conforman el proceso de las políticas públicas y la relevancia de la evaluación en el neoliberalismo, pero ¿cómo se produce la retroalimentación entre la evaluación del final de un ciclo y la reformulación del siguiente? El presente artículo tiene por objetivo analizar este proceso, para lo cual se utiliza un análisis comparativo basado fundamentalmente en información documental. Para el caso del desarrollo social nacional se confirma la situación registrada en otros países, consistente en una limitada utilización de los resultados de las evaluaciones, y se analizan algunas explicaciones posibles.

Palabras clave: evaluación, reformulación, políticas públicas, desarrollo social, México.

Abstract

There is a considerable amount of literature regarding the phases of development of public policies and the relevance of evaluation in Neoliberalism. But there is not very much concerning how the feedback between the evaluation of the end of a cycle and the formulation of the next one is produced. The objective of this paper is to analyse this process. The study is based mainly a on comparative analysis of published information. We confirm that national social development is following the trend presented in other countries, where the results of evaluations are only utilized to a limited extent. We analyse possible explanations for this situation.

Key words: evaluation, formulation, public policies, social development, Mexico.

INTRODUCCIÓN

El ciclo teórico de las políticas y programas públicos identifica el desarrollo de tres etapas fundamentales —formulación, implementación y evaluación— después de las cuales se reinicia un nuevo proceso, donde la formulación es retroalimentada con los resultados de la evaluación (reformulación).

Mucho se ha escrito sobre estas etapas, particularmente en años recientes, sobre los importantes esfuerzos nacionales y subnacionales realizados en América Latina, y México en particular, para la institucionalización de la evaluación impulsada por la Nueva Gerencia Pública (NGP) en el contexto del neoliberalismo, aunque aún no se puede considerar plenamente cumplida la tarea, en especial si lo que se quiere es evaluar las políticas, no sólo los programas públicos.1

Pero no basta con disponer de buenas evaluaciones, se necesita que éstas sean tomadas en cuenta por las instancias evaluadas y por los órganos responsables de realizar la asignación de presupuestos, cuestión que diversas metaevaluaciones realizadas en contextos nacionales distintos del nuestro han mostrado que presenta fuertes limitaciones.2

En México no se han realizado trabajos de investigación sobre el tema, por lo que para conocer la situación y mejorar la incidencia de las evaluaciones en el campo del desarrollo social, el presente artículo se propone encontrar respuestas a las siguientes preguntas: ¿cómo se produce la retroalimentación entre el final de un ciclo y el inicio del siguiente?, o sea, ¿qué aporta la evaluación a la reformulación?; en particular, ¿cómo asegurarse de la factibilidad y calidad de las recomendaciones emitidas por los evaluadores?, ¿cómo incidir en una asignación de recursos que tome en cuenta los resultados obtenidos?, ¿qué procedimientos aplicar para que las recomendaciones pertinentes sean consideradas en la reformulación de políticas?, ¿cómo medir el impacto logrado con esta última?

MARCO DE REFERENCIA

Principales conceptos

Las políticas públicas constituyen respuestas diseñadas y aplicadas, a través de procesos políticos y técnicos, para resolver problemas que, por su relevancia para importantes sectores de la sociedad, no son factibles de enfrentarse eficazmente desde el ámbito privado. Ellas surgen como resultado de:

[... ] un proceso de sucesivas tomas de posición, que se concretan en un conjunto de decisiones, acciones u omisiones, asumidas fundamentalmente por los gobiernos, que traducen, en un lugar y periodo determinado, la respuesta preponderante del mismo frente a los problemas públicos vividos por la sociedad civil.3

En especial, las políticas sociales son un tipo particular de políticas públicas dirigidas a mejorar el bienestar social mediante estrategias de redistribución de la riqueza y del ingreso.4

El proceso de las políticas públicas puede desagregarse para fines analíticos en etapas; actualmente existe bastante consenso en incluir al menos las siguientes:

• La formulación (análisis ex-ante, tomando como referencia la acción), que se basa en un diagnóstico y definición del problema, para generar y analizar sus alternativas de solución; con la finalidad de seleccionar la que se considere más apropiada.

• La implementación, que debería corresponder a la puesta en práctica y control de la formulación anterior (en forma concomitante) mediante la toma de decisiones operativas y acciones concretas destinadas a incidir en el problema público original, pero que, en la práctica, puede distanciarse de la etapa anterior.

• La evaluación (análisis ex-post) consistente en una investigación interdisciplinaria aplicada, realizada mediante la aplicación de un método sistemático, cuyo objetivo es conocer el proceso desarrollado, explicar sus determinantes y condicionantes y calificar su grado de efectividad, así como aportar elementos al proceso de toma de decisiones (reformulación), que permitan mejorar los efectos de la actividad evaluada y contribuyan a la rendición de cuentas y a la generación de ciudadanía.5

Los estudiosos de las políticas públicas han atribuido una importancia variable a la evaluación en el tiempo y ha habido casos nacionales que presentan avances desde hace ya un siglo, como Estados Unidos con su experimentalismo pre-tayloriano en el campo educativo o Reino Unido en materia de servicios públicos. Su importancia se revitaliza durante la vigencia del Estado de bienestar europeo y la Sociedad de las Reformas en Estados Unidos, posteriores a la Segunda Guerra Mundial. En décadas recientes, y especialmente en América Latina, adquiere un auge sin precedentes por el impulso que le atribuye el enfoque neoliberal y las reformas promovidas por la NGP, que han sido impulsados por la Organización para la Cooperación y el Desarrollo Económicos, el Fondo Monetario Internacional y el Banco Mundial,6 y tuvieron sus casos emblemáticos en Nueva Zelanda, Reino Unido y Australia. Este enfoque introduce cambios en la gestión presupuestal dirigidos al control del gasto y al logro de resultados con eficacia, economía, eficiencia y calidad; promueve la descentralización y la delegación de facultades para conducir la gestión pública, pero la sujeta a la evaluación de sus resultados. Adicionalmente, otras organizaciones menos permeables a la NGP como la Unión Europea también han impulsado la evaluación de programas.7

La metaevaluación, por su parte, analiza particularmente los informes finales de las evaluaciones ya realizadas para valorar la calidad y el mérito del trabajo de los evaluadores profesionales, con la intención de contribuir al perfeccionamiento del mismo. Pero también puede tomar en cuenta todos los factores que la afectan, recuperando el contexto inmediato en que la evaluación se desarrolla.8 En particular, permite analizar la utilización de los resultados de las evaluaciones para el rediseño de políticas y programas, objetivo de nuestro trabajo.

Para lograr dicho objetivo se combinaron diversos métodos: fundamentalmente el análisis documental (informes de evaluación y de seguimiento de recomendaciones y gasto ejercido), que se complementó con algunos resultados de las entrevistas aplicadas en 2004 a informantes-clave (funcionarios, diputados, evaluadores y operadores de programas)9 y con un intercambio reciente (2013) de información y comentarios con los funcionarios de más alto nivel de los Consejos que se encuentran funcionando,10 así como observación participante en calidad de evaluadora y de integrante de uno de los Consejos.

De esta manera se describen y comparan los procesos seguidos por ambos Consejos para valorar sus gestiones, exclusivamente en el tema que nos ocupa y en función del criterio de efectividad, lo que permitió finalmente identificar un problema compartido. Dicha comparación implica revisar dos instancias de evaluación, que corresponden a distintos niveles de gobierno, con ideologías partidistas y enfoques de evaluación también diferentes. Con el fin de identificar y analizar las similitudes y diferencias entre ellos fue necesario definir un conjunto de categorías a comparar: sus procesos de institucionalización, de valoración de los resultados de los informes de evaluación y de preparación de recomendaciones a los órganos evaluados, así como el impacto de los anteriores en materia de asignación de recursos y utilización en la reformulación de políticas y programas.

INSTITUCIONALIZACIÓN DE LA EVALUACIÓN

Desde la década de 1980 el mundo ha visto crecer rápidamente los procesos de implantación de mecanismos de evaluación, especialmente de programas gubernamentales, y la creación de órganos y sistemas especializados en realizarla (Estados Unidos, Canadá, Reino Unido, Francia, Colombia, Costa Rica, etcétera).11

En lo que va del nuevo siglo, la institucionalización formal de la evaluación ha avanzado en México a nivel federal, respondiendo a las exigencias de eficiencia y focalización de los programas sociales propias del neoliberalismo y la NGP que empezaron a aplicarse durante las presidencias de De la Madrid y Salinas, sin que aún se haya podido generar plenamente una verdadera cultura que la internalice a nivel sustantivo.12

Diferentes actores entrevistados en 200613 reconocieron como las principales causas del limitado avance de la evaluación en México, las condiciones culturales, sociales y políticas imperantes; en cambio, le otorgaron un peso mucho menor a los problemas metodológicos, algunos de los cuales continúan existiendo.

Para 2008, a pesar de los esfuerzos realizados por el recién creado organismo público descentralizado, denominado Consejo Nacional de la Evaluación de la Política de Desarrollo Social (Coneval), previsto en los artículos 72 y 81 de la Ley General de Desarrollo Social aprobada en 2003,14 los avances continuaban siendo limitados: "persiste la realización de evaluaciones más como requisito administrativo para la obtención de presupuesto (riesgo de simulación) que como una actividad de aprendizaje y mejoramiento de la gestión".15

Por su parte, el Gobierno del Distrito Federal (GDF), que había tratado de aplicar una política tendiente a la universalización de los derechos sociales, había funcionado de manera inercial, sin organizar un sistema de evaluación que sustentara sus decisiones, hasta que en 2007, el jefe de gobierno creó por decreto el Consejo de Evaluación del Desarrollo Social (Evalúa DF), también como un organismo público descentralizado, con autonomía técnica, de gestión y presupuestaria, a fin de transparentar los procesos y de facilitar el cumplimiento de sus atribuciones en materia de evaluación.

El artículo 42 de la Ley de Desarrollo Social del Distrito Federal establece que la evaluación externa de la política y los programas sociales es la que realiza de manera exclusiva e independiente Evalúa DF, ya sea por cuenta propia o a través de terceros. También que, como consecuencia de ella, este Consejo puede emitir observaciones (no vinculatorias) y recomendaciones (vinculatorias) dirigidas a reorientar y reforzar la política social. Si los órganos evaluados no aceptan las recomendaciones se promueve una controversia ante la Comisión Interinstitucional de Desarrollo Social, quien resuelve en forma definitiva. En caso de aceptación acompañada de su posterior incumplimiento, Evalúa DF debe informar a la Contraloría General, la que podrá aplicar las sanciones previstas por la Ley Federal de Responsabilidades Administrativas de los Servidores Públicos.16

El Coneval tiene la obligación legal de evaluar anualmente la cobertura, calidad e impacto17 de todos los programas de desarrollo social sujetos a Reglas de Operación (RO) que su inventario cuantifica actualmente en 273,18 lo que lo ha llevado a tener que aplicar, salvo excepciones, evaluaciones muy simplificadas y estandarizadas, como por ejemplo, las denominadas evaluaciones específicas de desempeño. El artículo 80 establece que el Coneval puede emitir sugerencias y recomendaciones al Ejecutivo Federal como resultado de las evaluaciones aplicadas; pero no prevé que tengan carácter vinculatorio ni se susciten controversias.19

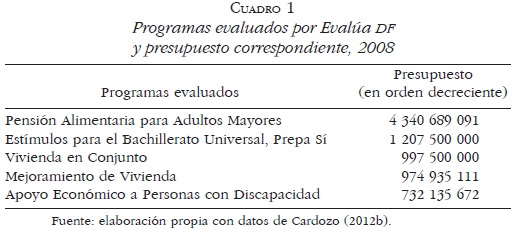

En cambio, Evalúa DF tiene la libertad de decidir las políticas, los programas o los servicios que evaluará, por lo que los ha seleccionado con base en criterios, entre los que se incluye: el monto de los recursos presupuestales erogados, la cobertura del programa, su relevancia para la solución de problemas sociales, su grado de maduración, entre otros. En 2008, por ejemplo, cinco de los programas evaluados coincidieron con los que insumían mayor presupuesto (Cuadro 1). En conjunto, en el primer periodo de funcionamiento (2008-2012), Evalúa DF efectuó trece evaluaciones de diseño y operación de programas sociales, siete evaluaciones de diseño y operación de políticas sociales, una evaluación de procesos, resultados e impacto de servicios públicos, así como dos metaevaluaciones.

Ambos Consejos cumplen sus funciones de evaluación mediante la contratación externa de equipos de evaluadores en casi todos los casos, para lo que elaboran y publican convocatorias y términos de referencia, adjudican contratos, revisan informes y emiten dictámenes. Sin embargo, la forma en que organizan sus trabajos y los enfoques teórico-metodológicos que asumen presentan diferencias sustantivas (positivismo/constructivismo), propias del contexto neoliberal federal en que se desarrollan sus políticas condicionadas y focalizadas y de la postura alternativa de defensa de los derechos sociales universales en el caso del Distrito Federal.20

FACTIBILIDAD Y CALIDAD DE LAS RECOMENDACIONES

La revisión final de los informes que realizan ambos Consejos tiene por objetivo valorar la calidad del trabajo realizado por los evaluadores (metaevaluación) en relación con los cuatro elementos fundamentales que lo componen: datos, interpretaciones, valoraciones y recomendaciones.21 Incluye, en consecuencia, las fuentes de información empleadas, los métodos de análisis, la consistencia de las argumentaciones, la fundamentación de las conclusiones, su valoración global y, muy especialmente, las recomendaciones derivadas del proceso.

Una vez concluido el proceso de aprobación de los informes de evaluación finales, el Coneval los envía a los órganos evaluados (al igual que al Congreso de la Unión y a la Secretaría de Desarrollo Social); recibe la respuesta institucional, prepara los Aspectos Susceptibles de Mejora (ASM) y firma el convenio para su instrumentación. En el caso de las Evaluaciones Específicas de Desempeño, también realiza reuniones de trabajo entre los programas evaluados y los evaluadores con objeto de analizar la pertinencia de las recomendaciones emitidas, mientras que en las de impacto promueve la realización de mesas de trabajo con expertos, evaluados y coordinadores de sector, para discutir la metodología y los resultados.

Para Evalúa DF el carácter vinculatorio de sus recomendaciones lo obliga a realizar un largo proceso que incluye el análisis de la factibilidad de las recomendaciones con base en otros estudios y documentos académicamente reconocidos sobre el tema, de las respuestas de los órganos evaluados al informe final, de las reflexiones generales sobre los programas sociales del Distrito Federal relativas a la maduración de los mismos, su legitimación social, su contribución a la construcción del régimen social de derechos, entre otros, así como del debate en reuniones públicas de los principales asuntos incluidos en la evaluación; después de lo cual el propio Evalúa DF emite sus recomendaciones "vinculatorias".

Complementariamente, para cumplir con el análisis de estos criterios de factibilidad y calidad, los Consejos pueden realizar ejercicios completos de metaevaluación, internos o contratados para su desarrollo independiente. Sin embargo, por tratarse de un tipo complejo de evaluación, sus resultados no son inmediatos y sirven sobre todo para realizar ajustes a los procesos a aplicar en posteriores trabajos, más que para considerarlos al momento de enviar recomendaciones a un órgano, política o programa concreto evaluado.

Hasta el año pasado, el Coneval tenía en su página algunos trabajos que se aproximan a este fin, aunque sin particularizar su análisis en cada evaluación realizada, donde se analizaban los Lineamientos generales para la evaluación22 o se identificaban fortalezas del sistema, desafíos y lecciones aprendidas.23 Un antecedente de éstas lo constituye un trabajo del Instituto Nacional de Salud Pública en que se revisan, aunque en forma poco crítica, las evaluaciones realizadas a los programas Progresa-Desarrollo Humano Oportunidades (en adelante, simplemente Oportunidades) de 1997 a 2006.24 Pero a partir de 2012 ha incorporado metaevaluaciones longitudinales de diferentes programas.25

En el caso de Evalúa DF se llevó a cabo una metaevaluación transversal y un autoanálisis crítico de la organización y gestión de las evaluaciones de programas de su primer año de trabajo, la calidad de sus informes y de las recomendaciones emitidas, la utilización de los resultados y las propuestas de mejoras para evaluaciones posteriores.26 El ejercicio se repitió al año siguiente mediante una contratación externa que sirvió para valorar el trabajo realizado en el caso de las primeras cuatro evaluaciones de políticas, concentrándose también en el contexto, el diseño de la evaluación, su marco legal, la organización y funcionamiento del sistema, y la calidad técnica, la utilidad y la ética de los informes.27

Con base en la información antes presentada se concluye que, aunque sus procesos presentan diferencias, ambos Consejos se ocupan en revisar que las recomendaciones cumplan los criterios aquí considerados.

IMPACTO DE LAS RECOMENDACIONES EN LOS PROCESOS DE ASIGNACIÓN DE RECURSOS

La asignación anual de recursos a las políticas y programas públicos en marcha debería realizarse en función de los resultados de las mismas, tratando de consolidar aquellas que resultan más efectivas y de mayor impacto, y de reforzar las que demuestran que sus avances limitados se deben a insuficiencia presupuestaria. Una forma de verificar si las evaluaciones realizadas en México han tenido alguna incidencia en el complejo proceso técnico-político de asignación de presupuesto consiste en contrastar este último con los resultados alcanzados por las primeras.

En el caso federal, el Cuadro 2 recupera la evolución del gasto ejercido en 2008-2010, la que en su conjunto alcanzó un incremento del 50%.28 Sin embargo, se observan notables variaciones por programas, siendo pocos los que se acercan a la media. En cambio aparecen programas que disminuyen notablemente su presupuesto (Oportunidades Productivas y Abasto Social de Leche), otros que se mantienen prácticamente sin cambios (Desarrollo de Zonas Prioritarias, Abasto Rural y Rescate de Espacios Públicos), algunos que presentan importantes incrementos (Empleo Temporal y Hábitat), y uno con un aumento notable (Apoyo Alimenticio).

A continuación se revisan los casos extremos:29

• Oportunidades Productivas y Empleo Temporal no han tenido evaluaciones de impacto a pesar de su larga existencia. En el primer caso la disminución presupuestal tampoco se debe a una reducción de las necesidades de ingreso que generan sus proyectos, sino más bien a un ajuste técnico-metodológico de su población potencial, definida además en función del presupuesto disponible y no a la inversa. Empleo Temporal tiene un aumento importante de población atendida entre 2007 y 2010 (pasa de 240 mil a 582 044 personas). El 71% de sus beneficiados manifiestan mejoras en sus condiciones de vida y 79% en sus ingresos. En consecuencia, el beneficio percibido y la creciente necesidad justificarían el aumento de su presupuesto.

• Abasto Social de Leche, según sus evaluaciones de impacto, sólo ha mostrado claros avances en materia de leche fortificada y en ciertas edades. En 2006 no se encontró impacto en el desarrollo cognitivo de los niños; tampoco en 2009 se identificó impacto en el desempeño escolar; en cambio, mejoró el desarrollo intelectual pero éste se explica por otra causa: el nivel socioeconómico.30 Sin embargo, en 2010 su población objetivo aumentó en 23%,31 mientras los beneficiarios atendidos se mantuvieron estables, al mismo tiempo que su presupuesto disminuyó y se produjo una reducción en su cobertura.

• Hábitat tuvo una evaluación de impacto en 2007 que reportó resultados favorables en el rubro de construcción de infraestructura básica, pero hasta 2011 no se había realizado otra. Su población potencial se ha mantenido estable. En 2010 se reporta la superación de 15 de sus 25 metas, gracias al incremento de sus recursos federales y estatales, no una relación a la inversa que explique la decisión del aumento presupuestario.

• Apoyo Alimenticio es el programa con un aumento más notable, aunque el monto absoluto de su presupuesto está por debajo de Hábitat, Desarrollo de Zonas Prioritarias, 70 y Más y —muy especialmente— Oportunidades. Está dirigido a las localidades rurales marginadas, pero ha sufrido cambios importantes en sus RO, por lo que los resultados positivos de la evaluación de impacto que se le realizó en 2006 han perdido vigencia. En 2009-2010 se fusionó con el Programa de Apoyo Alimentario en Zonas de Atención Prioritaria y pasó de ser responsabilidad de Diconsa a la Coordinación de Oportunidades, programa con el que se asimiló, cambiando su población objetivo, condicionando el apoyo a la asistencia a unidades de salud,32 etcétera. Si bien se menciona que su población objetivo no estaba cuantificada en 2010, se afirma que aumentó 139% respecto del año anterior, mientras su cobertura estuvo por debajo de lo planeado. La población atendida habría aumentado en 158% en ese mismo año, todo lo cual resulta entre confuso y contradictorio.

En resumen, si bien los procesos generalizados de evaluación externa de todos los programas que reciben recursos fiscales y están sujetos a RO dieron inicio en 2001 por decisión de la Cámara de Diputados con el objetivo de que sus informes fueran entregados a la Comisión de Presupuesto y Cuenta Pública, de manera que "los resultados sean considerados en el proceso de análisis y aprobación del Presupuesto de Egresos de la Federación para el siguiente Ejercicio Fiscal",33 el análisis de los casos más relevantes de incrementos o reducciones presupuestales mostró poca relación con los resultados de las evaluaciones realizadas a los programas federales. Esto a pesar de que el Coneval genera y difunde información especialmente preparada para el proceso presupuestario que, durante los años 2010 y 2011, se entregó directamente a la Cámara de Diputados y, a partir del 2012, se encuentra disponible en la página de internet del Coneval.34

En síntesis, la Cámara de Diputados continúa tomando sus decisiones con base en techos financieros preestablecidos, con una casi nula utilización de los resultados de las evaluaciones, a menudo desconocidas por sus integrantes entrevistados o confundidas con los trabajos de la Auditoría Superior de la Federación.35 Tampoco se percibe su utilización por la Comisión de Desarrollo Social en temas sustantivos.

En el caso del GDF, si bien no se cuenta con la información detallada por programa, menos aún cuando se trata de políticas, ésta existe en algunos casos en que el programa y la institución que lo opera prácticamente se identifican, lo que nos permite acercarnos a su análisis.

El Cuadro 3 muestra la evolución del presupuesto del GDF por organismos públicos en 2008-2012. Como podemos ver, en precios corrientes, el incremento promedio fue de 17%, pero como la inflación acumulada del periodo fue aproximada a 21%, casi se mantuvo estable en términos reales. Aunque existen variaciones pequeñas entre organismos (nada comparable a las analizadas en el caso previo), identificamos dos instancias que aumentan un poco más que la media: el Fideicomiso para la Educación Garantizada, Fidegar (0.30%) y el Instituto para la Atención de los Adultos Mayores (IAAM) (0.39%).36 Pero en estos casos existen explicaciones que nada tienen que ver con el éxito mostrado por la gestión de la política o programa en sus evaluaciones: el primero tuvo a su cargo el Programa del Bachillerato Universal, Prepa Sí37 y fue el único que no aceptó ninguna recomendación de Evalúa DF; de igual forma, en el segundo caso fueron rechazadas las recomendaciones de fuerte impacto presupuestal y el incremento debe estar relacionado más bien con la reducción de la edad para recibir el apoyo (de 70 a 68 años), que incrementó su población objetivo.

Evalúa DF debe entregar copia de los informes de evaluación a la Comisión de Desarrollo Social de la Asamblea Legislativa del Distrito Federal y ésta los ha utilizado en diversos casos, más no con fines presupuestales. Más bien han sido las propias instancias evaluadas quienes argumentan falta de recursos para negarse a llevar a cabo las recomendaciones, por temor de que la Secretaría de Finanzas no les apruebe el incremento presupuestal requerido.

En consecuencia, el proceso de aceptación y cumplimiento de las recomendaciones no muestra impactos sustantivos para mejorar la distribución de los recursos presupuestales en ninguno de los dos casos considerados.

MECANISMOS E IMPACTO DE LAS RECOMENDACIONES EN LA REFORMULACIÓN DE POLÍTICAS Y PROGRAMAS SOCIALES

Más allá de su incidencia presupuestal, es importante que las recomendaciones de calidad sean tomadas en cuenta por los responsables de políticas y programas para mejorar su diseño y planear mejor su implementación.

A nivel federal, al inicio del nuevo siglo, si bien la Secretaría de Desarrollo Social (Sedesol) contó con un Sistema de Seguimiento a Evaluaciones Externas, el mismo sólo parece haber sido útil al inicio de los procesos, ya que paulatinamente los funcionarios responsables fueron disminuyendo sus compromisos con los convenios asumidos y se limitaron a entregar oficios sin información de avances sustantivos, sólo para evitar que se les pudiera sancionar por incumplimiento. Según un funcionario entrevistado, la excepción habrían sido los programas relacionados con la desnutrición. En cambio, algunos evaluadores afirmaban que había casos en que los informes no eran ni siquiera leídos por las unidades responsables de la operación o la propia contratante de la misma, otros, que ésta no era distribuida a las instancias responsables en las entidades federativas y, en la mayoría, que no se tomaban decisiones para implementar las propuestas; o bien, que su consideración era muy lenta y formal, informándose de la misma manera, es decir, sólo el porcentaje de cumplimiento, pero no su contribución sustantiva para mejorar el problema identificado.38

Al crearse el Coneval en 2006, como sus recomendaciones carecen de carácter vinculatorio, este Consejo comenzó a buscar otros mecanismos que pudieran garantizarle que los ajustes recomendados en las evaluaciones y recogidos en los convenios respectivos se pusieran en práctica: un sistema computarizado de control de gestión diseñado conjuntamente con la Secretaría de Hacienda y Crédito Público (SHCP), o Programas de Mejoramiento de la Gestión a cargo de la Secretaría de la Función Pública (SFP).

Actualmente, después de presentado el informe final de la evaluación, proceso que ya fuera someramente descrito, la Unidad Responsable de la Operación del Programa debe emitir una carta dirigida al Coneval, la SHCP y la SFP emitiendo su Posición Institucional ante la evaluación. Recibida la carta, las tres instancias mencionadas seleccionan los ASM a ejecutar por sus operadores para mejorar la gestión del programa, tomando en cuenta criterios de claridad, relevancia, justificación y factibilidad. Posteriormente se establece un Convenio de Compromisos de Mejoramiento de la Gestión en el que el programa se compromete a instrumentarlos. También se emiten recomendaciones dirigidas a la Comisión Nacional de Desarrollo Social (CNDS) y a la Comisión Intersecretarial de Desarrollo Social (CIDS), a las cuales la Ley General de Desarrollo Social (LGDS) otorga atribuciones para la toma de decisiones hacia el mejoramiento de los programas y acciones prioritarias. Los ASM se definen y se publican en la página oficial del Consejo desde la generación de evaluaciones de 2008-2009; su Mecanismo de Seguimiento se actualiza anualmente y es realizado por la Secretaría de la Función Pública.

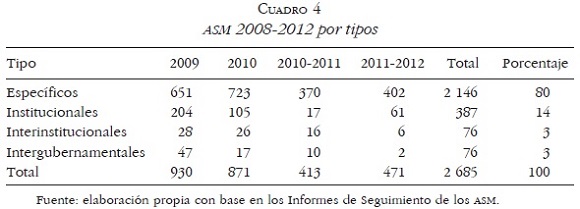

Los informes de seguimiento de 2008 y de 2009 recogen los ASM que se desprenden de las evaluaciones de Consistencia y Resultados y de Diseño realizadas en 2007-2008 y 2008-2009 (Cuadro 4). En ambos casos se informa de los nuevos ASM y se repiten los previos, pero no se informa sobre los avances realizados.

A partir de 2011, los ASM son clasificados en función de su nivel de prioridad y se clasifican en:

1. Aspectos específicos, cuya solución corresponde únicamente a las unidades responsables.

2. Aspectos institucionales, que requieren la intervención de dos o más áreas de la dependencia o entidad.

3. Aspectos interinstitucionales, que demandan la participación de más de una entidad o dependencia.

4. Aspectos intergubernamentales, que necesitan de la intervención adicional de otros ámbitos de gobierno (estatal y/o municipal).

Los dos últimos se entregan a la CNDS y a la CIDS.

En consecuencia, los informes de seguimiento de los ASM de 2010-2011 y 2011-2012 presentan información concentrada y comparable de la incidencia alcanzada por los medios anteriores. El análisis desarrollado para los ASM del primero de estos periodos mostraba un promedio general de avance del 69.4 por ciento.39

Por su parte, el referido a 2011-201240 menciona que sus ASM se concentraron en la Secretaría de Educación Pública (29%), la Comisión Nacional para el Desarrollo de los Pueblos Indígenas (18%), las secretarías de Medio Ambiente y Recursos Naturales (14%) y de Economía (10%).

En términos globales se reporta un cumplimiento pleno en 56.6% de los casos (55.9% en aspectos específicos y 70.6% en los institucionales), y un promedio aproximado de 40% de avance en los restantes, cuyo plazo ya había concluido. El promedio general de avance, incluido los terminados, alcanza 73.9% (Gráfica 1), lo que muestra una pequeña mejoría respecto del año anterior. Institucionalmente, el mayor número de ASM cumplidos correspondieron a Economía (46) y CDI (44). El cumplimiento pleno se produjo en 74 programas cuyas acciones se distribuyeron en: corregir actividades o procesos (71% de los casos), modificar apoyos al programa (12%), reorientar sustancialmente el programa (15%), adicionar o reubicar el programa (1%).

En conjunto, una vez distribuidas por tipos las ASM de los dos primeros periodos, en 2008-2012 se emitieron 2 685 ASM, de los cuales 80% fueron específicos y 14% institucionales, pero no contamos con información de su grado de cumplimiento en conjunto (Cuadro 4).

Para profundizar en el análisis se incluye el seguimiento correspondiente al programa más relevante (Oportunidades) en el periodo 2007-2011. Su Evaluación de Consistencia y Resultados 200741 realizó un conjunto de 14 recomendaciones de importancia sustantiva, que se habrían concretado en seis ASM según el documento "Seguimiento de Aspectos Susceptibles de Mejora Derivados de las Evaluaciones Externas 2007", pero en la Evaluación Específica de Desempeño de 2009-2010,42 sólo se retoman de ese periodo dos ASM específicos y dos institucionales, que dejan fuera importantes asuntos planteados en las recomendaciones (calidad de la educación, redefinición de poblaciones, evaluación de impacto, etcétera). Los primeros dos recuperan: la elaboración de un documento para sistematizar los mecanismos para el establecimiento de indicadores y metas; y el fortalecimiento de algunos indicadores de la Matriz de Indicadores para Resultados (mir) en temas relacionados con el mejoramiento de la salud, el tránsito a la educación media superior y la recepción de apoyos alimentarios por parte de los beneficiarios. Los segundos incluyen la elaboración de un diagnóstico actualizado y adecuado de la problemática que sustenta la razón de ser del programa, y la preparación de un Programa Estratégico.

En el seguimiento de los anteriores se expresa que los primeros dos se cumplieron plenamente en la fecha comprometida; mientras que los dos institucionales habían sufrido retrasos: el primero de ellos se concluyó seis meses después de lo acordado, y habría dado lugar al documento "Movilidad social intergeneracional de los jóvenes beneficiarios de Oportunidades provenientes de hogares en zonas rurales"; mientras que el segundo sólo presentaba un avance del 50% al 31 de diciembre de 2009.

La Evaluación Específica de Desempeño de 200843 reconoce que, en un Documento Institucional y otro Documento de Trabajo, ha habido una "reflexión" de parte de Oportunidades sobre los ASM señalados en 2007; sin embargo repite, aunque en forma más sintética, las primeras cinco recomendaciones relatadas en 2007, lo que hace suponer que no percibió un avance contundente en ellas.

Los ASM de las evaluaciones de 2008 reaparecen en 2010-2011 y habrían sido dos específicos, dos institucionales, tres interinstitucionales y uno intergubernamental.44 Se informa que fueron atendidos los específicos; seguían en proceso la elaboración del plan estratégico, si bien se contaba con una versión preliminar, y se carecía de información sobre los avances de los dos últimos tipos de aspectos.

En 2008-2009 también se realizó la evaluación de impacto de Oportunidades, que se tradujo en varios tomos de informes y 220 recomendaciones. De ellas surgirían 27 ASM, con amplia incidencia referida a la calidad de los servicios de salud (tomo II) o a la difusión de la información, pero sin impacto en materia de diseño. Se informó que muchas se descartaron por estar ya en proceso o requerir de mayores recursos presupuestarios que se prefirió dedicar a ampliar la cobertura del programa.

Nuevamente, la evaluación de desempeño 2009-2010 define otros ASM, aunque mucho menos claros y sustantivos que los anteriores, algunos redactados como recomendaciones, pero otros, en términos de objetivos o simplemente de problemas identificados.

Finalmente, en 2010-201145 se informa que se realizan dos evaluaciones de los efectos de mediano plazo de Oportunidades en zonas urbanas, una en educación y otra en salud y nutrición, las cuales estaban por concluirse, y que las RO de 2011 redefinían la población objetivo de acuerdo con la nueva metodología de medición multidimensional de la pobreza del Coneval.

Concretamente, como seguimiento de los ASM de las evaluaciones externas de 2010, se incluyen 17 específicos y 10 interinstitucionales o intergubernamentales.46 Se mencionan como atendidos los específicos y sin información los dos últimos tipos. En cambio, otro documento reporta un 100% de cumplimiento de las recomendaciones recibidas.47

En resumen, las evaluaciones de Oportunidades tienden a insistir con recomendaciones dirigidas a la educación y se observa una importante reiteración de ASM sobre el tema de la definición de las poblaciones potencial y objetivo, y de la necesidad de aumentar la coordinación interinstitucional para desarrollar mayores sinergias. Dicha reiteración sugiere la idea de que los ASM no se estuvieran cumpliendo; concretamente, la evaluación de 2008 había propuesto conformar un equipo de trabajo para su revisión.

Como conclusión general del mecanismo analizado se afirma que los porcentajes de cumplimiento general logrados por Coneval son considerables, restando aún poco más de 25% para alcanzar pleno cumplimiento y avanzando lentamente hacia la meta. Este cumplimiento parcial se logra ágilmente en asuntos metodológicos relacionados con la MIR, indicadores, metas, etcétera, y en temas relativos a procesos de operación, pero se ve más difícil cuando se trata de hacer un diagnóstico y, más aún, un programa estratégico, una reformulación de la política o una evaluación de impacto en la trasmisión intergeneracional de la pobreza.48 También se dificultan aspectos que involucran a varias instancias o varios ámbitos de gobierno. Finalmente, la información disponible no nos permitió valorar si existe relación entre el peso económico de llevar a cabo un ASM y su nivel de cumplimiento.

Desde 2007-2008, otro de los mecanismos ideados por el Coneval para realizar la promoción de la utilización de las recomendaciones ha sido el reconocimiento de Buenas Prácticas en el Uso de los Resultados de Monitoreo y Evaluación (no en el desempeño de los programas). El 29% de ellos ha correspondido al sector de Desarrollo Social, pero se destaca que en los últimos dos años ya no se relacionan claramente con la utilización de resultados de monitoreo y evaluación, y que su impacto no ha sido evaluado.

Como ya mencionó, a diferencia del Coneval, Evalúa DF tiene la particularidad de que sus recomendaciones tienen carácter vinculatorio. Pero, las dependencias evaluadas tienen la posibilidad de manifestar su desacuerdo, en cuyo caso Evalúa DF puede controvertirlas ante la Comisión Interinstitucional de Desarrollo Social.

En general, el cumplimiento total o parcial de las recomendaciones es bastante elevado, aunque existe un importante grado de retraso en su imple-mentación y la entrega de información. Es posible afirmar que son mucho mejor aceptadas las recomendaciones ligadas a la puesta en práctica de las políticas, a su operación o implementación, que las ligadas a su reformulación. Es que las primeras incluyen fundamentalmente cambios en los procedimientos en curso, mientras que las últimas modifican la definición misma de la política y eso, en muchos casos, implica mayor disponibilidad de recursos.

En 2009, por ejemplo, 105 recomendaciones fueron aceptadas (84.6%) y 19 rechazadas (15.4%), pero cinco de ellas fueron reconsideradas por Evalúa DF, quedando 14 sujetas a controversia (11.3%), todas correspondientes a dos de los programas evaluados49 (Gráfica 2). Dichas recomendaciones, dirigidas a 12 programas y dependencias, se distribuyeron aproximadamente en la misma proporción en materia de diseño (49.6%) que de operación (50.4%); sin embargo, de las 14 rechazadas, nueve se concentraron en diseño y ocho de ellas implicaban una fuerte repercusión presupuestal.

De las correspondientes al programa emblemático para Adultos Mayores fueron rechazadas siete de 19. Cinco de ellas se vinculaban con la propuesta de garantizar el derecho al acceso gratuito a los servicios médicos y medicamentos a las personas residentes en el Distrito Federal que carecen de seguridad social laboral, a través de los servicios públicos de salud del GDF. Una sexta corresponde a la propuesta de reducción de causales de baja del programa y la última a la revisión de los propósitos del procedimiento de visitas domiciliarias.

Por otra parte, de las recomendaciones aceptadas ese año, al 30 de junio de 2011 había: 65 cumplidas (63%), 20 cumplidas parcialmente (19%), 18 incumplidas (17%) y 2 (1%) aún no vencidas,50 lo que, suponiendo que el cumplimiento parcial fuera del 50%, nos daría un porcentaje global de cumplimiento de aproximadamente el 73%. El Programa de Pensión Alimentaria Adultos Mayores, de las 12 recomendaciones que había aceptado, contaba con ocho cumplidas, dos parcialmente cumplidas, y dos incumplidas.

En 2010 se emitieron 35 recomendaciones a 12 instancias gubernamentales: 30 fueron aceptadas, dos lo hicieron parcialmente y tres fueron rechazadas. Las últimas correspondieron al Instituto de las Mujeres del Distrito Federal; sin embargo, en los meses siguientes se modificó la ley correspondiente recuperando la esencia de las mismas, razón por la que ya no fueron controvertidas por Evalúa DF. En este programa se hizo la primera experiencia de dirigir recomendaciones directamente a la Secretaría de Finanzas cuando existen importantes repercusiones en las necesidades financieras. Se trató concretamente de la recomendación relacionada con el traslado de recursos de este programa a otro de nueva creación, lo que fue aceptado; sin embargo, no se trataba de una ampliación de recursos, sino de una mera transferencia.

A partir de 2011 las recomendaciones dejaron de dirigirse a programas para hacerlo a políticas, al igual que las evaluaciones realizadas, lo que complicó el seguimiento porque las recomendaciones ya no se dirigían a un solo órgano (responsable en el caso de los programas) sino a las varias instancias coordinadas para poner en marcha una política. Se trató de siete grandes recomendaciones, desglosadas en 21 para su seguimiento en el caso de agua potable51 y de 10, subdivididas en 56, en materia de trabajo.52 Las primeras fueron dirigidas a la Secretaría del Medio Ambiente, al Sistema de Aguas de la Ciudad de México, a la Secretaría de Desarrollo Urbano y Vivienda, a la Secretaría de Finanzas (SF), a la Contraloría General del Distrito Federal y a la Jefatura de Gobierno; mientras que las últimas lo hicieron a la Secretaría de Trabajo y Fomento al Empleo, a la Secretaría de Desarrollo Económico, a la Secretaría de Finanzas, a la Secretaría de Obras y Servicios, a la Oficialía Mayor y a la Jefatura de Gobierno.53

Como puede verse, en 2011 se volvieron a enviar recomendaciones a la SF, debido a que los órganos operativos no aceptaban las recomendaciones de fuerte impacto presupuestal por temor de que la SF no les autorizara el gasto correspondiente, pero ésta empezó también a rechazarlas por considerar que no le compete emitir opinión sobre las recomendaciones de carácter operativo, aunque ellas tengan fuerte impacto presupuestal.

En consecuencia, tampoco el carácter vinculatorio de Evalúa DF le ha permitido, hasta la fecha, tener la contundencia esperada en materia de reformulación de políticas y programas.

Más allá de asegurar la puesta en práctica de las buenas recomendaciones surgidas de un proceso de evaluación, es necesario verificar el impacto que las mismas tienen en el logro de los objetivos planeados para resolver problemas sociales. Tal vez sea muy pronto para que esta actividad se encare, pero a la fecha ninguno de los dos Consejos de evaluación considerados en el trabajo ha avanzado en su análisis y valoración.

DISCUSION Y CONCLUSIONES

Los casos de metaevaluación mencionados en la bibliografía internacional revisada (Unión Europea, Francia, España, Canadá y Costa Rica) nos informan sobre la limitada utilización de las recomendaciones surgidas de los informes de evaluación para la reformulación de las políticas y programas, pero ninguno de ellos cuantifica dicho nivel de incidencia y, menos aún, intenta explicarlo empíricamente, por lo que no es posible valorar nuestros avances a la luz de los anteriores. Lo que sí existe desde hace bastante tiempo en países como Francia son aproximaciones teóricas a las dificultades que impiden el avance de la evaluación (políticas, administrativas, metodológicas, psicológicas, etcétera),54 todas ellas manejables como posibles hipótesis explicativas en el caso mexicano.

Si bien se reconoce que los niveles de cumplimiento de los ASM del Coneval y las recomendaciones de Evalúa DF son relativamente altos para el tiempo que llevan trabajando, preocupa que, a pesar de las diferencias en su marcos jurídicos, organización, funcionamiento, enfoques, métodos, ambos logren su mayor impacto en los ajustes para la operación de los programas, incidiendo mucho menos en su reformulación. Esta situación también fue identificada en el caso canadiense55 hasta la implantación de la Ley sobre la Administración Pública del año 2000 que la reorienta hacia una Gestión por Resultados, con altos niveles de participación de sus funcionarios y un reforzamiento del papel del Poder Legislativo; experiencia que constituye otro camino a explorar.

Otro punto que es necesario analizar, y al que pueden contribuir los nuevos ejercicios de metaevaluación, es si se justifica o no que a nivel federal la cantidad de recomendaciones de evaluación que logran transformarse en ASM sea tan reducida, lo que no sucede en la experiencia de Evalúa DF, como puede verificarse en su página web. Pero nuevamente se desconoce la existencia de estudios de otros países que cuantifiquen este dato y muestren su evolución.

Experiencias como la de Reino Unido,56 impulsadas desde el enfoque de la NGP, demostraron que una forma efectiva de incentivar la utilización de resultados de la evaluación es vincularla estrechamente a la asignación de presupuesto. También algunos países latinoamericanos como Uruguay y Chile57 han intentado seguir este camino, pero con mayor flexibilidad y resultados variados. En el caso mexicano, si bien la Cámara de Diputados introdujo los procesos de evaluación con ese fin expreso, en la práctica no se visualizan avances al respecto.

A continuación se sintetizan las conclusiones a las que se ha ido arribando a lo largo del artículo:

• Desde el inicio del nuevo siglo, México ha puesto en marcha importantes procesos de actualización de su marco legal y de la evaluación formal de sus programas, recientemente también de algunas políticas; sin embargo, aún falta bastante para alcanzar el desarrollo de una verdadera e internalizada cultura de la evaluación y de la utilización de sus resultados.

• Coneval y Evalúa DF analizan la calidad y factibilidad de las propuestas que efectúan los equipos de evaluadores, pero el segundo debe emitir sus propias recomendaciones vinculatorias, recuperando también otros puntos de vista.

• El análisis de la evolución de los presupuestos muestra su tendencia inercial en el caso del Distrito Federal, y sus modificaciones, a veces incluso notorias, en el contexto federal, pero ninguna se relaciona claramente con los resultados de las evaluaciones aplicadas.

• Las evaluaciones llevadas a cabo por el Coneval no son tomadas en cuenta por la Cámara de Diputados, que carece de suficiente personal especializado y, a veces, ni siquiera conoce su existencia. Tampoco Evalúa DF ha logrado tener impacto a este nivel.

• En consecuencia, se confirma la rigidez de los procesos de asignación de recursos, frente a los cuales la evaluación prácticamente no está teniendo efectos, lo que implica que las recomendaciones de mayor envergadura (en torno al diseño) no pueden avanzar.

• En cuanto a las recomendaciones sustantivas dirigidas a los programas y políticas para mejorar sus formulaciones y procesos de ejecución, el Coneval ha tenido que diseñar mecanismos, en conjunto con la SHCP y la SFP, que le permitan presionar a los evaluados para el cumplimiento de los ajustes convenidos, debido a su falta de atribuciones vinculatorias.

• Las recomendaciones realizadas por Evalúa DF, si bien son legalmente vinculatorias, enfrentan serias dificultades para que las instancias responsables de las políticas y los programas acepten dichas recomendaciones por temor a comprometerse y que luego la SF no les autorice los recursos; mientras esta Secretaría rechaza las recomendaciones por considerar que se deben dirigir a los órganos operativos. Además, se han "congelado" los procesos previstos para dirimir las controversias.

• Los niveles de cumplimiento de las recomendaciones aceptadas giran en torno del 73-74%, lo que es un logro importante para Consejos que llevan funcionando entre 5 y 7 años. Sin embargo, cuando se revisa más profundamente su contenido, se encuentra que son las recomendaciones dirigidas a los procesos de ejecución y control las que engrosan estos porcentajes; en cambio, las que se dificultan son las relacionadas con la elaboración de diagnósticos, de evaluaciones de impacto y, muy especialmente, con la reformulación y planeación, que normalmente implican mayor disponibilidad de recursos presupuestales. Por lo que las evaluaciones van incidiendo poco a poco y con muchas dificultades en la toma de decisiones de los órganos responsables de las políticas y programas.

• En consecuencia, no hay evidencias contundentes de que las evaluaciones mexicanas estén contribuyendo a incrementar la eficiencia de los programas sociales, tema que preocupa al neoliberalismo. Queda pendiente que ambos Consejos asuman la necesidad de evaluar el impacto de las modificaciones hechas a los programas y políticas como consecuencia de las recomendaciones aplicadas.

• En síntesis, por su alcance nacional, mayor antigüedad y amplia disposición de recursos, el Coneval muestra un cierto grado de hegemonía en el tema; sin embargo, la experiencia de Evalúa DF ejemplifica la posibilidad de desarrollar un enfoque alternativo. Pero, queda abierta la inquietud sobre cuál debería ser el diseño institucional, alternativo a los dos analizados, que garantizara una mayor utilización de los resultados de evaluación en los procesos de reformulación.

En un contexto de restringida discusión internacional del tema, el presente artículo ha intentado aproximarse al conocimiento del mismo en el caso mexicano, con plena conciencia de la limitación que implica trabajar fundamentalmente a partir de documentos oficiales y de la necesidad de continuar investigando sus causas, para definir estrategias alternativas que permitan remover las actuales resistencias.

1 Véanse, entre otros: Ernesto Cohen, "Reforma del Estado, modernización administrativa y evaluación del desempeño de la gestión", en Los desafíos de la reforma del Estado en los programas sociales: tres estudios de caso, Serie Políticas Sociales núm. 45, Chile, CEPAL, 2001; [ Links ] Sonia Ospina, "Evaluación de la gestión pública: conceptos y aplicaciones en el caso latinoamericano", Revista Reforma y Democracia, núm. 19, Venezuela, CLAD, 2001; [ Links ] Nuria Cunill y Sonia Ospina, Evaluación de resultados para la gestión pública moderna y democrática: experiencias latinoamericanas, Venezuela, CLAD/AECI/MAP/FIIAPP, 2003, [ Links ] y Fortalecimiento de los sistemas de monitoreo y evaluación en América Latina, Proyecto CLAD, Banco Mundial, 2008; [ Links ] Ariel Zaltsman, "La evaluación de resultados en el sector público argentino: un análisis a la luz de otras experiencias en América Latina", Reforma y Democracia, Revista del CLAD, núm. 29, junio, 2004; [ Links ] Edgardo Mosqueira, "De la evaluación por productos a la evaluación por resultados e impactos: análisis de las experiencias recogidas del proyecto de modernización del Estado argentino", Reforma y Democracia, Revista del CLAD, núm. 38, Venezuela, CLAD, 2007; [ Links ] Myriam Cardozo, La evaluación de políticas y programas públicos. El caso de los programas de desarrollo social en México, Colección Conocer para Decidir, México, Cámara de Diputados/Miguel Ángel Porrúa, 2006, [ Links ] Evaluación y metaevaluación en las políticas y programas públicos. El estado del arte, México, UAM-Xochimilco, 2012a y Sistematizació [ Links ]n de la experiencia de evaluación de Evalúa DF en 2008. Metaevaluación y autoanálisis, México, UAM-Xochimilco/Evalúa DF, 2012b; [ Links ] Sara Ochoa, "Perspectiva sobre la evaluación y gestión pública", Reporte CESOP, núm. 9, LX Legislatura, México, Cámara de Diputados, 2007. [ Links ]

2 Al respecto véanse M. Frangois Lacasse, "Gestion et émasculation des évaluations: le cas de Canada", Revue Frangaise dAdministration Publique, núm. 66, Francia, 1993; [ Links ] Ester García Sánchez, "Metaevaluación de políticas públicas: una visión desde la ciencia política", Revista Reforma y Democracia, núm. 43.Venezuela, CLAD, 2003; [ Links ] María Bustelo, La evaluación de políticas públicas de igualdad de género en España, Madrid, Catarata, 2004; [ Links ] Luis Fernando Díaz, y Rosay Rosales, Metaevaluación: evaluación de la evaluación de políticas, programas y proyectos sociales, San José de Costa Rica, Universidad Estatal a Distancia, 2003; [ Links ] Pierre Lascoumes, "Pratiques et modeles de l'évaluation" y "Usages et retombées de l'évaluation", en Marie Christine Kesller et al., Evaluation des politiques publiques, París: L'Harmattan, 1998; [ Links ] B. Lajoudie y J. Toulemonde, "Méta-évaluation, bilan des évaluations réalisées en Limousin au cours de la période 1994-1998", ponencia presentada a las Cuartas Jornadas de la Société Frangaise d'Évaluation, Lille, France, 2002; [ Links ] José María Larrú, "Análisis de los resultados y metaevaluación del sistema de evaluaciones de EuropeAid", España, CECOD, 2003 [www.cecod.net], fecha de consulta: 22 de junio de 2004. [ Links ]

3 La síntesis presentada (incluida en Myriam Cardozo, Evaluación y metaevaluación en las políticas y programas públicos... , op. cit., p. 24) retoma ampliamente elementos desarrollados en los trabajos de Guillermo O'Donnell y Oscar Oszlak, Estado y políticas estatales en América Latina: hacia una estrategia de investigación, Argentina, CEDES, 1976; [ Links ] Oscar Oszlak, "Políticas públicas y regímenes políticos: reflexiones a partir de algunas experiencias latinoamericanas", Estudio CEDES, vol. 3, núm. 2, Argentina, 1980. [ Links ] Una descripción detallada de lo que el concepto puede abarcar puede consultarse en Joan Subirats, Análisis de políticas públicas y eficacia de la administración, España, INAP, 1989. [ Links ]

4 Myriam Cardozo, La evaluación de políticas y programas públicos..., op. cit.

5 Idem.

6 Inicialmente también por el Centro Latinoamericano de Administración para el Desarrollo.

7 Myriam Cardozo, Evaluación y metaevaluación en las políticas y programas... , op. cit.

8 Idem.

9 Myriam Cardozo, La evaluación de políticas y programas públicos... , op. cit.

10 Se aclara que, a pesar de que han existido intentos de institucionalizar otros Consejos como el del Estado de México o el de Puebla, a la fecha sólo funciona Coneval a nivel federal y Evalúa DF en la capital.

11 Myriam Cardozo, Evaluación y metaevaluación en las políticas y programas... , op. cit.

12 Myriam Cardozo, Evaluación y metaevaluación en los programas mexicanos de desarrollo social, Colección Teoría y Análisis, México, UAM-Xochimilco, 2009 y Evaluación y metaevaluación en las políticas y programas... , op. cit.

13 Myriam Cardozo, La evaluación de políticas y programas públicos... , op. cit.

14 "Ley General de Desarrollo Social" [www.diputados.gob.mx/LeyesBiblio/pdf/264.pdf], fecha de consulta: 14 de septiembre de 2013. [ Links ]

15 Myriam Cardozo, Evaluación y metaevaluación en los programas mexicanos de desarrollo social, op. cit., p. 106.

16 "Ley de Desarrollo Social para el Distrito Federal", publicada en la Gaceta Oficial del Distrito Federal el 11 de febrero de 2009 [www.evalua.df.gob.mx], fecha de consulta: 17 de julio de 2012. [ Links ] Ley Federal de Responsabilidades Administrativas de los Servidores Públicos [www.diputados.gob.mx/LeyesBiblio/pdf/240.pdf], fecha de consulta: 14 de septiembre de 2013. [ Links ] Una revisión más completa del marco jurídico se encuentra en Myriam Cardozo, Sistematización de la experiencia de evaluación de Evalúa DF en 2008. Metaevaluación y autoanálisis, op. cit.

17 Ibid., artículos 74 y 78.

18 Véase [www.coneval.gob.mx/sipf], fecha de consulta: 4 de septiembre de 2012. [ Links ]

19 Una exposición más amplia de su actual marco jurídico se encuentra en Myriam Cardozo, Evaluación y metaevaluación en los programas mexicanos de desarrollo social, op. cit.

20 Myriam Cardozo, "Organización y métodos alternativos en la evaluación de políticas y programas sociales. La experiencia consolidada y la emergente en el caso de México", Revista Gestión y Análisis de Políticas Públicas, núm. 5, España, INAP, 2011. [ Links ]

21 M.Q. Patton, Utilization-focused evaluation. The new century text, Thousand Oaks, Sage Publications, 1997. [ Links ]

22 Gladys Acevedo et al., "Análisis de los lineamientos generales para la evaluación de los programas federales de la administración pública federal", Banco Mundial [www.coneval.gob.mx/cmsconeval/rw/resource/coneval/quienes/2937.pdf], fecha de consulta: 12 de septiembre de 2012. [ Links ]

23 Manuel F. Castro et al., "El sistema de monitoreo y evaluación de México: un salto del nivel sectorial al nacional", Serie Documentos de Trabajo, núm. 20, Banco Mundial, 2009. [ Links ]

24 Sedesol-INSP, "Evaluación del proceso de evaluación del programa Oportunidades" [http://siteresources.worldbank.org], fecha de consulta: 17 de enero de 2009. [ Links ]

25 El Coneval y la Sedesol reportan metaevaluaciones 2007-2012 realizadas a los programas: Oportunidades, Estancias Infantiles para Apoyar a Madres Trabajadoras, Apoyo a las Instancias de Mujeres en las Entidades Federativas, Coinversión Social, 3X1 para Migrantes, Hábitat, etcétera. Las mismas se encuentran disponibles en las siguientes páginas consultadas el 23 de septiembre de 2013: [www.oportunidades.gob.mx/EVALUACION/es/wersd53465sdg1/docs/2012/informe_final_oport.pdf] [web.coneval.gob.mx/rw/resource/Mecanismos_2012/SEDESOL/S174_Programa%20de%20Estancias%20Infantiles%20a%20Madres%20Trabajadoras/S174_PI.pdf] [www.sedesol.gob.mx/work/models/SEDESOL/Resource/846/1/images/S155_%20Doc.pdf] [www.sedesol.gob.mx/work/models/SEDESOL/Resource/846/1/images/S070_Doc_Opinion.pdf] [www.sedesol.gob.mx/work/models/SEDESOL/Resource/846/1/images/S061_DocOpinion.pdf] [media.wix.com/ugd/660b5a_2c4743bf4496257db5b8070cb8c29bb8.pdf].

26 Myriam Cardozo, Sistematización de la experiencia de evaluación de Evalúa DF en 2008... , op. cit.

27 J. Luis Osuna et al., "Metaevaluación de las políticas evaluadas por Evalúa DF durante 2009" [www.evalua.df.gob.mx/metaevaluaciones.html], fecha de consulta: 13 de junio de 2011. [ Links ]

28 Se supone que en precios corrientes porque la fuente utilizada no lo aclara.

29 Coneval, "Desempeño de los Programas Sociales" [www.coneval.gob.mx/cmsconeval/rw/pages/evaluacion/desempeno_programas_sociales.es.do], fecha de consulta: 10 de septiembre de 2012. [ Links ]

30 Coneval, "Informe de la Evaluación Específica de Desempeño 2010-2011" [www.coneval.gob.mx/Evaluacion/paginas/Fichas-narrativas-EED.aspx], fecha de consulta: 13 de junio de 2013. [ Links ]

31 Aunque los evaluadores opinan que está sobreestimada, ya que ese año se eliminó la supuesta "duplicidad" con quienes recibían también el apoyo de Oportunidades.

32 A pesar de que opera en localidades que no tienen estos servicios ni los educativos.

33 Diario Oficial de la Federación, 1 de enero de 2002. [ Links ]

34 Coneval, "Información Coneval para el proceso presupuestario 2012" [www.coneval.gob.mx/Informes/Evaluaci%C3%B3n%202011/CP_201229_agosto_2011.pdf] [http://web.coneval.gob.mx/Evaluacion/Paginas/PaqueteInformativoPresupuestario.aspx], fecha de consulta: 13 de junio de 2013. [ Links ]

35 Myriam Cardozo, Evaluación y metaevaluación en los programas mexicanos de desarrollo social, op. cit.

36 Evalúa DF, "Recomendaciones al Programa Pensión Alimentaria para Adultos Mayores de 70 años, residentes en el DF" [www.evalua.df.gob.mx/recomendaciones/recomendaciones_comite/rec_def_pen_al.pdf], fecha de consulta: 19 de julio de 2012. [ Links ]

37 Evalúa DF, "Recomendaciones al Programa de Estímulos para el Bachillerato Universal (Prepa Sí)" [www.evalua.df.gob.mx/recomendaciones/recomendaciones_comite/rec_def_prepa.pdf], fecha de consulta: 19 de julio de 2012. [ Links ]

38 Myriam Cardozo, Evaluación y metaevaluación en los programas mexicanos..., op. cit.

39 Coneval, "Informe de Seguimiento a los Aspectos Susceptibles de Mejora de Programas Federales 2010" [www.coneval.gob.mx/cmsconeval/rw/pages/evaluacion/seguimiento_recomendaciones/ASM_2010_2011.es.do;jsessionid=a87042d25f8147c911a47a5fde3bc5e08919d24c1847 56f2f5c9d8094f85c258.e34QaN4LaxeOa40Pbhj0], fecha de consulta: 12 de septiembre de 2012. [ Links ]

40 Coneval, "Informe de Seguimiento a los Aspectos Susceptibles de Mejora de los Programas y Acciones Federales de Desarrollo Social 2011-2012" [http://web.coneval.gob.mx/Informes/Evaluacion/Informe%20ASM/Informe%20ASM%20_2011_2012.pdf], fecha de consulta: 12 de septiembre de 2012. [ Links ]

41 Coneval, "Resumen Ejecutivo de la Evaluación de Consistencia y Resultados 2007 del Programa de Desarrollo Humano Oportunidades" [www.oportunidades.gob.mx/EVALUACION/441c7c1a3d30adf64e0e724174a9d527/impacto/2007/ECR_2007_2008_ResumenEjecutivo.pdf], fecha de consulta: 8 de septiembre de 2012. [ Links ]

42 Coneval, "Informe de la Evaluación Específica de Desempeño 2009-2010 del Programa de Desarrollo Humano Oportunidades" [www.oportunidades.gob.mx/EVALUACION/441c7c1a3d30adf64e0e724174a9d527/eval_especifica/oportunidades/oport_informe_completo_2009_2010.pdf], fecha de consulta: 8 de septiembre de 2012. [ Links ]

43 Coneval, "Informe de la Evaluación Específica de Desempeño 2008 del Programa de Desarrollo Humano Oportunidades" [www.oportunidades.gob.mx/EVALUACION/441c7c1a3d30adf64e0e724174a9d527/eval_especifica/oportunidades/oport_informe_completo_2008_2009.pdf], fecha de consulta: 8 de septiembre de 2012. [ Links ]

44 Evidentemente no hay una clara coincidencia de lo que se va reportando cada año.

45 Coneval, "Informe de la Evaluación Específica de Desempeño 2010-2011 del Programa de Desarrollo Humano Oportunidades" [www.oportunidades.gob.mx/EVALUACION/441c7c1a3d30adf64e0e724174a9d527/eval_especifica/pal/pal_informe_completo_2010_2011.pdf], fecha de consultado: 8 de septiembre de 2012. [ Links ]

46 Resulta extraño que en este caso se haga el seguimiento de 2008 y 2010, sin considerar 2009. Evidentemente no hay una clara coincidencia de lo que se va reportando cada año

47 Coneval, "Valoración del Desempeño de los Programas, con base en los resultados de las evaluaciones de desempeño 2010-2011" [http://web.coneval.gob.mx/Evaluacion/Paginas/PaqueteInformativoPresupuestario.aspx], fecha de consulta: 13 de junio de 20113. [ Links ]

48 En 2008 se llevó a cabo una evaluación de impacto del programa en áreas rurales, en materia de calidad de los servicios de salud, nutrición y educativos, y de la operación del programa y la atención de las familias beneficiadas, pero no en la trasmisión intergeneracional de la pobreza, como se ha venido proponiendo.

49 Evalúa DF, "Primer Informe Semestral del Estado de las Recomendaciones Aceptadas", mimeo, junio de 2011. [ Links ]

50 Idem.

51 Evalúa DF, "Recomendaciones a la Política de Acceso al Agua Potable" [www.evalua.df.gob.mx/recomendaciones/recomendaciones_comite/rec_agua.pdf], fecha de consulta: 19 de julio de 2012. [ Links ]

52 Evalúa DF, "Recomendaciones a las políticas de Fomento al Empleo y Protección del Trabajo" [www.evalua.df.gob.mx/transparencia/2010/rec_tra.pdf], fecha de consulta: 19 de julio de 2012. [ Links ]

53 Evalúa DF, 2011, op. cit.

54 Eric Monnier, "Objectifs et destinataires des évaluations", Documentación Administrativa, núms. 224-225, España, 1991; [ Links ] J.P Nioche y R. Poinsard, L'évaluation des politiques publiques, París, Economica, 1994; [ Links ] Jean-Claude Thoenig, "La evaluación en actos. Lecciones del pasado y preguntas para el futuro", Revista Gestión y Política Pública, vol. XI, núm. 2, México, CIDE, 2002, pp. 453-471. [ Links ]

55 Steve Jacob, "Trente ans d'évaluation de programme au Canada: l'institutionnalisation interne en quéte de qualité", Revue Frangaise dAdministration Publique, núm. 119, 2006, pp. 515-531. [ Links ]

56 W. Saint-Clair, "L'évaluation des politiques publiques au Royaume Uni", Revue Frangaise dAdministration Publique, núm. 66, Francia, 1993 pp. 265-269; [ Links ] Jean-Claude Thoenig, "Que peut-on apprendre s'agissant de la France de la rencontre franco-brittanique?", en Conseil Scientifique de l'Évaluation, L'évaluation en développement 1997, Francia, La Documentation Frangaise, 1998, pp. 49-50. [ Links ]

57 Nuria Cunill y Sonia Ospina, Evaluación de resultados para la gestión pública moderna y democrática..., op. cit., pp. 20-24 y 444-453; y Fortalecimiento de los sistemas de monitoreo..., op. cit., pp. 47-72.