Introducción

El desarrollo de Internet y la evolución de las herramientas tecnológicas de comunicación e información han ampliado el panorama educativo proporcionando nuevos espacios, recursos y funcionalidades que tienen como común denominador la virtualidad y el factor digital. En este sentido, es apreciable el incremento de recursos electrónicos con fines educativos que se han desarrollado en los últimos años, especialmente en el ámbito de la formación universitaria, y la tendencia a su publicación en abierto (Scanlon, 2014), dando lugar a los denominados Open Educational Resources, “materiales utilizados para apoyar la educación que pueden ser consultados, reutilizados, modificados y compartidos por cualquier persona” (Downes, 2011). Así, desde comienzos de este siglo, muchas instituciones de alto nivel, como la UNESCO o la Unión Europea, están apostando por la promoción de este tipo de recursos y por la financiación de proyectos orientados a su producción, colección, presentación, calidad, y gestión (Richter y McPherson, 2012; Richter y Veith, 2014).

La utilización de estos recursos es fundamental para apoyar unos procesos de enseñanza-aprendizaje basados en las teorías del aprendizaje de la era digital, como el constructivismo o el conectivismo. Estas teorías proponen un paradigma centrado en el protagonismo del estudiante, cada vez más autónomo, y en unos procesos más dinámicos y participativos que requieren de objetos digitales y de aplicaciones varias que fomenten la interacción entre todos los elementos que intervienen en este contexto de aprendizaje.

Ante la proliferación y heterogeneidad de este tipo de recursos se hace evidente la necesidad de conocerlos y evaluarlos, ya que un análisis detallado de los mismos permite obtener información significativa acerca de cómo utilizarlos para conseguir los objetivos pedagógicos que se pretenden en un contexto educativo determinado. Una evaluación constructiva ayuda a analizar, enriquecer y mejorar aspectos de los procesos de enseñanza-aprendizaje, pues permite obtener información sobre sus ventajas y desventajas, su potencial, sus limitaciones y sobre cómo son utilizados (Pinto, Gómez-Camarero y Fernández Ramos, 2012). Sin embargo, tanto su evaluación como su mejora no son tareas sencillas, ya que son muchos los factores que determinan su calidad y utilidad, y es necesario disponer de herramientas sencillas pero rigurosas que faciliten esta labor a profesores y a estudiantes.

Por estos motivos, se ha planteado como objetivo de este trabajo el desarrollo de una herramienta interactiva que oriente y facilite al estudiante y a cualquier usuario la evaluación y la mejora de la calidad de los recursos educativos electrónicos. No se trataría de una mera lista de criterios de evaluación, sino de una aplicación web centrada en una lista de confirmación (checklist) que valoraría los recursos, detectaría sus debilidades, sugeriría la forma de mejorarlos y aportaría ejemplos de buenas prácticas en el aspecto a mejorar.

Revisión de la literatura

La literatura científica sobre evaluación de recursos educativos electrónicos es abundante y puede categorizarse en función de la perspectiva o del enfoque desde el que ha sido planteada. Pueden distinguirse seis perspectivas principales: sistémica, heurística, centrada en el usuario, pedagógica, multidimensional y afectiva.

a) Perspectiva sistémica, que considera cada uno de los elementos como parte de un sistema que adquiere sentido gracias a su interacción y en su contexto. Dentro de esta corriente destacan Nesbit, Belfer y Vargo (2002), que proporcionan un conjunto de 8 criterios para el desarrollo efectivo de sistemas de evaluación de objetos de aprendizaje, entre los que se pueden destacar los métodos y normas de evaluación y/o los sistemas de evaluación fiables para la rentabilización económica en el intercambio de objetos de aprendizaje.

-

b) Perspectiva heurística, centrada en los resultados más que en los métodos. Esos estudios reducen la complejidad del tema centrándose en enfoques heurísticos que se basan en el modelo de usabilidad de Nielsen (1993), pero incorporando una preocupación progresiva por aspectos relacionados con la dimensión pedagógica de los recursos educativos, como en los trabajos de Quinn (1996)), Albion (1999), Squires y Preece (1996, 1999) o Preece, Rogers y Sharp (2002). En esta línea se pone de manifiesto la necesidad de realizar una evaluación integral de los recursos educativos electrónicos, combinando las nociones clásicas de usabilidad y aprendizaje: un recurso no sólo debe ser “usable” en cuanto a su diseño sino que también resulta determinante su valor pedagógico (Squires, 1999). A la “interactividad tecnológica” de los recursos educativos mencionada por Colomina, Onrubia y Rochera (2001) se van incorporando elementos de reflexión acerca de la experiencia de los usuarios, sus necesidades y expectativas, el contexto, etc., y se convierten en objeto de evaluación otros criterios que van más allá de los principios generales de usabilidad (Kukulska-Hume y Shield, 2004). Es lo que Coll, Mauri y Onrubia (2008) denominan interactividad pedagógica o instruccional, la cual está relacionada con el diseño instruccional que guía el proceso de enseñanza y aprendizaje.

Dentro de esta perspectiva se integran herramientas de evaluación como la Evaluating, Selecting, and Managing Learning Resources: A Guide (British Columbia, 2002), cuyos criterios de evaluación se refieren al contenido, el formato, la metodología, la evaluación y consideraciones de tipo social, mientras que los específicos atienden al contenido, el diseño instruccional, el diseño técnico y consideraciones de tipo social. Otra herramienta es el modelo LORI (Learning Object Review Instrument) (Nesbit, Belfer y Leacock, 2003), diseñado para evaluar objetos de aprendizaje multimedia, que tiene en cuenta la calidad de los contenidos, adecuación de los objetivos de aprendizaje, feedback y adaptabilidad, motivación, diseño y presentación, usabilidad, accesibilidad, reusabilidad, y cumplimiento de estándares.

-

c) Perspectiva centrada en el usuario, cuyas opiniones son tomadas en cuenta para el diseño de interfaces de usuario en el caso de creación de productos y servicios de información digital, tanto en los aspectos de disposición de elementos como de ejecución de tareas (Tramullas, 2004). Hay un grupo de autores que inciden en la dimensión subjetiva del usuario final, como Horila et al. (2002) o Nokelainen (2006). Este último investigador evoluciona desde una dimensión meramente pedagógica a una dimensión combinada técnico-pedagógica mediante el desarrollo de una herramienta de evaluación llamada eValuator (Nokelainen, 2004), que incluye 10 dimensiones y 56 subdimensiones y aborda aspectos como la responsabilidad del alumno ante su propio aprendizaje, la labor del docente como facilitador del aprendizaje, la utilización de fuentes de información en las actividades, los mecanismos de comunicación síncronos y asíncronas presentes para facilitar el trabajo en grupo o el aprendizaje basado en problemas y adaptado a posibles situaciones de la vida real.

Otra herramienta con enfoque hacia la calidad basada en la perspectiva del usuario es SREB-SCORE (Sharable Content Object Repositories for Education) (SREB, 2007), que utiliza como criterios de calidad y efectividad la calidad del contenido, la alineación con los objetivos de aprendizaje, el feedback, la motivación, el diseño de la presentación, la usabilidad de la interfaz, la accesibilidad, la reusabilidad, la conformidad con los estándares y especificaciones y la propiedad intelectual y derechos de autor.

Por su parte, HEODAR (Morales Morgado, Gómez Aguilar y García Penalvo, 2008) toma como referente el instrumento LORI y extiende sus criterios para evaluar aspectos psicopedagógicos relativos al usuario, como la capacidad de motivación, la creatividad, la adecuación a los destinatarios, la interactividad y los elementos didácticos relacionados con el ámbito curricular.

d) Perspectiva pedagógica, que tiene en cuenta las posibilidades educativas de los recursos educativos electrónicos. Autores como Laurillard (2002) adoptan una postura pedagógica funcional, apartándose de los enfoques anteriores, puesto que insisten en que el recurso educativo debe conseguir que el usuario se centre en la tarea propuesta para lograr los objetivos pedagógicos e intentar que el diseño de la interfaz sea casi irrelevante para que no produzca ninguna interrupción en la actividad de aprendizaje del profesor y del alumno. Su modelo de evaluación se centra en tres aspectos: interfaz de usuario, diseño de actividades y objetivos de aprendizaje. En esta línea se incluye la guía LiVtraining (Livingston Institute of Vocational Training, 2010), que presenta únicamente dos criterios: el diseño instruccional y el contenido, y la propuesta de El Mhouti, Nasseh y Erradi (2013), que contempla el análisis de la calidad académica, pedagógica, didáctica y técnica.

e) Perspectiva multidimensional, que parte del enfoque de que la calidad es un concepto relativo, subjetivo e impregnado de valores en función de diferentes variables en las que cobran gran importancia los valores personales. En esta línea existen trabajos que apuestan por una propuesta multidimensional que gira en torno a cuatro elementos: profesor- estudiante- tarea- tecnología (Olive et al., 2010) y proponen la introducción del elemento de la tecnología en el tradicional triángulo didáctico para redefinir un nuevo espacio para la creación de conocimiento.

f) Perspectiva afectiva, que incorpora la dimensión emocional y centra la atención en el impacto que los estados afectivos y emocionales tienen en los procesos de enseñanza-aprendizaje. Se basa en las teorías que afirman el papel crucial que las emociones desempeñan en el éxito o fracaso de los procesos educativos (Picard et al., 2004). En el aprendizaje afectivo, la motivación, la emoción, el interés, la atención y la curiosidad son funciones íntimamente unidas a las funciones cognitivas. Según Zaharias y Poylymenakou (2009), el afecto es el combustible que los estudiantes aportan al entorno de aprendizaje conectándolos al “porqué” del aprender y la “motivación para aprender” es el factor de aprendizaje afectivo que más puede influenciar la interacción de los usuarios con la aplicación e-learning. Este autor desarrolla un cuestionario de evaluación en el que combina los clásicos criterios de usabilidad y los derivados del diseño instruccional, proponiendo además la “motivación para aprender” como una nueva medida de usabilidad para el diseño de e-learning. Se trata de una perspectiva en auge que han seguido otros autores como Lera, Fernández y Almirall (2009) o Keller (2010).

Metodología

Para cumplir con los objetivos propuestos se planificó el desarrollo de un portal web cuya parte nuclear fuese una aplicación basada en un checklist, que sirviera para evaluar recursos electrónicos educativos y que proporcionase el usuario un informe acerca de su calidad y de cómo mejorarla. Además, el portal debería incluir un repositorio de recursos evaluados y una sección de bibliografía sobre evaluación de recursos electrónicos educativos.

Checklist

La metodología empleada para desarrollar el checklist Evaluareed parte de un enfoque cualitativo-cuantitativo para llegar a la definición de un conjunto de criterios e indicadores ponderados. El primer paso para su elaboración fue revisar la literatura especializada, que proporcionó un sólido apoyo teórico sobre perspectivas de evaluación de la calidad de los recursos educativos electrónicos, y el análisis de otras herramientas similares para conocer las dimensiones y criterios de calidad más recurrentes. Para ello se realizó una búsqueda bibliográfica en las bases de datos LISA, SCOPUS, WOS y Google Académico sobre indicadores y criterios de evaluación, tanto de sitios web en general como de recursos electrónicos educativos. Se realizó un análisis de contenido de los documentos recuperados y se obtuvo una amplia batería de dimensiones, criterios e indicadores de evaluación que sirvió como base para determinar los que finalmente se incluirían en Evaluareed. Puesto que se pretendía diseñar un cuestionario no demasiado extenso ni demasiado complicado, se hizo un esfuerzo de síntesis y selección para que el checklist fuera operativo y al mismo tiempo contemplara los principales aspectos que deben tenerse en cuenta para evaluar un recurso electrónico educativo. Hubo que considerar que diferentes autores se refieren al mismo concepto de formas distintas y que hay variaciones al agrupar indicadores en dimensiones.

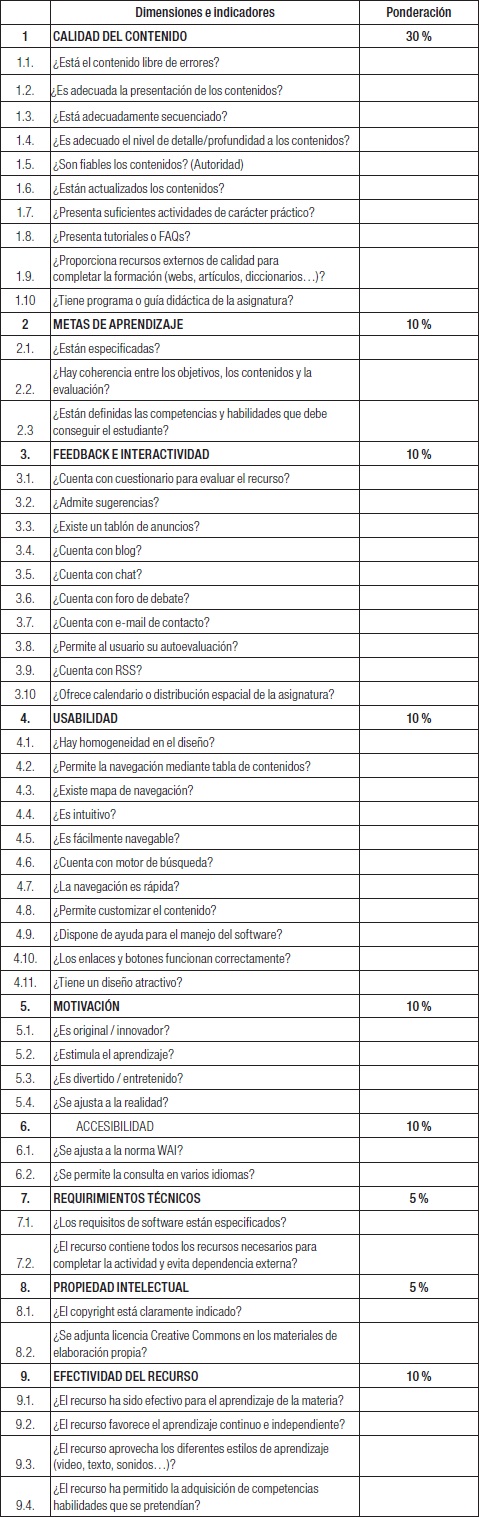

Se establecieron 9 dimensiones que eran recurrentes en la literatura científica y que fueron consensuadas por los autores con base en su utilidad e importancia. Posteriormente se sometieron a consideración los distintos indicadores que se habían recogido en la revisión de la literatura y se extrajo un conjunto de ellos no demasiado prolijo, que permitiese valorar cada dimensión de la forma más objetiva posible. Este primer borrador del checklist, que contaba con 44 indicadores, fue probado en un conjunto de 20 recursos con el objeto de determinar su eficiencia en sus diferentes contextos y condiciones de uso y determinar si los indicadores se ajustaban a los objetivos del checklist. Con base en los resultados de la prueba se decidió modificar el listado de indicadores, quitando algunos que no resultaban operativos y añadiendo otros que consideramos relevantes. El checklist final está compuesto por 9 dimensiones y 48 indicadores.

Puesto que el número de indicadores variaba de unas dimensiones a otras y que puede ser muy útil asignar un peso específico a cada una de ellas si se considera que no todas son igual de relevantes (Barnes y Vidgen, 2002), lo que suele suceder en la mayoría de las ocasiones en que se lleva a cabo un proceso de evaluación, se decidió ponderar cada una de las dimensiones. Para esta labor se llevó a cabo una consulta a un grupo de expertos en la materia que ya habían colaborado con nosotros en labores similares, en la que se les pedía que opinasen sobre qué porcentaje de la puntuación total debía corresponder a cada dimensión. Con las opiniones recabadas y el consenso entre los autores de este trabajo se estableció la ponderación definitiva (Anexo I).

Generador de informes

Para que la aplicación web pudiese generar de forma automática un informe de evaluación a partir de la cumplimentación del checklist se tuvieron en cuenta las posibles puntuaciones en cada uno de los indicadores y se creó una batería de respuestas con consejos y bibliografía para, en su caso, mejorar cada uno de los indicadores. La aplicación contabiliza la puntuación de cada recurso, tanto a nivel global como a nivel de dimensión y de indicador, y genera un informe en PDF con toda la información.

Repositorio de recursos evaluados y bibliografía sobre el tema

Para poder crear una sección de recursos educativos electrónicos que sirviera de ejemplo de buenas prácticas, se tomó una muestra de ellos (OCW de universidades españolas en el ámbito de ciencias sociales y humanidades) y se evaluaron utilizando el checklist Evaluareed. Aquellos con mejor puntuación fueron incluidos en el portal, organizados por áreas temáticas.

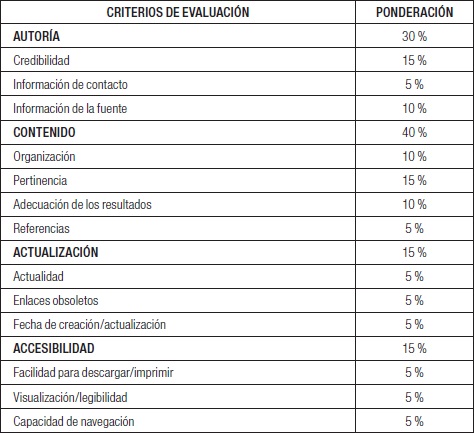

Para poder facilitar al usuario del portal Evaluareed la localización de recursos de información sobre evaluación de recursos electrónicos educativos se creó una sección con una selección bibliográfica y de páginas web de calidad. Esta selección se hizo en función de la evaluación de dichos recursos de acuerdo a los criterios y subcriterios expuestos en la Tabla 1.

Se aceptaron como recursos de calidad y pertinentes sólo aquéllos cuya valoración numérica global superase el 40 %, clasificándose en una escala de tres a cuatro estrellas.

Resultados

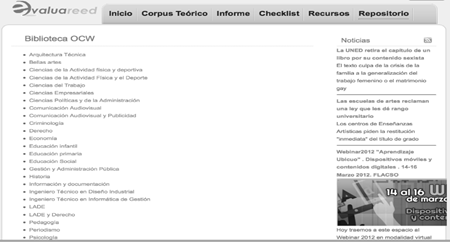

El resultado final del proyecto ha sido un portal web (http://www.evaluareed.edu.es) centrado en la evaluación de recursos electrónicos educativos desde el que se tiene acceso al checklist Evaluareed, núcleo del portal, y a una serie de secciones auxiliares que lo complementan y que sirven para profundizar en el tema (corpus teórico, informe detallado del proyecto, recursos evaluados y bibliografía), diseñado de forma que permite un acceso sencillo e intuitivo a los contenidos, especialmente al uso del checklist y de los informes de evaluación. Desde su lanzamiento piloto en 2011 el portal ha sido actualizado con regularidad, siendo la última versión de principios de 2015.

Checklist

El checklist está conformado por 9 dimensiones de calidad (calidad del contenido; objetivos y metas de aprendizaje; feedback; usabilidad; motivación; accesibilidad; requerimientos técnicos; propiedad intelectual, y efectividad del recurso desde el punto de vista del aprendizaje), subdivididas en 48 indicadores, que atienden a diversos elementos considerados idóneos para un recurso educativo de calidad. Estos indicadores, que son las condiciones que han de cumplir para conseguir una puntuación positiva, son valorados en unos casos según una escala de medición que va del 0 al 4 y en otros mediante la opción lógica sí/no. (Anexo I)

Los indicadores empleados son de dos tipos: estimados por expertos humanos y programados por una sonda automática, prestándose especial atención a la relación entre ambos y a su complementariedad de cara a permitir una evaluación asistida por ordenador lo más objetiva posible, aunque sin prescindir del juicio humano en aquellos aspectos en que éste sea necesario. La valoración de los recursos es tanto objetiva (aspectos tangibles como la autoría, actualización, datos de identificación…) como subjetiva, basada en las impresiones de los usuarios y codificadas según la escala correspondiente (motivación, efectividad, satisfacción o estética). Para ayudar en el proceso de evaluación, el checklist cuenta con una explicación de cada dimensión, así como instrucciones sobre como valorar los indicadores.

Calidad del contenido

El contenido es uno de los criterios a los que necesariamente debe prestarse atención cuando se evalúa la calidad de cualquier recurso web en general (Codina, 2000) y de un recurso educativo en particular (Bottentuit Junior y Coutinho, 2008). En esta dimensión se contemplan indicadores como la ausencia de errores gramaticales, la adecuación de la presentación de los contenidos para contextualizarlos en forma de un sumario, un resumen y unas palabras clave. Otras cuestiones que se miden también en este bloque son la actualización del contenido, su fiabilidad en cuanto a que proceden de una fuente reconocida (Blummer y Kritskaya, 2009; Toll y Ril, 2013) y la adecuación en su secuenciación, es decir, la expresión de las competencias y los objetivos, seguidos de los correspondientes contenidos teóricos y actividades prácticas (SREB, 2007; Squires y Preece, 1996), de manera que el estudiante pueda progresar en sus conocimientos de forma gradual (Krauss y Ally, 2005). Se valora igualmente la adecuación en el nivel de detalle o la exactitud y la presentación equilibrada de ideas, así como la presencia de suficientes actividades de carácter práctico (SREB, 2007) o de recursos de información externos para completar la formación. Por último, se considera positiva la existencia de alguna guía didáctica o material similar, como tutoriales o sección de preguntas frecuentes, que ayuden al alumno en su proceso de aprendizaje y le permitan conocer todas las posibilidades que ofrece el recurso educativo (Krauss y Ally, 2005).

Objetivos y metas de aprendizaje

En esta dimensión se pretende medir el valor pedagógico del recurso educativo en cuanto a la coherencia entre los objetivos expresados, los contenidos y la evaluación, adaptados a la materia en cuestión y adecuados al perfil del alumnado (SREB, 2007; Blummer y Kritskaya, 2009; Quinn, 1996). Se valora la explicitación de los objetivos y de las competencias que deben ser adquiridas, puesto que establece una medida concreta para que el usuario pueda evaluar si ha conseguido o no los resultados (Krauss y Ally, 2005; Toll y Ril, 2013; Blummer y Kritskaya, 2009; Reeves, 1997).

Feedback

En esta dimensión se mide el potencial del recurso educativo para interactuar con el estudiante a lo largo de su proceso de aprendizaje, a través de la presencia de elementos que permiten la intercomunicación con el profesor o con el resto de los estudiantes. Se valora la existencia de herramientas de comunicación sincrónicas y asincrónicas (Wang y Chen, 2009), como blogs, chats, tablón de anuncios, foros, email de contacto o buzón de sugerencias (SREB, 2007; Blummer y Kritskaya, 2009; Oliver, 2005), así como la presencia de un cuestionario para evaluar la percepción del usuario respecto al objeto de aprendizaje (Brodahl y Smestad, 2009) y cuestionarios de autoevaluación que permitan evaluar de forma autónoma e individual los resultados del aprendizaje (Toll y Ril, 2013).

Usabilidad

La usabilidad es un concepto amplio que mide el grado de eficiencia, eficacia y satisfacción que experimenta un usuario al interactuar con un objeto de aprendizaje para alcanzar sus objetivos (International Standards Organization, 1998). Su importancia es enorme ya que “optimizar la usabilidad de los materiales de e-learning es necesario para reducir la carga cognitiva y maximizar su potencial educativo” (Davids, Chikte y Halperin, 2014: 155). Se evalúa la homogeneidad en el estilo, que atiende aspectos como colores, tamaños y tipos de letra, un diseño atractivo y apropiado para los estudiantes, así como una presentación cuidada. Se mide también la facilidad de navegación entre los contenidos, que estos cuenten con una estructura ordenada y organizada, con acciones y opciones claras y consistentes que eviten la sensación de desorientación al usuario y le ayuden en el aprendizaje (Benson et al., 2002; Marzal, Calzada-Prado y Viannello, 2008; Ho et al., 2009). La navegación debe ser rápida, lo cual quiere decir que tanto el funcionamiento del recurso como la descarga de elementos debe ser eficaz e intuitiva (Nielsen, 1993; Shneiderman, 1998), tanto desde el punto de vista del diseño de la interfaz como en términos de diseño instruccional o pedagógico. Por otro lado, la posibilidad de buscar contenidos es valorada positivamente, por ello se evalúa la presencia de un motor de búsqueda (Ho et al., 2009) así como la personalización del contenido, entendiendo como tal la flexibilidad del recurso para adaptarse en función del estudiante según perfiles de uso, secuenciación de elementos, ritmos y estilos de aprendizaje (Marzal, Calzada-Prado y Viannello, 2008). La presencia de manuales o guías para el manejo del software cuando sea necesario es otro de los elementos para analizar en un recurso de aprendizaje (Benson et al., 2002). Esta documentación debe ser clara, correcta y precisa.

Motivación

Esta dimensión está relacionada con la capacidad del recurso educativo para motivar y generar interés en el alumno con el fin de conseguir los objetivos de aprendizaje propuestos (Toll y Ril, 2013; Horila et al., 2002; Reeves, 1997; Oliver, 2005). En este sentido, Evaluareed contempla la originalidad o el carácter innovador del objeto, su adecuación a la realidad para estimular el aprendizaje del alumno, a través de actividades motivadoras, entretenidas e interesantes para el usuario.

Accesibilidad

La accesibilidad se refiere a la adaptación y flexibilidad del recurso a las características especiales de estudiantes, independientemente de sus conocimientos o capacidades personales y de las características técnicas del equipo utilizado para acceder a la web. Por ello se valora que el objeto de aprendizaje sea conforme a las recomendaciones especificadas por la WAI (SREB, 2007; Nesbit, Belfer y Leacock, 2003) y que esté disponible en varios idiomas, con el fin de llegar a más estudiantes y aumentar la visibilidad del recurso a nivel internacional.

Requerimientos técnicos

Los requerimientos técnicos se refieren a las particulares características del software que pudiera utilizar el recurso de aprendizaje. Se valora si éstos están claramente especificados y si cuenta con todos los recursos necesarios para su uso, evitando que el estudiante se disperse buscando en otros lugares externos al recurso (SREB, 2007; Nesbit, Belfer y Leacock, 2003).

Propiedad intelectual

Esta dimensión pretende hacer tomar conciencia a los usuarios de los recursos de aprendizaje de la importancia de los derechos de autor y de la propiedad intelectual, por lo tanto se tiene en cuenta la indicación explícita del copyright o de algún tipo de derechos más flexibles como las licencias Creative Commons (SREB, 2007).

Efectividad del recurso

Esta dimensión complementa los datos obtenidos acerca del potencial pedagógico del recurso educativo. Se pretende obtener un marco de medición sobre la eficacia del mismo para el aprendizaje de la materia y la adquisición de competencias y habilidades previamente señaladas en los objetivos pedagógicos (Oliver, 2005). Igualmente, se evalúa la capacidad de aprendizaje continuo y autónomo del usuario (Quinn, 1996), y si aborda los diferentes estilos de aprendizaje (visual, auditivo, kinestésico, activo, reflexivo, pragmático y teórico).

Informes de evaluación

Una vez completado el checklist con los datos de un recurso educativo electrónico, Evaluareed genera automáticamente un detallado informe que contiene:

Una valoración global sobre la calidad del recurso con base en la puntuación obtenida, que puede ser excelente, bueno, mejorable o muy mejorable.

Una valoración de cada dimensión, en la que además se ofrecen recomendaciones y pautas de mejora en aquellos aspectos o indicadores que lo requieran, así como bibliografía y recursos sobre cómo mejorar un indicador en concreto.

Repositorio de recursos evaluados y bibliografía sobre el tema

Evaluareed cuenta con una sección de recursos educativos electrónicos que han sido evaluados con el checklist diseñado en este trabajo. En un principio se incluyeron únicamente los OCW de las titulaciones de Ciencias Sociales y Jurídicas de las universidades españolas, es decir, aquellos materiales educativos en formato digital de acceso abierto y gratuito que los profesores ofrecen en los repositorios universitarios para su uso y re-uso en la enseñanza, el aprendizaje y la investigación (Unesco, 2002). Posteriormente se incluyeron otras disciplinas, hasta un total de 31. El acceso a los recursos es temático y cada uno cuenta con una ficha descriptiva que incluye el título del recurso, autor, universidad, facultad, año y una valoración de su calidad.

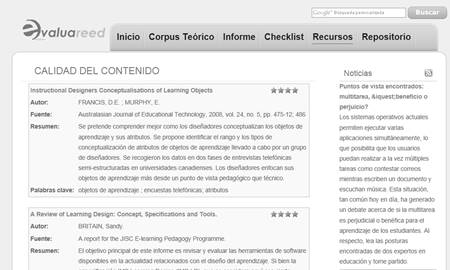

La sección “Recursos” permite el acceso a un conjunto de fichas descriptivas de recursos bibliográficos relacionados con la evaluación de recursos educativos. Cada ficha contiene información del título, autor, fuente, resumen y palabras clave, así como una valoración de su calidad en forma de estrellas, que se corresponde con la puntuación obtenida según se explicó en el apartado “Repositorio de recursos evaluados y bibliografía sobre el tema”. Las fichas están organizadas en 10 categorías temáticas: una sobre la evaluación de recursos educativos en general y otras 9 sobre cada una de las dimensiones del checklist.

Conclusiones

La importancia que están cobrando los recursos electrónicos en el ámbito de la educación y especialmente en la educación superior es cada vez mayor debido al uso masivo de las tecnologías de la información en las instituciones educativas, al auge de la enseñanza a distancia y al cambio de paradigma educativo, en el que el alumno cada vez es más autónomo. Puesto que van a jugar un papel importante en los procesos de enseñanza, es necesario que estos recursos tengan la máxima calidad para que puedan cumplir adecuadamente con los objetivos para los que fueron creados. Esto supone la necesidad de su evaluación y, por tanto, de contar con técnicas y herramientas que ayuden a determinar su valor y utilidad y a mejorar dichos recursos. Este proceso no sólo afecta a los docentes, que deben seleccionar recursos apropiados o crearlos, sino que también es importante para los alumnos, que deben ser capaces de elegir las mejores fuentes de información en sus procesos de aprendizaje, y para los bibliotecarios, que deben proporcionar a sus usuarios los recursos que necesitan y cuya experiencia y competencia en evaluación de recursos informativos les permite apoyar a ambos en la selección y evaluación de recursos educativos electrónicos.

Con la herramienta desarrollada se pretende contribuir a la mejora de este tipo de recursos y a fomentar la cultura de la evaluación y la calidad en este ámbito. Creemos que se trata de una iniciativa pionera al aglutinar en un mismo portal web una herramienta de evaluación de recursos educativos electrónicos (el checklist), una ayuda para mejorarlos (generador de informes), una guía de buenas prácticas (repositorio) y una base de datos de recursos web y bibliografía relevante (recursos y bibliografía). Su facilidad de uso y sus distintas prestaciones hacen que sea una herramienta muy adecuada tanto para alumnos como para profesores y bibliotecarios en el ámbito hispanohablante.

nueva página del texto (beta)

nueva página del texto (beta)