Introducción

El instrumento creado por Raúl Cremades1 para el análisis y evaluación de webs de bibliotecas escolares, consiste en un sistema de categorización jerárquica basado en los conceptos de parámetros e indicadores propuestos por Codina (2000: 35), el cual define los primeros como propiedades o características de los recursos digitales objeto de evaluación, y los segundos como los aspectos o elementos que se tienen en cuenta para evaluar la calidad de un indicador. Los elementos categoriales del citado instrumento están basados tanto en las propuestas de expertos en evaluación de webs (Bazin, 1999; Codina; 2000; Romagnoli et al., 2001; Merlo, 2003; Martín, 2005; Ayuso y Martínez; 2006; Jiménez-Piano y Ortiz, 2007) como en las consideraciones específicas de especialistas en webs de bibliotecas escolares (Murphy, 2003; Camacho, 2004; Luque, 2007).

El presente trabajo se centra en la exposición de la metodología seguida y los resultados obtenidos tras someter la propuesta inicial del autor del instrumento (denominada instrumento piloto) a un proceso de validación a través de un acuerdo interjueces. Se presentan, por tanto, las modificaciones experimentadas por la propuesta inicial con motivo de la valoración y opiniones vertidas por los jueces, que han dado lugar al resultado final (denominado instrumento definitivo), y se exponen las conclusiones obtenidas tras la ejecución del proceso.

Metodología

Como afirman Julio Cabero y Felicidad Loscertales (1996), una de las formas de asegurar la fiabilidad de un sistema categorial es la consulta con expertos para comprobar el grado de acuerdo en su interpretación de ese sistema. Entre las técnicas de consulta a expertos se encuentra la del acuerdo interjueces (Dubé, 2008: 75-80), que consiste en establecer el grado de acuerdo entre varias personas de solvencia garantizada acerca de una serie de criterios científicos determinados.

El objetivo esencial de nuestra investigación es transformar el instrumento piloto para mejorarlo a través de las opiniones, valoraciones y sugerencias que alcancen el consenso necesario al llevar a cabo el método del acuerdo interjueces. Pero debemos tener en cuenta, como punto de partida, que el instrumento ha sido creado para utilizarse mediante el análisis de contenido, definido por Bernard Berelson (1952) como “una técnica de investigación para la descripción objetiva, sistemática y cuantitativa del contenido manifiesto de la comunicación”. A la luz de esta definición, Javier Álvarez Galvez (2012: 130-150) resalta la importancia de garantizar la reproductividad y la validez de los resultados estableciendo una serie de reglas predefinidas por el investigador. Estos mismos principios son los que incluye Krippendorff en su definición del análisis de contenido: “una técnica de investigación para la realización de inferencias replicables y válidas a partir de textos (u otros contenidos significativos) en relación con su contexto de uso” (2004: 18).

Los pasos que deben seguirse en el análisis de contenido han sido sintetizados por Jaime Andréu Abela (2001: 11) en estas cinco acciones: 1. determinar el objeto o tema de análisis; 2. establecer las reglas de codificación; 3. especificar el sistema de categorías; 4. comprobar la fiabilidad del sistema de codificación-categorización; 5. realizar inferencias. Una de las maneras sugeridas por Andréu para comprobar la fiabilidad del sistema de codificación-categorización (en nuestro caso, concretado en el instrumento piloto) es la valoración de los codificadores (en este caso, los jueces o expertos):

La fiabilidad se expresa como una función del acuerdo alcanzado entre los codificadores sobre la asignación de las unidades a las diversas categorías. Si dicho acuerdo es total para todas las unidades, está garantizada la fiabilidad, por el contrario si no es mayor que el correspondiente al azar, la fiabilidad es nula (Abela, 2001: 19).

La metodología que sigue nuestra investigación incluye la codificación manual, es decir, el uso de codificadores humanos que aporten su valoración personal de los textos, según una serie de reglas o criterios comunes. Pero, como afirma Álvarez Gálvez (2012: 136), no todo el mundo es válido para codificar. Los prerrequisitos esenciales de los codificadores son dos: familiaridad hacia la información tratada y entrenamiento en el sistema de codificación (Krippendorff, 2004). Asimismo, es muy recomendable que todos los miembros del grupo de codificadores tengan unos niveles culturales, educativos y profesionales similares (Peter y Lauf, 2002: 815-832), ya que una parte esencial de su tarea se basará en la comprensión e interpretación de los datos textuales sometidos a acuerdo.

El análisis de las coincidencias y discrepancias es la base de la metodología del acuerdo interjueces (Muñoz, Montoro y Luque, 2006: 519-537), pero debemos tratar de reducir al máximo el inevitable sesgo personal proporcionándoles una serie de criterios claros y estables. Cuanto mayor es el número de jueces, más importante será el rigor de esos criterios que, en nuestro caso, han sido fijados a través de un cuestionario y sus correspondientes instrucciones. El cuestionario ha sido estructurado en tres partes: la primera consiste en una valoración mediante opciones múltiples de cada uno de los ítems del instrumento piloto; la segunda es una pregunta abierta sobre posibles ítems no incluidos; y la tercera es otra pregunta abierta sobre posibles comentarios generales respecto al instrumento piloto.

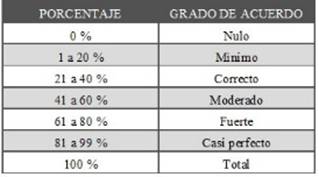

Por último, una vez fijados los criterios, se deben establecer los límites de aceptabilidad de los acuerdos. Como afirman U. N. Umesh, Robert A. Peterson y Mattehew H. Sauber (1989: 835), decidir si un determinado valor del porcentaje de acuerdo es suficiente o insuficiente no resulta fácil en la práctica. Para nuestra investigación se ha decidido acudir a la interpretación de J. Richard Landis y Garay G. Koch (1977: 159-174) y adaptar sus valoraciones sobre lo que debe considerarse “acuerdo moderado” y “acuerdo sólido”, como se verá más abajo en la Tabla 2, teniendo en cuenta tanto los objetivos del instrumento piloto como el número de jueces participantes.

Instrumento piloto

Diseñado para ser usado con la técnica del análisis de contenido y con la regla de recuento de la presencia de los elementos definidos en sus categorías (Andréu Abela, cit. en Landis y Koch, 1977: 11-19), el instrumento piloto para el análisis y evaluación de webs de bibliotecas escolares estaba compuesto por los sesenta y ocho ítems (dos parámetros, doce indicadores y cincuenta y cuatro subindicadores) que se exponen en la Tabla 1.

La fundamentación teórica de los parámetros, indicadores y subindicadores que componen el instrumento piloto ha sido publicada previamente por el autor, tanto para los contenidos (Cremades, 2013) como para los aspectos formales y organizativos de las webs (Cremades, 2015).

Validación del instrumento: acuerdo interjueces

Para llevar a cabo la validación de nuestro instrumento piloto se recabó el juicio de nueve personas (ocho españolas y una chilena) expertas en bibliotecas escolares y evaluación de webs educativas, seleccionadas por su experiencia personal y sus publicaciones científicas en la materia. Se consideró pertinente el número de jueces seleccionados siguiendo el criterio de Klaus Krippendorf (2004), que considera un número mínimo de dos personas con una demostrada independencia entre ellos y respecto a cualquier institución.

Los nueve jueces fueron María Isabel Borda, jueza uno (profesora del Departamento de Didáctica de la Lengua y la Literatura de la Universidad de Málaga); Ana Castillo, jueza dos (profesora del Departamento de Información y Comunicación de la Universidad de Extremadura); Luis Miguel Cencerra.do, juez tres (coordinador del Centro de Documentación e Investigación de Literatura Infantil y Juvenil de la Fundación Germán Sánchez Ruipérez en Salamanca); Jaume Centelles, juez cuatro (maestro y bibliotecario escolar del ceip Sant Josep-El Pi de L’Hospitalet, Barcelona); Glòria Durban, jueza cinco (responsable de la biblioteca de la Escuela Técnica Profesional del Clot, Barcelona); José García Guerrero, juez seis (responsable del apoyo y desarrollo de las bibliotecas escolares en la Delegación de Educación de Málaga de la Junta de Andalucía); Pere Marquès, juez siete (profesor titular de Tecnología Educativa del Departamento de Pedagogía Aplicada de la Universidad Autónoma de Barcelona); Constanza Mekis, jueza ocho (coordinadora nacional de Bibliotecas Escolares/CRA, Enseñanza Básica y Media del Ministerio de Educación de Chile); y María Dolores Moreno, jueza nueve (maestra y responsable de la biblioteca escolar del cp José María de Calatrava, Mérida, Badajoz).

Los cinco criterios que se siguieron para la selección de estos especialistas fueron:

Independencia. Ninguna de las nueve personas elegidas para valorar el instrumento piloto está sometida a ningún tipo de presión o sesgo institucional ni mantiene relación de dependencia con el resto.

Solvencia profesional. Todos los jueces son personas dedicadas profesionalmente al mundo de la docencia, investigación o gestión, relacionadas con las bibliotecas escolares y con la evaluación de webs educativas. Todos cuentan con gran experiencia en su desempeño profesional.

Actividad investigadora. Todos los jueces seleccionados han realizado algún tipo de investigación educativa y han publicado los frutos de ésta. Por tanto, se trata de personas familiarizadas con el discurso académico y los métodos de investigación aplicada a la educación.

Diversidad geográfica. De los nueve jueces, ocho son españoles y una chilena. Los jueces españoles provienen de cuatro comunidades autónomas diferentes y de seis ciudades distintas.

Nivel de responsabilidad. Tres de los nueve jueces son docentes universitarios; otros tres son responsables de bibliotecas escolares; otros dos son coordinadores de organismos públicos relacionados directamente con las bibliotecas escolares; y uno es responsable de un centro de documentación privado también relacionado con las bibliotecas escolares.

A estas nueve personas se les entregó el instrumento piloto junto con un texto explicativo de la investigación, y se les pidió que tuvieran en cuenta la imposibilidad de un consenso total acerca de los ítems necesarios para analizar y evaluar cualquier tipo de web. Se les indicó que la lista propuesta de 68 ítems (dos parámetros, doce indicadores y 54 subindicadores) era discutible y ampliable, por ello, además de su valoración, se les ofrecía la posibilidad de que sugirieran algún ítem que consideraran imprescindible y que no estuviera incluido en el instrumento piloto. Para ello se les pidió que respondieran a estas tres cuestiones:

Valora cada uno de los parámetros, indicadores y subindicadores de uno a tres según tu criterio sobre su validez para el análisis y evaluación de la calidad de webs de bibliotecas escolares. 1. Poco importante; 2. importante; 3. muy importante.

¿Consideras que existen otros parámetros, indicadores o subindicadores esenciales que no están incluidos?

¿Quieres añadir algún comentario general sobre este instrumento para el análisis y evaluación de la calidad de webs de bibliotecas escolares?

Resultados del acuerdo

Una vez recibidas las respuestas de los nueve jueces, se calculó el grado de acuerdo mediante porcentajes según las puntuaciones otorgadas por cada persona a cada una de las tres posibilidades, ya que según Francisco Muñoz Leiva et al. (2006), la marca más usada en esta técnica es la medición de la proporción de los acuerdos. También se halló la puntuación media sobre tres de cada uno de los parámetros, indicadores y subindicadores para contar con una visión de conjunto sobre la valoración de cada ítem.

Para establecer el grado conceptual de acuerdo partiendo de cada porcentaje se adaptó a las características del instrumento piloto la interpretación ofrecida por J. Éric Dubé (2008) de la estadística kappa (k) de Cohen, según Landis y Koch (1977), como se indica en la Tabla 2.

Los resultados numéricos del acuerdo interjueces sobre cada uno de los ítems del instrumento piloto se presentan a continuación en las Tablas 3 y 4, una para cada parámetro. Se aporta la puntuación que otorga cada uno de los jueces (J. 1, J. 2, J. 3, etc.) a cada uno de los parámetros, indicadores y subindicadores, así como la puntuación media y el porcentaje de acuerdo sobre cada uno de los tres valores posibles (PI: poco importante; I: importante; MI: muy importante).

Modificación del instrumento piloto

Tras la valoración numérica emitida por los nueve jueces se suprimieron los subindicadores 1.2.5, 1.3.3, 1.3.6, y 2.3.1, debido a que concitaban más del 50% de grado de acuerdo para la valoración de poco importante.

De las respuestas a las cuestiones b) y c) de los jueces se pudieron inferir las siguientes consideraciones respecto a los ítems del instrumento piloto:

La experta Constanza Mekis (jueza ocho) opina que el indicador 1.2 podría incluir un subindicador referido a las estadísticas de uso. No se incluyó esta modificación al considerar que las estadísticas de uso pueden ser una herramienta útil para la persona encargada de gestionar la web de biblioteca escolar, pero no para los usuarios de la web.

En relación al indicador 1.3, la profesora Ana Castillo (jueza dos) opi.na que no resulta tan esencial que la web disponga de un blog, una wiki o un servicio de podcasting, como el uso que se haga de los mismos. Para ella, una página web sin ninguno de estos recursos y simplemente con un chat o cualquier herramienta que aporte interactividad (pero bien gestionada) puede ser más participativa que un blog. En definitiva, Castillo apoya firmemente la inclusión de este indicador sobre la interactividad y las herramientas 2.0.

La profesora Mekis (jueza ocho) opina que el indicador 2.6 podría incluir un subindicador sobre la comprensión digital y las habilidades de información. Sin embargo, no se incluyó esta modificación porque las competencias relacionadas con la comprensión digital y las habilidades de información ya están presentes en cada uno de los parámetros, indicadores y subindicadores del instrumento piloto.

Las profesoras María Isabel Borda (jueza uno) y Mekis (jueza ocho) coinciden en sugerir que los subindicadores incluidos en el indicador 2.7 deben ser cambiados para dejar más clara la distinción entre los materiales relacionados con lengua y literatura y los que se agrupan bajo la expresión “de temática general”. Sí se tuvo en cuenta esta aportación para modificar el texto de todos los subindicadores del indicador 2.7, según se detalla más adelante.

Además, debido a la opinión expresada por los jueces en sus respuestas a las cuestiones b) y c), se modificaron los siguientes ítems del instrumento piloto:

La profesora Castillo (jueza dos) sugiere que la redacción del subindicador 1.4.5 puede dar lugar a confusión, por tanto se procedió a enunciarlo en sentido positivo de este modo: Todos los enlaces funcionan bien.

A sugerencia de la profesora M. Dolores Moreno (jueza nueve), se modificó el contenido del subindicador 2.4.1 para expresar que las reseñas o críticas, novedades bibliográficas o noticias del sector se pueden ofrecer también sin el formato de un boletín propio de la biblioteca escolar. La nueva redacción quedó así: Se ofrece información sobre novedades bibliográficas, noticias del sector editorial o boletín de la biblioteca escolar en papel o en formato digital.

Por las sugerencias de las profesoras Borda (jueza uno) y Mekis (jueza dos) en referencia al indicador 2.7, se modificó la redacción de los subindicadores 2.7.1, 2.7.2 y 2.7.3 de este modo: Se ofrecen [textos, audios, videos] no orientados específicamente a la educación lingüística o literaria. Por las mismas sugerencias se modificó la redacción de los subindicadores 2.7.4, 2.7.5 y 2.7.6 de este modo: Se ofrecen [textos, audios, videos] orientados específicamente a la educación lingüística o literaria.

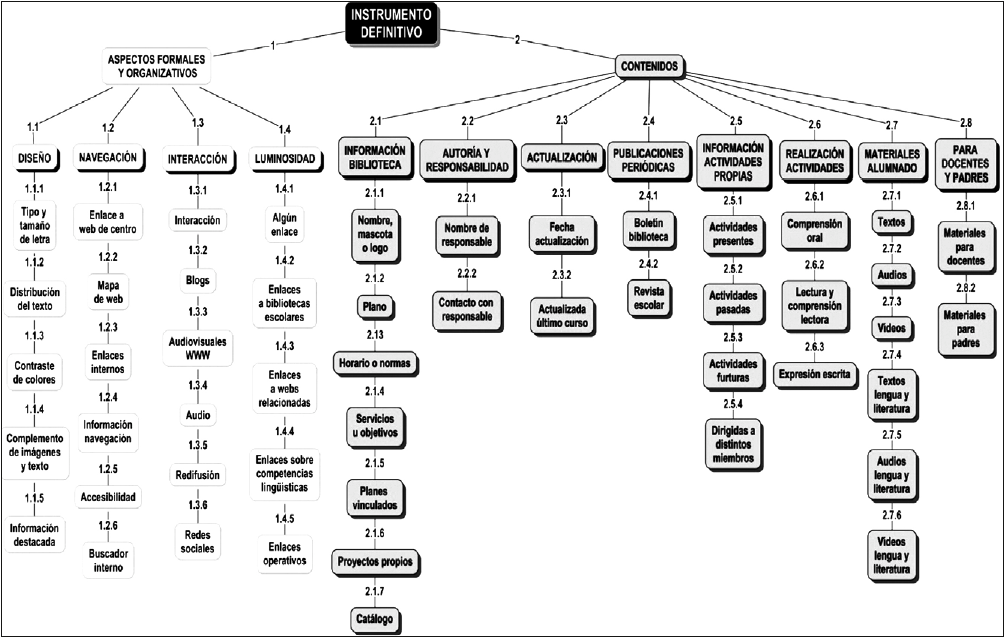

Instrumento definitivo

Una vez suprimidos los cuatro subindicadores citados e introducidas las modificaciones textuales recogidas en el apartado anterior, quedó establecido el instrumento definitivo para el análisis y evaluación de webs de bibliotecas escolares validado mediante acuerdo interjueces. Este instrumento cuenta con un total de 64 ítems (dos parámetros, doce indicadores y cincuenta y cuatro subindicadores) cuya presencia en la web debe ser consignada por la persona que realice el análisis y evaluación a través de la técnica del análisis de contenido. El texto completo del instrumento definitivo es el siguiente:

Parámetro 1: Aspectos formales y organizativos

Indicador 1.1: Diseño de la web

Subindicadores:

1.1.1 Tipo y tamaño adecuado de letra para facilitar la lectura.

1.1.2. Distribución espacial del texto adecuada para facilitar la lectura.

1.1.3. Contraste adecuado de colores para facilitar la lectura.

1.1.4. Las imágenes y los textos se complementan de forma adecuada para un eficaz acceso a la información.

1.1.5. Se destaca de algún modo la información más reciente o más importante.

Indicador 1.2: Navegación por la web

Subindicadores:

1.2.1. Existe enlace directo desde la web principal del centro.

1.2.2. Existe mapa de la web del centro o de la web de la biblioteca escolar.

1.2.3. Incluye enlaces internos entre las distintas secciones de la web.

1.2.4. Se ofrece información del apartado donde se encuentra el usuario en cada momento.

1.2.5. Se indica el nivel de accesibilidad de la web para personas con problemas de audición, visión o movilidad.

1.2.6. Existen motores de búsqueda simple o avanzada de información.

Indicador 1.3: Interactividad y herramientas 2.0

Subindicadores:

1.3.1. Se ofrece a los usuarios alguna posibilidad de interacción.

1.3.2. Dispone de blog o la web es un blog.

1.3.3. Se ofrecen fotografías, presentaciones o vídeos alojados en la World Wide Web.

1.3.4. Se ofrecen podcasts o audiolibros.

1.3.5. Dispone de posibilidad de redifusión web o sindicación web.

1.3.6. Dispone de presencia o interactividad con redes sociales.

Indicador 1.4: Luminosidad de la web

Subindicadores:

1.4.1. Ofrece algún enlace externo.

1.4.2. Ofrece enlaces a otras bibliotecas escolares.

1.4.3. Ofrece enlaces a otras webs relacionadas con la biblioteca escolar.

1.4.4. Ofrece enlaces a webs relacionadas con competencias lingüísticas y literarias.

1.4.5. Todos los enlaces funcionan bien.

Parámetro 2: Contenidos

Indicador 2.1: Información sobre la biblioteca escolar

Subindicadores:

2.1.1. Se informa sobre el nombre propio, la mascota o el logo de la biblioteca escolar.

2.1.2. Se ofrece un plano de la biblioteca escolar.

2.1.3. Se informa sobre el horario y/o las normas de uso de la biblioteca escolar.

2.1.4. Se informa sobre los servicios u objetivos de la biblioteca escolar.

2.1.5. Se informa sobre los planes vinculados a la biblioteca escolar.

2.1.6. Se informa sobre proyectos propios de la biblioteca escolar.

2.1.7. Se ofrece acceso al catálogo de la biblioteca escolar.

Indicador 2.2: Información sobre autoría y responsabilidad

Subindicadores:

2.2.1. Aparece el nombre de la persona autora y/o responsable de la web.

2.2.2. Se facilita correo electrónico u otro modo de contacto con la perso.na responsable de la web.

Indicador 2.3. Actualización de los contenidos

Subindicadores:

2.3.1. Se indica fecha de última actualización.

2.3.2. La web se ha actualizado durante el último curso escolar.

Indicador 2.4. Publicaciones periódicas propias o relacionadas

Subindicadores:

2.4.1. Se ofrece información sobre novedades bibliográficas, noticias del sector editorial o boletín de la biblioteca escolar en papel o en formato digital.

2.4.2. Se ofrece información sobre revista escolar en papel o en formato digital.

Indicador 2.5: Información (sincrónica, diacrónica y selectiva) sobre actividades propias

Subindicadores:

2.5.1. Se informa sobre actividades propias presentes.

2.5.2. Se informa sobre actividades propias pasadas.

2.5.3. Se informa sobre actividades propias futuras.

2.5.4. La información sobre actividades propias se dirige específicamente a distintos miembros de la comunidad educativa.

Indicador 2.6: Posibilidad de realizar actividades

Subindicadores:

2.6.1. Se ofrecen actividades propias de comprensión oral.

2.6.2. Se ofrecen actividades propias de lectura y comprensión lectora.

2.6.3. Se ofrecen actividades propias de expresión escrita.

Indicador 2.7: Materiales a disposición del alumnado

Subindicadores:

2.7.1. Se ofrecen textos no orientados específicamente a la educación lingüística o literaria.

2.7.2. Se ofrecen audios no orientados específicamente a la educación lingüística o literaria.

2.7.3. Se ofrecen videos no orientados específicamente a la educación lingüística o literaria.

2.7.4. Se ofrecen textos orientados específicamente a la educación lingüística o literaria.

2.7.5. Se ofrecen audios orientados específicamente a la educación lingüística o literaria.

2.7.6. Se ofrecen videos orientados específicamente a la educación lingüística o literaria.

Indicador 2.8: Material didáctico para docentes y padres

Subindicadores:

2.8.1.Se ofrece algún tipo de material didáctico propio para docentes.

2.8.2. Se ofrece algún tipo de material didáctico propio para padres.

Con el objetivo de facilitar una visión global de la categorización establecida, se presenta en la Figura 1 un gráfico con el esquema jerárquico de todos los elementos que componen el instrumento definitivo para el análisis y evaluación de webs de bibliotecas escolares.

Conclusiones

Las conclusiones obtenidas tras el proceso de validación del instrumento de análisis y evaluación de webs de bibliotecas escolares mediante el acuerdo interjueces se exponen en relación a tres ámbitos: aplicación de la técnica, eficacia del método y limitaciones del proceso.

Aplicación de la técnica

La técnica del acuerdo interjueces se ha aplicado correctamente porque se han seguido los principios científicos establecidos por los especialistas en relación a los siguientes aspectos:

Determinación del número de jueces. La elección de nueve jueces ha sido una decisión acertada ya que, además de cumplir con el mínimo de dos establecido por Krippendorff (2004: 522), ha posibilitado la diversidad e independencia de opiniones y ha preservado la proporcionalidad entre el número de ítems valorado y su codificación manual.

Elección de los jueces. Los jueces fueron elegidos según los cinco criterios ya expuestos de independencia, solvencia profesional, experiencia investigadora, diversidad geográfica y diverso nivel de responsabilidad especializada. Estos criterios son adecuados porque han posibilitado el cumplimiento de los requisitos contemplados tanto por Krippendorff (2004: 522) como por Jochen Peter y Edmund Lauf (2002): afinidad con la información tratada, adiestramiento en el sistema de codificación y semejantes niveles educativos, culturales y profesionales.

Información a los jueces. Se ha proporcionado el mismo tipo de información (cuestionario e instrucciones) a todos los jueces con el objetivo de evitar diferencias en los criterios de valoración y de minimizar el sesgo personal de los codificadores manuales.

Establecimiento de las reglas de valoración. Los límites de aceptabilidad de los acuerdos han sido de dos tipos: numéricos y analíticos. En el cuestionario valorativo se ha establecido una escala con una adaptación (según los objetivos del instrumento y el número de jueces) de la estadística kappa de Cohen. El límite de aceptabilidad para la supresión de ítems se ha establecido en el 50% de grado de valoración como poco importante. En las cuestiones de respuestas abiertas se ha analizado la aceptabilidad de las propuestas de cambio según los argumentos aportados por cada uno de los jueces y su relación con la valoración numérica. La aplicación de estas reglas ha dado lugar a la supresión y cambios en la redacción de ítems pero no se ha producido la adición de ninguno nuevo.

Eficacia del método

El cumplimiento de los objetivos de nuestra investigación ha demostrado la eficacia del método usado para la validación del instrumento, lo que ha quedado patente en un triple sentido:

El instrumento final validado es el resultado del consenso de nueve expertos sobre la base de una propuesta fundamentada científicamente. La combinación de preguntas abiertas y cerradas en el cuestionario respondido por los jueces ha redundado en una mayor aportación para la mejora del instrumento piloto.

El instrumento final, tras las supresiones y redefiniciones de ítems, se puede considerar solvente para ser utilizado en el análisis de contenido de webs de bibliotecas escolares, como se indica en el cuarto de los componentes de este tipo de análisis, según Andréu Abela (2001), referido a la comprobación de la fiabilidad del sistema de codificación-categorización.

El texto definitivo del instrumento refuerza la posibilidad de llevar a cabo, mediante la regla de presencia, el análisis de contenido según las características establecidas por Berelson (1952) de objetividad, sistematización, cuantificación e información manifiesta.

Limitaciones del proceso

Aunque la aplicación de la técnica del acuerdo interjueces ha resultado adecuada y su eficacia ha quedado demostrada, en el proceso de nuestra investigación también se han evidenciado algunas limitaciones, entre las que podemos destacar:

El hecho de establecer los límites necesarios en la aceptabilidad de los acuerdos conlleva la no incorporación al instrumento definitivo de recomendaciones oportunas por parte de alguno de los jueces al no alcanzar el consenso requerido.

Aunque los criterios seguidos para la elección del número de jueces y de las personas concretas han sido acertados, con esos mismos criterios se hubiera podido elegir un número diferente de jueces y a otras personas distintas, lo que habría dado lugar a resultados también diversos. El instrumento para el análisis y evaluación de webs de bibliotecas escolares habría quedado igualmente validado, pero con aportaciones distintas.

Si el número de jueces hubiera sido mayor, también habría aumentado la cantidad de propuestas y sugerencias en las preguntas abiertas del cuestionario, pero es posible que el instrumento hubiera quedado reducido en el número de ítems, ya que a mayor número de jueces resulta más difícil alcanzar acuerdos relevantes. En nuestra opinión, para analizar documentos tan extensos y variados como las páginas webs, conviene abarcar un número elevado de aspectos. Por tanto, si se amplía el número de jueces sería recomendable modificar los límites de aceptabilidad de los acuerdos.

En definitiva, podemos concluir que nuestra investigación aporta una de las formas posibles de validar un instrumento fiable que cumple con todos los requisitos para analizar y evaluar el contenido de cualquier web de biblioteca escolar.

nueva página del texto (beta)

nueva página del texto (beta)