Services on Demand

Journal

Article

Indicators

-

Cited by SciELO

Cited by SciELO -

Access statistics

Access statistics

Related links

-

Similars in

SciELO

Similars in

SciELO

Share

Revista mexicana de análisis de la conducta

Print version ISSN 0185-4534

Rev. mex. anál. conducta vol.37 n.2 México Jan. 2011

https://doi.org/10.5514/rmac.v37.i2.26139

Artículos empíricos

Respuestas de observación y resistencia a la extinción

Observing responses and resistance to extinction

Rogelio Escobar

Universidad Nacional Autónoma de México - Laboratorio de Condicionamiento Operante, México, D.F., México

Dirigir correspondencia a:

Rogelio Escobar.

Laboratorio de Condicionamiento Operante,

Facultad de Psicología, UNAM.

Av. Universidad 3004, Col. Copilco-Universidad,

C.P. 04510. Del. Coyoacán,

México, D.F.,

correo: rescobar@servidor.unam.mx

Recibido: Mayo 3, 2011

Revisado: Junio 9, 2011

Aceptado: Junio 24, 2011

Resumen

Se determinó la resistencia a la extinción de la conducta de observación al eliminar el reforzamiento primario y presentado solamente estímulos asociados con la entrega de comida (E+), estímulos asociados con la ausencia de comida (E-) o estímulos neutros. Durante tres condiciones de entrenamiento de 30 sesiones, se reforzaron con comida las presiones a una palanca en ratas usando un programa de reforzamiento mixto razón al azar 50 extinción. Cada presión en una segunda palanca (observación) produjo por 5 s un E+ durante el componente de reforzamiento y un E- durante extinción. Después de cada condición de entrenamiento, se expuso a las ratas a 10 sesiones de extinción en las que eliminó el programa de reforzamiento mixto. En cada una de las tres condiciones de extinción, cada presión en la palanca de observación produjo sólo el E+, sólo el E- y sólo el estímulo neutro. El orden de exposición fue diferente para cada rata. Se encontró que el E+ aumentó y el E- disminuyó la resistencia la extinción de las respuestas de observación relativo al estímulo neutro. Estos resultados sugieren que el concepto de reforzamiento condicionado sigue siendo necesario en el análisis de la conducta.

Palabras clave: Respuestas de observación, resistencia a la extinción, reforzamiento condicionado, palanqueo, ratas.

Abstract

The resistance to extinction of observing behavior was determined by removing the primary reinforcer and presenting only a stimulus associated with reinforcement (S+), only a stimulus associated with extinction (S-), and only a neutral stimulus. In three training conditions of 30 sessions each, lever pressing by rats was reinforced on a mixed random ratio 50 extinction. Each press on a second lever (observing) produced for 5 s an S+ during the reinforcement component and an S- during extinction. After each training condition, rats were exposed to 10 sessions of extinction in which the mixed schedule was discontinued. In each of the three successive extinction conditions, each press on the observing lever produced only the S+, only the S-, or only the neutral stimulus. The order of exposure was different for each rat. Presenting the S+ increased and presenting the S- decreased resistance to extinction relative to the neutral stimulus. These findings suggest that the concept of conditioned reinforcement is still a necessary one in behavior analysis.

Keywords: Observing responses, resistance to extinction, conditioned reinforcement, lever pressing, rats.

Un reforzador condicionado se define como un estímulo, previamente neutro, que a partir de su apareamiento repetido con un reforzador primario ha adquirido la capacidad de fortalecer respuestas (Mazur, 2006). En los orígenes del análisis de la conducta, el reforzamiento condicionado parecía ser la panacea para explicar patrones complejos de conducta que aparentemente no dependen de la presentación de reforzadores primarios como agua o comida (e.g., Keller & Schoenfeld, 1950).

El concepto de reforzamiento condicionado, sin embargo, lejos de permitir la explicación de conducta compleja, ha sido problemático en el condicionamiento operante (Williams 1994a). El problema central ha sido determinar si un estímulo originalmente neutro es capaz de fortalecer la conducta que lo precede (Shahan, 2010). Para contestar esta pregunta, es necesario mostrar inequívocamente que una operante está controlada por el efecto del reforzador condicionado y no por algún otro evento o función del estímulo.

Parte del problema reside en que los efectos de un reforzador condicionado son difíciles de disociar de los efectos del reforzamiento primario. En algunos estudios sobre reforzamiento condicionado se utilizaron programas de reforzamiento encadenados (véase Gollub, 1977), en los que, por ejemplo, las respuestas en un programa de reforzamiento resultan en la presentación de un segundo programa de reforzamiento y en un cambio en la estimulación. El responder durante este segundo programa, resulta en la presentación del reforzador primario. Debido a que el responder en el primer programa, o eslabón inicial, resulta en un cambio de estimulación, se considera que la tasa de respuesta en este primer eslabón está mantenida por las propiedades reforzantes condicionadas del cambio de estimulación que a su vez está asociado con el reforzador primario. Algunos autores (e.g., Williams, 1994b), sin embargo, han señalado que estas respuestas no sólo están mantenidas por el reforzador condicionado sino también por el cambio en el programa de reforzamiento que es necesario para que ocurra el reforzador primario. Staddon y Cerutti (2003), incluso argumentaron que con este tipo de procedimientos, no es necesario apelar al concepto de reforzamiento condicionado debido a que las respuestas en el eslabón inicial podrían estar mantenidas exclusivamente por el efecto del reforzador primario demorado. Con base en estas críticas se puede argumentar que el hecho de que las respuestas en un mismo operando produzcan tanto el reforzamiento primario como el condicionado ha complicado la interpretación de los resultados y ha puesto en duda la utilidad del concepto de reforzamiento condicionado.

En comparación, los procedimientos de respuestas de observación (Wyckoff, 1952) han sido útiles para disociar los efectos del reforzamiento primario de los efectos del reforzamiento condicionado. En estos procedimientos, tradicionalmente, se expone a los sujetos a un programa de reforzamiento mixto en el que alternan al azar dos componentes. En uno de los componentes, se refuerzan las respuestas conforme a un programa de reforzamiento intermitente, en el otro componente las respuestas no tienen consecuencias programadas. Las respuestas en un segundo operando (de observación), producen estímulos asociados con los componentes del programa mixto en curso. Es decir, transforman temporalmente el programa mixto en un programa de reforzamiento múltiple. A partir de la asociación del estímulo correlacionado con el componente de reforzamiento (E+) y el reforzador primario, el E+ adquiere una función de reforzador condicionado de las respuestas de observación. Debido a que las respuestas de observación no alteran la frecuencia del reforzamiento primario, los procedimientos de observación han sido una de las herramientas más útiles para estudiar el fenómeno del reforzamiento condicionado (Williams, 1994b).

Con los procedimientos de respuestas de observación se han reportado efectos que son consistentes con la noción de que los reforzadores condicionados duplican la función de un reforzador primario. Por ejemplo aumentar la frecuencia de presentación del reforzador condicionado (Shahan, Podlesnik, & Jimenez-Gomez, 2006), reducir la demora entre el reforzador condicionado y el reforzador primario (Escobar & Bruner, 2009), y aumentar la magnitud del reforzador condicionado (Escobar, 2010), son manipulaciones que aumentan la frecuencia de ocurrencia de las respuestas de observación. La tasa de ocurrencia de una respuesta, sin embargo, es sólo uno de los dos aspectos disociables de una operante junto con la resistencia a la extinción (Nevin & Grace, 2000).

A pesar de que ambas variables se han considerado tradicionalmente como un índice de la fuerza de la respuesta (e.g., Skinner, 1938), Nevin and Grace (2000) argumentaron que la resistencia a la extinción es un mejor índice de la fuerza de la respuesta que la tasa de respuesta debido a que ésta última está controlada por las contingencias de reforzamiento o las relaciones respuesta-reforzador que pueden o no tener un efecto sobre la fuerza de la respuesta. Por ejemplo, si se observan las tasas de respuestas mantenidas por programas de reforzamiento de tasas bajas y se comparan con las tasas obtenidas con un programa de reforzamiento de tasas altas, se pueden hacer conclusiones sobre como la contingencia de reforzamiento afecta la conducta pero no se puede determinar si ocurrió un cambio en la fuerza de la respuesta (Shahan, 2010). Comparativamente, la resistencia al cambio es una medida que refleja la fuerza de la operante independientemente de la contingencia de reforzamiento que se programe.

En una serie de experimentos que han puesto en duda la utilidad del concepto de reforzamiento condicionado, Shahan y Podlesnik (2005; 2008) reportaron recientemente que los reforzadores condicionados no afectan la resistencia a la extinción de las respuestas de observación (véase Shahan 2010, para una revisión). En un experimento, Shahan y Podlesnik (2005, Experimento 1) usaron un programa múltiple de dos componentes para examinar los efectos de la frecuencia del reforzador condicionado sobre la resistencia a la extinción de las respuestas de observación en palomas. En cada componente del programa múltiple programaron un procedimiento de respuestas de observación. En uno de los componentes se encontraba vigente en una tecla un programa mixto intervalo al azar (IA) 120 s extinción. Los picotazos en una segunda tecla encendían los estímulos asociados con el programa de reforzamiento en curso por 15 s de acuerdo con un programa de IA 15 s. En el otro componente, el programa difería únicamente en que las respuestas de observación producían los estímulos conforme a un programa de IA 60 s. Los autores encontraron que la tasa de respuestas de observación fue más alta con el programa de IA 15 s que con el programa de IA 60 s. Este hallazgo es congruente con lo que se esperaría de variar la frecuencia de reforzamiento de un reforzador primario (e.g., Catania & Reynolds, 1968). Cuando posteriormente eliminaron los estímulos durante la prueba de resistencia a la extinción por 5 sesiones, sin embargo, las respuestas de observación no fueron diferentes en los dos componentes del programa múltiple.

Shahan y Podlesnik (2005) replicaron los hallazgos del experimento anterior haciendo incluso mayor la diferencia en la frecuencia del reforzamiento condicionado en los dos componentes del programa múltiple (IA 60 s vs IA 10 s, Experimento 2) o variando el valor del reforzamiento condicionado en uno de los componentes al añadir reforzamiento primario independiente de la respuesta (Shahan y Podlesnik, 2008). Aunque estos resultados aparentemente sugieren que los reforzadores condicionados no fortalecen las respuestas que los preceden, de acuerdo con los mismos autores, la complejidad del procedimiento dificulta interpretar los resultados inequívocamente. Por ejemplo, cuando se utilizan programas de reforzamiento múltiples y se realizan pruebas de resistencia a la extinción, las relaciones entre los estímulos (reforzadores y contexto) determinan la resistencia a la extinción (e.g., Nevin, Tota, Torquato, & Shull, 1990). En el caso de los estudios de Shahan y Podlesnik (2005; 2008) únicamente si se establecía una asociación de segundo orden entre el E+ y el estímulo de contexto, hubiera sido esperable encontrar un aumento en la resistencia a la extinción. Otro detalle que complica aún más la interpretación de los resultados es que uno de sus hallazgos sugiere una explicación alternativa.

Cuando Shahan y Podlesnik (2008, Experimento 2) compararon las respuestas de observación en una condición en la que dejaron de presentar el reforzador primario, encontraron que las respuestas de observación fueron más frecuentes cuando producían el E+ que cuando dejaban de producirlo. Este resultado es consistente con los hallazgos de Bell, Seip, y Fitzsimmons (2007), quienes reportaron que después de utilizar reforzamiento demorado señalado, la resistencia a la extinción fue mayor cuando presentaron la señal de la demora durante extinción que cuando dejaron de presentarla. Aunque este resultado de Shahan y Podlesnik podría sugerir que la resistencia a la extinción del reforzamiento primario puede aumentar en función de presentar un reforzador condicionado, es difícil comparar la frecuencia de ocurrencia de las respuestas de observación cuando se eliminan los estímulos debido a que eliminar los estímulos aumenta la base de tiempo durante la cual se pueden emitir las respuestas de observación.

En la investigación clásica sobre reforzamiento condicionado (véase Kelleher & Gollub, 1962; Myers, 1958; Wike, 1966), también se realizaron pruebas de resistencia a la extinción en las que se eliminaba el reforzador primario y se comparaban las respuestas en presencia y en ausencia del reforzador condicionado. Estos procedimientos se abandonaron esencialmente debido a la dificultad de distinguir entre los efectos de los estímulos como reforzadores condicionados o como estímulos discriminativos que señalan la disponibilidad del reforzador primario (e.g., Bitterman, Fedderson, & Tyler, 1953; Dinsmoor, 1950). Debido a que los procedimientos de observación permiten disociar las respuestas que producen el reforzador primario de las respuestas que producen el reforzador condicionado, estos procedimientos podrían ser útiles para explorar los efectos de la resistencia a la extinción de las respuestas de observación. En el presente experimento se examinó esta afirmación al determinar los efectos de eliminar el reforzador primario y presentar únicamente el E+ y el E- en comparación con un estímulo neutro (EN). Con este procedimiento se esperaría que si el E+ tiene una función de reforzador condicionado debería controlar un número mayor de respuestas de observación durante extinción que un EN. En contraste, si el E- tiene funciones de estímulo aversivo, debería controlar un número menor de respuestas durante extinción que el E+ y el EN. Para determinar por separado la función de los estímulos como estímulos discriminativos, también se analizaron las respuestas por comida que ocurrieron durante extinción.

Método

Sujetos

Se usaron 3 ratas Wistar macho de tres meses de edad al inicio del experimento y experimentalmente ingenuas. Las ratas se mantuvieron en cajas habitación individuales con acceso libre al agua y se les restringió el acceso a la comida hasta que alcanzaron el 80% de su peso en alimentación libre.

Aparatos

Se utilizaron tres cámaras experimentales (Med Associates Inc. modelo ENV-001) equipadas con un comedero de metal en el centro del panel frontal y una palanca a cada lado del comedero. El interruptor de las palancas operó con una fuerza mínima de 0.15 N. Las cámaras experimentales también estaban equipadas con un sonalert (Mallory SC 628) que generó un tono de 2900 Hz 70 dB, con un foco que sirvió para iluminar el interior de la cámara experimental y con dos luces, una arriba de cada palanca, que generaron una iluminación tenue. El comedero estaba conectado a un dispensador de bolitas de comida (Med Associates Inc. modelo ENV-203) fabricadas remoldeando comida pulverizada para ratas. Cada cámara experimental se introdujo en un cubículo sonoamortiguado de madera equipado con un generador de ruido blanco y con un ventilador que sirvió para facilitar la circulación de aire. Los eventos experimentales se controlaron por medio de una interfase (Med Associates Inc. modelo SG-503) conectada a una computadora con software Med-PC ver. 2.0 ubicada en un cuarto adyacente al cuarto en el que se colocaron las cámaras experimentales.

Procedimiento

Después de retirar la palanca derecha de la cámara experimental, se expuso a las tres ratas a cinco sesiones en las que cada presión a la palanca izquierda fue reforzada con una bolita de comida. Posteriormente, durante 20 sesiones se cambió el programa de reforzamiento continuo por un programa de razón al azar (RA) 50 para las tres ratas.

Entrenamiento en un programa múltiple RA 50 extinción. Se expuso a las tres ratas a un programa múltiple RA 50 s extinción. La duración de ambos componentes, de reforzamiento y de extinción fue de 60 s. En cada sesión se presentaron 30 componentes de reforzamiento y 30 componentes de extinción alternados al azar con la restricción de que no ocurrieran más de dos componentes iguales consecutivamente. El componente de reforzamiento se señaló con el encendido intermitente (cada segundo) de las dos luces (E+) y el componente de extinción con el encendido constante del tono (E-). Esta fase se mantuvo en efecto durante 30 sesiones diarias.

Procedimiento de respuestas de observación y pruebas de extinción. Durante esta condición, para todas las ratas se instaló la palanca derecha en la cámara experimental y se eliminó la presentación de los estímulos. Cada presión en la palanca derecha encendió el estímulo asociado con el componente del programa mixto en curso durante 5 s. Si la presentación de algún estímulo coincidió con un cambio de componente del programa el estímulo se apagó hasta que una siguiente respuesta encendió los estímulos nuevamente. Esta condición estuvo en efecto en tres bloques de 30 sesiones cada uno. Cada sesión consistió de 30 componentes de reforzamiento y 30 de extinción.

Después de cada bloque de 30 sesiones del programa de reforzamiento mixto, durante 10 sesiones para una rata sólo se presentó el E+, para otra rata el E- y para la tercera rata un EN (apagado de la luz general) conforme a un programa de reforzamiento continuo en la palanca derecha. Cada sesión tuvo la misma duración que las sesiones de la condición anterior en el programa mixto. Esta secuencia del procedimiento se repitió de tal manera que lastres ratas se expusieron durante 10 sesiones de extinción al E+, al E- y al EN. Para evitar un posible efecto de secuencia, el orden de exposición a los estímulos en extinción fue diferente para cada rata (R10, EN, E-, E+; R11, E+, EN, E-; R12, E-, E+, EN). Después de cada prueba de extinción y durante la primera sesión de entrenamiento con el programa de reforzamiento mixto, se entregó comida a los sujetos conforme a un programa de razón fija 1 durante el componente de reforzamiento que se cambió gradualmente por un programa de RV 50.

Resultados

Con el propósito de mostrar la velocidad de caída en el número de respuestas de observación al eliminar la entrega de comida, los paneles de la izquierda en la Figura 1 muestran el número de respuestas en la palanca de observación como un porcentaje del número máximo de respuestas para cada sujeto. En cada panel se muestra el porcentaje de respuestas de observación obtenido cuando sólo se presentó el E+, el E- o el EN durante las 10 sesiones consecutivas de extinción. En la mayoría de las sesiones y para los tres sujetos se encontró que el número mayor de respuestas de observación lo controló la presentación del E+. Para la Rata R11, el número más bajo de respuestas de observación, en la mayoría de las sesiones, ocurrió cuando sólo se presentó el EN. Este efecto se observó únicamente durante las últimas dos sesiones de extinción en la Rata R12. Para la Rata R10, no se encontraron diferencias sistemáticas de presentar sólo el E- o sólo el EN.

Como un índice de la resistencia a la extinción del valor discriminativo de los estímulos, en los paneles de la derecha en la Figura 1 se muestra el número de respuestas en la palanca izquierda (comida) como un porcentaje del número máximo de respuestas para cada sujeto en cada una de las 10 sesiones consecutivas en extinción. Durante las primeras 5 sesiones de extinción, para las Ratas R10 y R12 se observó un número de respuestas en la palanca de comida ligeramente mayor cuando sólo se presentó el E+ que cuando se presentaron el E- o el EN. Este patrón también se observa durante la última sesión de extinción en los tres sujetos. En el resto de las sesiones, sin embargo, no se encontró un efecto sistemático de presentar el E+, el E- o el EN.

En la Tabla 1 se muestra el número de respuestas obtenidas en cada sesión de extinción en las palancas de comida y de observación para cada sujeto. Estos datos se muestran únicamente con fines de comparación con la Figura 1 debido a que estos datos están modulados por la tasa de respuesta en cada palanca durante las condiciones de entrenamiento previas a cada condición de extinción. A pesar de este efecto, para las tres ratas el número mayor de respuestas de observación ocurrió cuando estas produjeron el E+ en ausencia del programa de entrega de comida. El número menor de respuestas de observación ocurrió cuando estas produjeron el E- en las Ratas R10 y R12. Para la Rata R11 el número más bajo de respuestas de observación ocurrió cuando estas produjeron el EN. El número de respuestas en la palanca de comida, en contraste, estuvo determinado por el orden de presentación de las condiciones de extinción y no por el estímulo que estuvo presente durante extinción.

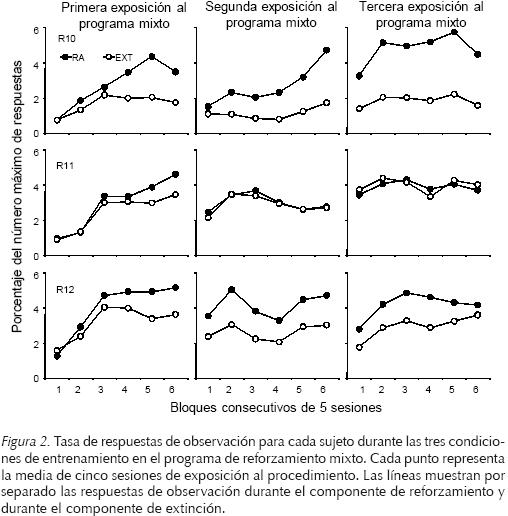

Con el propósito de analizar si durante las exposiciones al procedimiento de observación, existieron diferencias entre los tres sujetos que permitan explicar las diferencias encontradas en el número de respuestas de observación mantenidas por el E-, se analizaron la tasa de respuestas de observación, la tasa de respuestas por comida y el número de reforzadores obtenidos. En la Figura 2 se muestra la tasa de respuestas de observación individual en cada una de las exposiciones al programa de reforzamiento mixto RA 50 extinción. En cada fase se muestra la tasa en seis bloques de 5 sesiones cada uno. En las Ratas R10 y R12 se encontró una tasa de respuestas de observación notablemente más alta durante el componente de reforzamiento que durante el componente de extinción y no se observaron diferencias sistemáticas entre las tres exposiciones al programa de reforzamiento mixto. Para la Rata R11, en contraste, esta diferencia solamente se observó durante la primera exposición al programa de reforzamiento mixto. En las dos siguientes exposiciones al programa de reforzamiento mixto la tasa de respuesta fue similar en los componentes de reforzamiento y de extinción.

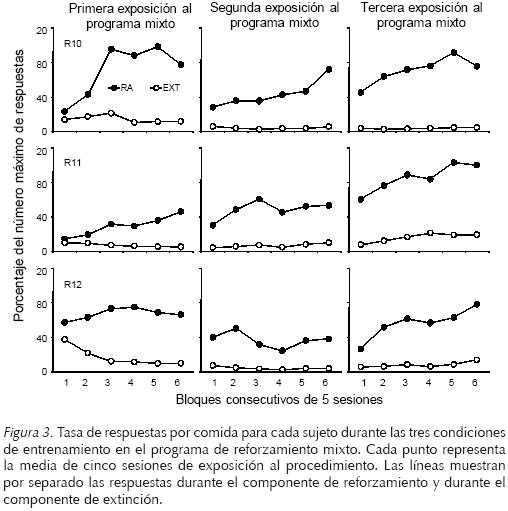

La Figura 3 muestra la tasa de respuestas por comida para cada rata durante las tres exposiciones al programa de reforzamiento mixto en cada uno de los bloques de cinco sesiones. En las tres ratas se encontró que la tasa de respuestas por comida fue más alta en el componente de reforzamiento que en el componente de extinción. La tasa de respuestas por comida no varió sistemáticamente en las tres condiciones de exposición al programa de reforzamiento mixto.

La Figura 4 muestra el número de reforzadores obtenidos como la media en cada uno de los cinco bloques de seis sesiones de las tres exposiciones al programa mixto RA 50 extinción. Al igual que en la Figura 4 no se observaron diferencias entre el número de reforzadores obtenidos en las tres exposiciones al programa de reforzamiento mixto.

Discusión

Se encontró que la presentación del E+ aumentó la resistencia a la extinción de las respuestas de observación. Este efecto fue consistente a través de las sesiones de extinción y para los tres sujetos. Haber contrabalanceado la exposición a las sesiones de extinción en presencia de los diferentes estímulos, descarta que este efecto se deba al orden de presentación de las condiciones de extinción. Este resultado es consistente con el hallazgo de Shahan y Podlesnik (2008, Experimento 2) quienes mostraron que las respuestas de observación fueron más frecuentes cuando producían el E+ que cuando no tenían consecuencias programadas. También es consistente con los resultados de Bell et al. (2007) quienes reportaron que las respuestas eran más resistentes a la extinción cuando se presentó una señal que había estado presente durante una demora de reforzamiento que cuando la señal no se presentó. Estos resultados en conjunto sugieren que el concepto de reforzamiento condicionado sigue siendo un concepto útil en el análisis de la conducta (e.g., Bejarano & Hackenberg, 2007; pero cf. Davison & Baum, 2006) debido a que un reforzador condicionado no sólo aumenta la frecuencia de una respuesta que lo precede sino que también puede aumentar la resistencia a la extinción de las respuestas de observación.

Es intrigante, sin embargo, que Shahan y Podlesnik (2005; 2008) no encontraron efectos de variar los parámetros del reforzamiento condicionado (e.g., frecuencia y valor) sobre la resistencia a la extinción de las respuestas de observación en ausencia del reforzador condicionado. Una explicación, es que, como Shahan y Podlesnik (2008) mencionaron, para mostrar cambios en la resistencia a la extinción su procedimiento requería la asociación entre el E+ y el estímulo de contexto (condicionamiento de orden superior) (Nevin & Grace, 2000). Esta asociación, se ha mostrado que es difícil de establecer en diversos procedimientos (véase Rescorla, 1977, para una revisión).

La presentación del E- durante extinción redujo la resistencia a la extinción relativo a un EN en dos de tres sujetos. Este hallazgo es congruente con una explicación en términos de la función aversiva del E-. Una interpretación tradicional de los efectos del E- en los procedimientos de observación sugiere que el E- señala una reducción en la frecuencia de reforzamiento relativo a la ausencia de estimulación y, por lo tanto, este debería funcionar como un estímulo aversivo (Dinsmoor, 1983; veáse también Tomanari, 2010). Para el tercer sujeto, sin embargo, el E- aumentó la resistencia a la extinción relativo al EN.

Para explicar la diferencia en los hallazgos en este sujeto fue necesario analizar la tasa de respuestas de observación durante las condiciones en la cuales se expuso a los sujetos al procedimiento de respuestas de observación (ver Figura 2). Para este sujeto, la tasa de respuestas de observación fue similar en ambos componentes del programa de reforzamiento mixto. Este hallazgo sugiere que probablemente el E-adquirió una función diferente a la de estímulo aversivo. Escobar y Bruner (2009) describieron que cuando el E- y el E+ ocurren en sucesión, el E- puede adquirir una función de reforzador condicionado (véase también Tomanari, 2001). Zentall y Sherburne (1994) reportaron un hallazgo similar usando una discriminación simultánea. Estos autores reportaron que un E+ puede transferir su valor aun E-. En línea con esta sugerencia, Escobar and Bruner (2008) mostraron que cuando se añade un intervalo de tiempo entre el componente de extinción y el componente de reforzamiento, disminuyen las respuestas de observación durante el componente de extinción. En contraste, cuando el mismo intervalo se añade al inicio del componente de extinción, no se observan cambios en la tasa de respuestas de observación en el componente de extinción. Por lo tanto, para la Rata R11, el E- pudo haber funcionado como un reforzador condicionado debido a su apareamiento accidental con el E +.

En la palanca en la que las respuestas producían comida durante las condiciones de entrenamiento en el procedimiento de respuestas de observación, no se encontró una diferencia notable en la resistencia a la extinción mantenida por el E+ , el E- o el EN. Únicamente se encontró que el E+ aumentó la resistencia a la extinción durante las primeras cinco sesiones para dos sujetos y durante la última sesión para los tres sujetos. Si bien podría argumentarse que el hecho de que no se encontrara un aumento en la resistencia a la extinción en la palanca en la que las respuestas produjeron comida durante el entrenamiento podría deberse a la falta de discriminabilidad de los estímulos usados como E+, E- y EN, esta explicación es poco probable debido a que se encontró que la tasa de respuesta por comida durante el entrenamiento fue claramente diferente en los dos componentes del programa de reforzamiento mixto (ver Figura 3). Otra explicación es que este resultado pudo deberse a las diferencias entre las condiciones de entrenamiento con un procedimiento de respuestas de observación y las condiciones de extinción en las que únicamente se presentó el E+ , el E- o el EN. Debido a las diferencias entre los procedimientos, después de algunas exposiciones a los estímulos, la ausencia del reforzador y del cambio de componente pudo haber facilitado la discriminación entre las sesiones de entrenamiento y las sesiones de extinción (véase Nevin, 1988 para un argumento similar).

En la literatura clásica sobre reforzamiento condicionado (Myers, 1958; Kelleher & Gollub, 1962; Wike, 1966), se usaron pruebas del efecto del refozador condicionado durante extinción para examinar el valor de los estímulos como reforzadores condicionados (e.g., Skinner, 1938). Existen dos tipos diferentes de procedimientos con pruebas durante extinción. En un procedimiento se aparea un estímulo neutro con un reforzador independiente de la respuesta de los sujetos y, en una siguiente condición, la presentación del estímulo originalmente neutro se hace contingente a una nueva respuesta en ausencia del reforzador primario. Skinner (1938) usando este procedimiento mostró que la tasa de respuesta aumentó debido a la presentación del estímulo. Por lo tanto, concluyó que el estímulo funcionó como un reforzador condicionado. Este procedimiento se conoce como el método de la nueva respuesta (e.g., Myers, 1958; Wike, 1966).

Otro procedimiento, similar al procedimiento usado en el presente estudio, consiste en establecer una respuesta con un reforzador primario que va precedido de un estímulo neutral. Posteriormente se expone a los sujetos a extinción, de tal forma que las respuestas que antes producían el estímulo y el reforzador sólo producen el estímulo. Este procedimiento se conoce como el método de la respuesta establecida (e.g., Myers, 1958; Wike, 1966). Por ejemplo, Bugelski (1938) usó dos grupos de sujetos y comparó la resistencia a la extinción (número de respuestas durante extinción) de un grupo de sujetos en los que las respuestas produjeron el estímulo apareado con la comida en la condición anterior con la resistencia a la extinción en otro grupo de sujetos en los cuales las respuestas no produjeron estímulos. Los resultados de Bugelski fueron consistentes con los encontrados en el presente experimento. Encontró que ocurrieron más respuestas durante extinción cuando éstas produjeron estímulos que cuando no los produjeron y concluyó que el estímulo funcionó como un reforzador condicionado.

Los procedimientos con pruebas durante extinción fueron objeto de diferentes críticas. Algunos autores sugirieron que estos estudios no mostraron efectos de reforzamiento condicionado debido a que los efectos fueron apenas estadísticamente significativos (e.g., Wyckoff, 1959). Para Wyckoff el estímulo durante extinción sólo causa un aumento en la actividad general debido a que señala la presencia de comida. De acuerdo con Wyckoff, este aumento en la actividad es responsable del aumento en el número de respuestas que producen los estímulos. El presente experimento, elude, al menos hasta un cierto punto, estas críticas debido a que, en primer lugar, se utilizó un diseño intrasujeto. Este tipo de diseño experimental permite usar la conducta de un mismo sujeto como línea base para la comparación de los efectos de las variables exploradas (véase Sidman, 1960) y se encontró que el efecto fue consistente en los tres sujetos del estudio. Con este tipo de diseños se evita el uso de procedimientos estadísticos que pueden mezclar efectos de las variables exploradas con errores en la medición. En segundo lugar, durante las tres pruebas de extinción, las respuestas de observación produjeron tanto como 680 E+s (Rata 12) en ausencia de comida. Si el efecto, fuera debido al aumento en la actividad producto de la entrega de comida, el efecto debió haber desaparecido después de unas cuantas sesiones. En cambio, la diferencia en el efecto sobre las respuestas de observación de los tres estímulos usados durante las condiciones de extinción, se mantuvo aún después de 10 sesiones.

Para algunos autores (véase Kelleher & Gollub, 1962) un problema con las pruebas de reforzamiento condicionado durante extinción es que el reforzador condicionado pierde propiedades reforzantes rápidamente conforme transcurre el tiempo de exposición a la prueba en extinción. Un hallazgo importante del presente experimento es que mostró que incluso cuando las respuestas de observación nunca produjeron comida durante el entrenamiento, se mantuvieron durante 10 sesiones cuando su única consecuencia fue la presentación del E+. Posteriores estudios podrían explorar el límite del mantenimiento de las respuestas de observación en ausencia del reforzador primario usando un número mayor de sesiones de extinción.

Otro problema con las pruebas de reforzamiento condicionado durante extinción radica en distinguir si los efectos se deben a la función discriminativa del estímulo o a su función como reforzador condicionado. Por ejemplo, Bitterman et al. , (1953) sugirieron que las respuestas que producen los estímulos durante extinción ocurren en función de la similitud entre las condiciones de entrenamiento y de extinción. Debido a que los estímulos señalan la entrega de comida, cuando se presentan durante extinción aumentan el número de respuestas que antes producían la comida.

Por lo tanto, los procedimientos con pruebas durante extinción no muestran efectos de reforzamiento condicionado sino de discriminación. Esta diferencia es importante porque aunque una de las primeras explicaciones para el establecimiento de reforzadores condicionados (e.g., Keller & Schoenfeld, 1950) sugería que es necesario establecer un estímulo como discriminativo para que adquiera una función como un reforzador condicionado, estudios posteriores mostraron que un reforzador condicionado puede funcionar como tal sin funcionar como estímulo discriminativo (e.g., Stein, 1958).

El procedimiento de respuestas de observación con pruebas posteriores de extinción, eliminó el problema de que la misma respuesta que produce comida durante el entrenamiento, produce el reforzador condicionado durante extinción. En el presente experimento, el hecho de que el E+ no aumentó la resistencia a la extinción de las respuestas que produjeron comida durante el entrenamiento pero si aumentó la resistencia a la extinción de las respuestas que produjeron el E+ sugiere que los efectos de reforzamiento condicionado son disociables de los efectos de la discriminación de estímulos (véase Kelleher & Gollub, 1962).

En el origen de nuestra disciplina (e.g., Keller & Schoenfeld, 1950; Skinner, 1938) el concepto de reforzamiento condicionado parecía útil para explicar el hecho de la conducta humana en numerosas ocasiones parece estar controlada por estímulos que no son claramente reforzadores primarios. La investigación sobre reforzamiento condicionado, sin embargo, ha producido hallazgos contradictorios que en ocasiones sugieren que los reforzadores condicionados no aumentan la tasa (Schuster, 1969) ni la resistencia a la extinción (Shahan & Podlesnik, 2005, 2008) de las respuestas que los producen. Es probable que muchos de estos hallazgos contradictorios se deban a problemas para disociar los efectos de un reforzador condicionado de los efectos de un reforzador primario o a la falta de comprensión del proceso responsable de la función de un estímulo como reforzador condicionado (e.g., como estímulo de puente o condicionamiento de orden superior). Aunque el presente experimento sugiere que el concepto de reforzamiento condicionado sigue siendo útil en el condicionamiento operante, es necesario realizar más investigación para mostrar si los reforzadores condicionados adquieren la capacidad de reforzar la conducta que los produce a partir de su apareamiento con un reforzador primario. A pesar de que el concepto de reforzamiento ha perdido su antiguo poder explicativo, podría seguir siendo ser importante para explicar patrones conductuales en los que un estímulo precede la presentación de un reforzador primario.

Referencias

Bejarano, R., & Hackenberg, T. D. (2007). IRT-stimulus contingencies in chained schedules: Implications for the concept of conditioned reinforcement. Journal of the Experimental Analysis of Behavior, 88, 215-227, available via: http://dx.doi.org/ 10.1901/jeab.2007.87-03. [ Links ]

Bell, M. C., Seip, K. M., & Fitzsimmons, K. S. (2007). Effect of signaling reinforcement on resistance to change in a multiple schedule. Behavioural Processes, 74, 33-48, available via: http://dx.doi.org/10.1016/j.beproc.2006.09.009. [ Links ]

Bitterman, M. E., Feddersen, W. E., & Tyler, D. W. (1953). Secondary reinforcement and the discrimination hypothesis. American Journal of Psychology, 66, 456-464, available via: http://dx.doi.org/10.2307/1418240. [ Links ]

Bugelski, R. (1938). Extinction with and without sub-goal reinforcement. Journal of Comparative Psychology, 26, 121-134, available via: http://dx.doi.org/10.1037/h0057091. [ Links ]

Catania, A. C., & Reynolds, G. S. (1968). A quantitative analysis of the responding maintained by interval schedules of reinforcement. Journal of the Experimental Analysis of Behavior, 11, 327-383, available via: http://dx.doi.org/ 10.1901/jeab.1968.11-s327. [ Links ]

Davison, M., & Baum, W. M. (2006). Do conditional reinforcers count? Journal of the Experimental Analysis of Behavior, 86, 269-283, available via: http://dx.doi.org/10.1901/jeab.2006.56-05. [ Links ]

Dinsmoor, J. A. (1950). A quantitative comparison of the discriminative and reinforcing functions of a stimulus. Journal of Experimental Psychology, 40, 458-472, available via: http://dx.doi.org/10.1037/h0056266. [ Links ]

Dinsmoor, J. A. (1983). Observing and conditioned reinforcement. Behavioral and Brain Sciences, 6, 693-728, available via: http://dx.doi.org/10.1017/S0140525X00017969. [ Links ]

Escobar, R. (2010). The effects of travel distance on observing responses by rats. European Journal of Behavior Analysis, 11, 79-91. [ Links ]

Escobar, R., & Bruner, C.A. (2008). Effects of the contiguity between the extinction and the reinforcement component in observing-response procedures. Revista Mexicana de Análisis de la Conducta, 34, 331-345. [ Links ]

Escobar, R., & Bruner, C.A. (2009). Observing responses and serial stimuli: Searching for the reinforcing properties of the S-. Journal of the Experimental Analysis of Behavior, 92, 215-231, available via: http://dx.doi.org/10.1901/jeab.2009.92-215. [ Links ]

Gollub, L. R. (1977). Conditioned reinforcement: Schedule effects. En W. K Honig & J. E. R. Staddon (Eds.), Handbook of operant behavior (pp. 288-312). Englewood Cliffs, NJ: Prentice-Hall. [ Links ]

Kelleher, R. T., & Gollub, L. R. (1962). A review of positive conditioned reinforcement. Journal of the Experimental Analysis of Behavior, 5, 543-597, available via: http://dx.doi.org/10.1901/jeab.1962.5-s543. [ Links ]

Keller, F. S., & Schoenfeld, W. N. (1950). Principles of psychology. Nueva York: Appleton-Century-Crofts. [ Links ]

Mazur, J. E. (2006). Learning and behavior (Sixth Edition). Upper Saddle River, NJ: Prentice Hall. [ Links ]

Myers, J. L. (1958). Secondary reinforcement: A review of recent experimentation. Psychological Bulletin, 55, 284-301, available via: http://dx.doi.org/10.1037/h0046125. [ Links ]

Nevin, J. A. (1988). Behavioral momentum and the partial reinforcement effect. Psychological Bulletin, 103, 44-56, available via: http://dx.doi.org/10.1037//0033-2909.103.1.44. [ Links ]

Nevin, J. A., & Grace, R. C. (2000). Behavioral momentum and the law of effect. Behavioral and Brain Sciences, 23, 73-130, available via: http://dx.doi.org/10.1017/S0140525X00002405. [ Links ]

Nevin, J. A., Tota, M. E., Torquato, R. D., & Shull, R. L. (1990). Alternative reinforcement increases resistance to change: Pavlovian or operant contingencies? Journal of the Experimental Analysis of Behavior, 53, 359-379, available via: http://dx.doi.org/10.1901/jeab.1990.53-359. [ Links ]

Rescorla, R. A. (1977). Pavlovian second-order conditioning: Some implications for instrumental behavior. En H. Davis & H. M. B. Hurwitz (Eds.), Operant-Pavlovian interactions. Hillsdale NJ: Wiley. [ Links ]

Schuster, R. H. (1969). A functional analysis of conditioned reinforcement. En D. P. Hendry(Ed.), Conditioned reinforcement (pp. 192-234). Homewood, Ill: Dorsey Press. [ Links ]

Shahan, T.A. (2010). Conditioned reinforcement and response strength. Journal of the Experimental Analysis of Behavior, 93, 269-289, available via: http://dx.doi.org/10.1901/jeab.2010.93-269. [ Links ]

Shahan, T. A., & Podlesnik, C. A. (2005). Rate of conditioned reinforcement affects observing rate but not resistance to change. Journal of the Experimental Analysis of Behavior, 84, 1-17, available via: http://dx.doi.org/10.1901/jeab.2005.83-04. [ Links ]

Shahan, T.A., & Podlesnik, C.A. (2008). Conditioned reinforcement value and resistance to change. Journal of the Experimental Analysis of Behavior, 89, 263-298, available via: http://dx.doi.org/10.1901/jeab.2008-89-263. [ Links ]

Shahan, T.A., Podlesnik, C.A. & Jimenez-Gomez, C. (2006). Matching and conditioned reinforcement rate. Journal of the Experimental Analysis of Behavior, 85, 167- 180, available via: http://dx.doi.org/10.1901/jeab.2006.34-05. [ Links ]

Sidman, M. (1960). Tactics of scientific research: Evaluating experimental data in psychology. New York: Basic Books. [ Links ]

Skinner, B. F. (1938). The behavior of organisms: An experimental analysis. New York: Appleton-Century-Crofts. [ Links ]

Staddon, J. E. R., & Cerutti, D. T. (2003). Operant conditioning. Annual Review of Psychology, 54, 115-144, available via: http://dx.doi.org/10.1146/annurev.ps-ych.54.101601.145124. [ Links ]

Stein, L. (1958). Secondary reinforcement established with subcortical reinforcement. Science, 127, 466-467, available via: http://dx.doi.org/10.1126/science.127.3296.466. [ Links ]

Tomanari, G. Y. (2001). Respostas de observação controladas por estímulos sinaliza-dores de reforçamento e extinção. Acta Comportamentalia, 9, 119-143. [ Links ]

Tomanari, G. Y. (2010). Respostas de observação em pombos expostos a apresentações de comida independente de resposta. Acta Comportamentalia, 18, 301-316. [ Links ]

Wike, E. L. (1966). Secondary reinforcement: Selected experiments. Nueva York: Harper & Row. [ Links ]

Williams, B. A. (1994a). Conditioned reinforcement: Neglected or outmoded explanatory construct? Psychonomic Bulletin & Review, 1, 457-475. [ Links ]

Williams, B. A. (1994b). Conditioned reinforcement: Experimental and theoretical issues. The Behavior Analyst, 17, 261-285. [ Links ]

Wyckoff, L. B., Jr. (1952). The role of observing responses in discrimination learning. Part I. Psychological Review, 59, 431-442, available via: http://dx.doi.org/10.1037/h0053932. [ Links ]

Wyckoff, L. B. (1959). Toward a quantitative theory of secondary reinforcement. Psychological Review, 66, 68-78, available via: http://dx.doi.org/10.1037/h0046882. [ Links ]

Zentall, T. R., & Sherburne, L. M. (1994). Transfer of value from S+ to S- in a simultaneous discrimination. Journal of Experimental Psychology: Animal Behavior Processes, 20, 176-183, available via: http://dx.doi.org/10.1037/0097-7403.20.2.176 [ Links ]