Serviços Personalizados

Journal

Artigo

Indicadores

-

Citado por SciELO

Citado por SciELO -

Acessos

Acessos

Links relacionados

-

Similares em

SciELO

Similares em

SciELO

Compartilhar

Salud mental

versão impressa ISSN 0185-3325

Salud Ment vol.32 no.1 México Jan./Fev. 2009

Artículo original

La respuesta emocional a la música: atribución de términos de la emoción a segmentos musicales

The emotional response to music: attribution of emotions words to musical segments

Enrique Flores–Gutiérrez1, José Luis Díaz2*

1 Unidad de Psicofisiología Aplicada, Servicios Clínicos, Instituto Nacional de Psiquiatría Ramón de la Fuente Muñiz. Facultad de Psicología, Universidad Nacional Autónoma de México. floreseo@servidor.unam.mx

2 Departamento de Historia y Filosofía de la Medicina. Facultad de Medicina, Universidad Nacional Autónoma de México. jldiaz@correo.unam.mx

*Correspondencia:

José Luis Díaz.

Departamento de Historia y Filosofía de la Medicina.

Facultad de Medicina,

Universidad Nacional Autónoma de México, UNAM,

México, D.F.

Recibido: 23 de julio de 2008

Aceptado: 29 de agosto de 2008

Abstract

Even though music is usually considered a source of intense, diverse, and specific affective states, at the present time there is not a standardized scientific procedure that reveals with reliable confidence the emotional processes and events evoked by music. The progress in understanding musical emotion crucially depends in the development of reasonable secure methods to record and analyze such a peculiar and universally–sought affective process.

In 1936 Kate Hevner published a pioneer study where she used a list of 66 adjectives commonly used to categorize musical compositions arranged in a circle of eight groups of similar emotions. The volunteers selected the terms that seemed appropriate to categorize their emotional experience while they listened to masterpieces by Debussy, Mendelssohn, Paganini, Tchaikovsky, and Wagner. The results were presented in histograms showing a different profile for each piece. Subsequent studies have advanced in the methods and techniques to assess the emotions produced by music but there are many still unresolved difficulties concerning the criteria to choose the musical pieces, the terms of emotion, the design of the experiment, the proper controls, and the relevant statistical tools to analyze the results.

The present study was undertaken in order to test and advance an experimental technique designed to evaluate and study the human emotions evoked by music. Specifically, the study intends to prove if different musical excerpts evoke a significant agreement in the selection of previously organized emotion terms within a relatively homogeneous population of human subjects. Since music constitutes a form of acoustic language that has been selected and developed through millennia of human cultural evolution for the expression and communication of emotional states, it is supposed that there will be a significant agreement in the attribution of terms of emotion to musical segments among human evaluators belonging to a relatively homogeneous population. The attribution system allowed both to obtain objective responses derived from introspection and to analyze the data by means of an appropriate statistical processing of data obtained in groups of subjects submitted to carefully selected musical stimuli.

Volunteer subjects were 108 college–level students of both sexes with a mean age of 22 years from schools and universities located in the central Mexico. The audition and attribution sessions lasted for 90 min and were conducted in a specially adapted classroom located in each institution. Four criteria were established for the selection of the musical excerpts: instrumental music, homogeneous melody and musical theme, clear and distinct affective tone, and samples of different cultures. The ten selected pieces were: 1. Mozart's piano concerto no. 1 7, K 453, third movement; 2. A sound of the magnetic spectra of an aurora borealis, a natural event; 3. Mussorgsky's Gnome, from Pictures at an Exhibition orchestrated by Ravel; 4. Andean folk music; 5. Tchaikovsky's Fifth Symphony, second movement; 6. << Through the Never>>, heavy metal music by Metallica; 7. Japanese Usagi folk music played with koto and shyakuhachi; 8. Mahler's Fifth Symphony, second movement; 9. Taqsim Sigah, Arab folk music played with kamandja, and 1 0. Bach's Inventions in three parts for piano, BMW 797.

The selected fragments and their replicas were divided in two to five musically homogeneous segments (mean segment duration: 24 seconds) and were played in different order in each occasion. The segments were played twice during the test. During the first audition, the complete piece was played in order for the subjects to become familiar with the composition and freely express their reaction in writing. During the second hearing, the same piece was played in the separate selected segments and the volunteers were asked to choose those emotion–referring terms that more accurately identified their music–evoked feelings from an adjunct chart obtained and arranged from an original list of 328 Spanish words designing particular emotions. The terms had been previously arranged in 28 sets of semantically related terms located in 14 bipolar axes of opposing affective polarity in a circumflex model of the affective system.

The recorded attributions from all the subjects were captured and transformed into ranks. The non–parametric Friedman test of rank bifactorial variance for k related samples was selected for the statistical analysis of agreement. All the data were gathered in the 28 categories or sets of emotion obtained in the previous taxonomy of emotion terms and the difference among the musical segments was tested. The difference was significant for 24 of the 28 emotional categories for α=0.05 and 33 degrees of freedom (Fr ≥43.88). In order to establish in which segments were the main significant differences, the extension of the Friedman test for comparison of groups to a control was undertaken. Thus, after applying the appropriate formula, a critical value of the difference | R1 – Ru | was established at ≥18.59. In this way it was possible to plot the significance level of all 28 emotion categories for each music segment and thereby to obtain the emotion profile of each selected music fragment.

The differences obtained for the musical pieces were established both for the significant response of individual emotion, groups of emotions, and the global profile of the response. In all the pieces used, one or more terms showed significance. Sometimes as many as seven terms appear predominant (Mahler, Mozart). In contrast other segments produce only one or two responses (aurora borealis, Arab music). In most musical segments there were null responses implying that there was an agreement concerning not only the emotions that were present, but also those that did not occur.

Concerning the global response, there were several profiles recognizable among different pieces. The histogram is slanted to the left when positive and vigorous emotions are reported (Tchaikovsky, Bach). The predominance of emotions in the center–right sector corresponds to negative and quiet emotions (Arab music) or in the fourth sector of negative and agitated emotions (Mahler). Sometimes a <<U>> shaped profile was obtained when vigorous emotions predominated (Mahler, Metallica). A bell–shaped response was obtained when calm emotions were reported, both pleasant and unpleasant (Japanese music). There is also music that globally stimulates one of the four quadrants defined in the affective circle, such as pleasant (Mozart), unpleasant (Mussorgsky), exciting (Metallica) or relaxing emotions (Japanese music). The only segment that produced scattered responses in the four sectors of emotions was the aurora borealis. Very similar profiles were obtained with very different pieces, such as the identical responses to Mozart and Andean music. It is necessary to analyze the individual emotion terms to distinguish them. Several common characteristics can be detected in these two pieces, such as fast speed in tempo allegro, binary rhythm, counterpoint figures, and ascending melody, well known features in music composition. In contrast other segments evoked unpleasant responses (Mussorgsky), where fear, tension, doubt or pain was reported. The listener probably concedes a high value to a piece that evokes emotions that normally avoids in the context of a controlled artistic experience.

The cultural factor seems to have influenced the results, since the responses were more defined and robust with familiar types of music so that Japanese and Arab music evoked the least distinctive and robust responses. It would be of interest to perform a similar experiment in Arab and Japanese subjects to compare the response.

If the terms of emotion selected by the volunteer subjects actually corresponded to relatively discrete emotional states, most musical segments appear to evoke an emotional response that is similar among the subjects due to their composition and interpretation characteristics. Musical segments selected for their expressive characteristics seem to generate an emotional response which is similar among listeners with comparable cultural and educational backgrounds. This technique may be useful to generate and analyze specific emotional status in experimentally–controlled situations of musical audition.

Key words: Music, emotion, emotion terms, attribution, inter–valuator agreement.

Resumen

A pesar de que la música se considera habitualmente una fuente de estados afectivos variados diferentes e intensos, no existe una técnica en la ciencia que revele con suficiente fidelidad experimental los procesos y estados emocionales evocados por ella. Es así que el progreso en el entendimiento de la emoción musical depende críticamente del desarrollo de métodos razonablemente seguros para registrar y analizar este peculiar proceso afectivo.

El presente estudio se realizó para desarrollar y probar una técnica diseñada para el estudio de las emociones humanas provocadas por la música. En particular se estudia si diferentes piezas musicales evocan un acuerdo significativo en la selección de términos de la emoción previamente sistematizados entre una población comparable de sujetos humanos. Dado que la música constituye un tipo de lenguaje acústico evolutiva y culturalmente seleccionado para la comunicación de estados emocionales, se puede suponer un acuerdo significativo entre evaluadores de una población homogénea en la atribución de términos de la emoción a segmentos musicales cuidadosamente seleccionados. El sistema de atribución elegido permitió obtener respuestas objetivas, derivadas de la introspección, a segmentos musicales y analizar los datos mediante un procesamiento estadístico apropiado de nivel de acuerdo entre observadores.

Los voluntarios fueron 108 estudiantes con una edad promedio de 22 años, de ambos sexos, de cuatro escuelas de nivel superior en los Estados mexicanos de Querétaro y Guanajuato. Las sesiones duraron 90 minutos cada una y se realizaron en un salón adaptado en cada centro pedagógico. En las sesiones de audición y atribución se tocaron 10 obras musicales: cinco del repertorio clásico, cuatro del inventario popular propio y ajeno, así como la sonorización del espectro magnético de una aurora boreal, un fenómeno natural. Los fragmentos seleccionados, divididos en dos a cinco segmentos de 24seg de duración en promedio, se reprodujeron con diferente orden y en dos pasos consecutivos. Primero se tocó la sección completa para que el oyente expresara libremente sus reacciones por escrito. A continuación se tocaron los segmentos de la misma obra y el oyente escogió términos de la emoción que mejor identificaran su respuesta afectiva a cada uno de ellos a partir de un compendio adjunto. El formato de respuestas presentaba un arreglo donde el sujeto realizó la selección y atribución de los términos de la emoción que le evocaron los diferentes segmentos musicales al tiempo de escucharlos. Para esta tarea se proveyó a los sujetos de un esquema circular de términos de la emoción, anexo al formato, el cual se obtuvo a partir de una lista de 328 palabras en castellano que denominan emociones particulares. Los términos fueron agrupados finalmente en 28 conjuntos y 14 ejes de polaridades afectivas opuestas en un modelo circular del sistema afectivo, con un total de 168 términos.

Para el análisis estadístico, las atribuciones de todos los sujetos participantes fueron transformadas a rangos y se aplicó la prueba no paramétrica de varianza bifactorial de Friedman para k muestras relacionadas como análisis de acuerdo entre observadores. Los datos se agruparon en las 28 categorías emocionales mencionadas y se probaron las diferencias entre los segmentos musicales. Éstas resultaron significativas en 24 de las 28 categorías emocionales para α = 0.05, con 33 grados de libertad (Fr ≥ 43.88). Para establecer en cuáles segmentos se ubicaban las diferencias, se aplicó la extensión de la prueba de Friedman para comparaciones de grupos con un control y se obtuvo un valor crítico de las diferencias, | R1 – Ru | ≥18.59, con lo cual fue posible graficar el nivel de significancia de todas las categorías emocionales para cada segmento musical. De esta forma se obtuvo el perfil emocional específico de cada fragmento de música para la población analizada. Los resultados muestran que en todos los segmentos musicales hay predominio significativo de una o más categorías de la emoción y que éstos son diferentes para la mayoría de los segmentos. Si, como es verosímil suponer, los términos de la emoción elegidos por los sujetos participantes correspondían efectivamente a estados emocionales particulares, entonces la mayoría de los segmentos musicales elegidos como estímulos parecen generar una respuesta emocional semejante y relativamente específica entre los escuchas, en función de las características de su composición. Esta técnica puede ser útil para generar y analizar estados emocionales específicos en situaciones experimentales y controladas de audición musical.

Palabras clave: Música, emoción, términos de la emoción, atribución, acuerdo entre evaluadores.

INTRODUCCIÓN

El sentido y el valor que tiene la música para los seres humanos están dados en gran medida por su notable capacidad para expresar, transmitir y evocar diversas emociones y afectos.1–3 Congruente con tan destacada función personal y social, esta compleja expresión sonora parece ser una de las formas más antiguas, prevalecientes y universales de comunicación humana.2–5 En el mismo sentido se ha mostrado que el estudio científico de la música puede proveer un acercamiento muy valioso para la comprensión de la evolución,6–8 la cognición,9–12 la percepción13–15 y la neurobiología humanas.16–20 Ahora bien, a pesar de esta relación obligada entre música y emoción, la emoción musical y la respuesta afectiva a la música han sido temas de investigación relativamente escasos y recientes.17,21–24

El presente trabajo se aboca al estudio de la respuesta emocional a la música y a la atribución de términos de la emoción a piezas musicales seleccionadas en referencia a los estados de ánimo que su audición provoca en voluntarios sanos. La hipótesis primordial de la investigación supone y predice la producción de estados emocionales específicos con la audición de ciertos tipos de música. En 1936, Kate Hevner publicó un artículo clásico en esta área.25 Su método para recabar respuestas afectivas a la música fue una lista de 66 adjetivos que usualmente se aplican a las composiciones musicales, arreglados en ocho grupos de matices emocionales dispuestos en círculo, colocando juntos términos semánticamente semejantes. Cada oyente contaba con una lista de adjetivos ordenados para seleccionar los que estimara pertinentes a sus propias emociones, evocadas por cada estímulo musical. Al final se comparó el número de votos por adjetivo para obras de Debussy, Mendelssohn, Paganini, Tchaikowsky y Wagner. Los resultados se graficaron en histogramas que mostraron un perfil característico para cada obra con una mayor puntuación en ciertos adjetivos emocionales que supuestamente reflejaban el tono afectivo específico de cada pieza musical. En ese artículo, los resultados reflejan acentuadamente lo esperado de acuerdo con el carácter de cada obra, tal vez por un sesgo debido a la selección de los adjetivos musicales que sugieren directamente dicho carácter. Por otra parte, los sujetos no distinguieron entre las emociones que sentían al escuchar una pieza y las atribuciones que podían proyectar a la pieza musical o la intención del compositor. Tampoco se realizaron pruebas estadísticas más allá de la descripción porcentual.

En un estudio con EEG, realizado por Ramos y Corsi–Cabrera,26 en 1989, se analizó la actividad eléctrica de la corteza cerebral en 14 sujetos adultos a quienes se registró durante un estímulo de música clásica, el llanto de un niño y un periodo de silencio. Ante la experiencia de escuchar música agradable, observaron que el cerebro frontopolar responde con un particular patrón de poder relativo Theta significativamente alto. Posteriormente, en 1996, Ramos et al.30 estudiaron los estados afectivos provocados por obras de música agradable (piezas de Grieg, Sibelius y Smetana) y desagradable (una pieza de Prodromidès). Los sujetos evaluaron las piezas con 32 reactivos escalares continuos. La composición Peer Gynt (El amanecer) de Grieg se consideró la más placentera y el fragmento de la obra Danton de Prodromidès, la más desagradable. Una vez establecido esto, las autoras reclutaron 215 estudiantes en 12 grupos aleatorios que calificaron las dos obras con 27 reactivos escalares continuos. El cuestionario fue validado y resultó útil para evaluar los cambios afectivos.

Por su lado, North y Hargreaves27 analizaron si la valoración de ocho emociones específicas se relacionaba con la representación afectiva en las dimensiones de agrado–desagrado y excitación–calma. Sesenta sujetos escucharon 32 pasajes musicales y valoraron ocho emociones específicas en escalas de 11 puntos. Las emociones valoradas fueron predecibles en términos del potencial de agrado y excitación. Recientemente, mediante estudios experimentales en seres humanos, se ha establecido que la música tiene el poder de producir diferentes efectos neurofisiológicos, relacionados con las emociones que induce.15,17,22–24,28 En general, estos estudios sugieren que los estímulos musicales evocan emociones específicas que permiten evaluaciones afectivas, cognoscitivas y fisiológicas en tiempo real.

En la actualidad es de interés continuar con el desarrollo de métodos para registrar y analizar los procesos emocionales generados por segmentos musicales. Para ello se debe tratar de superar importantes obstáculos metodológicos que no han sido resueltos, en particular los relacionados con la selección de términos de la emoción, la forma de atribución de estos términos a los sentimientos generados por la música y la selección y aplicación de técnicas estadísticas apropiadas para evaluar los resultados. El presente trabajo pretende contribuir al desarrollo de los métodos para lograr registrar y analizar de una manera más fidedigna los procesos emocionales generados por segmentos musicales de tal forma que puedan ser considerados estímulos calibrados para estudiar sus efectos fisiológicos, en particular los cerebrales.

De este modo, el primer requisito difícil de cumplir y estandarizar se refiere a los criterios para seleccionar y presentar los términos de la emoción en diseños experimentales controlados. En un trabajo previo1 propusimos una taxonomía de los términos de la emoción del idioma español en un modelo de dos dimensiones ortogonales, una hedónica (agrado–desagrado) y la otra de activación (calma–excitación). Esto permite la identificación de 28 conjuntos de términos similares y la ubicación de 14 ejes bipolares de 328 términos de la emoción en un diagrama circular que constituye un esquema metódico de términos vigentes de la emoción que se presta para cualquier estudio de atribución emocional. El sistema parece útil para que los sujetos puedan ubicar y seleccionar con relativa facilidad los términos que consideren más precisos para etiquetar los sentimientos que experimentan durante la audición de piezas musicales seleccionadas. De esta forma es posible progresar con el primer requisito de una selección de términos más rigurosa y apropiada.

Además de contender con el problema de la presentación y selección de los términos de la emoción, en este trabajo se explora la posibilidad de evaluar la capacidad de diferentes piezas musicales para evocar emociones discretas y conscientes. El método consistió en la atribución de términos de estados afectivos generados por segmentos musicales representativos de diversas tradiciones y permitió establecer cuáles categorías emocionales se aplican con mayor o menor frecuencia de lo que se esperaría al azar en cada segmento. La aplicación de un análisis estadístico del acuerdo entre evaluadores permitió afirmar cuáles categorías emocionales se atribuyeron a cada segmento, con lo cual se pudo inferir con alguna evidencia cuáles estímulos musicales determinaban cuáles emociones particulares.

Si la música constituye un tipo de expresión o de lenguaje para la comunicación de estados emocionales, puede suponerse que habrá un acuerdo significativo en la atribución de ciertos términos de la emoción a segmentos musicales entre evaluadores humanos independientes. Si esto se comprueba, se justificaría el uso de ciertas piezas musicales como estímulos calibrados para evocar estados afectivos relativamente específicos y analizar correlatos neurofisiológicos de la emoción musical con mayor propiedad y certeza.

MATERIAL Y MÉTODO

Criterios para la selección de los estímulos musicales

El material musical seleccionado consistió en 10 obras. Cinco de ellas corresponden al repertorio de la música <<culta>> en los periodos barroco, clásico, romántico, impresionista y moderno y cuatro al repertorio de música <<popular>> de diferentes nacionalidades y épocas. La pieza restante corresponde a la sonorización de una aurora boreal, un fenómeno natural. Es importante aclarar que el presente estudio no intenta por el momento analizar cuáles elementos musicales particulares tienen que ver con los afectos ni cuáles son los mecanismos involucrados en ello, sino solamente establecer el nivel de acuerdo de la población estudiada para la atribución de términos de la emoción al sentimiento subjetivo que evoca cada pieza tal como ha sido compuesta, interpretada y grabada.

Se establecieron cuatro criterios para seleccionar las obras musicales: 1. tema y melodía homogéneos e identificables; 2. obras exclusivamente instrumentales; 3. segmentos musicales con tono afectivo (<<tema y motivo>> musical) claro y distinto; 4. muestras de diferentes épocas y estilos. La amplia muestra de música <<culta>> entre los estímulos seleccionados se debe a que esta música, también llamada genéricamente <<clásica,>> es una de sus formas más depuradas por implicar extensos conocimientos teóricos y gran habilidad técnica. Para los objetivos del presente trabajo, es de particular relevancia el manejo deliberado y erudito de elementos sonoros como la melodía, el ritmo o la armonía para expresar ideas musicales con cierto tono afectivo. Una de las selecciones, la <<aurora boreal>>, no es propiamente una obra musical, sino secuencias aleatorias en progresiones armónicas que se presentan en la naturaleza. Este segmento plantea si una serie de sonidos naturales tendrá algún significado emocional en la población estudiada.

Obras musicales seleccionadas

Las siguientes son las 10 obras seleccionadas en el orden en que fueron grabadas en el CD de trabajo y que no es el orden de audición en la prueba, ya que la presentación fue contrabalanceada. Los datos discográficos están disponibles por solicitud al correo electrónico de los autores. La palabra clave para cada pieza se pone en negritas para su identificación posterior y a continuación se realiza una breve descripción de cada obra.

1. De Wolfang Amadeus Mozart (1756–1791), Concierto para piano no. 17 K 453, tercer movimiento allegro, escrito en un tiempo rápido (100 golpes por minuto, aproximadamente) con una estructura o forma musical de tema y variaciones característica del periodo clásico.

2. Aurora boreal. Sonorización de la señal electromagnética de una aurora boreal. Aunque no hay tema melódico, ritmo o armonía determinados, se perciben secuencias que incluyen principalmente al 1°, 2°, 3° y 4° armónicos, y aunque parecen combinaciones musicales, se presentan de manera aleatoria.

3. De Modesto Musorgski (1839–1881), en arreglo orquestal de Maurice Ravel (1875–1937), Cuadros de una exposición. De esta obra impresionista se seleccionó el cuadro sombrío denominado El gnomo.

4. Música andina del compositor Arturo Ruiz del Pozo. Tema <<Cumbres>>, interpretado por el grupo Yawar, con instrumentos tradicionales y electrónicos. Tres partes rápidas y una lenta.

5. De Piotr Ilich Tchaikovsky (1840–1893), Sinfonía no 5, segundo movimiento andante cantabile en tiempo lento y moderado. Obra para gran orquesta del periodo romántico. Se seleccionó la reexposición del tema principal que contiene el clímax y se continúa con la cadencia final.

6. Del grupo Metallica, <<Through the Never>>. Rock pesado, estilo heavy metal en ritmo rápido, volumen fuerte, distorsión en la amplificación de la guitarra y el bajo eléctrico. Ritmo con acentos en el segundo y cuarto tiempos.

7. Música japonesa tradicional. Melodía de dominio popular llamada Usagi, tocada con el koto, instrumento de cuerda punteada parecido al arpa, y el shyakuhachi, flauta de bambú de sonido suave y profundo. Tiempo lento equivalente al adagio.

8. De Gustav Mahler (1860–1911), Sinfonía no. 5, segundo movimiento, rápido agitado seguido de una secuencia lenta. Se eligieron dos segmentos consecutivos del inicio del segundo movimiento. Es una obra característica del periodo moderno.

9. Música árabe tradicional. Taqsim Sigah: obra tocada con el kamandja, especie de violín rudimentario. Velocidad moderada con ritmo variable en el estilo maquam característico de la improvisación denominada taqsim en el mundo islámico.

10. De Juan Sebastián Bach (1685–1750), Invenciones a tres partes, BWV 789–801. Son pequeñas piezas para piano a tres voces típicas del periodo barroco. Se eligieron tres de ellas, BWV 797, 796 y 801. Se presentan sólo datos de la 797. Los tiempos musicales para su ejecución son: andante–dulce, allegro y allegro–agitato.

Segmentación y grabación final del material musical seleccionado

De cada una de estas obras se seleccionaron pasajes o segmentos característicos, respetando las frases y los temas musicales, con duraciones de tres a cinco minutos. En algunos casos fue necesario editar el pasaje musical para evitar repeticiones y puentes o enlaces entre temas. Cada pieza fue fraccionada en pequeños segmentos musicales caracterizados por una frase, motivo, periodo musical o el predominio de alguna característica particular que la hiciera diferente y expresivamente homogénea. Los 10 pasajes quedaron con diferente número de segmentos, cada uno con características particulares. De esta manera, de las diez piezas musicales, resultaron en total 34 segmentos, con una duración total de 25min y 28seg. Las características musicales para cada segmento y su duración, se especifican en el Anexo I. Los anexos del presente estudio se encuentran disponibles por correo electrónico.

Una vez editada la música, se grabó el material en un CD con diez pistas y cada una (pieza musical) con sus segmentos. La separación entre pistas y segmentos musicales fue de 10seg para dar lugar a la introspección y la elección de los términos de la emoción en cada segmento.

Sujetos

El estudio se realizó en 108 personas (60 mujeres y 48 hombres), alumnos de cuatro diferentes escuelas de los estados de Querétaro y Guanajuato en nuestro país. La edad promedio fue de 22 años ± 7.67. Participaron cuatro grupos: 1. Primer semestre de la Facultad de Derecho de la Universidad de Guanajuato (38 alumnos, 19 mujeres y 19 hombres, edad promedio 21 años); 2. Primer semestre de la Facultad de Psicología de la Universidad Autónoma de Querétaro (34 alumnos, 26 mujeres y 28 hombres, edad promedio 22 años); 3. Octavo semestre de la carrera de Leyes de la Universidad Santa Fe A.C. en la ciudad de Guanajuato (19 alumnos, 10 mujeres y nueve hombres, edad promedio 22 años); y 4. Alumnos de primer ingreso a la Escuela de Música de la Universidad de Guanajuato (17 alumnos, cinco mujeres y 12 hombres, edad promedio de 22 años).

Modelo de términos de la emoción

En un estudio previo,1 a partir de una lista de cerca de 500 términos de la emoción en castellano, se seleccionaron 328 palabras <<que denotan directa y definitivamente emociones particulares>>. Se identificaron 28 familias de conceptos similares y 14 ejes de emociones opuestas. Los 14 ejes se ubicaron en un diagrama bidimensional de agrado–desagrado y calma–excitación, de tal manera que se establecen cuatro cuadrantes de términos (agrado–calma, agrado–excitación, desagrado–calma, desagrado–excitación). Con el objeto de facilitar a los participantes del presente estudio la identificación de los términos de la emoción más adecuados a los sentimientos que les evocara la música, se les proveyó con una versión compacta del diagrama bidimensional en que aparecen los términos de la emoción para cada uno de los cuadrantes (Anexo II).

El modelo de términos de la emoción se anexó en una hoja aparte con el esquema circular que sólo incluye 168 términos seleccionados por su claridad y frecuencia de uso acomodados en dos círculos concéntricos. En el círculo interno se anotaron los 28 términos representativos de cada grupo de emociones, organizados en los 14 ejes radiales de polaridades opuestas. La disposición del círculo interno también permite ubicar de manera contigua los términos de la emoción más semejantes. El círculo interno se ubica en los cuatro cuadrantes principales limitados por los ejes de agrado–desagrado y tensión–calma. Al círculo externo corresponden otros 28 bloques con cinco términos cada uno, de acuerdo con su similitud semántica, lo que suma 140, es decir, siete grupos de cinco términos por cada cuadrante.

Formato de respuestas

En la hoja frontal de respuestas (Anexo III) aparece una breve introducción a la prueba y los espacios para la ficha de identificación del participante. También hay tres preguntas acerca del tipo de contacto previo con la música. Al reverso se dan las instrucciones para el desarrollo de la prueba y de cómo se debe completar el formato. El formato de respuestas está en las hojas que siguen, impresas con espacios para escribir las atribuciones emocionales durante la audición. Se usó una página para cada pieza musical con sus segmentos. La parte inferior de cada página se usó para la atribución de términos de la emoción a los segmentos musicales de la pieza en turno, según los sentimientos experimentados durante su audición. En la parte superior se dejó un espacio para una narración libre de imágenes, ideas o recuerdos evocados por cada pieza, cuyo análisis no se incluye en este trabajo.

Audición y atribución

La prueba completa duró una hora treinta minutos. El orden de presentación de las piezas fue diferente y contrabalanceado para cada grupo. La reproducción de la música se hizo con un aparato modular Samsung modelo Max 916. Se utilizó el CD previamente grabado con las obras musicales y sus segmentos a una intensidad de entre 40 y 80 dB SPL. Las sesiones de trabajo se llevaron a cabo en un salón de clases de cada escuela acondicionado para la prueba (instalación del aparato de sonido, ambiente tranquilo y aislado). Cada sesión se realizó en seis pasos consecutivos: 1. Presentación e indicaciones para el llenado de la ficha de identificación; 2. Indicaciones para llenar el formato de respuestas; 3. Explicación del esquema de términos de la emoción; 4. Aclaración de dudas; 5. Sesión de audición y atribución; 6. Conclusión y despedida.

Se solicitó a los participantes considerar y anotar el término o los términos del esquema que mejor describieran o especificaran su propia respuesta emocional al escuchar el pasaje musical en turno. Se hizo hincapié en la indicación de expresar en cada término la propia experiencia emocional evaluada por introspección al escuchar la música y no la creencia de lo que la música representa o pretende comunicar. A continuación, se reprodujo el CD preparado previamente para que el sujeto eligiera los términos más indicativos de la emoción que le evocaba cada segmento.

Captura de datos

Cada uno de los 108 sujetos generó en el formato de respuestas un promedio de nueve diferentes términos de la emoción para cada una de las 10 piezas musicales; es decir, tres respuestas en promedio para cada segmento. Esto representó más de 9500 datos que tuvieron que ser ordenados y convertidos a frecuencias de atribución de los 28 términos de la emoción para cada uno de los 34 segmentos musicales. Los datos se concentraron primero en matrices por grupo y finalmente en una matriz general de datos crudos ordenados como filas de 28 términos de la emoción por 34 columnas de segmentos musicales con la puntuación de frecuencias en cada casilla.

Los resultados del total de la población se ordenaron considerando cuatro tipos de datos: 1. las diferentes condiciones de audición (34 segmentos musicales); 2. las categorías emocionales que escogieron como presentes en cada condición (una o más categorías en una gama de 28); 3. la suma de las puntuaciones (frecuencias) para cada categoría emocional en cada condición; y 4. la n por grupo y la N total.

Los datos de atribución de términos de la emoción a los segmentos musicales se vaciaron en formatos diseñados para concentrar las puntuaciones de todos los sujetos (Anexo IV). Se sumaron las puntuaciones de los términos de la emoción por cada conjunto semántico derivando todas las atribuciones en el término principal de cada categoría emocional, según la clasificación realizada previamente.1 De esta manera, en vez de considerar cientos de categorías emocionales, lo cual sería inmanejable, se utilizaron sólo 28 para facilitar el análisis de los datos. Las puntuaciones obtenidas se desahogaron en el programa Excel de Microsoft Corporation, para obtener una matriz de datos crudos de cada grupo (Anexo V).

Estadística

Las características de la muestra para la selección del método estadístico adecuado son las siguientes: 1. incertidumbre sobre el tipo de distribución de la población, 2. grado no estipulado de homocedasticidad necesario para las pruebas paramétricas, 3. datos en una escala ordinal y 4. observaciones no independientes, sino relacionadas. Dadas las características de los datos generados se buscó una estadística no paramétrica. La prueba seleccionada debería establecer: 1. si en el total de los datos hay diferencias significativas en las puntuaciones de atribución de cada categoría emocional para cada segmento musical, 2. en cuál segmento están las máximas puntuaciones y 3. si éstas son estadísticamente significativas en referencia al resto. Finalmente, el análisis de varianza bifactorial por rangos de Friedman para k muestras relacionadas, se eligió como la prueba más adecuada para este caso.29 Para esta prueba, los datos deben presentarse en una tabla de doble entrada que contiene N renglones o filas y k columnas por cada categoría emocional. Los renglones representan los conjuntos de sujetos igualados y las columnas las distintas condiciones en la categoría emocional correspondiente. Cada renglón proporciona las puntuaciones de cada grupo de sujetos en cada una de las k condiciones, es decir, para cada segmento de música.

Para llevar a cabo este análisis fue necesario transformar los datos crudos a rangos. En cada matriz de datos crudos se transformaron las puntuaciones de cada renglón por separado. Los rangos de cualquier renglón varían de 1 a k, es decir, a la puntuación menor se le aplica el rango 1, a la siguiente 2 y así sucesivamente hasta llegar a la puntuación mayor que tendrá el rango 34. Como un paso previo para aplicar la estadística de prueba, los datos de cada categoría emocional de los cuatro grupos se reunieron para obtener una tabla de 4 × 28 por cada categoría emocional. Por ejemplo, para cada término se alinearon los cuatro grupos para obtener así en un renglón adicional la suma de los rangos elevados al cuadrado (Rj2) en cada columna (condición). Una vez obtenidos los rangos en las 28 filas de los cuatro grupos (Anexo VI), se procedió a la aplicación de la prueba de Friedman. La estadística de prueba denotada por Friedman como χ2r también conocida como Fr, se calcula con la siguiente fórmula:

Donde n es el número de filas (bloques) y k es el número de columnas (tratamientos). Rj es la suma de los rangos en la j–ésima columna y  es la sumatoria de los cuadrados de los rangos de todas las condiciones. Los valores críticos de χ2r para distintos n y k se pueden consultar en el Anexo VII.

es la sumatoria de los cuadrados de los rangos de todas las condiciones. Los valores críticos de χ2r para distintos n y k se pueden consultar en el Anexo VII.

Para establecer en cuáles segmentos se situaban las principales diferencias significativas, se aplicó la extensión de la prueba de Friedman para comparaciones de grupos con un control. Al aplicar la fórmula correspondiente, se obtuvo el valor crítico de las diferencias | R1– Ru | ≥18.59, con lo cual fue posible graficar el nivel de significancia de todas las categorías emocionales para cada segmento musical. La fórmula es:

Los datos crudos obtenidos en las pruebas se concentraron en las matrices correspondientes, una para cada grupo (Anexo VIII). El primer tratamiento fue transformar los datos crudos en rangos de Friedman (Anexo IX). Finalmente, la estadística de prueba, el cálculo de significancia y la comparación entre grupos se hicieron en una matriz donde se conjuntaron los datos de los cuatro grupos, ordenados por categoría emocional (Anexo X).

Graficación de resultados

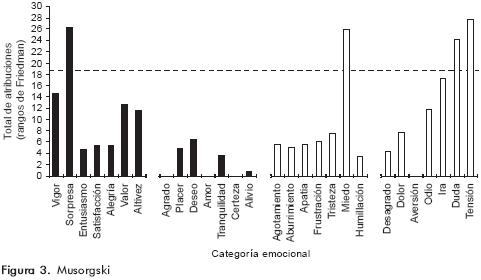

La selección de términos de la emoción de todos los sujetos fue expresada finalmente en histogramas para cada uno de los 10 segmentos musicales elegidos en este trabajo. En la abscisa de cada histograma aparecen los 28 términos emocionales tipo de cada uno de los conjuntos establecidos previamente, con la palabra que representa a cada conjunto entero de términos relacionados a esa emoción. Los 28 términos aparecen conforme al orden establecido en el círculo de la emoción tomando como primero al vigor. De esta manera aparecen en secuencia los cuatro cuadrantes del círculo, delimitados por los ejes de valor hedónico (agradable o desagradable) y de nivel de activación (excitación o relajación). El primer cuadrante con su grupo de siete emociones corresponde a las agradables y vigorosas (barras de color negro), el segundo a las agradables y relajadas (barras de color negro, segundo grupo), el tercero a las desagradables y relajadas (barras blancas, tercer grupo) y el cuarto a las desagradables y vigorosas (barras blancas, último grupo a la derecha). En el eje de las ordenadas aparece el total de atribuciones rectificado por la prueba de rangos de Friedman. Asimismo, en cada histograma se identifica con una línea punteada horizontal el nivel requerido para considerar una respuesta como significativa (p<0.05).

RESULTADOS

A continuación se presentan y describen los resultados obtenidos para cada uno de los diez estímulos musicales. Se muestra sólo el gráfico de un segmento representativo para cada pieza musical.

Mozart (figura 1). Respuesta afectiva robusta inclinada hacia la izquierda, es decir, hacia términos agradables y estimulantes. En este primer cuadrante, cuatro de las siete emociones sobrepasaron el umbral de significación estadística: entusiasmo, satisfacción, alegría y altivez. Tres de las siete emociones positivas y relajadas (segundo cuadrante) alcanzaron también significación: agrado, placer y deseo. Ocho conjuntos no fueron seleccionados por ningún evaluador: agotamiento, apatía, frustración, miedo, humillación, ira, duda y tensión.

Aurora boreal (figura 2). Repuesta dispersa y muy débil, con tendencia a ser más abundante en el tercer sector de términos, que corresponden a afectos negativos y relajados. Hay cinco respuestas apenas significativas: sorpresa, deseo, frustración, desagrado y duda. Varios sujetos calificaron el segmento con tristeza, miedo y tensión, muy cerca del nivel de significación. No hubo ninguna atribución a dolor.

Musorgski (figura 3). Perfil muy asimétrico de respuestas con inclinación hacia el último sector de emociones desagradables y agitadas, como duda y tensión que alcanzan niveles significativos. Miedo y sorpresa resultan muy significativos. Nadie eligió términos de agrado, amor, certeza y aversión.

Música andina (figura 4). Respuesta selectiva hacia la mitad izquierda de la gráfica (emociones positivas). Del primer conjunto de emociones destacan significativamente satisfacción y alegría y del segundo agrado y deseo. Entusiasmo y placer se acercan a los niveles significativos, en tanto que sorpresa es muy escasa en este fragmento. En general, la selección para términos de emociones desagradables fue muy exigua, y en lo particular resultó nula para las de agotamiento, aburrimiento, frustración, miedo e ira.

Tchaikovsky (figura 5). Respuesta intensa y compacta por ser muy robusta y específica para el segundo sector de términos con significados agradables y relajados. Seis de ellos (agrado, placer, deseo, amor, tranquilidad y certeza) rebasan el nivel requerido. La altivez y la alegría se acercan al umbral. No hubo registros de sorpresa, desagrado y aversión.

Metallica (figura 6). Respuesta intensa con valores altos en los extremos derecho e izquierdo (activación) y bajos en el centro del histograma (calma). En el primer grupo, vigor, entusiasmo, satisfacción, alegría y valor, alcanzan niveles significativos. Ira y tensión, del último grupo, también. Respuestas nulas para amor, tranquilidad, certeza, alivio, tristeza y humillación.

Música japonesa (figura 7). Respuesta en forma de campana con los valores más elevados al centro del histograma.

Los niveles significativos estuvieron en el segundo sector para tranquilidad y alivio, en el tercer sector para apatía, frustración, tristeza y en el cuarto sector únicamente para dolor. El primer sector resultó con bajo nivel de atribuciones que además fueron nulas para sorpresa, entusiasmo y alegría; tampoco hubo atribuciones para aversión.

Mahler (figura 8). Respuesta en forma de <<U>>. Predominio del cuarto sector, en particular dolor, ira, duda y tensión. Tres términos del primer grupo alcanzan también valores significativos: vigor, sorpresa y valor. Hay niveles elevados para miedo. Los niveles más bajos se ubicaron en el segundo grupo de términos (emociones relajadas y agradables).

Música árabe (figura 9). Respuesta dispersa y poco robusta. Tranquilidad, agotamiento y duda alcanzan apenas el nivel de significación; alivio y dolor se aproximan. No hay respuestas nulas y predomina ligeramente el tercer sector en conjunto, aunque ninguno de sus componentes haya sido muy significativo.

Bach (figura 10). Respuesta robusta, compacta y específica para el segundo sector de emociones agradables y relajadas. Los siete términos del conjunto (agrado, placer, deseo, amor, tranquilidad, certeza y alivio) rebasaron el nivel de significación y ningún otro. Tristeza se aproxima al umbral y no se registraron respuestas para vigor, aversión, odio e ira.

DISCUSIÓN

Las diferencias entre los histogramas de los diversos segmentos musicales se establecen debido a dos factores: nivel de significado estadístico para cada término de la emoción y perfil afectivo global del segmento. En referencia a los niveles de significado estadístico, es decir, los niveles particulares de respuesta para cada término de la emoción, se puede afirmar que uno o varios aparecen como significativos para cada uno de los segmentos analizados. En ocasiones se ofrecen muchas respuestas predominantes, como ocurre en Mahler con ocho términos significativos, o en Mozart con siete. También hay fragmentos que evocan pocas respuestas que lleguen al umbral, como sucede en la aurora boreal o en la música árabe. El hecho de que en casi todos los segmentos haya respuestas nulas significa que ninguno de los sujetos eligió ciertos términos, lo cual muestra que no sólo se dan acuerdos para la selección de términos, sino también acuerdos para la omisión de algunos otros. Si los términos seleccionados indican emociones relativamente específicas, se puede afirmar que los fragmentos musicales usados como prueba evocan una respuesta emocional particular, lo cual fortalece la hipótesis explorada desde la década de 1930 con otros métodos y enfoques.25,30

La otra característica diferencial de los histogramas es el perfil global de la respuesta, pues cada uno de los fragmentos o estímulos musicales de prueba no sólo evoca la presencia y la ausencia de uno o más términos de la emoción, sino un rasgo global que se puede definir por la forma o perfil del histograma usualmente más pronunciado en un sector particular. El histograma se inclina hacia la izquierda cuando las emociones positivas y vigorosas del primer sector son las predominantes, tal y como ocurre en la música andina. En otras ocasiones, el perfil se hace dominante en el segundo sector de términos de emociones positivas y relajadas. Tal cosa ocurre en Tchaikovski y en Bach, pues en éstos sólo este cuadrante sobrepasa el criterio de significación. Hay también casos de acumulación del lado derecho del histograma, sea en el tercer sector de términos de emociones negativas y relajadas (aurora boreal y música árabe) o el cuarto sector en el extremo derecho con predominio de términos negativos y agitados, como en Mahler.

Se registran casos en que la respuesta se acumula en dos sectores aledaños. El perfil toma entonces forma de <<U>> o de campana. La forma de <<U>> acontece con el predominio de los cuadrantes 1 y 4, como se puede constatar en Metallica o en Mahler. A pesar de la distancia en el histograma, estos son sectores de términos aledaños en el modelo circular de las emociones1 porque la abscisa de los histogramas de respuesta afectiva se inicia por vigor que es el vecino inmediato de la tensión, aunque en el histograma ésta se ubique en el extremo opuesto. Se trata de segmentos que estimulan emociones tanto agradables como desagradables, aunque lo que se define en ellos es el factor de inquietud o agitación indistintamente de su polaridad o valor hedónico. Lo opuesto ocurre cuando la curva toma forma de campana, es decir, cuando los valores altos se agrupan en el sector central, como se puede ver en la música japonesa. En esos casos se seleccionan términos de emociones agradables y desagradables, pero todas ellas caracterizadas por la relajación y la calma.

Con estas evidencias se puede afirmar que hay secuencias musicales que estimulan un grupo de emociones específico y otras que evocan una respuesta más general para un tipo de emociones que tiene una polaridad determinada, como el ser agradables y vigorosas. En la presente muestra hay también música que estimula en forma global uno de los cuatro ejes mayores definidos en el modelo afectivo circular, como son las emociones agradables (Mozart), desagradables (Musorgski), excitantes (Metallica) o relajantes (música japonesa). Esto proporciona un soporte empírico al modelo circular del sistema afectivo integrado por dos ejes fundamentales, uno de agrado–desagrado y otro de excitación–relajación,31,32 cuya variante basada en el idioma castellano fue la empleada en el esquema de clasificación de las emociones1 usado como fuente de los términos en el presente estudio. Se hace necesario entonces considerar si el resultado se produce debido a los criterios de agrupación de las emociones. Si este fuera el caso, se deberían observar respuestas significativas dispersas y salpicadas en el histograma, lo cual ocurrió sólo para la aurora boreal que evoca una respuesta significativa por cada uno de los cuadrantes. Es importante anotar que este sonido no es estrictamente musical en el sentido de que no es creación o artificio humano.

Aunque cada fragmento de música evoca una respuesta particular, no se puede afirmar que la respuesta sea específica pues se evocan respuestas muy similares con música de autores y culturas muy distintos. Por ejemplo, se registran perfiles muy similares o aun indistinguibles en Mozart y en la música andina. A pesar de sus múltiples diferencias estructurales y culturales, se trata de momentos musicales que fácilmente reconocemos como alegres y agradables. Sin embargo, no es posible concluir que desde el punto de vista afectivo sea lo mismo escuchar cualquiera de estos fragmentos, pues un análisis más detallado del histograma muestra que la combinación de las emociones sobresalientes dicen más que el perfil general. Así, en Mozart destacan alegría, placer y agrado, y en la música andina alegría, agrado y entusiasmo. Aunque ambas tienen alegría y agrado con el nivel más alto, la combinación con las otras categorías les da un tono particular y algo diferente que podrá explorarse en mayor detalle. Sin duda, en la evaluación de la música deben participar no sólo el rango de las diferentes emociones que evoca sino factores cognitivos de seguimiento melódico o perceptual de las cualidades o timbres distintivos, entre otros. Además, el grado de familiaridad con un tipo particular de música, las asociaciones biográficas y las imágenes mentales son factores cognoscitivos que seguramente contribuyen a la experiencia estética de la música y que no fueron variables controladas en este estudio.

Con el presente resultado se plantea una investigación estética en referencia a los elementos musicales que puedan ser responsables de tal similitud de respuestas afectivas en fragmentos de autores o tradiciones muy distintos. Dado que se ha elaborado y presentado una descripción musical de cada una de las piezas y de los segmentos utilizados en términos de su estructura (Anexo I), puede intentarse alguna correlación preliminar entre la estructura de la música y la experiencia afectiva de su escucha. Por ejemplo, entre los factores de composición y ejecución comunes a los fragmentos citados arriba (Mozart y música andina) y que comparten una respuesta robusta hacia la izquierda del histograma en emociones de alegría y agrado, se pueden apreciar los siguientes cinco elementos musicales comunes a ellos: 1. velocidad entre moderada y rápida conocida como tiempo allegro, 2. compás binario con los tiempos fuertes por pares, 3. variedad de timbres que llenan el escenario acústico con todo el ensamble, 4. figuras de contrapunto en el acompañamiento haciendo valores más cortos que dan la impresión de mayor dinamismo y 5. líneas melódicas de predominio ascendente que dan un efecto de levantamiento progresivo del ánimo. Estas inferencias no sólo vienen a confirmar experimentalmente principios muy antiguos de composición musical, sino que pueden convertirse en elementos de interés para la estética musical y el estudio de la emoción humana.

En referencia a la experiencia estética evocada por la música parece también relevante subrayar que no en todos los segmentos ocurre una selección de los afectos agradables. En particular destaca que alguna pieza, como El gnomo de Los Cuadros para una Exposición de Musorgski, evoca un perfil de respuestas inclinado hacia la derecha, hacia las emociones desagradables. Es posible que el escucha goce o aprecie esta música, aun cuando le atribuya sensaciones de miedo, tensión, duda o dolor que pueden ser experimentadas y aun buscadas en este fragmento de Musorgski. Esta experiencia estética es compleja y de gran significación ya que el escucha puede otorgar un alto valor a la música por expresar y evocar emociones que normalmente evita, pero que reconoce o experimenta en una situación contenida y a salvo, lo que le permite evaluarlas de manera controlada y novedosa. Algo similar ocurre en expresiones plásticas que expresan contenidos angustiosos, dolorosos o temibles. Fischer y Krehbiel33 solicitaron a voluntarios reportar sus sentimientos al escuchar segmentos musicales y también sus creencias sobre cuál sería la intención comunicativa del músico. La correlación entre los sentimientos y las creencias fue en general positiva, aunque hubo excepciones como un tango de Astor Piazzolla en el cual los sujetos consideraron que la intención del compositor era expresar sentimientos desagradables o angustiosos, aunque reportaron que la música les produjo un intenso agrado.

Otro de los factores que influyen en un estudio como el presente es el cultural. Es de esperar que la música de la cultura a la que pertenece el escucha sea procesada de una manera mucho más directa desde el punto de vista afectivo por la familiaridad con los instrumentos, sentido y estructuras sonoras. Un tema de importancia es detectar los elementos universales y los variables de la respuesta emocional a la música propia y extraña para lo cual será necesario un estudio transcultural. Con los resultados presentes es posible hacer algunas inferencias, pues se incluyeron piezas musicales provenientes de culturas lejanas en tiempo, espacio y tradición a la de los sujetos participantes, en particular la música árabe y la japonesa que, a diferencia de la clásica y popular occidentales, pueden dar entonces pistas para identificar respuestas culturales. Hay dos elementos en las respuestas a estas piezas culturalmente distantes. Tanto la música japonesa como la árabe presentan pocas respuestas nulas en oposición a la música clásica occidental en la cual es frecuente una ausencia de respuesta en varias categorías emocionales. Esto implica que los sujetos reconocen la expresión emocional de la música familiar y no lo hacen en la de otras culturas. De igual forma, la respuesta a las piezas culturalmente ajenas es más dispersa y se inclina hacia emociones desagradables. Es posible que estos mismos fragmentos musicales en poblaciones árabes o japonesas produjeran respuestas más orientadas hacia emociones agradables y más vigorosas. El tema de la variabilidad intercultural es de importancia para poner a prueba la hipótesis, tan repetida pero no debidamente demostrada (Besson y Schon, 2001; Brown, 2001), de que la música es una especie de lenguaje universal de los afectos.

AGRADECIMIENTOS

El trabajo fue realizado como parte de los requisitos para la Maestría en Neurobiología de EOFG bajo la dirección de JLD. EOFG tuvo el apoyo de CONACYT. Los autores agradecen a los sinodales de la tesis: doctores Augusto Fernández–Guardiola (†), Magdalena Giordano Loyola, Raúl Gerardo Paredes Guerrero, Thalía Harmony Baillet, Julieta Ramos Loyo y Julio Estrada, que fueron de enorme ayuda en su desarrollo.

REFERENCIAS

1. Díaz JL, Flores E. La estructura de la emoción humana: un modelo cromático del sistema afectivo. Salud Mental 2001;24(4):20–35. [ Links ]

2. Dissanayake E. Antecedents of the temporal arts in early mother infant interaction, in origins of music. Cambridge, Mass.: MIT press; 1999. [ Links ]

3. Baumgartner T, Lutz K, Schmidt CF, Jäncke L. The emotional power of music: How music enhances the feeling of affective pictures. Brain Res 2006;1075(1):151–164. [ Links ]

4. Huron D. Is music an evolutionary adaptation? Ann NY Acad Sci 2001; 930:43–61. [ Links ]

5. Fukui H. Music and testosterone: a new hypothesis for the origin and function of music. Ann NY Acad Sci 2001;930:448–451. [ Links ]

6. Wallin NL, Merker B, Brown S (Eds.). The origins of music. Cambridge, Mass.: The MIT Press; 2001. [ Links ]

7. Besson M, Schön D. Comparison between language and music. Ann NY Acad Sci 2001;930:232–258. [ Links ]

8. Brown S. Are music and language homologues? Ann NY Acad Sci 2001;930:372–374. [ Links ]

9. Ashby F, Isen A, Turken U. A neuropsychological theory of positive affect and its influence on cognition. Psychological Review 1999;106(3):529–550. [ Links ]

10. Allman JM, Hakeem A, Erwin JM, Nimchinsky E, Hof P. The anterior cingulated cortex: the evolution of an interface between emotion and cognition. Ann NY Acad Sci 2001;935:107–117. [ Links ]

11. Platel H, Baron JC, Desgranges B, Bernard F, Eustache F. Semantic and episodic memory of music are subserved by distinct neural networks. Neuroimage 2003;20:244–256. [ Links ]

12. Peretz I, Zatorre R. Brain organization for music processing. Annu Rev Psychol 2005;56:89–114. [ Links ]

13. Bhattacharya J, Petsche H, Pereda E. Long–range synchrony in the gamma band: role in music perception. J Neurosci 2001;21:6329–6337. [ Links ]

14. Castro–Sierra E. Development of pitch perception in children. Stanford University (tesis doctoral); Stanford: 1989. [ Links ]

15. Peretz I, Gagnon L, Bouchard B. Music and emotion: perceptual determinants, immediacy, and isolation after brain damage. Cognition 1998;68(2):111–41. [ Links ]

16. Bard P, Mountcastle VB. Some forebrain mechanisms involved in expression of rage with special reference to suppression of angry behavior. J Nervous Mental Disease 1948;27:362–404. [ Links ]

17. Blood AJ, Zatorre RJ, Bermudez P, Evans AC. Emotional responses to pleasant and unpleasant music correlate with activity in paralimbic brain regions. Nat Neurosci 1999;2(4):382–387. [ Links ]

18. Parsons LW. Exploring the functional neuroanatomy of music performance, perception, and comprehension. Ann NY Acad Sci 2001;930:211–230. [ Links ]

19. Janata P, Birk JL, vHorn JD, Leman M, Tillman B et al. The cortical topography of tonal structures underlying western music. Science 2002;298:2167–2170. [ Links ]

20. Halpern AR, Zatorre RJ, Bouffard M, Johnson A. Behavioral and neural correlates of perceived and imagined musical timbre. Neuropsychologia 2004;42(9):1281–1292. [ Links ]

21. Blood AJ, Zatorre RJ. Intensely pleasurable responses to music correlate with activity in brain regions implicated in reward and emotion. Proc Natl Acad Sci USA 2001;98:11818–11823. [ Links ]

22. Khalfa S, Schon D, Anton JL, Liegeois–Chauvel C. Brain regions involved in the recognition of happiness and sadness in music. Neuroreport 2005;16:1981–1984. [ Links ]

23. Koelsch S, Fritz T, vCramon DY, Muller K, Friederici AD. Investigating emotion with music: An fMRI study. Hum Brain Mapp 2006;27:239–250. [ Links ]

24. Flores–Gutiérrez EO, Díaz JL, Barrios FA, Favila–Humara R, Guevara MA et al. Metabolic and electric brain patterns during pleasant and unpleasant emotions induced by music masterpieces. Int J Psychophysiol 2007;65(1):69–84. [ Links ]

25. Hevner K. Experimental Studies of the Elements of Expression in Music. American J Psychology 1936;48:246–268. [ Links ]

26. Ramos J, Corsi–Cabrera M. Does brain electrical activity react to music? Int J Neurosci 1989;47(3–4):351–357. [ Links ]

27. North A, Hargreaves D. Liking, arousal potential, and the emotions expressed by music. Scand J Psychol 1997;38(1) :45–53. [ Links ]

28. McFarland RA, Kadish R. Sex Diferences in finger temperature response to music. Int J Psychophysiology 1991;3:295–298. [ Links ]

29. Siegel S. Estadística no paramétrica. México: Trillas; 1985. [ Links ]

30. Ramos J, Guevara MA, Martinez A, Arce C, Del Rio Y et al. Evaluación de los estados afectivos provocados por la música. Revista Mexicana Psicología 1996;13(2):131–145. [ Links ]

31. Russell JA, Carroll JM. On the bipolarity of positive and negative affect. Psychol Bull 1999;125(1):3–30. [ Links ]

32. Watson D, Tellegen A. Toward a consensual structure of mood. Psychol Bull 1985;98:219–235. [ Links ]

33. Fischer B, Krehbiel S. Dynamic rating of emotions elicited by music. Proceedings of the National Conference on Undergraduate Research (NCUR). University of Kentucky, March 15–17. Lexington, Kentucky; 2001. [ Links ]