Servicios Personalizados

Revista

Articulo

Indicadores

-

Citado por SciELO

Citado por SciELO -

Accesos

Accesos

Links relacionados

-

Similares en

SciELO

Similares en

SciELO

Compartir

Revista de la educación superior

versión impresa ISSN 0185-2760

Rev. educ. sup vol.42 no.166 Ciudad de México abr./jun. 2013

Ensayos

La calidad de las universidades públicas estatales en México desde la perspectiva de un multi-ranking

Santos López Leyva*

* Profesor de tiempo completo de la Facultad de Economía y Relaciones Internacionales de la Universidad Autónoma de Baja California, campus Tijuana. Correo e: slleyva@uabc.edu.mx.

Ingreso: 01/04/13

Aprobado: 17/05/13

Resumen

El trabajo integra a las universidades públicas de México en un multi-ranking, instrumento que resulta de la combinación de tres rankings. Como producto de este ejercicio se concluye que es adecuada la elaboración de este tipo de instrumentos, ya que complementan la evaluación institucional que de forma tradicional se lleva a cabo. La perspectiva de un multi-ranking disminuye los efectos perversos de los rankings al lograr la combinación de propósitos, métodos, indicadores e intereses de los usuarios de la educación superior y mejora la eficiencia de la evaluación institucional. El multi-ranking funciona como un promedio de los rankings considerados.

Palabras clave: Calidad de la educación, Evaluación institucional, Evaluación de las universidades, Métodos de evaluación, Ranking de universidades.

Abstract

This paper develops a multi-ranking for public state universities in Mexico, it is elaborated blending three different rankings. This exercise concludes that is appropriate to advance in instruments to complement the institutional forms of evaluation. Using a multi-ranking for university evaluation decreases the adverse effects of rankings as it associates purposes, methods, indicators and stakeholders in higher education. The multi-ranking works as an average of the rankings involved.

Key words: Quality of education, Institutional evaluation, Evaluation of universities, Evaluation methods, Ranking of universities.

Introducción

El presente trabajo cumple con dos propósitos fundamentales, por una parte lleva a cabo un análisis del comportamiento que sigue el subsistema de Universidades Públicas Estatales en México en un listado ponderado, mediante la combinación de tres rankings, para construir lo que se denomina un multi-ranking; además, resalta la importancia de atender la evaluación de las instituciones de educación superior desde esta perspectiva, es decir, mediante la combinación de indicadores de calidad en los que se sustentan los rankings seleccionados.

El primero de ellos es un ranking aparecido en la revista Regional and Sectoral Economic Studies 12(3), publicado por la Euro-American Association of Economic Development Studies (EAAEDS), el cual se elabora con indicadores del comportamiento de las instituciones de educación superior ante las principales variables que considera el Programa de Mejoramiento del Profesorado en México (PROMEP), al que se denomina ranking (EAAEDS). El segundo es el ranking Iberoamericano sir, calculado y promovido por el SCImago Research Group, cuya principal variable de atención la constituye la función de investigación que realizan las instituciones. Por último, se considera el ranking web de universidades (Webometrics), desarrollado desde 2004 por el laboratorio de Cibermetría del Consejo Superior de Investigaciones Científicas de España, el cual se basa en la presencia que tienen las instituciones de educación superior en la web. Mediante la combinación de estos tres instrumentos se construye un multi-ranking.1

A partir de una elaboración de este tipo se llega a la conclusión de que las instituciones de educación superior en México, al revisar sus políticas para mejoramiento de la calidad y, por ende, su posición en los rankings, tendrían que hacerlo desde la perspectiva de un multi-ranking, ya que de esta forma sería mayor el número de variables e indicadores a tomar en cuenta en la evaluación tanto en el contexto nacional como internacional. Existen autores que recomiendan la realización de agrupamientos de instituciones de acuerdo a su calidad y sus funciones para llevar a cabo ejercicios de evaluación comparada, o bien mediante la construcción de conglomerados (clústeres), con la finalidad de potencializar los ejercicios de evaluación institucional (Baraibar y Luna, 2012; García-Aracil y Palomares-Montero, 2012; Ordorika, Rodríguez, Lozano y Márquez, 2009; Palomares-Montero y García-Aracil, 2011; Horstschräer, 2012).

Los rankings y su desarrollo

En la actualidad los rankings han logrado popularidad como instrumentos para clasificar las instituciones de educación superior de acuerdo a criterios de calidad, pero estos procesos de jerarquización no son nada nuevos. Shin y Toutkoushian (2011) señalan que tienen su origen en 1925, cuando Donald Hughes elaboró un ranking mediante la evaluación por pares para los programas de graduados en los Estados Unidos. Por otra parte, Hazelkorn (2011), recurriendo a Webster (1986), señala que el hombre quien inventó los rankings fue James Mckeen Cattell con su trabajo American Men of Science publicado en 1910.

En el presente, según Morphew y Swanson (2011), los rankings deben ser atendidos por las universidades ya que aportan varias lecciones a considerar, entre ellas, las siguientes: a) este sistema de evaluación es una realidad y resulta difícil que se abandone ya que se ha vuelto muy popular, por lo que las universidades deben atender su participación con el mismo cuidando que vigilan el mejoramiento de su calidad; b) si las universidades, por determinadas circunstancias, no pueden mejorar su posición en los listados, cuando menos, deben aspirar a no perder lugares; c) las técnicas utilizadas para participar en estos procesos se equiparan a las técnicas manejadas en las justas deportivas, las universidades han movido todo lo que tienen a su alcance para incorporase a los rankings o bien para mejorar su posicionamiento, y d) toda universidad que participa en estos modelos no debe desatender elementos como la equidad, la cual constituye una dimensión importante en los diferentes mecanismos de evaluación.

Los rankings presentan dos grandes dificultades, tanto en su elaboración como en su aplicación, según establecen Van Vught, Westerhejden y Ziegele (2012), la primera proviene de la gran diversidad de modelos de instituciones de educación superior, la variedad de misiones que éstas cumplen en la sociedad y de la pluralidad de actividades que desarrollan; por otra parte, se encuentra la dificultad derivada de los intereses de los diferentes sujetos involucrados, donde se hallan estudiantes, académicos, empleadores, líderes institucionales, responsables y diseñadores de políticas.

Márquez (2010) reconoce que estos instrumentos parecen brindar respuesta al propósito de establecer comparaciones, bajo criterios de competencia, entre las instituciones de educación superior, sin embargo, presentan una serie de problemas, entre ellos: la parcialidad de los elementos que se consideran para jerarquizar las instituciones; el ignorar las diferentes trayectorias históricas y diversidad de características que guardan las instituciones, y las limitaciones que presentan las metodologías que sirven de base a la jerarquización.

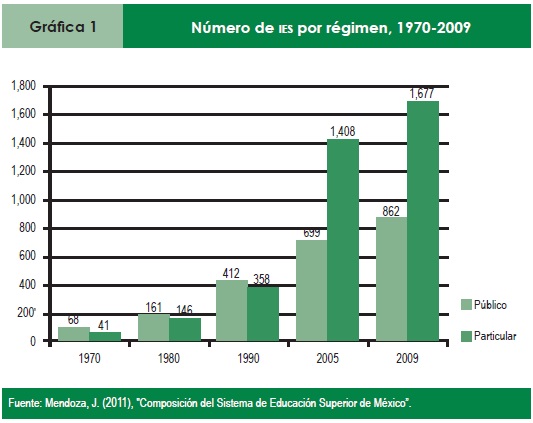

Aunque se menciona que no existen evidencias claras de que los rankings contribuyan en la calidad institucional, de mejor manera, parecen tener efectos negativos en las conductas de las instituciones (Shin, 2011). El mismo autor menciona que se deben estudiar de forma adecuada con la finalidad de minimizar los problemas y mejorar sus resultados en la clasificación de las universidades. Estos instrumentos han proliferado y seguirán aumentando debido a la masificación de la educación superior, en matrícula e instituciones, al incremento de la competencia entre las instituciones y al fenómeno de internacionalización de este nivel educativo (Teichler, 2011).

Ante este tipo de dificultades han surgido propuestas que tienen el propósito de concertar y regular la construcción de los rankings, por ejemplo Logden (2011), establece siete etapas a seguir en la elaboración de un instrumento de este tipo: 1) definir las razones y motivos para la construcción de un ranking; 2) seleccionar las medidas adecuadas y el comportamiento de los indicadores; 3) establecer los mecanismos para la recolección de los datos; 4) especificar el comportamiento de los indicadores conforme a la escala establecida; 5) constituir criterios de estandarización de las medidas antes de aplicarlas a nivel agregado; 6) precisar el peso que tendrá cada índice antes de considerarlo en el valor general, y y) creación del índice que refleje el comportamiento general de cada universidad. Por último, estaría la tarea de elaborar el listado de acuerdo al valor alcanzado por cada institución.

Por su parte, Martínez Rizo (2011) señala que, para que un ranking se pueda considerar de buena calidad, debe contar con los siguientes elementos: 1) identificación clara de los evaluados; 2) definición precisa de la noción de calidad que se espera tengan los evaluandos; 3) calidad de la información que se utilice para cada indicador; 4) justificación sólida de la forma en que se agregarán las mediciones de los indicadores; 5) suficiente precisión en las mediciones; 6) identificación de los estándares de referencia; y) consistencia de los resultados y las tendencias resultantes, y 8) correcta formulación de los juicios a los que se llega por el hecho mismo de hacer un ranking.

También se encuentran esfuerzos institucionales encaminados a lograr un mejoramiento de estos instrumentos tanto desde su construcción como en su uso, en tal sentido, en 2004 el Centro Europeo para la Educación Superior de la UNESCO y el Instituto para las Políticas en Educación Superior de Washington, D. C. fundaron el Grupo Internacional de Expertos en Rankings, el cual trabajó en la preparación de un reglamento para la elaboración y diseminación de estos instrumentos, dando a conocer, el 20 de mayo de 2006, The Berlin Principles on Rankings of Higher Education Institutions. En total son dieciséis principios estructurados en cuatro partes, que se presentan a continuación (Buela-Casal et al., 2010; Institute for Higher Education Policy, 2006; McCormick, 2008).

Parte A). Propósitos y metas de los rankings, que se expresan en los siguientes principios: 1) constituirse en uno de los diversos enfoques de evaluación de la educación superior que considera insumos, procesos y resultados; 2) tener claridad sobre sus propósitos y sus grupos objetivo; 3) reconocer la diversidad de instituciones y considerar las diferentes misiones y metas de las instituciones en el reporte; 4) proporcionar claridad acerca de las fuentes de información que se disponen y el mensaje que cada una de las fuentes suministra, y 5) especificar el contexto lingüístico, cultural, económico e histórico del sistema que se observa.

Parte B). Diseño y ponderación de los indicadores, que atienden los principios de: 6) ser transparente en relación con la metodología utilizada para la construcción del ranking; y) seleccionar indicadores por su relevancia y validez; 8) medir los resultados de forma preferente sobre los insumos, siempre que esto sea posible, 9) establecer los pesos de cada uno de los indicadores usados y los límites entre los que se pueden mover.

Parte C). Recolección y procesamiento de la información, con los principios: 10) atender las normas éticas y las recomendaciones de buenas prácticas declaradas en estos principios; 11) utilizar datos debidamente comprobados o cuya comprobación sea posible; 12) incluir solo datos que se recojan mediante la utilización de procedimientos científicos; 13) aplicar medidas de aseguramiento de la calidad en el proceso de construcción de estos rankings, y 14) aplicar medidas organizacionales que mejoren la credibilidad de los rankings.

Parte D). Presentación de los resultados de los rankings, bajo los principios: 15) proporcionar a los consumidores un entendimiento claro de los factores usados para desarrollar los rankings, y ofrecer una muestra sobre el comportamiento de los mismos, y 16) ser compilado o agrupado de tal manera que elimine o disminuya los errores que presentan los datos originales y organizados de tal manera que los errores o fallas se puedan corregir.

Existen opiniones en torno a que pese a todas estas recomendaciones e instrumentos para mejorar los rankings, no constituyen una buena medida de la calidad de la institución, en este sentido, Pérez-Esparrels y López (2009, p. 328) señalan que:

"...los rankings llevan implícito una posición para cada institución lo que hace inevitable las comparaciones. El problema surge cuando se identifica una mejor posición con una mejor calidad, dado el amplio espectro que abarca este concepto".

Sin embargo, con el avance en la información en el tratamiento de los datos y en general en el trabajo de investigación institucional, es posible relacionar de mejor manera estos listados de instituciones con el aseguramiento de la calidad y con los mecanismos de rendición de cuentas. En un trabajo desarrollado por Federkeil (2008), se relaciona en forma adecuada los sistemas de rankings con el aseguramiento de la calidad en educación superior.

Los beneficios de un multi-ranking

Las universidades, al atender el mejoramiento de su calidad mediante la designación de su posicionamiento en un tipo de ranking, deben pensar en la utilización de un proceso multi-ranking, ya que ello les puede reportar múltiples beneficios. Los frutos provenientes de utilizar un instrumento de este tipo pueden aparecer desde diferentes perspectivas, una de ellas es que, al ser una herramienta plurifuncional, puede atender las diferentes funciones y misiones de una institución. Es multinivel porque considera la calidad que observa la institución en los diferentes niveles educativos que integra; multidimensional al reflexionar la dimensión interna de la institución, así como los espacios regionales, nacionales e internacionales donde se involucra la institución. Puede atender a diferentes visiones de la calidad, tanto como a distintos indicadores desde el enfoque cuantitativo como cualitativo de la investigación institucional. También es posible ensayar diferentes métodos de evaluación de la calidad de las instituciones. Otro elemento para reflexionar la calidad de una universidad por medio de un multi-ranking es la atención de los usuarios, ya que estos cuentan con diferentes perfiles e intereses.

Van Vught y Westerheijden (2012) hacen una revisión de algunos rankings que se utilizan en la actualidad; derivado de ésta, formulan una serie de críticas a estos instrumentos y expresan la necesidad de una perspectiva desde el multi-ranking para observar la calidad de una institución de educación superior. Establecen doce puntos de partida, los cuales dirigen la atención hacia la utilización de un multi-ranking. 1) atendiendo a los principios de Berlin, un multi-ranking facilita la definición de los grupos objetivo, el tipo de indicadores a utilizar y la forma de presentar los resultados; 2) los rankings y el aseguramiento de la calidad constituyen dos mecanismos que se deben complementar, pero también se pueden integrar con ejercicios de rendición de cuentas; 3) los grupos objetivo presentan diferentes motivaciones al consultar un ranking, lo cual se puede enfocar de mejor manera desde la perspectiva de un multi-ranking; 4) resulta más fácil hacer comparaciones entre los campos disciplinarios que practican las universidades; 5) desde esta perspectiva se atiende la multidimensionalidad; 6) la posible diversidad en la utilización de indicadores; 7) una mayor posibilidad de analogías internacionales; 8) se tiene la oportunidad de hacer comparaciones robustas por grupos de instituciones y no en forma de tablas jerarquizadas desde 1 hasta n; 9) se cuenta con mayores posibilidades en la utilización de datos, así como el establecimiento de relaciones funcionales entre estos datos; 10) se consiguen mejores reflexiones en cuanto a los posibles efectos perversos en la utilización de rankings; 11) se puede involucrar a los diferentes interesados en el diseño de los instrumentos, y 12) existe la posibilidad de utilizar mecanismos que permitan una mejor y más amplia evaluación de la calidad de las instituciones.

Ranking EAAEDS

Este ranking es presentado por la revista Regional and Sectoral Economic Studies publicada por la Euro-American Association of Economic Development Studies (López-Leyva, 2012).

El instrumento trabaja con siete variables, las cuales son: 1) profesores de tiempo completo (PTC); 2) PTC con reconocimiento vigente de perfil deseable en el Programa de Mejoramiento del Personal Académico (PROMEP); 3) PTC con reconocimiento en el Sistema Nacional de Investigadores (SNI); 4) PTC con estudios de posgrado; 5) número de programas de posgrado en el Programa Nacional de Posgrados de Calidad (PNPC); 6) cuerpos académicos consolidados reconocidos por PROMEP, y y) cuerpos académicos en consolidación.

Para la elaboración del índice que refleja el comportamiento general de la institución, primero se elaboraron tres índices, los cuales se expresan a continuación.

Índice de Potencialidad Académica General (IPAG), el cual se elaboró con el número de PTC con perfil deseable, el número de PTC miembros del SNI y los PTC con nivel de posgrado.

El Índice de Potencialidad Académica Individual es calculado para cada universidad y resulta de la división del índice anterior entre el número de profesores tiempo completo de cada institución.

Un tercer es el Índice de Competitividad Académica de los profesores con posgrado de cada institución, el cual resultó de la siguiente ecuación:

CA= 3D + 2M + E + 2(CAC) + CAEC

CA= Competitividad Académica

D= Número de programa de Doctorado en el PNPC

M= Número de programas de Maestría en el PNPC

E= Número de programas de Especialización en el PNPC

CAC= Cuerpos Académicos Consolidados

CAEC= Cuerpos Académicos en Consolidación

Mediante la estandarización de estos tres índices se elaboró un índice general en el cual se basa la construcción del mencionado ranking. (Tabla tres).

Ranking Iberoamericano SIR

La primera edición de este ranking fue en 2010, actualmente es calculado y promovido por el SCImago Research Group, fundado en 2008; la información que maneja proviene de SCOPUS. En 2010 integró a 607 universidades, para 2011 este número se incrementó a 1,369 y en 2012 a 1,401 instituciones.

El mayor peso de este ranking se encuentra en la función de investigación de las instituciones, pues su función es mostrar un perfil detallado de la actividad investigadora de las universidades basándose en datos cuantitativos.

Los indicadores que maneja son los siguientes:

Producción científica. Es medida por el número de publicaciones de la institución en revistas científicas.

Colaboración internacional. Se mide por la proporción de publicaciones científicas de una institución que han sido elaboradas por sus académicos conjuntamente con profesores de instituciones de otros países.

Calidad Científica Promedio. Impacto científico de una institución después de eliminar la influencia del tamaño y el perfil temático de la institución.

Porcentaje de publicaciones en revistas del primer cuartil del SCImago Journal Rank (SJR). Indica el porcentaje de publicaciones que una institución ha publicado en revistas que se encuentren en el primer 25% del indicador SJR.

Razón de Excelencia. Es el porcentaje del producto de una institución que se encuentra incluido en el 10% de los trabajos más citados del mundo en sus respectivos campos científicos. La participación de las universidades mexicanas en este ranking se presenta en las columnas IV, V y VI de la tabla tres.

Ranking Web de Universidades (Webometrics).

Los autores de este instrumento empiezan por reconocer que, en la actualidad, la web académica se ha convertido en una fuente de conocimiento, incluso, en un medio poderoso para la comunicación científica y cultural, también los sitios web constituyen el instrumento más eficiente y barato para el impulso a las tres actividades sustantivas de las instituciones de educación superior: docencia, investigación y transferencia de conocimiento (Aguillo, Ortega y Fernández, 2008).

El propósito de este ranking es motivar a instituciones y académicos para que tengan una presencia en la red que refleje adecuadamente sus actividades. Si las instituciones no manifiestan en forma apropiada sus actividades en la web, la invitación es para que reconsideren su política en estos espacios promoviendo un incremento sustancial en la calidad y volumen de sus publicaciones electrónicas. Reporta una calificación por dominio institucional en la Web, si las instituciones cuentan con más de un dominio, éstas son calificadas de acuerdo con el número de dominios de que disponen.

Aguillo et al., (2008) establecen que existen tres aspectos claves a medir en una red académica: el tamaño, que se refiere al volumen de la información publicada; la visibilidad, el número de enlaces externos que recibe el dominio, y la popularidad, el monto de visitas o visitadores que tiene la página.

El Factor de Impacto de la Web (WIF) está compuesto por cuatro indicadores:

Tamaño (S). Número de páginas recuperadas de Google (10%)

Visibilidad (V). Se cuenta por el número de enlaces externos recibidos, multiplicado por los dominios de referencia a estos enlaces, de acuerdo con los datos históricos de Majestic seo. (50%).

Archivos Ricos (R). Se consideran sólo los archivos en los siguientes formatos: Adobe Acrobat, Adobe PostScript, Microsoft Word y Microsoft Power Point (10%).

Académicos (Sc). Artículos publicados en Google Scholar y los reconocidos por Scimago sir (30%).

Aunque el peso de estos indicadores puede cambiar, Aguillo et al., (2008) establecen una fórmula para el cálculo de este ranking:

WR=2xRank (S) + ixRank (R) +ixRank (Sc) + 4xRank (V)

Donde S=Tamaño R=Archivos ricos Sc=Número de artículos V=Visibilidad

Una de las limitaciones que señalan Aguillo et al., (2008) es que, desafortunadamente, las instituciones cuentan con más de un dominio principal en la red y usan diferentes nombres para cada dominio, lo cual entorpece la elaboración del instrumento.

En el comportamiento de este ranking se demuestra que los resultados más sobresalientes, es decir, las mejores ubicaciones en el listado, se las adjudican las universidades europeas y norteamericanas, en contraste con otros rankings donde se observa el dominio de las instituciones de los Estados Unidos (Aguillo et al., 2008). El comportamiento de las instituciones de nuestro interés se encuentra en las columnas VII, VIII y IX de la tabla tres.

Un resumen de los indicadores que presenta cada ranking se aprecian en la tabla uno.

La tabla uno presenta los indicadores de cada uno de los rankings, el EAAEDS contiene siete indicadores cuyo centro es el núcleo académico que forman los profesores de tiempo completo de la universidad, de ello se deriva nuestro interés, pero además es desarrollado en forma exclusiva para las universidades públicas de los estados en México. El ranking Iberoamericano tiene su centro de atención en la producción científica, esto se puede observar en los cinco indicadores; por otra parte, el Webometrics pone atención en la difusión del quehacer científico de la universidad a través de un instrumento que ella misma puede elaborar y controlar, que es su página web. Se seleccionaron estos tres rankings ya que presentan distintos objetivos e indicadores, pero además, en ellos aparecen las 39 instituciones que tiene en su lista el PROMEP en la categoría de universidades públicas de los estados.

Métodos y datos

El espacio de trabajo está constituido por el sistema de universidades públicas de los estados en México que, en 2011, según el PROMEP, eran 39 instituciones. Los nombres de éstas, los acrónimos utilizados y el número de profesores aparecen en la tabla 2.

La tabla 3 presenta tres rankings donde participan las universidades públicas estatales de México. Primero aparece el ranking desarrollado por la revista Regional and Sectoral Economic Studies 12 (3) (López-Leyva, 2012). El segundo es el ranking Iberoamericano y, por último, se presenta el ranking Webometrics.

La construcción del multi-ranking

Para la construcción de este instrumento se tomó primero el ranking Iberoamericano considerando la posición de cada una de las 39 instituciones, este lugar se tradujo a proporciones dividiendo el lugar de cada universidad entre el número de instituciones, para 2011 incluía a 1,369. En este sistema de proporciones, las universidades con posición baja en el ranking alcanzan una proporción mayor por lo que, para invertir estos valores, se les restó la unidad, dando como resultado valores negativos; por ello, se multiplicaron por (-1) y estos números se multiplicaron por 100. Los resultados aparecen en la columna IV de la tabla 4.

En cuanto al ranking Webometric, la proporción se encontró mediante la división del lugar de cada universidad entre 19,403 que era el total de universidades a nivel mundial incluidas este ranking en 2011. Se presentó el mismo fenómeno que las universidades mejor ubicadas alcanzaron una proporción menor, ya que el listado es de números ordinales donde los primeros lugares son números más pequeños, por tanto, al contar con un numerador menor, la proporción también es más reducida, por lo que se siguió el mismo procedimiento que para el ranking Iberoamericano, se le restó uno, se multiplicó por (-1) y después se multiplicó por i00. Los resultados aparecen en la columna V de la tabla 4. En la columna tres aparece el multi-ranking, el cual es resultado de sumar las columnas IV, V y VI.

Análisis y discusión

Los tres rankings utilizados atienden, en lo fundamental, a los principios de Berlin al contemplar los indicadores que dichos principios establecen; para su elaboración atienden las etapas que Logden (2011) sugiere para la construcción de un instrumento de este tipo. Sin embargo, de manera específica, cada uno de los tres contempla un espacio reducido del quehacer de una institución de educación superior, por lo que, de forma particular, sólo atienden una perspectiva corta de la evaluación de una universidad, de la cual proviene la conveniencia de utilizar un multi-ranking, o bien otras formas de agrupamiento de las instituciones.

El ranking EAAEDS fluye bajo una representación muy conectada a la actividad académica al tener en el centro de su construcción a los profesores de tiempo completo de la institución, pues de la cantidad de profesores con que se cuente y de la habilitación que éstos tengan dependen, en gran medida, las otras variables del ranking. Esto se debe a que un académico, para obtener el reconocimiento de perfil deseable de parte de PROMEP, necesita contar con la categoría de PTC pero, además, mostrar buena disposición en la docencia, la investigación y la difusión del conocimiento, así como en la realización de tareas relacionadas con la administración y gestión de la academia. Lo mismo sucede con el SNI: para ser miembro de este sistema se debe ser profesor de tiempo completo, pero además mostrar resultados en las tareas de investigación y en la formación de nuevos investigadores. Algo similar acontece con la adscripción de programas de posgrado al PNPC, donde la principal variable para que un posgrado sea considerado de calidad es la habilitación de un núcleo básico que constituya el sostén académico del programa. En el mismo sentido, quienes participan en la conformación de cuerpos académicos son los PTC, para ello deben contar con la habilitación suficiente pero, además, tener la disposición para la realización de trabajo académico en equipo. Por lo tanto, en el centro de este ranking se encuentra la planta de profesores de tiempo completo tanto en su número como en la habilitación y los logros alcanzados por éstos.

En el listado de las universidades que están bajo este esquema se encuentran instituciones que tienen buen desempeño por el número de profesores, tal es el caso de la Universidad de Guadalajara que, en 2011, contaba con 3,608 académicos de este tipo; este número de académicos y el desempeño de los mismos llevan a esta institución a aparecer en primer lugar en todos los rankings; en el mismo caso se encuentran las universidades UANL, con 2,291 profesores de tiempo completo; UV con 1,929 profesores y la BUAP con 1,946 académicos. Todas ellas aparecen en los primeros lugares en los rankings. Otro ejemplo es la Universidad Autónoma del Estado de Morelos que, con 475 profesores en el mismo año, aparece en segundo lugar en el multi-ranking y en el EAAEDS y en el cuarto lugar en el ranking Iberoamericano. Esta última institución es la que presenta el mayor rendimiento de sus académicos, lo cual se observa en el Índice de Potencialidad Académica Individual (IPAI) (López-Leyva, 2012), en el cual la UDG figura en el lugar número 12.

En cuanto al ranking Iberoamericano, como sus autores lo mencionan, su centro de atención es la investigación en la universidad, pues los cinco indicadores que contempla están relacionados con esta función. Su primer indicador es el número de artículos científicos publicados por los investigadores en revistas indexadas en el contexto internacional. El segundo se refiere a la colaboración internacional y también mide la colaboración que se establece con investigadores de otros países para la publicación de artículos científicos; lo central sigue siendo la publicación, pero ahora en forma de grupo con investigadores extranjeros. En el tercer indicador se elimina el área donde la institución sobresale; constituye una media de las publicaciones pero sin atender el tamaño de la institución, por eso es un promedio.

El siguiente indicador también está referido a publicaciones científicas, pero ahora en el ranking de revistas científicas que el mismo grupo SCImago elabora; solamente toma en cuenta las publicaciones aparecidas en el primer cuartil del ranking de revistas elaborado por este grupo. El último indicador, denominado razón de excelencia, se refiere al porcentaje de publicaciones que se encuentra incluido en el 10% de los trabajos más citados en cada uno de los campos científicos. Como se puede observar, los cinco indicadores en que se basa este ranking están relacionados con la producción de artículos científicos en revistas indexadas. La información con la que trabaja este listado de instituciones proviene de SCOPUS, por ende, las revistas científicas que toman en cuenta deben pertenecer a este banco de información científica.

El tercer ranking, Webometrics, se sustenta en la evaluación de las páginas web de las instituciones de educación superior; en 2011 incluía 19,403 instituciones y, para febrero de 2013, 21,250. El factor dominante en este ranking es la visibilidad de la página institucional, medida por el número de enlaces externos que tenga dicha página; los datos son tomados de Majestic seo, el mayor proveedor de información sobre páginas y enlaces en el mundo. Cabe aclarar que, para 2013, cambió el peso de los factores, pero este artículo se basa en la metodología presentada en 2011. El siguiente indicador, por su porcentaje en el peso para la evaluación, es el de académicos, que toma en cuenta los artículos científicos aparecidos en Google Scholar y los reconocidos por SCImago; aquí de nueva cuenta aparece la investigación, pues en ambos casos los artículos provienen de revistas indexadas. Otro indicador más es el tamaño, medido por el número de páginas, dominios y subdominios, reconocidos por Google, con que cuenta la institución; este indicador se conoce como presencia. El último indicador es el de archivos ricos, en el cual sólo figuran los archivos aparecidos en Acrobat, Post Script, Word y Power Point.

En este ranking se pueden encontrar universidades que tienen buen comportamiento académico en los otros listados, pero que aquí no aparecen en los primeros lugares, como la UAMOR que llega a ocupar el segundo lugar en el EAAEDS y en el multi-ranking y aquí parece en lugar número 13; esta institución, sin duda, ha descuidado su lugar en el ranking. La UNISON, en cambio, ocupa posiciones abajo en los otros rankings y en este aparece en tercer lugar. Otro elemento que se observa es la gran distancia que hay en el ranking entre las universidades mexicanas: la UDG, por ejemplo, aparece en el lugar 493, mientras que la UDO se encuentra en el lugar 9,010.

Como se observa en los apartados anteriores, cada uno de los rankings muestra sus criterios, funciones, indicadores y grupos objetivo; lo más recomendable, entonces, es trabajar en la realización de agrupamientos.

Otro elemento que posibilita el uso del multi-ranking son las comparaciones robustas entre grupos de universidades; es posible agrupar instituciones que han manifestado éxito en el posgrado, en la formación de cuerpos académicos, e instituciones que han mejorado sus publicaciones o que han logrado difundir mejor sus actividades y que han llevado a cabo ejercicios comparativos de evaluación. Para ilustrar este caso se encuentra el trabajo desarrollado por un equipo académico de la Dirección General de Evaluación Institucional de la Universidad Nacional Autónoma de México (Ordorika et al., 2009). Este reporte hace una comparación de la función de investigación de universidades mexicanas en cinco rubros: 1) Información general de cada universidad donde se presentan datos de la matrícula, personal académico y subsidio; 2) participación de las instituciones en el Sistema Nacional de Investigadores; 3) artículos científicos en revistas indexadas; 4) programas en el Padrón Nacional de Posgrados de Calidad y 5) cuerpos académicos consolidados y el total de cuerpos académicos. Este no constituye un ranking pero si un buen ejercicio de comparación de universidades mexicanas, de tal manera que las evaluaciones y acreditaciones tradicionales de las instituciones de educación superior que se realizan en México, para una evaluación más integral, deberían de acompañarse de este tipo ejercicios.

La construcción de un multi-ranking y los ejercicios de evaluación comparada constituyen elementos que aminoran los efectos perversos que llevan, en sí, los rankings y brindan espacios para que se sientan incluidos diferentes tipos de interesados en observar la calidad de las universidades.

Concebir la evaluación de la calidad de una institución desde la perspectiva de un multi-ranking es tener un acercamiento a las otras dos formas de evaluación de una universidad: por un lado, al aseguramiento de la calidad por la vía de los indicadores y, por otro, a la rendición de cuentas por la vía de presentación de resultados.

En México, el Comité de Administración y Gestión Institucional, perteneciente a los Comités Interinstitucionales de Evaluación de la Educación Superior (CIEES), en su marco de referencia, considera 16 categorías con 158 indicadores, lo cual constituye un espacio amplio para la evaluación de una institución; no obstante, ésta constituye una evaluación cargada hacia los procesos y muy reducida en ponderación de los resultados, por lo que la aplicación de un criterio de multi-ranking de manera conjunta con la evaluación de procesos, constituye un mecanismo de evaluación más amplio y más integral.

Es posible encontrar otras prácticas de agrupamientos, por ejemplo, para el caso de las universidades españolas existen estudios a los que denominan agrupaciones alternativas (García-Aracil y Palomares-Montero, 2012; Palomares-Montero y García-Aracil, 2011). Estas autoras señalan que los rankings están más centrados en lo que se puede medir y no en lo que es importante para las universidades. Mediante el uso de conglomerados (clústeres) ofrecen una clasificación integradora de las misiones de las tres principales funciones universitarias con el fin de saber si el Sistema Universitario Español tiende a ser más homogéneo y permite que las universidades puedan ser comparables en entre sí o, por el contrario, se trata de un sistema que se ha especializado de acuerdo a estrategias particulares de cada institución. Trabajar la evaluación de universidades a través de la formación de clústeres constituye una buena alternativa para la valoración de su calidad.

Otra forma de evaluación de la instituciones es por medio del mecanismo de rendición de cuentas, el cual se puede compaginar con los resultados de un ranking, como en el caso del trabajo desarrollado por Baraibar y Luna (2012) que relaciona la reputación de 74 universidades españolas, medida por la posición que tienen en el ranking webometrics, a través del impulso a la actividad social y preocupación por la transparencia.

La gráfica 1 se construye alrededor del multi-ranking, considerado como un promedio; allí se observa que los tres primeros rankings, el multi-ranking, el AEEADS y el Iberoamericano, presentan tendencias muy similares hasta la posición número 20, para admitir después, los dos últimos, un comportamiento de mayor dispersión; de la posición 35 en adelante alinean su tendencia de nueva cuenta al multi-ranking, lo que significa que las instituciones que presentan mejor comportamiento lo hacen en los tres rankings y las de peor comportamiento también lo hacen en los tres listados.

En el ranking Iberoamericano los mayores desfases los presentan la UQROO que aparece en el lugar 35 y se encuentra en el lugar 24 en el multi-ranking; otro caso es el de la UNICACH que se encuentra en el lugar 36 en este ranking y en el 25 en el multi-ranking. Estas instituciones se benefician del hecho de ser consideradas en un agrupamiento.

En la serie 4 se observa que el ranking Webometrics presenta un comportamiento irregular con respecto al multi-ranking. Por ejemplo, el primer gran salto en el gráfico pertenece a la UAEMOR, que llega a ubicarse en segundo lugar en el multi-ranking y en el EAAEDS y cuarto en el Iberoamericano, en tanto que en el Webometrics aparece hasta el lugar número 13; el siguiente pico es de la UASLP que, del sexto lugar en el mult-ranking, se va a hasta el 12 en el Webometrics. Otras universidades que presentan picos son las UAQ, UUA y UACOAH. Estas instituciones deben poner más atención para que su trabajo académico se refleje de mejor manera en sus páginas web. Por otra parte, existen instituciones que ocupan mejores lugares en este ranking que en el listado general, por ejemplo, la UNISON aparece en tercer lugar, cuando en el muti-ranking está en el lugar 11; lo mismo sucede con la UTMIX que, en este listado, alcanza el lugar 17 y, en el multi-ranking, se va a lugar número 30. Para fortalecer la participación de las universidades en este ranking la primera recomendación es que cuenten con solamente una página institucional y que todos los enlaces —por funciones, por departamentos, por unidades, etc.—, se hagan a esta página.

Conclusiones

En el trabajo se reportan varios esfuerzos por mejorar las metodologías en la construcción de los rankings para las instituciones de educación superior, con el fin de facilitar su uso, convirtiéndolos en instrumentos más adecuados y próximos a la calidad que ostentan las universidades. Una de esas formas es la elaboración de un multi-ranking.

Mediante la elaboración de instrumentos de este tipo, o bien a través de otras metodologías de agrupamiento de las universidades para la práctica de ejercicios de evaluación, se fortalece el desempeño en la evaluación institucional, porque esto posibilita compaginar las cualidades de los diferentes indicadores y métodos y constituye una posibilidad de conjuntar los intereses de los involucrados. Esta forma de evaluación se puede combinar de manera más adecuada con los sistemas de evaluación existentes, tanto desde el aseguramiento de la calidad como desde la rendición de cuentas.

Tanto en el muti-ranking como en el ranking EAAEDS y en el Iberoamericano, el comportamiento de las instituciones que aparecen arriba de media tabla es similar, es decir, se alinea en los indicadores académicos; lo mismo pasa con las que se inscriben en los últimos lugares. Las instituciones consideradas de buena calidad en estos rankings mantienen este nivel de calidad en todos sus indicadores. Por otra parte, el ranking Webometrics presenta mayor dispersión con respecto a los tres anteriores y, en este, es posible encontrar casos como los de las UAEMOR, UASLP, UAQ, UUA y UACOAH que observan posiciones desfasadas de acuerdo a los lugares que ocupan en los otros rankings; es aconsejable que estas instituciones mejoren su presencia mediante sus páginas web.

Un trabajo pendiente para los organismos evaluadores y acreditadores de universidades en México, pero también para los estudiosos de estas temáticas, los diseñadores e instrumentadores de políticas en este campo y los administradores de las universidades, es la búsqueda de nuevos esquemas para la evaluación institucional y la mejoría de los existentes, ya que se han vuelto muy tradicionales y repetitivos.

Referencias

Aguillo, Isidro F., Ortega, J. L. y Fernández, M. (2008). Webometrics Ranking of World Universities: Introduction, Methodology, and Future Developments. Higher Education in Europe, 33 (2), 233-244. [ Links ]

Baraibar Diez, Elisa y Luna Sotorrío, Ladislao (2012). The Influence of Transparency of University Social Responsibility in the Creation of Reputation. Regional and Sectoral Economic Studies, 12 (3), 21-30. [ Links ]

Buela-Casal, Gualberto, Bermúdez, Ma. Paz, Sierra, Juan Carlos, Quevedo-Blasco, Raúl y Castro, Ángel (2010). Ranking de 2009 en investigación de las universidades públicas españolas. Psicothema, 22 (2), 171-179. [ Links ]

Federkeil, Gero (2008). Rankings and Quality Assurance in Higher Education. Higher Education in Europe, 33 (2, 3), 209-231. Obtenido de: http://dx.doi.org/10.1080/03797720802254023. [ Links ]

García-Aracil, Adela y Palomares-Montero, Davinia (2012). Agrupación alternativa para la evaluación de las universidades públicas españolas. Regional and Sectoral Economic Studies, 12 (3), 179-194. [ Links ]

Hazelkorn, Ellen (2011). Rankings and the Reshaping of Higher Education. The Battle for World-Class Excellence, London: Palgrave Macmillan. [ Links ]

Horstschräer, Julia (2012). University Rankings in Action? The Importance of Rankings and an Excellence Competition for University Choice-Ability Students. Economics of Education Review, 31, 1162-1176. [ Links ]

Institute for Higher Education Policy (2006). Berlin Principles on Ranking of Higher Education Institutions. Obtenido de: http://www.ihep.org/Publications/publications-detail.cfm?id=3. [ Links ]

Longden, Bernard (2011). Rankings indicators and weights. En Shin, Jung, Toutkoushian, Robert K. y Teichler, Ulrich (Eds.), University Rankings. Theoretical Basis, Methodology and Impacts on Global Higher Education, London y New York: Springer, 73-104. [ Links ]

López-Leyva, S. (2012). Fortaleza académica de las universidades públicas estatales en México expresada en un ranking nacional. Regional and Sectoral Economic Studies, 12 (3), 143-160. [ Links ]

Martínez Rizo, Felipe (2011). Los rankings de universidades. Una visión crítica. Revista de la Educación Superior, XL (157), 77-97. [ Links ]

McCormick, Alexander C. (2008). The Complex Interplay Between Classification and Ranking of College and Universities: Should the Berlin Principles Apply Equally to Classification? Higher Education in Europe, 33 (3), 209-218. [ Links ]

Márquez Jiménez, Alejandro (2010). Estudio comparativo de las universidades mexicanas (ECUM). Otra mirada a la realidad universitaria. Revista Iberoamericana de Educación Superior (RIES), 1 (1), 148-156. Obtenido de: http://ries.universia.net. [ Links ]

Morphew, Christopher C. y Swanson, Christopher (2011). On the Efficacy of Raising Your University's Rankings. En Shin, Jung, Toutkoushian, Robert K. y Teichler, Ulrich (Eds.), University Rankings. Theoretical Basis, Methodology and Impacts on Global Higher Education, London y New York: Springer, 185-199. [ Links ]

Ordorika Sacristán, Imanol, Rodríguez Gómez, Roberto, Lozano Espinoza, Francisco Javier, Márquez Jiménez, Alejandro (2009). Desempeño de universidades mexicanas en la función de investigación: Estudio comparativo. Cuadernos de Trabajo de la Dirección General de Evaluación Institucional, 1 (2). [ Links ]

Palomares-Montero, Davinia y García-Aracil, Adela (2011). Utilización de indicadores para la evaluación de las universidades públicas españolas. ¿Existe consenso? Investigaciones en economía de la educación, 6, 460-473. Obtenido de: http://ideas.repec.org/b/aec/ebooks/06.html. [ Links ]

Pérez-Esparrells, Carmen y López García, Ana María (2009). Los rankings de las instituciones de educación superior: una revisión del panorama internacional. Calidad de la educación, 30, 328-343. [ Links ]

Shin, Jung Cheol (2011). Organizational Effectiveness and University Rankings. En Shin, Jung, Toutkoushian, Robert K. y Teichler, Ulrich (Eds.), University Rankings. Theoretical Basis, Methodology and Impacts on Global Higher Education, London y New York: Springer, 19-34. [ Links ]

Shin, J. Ch. y Toutkoushian, R. K. (2011). The Past, Present, and Future of University Rankings. En Shin, Jung, Toutkoushian, Robert K. y Teichler, Ulrich (Eds.), University Rankings. Theoretical Basis, Methodology and Impacts on Global Higher Education, London y New York: Springer, 1-16. [ Links ]

Teichler, Ulrich (2011). The Future of University Rankings. En Shin, Jung, Toutkoushian, Robert K. y Teichler, Ulrich (Eds.), University Rankings. Theoretical Basis, Methodology and Impacts on Global Higher Education, London y New York: Springer, 259-265. [ Links ]

Van Vught, F., Westerhijden, D. F. y Ziegele, F. (2012). Introduction: Towards a New Ranking Approach in Higher Education and Research. En Van Vught, F. A. y Ziegele, F. (Eds.), Multidimensional Ranking. The Design and Development of U-Multirank, London y New York: Springer, 1-7. [ Links ]

Van Vught, F., Westerhijden, D. F. (2012). Impact of rankings. En Van Vught, F. A. y Ziegele, F. (Eds.), Multidimensional Ranking. The Design and Development of U-Multirank, London y New York: Springer, 71-81. [ Links ]

Van Vught, F.A y Ziegele, F. (Eds.). (2012). Multidimensional Ranking. The Design and Development of U-Multirank, London y New York: Springer. [ Links ]

Webster, D. S. A. (1986). Academic Quality Rankings of American Colleges and Universities, Springfield IL: Charles C. Thomas. [ Links ]

1 Este concepto fue tomado de Van Vught y Ziegele (2012).