Presentación

La revolución digital está penetrando cada vez con mayor intensidad en todos los ámbitos educativos, y la evaluación no es una excepción. Bennett (2004) afirmó hace más de una década que ningún tema tendría mayor importancia para la innovación y la práctica futura de la evaluación educativa que las computadoras y la Internet. Su predicción fue correcta, ya que ambas actividades se han desarrollado a un ritmo vertiginoso. La revolución digital en el campo de la evaluación educativa ofrece ahora posibilidades que apenas hace una década eran impensables, y ha dado lugar al advenimiento de una nueva era en dicha evaluación.

Entre las múltiples ventajas de los recursos digitales para la evaluación, hay que destacar que pueden generar preguntas y procesar las respuestas por algoritmos en cuestión de décimas de segundo; establecer enlaces en línea de alta velocidad para trasmitir flujos de información en tiempo real y diferido; usar recursos multimedia para hacer presentaciones de textos, imágenes, sonido y video en formatos de alta definición; articular vínculos dinámicos como hipertexto (enlaces internos) e hipervínculo (enlaces web) que permiten relacionar distintas fuentes de información de manera instantánea y monitorear la interacción (respuestas en pantalla). También se puede medir el tiempo de respuesta, generar bases de datos relacionadas que permiten acceder, recuperar, procesar, interpretar e integrar información diversa; y programar con lenguajes de cómputo el diseño, formato, administración y calificación de una amplia variedad de reactivos que superan muchas de las limitaciones de las preguntas tradicionales de opción múltiple. Estas potencialidades han dado lugar a una nueva generación de evaluaciones del aprendizaje, cuyas características principales son: la digitalización de todos sus procesos, la administración ramificada (no lineal), la medición a profundidad de competencias cognitivas por respuesta construida y la generación automática de ítems (automatic item generation).

Los exámenes más acreditados elaborados por el Educational Testing Service, como son el Test of English as a Foreign Language (TOEFL iBT) y el Graduate Record Examination (GRE), ahora trabajan en plataformas digitales. La evaluación del Programme for International Student Assessment (PISA), de la Organización para la Cooperación y Desarrollo Económico (OECD, por sus siglas en inglés), ha señalado que la aplicación correspondiente a 2015 se realizará principalmente en formato digital (OECD, 2015).

En México, desde 1993, el Examen de Habilidades y Conocimientos Básicos (EXHCOBA) se ha aplicado en formato digital a cientos de miles de aspirantes a ingresar a instituciones universitarias de educación media superior y superior (Backhoff et al., 1996).

No obstante lo anterior, a pesar de que ha habido un gran avance en la digitalización de la evaluación de los aprendizajes, muchas de las pruebas computarizadas siguen valorando conocimientos y habilidades con base en reactivos de opción múltiple, toda vez que ha sido la forma tradicional para hacer pruebas válidas y confiables que son rápidas de calificar de manera automatizada. Esto ha sido particularmente importante para las evaluaciones a gran escala, donde miles, o decenas de miles de estudiantes tienen que aplicarlas en tiempos acotados. En el mejor de los casos, algunas evaluaciones de gran escala ya utilizan reactivos de respuesta construida, a partir de respuestas cortas, para después ser calificadas por un grupo de especialistas entrenados a través de rúbricas, tal y como se reporta en el programa PISA for Development (OECD, 2014).

Por la variabilidad que suele haber en las respuestas construidas, así como lo tardado y costoso que puede significar su calificación a través de rúbricas, la mayoría de las instituciones responsables del desarrollo de pruebas estandarizadas ha seguido utilizando los procedimientos tradicionales para diseñar y usar evaluaciones donde se requiere que el estudiante seleccione una respuesta dada. Por lo general, estos procedimientos demandan que especialistas en contenidos especifiquen los conocimientos, habilidades o competencias que se desean examinar; que otro grupo de expertos elabore las especificaciones definidas de los reactivos que se utilizarán en las pruebas; y que se hagan estudios piloto de validación de los reactivos para finalmente conformar la versión definitiva de la prueba con aquellos ítems que logren obtener los estándares psicométricos internacionalmente aceptados de validez y confiablidad. Usualmente se construyen varios reactivos para cada especificación, con el objetivo de tener dos o más versiones de una prueba con reactivos equivalentes. Esto implica que se pueden tener versiones diferentes de un mismo examen mientras sean conceptual y psicométricamente equivalentes, pero hay dos inconvenientes: 1) es difícil construir reactivos de opción múltiple que sean diferentes y a la vez isomorfos (equivalentes conceptual y psicométricamente); y 2) el procedimiento es lento y costoso.

A pesar de que estas pruebas pueden tener varias versiones, sufren el desgaste natural al usarse repetida e intensivamente, como es el caso de las pruebas de ingreso a las universidades, porque se filtran las preguntas, los aspirantes se van aprendiendo las respuestas y en consecuencia pierden su validez. También las respuestas de opción múltiple tienen el inconveniente de ser fáciles de copiar, además de que pueden ser respondidas correctamente al azar. Es por estas razones que los ítems de estas pruebas deben renovarse en forma constante, con el objetivo de mantener vigente la validez de sus resultados.

La mayoría de exámenes estandarizados a gran escala evalúa con el formato de respuesta. La razón principal es que así se pueden calificar objetivamente con gran rapidez; aun si la vía de administración del examen es por lápiz y papel, se pueden usar lectores ópticos. Adicionalmente, la psicometría ha desarrollado en las últimas décadas análisis y procedimientos que mejoraron la evaluación, como la teoría de respuesta al ítem (item response theory), que revolucionó en los años sesenta del siglo pasado muchos de los planteamientos de la teoría clásica de la evaluación. Esto ha ayudado a preservar la opción múltiple.

Es bien sabido que el formato de elección de respuesta presenta limitaciones serias que no se pueden obviar, tal y como lo señalan muchos autores. Entre sus limitaciones más relevantes destaca que no evalúa la comprensión de conocimientos a profundidad (pensamiento complejo), ni las habilidades de ejecución (Rothstein et al., 2010). Asimismo, hay importantes críticas a dos de sus premisas básicas que sostienen que: 1) es posible desagregar los aprendizajes en unidades pequeñas de respuesta, en tanto el todo se puede descomponer en sus partes; y 2) el aprendizaje se puede estudiar e interpretar con base en elementos aislados de su contexto. Resnick y Resnick (1992) comentan que estos supuestos no corresponden con lo que ocurre en la vida real, donde todo está relacionado y los significados se configuran en contextos, los cuales hacen que se interpreten las propiedades del entorno desde un referente cultural. Las evaluaciones suelen ser útiles para la escuela, pero no para la vida o la vida profesional.

Ng y Chan (2009) analizaron los llamados exámenes objetivos y concluyeron que éstos se limitan a dos clases de respuestas correctas: las que el examinado conoce, y las que acierta por azar. Estas últimas, dadas por correctas, son una fuente de error que contamina y aminora la validez de estos exámenes.

El modelo de opción múltiple suele presentar entre tres a cinco opciones de respuestas posibles, donde las respuestas incorrectas se conciben técnicamente como "distractores" (distraen), incorporan "ruido", y aunque son plausibles, solamente una opción debe ser la correcta. Este formato atomiza el saber y promueve la concepción del aprendizaje fragmentado, circunscrito a precisiones, lo que suele ser aprendido por memorización. De este modo se restringe al sustentante a elegir entre las limitadas opciones disponibles y no se le permite que desarrolle y construya sus propias respuestas.

También puede ocurrir que el examinado conozca parte de la solución, que tenga ciertos conocimientos del área, porque el conocimiento se da en un continuo, y no de manera atomizada en respuestas puntuales, como se concibe en las respuestas que son dicotómicas (correcto-incorrecto). En este tipo de exámenes no se reconoce que hay distintos niveles de conocimiento, no se valora el saber parcial ni se registra; no se le otorga crédito parcial, simplemente se ignora y se pierde esa información.

Teniendo presentes las limitaciones observadas en las evaluaciones tradicionales disponibles en formato de selección de respuesta aplicadas en lápiz y papel, y dadas las amplias potencialidades que ofrecen los medios digitales, en las últimas décadas se han explorado nuevos planteamientos para mejorar los procesos de valoración. En este trabajo se presenta un nuevo paradigma de evaluación de competencias académicas, sustentado en tres grandes características: 1) examinar habilidades cognitivas complejas en contexto, a través de tareas que requieran del sustentante que construya sus respuestas, y no simplemente las seleccione; 2) formular las tareas de evaluación con base en reactivos equivalentes que son técnicamente isomorfos; 3) generar de manera automática, en un sistema de cómputo, las tareas de evaluación, permitiendo el control de niveles de dificultad; y 4) calificar las respuestas con un esquema de crédito parcial. Este modelo está integrado por dos componentes: el Examen de Competencias Básicas (EXCOBA) y un editor de reactivos computarizado integrado por el programa GenerEx (generador de exámenes).1

Marco conceptual

La evaluación de los aprendizajes requiere partir de un paradigma que tenga una concepción de la educación como un sistema complejo, bajo una visión del aprendizaje entendido como las resultantes de procesos multifactoriales, en los que se originan efectos interactivos no lineales entre los factores, lo cual ocurre en procesos longitudinales que forman trayectorias a lo largo del tiempo, ante diversas circunstancias, distintas situaciones, en múltiples instituciones y organizaciones; por todo ello se hace necesario concebir análisis sistémicos (Lemke y Sabelli, 2008).

Los primeros planteamientos para explicar los procesos de la apropiación del conocimiento desde el punto de vista psicológico aparecen con las primeras teorías de la cognición, las cuales tuvieron su origen en los años veinte del siglo pasado, con los trabajos experimentales de los psicólogos alemanes de la escuela de la Gestalt. Posteriormente, siguió un gran desarrollo de las teorías cognoscitivas a mediados del siglo XX, particularmente en Europa, con los planteamientos psicogenéticos de Jean Piaget y psicosociales de Lev Vygotsky, y en los Estados Unidos con los de Jerome Bruner y David Ausubel.

Actualmente, el constructivismo es el paradigma dominante en la psicología educativa; concibe al desarrollo del conocimiento como un proceso de construcción propia del educando, en tanto no se da una reproducción fiel de los estímulos provenientes del ambiente externo, ni tampoco la codificación apegada a un texto o discurso del profesor (Serrano y Pons, 2011). En el paradigma constructivista hay una controversia epistemológica que surge de la atribución del carácter interno o externo en el proceso de construcción del saber: unos enfatizan más el carácter individual (interno) y otros el carácter social de la construcción bajo una concepción socio-cultural (Coll, 2001).

La tesis central de este paradigma establece que el conocimiento y el aprendizaje no son resultado de la experiencia directa, sino el producto de una actividad cognitiva constructiva, donde las personas interpretan las experiencias de vida y elaboran representaciones que se codifican en una estructura o malla semántica dotada de significado y significación. Esta posición es compartida por las distintas tendencias de la investigación psicológica y educativa contemporáneas. Sin embargo, se pueden identificar grosso modo tres posiciones: el constructivismo cognitivo, con raíces en la psicología y epistemología genéticas de Jean Piaget, donde se enfatiza la elaboración de la estructura de conocimientos por parte del aprendiz, bajo un proceso de equilibrio entre la asimilación y la acomodación (Piaget, 1970); el constructivismo de orientación social, inspirado en los planteamientos de Lev Vygotsky, que concibe el proceso del desarrollo del pensamiento como un fenómeno social que está mediado básicamente por el lenguaje (Vygotsky, 1986); y el construccionismo socio-cultural que sustenta Mikel Cole, entre otros, con un enfoque en el que se pone mayor énfasis en la elaboración del conocimiento a partir de las mediaciones y el contexto socio histórico cultural del aprendiz. En este tercer enfoque se destacan también las prácticas lingüísticas, pero concebidas como artefactos que median la actividad cognitiva, lo que plantea una visión de una psicología cultural con una orientación más antropológica (Cole, 1998).

El Examen de Competencias Básicas está basado, particularmente, en algunos aspectos del constructivismo cognitivo socio-cultural, que está sustentado en que el conocimiento de las personas se codifica en estructuras que forman mallas o campos semánticos (Luria, 1981). La teoría de campo no sólo establece las relaciones conceptuales de una estructura de cognición jerarquizada, sino que asume que la evocación conceptual tiene relaciones con distintas valencias (fuerzas de enlace). El EXCOBA está diseñado para evaluar competencias académicas básicas que adquieren las personas durante su escolarización, las cuales constituyen elementos que permiten tener éxito escolar en niveles de estudio superiores y en la vida.

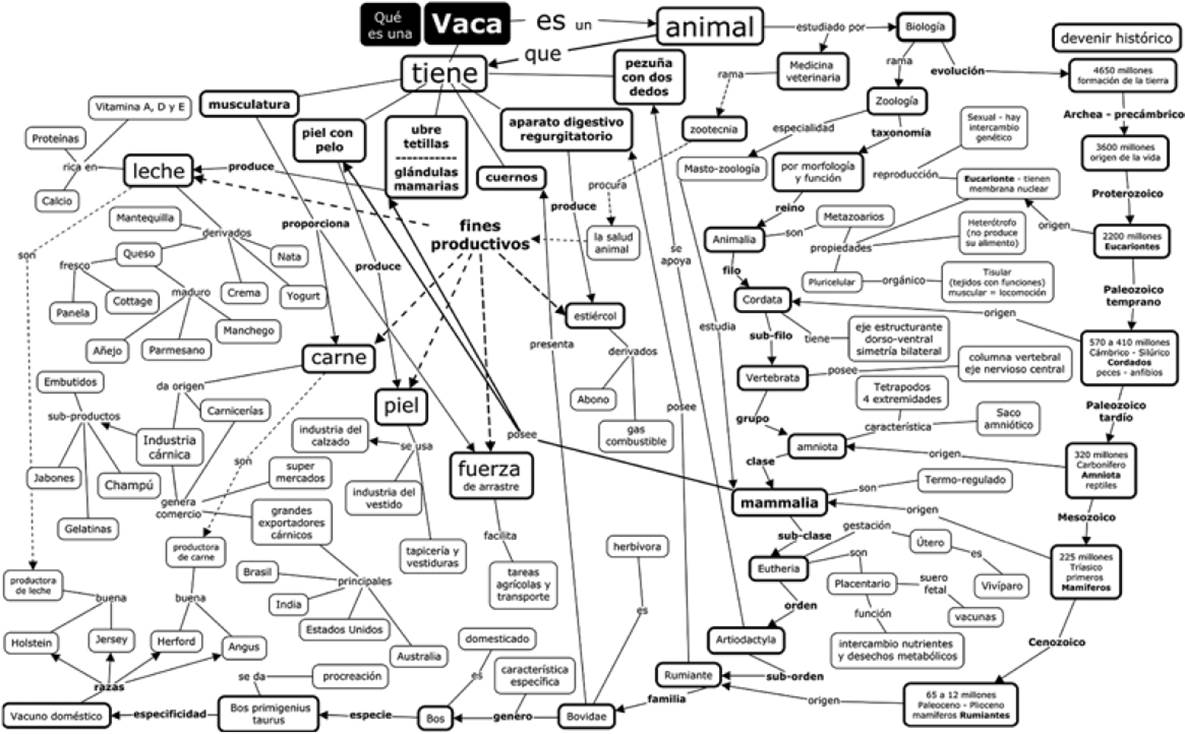

El conocimiento se codifica en categorías que irradian un campo semántico de significación, donde hay relaciones jerárquicas (supra-ordinadas / ordinadas / sub-ordinadas), en tanto unos conceptos incluyen a otros, por ejemplo, el concepto vaca, está incluido en conceptos generales (supra-ordinados) como ser un animal mamífero. Hay conceptos específicos que la definen (sub-ordinados), como tener cuernos y dar leche, que incluye a sus derivados, como mantequilla y quesos; y éstos a los diferentes tipos, etcétera. La estructura de cognición ha dado lugar a concebir los mapas conceptuales, que corresponden a una visualización de un campo semántico. En el diagrama de la Fig. 1 se presenta un ejemplo de irradiación conceptual de un campo semántico a partir del concepto vaca, representado en un mapa conceptual.

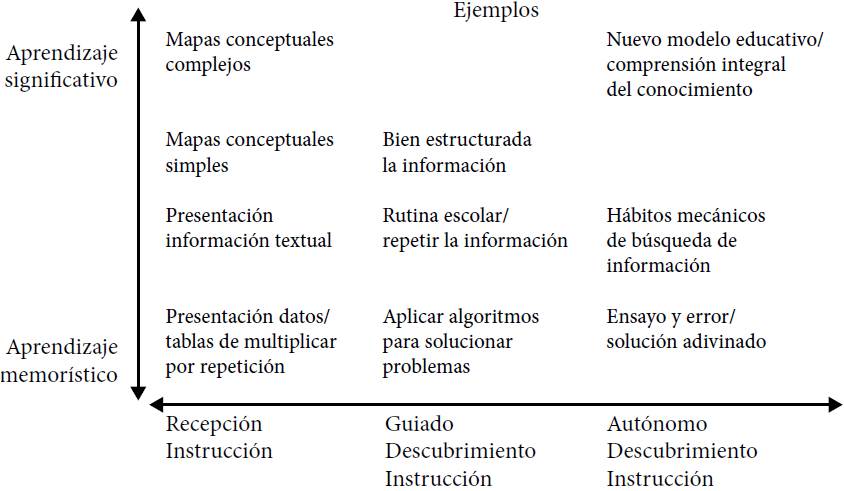

Novak y Cañas (2008) plantean que hay dos dimensiones ortogonales en los procesos de aprendizaje: la primera va del aprendizaje de datos que se logra por simple recepción, con muy limitado significado, y transita hacia el aprendizaje significativo hasta llegar a campos complejos del conocimiento (representado en el eje Y de la Fig. 2); la otra dimensión se refiere a las dinámicas del aprendizaje, que inicia por recepción (pasivo y memorístico) y evoluciona hacia el aprendizaje por descubrimiento (activo y por comprensión insight), representados en el eje X.

El planteamiento es que en el aprendizaje por recepción el contenido a aprender se presenta al alumno en su forma final y el estudiante debe asimilar o incorporar los conceptos a su estructura de conocimientos de modo arbitrario, por un procedimiento memorístico basado en la simple repetición, de lo que resulta un conocimiento estático que tiene poca o nula operatividad cognitiva. Por el contrario, en el aprendizaje por descubrimiento, el alumno debe reorganizar la información, integrarla o ajustar su estructura cognoscitiva existente al transformarla para obtener el producto final deseado. En la segunda dimensión, el aprendizaje significativo ofrece operatividad cognitiva; esto implica que el objeto de aprendizaje se relaciona de modo sustancial y no arbitrario con la estructura de conocimientos del alumno, con lo que ya sabe, y por lo mismo adquiere operatividad cognitiva que estimula una actitud a favor del aprendizaje (Ausubel et al., 1978).

La comprensión se da cuando hay construcción de significado que permite la operatividad cognitiva, la reflexión que posibilita entender las relaciones de pertinencia que subyacen a una idea o proposición. Entre más profunda es la reflexión, mayor es la significación, las relaciones de pertinencia son más extensas (como en el ejemplo del concepto vaca), y por lo mismo, la fuerza de la huella mnémica es más resistente al olvido. En el proceso de evaluación se busca evaluar competencias ubicadas en los extremos de los ejes ortogonales (presentados en la Fig. 2), relaciones conceptuales extensas y desarrollo autónomo, que equivale a reflexionar a profundidad.

La mayor eficacia del aprendizaje significativo reside en cuatro grandes ventajas: facilita nuevos aprendizajes, produce efectos de memoria más resistentes al olvido, se superan detalles concretos (precisiones) y, lo más importante, genera la comprensión que habilita la reflexión para construir nuevas respuestas, tanto críticas como creativas. Esta orientación evoca distintas actitudes hacia el aprendizaje y la evaluación, ya que es muy diferente a la evaluación tradicional, que suele requerir el recuerdo literal del aprendizaje original, así como el reconocimiento de respuestas dadas para evaluar la comprensión. Los dos tipos de aprendizaje planteados por Ausubel et al. (1978) no son dicotómicos ni excluyentes; coexisten y se conforman en un continuo, como se planteó en la Fig. 2. En consecuencia, en las nuevas estrategias de evaluación educativa se prioriza el aprendizaje significativo, y se tiende a dejar relegada la estrategia de opción múltiple, por estar más relacionada con procesos de identificación puntual de conocimiento memorizado.

De acuerdo con lo expuesto en este apartado, el EXCOBA pretende recuperar los aprendizajes significativos que tuvieron lugar tanto en la educación básica como en la media superior, ocurridos por comprensión o por descubrimiento (insight). El examen evalúa aquellos conceptos y procedimientos expresados en el currículo que el estudiante logró relacionar sustancialmente, y que permanecieron de manera organizada y no arbitraria en su estructura cognoscitiva.

El modelo del EXCOBA

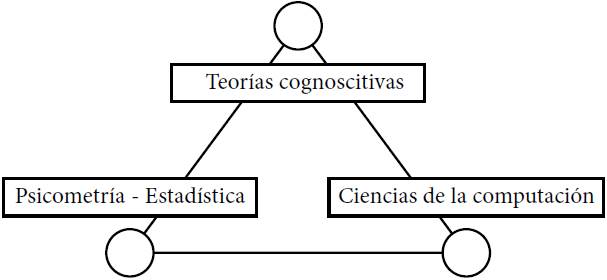

El modelo del Examen de Competencias Básicas se sustenta en tres soportes teóricos de gran fortaleza: las teorías de la cognición, la psicometría y las ciencias de la computación, como se ilustra en la Fig. 3.

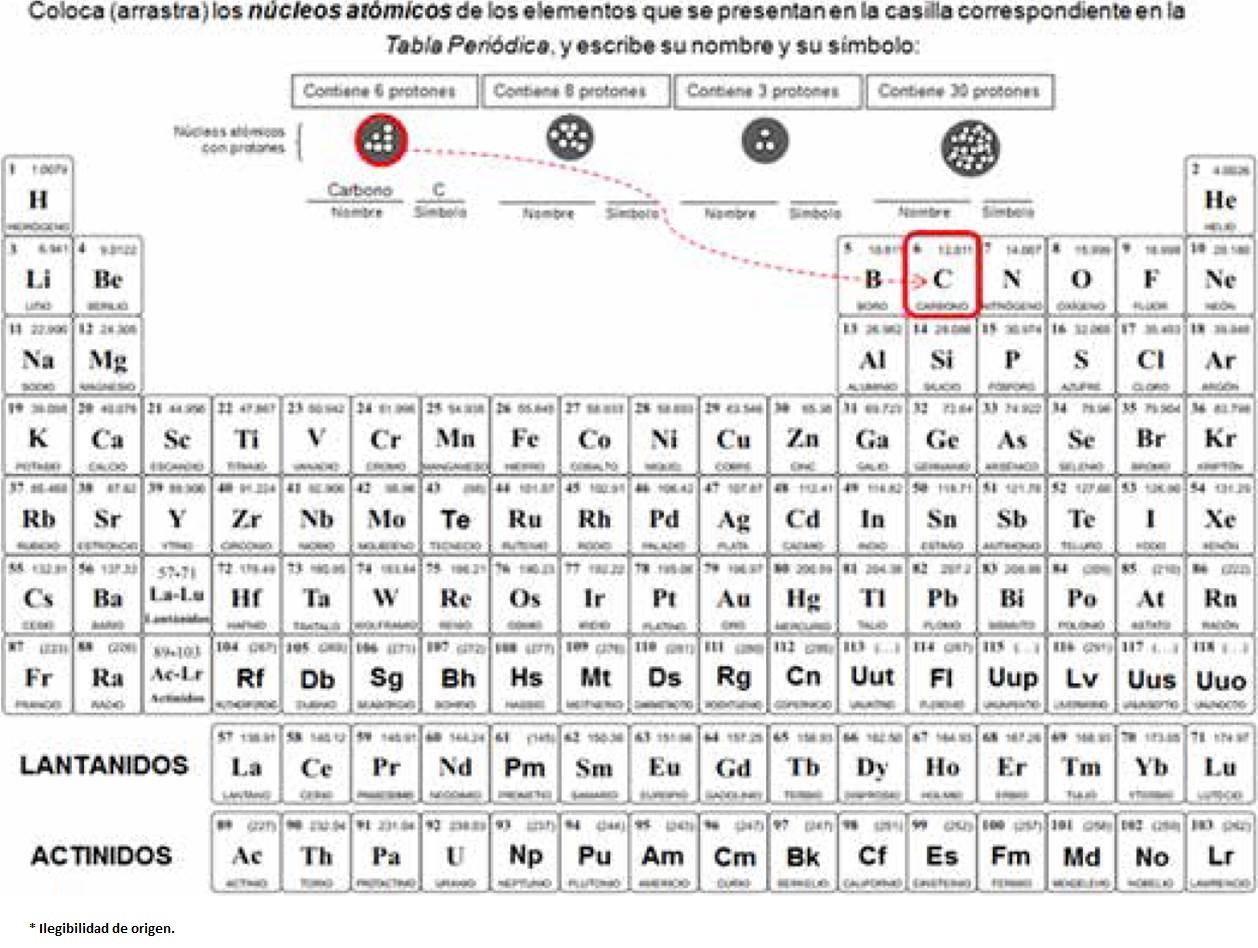

En el diseño conceptual, el tipo de reactivos utilizados en el examen corresponde a lo que denominamos reactivos estructurales constructivos. El concepto de reactivo estructural es porque la actividad a evaluar apela a un campo semántico del conocimiento, y no a un contenido puntual. Por lo tanto, el sustentante debe mostrar la capacidad para responder a un sistema de conceptos coherentes, entrelazados, organizados, estructurados, como es en química la tabla periódica de los elementos, y no a un concepto único y desarticulado, como sería mencionar o reconocer el número o peso atómico de un elemento dado. El nombre de reactivo constructivo refiere al constructivismo cognitivo, ya que el sustentante deberá construir sus propias respuestas, como comprender que la fracción de 2/5 de un área dada equivale a 0.4, o que corresponde al 40 por ciento; en este ejemplo, se requiere que construya la respuesta marcando la parte del área que corresponda a la fracción indicada en cualquiera de sus tres expresiones (2/5, 0.4, 40 por ciento).

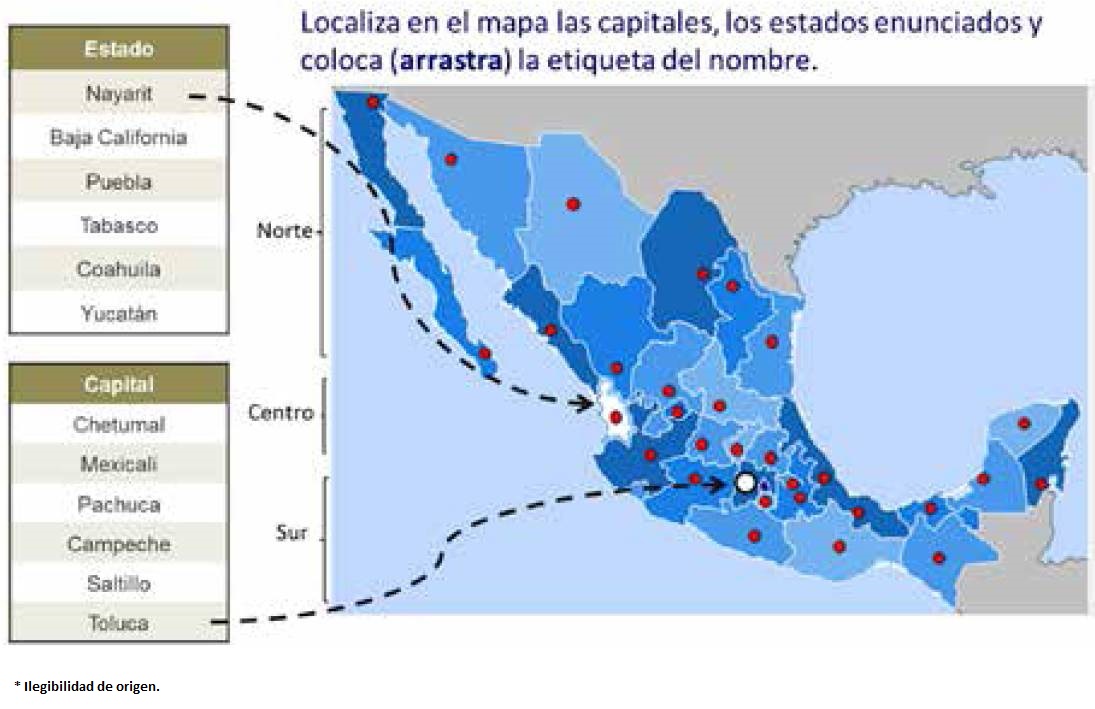

Otra particularidad de los reactivos estructurales es la cantidad de respuestas solicitadas por reactivo: hay ítems donde el resultado es único y sólo puede ser calificado como correcto o incorrecto (ítems dicotómicos); pero en otros ítems se requiere de múltiples respuestas, dos o más (ítems politómicos), de manera que se puede calificar en función del número de respuestas que el sustentante pudo contestar correctamente con un esquema de crédito parcial. Un ejemplo puede ser identificar seis estados y seis capitales en un mapa de la república mexicana, de manera que hay 12 respuestas, de las cuales unas pueden estar bien y otras no; en este caso el crédito se otorga de acuerdo al número de respuestas correctas, de manera que si contesta seis bien se otorga 0.5 de punto; si fueran nueve se daría 0.75 de punto, es decir, proporcional al número de aciertos.2

Los reactivos estructurales no necesariamente descartan el formato de selección de respuesta, pero se dan dentro de las exigencias de diferentes contextos a evaluar por medio de planteamientos estructurales, como se verá en un ejemplo en el que se requiere seleccionar has (de haber) o haz (de hacer). Los procesos de evaluación no se pueden reducir a un único formato, sino que se configuran y distribuyen en diferentes formatos, de acuerdo con los campos semánticos. Los reactivos estructurales se pueden plantear en cualquier campo del saber: en muchos casos, como en la aritmética, la física, la química, la geometría y el álgebra, el sustentante debe construir la respuesta y anotar la solución numérica o literal, según se requiera; pero en otros casos los ítems presentan campos estructurados y se solicita al sustentante construir su respuesta organizando los componentes de la tarea evaluativa.

Como se indicó, otro de los componentes teóricos del modelo se sustenta en la psicometría, que también tiene sus orígenes a principios del siglo XX, con el primer test de inteligencia para medir la edad mental de los estudiantes en una escala, elaborada en 1908 por Alfred Binet y Théodore Simon. La psicometría constituye un cuerpo disciplinario desarrollado por más de un siglo para hacer mediciones rigurosas de los fenómenos psicológicos, como son la inteligencia, el aprendizaje y la personalidad, a partir de elementos que permitan medir, con sustento empírico, dichos atributos psicológicos; es así como se ha pretendido obtener indicadores objetivos, precisos, estables, válidos y confiables, lo que ha dado lugar a la construcción de test y pruebas, entre otras, las relacionadas con el rendimiento académico o escolar. Para fortalecer sus análisis, la psicometría se ha valido del uso de las matemáticas y, en particular, de la teoría de la probabilidad, que cristalizó en la teoría clásica de la medida. Hay otros planteamientos, como la teoría de respuestas al ítem, que a diferencia de la primera no parte de la distribución normal de la dificultad de los ítems dentro de un continuo, sino que asume que el nivel de dificultad es propio de cada ítem, es decir, es independiente; se trata de estimar la probabilidad de que una persona con determinado nivel de competencias pueda contestar correctamente una pregunta dentro de un rango de dificultad dado en una escala. La psicometría ha logrado análisis tan complejos y sustentados que muchos especialistas los han reconocido como aportaciones relevantes al desarrollo del conocimiento matemático.

El tercer componente está dado por las ciencias de la computación, las cuales se han desarrollado vertiginosamente desde finales del siglo pasado, transformando todos los campos del saber, las tecnologías, aplicaciones industriales y telemáticas. En el EXCOBA el modelo está sustentado en procesos de ingeniería de tests que hacen posible aplicar algoritmos automatizados, como es el caso de GenerEx, que permite evaluar campos semánticos a través de generar reactivos isomorfos de respuesta construida o semi-construida.

El ambiente computarizado facilita la mediación para poder aprovechar diversos códigos de conocimiento, como la representación visual, dada la facilidad de incorporar y recrear imágenes dinámicas que son factibles de ser transformadas por el sustentante; además, permite medir el tiempo de reacción y respuesta de cada sustentante en cada uno de los reactivos de la prueba, lo cual ofrece ventajas que son impensables en el formato tradicional de lápiz y papel. La aplicación computarizada constituye una nueva dimensión.

Propiedades del EXCOBA

Después de 20 años de investigación e innovación, se logró concebir un nuevo paradigma y consolidar el Examen de Competencias Básicas, el cual aprovecha las ventajas antes enunciadas de la cognición, la psicometría y la tecnología digital. Este examen computarizado de aplicación a gran escala fue diseñado para seleccionar y diagnosticar a los estudiantes que aspiran ingresar a los niveles de educación media superior (EMS) y educación superior (ES). El examen evalúa competencias a partir de la operatividad cognitiva de los aprendizajes básicos y estructurales que los estudiantes debieron adquirir durante su trayectoria escolar. Su originalidad consiste en la concepción, diseño e instrumentación de un modelo de evaluación de competencias educativas (para la escuela y para la vida), concebido con una visión estructuralista y constructivista, que es más cercana a los problemas que se presentan en la vida cotidiana; lo que es referido como evaluación auténtica.

La selección del contenido se realiza mediante la identificación, en el currículo, de aprendizajes esperados que se consideren básicos y estructurales, es decir, que sean el sustento conceptual que da andamiaje para poder estructurar y comprender otros conocimientos que son más complejos; también se considera la relevancia, en tanto permiten integrar otros conocimientos que dan competencias para la vida dado un contexto socio-cultural. Por ejemplo, al definir la relevancia de países o ciudades algunos resultan de mayor importancia para ciertos contextos: países como España o ciudades como Washington tienen mayor relevancia para los mexicanos dadas las múltiples relaciones políticas, económicas, históricas y culturales que se tienen con ellos, en comparación con países como Kenia o ciudades como Asunción, donde las relaciones son menos relevantes y frecuentes.

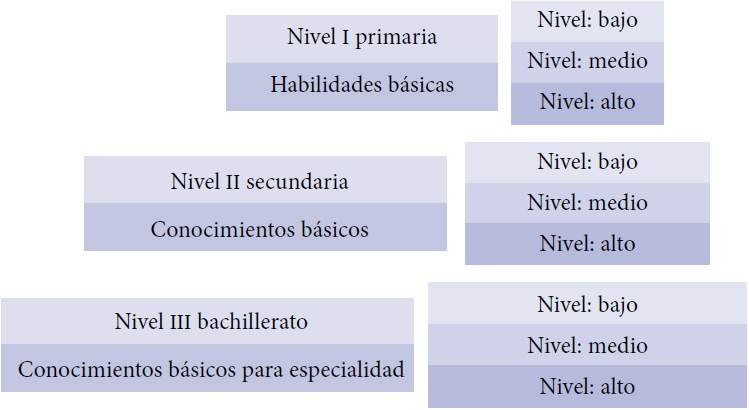

La estructura del examen se basa en el análisis conceptual de los planes y programas de estudio, lo que requiere un riguroso análisis longitudinal de las articulaciones de los contenidos curriculares para identificar las habilidades y conocimientos sustantivos implicados en las diversas disciplinas (Backhoff et al., 2006). Se trata de reconocer los conocimientos básicos estructurales; observar cómo a lo largo del currículo éstos se amplían y complejizan de manera articulada. De aquí la estructura de complejidad multinivel que define los niveles de dificultad (Fig. 4). Por ejemplo, se identifica cuándo es la primera vez que se presenta en el currículo el concepto de átomo, y se da seguimiento para observar el tratamiento que se le da a esta noción en niveles superiores. El concepto de átomo es básico y estructural para poder comprender conceptos más complejos como el de isótopo, porque se requiere comprender la estructura atómica (núcleo) y sus componentes (protones y neutrones) para poder entender que el desbalance forma un isótopo. Se trata, entonces, de evaluar conocimientos básicos que se precisan en los planes de estudio de los programas de educación obligatoria, y que se definen como aprendizajes esperados.

Así mismo, se presenta una propuesta innovadora con relación a la forma de evaluar dichas competencias curriculares, en el sentido de alejarse del formato tradicional de selección de respuesta. En el nuevo modelo se utilizan formatos de respuesta construida y semi-construida, que implican la ejecución de respuestas en contexto. Así resultan los reactivos más naturales o auténticos para evaluar el aprendizaje, dado que en la vida cotidiana se responde en contextos, de acuerdo a la "evaluación auténtica" (Chittenden, 1991; Darling-Hammond y Snyder, 2000).

El modelo del EXCOBA consiste en presentar tareas evaluativas complejas, que requieren del sustentante construir las respuestas o integrarlas dentro de un esquema o contexto. Esto permite otorgar crédito parcial a las respuestas, con base en sus aciertos, errores y omisiones, con lo que se mejora la precisión de la evaluación.

Prototipos de reactivos

El GeneEx es capaz de proveer una infinidad de versiones de reactivos isomorfos estadísticamente equivalentes en diferentes campos del conocimiento que son definidos en una tabla de especificaciones.

En el campo del conocimiento matemático, tanto los indicadores nacionales obtenidos por EXCALE (Examen para la Calidad y el Logro Educativo), como los internacionales de PISA (Programme for International Student Assessment), permiten apreciar que una de las áreas de mayor dificultad para ser comprendida por los estudiantes son las relaciones numéricas básicas, como porcentajes, decimales o fracciones.

Una manera de evaluar esta habilidad es pidiéndole al estudiante que marque el número de partes que son necesarias para igualar la fracción que se solicita, en este caso, dos quintos (2/5), como se ve en la Fig. 5-A.

Aquí el sustentante debe construir su respuesta marcando el número de partes que correspondan a dos quintos de la figura (el cuadrado). No hay un orden predefinido y puede haber muchas respuestas para responder este reactivo correctamente. Con esto se rompe la idea común de que ante una pregunta hay, y debe haber, solamente una respuesta correcta, más cuando se trata de un problemas de matemáticas. En la Fig. 5 se observan dos opciones distintas de respuestas (B y C) entre muchas otras posibles, que son igualmente correctas y equivalentes, aunque son distintas; lo que muestra que es un reactivo de comprensión.

En la Fig. 6 se puede ver un reactivo isomorfo de la pregunta anterior, en tanto que explora la misma área de conocimiento (corresponde al mismo contenido), y tiene un nivel de dificultad equivalente; de igual manera, es de respuesta construida, y puede haber múltiples formas de contestarlo correctamente.

Para entender el funcionamiento del GenerEx en este tipo de reactivos, de una plantilla de ítems isomórficos la computadora selecciona una fracción (2/5, 3/5, 4/5, 2/6, 3/6, 4/6, etc.), de manera que la figura contenga múltiplos de la fracción correspondiente. Así se puede presentar un número indefinido de reactivos equivalentes en dificultad y contenido. Es importante resaltar que puede haber muchos reactivos isomórficos cambiando las figuras (octágonos, rombos, cuadrados, círculos, etc.), así como su color y tamaño, por lo que nuevamente se puede decir que es muy difícil que dos sustentantes tengan un ítem con la misma fracción, la misma figura, del mismo color y en el mismo momento; por lo tanto, es casi imposible copiar en este tipo de exámenes, pero aún más importante, también es muy difícil obtener aciertos por respuestas dadas al azar.

En la Fig. 7 se presenta un reactivo correspondiente al área de lenguaje. Se evalúa la comprensión ortográfica en el contexto de una narrativa que constituye un campo semántico que otorga significado específico a las opciones de respuesta. No se trata de reglas ortográficas puntuales de memorización, sino que se refiere a la comprensión del uso apropiado de acentos diacríticos como: esta cuando es adjetivo demostrativo, ésta cuando es pronombre y está cuando es verbo, o una letra que transforma la función de un verbo, como: has de haber y haz de hacer. Si una persona no reconoce estas diferencias, sus competencias para expresarse apropiadamente por escrito estarán más limitadas en comparación con quien sí las domina. Lo relevante es que la competencia tanto de escritura como de lectura están vinculadas, de aquí que es posible obtener alguna valoración por medio de estos indicadores, en tanto habrá una correlación entre quien comprende estas reglas ortográficas, sabe escribir con mayor propiedad y es más asiduo/a a la lectura, es decir, hay correlatos que ofrecen indicadores indirectos del dominio en ciertos campos del conocimiento.

En el primer recuadro (A) de la Fig. 7 se da un ejemplo de un reactivo de comprensión de reglas ortogáficas dentro de un contexto de escritura. En el segundo recuadro (B) se puede apreciar la manera en que se comporta el sistema cuando el sustentante contesta. Obsérvese que al colocar el cursor en la línea de la palabra demandada, automáticamente se despliegan varias opciones de respuesta, de las que se requiere seleccionar por comprensión, no por memorización, la que es apropiada para el contexto específico. En el último recuadro (C) se ofrece el reactivo cuando se ha respondido apropiadamente.

Es importante resaltar que el reactivo no se contesta con una respuesta, sino que requiere de 10 respuestas, de tal forma que se puede calificar con crédito parcial; de esta manera se hace posible evaluar con mayores niveles de precisión. El conocimiento se da en un continuo: en un campo semántico se pueden tener nociones, se puede saber más o menos sobre cierto tema. El conocimiento no es dicotómico: sí se sabe o no se sabe; es politómico, en el sentido de que se tienen ciertos conocimientos y otros se ignoran.

En la Fig. 8 se presenta un prototipo de reactivo para evaluar conocimientos de química. Un conocimiento fundamental básico estructural en química es la tabla periódica, dado que organiza, clasifica y distribuye a los elementos químicos conforme a sus propiedades y características; constituye una estructuración de todos los elementos a partir de su número o peso atómico, y conforma un ordenamiento en periodos y grupos que se distinguen por sus propiedades y características físico-químicas. La tabla periódica constituye un campo semántico, un mapa conceptual cuya comprensión permite la operatividad cognitiva. Solicitar al sustentante que escriba el nombre y símbolo del elemento a partir del número atómico no trae consigo una respuesta de memorización, ya que lo que se requiere es comprender la organización de la tabla y leer para transcribir las respuestas puntuales. De igual manera, se podría solicitar en otro reactivo isomórfico que transcriba el valor del peso atómico de los elementos que se cuestionan, ya que igualmente están dados en la tabla.

Este reactivo permite una evaluación auténtica porque en la vida cotidiana todos podemos fácilmente consultar la tabla periódica. Es absurdo pretender memorizarla, a pesar de que todavía hay profesores que así lo requieren y que lo que evalúan es su memorización.

Ahora se presentan algunos prototipos de reactivos en el terreno de los conocimientos sociales relacionados con el área de geografía e historia. Igualmente, en estas áreas se presentan campos de conocimiento estructurados donde el sustentante tiene que integrar (construir) su respuesta. Para ejemplificar, hemos considerado la evaluación de los conocimientos de geografía política que tiene una persona. Para evaluar este tipo de conocimiento, en un reactivo del EXCOBA se le presenta al sustentante un mapa de la geografía política de México con los 32 estados y sus capitales, sin sus nombres, y a un lado se ofrece un listado con el nombre de seis estados y seis capitales, los cuales son seleccionados al azar por el sistema computarizado atendiendo un criterio de distribución: dos del norte, dos del centro y dos del sureste. Se solicita que seleccione cada uno de los nombres que están en el listado (haga clic sobre el nombre) y los "arrastre" (drag) hasta el lugar correspondiente en el mapa, tal y como se ve en la Fig. 9.

De esta manera se explora el conocimiento geográfico que tiene el sustentante sobre un contexto general estructurado, lo que resulta en un proceso de evaluación más auténtica, ya que se apega a las circunstancias en que se suele presentar en la vida cotidiana el conocimiento de la geografía política del país. Esto contrasta mucho con lo que sería una pregunta similar formulada en opción múltiple, tal como: "la capital del Estado de México es: a) Chetumal, b) Campeche, c) Toluca, d) Mexicali". En este reactivo de opción múltiple sólo hay una opción correcta, mientras que el reactivo estructural se construye con 12 posibles respuestas, se exploran más conocimientos y se requiere saber más. El reactivo estructural podría contener más elementos o menos, y se puede calificar con crédito parcial, es decir, tener una evaluación ponderada en función del número de elementos que se hayan colocado de manera correcta.

La decisión de cuántos elementos debe contener cada reactivo, y de si se debe dar crédito parcial ponderado o redondear, se tiene que tomar con base en los análisis empíricos que permitan obtener los mejores indicadores psicométricos de validez predictiva. Esto es así porque en los procedimientos digitales (la analítica de datos, big data) es posible registrar todas las respuestas y que éstas vayan alimentando una base de datos; de esta manera, el sistema puede procesar, seleccionar y organizar las preguntas de acuerdo al registro histórico por orden de dificultad, definida de manera operativa: muy sencillas (preguntas en que aciertan los sustentantes en más de 80 por ciento en promedio), sencillas (donde acierta entre 60 y 79 por ciento), de dificultad media (acierta entre 40 y 59 por ciento), compleja (acierta entre 20 y 39 por ciento), y muy compleja (acierta no más de 19 por ciento). Para el caso del ejemplo de los estados y capitales de México, se puede programar para que el sistema presente estados del norte, del centro y del sur, en cada caso uno de ellos complejo y el otro sencillo, lo que permitirá estructurar reactivos de doble criterio: distribución geográfica y dificultad.

En el reactivo de opción múltiple presentado puede haber un error de sesgo de orden fonético (Mexicali - Estado de México), lo cual queda anulado en el formato estructural, porque se responde a una representación integral en un campo estructurado (un mapa). Otro sesgo en la pregunta de opción múltiple es que quienes son originarios del Estado de México o entidades federativas vecinas se verán beneficiados porque les será más fácil saber la respuesta correcta que a una persona que es oriunda de un estado lejano, es decir, la referencia a Toluca será más frecuente para quien vive en ella o cerca de ella. Este sesgo no se da en el reactivo estructural constructivo, ya que, como se ha dicho, el examinado requiere colocar el nombre de seis estados y seis capitales, dos del norte, dos del centro y dos del sur, lo que neutraliza los sesgos favorables o desfavorables por la región de procedencia; todos tendrán equiparadas, de alguna manera, las ventajas de la cercanía y las desventajas de la lejanía.

Lo más relevante de este tipo de reactivos es que evalúa conocimientos estructurales que son consustanciales para la comprensión y asimilación de conocimientos vinculados a esta área semántica. El conocimiento no se da atomizado. Por ejemplo, cuando se conoce una noticia y se tiene conocimiento del lugar de su ocurrencia, la nota cobra otro significado y significación, porque hay mayor irradiación semántica. Si se analiza el conocimiento de geografía política con otros conocimientos relacionados, se observa que hay correlación: no es común saber el nombre del gobernador de un estado y no saber de qué estado se trata y dónde se ubica. Si se ignora esto es claro que el significado y la significación semántica son pobres. Si se explora el conocimiento que se tiene de las estructuras de gobierno (municipio - estado - federación), de la división de poderes (legislativo - ejecutivo - judicial), y de los gobernantes, se observa que hay una correlación que es indicativa de niveles de dominio de esta área de conocimiento. No será lo mismo quien asiste a votar y no logra reconocer la diferencia entre candidatos a la diputación estatal y la federal, respecto de quien sí la distingue. Esto es lo que da sustento profundo a este procedimiento de evaluación por reactivos estructurales, en tanto explora campos semánticos.

Esta misma estrategia se puede seguir para obtener indicadores de niveles de dominio de áreas de conocimientos en geografía internacional, al solicitar la ubicación en un mapamundi de ocho países y ocho capitales, dos del continente americano, dos del europeo, dos del africano y dos del asiático; uno sencillo y otro complejo, definidos operativamente. El estructurar reactivos con preguntas sencillas y complejas es importante porque así se construyen escalas: por ejemplo, identificar la capital de Estados Unidos (Washington) será más fácil que la de Paraguay (Asunción), dadas las marcadas diferencias en las implicaciones políticas, económicas, históricas y culturales que se tienen. El poder de discriminar se da al contar con escalas (preguntas muy sencillas, sencillas, medio sencillas, medio complejas, complejas, muy complejas), cuya congruencia entre el poder de discriminación y confiabilidad se puede medir con la prueba Alpha de Cronbach. Una prueba no es un agregado de preguntas, es un diseño estructurado y balanceado de preguntas que componen escalas de media; para juzgar si una persona es alta o baja de estatura, se requiere tener una escala de referencia definida dentro de un contexto.

De igual manera, en un mapamundi se puede explorar la ubicación de sitios históricos, aportaciones culturales, personajes históricos y políticos; o bien de otra naturaleza, como ríos, montañas, fauna, puntos de coordenadas, etcétera, en tanto constituyen indicadores del dominio de ciertos campos semánticos de conocimiento.

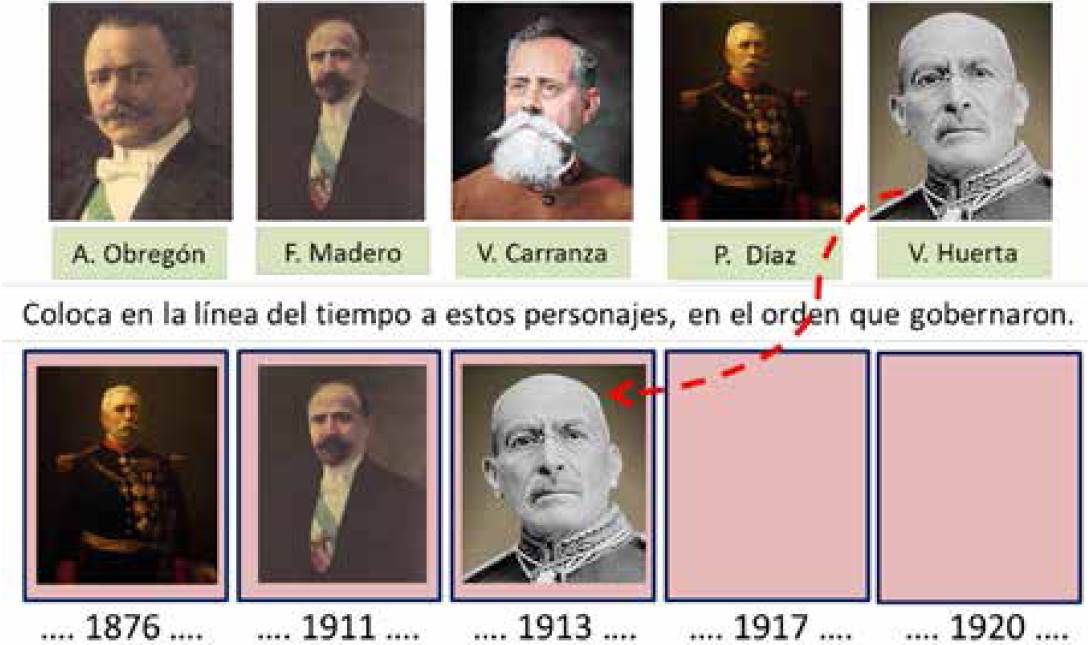

Para finalizar se ofrece en la Fig. 10 el prototipo de un reactivo en formato digital apoyado por representación visual para valorar conocimientos de historia de México. En contraste a un planteamiento de opción múltiple, el ítem consiste en solicitar a los sustentantes que acomoden (arrastrando) las imágenes en la línea del tiempo, atendiendo el orden en que gobernaron los personajes históricos que se presentan.

En la pregunta subyace una estructura cronológica fundamental para poder organizar y comprender la revolución mexicana, ya que Díaz fue derrocado por el movimiento revolucionario que emplazó Madero, Madero fue derrocado por un golpe de Estado que encabezó Huerta, Huerta fue derrotado por las fuerzas revolucionarias encabezadas por Carranza, y Carranza fue asesinado por orden de Obregón. La respuesta implica un problema estructural, porque se requiere concatenar los acontecimientos, acomodarlos en el orden histórico, lo que traza una visión básica estructural de la historia de México de la segunda década del siglo XX que fue particularmente crítica y trascendental.

En el formato de opción múltiple esta pregunta sería: "De los siguientes personajes, cuál es el orden en que gobernaron: a) F. Madero P. Díaz V. Carranza V. Huerta. A. Obregón; b) V. Huerta P. Díaz V. Carranza F. Madero A. Obregón; c) P. Díaz F. Madero V. Huerta V. Carranza A. Obregón; d) F. Madero V. Carranza P. Díaz V. Huerta A. Obregón.

Es importante observar que cuando esta pregunta se formula en formato digital, a diferencia de la opción múltiple, se plantea mediante la representación visual dada por la imagen, así como la representación conceptual por los nombres de los personajes y el eje cronológico. Las imágenes contribuyen a facilitar la elaboración de la respuesta porque en ellas hay conocimiento representado en códigos visuales, lo cual ayuda si se tiene la representación icónica de los personajes; este conocimiento es importante para el logro de las competencias. Además, la estrategia de ir arrastrando las imágenes para colocarlas en la línea del tiempo hace que la actividad sea más creativa, rápida y fácil en tanto se va estructurando la integración de la respuesta; esta manera de formular el reactivo cambia la actitud del sustentante respecto al de opción múltiple, donde sólo se reconocen los nombres y el ordenamiento de los personajes. De acuerdo con la taxonomía de Bloom y Krathwohl (1966), el reconocimiento es el nivel más bajo en la elaboración de una respuesta, lo cual permite apreciar lo limitado que resulta un formato de selección de respuesta comparado con los reactivos estructurales constructivos.

Otro parámetro que se puede ponderar en los reactivos es la dimensión del error. No todos los errores son iguales; unos demuestran mayor desconocimiento porque son más graves que otros. Por ejemplo, en la secuencia histórica de los presidentes enunciados, no es un error equivalente el colocar a Obregón antes de Carranza, a antes de Díaz, ya que el primero es un error de años y el segundo de décadas. De aquí que en las propiedades de un error también hay potencialidades para afinar los proceso de evaluación, al ponderar el nivel de los errores cometidos.

En la base de datos que configura esta pregunta se puede poner el listado de 20 presidentes mexicanos, los más importantes por su relevancia histórica, y seleccionar, de acuerdo al registro histórico, seis de ellos al azar, por orden de dificultad: dos fáciles, dos de dificultad media y dos difíciles.

Discusión

Es importante considerar algunas de las limitaciones que ahora presentan la evaluación computarizada y la generación automática de exámenes. Por un lado, se sabe que en México la infraestructura computarizada es aún limitada en las escuelas públicas, especialmente en las del nivel básico y particularmente en las que se ubican en zonas rurales. Así mismo, muchos docentes están poco familiarizados y carecen de entrenamiento para utilizar recursos digitales con propósitos educativos. Las condiciones escolares del país hacen que la evaluación por computadora sea aún un tema ajeno para muchos profesores, e inaccesible para la realidad cotidiana del salón de clases en la mayoría de las escuelas públicas del nivel básico, por lo que muchos estudiantes pueden enfrentar dificultades cuando se presenten por primera vez a una evaluación que les requiera utilizar una computadora. Claro que esto puede ser obviado si previamente se les proporciona el entrenamiento requerido.

Es importante considerar que el uso de las tecnologías digitales presenta crecimientos exponenciales, particularmente los dispositivos móviles de interconexión (teléfonos inteligentes y tabletas) que son cada vez más económicos y más utilizados, aun en sectores de ingreso limitado. Las competencias digitales están en constante expansión, lo que parece ser una transformación cultural progresiva irreversible, característica de nuestro tiempo.

También es importante tener presente que, aunque los generadores automáticos de ítems pueden resolver el problema de la construcción de ítems isomorfos y exámenes paralelos, representan tan sólo una manera más de acercarse al complejo proceso de la evaluación de las competencias ganadas por los escolares y del logro educativo alcanzado. Los docentes sin duda deben seguir cultivando los muy diversos procedimientos de evaluación que se pueden realizar en el aula a partir de los productos generados por los alumnos, así como aprovechar otros referentes, como pueden ser procesos de evaluación auténtica, co-evaluación, auto-evaluación y meta-evaluación, todos estos aprovechados en una dinámica longitudinal de evaluación formativa.

Hay que comprender que los diversos procesos de evaluación son complementarios y no excluyentes; unos no cancelan a los otros, por el contrario, agregan, al crear una visión desde diferentes perspectivas, y conforman representaciones que se deben integrar en una coherencia y congruencia explicativa de la complejidad educativa.

Conclusión

Los sistemas de cómputo están transformando de manera muy profunda los procesos de evaluación en todos los campos; en el campo de la medicina, por ejemplo, la revolución de los datos masivos (big data) y la telemática permiten ahora levantar registros y monitorear el ritmo cardiaco de decenas de miles de personas con dispositivos electrónicos móviles, como un sensor de pulsera, y así evaluar los efectos de un fármaco en contextos y tiempo real, es decir, se puede hacer una evaluación auténtica del comportamiento del sistema cardiovascular.

Dado el crecimiento exponencial en la capacidad de almacenar, transferir, investigar, depurar (desagregar y robustecer), visualizar, distribuir y analizar enormes cantidades de información, gracias al formato digital, se ha desarrollado la minería de datos, la cual, en el campo de la investigación educativa, ha dado lugar al learning analytics (Ari y White, 2014), que permite hacer mediciones, análisis y reportes para comprender los procesos del aprendizaje y su evaluación.

Con el GenerEx y el EXCOBA se obtienen registros de cuántos segundos tardó cada sustentante en contestar cada pregunta de la prueba, lo que permite hacer análisis estadísticos integrados bajo la teoría clásica de la medida y la teoría de respuesta al ítem (TRI), para así definir nuevos valores psicométricos; esto ofrece una aproximación de vanguardia en el campo de la evaluación educativa.

En los sistemas de cómputo un estudiante, al ingresar, genera una identidad electrónica, que permite obtener trayectorias longitudinales de su desempeño; esto transforma los procesos de evaluación. El estudiante puede responder en línea a la hora y lugar que sea de su conveniencia; incluso si se interrumpe la energía en el momento de contestar un examen, es posible continuar posteriormente ya que, como todo está soportado en bases de datos, se puede reconfigurar la situación. Al crear la identidad electrónica los sistemas de seguridad permiten obtener registros que no son vulnerables a la suplantación, tales como fotografías e información biométrica a partir de tomas de huellas digitales o registro del iris ocular.

La identidad electrónica permite llevar registro del uso de la guía del examen en línea (demo), su frecuencia, tiempo de entrenamiento, velocidad de respuesta considerando el tiempo de reacción (entre que aparece una pregunta y se emite una respuesta al dar un clic) y el tiempo de respuesta (entre que aparece una pregunta y se da por terminada al pasar a otra pregunta); con ello se hace posible analizar indicadores que permitan evaluar los reactivos en contextos diferentes al de la aplicación de un examen.

Además, dado el soporte digital, hay plena transparencia al imprimir el resultado obtenido en el momento de concluir el examen; además, se puede revisar detenidamente, en otro momento, la ejecución de cualquier sustentante para despejar todas las dudas que pudiera tener, lo que también puede generar aprendizaje. Con los resultados en el examen, las trayectorias de desempeño y los cuestionarios de contexto se pueden realizar análisis multinivel de los factores socioculturales asociados al desempeño y crear políticas institucionales de atención diferenciada.

Pero, a nuestro juicio, la ventaja más relevante de la revolución digital en el campo de la evaluación está en la transformación operativa que permite utilizar procedimientos más acordes a los paradigmas cognoscitivos. En el EXCOBA ha sido posible aplicar los principios del construccionismo, considerando que el conocimiento está integrado en estructuras cognitivas, en campos semánticos que tienen una irradiación de aprendizaje expansivo, como se ilustró en el ejemplo de la vaca de la Fig. 1. Las preguntas no se responden por reconocimiento, sino que hay una elaboración de la respuesta, dado un contexto, donde es muy difícil obtener aciertos por azar o por copia. Tampoco tiene que ser dicotómica (acierto o error); puede ser politómica, ya que requiere varias respuestas de las cuales algunas pueden ser correctas y otras no. Esto posibilita la evaluación con crédito parcial, lo que contribuye a mejorar los niveles de precisión de los procesos de evaluación.

La mediación digital permite medir el conocimiento representado en diferentes códigos, como el visual, a partir de imágenes dinámicas, o la ubicación de eventos dentro de un mapa, donde se configura una gestalt. En un mapa están implícitas todas las distancias entre dos puntos (ciudades o pueblos); no es conocimiento puntual, es heurístico, de manera que el sustentante responde ante contextos y construye su respuesta. Este proceso es mucho más cercano a lo que ocurre en la vida cotidiana, y por lo mismo más próximo a lo que se conoce como evaluación auténtica, que valora competencias para la vida, no sólo para la escuela.

Con el nuevo paradigma que se ha planteado en este trabajo, se pueden apreciar algunas de las múltiples ventajas de la revolución digital en el campo de la evaluación educativa.

text new page (beta)

text new page (beta)