Introducción

Las tareas de evaluación forman parte del quehacer cotidiano de los académicos. Se manifiestan en múltiples instancias y formas. Pueden incluir dictaminar sobre la calidad de un artículo para una publicación científica, evaluar a los colegas en el jurado de un premio o formar parte de una comisión que determine el otorgamiento de estímulos, subsidios, plazas, promociones, definitividades, etc. Puede ser ex ante o ex post, entendiendo la primera cuando se juzga sobre un proyecto o actividades aún no realizadas, y la segunda cuando de lo que se trata es de determinar si se han cumplido las metas formuladas en un proyecto o actividad ya transcurrida. También puede darse una combinación de ambas, cuando, por ejemplo, se analiza la trayectoria previa de una persona en conjunto con su propuesta de trabajo que va a realizar a futuro.

En este contexto, las revistas académicas fueron adquiriendo un papel privilegiado como aseguradoras de la calidad de la producción científica. En tanto la publicación en las mismas está sujeta a un arbitraje previo de otros miembros de la comunidad, se consideró que el hecho de publicar un trabajo en una revista que contara con este mecanismo de evaluación podía ser una medida de su calidad. Las revistas adquirieron, entonces, una función central en el proceso de evaluación. En tanto un comité de pares no necesariamente tiene la posibilidad –ni la experticia específica– para analizar en detalle todos los trabajos del académico evaluado, confía en el juicio de los pares que dictaminaron favorablemente el artículo para su publicación. Dado que esto requiere que se tenga confianza en los procesos internos de las revistas, ello dio lugar a diversas estrategias para establecer criterios editoriales y procedimentales que permitieran a los pares delegar en ellas el juicio de calidad.

El surgimiento de la cienciometría contribuyó en parte a este objetivo. El estudio cuantitativo de las producciones científicas permitió realizar inferencias acerca de cómo se estructuran jerárquicamente las comunidades académicas y cómo se atribuye el prestigio. El mayor impacto de los métodos cuantitativos lo constituyó el intento de Eugene Garfield de establecer un conjunto de revistas centrales [core journals], en la década de 1950 (Garfield, 1955). La base de datos que lanzó Garfield en 1964, el Science Citation Index (SCI), sistematiza la información de las citas que los artículos hacen a otras revistas, con lo cual se puede conocer el “factor de impacto” (FI) de una determinada publicación, entendido éste como una función de las citas recibidas por artículo en otras publicaciones científicas igualmente arbitradas, en un periodo de dos años. El SCI es el antecedente de lo que hoy se denomina Web of Science (WoS), base de datos desarrollada originalmente en el Institute of Scientific Information (ISI). Los resultados del cálculo del factor de impacto de las revistas a partir de datos de WoS se dan a conocer en el Journal Citation Reports (JCR) cuyos datos provienen de tres secciones que conforman la WoS: Science Citation Index Expanded (SCIE), Social Science Citation Index (SSCI) y Arts&Humanities Citation Index (AHCI), aunque debido a que en artes y humanidades el nivel de citación es mucho menor, no se calcula el factor de impacto de esas revistas, sino simplemente se emite un listado de las mismas.1

En años recientes, los indicadores derivados de los índices de citación se han multiplicado y se han vuelto más complejos. El factor de impacto de una revista hoy compite principalmente con otro indicador bibliométrico similar, creado a partir de datos de Scopus, base de datos perteneciente a la empresa Elsevier. Este indicador, llamado SCImago Journal Rank Indicator (SJR, por sus siglas en inglés) fue desarrollado por el grupo SCImago, una empresa conformada por académicos del Consejo Superior de Investigaciones Científicas (CSIC), de la Universidad de Granada, Extremadura, Carlos III (Madrid) y Alcalá de Henares, de España. Tanto el acceso a la WoS como a Scopus se realiza por suscripción, pero los datos del SJR sí se encuentran disponibles públicamente, a través del SCImago Journal & Country Rank.

También existen diversas métricas a nivel de autor, como el índice H, o valoraciones de desempeño institucional, como las que alimentan la clasificación o ranking de las universidades. Por otra parte, han surgido iniciativas que buscan otras formas cuantitativas de medir el impacto de una publicación que no estén basadas únicamente en las citaciones recibidas; son las llamadas “métricas alternativas” o altmetrics, que se construyen a partir de las actividades académicas en la web social (Vidal, 2015). Esta tendencia ha sido vista con recelo por muchos investigadores, que temen por los abusos que pueden derivarse de esta “marea métrica” (HEFCE, 2015; Hicks et al., 2015).

Por otra parte, cabe destacar que la creciente importancia de la construcción de métricas y dispositivos cuantitativos de evaluación no es patrimonio exclusivo del campo académico, como han mostrado Power (1999), con su concepto de audit society, o Dahler-Larsen (2011), con el de evaluation society. Beer (2016) ha hablado del poder de las métricas y de su avance en distintos ámbitos de la vida social, a través de un proceso que denomina “metrificación de la sociedad”.

En el presente trabajo nos ocupamos de una de las formas en que estas prácticas de evaluación cuantitativa están permeando la evaluación del trabajo de los académicos en América Latina, particularmente de los de ciencias sociales. Nuestro foco de atención no son las prácticas de evaluación en sí mismas, sino la construcción de instrumentos que posibilitan la introducción en ella de criterios ligados a la bibliometría. En concreto, analizaremos la forma en la que tres países de la región (Argentina, México y Colombia) han construido sus sistemas de clasificación de las revistas académicas. En forma indirecta, estos sistemas envían señales a las prácticas de evaluación y condicionan a los propios investigadores. Esto es así en la medida en que los sistemas de evaluación estatales incorporan explícitamente estas clasificaciones a la hora de valorar el trabajo de los académicos. Nuestra hipótesis es que las reformas recientes a estos sistemas de clasificación están tendiendo a otorgar un papel central a medidas basadas en la citación, en detrimento de otros indicadores e indexaciones, sin la debida discusión de los impactos que esto puede tener tanto en las prácticas de edición de revistas académicas como en las dinámicas de producción de conocimiento.

El artículo se estructura de la siguiente manera. En primer lugar, presentamos las dificultades que podría tener para las ciencias sociales latinoamericanas la incorporación acrítica de dichos indicadores bibliométricos. Luego, analizamos los sistemas de evaluación de revistas de los tres países y el lugar que en ellos ocupan los indicadores y las indexaciones. Finalmente, examinamos a través de qué instrumentos estas medidas pueden influir en las prácticas efectivas de los académicos y las precauciones que deberían tenerse en cuenta al respecto.

Ciencias sociales en América Latina: doble periferia en la evaluación bibliométrica

Autores como Castellani, Pontecorvo y Valente (2016), Hicks et al. (2015) y Martin y Whitley (2010), así como la Declaración de la ACSB (2012), entre otros, han advertido que la inclusión de indicadores bibliométricos resulta polémica en todas las áreas del conocimiento. En el campo de las ciencias sociales y humanidades en América Latina, el tema es particularmente complejo, ya que la producción en estas áreas no está suficientemente representada en las bases de datos utilizadas para construir los principales indicadores bibliométricos, como el factor de impacto (Rafols y Molas, 2016; Alperin, 2014; Cetto y Alonso-Gamboa, 1998). Esto configura un sesgo importante en el análisis de la producción académica regional. En este sentido, puede afirmarse que es un campo que constituye una “doble periferia”: disciplinaria y lingüístico-geográfica. La periferia disciplinaria refiere a las limitaciones específicas de los indicadores bibliométricos basados en citas para dar cuenta de la producción en las ciencias sociales. La periferia lingüística da cuenta de la limitación en la cobertura de publicaciones realizadas en español y portugués, y en idiomas diferentes del inglés, en general. Finalmente, la periferia geográfica está estrechamente relacionada con la segunda y se vincula con la potencial marginación en las revistas de mayor impacto de las agendas de investigación de interés local en los países de América Latina.

La periferia disciplinaria

Los mecanismos a través de los cuales las ciencias sociales y las humanidades comunican los resultados de sus investigaciones difieren sustantivamente de los empleados por las ciencias biológicas, exactas y naturales. Mientras las últimas se centran en artículos publicados en revistas científicas indexadas en bases de datos internacionales, las ciencias sociales y las humanidades tienen una diversidad mayor de formas de diseminación de resultados. Para ellas es muy importante también la publicación en revistas nacionales, libros y capítulos de libros académicos, libros orientados a una audiencia más amplia (denominados en inglés enlightment literature) y monografías y documentos de trabajo que se encuentran en una zona gris entre la academia y la política pública. A su vez, en las artes encontramos contenido que no es textual, como en el caso de la música y el teatro (Martin, 2010; Nederhof, 2006). Small y Crane (1979) señalan que 39% de las citas en sociología y 25% en economía correspondían a libros, mientras que en física de alta energía éstas representaban sólo 0.9%. A partir de ello, Hicks (2005) estima que entre 40% y 60% de la literatura de las ciencias sociales corresponde a libros. Por su parte, Glänzel y Schoepflin (1999) encontraron que las referencias a revistas constituyen 94% en inmunología, pero tan solo 35% en historia, filosofía y ciencias sociales.

Las dificultades a la hora de evaluar la producción de las ciencias sociales surgen en tanto los indicadores bibliométricos que incorporan información de citación están basados centralmente en dos fuentes de información: WoS y Scopus. En estas bases de datos la cobertura de revistas de ciencias sociales y humanidades es mucho menor que la de otros campos del conocimiento. Nederhof (2006) pasa revista a numerosas investigaciones que señalan, por ejemplo, para el caso de las universidades neerlandesas, que la cobertura del WoS para disciplinas como administración pública es solamente de 2%, mientras que en psicología experimental llega a 62%. Sobre los sesgos que un uso acrítico de estos indicadores puede producir, observa que “los científicos naturales tienen un número mayor de artículos en los índices del WoS que los académicos de ciencias sociales y humanidades, aun cuando sean igualmente productivos en términos de cantidad de artículos publicados” (Nederhof, 2006: 91). Cabe destacar que ambas empresas realizan esfuerzos constantes para ampliar la información disponible a fuentes distintas de los artículos. Scopus, por ejemplo, incluye una cantidad cada vez mayor de libros. WoS, por su parte, ha creado una nueva base de datos, llamada Emerging Sources Citation Index, en la que incluye a revistas que han solicitado su ingreso a las bases principales, con lo que amplía la exhaustividad y suma a las otras bases de datos regionales, como el Korean Journal Database (Repiso y Torres-Salinas, 2016).

El riesgo de dar un peso preponderante a la información proveniente de estas bases de datos para la evaluación puede llevar a desatender los resultados de investigación que no se expresan en artículos. En este sentido, Hicks (2005; 2013) señala que existen cuatro conjuntos de productos en las ciencias sociales: los artículos indexados, que son internacionalmente reconocidos y comparables; los libros, que pueden presentar investigaciones de más largo alcance; las literaturas nacionales, que enfatizan problemas locales; y las publicaciones no académicas que contribuyen a la aplicación del conocimiento. La identidad de las ciencias sociales está asociada con todas estas funciones y, por lo tanto, el uso de indicadores que no recojan adecuadamente información de publicaciones de todos estos tipos no puede ser hegemónico en estas disciplinas.

La periferia lingüístico-geográfica

Si las ciencias sociales en sí constituyen un espacio marginado por los principales indicadores bibliométricos, esta periferia se acentúa al considerar las ciencias sociales producidas en el contexto geográfico latinoamericano. En primer lugar, hay una tendencia a la sub-representación relacionada con lo lingüístico. Las bases de datos principales incorporan una gran mayoría de revistas publicadas en inglés. Archambault et al. (2006) comparan las revistas indizadas por WoS con las contenidas en el directorio Ulrich’s2 y señalan que, mientras 75% de las revistas en Ulrich’s se publica en inglés, en WOS este porcentaje asciende al 90%. La sub-representación del francés es de 26%, del alemán, 50%, y del español, casi 70%. Los autores señalan que, si bien existen otras bases de datos, la comunidad de bibliómetras está “casada” con WoS, en parte porque esta base se ha desarrollado teniendo en cuenta los intereses de la comunidad académica de investigadores. Esto hace que, si bien pueden existir otras fuentes de información más representativas, la sub-representación en las bases de datos principales sigue siendo una cuestión problemática.

Si además de analizar el lenguaje de publicación nos centramos en el país en el que las revistas son publicadas, sólo se incluye a uno de América Latina: Brasil (Archambault et al., 2006), para el cual se informa que la sub-representación de revistas brasileñas en WoS frente a Ulrich’s es de 96%. Martin (2010) señala que la competencia comercial entre Thomson Reuters y Elsevier puede generar una dinámica provechosa en el sentido de proveer una mayor cobertura en las regiones del mundo en desarrollo. La inclusión de las revistas en la plataforma de origen brasileño, Scientific Electronic Library Online (SciELO), y como una colección regional en WoS (Scielo Citation Index), a partir de 2014, puede interpretarse como un resultado de esta competencia.

La menor participación de la región en estos índices no significa que no se hayan desarrollado estrategias regionales para incrementar la calidad editorial de las revistas científicas y aumentar su visibilidad. Existe en la región una fuerte inclinación por publicar las revistas en acceso abierto. Esto se relaciona, entre otros factores, con el alto porcentaje de las revistas latinoamericanas que son editadas por instituciones académicas y no por editoriales comerciales (Alperin y Fischman, 2015). Por otra parte, dado el bajo número de instituciones de la región que posee un presupuesto importante destinado a los costos de suscripción, de no optarse por el acceso abierto muchos potenciales lectores interesados no podrían hacer uso de los contenidos. Actualmente, de las más de 9 500 revistas que forman parte del Directory of Open Access Journals (DOAJ), aproximadamente 17% son latinoamericanas, de las cuales cerca de mil son brasileñas. Además, existen tres portales de revistas de acceso abierto desarrollados en América Latina: Latindex,3 SciELO4 y Redalyc,5 que garantizan criterios de calidad editorial de las publicaciones que incluyen. En este sentido, debe ponerse ya en duda la identificación que algunos, como Jeffrey Beall (citado en Butler, 2013), establecen entre acceso abierto y revistas predatorias.6

Un problema central que se encuentra fuertemente relacionado con el reto de la visibilidad y el reconocimiento de las revistas latinoamericanas es el de las agendas de investigación. Las revistas privilegian la publicación de contribuciones que abordan temas actuales o “de moda” en las disciplinas, los cuales suelen estar ligados a las tendencias predominantes en los países que las editan. El problema surge porque, como hemos visto, la gran mayoría de las revistas que figuran en las principales bases de datos bibliométricas son editadas en países centrales que tienen más preferencia por los temas que se están discutiendo allí. Esta problemática ya había sido planteada en la década de 1960, en el marco del llamado “Pensamiento Latinoamericano en Ciencia, Tecnología y Desarrollo” (Dagnino, Thomas y Davyt, 1996; Feld, 2015). Dentro de esa corriente, autores como Oscar Varsavsky o Amílcar Herrera veían en las agendas de investigación pretendidamente universales sesgos hacia temáticas de interés para los países desarrollados. Con distintos matices, impulsaban una “ciencia nacional” que estuviera ligada de modo más directo con las problemáticas más acuciantes en los países en desarrollo (Vasen, 2016).

En fecha más reciente, inspirados en esta línea de argumentación, Vessuri, Guédon y Cetto (2014) critican la ideología unidimensional de la “excelencia”, que identifica la calidad académica con la publicación en revistas internacionales. En la medida en que se incentive a los investigadores a publicar en espacios en los que las agendas de investigación locales no son de particular interés, se verán forzados a modificar sus temas de investigación para adecuarlos a una agenda global. Esto podría implicar un mayor distanciamiento de los problemas locales y, en consecuencia, una menor posibilidad de tener impacto en las políticas públicas o el desarrollo local. Partiendo de la experiencia uruguaya, Bianco, Gras y Sutz (2016) argumentan en la misma línea. Señalan que, si ya de por sí las demandas de conocimiento al sector académico por parte de otros actores sociales son débiles en la región, si a esto se suman mecanismos de evaluación que desincentivan estas vinculaciones y los concentran en alinearse con agendas internacionales, difícilmente podrán la ciencia y la tecnología cumplir las promesas de contribución al desarrollo socioeconómico con las que buscan justificar el financiamiento público que se les otorga.

Finalmente, cabe destacar que, aunque puede ser retóricamente muy efectiva, la oposición binaria entre “centro” y “periferia” oculta la complejidad y los matices de las dinámicas de circulación de conocimiento en la comunidad académica. En este sentido, puede ser hoy más provechoso hablar de centros y periferias, en plural, como propone Kreimer (2016), o de circuitos que operan en distintos niveles, nacionales regionales y globales (Beigel, 2014), sin perjuicio de continuar reconociendo que existen diferencias estructurales en la distribución de recursos.

En síntesis, en esta sección el objetivo ha sido mostrar porqué aplicar al campo de las ciencias sociales y las humanidades en América Latina los indicadores bibliométricos basados en citas más utilizados a nivel global puede generar sesgos indeseados. Por una parte, esto es así en tanto las ciencias sociales comunican sus resultados a través de otros productos, además de los artículos científicos, y estas otras vías de publicación no están convenientemente representadas en las bases de datos. Por otra parte, también están sub-representadas las publicaciones en español y portugués, idiomas principales de difusión de estas disciplinas en la región. Finalmente, en cuanto a lo temático, dada la distribución geográfica de las revistas, se señala que las agendas de investigación predominantes en las revistas indexadas a nivel internacional no necesariamente coinciden con los temas de mayor relevancia local.

Sistemas nacionales de clasificación de revistas académicas: criterios y supuestos

En esta sección nos ocupamos de analizar los sistemas para clasificar revistas académicas que se han originado en tres países latinoamericanos: Argentina, México y Colombia. La selección de los tres casos se realizó en función del problema analizado. México y Colombia han cambiado recientemente sus sistemas y estas tendencias no han sido aún analizadas de modo crítico. Argentina, en cambio, ofrece un contraste, en la medida en que sus normativas están menos alineadas con la tendencia internacional.7

Argentina

Las principales iniciativas de clasificación de revistas en el ámbito de las ciencias sociales en Argentina las ha llevado a cabo el Consejo Nacional de Investigaciones Científicas y Técnicas (CONICET), a través del Centro Argentino de Información Científica y Tecnológica (CAICyT). El primer antecedente se remonta a la conformación de un Núcleo Básico de Revistas Científicas Argentinas, en 1999, mediante la Resolución 2863, que es integrado por ocho revistas. Un año más tarde se constituye un Comité Científico Asesor, compuesto por ocho titulares y seis suplentes de reconocido prestigio en el campo académico y editorial cuya función es evaluar las revistas que se incluyen en el núcleo y reevaluarlas cada tres años para validar su permanencia. En 2001, Argentina se incorpora al proyecto SciELO y se determina que las revistas incluidas en él formarán parte a su vez del Núcleo Básico. En 2005, a través de la Resolución 1640/05, se establecen criterios que deben cumplir las publicaciones del Núcleo Básico, a saber:

Contar con un comité editorial integrado por pares especialistas en su temática;

Estar indizadas en bases de datos internacionales;

Contener un alto porcentaje de artículos y notas breves originales;

Publicar mayoritariamente materiales de autores externos a la entidad editora;

Someter los artículos publicados a estricto arbitraje externo;

Ser reconocidas por su trayectoria y liderazgo en su temática y contar con respaldo institucional, académico o profesional;

Ser editadas regularmente, de acuerdo con la periodicidad declarada por sus editores;

Respetar, en su diseño y formato, las normas editoriales internacionales, cumpliendo con los parámetros de calidad editorial del Sistema Latindex;

Estar registradas en el Centro Nacional Argentino del ISSN y haber publicado este código;

Cumplir con las normas internacionales en materia de conflicto de intereses y normas éticas.

Hoy en día, el Núcleo Básico cuenta con 217 publicaciones, de las cuales 68.7% (149) corresponde a ciencias sociales y humanidades. Cabe destacar que esta iniciativa se articula con SciELO Argentina y con la pertenencia al directorio y catálogo Latindex, ya que la admisión a los tres sistemas está gestionada localmente por el CAICyT (2016).

Las iniciativas previas representan esfuerzos considerables para asegurar que las publicaciones editadas en Argentina reciban certificaciones de calidad. Sin embargo, el problema de generar una clasificación de revistas para la evaluación académica no se agota allí, en la medida en que deben también determinarse pautas de peritaje para las revistas extranjeras en las que publican los investigadores argentinos. En parte para responder a esta necesidad, en agosto de 2013 el Directorio del Conicet nombró una comisión de expertos en ciencias sociales y humanidades, quienes, en conjunto con el CAICyT, redactaron el documento “Bases para la categorización de publicaciones periódicas en ciencias sociales y humanidades”, que fue aprobado en junio de 2014 (Resolución 2249/14). Este documento observa que en las ciencias exactas y naturales se ha organizado una jerarquía de publicaciones en función de las citas recibidas y reconoce que esta metodología goza de cierta aceptación en dichos campos del conocimiento. Sin embargo, señala que “esta clasificación basada en el factor de impacto o en el índice de citas no tiene la misma incidencia en las ciencias sociales y las humanidades, tal como ha sido ampliamente reconocido a nivel internacional”. Y a continuación comenta que las prácticas de citación en las ciencias sociales y humanidades son distintas a las de las ciencias naturales, como también ambos campos tienen diferencias en cuanto a la importancia de las lenguas nacionales y los libros individuales y colectivos. Por ello, se reitera que “los criterios bibliométricos, como el factor de impacto no deben ser tomados como criterio para evaluar la calidad de las publicaciones periódicas en CSH”. El requisito básico para que un artículo sea considerado científico es que la revista tenga revisión por pares y un comité editorial conformado por especialistas. Finalmente, la resolución se cierra con una propuesta de tres niveles de clasificación. El nivel 1 (internacional, global y regional) incluye WoS, Scopus, ERIH, Scielo, y el nivel A de la clasificación española CIRC. El nivel 2 (internacional y regional) comprende publicaciones con referato no incluidas en el nivel anterior y menciona Francis, Pascal, Redalyc y el Núcleo Básico de Revistas del CAICyT. En el nivel 3 se incluyen publicaciones con referato presentes en bases de datos no consideradas anteriormente, entre las que destacan bases monodisciplinarias (Philosopher’s Index, Sociological Abstracts, EconLit, etc.) y el catálogo Latindex.

La resolución claramente representa un avance en la definición de criterios que puedan ser utilizados en la evaluación académica. Destaca la inclusión de SciELO en el nivel 1, a la par de las bases de datos internacionales de mayor prestigio. En este sentido, representa un intento importante de jerarquizar la producción científica regional en español. En el otro extremo, la relegación del catálogo Latindex al nivel 3 y de Redalyc al nivel 2 no tiene una explicación clara. Es decir, más allá de la declaración de principios -por cierto, loable-, no existe una explicación o criterio claro de por qué algunas bases de datos se ubican en uno u otro nivel. Por otra parte, es llamativo que no haya ninguna referencia a los temas de acceso abierto, aun cuando existe en Argentina una ley desde 2013 que obliga a las instituciones públicas del Sistema Nacional de Ciencia y Tecnología a facilitar el acceso a las publicaciones científicas.

México

Al igual que en Argentina, el Consejo Nacional de Ciencia y Tecnología (Conacyt) de México tiene entre sus objetivos proveer un marco de evaluación para las publicaciones periódicas editadas en el país y que pueda también ayudar a las comisiones evaluadoras. En 1993, el Conacyt lanzó la primera edición del Índice de Revistas Mexicanas de Investigación Científica y Tecnológica, en el que se aprobó la participación de 86 revistas. En la última edición, disponible en la página web del Conacyt desde junio de 2016, pudo constatarse que ese número había ascendido a 137. Los criterios adoptados por el Conacyt para la inclusión de las revistas en el Índice comprenden elementos relacionados con la calidad del contenido y el formato de publicación. En cuanto al contenido, se privilegian revistas que publiquen artículos de investigación original. La calidad del contenido debe estar respaldada por un consejo editorial de reconocido prestigio y su director debe ser un investigador activo. Se espera, además, que los artículos sean objeto de una rigurosa evaluación por pares (Bonilla y Pérez, 1999). Estos criterios se detallaron aún más en ediciones posteriores. Por ejemplo, en la convocatoria 2006-2007, se requería que 75% del total del material debía corresponder a artículos con arbitraje, que el comité editorial fuera multinstitucional y, de preferencia, internacional, que la revista tuviera una antigüedad mínima de tres años y que estuviera al día en la publicación de sus números, así como otros criterios de política editorial. Cabe destacar que, en el año 2008, de las 99 revistas indexadas, 55 (56%) correspondían al área de ciencias sociales y humanidades (Rodríguez, 2008). En este sentido, se repite la tendencia encontrada en Argentina con respecto a la preponderancia de revistas de estas disciplinas en los índices nacionales.

En 2014, el Conacyt encargó a la empresa española SCImago Research Group un estudio sobre el estado de las revistas científicas mexicanas y los efectos de las políticas públicas desarrolladas para su fortalecimiento. Como resultado de este proceso, en agosto de 2016 el Conacyt decide eliminar el Índice y proponer el nuevo sistema de Clasificación de Revistas Mexicanas de Investigación (CRMCyT), en el cual se eliminó el criterio binario del índice (incluido/no incluido) y se propuso clasificar en ocho estratos a las revistas que forman parte del sistema. En los cuatro superiores se incluyen las revistas indexadas por Scopus y WoS y su ubicación depende del cuartil8 que ocupen dentro de esas bases de datos. En caso de que se encuentren en distintos cuartiles, con base en la información de JCR o SJR, se le asignará el mejor cuartil.

Por otra parte, las revistas no indizadas por una de estas dos plataformas son clasificadas en cuatro grupos, con base en el puntaje obtenido en los criterios de evaluación del sistema CRMCyT, que califican los siguientes rubros: a) política y gestión editorial; b) calidad del contenido; c) nivel de citación; d) cumplimiento de frecuencia de publicación; d) accesibilidad9 y, e) indexación internacional. Así, de acuerdo con el puntaje se ordenarán de mayor a menor y se conformarán otros cuatro estratos, a saber: competencia internacional, competencia nacional, en consolidación y en desarrollo (Figura 1).

Cabe destacar que, en el caso de las revistas de humanidades, se menciona que se considera su inclusión en el A&H Citation Index (WoS) ya que las publicaciones de estas áreas no cuentan con factor de impacto. Otra característica del nuevo modelo mexicano es la vigilancia del perfil académico de los editores, por medio del Author Search, una herramienta de Scopus para determinar el “perfil científico del editor”. Asimismo, se utiliza el índice H del editor para asignarle un puntaje específico.

Así, de un sistema de inclusión en un índice se pasa a un sistema que incluye información de las bases de datos bibliométricas y que adopta como propia esa estratificación. Por otra parte, propone un circuito secundario para las revistas que no forman parte de ellas. Si bien parece razonable reconocer el trabajo de las revistas que se encuentran en esas bases, con ello se crea de facto una jerarquización entre ellas y se refuerza la idea de que sólo hay una única forma de consagración para las publicaciones. En este sentido, el sistema mexicano se diferencia de la visión de la normativa del Conicet argentino, el cual, para el caso de las ciencias sociales, pone en el mismo nivel la pertenencia a un índice latinoamericano, como SciELO, que a bases internacionales, como Scopus o WoS.

Además, es importante considerar que a través del sistema de CRMCyT las revistas acceden a fondos de financiamiento para gastos de edición, primordialmente en formato electrónico. La convocatoria del Fondo Concursable para el Posicionamiento Nacional e Internacional de Revistas de Ciencia y Tecnología Editadas en México (Conacyt, 2016) invitó a las revistas a presentar proyectos financiables para desarrollarlos en un periodo de seis meses. De acuerdo con los resultados de esta convocatoria, hay 35 revistas de ciencias sociales (38%) y 15 de humanidades y ciencias de la conducta (16%). Los rubros en los que pueden ser gastados los fondos otorgados (que van de $110 000.00 a $130 000.00 pesos,10 según el nivel obtenido en la CRMCyT) son: gastos de inversión y bienes de capital; pago de DOI;11 gastos de asesoría y consultoría experta; conversión de artículos a XML con marcado en estándar SciELO, y gastos de difusión. La convocatoria destaca que el financiamiento no podrá ser utilizado para gastos de impresión de la revista, así como pago de suscripciones a publicaciones y plataformas de gestión editorial comerciales, entre otros. (Conacyt, 2016).

Colombia

El sistema de evaluación de revistas académicas de Colombia fue creado en los años de 1990 por Colciencias, entidad estatal encargada de la política de ciencia, tecnología e innovación. Durante esa década, Colciencias recolectó información sobre los artículos publicados por investigadores nacionales en revistas editadas en Colombia, que sirvió de base para la conformación del Índice Bibliográfico Nacional Publindex (IBN). Al principio, el IBN Publindex era un instrumento de concentración de información sobre las revistas, más que un índice propiamente (Charum, 2014); pero, con el tiempo, se constituyó en un sistema de evaluación más complejo, que incluye la clasificación de revistas editadas en Colombia y la homologación de las extranjeras, considerando que los investigadores no solamente publican en revistas nacionales. Actualmente Publindex brinda servicio permanente de indexación a revistas de ciencias, ciencias sociales y humanidades; la vigencia de la misma es de dos años, con lo cual las revistas postulan en el tiempo correspondiente para permanecer indizadas. Cabe señalar que la clasificación de las publicaciones en este sistema no implica el otorgamiento de fondos para su sostenimiento, sino que se utiliza como parámetro para la evaluación de los académicos.

El IBN Publindex se puso en marcha vinculándolo con las políticas de incrementos salariales otorgados a los investigadores, con base en sus publicaciones en revistas especializadas, entre otros criterios. El decreto 1279, emitido en 2002, establece las condiciones salariales de los docentes de las universidades públicas y declara que dichos incrementos se determinan de acuerdo con la productividad académica, reflejada, principalmente, en artículos definidos como trabajos, ensayos y artículos de carácter científico, técnico, artístico, humanístico o pedagógico (2002); aunque también se consideran artículos cortos, reportes de caso, revisiones, cartas al editor y editoriales, con un puntaje menor.

En las convocatorias públicas emitidas en 1996, 1998 y 2000, Colciencias llamó a los editores a presentar las revistas para que fueran evaluadas por un comité de expertos de distintas áreas del conocimiento. Se recolectaron datos para asignar a las revistas una calificación en alguna de las categorías establecidas: A, B y C. Los resultados de la clasificación se dieron a conocer públicamente en el índice Publindex en el año 2000 (Colciencias, 2016). En 2002, por el Decreto 1279, se redefinió la clasificación, estableciendo cuatro categorías: A1, A2, B y C, que permanecen hasta la fecha. Estas categorías son progresivas, siendo A1 la más alta. Colciencias estipula los criterios para cada una de las categorías, que cubren cuatro rubros: a) calidad científica, relacionada con la organización técnico administrativa de la revista y con el control de calidad de los documentos mediante la revisión por pares; b) calidad editorial, focalizada en la declaración de políticas editoriales e instrucciones para autores; c) estabilidad, es decir, la antigüedad de la revista y el cumplimiento de su periodicidad y, d) visibilidad, que se refiere a la inclusión de la revista en índices y bases de datos para mayor circulación, y también a la accesibilidad de los contenidos (Villegas, 2013).

De acuerdo con de Oliveira et al. (2015), Publindex es uno de los índices nacionales de mayor complejidad en América Latina, dada la categorización por niveles, lo cual de alguna manera responde al escenario de crecimiento acelerado de la producción científica colombiana en los últimos tres lustros. González y Mattar (2010) destacan que en el periodo de 2004-2010 el número de revistas indizadas en Publindex mostró un incremento de poco más de 400%, pasando de 91 revistas en 2004 a 368 en 2010. Uribe (2016) refiere que en la clasificación de 2002 se registraron 130 revistas, de las cuales 30% eran de creación reciente, lo que demuestra el ritmo de crecimiento de las publicaciones. Según datos de 2014, actualmente hay 562 revistas en el IBN Publindex, de las cuales 51% son de ciencias sociales y humanidades (Lucio et al., 2015).

Uno de los rasgos particulares del sistema colombiano es la incorporación de Servicios de Indexación y Resumen (SIR) como parte de los parámetros de evaluación de las publicaciones para su inclusión en el índice nacional. En 2015 el listado de los SIR estaba conformado por 86 registros. Éstos incluyen tanto índices bibliométricos como otros directorios o bases de datos que dan visibilidad a las revistas en un contexto internacional o bien en un ámbito temático específico. La intención de incluir los SIR en la evaluación es conocer si una revista ha cumplido los requisitos de selección y permanencia en esos servicios, lo que puede dar indicios de la calidad editorial y la calidad científica. Los SIR que se consideran en Publindex se clasifican en: a) índices bibliográficos con comités de selección; b) bases de datos con comités de selección (tanto generales, que integran varias áreas de ciencia y tecnología, como enfocadas en algún área en particular) y, c) índices bibliográficos citacionales (Charum, 2014).

Este rasgo habla de la preocupación de Colciencias por la visibilidad y la internacionalización de las revistas académicas, que ha derivado en un viraje de la política dado recientemente en 2016. Similar al caso mexicano, el SCImago Research Group encabezó la elaboración de la nueva política de evaluación de revistas, dividida en dos rubros: 1) Política para mejorar la calidad de las publicaciones científicas y, 2) Modelo de clasificación de revistas científicas, 2016. La convocatoria 286-2016 se abrió en agosto de ese año, luego de que los detalles del modelo fueron dados a conocer a los interesados mediante jornadas de socialización celebradas en diferentes ciudades de Colombia durante 2016.

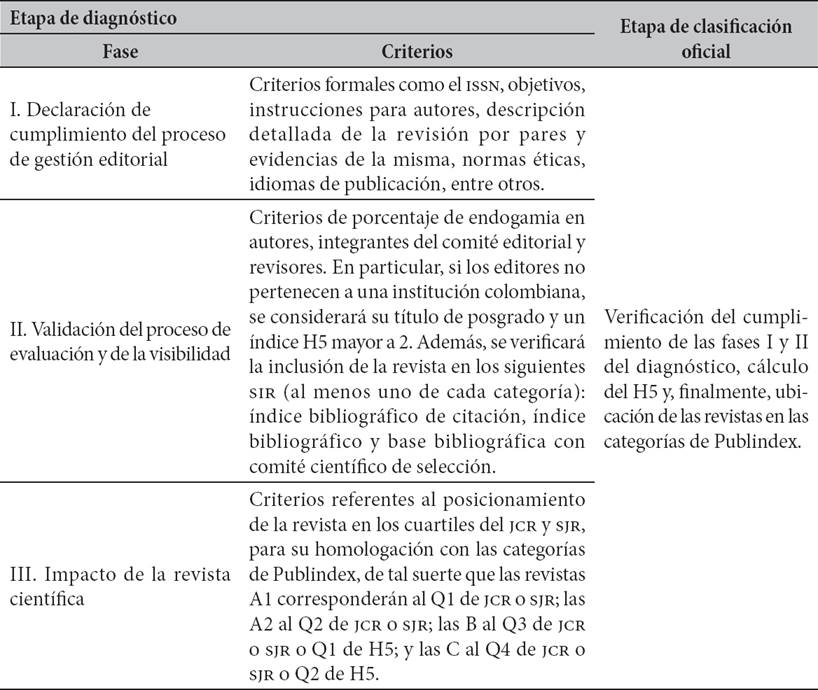

Si bien la declaratoria del nuevo modelo describe que se realizará un proceso de evaluación cuantitativa y cualitativa de las revistas, destaca que uno de los principales cambios es que las revistas serán clasificadas con base en tres indicadores bibliométricos: el Factor de Impacto (FI) tomado del Journal Citation Report (JCR) según WoS; el índice SCImago Journal Rank (SJR) de Scimago-Scopus, y el índice H5 de Google Scholar. El Cuadro 1 muestra la estructura y etapas de implementación de la clasificación de revistas del nuevo modelo.

Cuadro 1 Estructura del nuevo sistema de clasificación Publindex

Fuente: elaboración propia a partir de los datos de la convocatoria para la indexación de revistas colombianas especializadas-Publindex, 2016.

Por otro lado, una de las novedades en esta convocatoria es la propuesta de fusión de revistas, con tal de “mejorar su posterior clasificación, visibilidad e impacto” (Colciencias, 2016). Para la fusión las revistas implicadas deben cumplir las tres fases de la etapa de diagnóstico.

Llama la atención la polémica generada entre la comunidad académica con el anuncio de esta nueva política. Posterior a su comunicación pública, en diversos medios se dieron a conocer algunas reacciones tanto de apoyo al modelo como de fuerte crítica. Algunos académicos, convocados por la Academia Colombiana de Ciencias Exactas, Físicas y Naturales, enviaron una carta a las autoridades de Colciencias en julio de 2016 para proponer ajustes al nuevo modelo de clasificación (Universidad de Antioquia, 2016). Entre los siete puntos abordados en esa carta destaca la sugerencia de que el nuevo modelo estuviera basado únicamente en la clasificación por cuartiles realizada por los índices internacionales (WoS y Scopus), dado que es “simple, reproducible, competitivo a nivel mundial”, con lo cual se asume cierta neutralidad de dichos índices, cuestión que ha sido discutida ampliamente debido a los sesgos disciplinarios, geográficos e idiomáticos que estos índices generan. Las reacciones frente a estas peticiones no se dejaron esperar y un grupo de académicos de las ciencias sociales emitió otro escrito público donde se criticaba duramente la propuesta de basar la clasificación de las revistas en los cuartiles de los índices internacionales (Vélez, 2016).

Si bien los argumentos tanto a favor de la política como en su contra reflejan inconformidad entre la comunidad académica, claramente dividida por las áreas de conocimiento, lo cierto es que el nuevo modelo puede llegar a afectar a las revistas más que beneficiarlas, por varias razones: 1) debido a los requisitos más rigurosos que plantea la política de evaluación, algunas revistas pueden extinguirse o bien fusionarse como el mismo modelo propone (Uribe, 2016); 2) muy probablemente, las revistas bajarán de categoría e incluso la A1 podría quedar desierta, dado que hay muy pocas revistas en Q1 de JCR y SJR; 3) por lo mismo, se corre el riesgo de que merme la recepción de documentos, con la consecuente dificultad para mantener la periodicidad (Agudelo, 2016).

Algunos ejes de comparación

En el Cuadro 2 pueden apreciarse algunos ejes de comparación entre los tres países, entre los que podemos destacar los siguientes puntos. En Argentina, a diferencia de México y Colombia, se cuenta con una normativa para clasificar revistas que busca homogeneizar los procesos de evaluación académica, y otro sistema para clasificación de revistas nacionales en términos de calidad editorial. En Colombia, el sistema Publindex considera criterios de calidad editorial y establece una clasificación orientada a la evaluación académica. En México, el objetivo fundamental es jerarquizar las revistas con el fin de ofrecerles estímulos para su impulso y desarrollo, pero no se aborda directamente la cuestión de la evaluación académica.

Tabla 2 Características de los sistemas de evaluación de revistas académicas en Argentina, Colombia y México

Fuente: elaboración propia.

Respecto de los indicadores utilizados para establecer una clasificación, cabe destacar que en todos los casos se utilizan criterios de calidad editorial. El uso de indicadores bibliométricos propiamente dichos sólo se aprecia en las reformas recientes de Publindex y el sistema mexicano. Por el contrario, en Argentina, el Núcleo Básico no los considera y la resolución de Conicet explícitamente se manifiesta en contra de incluir estos indicadores como una forma de estratificar las publicaciones académicas. En la versión nueva de Publindex, se consideran primordialmente los indicadores bibliométricos elaborados por Thomson Reuters, Scimago y Google.12 En el caso mexicano, el índice vigente hasta 2016 se basaba únicamente en criterios de calidad editorial. En la nueva versión, se incorpora el uso del factor de impacto e índice SJR. Por otra parte, el uso de otros servicios de indexación y resumen como parte de los elementos de juicio para valorar el desarrollo de la revista se aprecia en los sistemas argentinos y en la versión antigua de Publindex.

Un punto interesante que cabe señalar al respecto es que, en el caso de Argentina, la resolución de Conicet pone en el mismo nivel a las revistas indexadas en SciELO, un índice regional latinoamericano, con las indexadas en bases de datos internacionales, como WoS o Scopus. Por el contrario, en el caso del nuevo sistema mexicano, sólo las revistas ingresadas en estas últimas bases de datos acceden a los cuatro niveles más altos del sistema. En Colombia, el impacto de aquellas revistas que no cuentan con índice de impacto de JCR o SJR se mide a través del índice h5 de Google Académico. Al igual que en el caso mexicano, los niveles más altos del sistema (A1 y A2) están reservados a revistas que posean factor de impacto o SJR. Este énfasis en criterios bibliométricos en la nueva versión de los sistemas colombiano y mexicano podría vincularse con el hecho de que la clasificación de Conicet es específica para las ciencias sociales, donde estos índices son más cuestionados, mientras que los nuevos sistemas de Conacyt y Colciencias están pensados para todas las áreas del conocimiento. En este sentido, muestra el riesgo que la adopción de un sistema de clasificación universal puede implicar para las dinámicas disciplinares.

Por otra parte, llama la atención que, si bien los tres países están en sintonía con el movimiento de acceso abierto (Argentina y México cuentan con una legislación al respecto, y en Colombia existe el Sistema Nacional de Acceso Abierto), hay una ausencia importante de criterios que correspondan a una mayor apertura de las revistas, no sólo en términos de la disponibilidad gratuita de sus contenidos, sino de prácticas de apertura en temas de derechos de autor, licenciamiento de contenidos e infraestructura para el acceso abierto. En las políticas de los tres países hay muy poca referencia a prácticas como el uso de plataformas de datos abiertos, políticas de autoarchivo, por ejemplo, en la modalidad abierta del proceso de revisión por pares (open peer review). De hecho, si bien en el sistema mexicano se menciona la obligatoriedad de tener los contenidos de las revistas en acceso abierto, en la puntuación que se asigna referente al proceso de evaluación por pares, hay un dato interesante: se otorgan cuatro puntos cuando las revistas realizan un proceso doble ciego y sólo dos puntos cuando la revisión es abierta o bien se realiza post-publication review. Al mismo tiempo se declara lo siguiente: “Se valora la transparencia, como publicar la lista de dictaminadores”, lo cual resulta paradójico. Además, también llama la atención que en ninguno de los tres sistemas de clasificación hay mención a las declaraciones internacionales que dan fundamento al acceso abierto (declaraciones de Budapest, Berlín y Bethesda), lo cual es un indicio de una desconexión de estos sistemas nacionales con las políticas internacionales en este ámbito.

Sistemas de clasificación de revistas y evaluación académica

Los sistemas de evaluación de las publicaciones académicas dan señales a los investigadores acerca de cuáles son los circuitos en los que es deseable publicar. Estas indicaciones se trasladan a los académicos fundamentalmente en la forma de criterios para evaluar su productividad académica y configuran sus condiciones de producción intelectual (Naidorf y Pérez, 2012). En tanto los tabuladores de evaluación de las universidades, consejos nacionales o programas de estímulos incorporen las clasificaciones de revistas como una forma de realizar un juicio mediato sobre la calidad de la producción, podemos afirmar que estas clasificaciones juegan un papel relevante a la hora de direccionar la producción de los académicos.

Presencia de la clasificación de revistas en las guías de evaluación

En el caso de Argentina, cabe señalar que la Resolución de Conicet analizada se encuentra en un punto intermedio entre las clasificaciones de revistas y la evaluación académica, ya que es una medida que cataloga a las revistas, pero con el único fin de facilitar la evaluación académica. Por ello, no se limita a las revistas nacionales, sino que incluye a todas aquellas en las que los investigadores argentinos puedan publicar. Sin embargo, su uso no es vinculante, sino orientador para las comisiones que evalúan a los académicos que son miembros del Conicet. Beigel (2014), quien ha realizado una encuesta a coordinadores de las comisiones evaluadoras de Conicet, señala que mientras que las comisiones de ciencias exactas y naturales consideran a los índices internacionales como Scopus y WoS superiores a los locales, en las comisiones de ciencias sociales y humanidades hay consenso en que los índices regionales son equivalentes a los internacionales. A su vez, Beigel afirma que la evaluación de libros y capítulos de libro es más compleja, ya que no hay certeza acerca de que el libro haya sido evaluado por pares y no hay un criterio o consenso sobre cómo tratar este aspecto. Esto hace que, en última instancia, sean los artículos los que lleven un mayor peso en la evaluación de los postulantes. Además del sistema de Conicet, otro de los espacios más importantes de evaluación del desempeño de los investigadores en Argentina lo constituye el Programa de Incentivos al personal académico de las universidades nacionales, que gestiona el Ministerio de Educación. Si bien se especifican los tipos de producción científica aceptable, no hay allí referencia explícita a las indexaciones y bases de datos bibliométricas como una forma de medir el desempeño de los investigadores (SPU, 2014). En este sentido, el sistema es mucho menos específico que la propuesta de Conicet y da lugar a mayor plasticidad.

En el caso de México, al igual que en el caso argentino, las prácticas específicas en el uso de indicadores cuantitativos bibliométricos dependerán de cada programa y disciplina. Un punto que cabe señalar sobre el caso mexicano es que, a diferencia de Argentina, los programas de pago al mérito juegan un papel central en la orientación del trabajo de los académicos (Galaz y Gil-Antón, 2013). Mientras en México el porcentaje de ingreso mensual que se canaliza a través de estos programas es muy significativo, en Argentina el único programa que sigue esta lógica ha ido perdiendo importancia en términos económicos con el correr de los años (Sarthou, 2016). En el caso del Sistema Nacional de Investigadores (SNI) de Conacyt, los criterios para el área de ciencias sociales consideran como productos de investigación los artículos en revistas, libros y capítulos de libros académicos, patentes y certificados de invención, software, y asesorías especializadas. Con respecto a los artículos, se da preferencia a las revistas internacionales y las del índice de Conacyt, en el caso de las nacionales. Se aclara que si una revista es nueva y muestra tener arbitraje estricto y de calidad también será considerada, incluso si no pertenece al padrón. En este sentido, se observa que los criterios son un tanto ambiguos, en la medida que la expresión “revistas internacionales” es poco clara, pues podría referirse a cualquier revista académica publicada en un país distinto a México, independientemente de su indexación (Conacyt, 2015). Por otra parte, cabe destacar que estos criterios operaban antes de la puesta en práctica del nuevo sistema de clasificación de revistas, por lo que habrá que esperar a la convocatoria 2017 del SNI para conocer cómo se trasladan los nuevos criterios a la evaluación de los investigadores.

Por último, en Colombia, el Decreto 1279 del 19 de junio de 2002, que reglamenta el régimen salarial de los docentes de las universidades estatales, dispone en su artículo 10 los puntajes que son asignados por publicar en revistas especializadas. Aquí traslada directamente la clasificación obtenida de la revista por el índice de Colciencias. En este sentido, afirma que se otorgarán 15 puntos por cada publicación en revista tipo A1; 12 puntos, en A2; 8 puntos, en B; y 3 puntos, en C. Los criterios de Publindex también permean la evaluación del personal académico en universidades privadas. En el caso de la Pontificia Universidad Javeriana (s/f), por ejemplo, señala que se asignarán 100 puntos por artículo publicado en revista en Q1 o Q2 de JCR o Scopus; 90 puntos en revista Q3 o Q4; 70 puntos en revista Publindex A1; 60 en revista Scielo, Redalyc o Publindex A2; 30 para Publindex B, y 10 para Publindex C.13

Si bien sería necesario un estudio más detallado para poder hacer afirmaciones concluyentes sobre la forma en que efectivamente funcionan las comisiones evaluadoras, las normativas mencionadas muestran que existe una tendencia a dar un valor importante a las clasificaciones de las revistas efectuadas por los consejos nacionales de ciencia y tecnología. La evaluación académica es un proceso que se parece más a un juicio informado o a un peritaje, que a la aplicación de un algoritmo de clasificación y medición (Lamont, 2009). Incluso si nos decantáramos por un método híper-reglamentado, los estudios CTS han llamado la atención sobre el punto de que la práctica de contar es situada y dependiente del contexto (Verran, 2001; Kaltenbrunner y de Rijcke, 2016). En este sentido, siempre queda un resto de discrecionalidad. Dentro de ciertos límites, esto puede ser positivo, en la medida en que permite reconocer méritos excepcionales no capturados por las medidas usuales. Sin embargo, un exceso en el margen de discrecionalidad también puede dar lugar a arbitrariedades.

En los casos analizados puede destacarse que, si bien las prescripciones de los sistemas de evaluación de revistas pueden no ser vinculantes, sus recomendaciones sí aparecen en las guías de evaluación para académicos. En este sentido, un viraje en los criterios aplicados en estos sistemas podría provocar modificaciones en la conducta de los investigadores y reorientar su producción. Las modificaciones recientes en los sistemas de México y Colombia tienden a interiorizar como criterio excluyente para los niveles más altos del sistema la inclusión en las dos bases de datos de citas predominantes. La ausencia de una lista de los servicios de indexación y resumen en la nueva versión de Publindex, que incluían bases de datos disciplinarias y regionales, es una señal de convergencia hacia un único set de indicadores.

En la segunda sección del trabajo llamamos la atención sobre los sesgos involucrados en la construcción de estos indicadores, particularmente en el caso de las ciencias sociales. En la medida en que el sistema mexicano y el colombiano no son específicos para estas disciplinas, no sería de extrañar que estas particularidades no hayan sido tomadas en cuenta. En el caso argentino, no sólo se hace hincapié en estas cuestiones, sino que además se adopta una postura “militante” al respecto, renegando del factor de impacto.

La profundización de una visión ortodoxa en la evaluación académica

Las tendencias mencionadas muestran una evolución del sistema de evaluación de revistas hacia un modelo basado en índices de citas y a una merma relativa de la importancia de otras bases de datos ligadas a campos de conocimiento específicos o regiones. La presión mayor por publicar en las revistas ubicadas en los mejores cuartiles de JCR y SJR puede llevar a que se modifiquen las agendas de investigación y se alejen de problemas de relevancia local o bien de enfoques con mayor capacidad transformadora para abordar esos problemas (Chavarro, Puay y Rafols, 2016). Por ejemplo, Arza y López (2017) señalan cómo, en una revista internacional, los revisores de un artículo sobre las potencialidades de la agroecología para el desarrollo inclusivo en Argentina sugirieron a los autores enfocarse en la comparación de la agroecología con la “intensificación sostenible”, una discusión en boga globalmente. Esto implicaba relegar la preocupación central de los autores ligada a la inclusión social.

En lo que hace al proceso de evaluación de la actividad académica, podemos identificar una corriente ortodoxa y otra heterodoxa. La disponibilidad de datos cuantitativos sobre la dinámica de la investigación científica y las nuevas oportunidades de colaboración que ofrecen las tecnologías de la información y la comunicación (TIC) han actualizado la agenda de ambas corrientes (Figura 2). En el caso de la ortodoxia, en su versión tradicional canonizaba la evaluación por pares y la complementaba con las distinciones y premios otorgados por los órganos de la comunidad científica, en el marco de un discurso global de “ciencia básica”. En contraste con ello, un discurso alternativo destacaba la importancia de las agendas ligadas a problemas locales de investigación y a la participación de actores externos y potenciales. La ortodoxia se ha actualizado a través de los índices globales de citas, que permiten cuantificar los impactos dentro de un mismo circuito reducido de publicaciones, reforzando la idea de una única estratificación de la ciencia global. Por otra parte, la heterodoxia también se ha actualizado con métricas alternativas, procesos abiertos de revisión y herramientas cuantitativas para analizar las asimetrías en la producción de conocimiento.

En el marco del análisis realizado en el presente trabajo queremos destacar que los sistemas de clasificación de revistas han evolucionado en la dirección de una ortodoxia actualizada y no han incorporado elementos de lo que podríamos llamar la “nueva heterodoxia”. Cabe señalar, por ejemplo, que en ninguno de los documentos analizados podemos percibir una preocupación por incorporar mayores prácticas de apertura o ciencia abierta, lo cual incluiría sistemas de open peer review, métricas alternativas que valoren impactos no derivados de las citaciones, o la participación de actores externos en el proceso de evaluación de las agendas de investigación emprendidas. Las consecuencias de estas tendencias podrán verse tan solo en el mediano plazo, pero es posible que repercutan en los contenidos sustantivos de la investigación social que se realiza en América Latina.

Conclusiones

En el presente trabajo nos hemos ocupado de las tendencias recientes en los sistemas de clasificación de revistas académicas en tres países latinoamericanos. Asimismo, hemos señalado cómo estos sistemas de clasificación pueden tener influencia sobre los principales sistemas de evaluación académica. En la primera sección del trabajo pudimos observar que existen ciertos reparos conceptuales y metodológicos para incorporar los indicadores bibliométricos estándar a la evaluación de las publicaciones académicas en las ciencias sociales latinoamericanas. Dada la sub-representación de las revistas académicas de la región en esas bases de datos, no resulta justificado su uso como principal indicador de evaluación de las publicaciones latinoamericanas. Sin embargo, las reformas recientes en los sistemas de Colombia y México no parecen hacer caso de esas consideraciones y proponen un sistema universal de clasificación para todas las disciplinas, que incorpora indicadores basados en citas como forma privilegiada de estratificación.

Teniendo en consideración las características del modelo de gestión de las publicaciones académicas en América Latina, esto podría provocar que algunas revistas deban fusionarse o estén condenadas a desaparecer. De igual forma, es muy posible que estos sistemas tan estrictos de clasificación dejen las categorías superiores desiertas en muchas disciplinas. Al parecer, estas consecuencias no han sido consideradas seriamente por los impulsores del sistema.

En el caso de Argentina, la tendencia no es tan marcada, en la medida en que se mantiene la relevancia de la pertenencia a sistemas regionales de indexación y no se incorporan indicadores basados en citas para estratificar. Sin embargo, tampoco la agenda heterodoxa es plenamente adoptada en Argentina, ya que en ninguno de los países ven incentivos en incorporar algunos sistemas alternativos basados en la ciencia abierta, más allá de las políticas de acceso gratuito a los textos completos.

Finalmente, queremos destacar que es importante que se abra el debate sobre la forma en que los criterios de evaluación moldean la práctica de la investigación social. Los indicadores son productos construidos socialmente y responden al contexto y a los intereses de quienes los han diseñado. En el campo de la política científica, a veces esto se olvida y se canonizan ciertas formas de medir la productividad académica como las únicas válidas. Nos fascinamos con las simplificaciones que nos brinda la tecnocracia. En aras de la comparabilidad y el “posicionamiento” internacional, perdemos de vista el papel que queremos para nuestras ciencias sociales. La prudencia que proponemos no debe entenderse como un llamamiento político radical a desacoplarse de las agendas internacionales y reivindicar una ciencia nacional. De lo que se trata, en cambio, es de mantener una actitud crítica y alerta ante las modificaciones en los regímenes de evaluación de las publicaciones, porque allí se juega una micropolítica que –inadvertidamente para muchos– tiene un impacto directo en la forma de hacer el tipo de investigación social que institucionalmente se considera deseable.

Sobre los autores

Federico Vasen es doctor en Ciencias Sociales por la Universidad Nacional de Quilmes y graduado en Filosofía por la Universidad de Buenos Aires. Actualmente se desempeña como becario del programa de becas posdoctorales de la UNAM, en el Instituto de Investigaciones Sociales. Se especializa en el campo de la política científica y tecnológica y los estudios sobre educación superior. Sus tres últimas publicaciones son: (con B. Vienni) “La institucionalización de la interdisciplina en la universidad latinoamericana: experiencias y lecciones de Argentina y Uruguay” (Avaliação. Revista da Avaliação da Educação Superior, 2017); “¿Estamos ante un giro poscompetitividad en la política de Ciencia, Tecnología e Innovación?” (Sociologias, 2016) y el capítulo “What does a ‘national’ science mean? Science policy, politics and philosophy of science in Latin America” (Paradigms Defected. The Politics of Science Studies during the Cold War, 2016).

Ivonne Lujano Vilchis es magister en Ciencias Sociales con orientación en Educación por FLACSO Argentina y licenciada en Educación por la Universidad Autónoma del Estado de México, donde se desempeña como docente. Es especialista en comunicación científica y cuenta con más de siete años de experiencia en gestión, implementación y evaluación de medios editoriales científicos. Actualmente es editora asociada y representante del Directory of Open Access Journals (DOAJ) para América Latina. Colabora con algunos equipos editoriales en América Latina y es divulgadora del acceso abierto y la ciencia abierta. Ha participado en la OpenCon organizada por SPARC, Estados Unidos, y en diversos encuentros académicos sobre bibliotecas y edición académica. Sus publicaciones más recientes son: (con Nestor Martínez Domínguez) Evaluación de las revistas mexicanas de divulgación científica en la era digital (2016) (versión en inglés: Evaluating Mexican Scientific Magazines in the Digital Age); “Revistas académicas de arte en bases de datos bibliográficas: disponibilidad en acceso abierto y en bibliotecas de tres instituciones mexicanas” (2012).

nueva página del texto (beta)

nueva página del texto (beta)