Serviços Personalizados

Journal

Artigo

Indicadores

-

Citado por SciELO

Citado por SciELO -

Acessos

Acessos

Links relacionados

-

Similares em

SciELO

Similares em

SciELO

Compartilhar

Investigación económica

versão impressa ISSN 0185-1667

Inv. Econ vol.72 no.286 Ciudad de México Out./Dez. 2013

Riesgo operacional en el proceso de liquidación del mercado mexicano de valores: un enfoque bayesiano

José Francisco Martínez-Sánchez*, Francisco Venegas-Martínez**

* Escuela Superior de Apan de la Universidad Autónoma del Estado de Hidalgo (ESAp-UAEH), México, <marzan67@hotmail.com>

** Escuela Superior de Economía del Instituto Politécnico Nacional (ESE-IPN), México, <fvenegas1111@yahoo.com.mx>

Manuscrito recibido en julio de 2011;

Aceptado en mayo de 2012.

Resumen

Este trabajo identifica y cuantifica los diversos factores de riesgo operacional (RO) del proceso de liquidación en el mercado de valores de México mediante un modelo de red bayesiana (RB). El modelo RB es calibrado con datos de eventos que se presentaron en el proceso de liquidación en el Instituto de Depósito de Valores (INDEVAL) durante el periodo 2007-2010 y con información adicional que se obtuvo de los expertos del mismo organismo. A diferencia de los métodos clásicos, la calibración del modelo RB con fuentes de información tanto objetivas como subjetivas permite capturar la interrelación entre factores de riesgo (causa-efecto), lo cual potencializa su utilidad, como se muestra en el análisis comparativo que se realiza entre los enfoques RB y clásico. Por último, es importante mencionar que el enfoque bayesiano que se propone es consistente en el sentido de Artzner et al. (1998).

Palabras clave: riesgo operacional, análisis bayesiano, simulación Monte Carlo.

Clasificación JEL: C11, C15, D81.

INTRODUCCIÓN

El enfoque bayesiano es una alternativa viable para el análisis de riesgos en condiciones de información insuficiente. Por construcción, los modelos bayesianos incorporan información inicial por medio de una distribución de probabilidad a priori, mediante la cual se puede incluir información subjetiva en la toma de decisiones como es: la opinión de expertos, el juicio de analistas o las creencias de especialistas. Este trabajo utiliza un modelo de red bayesiana (RB) para examinar la interrelación entre factores de riesgo operacional1 (RO) en el proceso de liquidación del mercado de valores en México que realiza el Instituto de Depósito de Valores (INDEVAL). El modelo RB que se propone se calibra con datos reales de eventos que se presentaron en el proceso de liquidación en el INDEVAL y con información que se obtuvo de los expertos2 del mismo organismo para el periodo 2007-2010.

Los modelos bayesianos incorporan la incertidumbre mediante una distribución de probabilidad paramétrica (modelo muestral), además de permitir agregar información subjetiva inicial por medio de distribución a priori, la cual podría considerar el juicio de expertos o creencias de analistas. En este contexto, el enfoque bayesiano, conjuntamente con la topología de redes, toman relevancia como alternativa para analizar desde una lógica económica y financiera la administración del RO.

El RO usualmente involucra una pequeña parte de las pérdidas totales anuales de la banca comercial; sin embargo, en el momento en que ocurre un evento de riesgo operacional extremo se pueden causar pérdidas notables. Por esta razón, los grandes cambios en la industria bancaria a escala mundial están dirigidos a contar con mejores políticas y recomendaciones en materia de riesgo operacional.

Llama la atención que existen en la literatura especializada diversas técnicas estadísticas para identificar y cuantificar el RO, las cuales tienen como supuesto fundamental la independencia entre eventos de riesgo, por ejemplo Degen, Embrechts, y Lambrigger (2007), Moscadelli (2004) y Embrechts, Furrer y Kaufmann (2003). No obstante, como se muestra en los trabajos de Aquaro et al. (2009), Supatgiat, Kenyon y Heusler (2006), Marcelo (2004), Neil, Marquez y Fenton (2004) y Alexander (2002), existe una relación causal entre los factores de RO.

A pesar de la existencia de trabajos como los de Reimer y Neu (2002; 2003), Kartik y Reimer (2007), Leippold (2003), Aquaro et al. (2009), Neil, Marquez y Fenton (2004) y Alexander (2002), que abordan de manera general la aplicación de las RB en la administración del RO, no existe una guía completa sobre cómo clasificar los eventos de RO, cómo identificarlos, cómo cuantificarlos y cómo calcular el capital económico de manera consistente.3 Este trabajo pretende cerrar estas brechas, primero estableciendo estructuras de información sobre eventos de RO de manera que sea posible identificar, cuantificar y medir el mismo y segundo cambiando el supuesto de independencia de eventos para modelar de manera realista el comportamiento causal de los eventos de RO. Para lo anterior, se estudia la correlación entre factores de riesgo a fin de desarrollar un modelo de RB que permita identificar y cuantificar el RO del proceso de liquidación en el mercado de valores de México.

El trabajo se organiza en cinco apartados, además de la introducción. En el primero se presenta la tipología y métodos de cálculo del RO de acuerdo con Basilea II (2001a). A continuación se analiza el marco teórico para el desarrollo del trabajo, enfatizando sobre las características y bondades de las rb's. En otro apartado se describe el análisis del proceso de liquidación del INDEVAL y la problemática que se pretende resolver, así como el alcance de la aplicación de la metodología propuesta. Posteriormente, se construye la RB a partir del análisis de los factores de riesgo asociados al sistema de liquidación de valores del INDEVAL; se obtienen dos redes una para la frecuencia y otra para la severidad. Para cuantificar cada nodo de las redes y obtener las probabilidades a priori se "ajustan" distribuciones de probabilidad para los casos donde existe información histórica (2007-2010); en caso contrario, se recurre a la opinión o juicio de los expertos para obtener las probabilidades correspondientes. Una vez que se cuenta con las probabilidades a priori de las dos redes se procede a calcular las probabilidades a posteriori por medio de algoritmos de inferencia bayesiana, en específico se utiliza el algoritmo junction tree. En el último apartado se calcula el riesgo operacional condicional del proceso de liquidación del INDEVAL por medio de una simulación Monte Carlo con distribuciones a posteriori calculadas para la frecuencia y la severidad.

TIPOS DE RIESGO OPERACIONAL

La definición más empleada del concepto de riesgo operacional corresponde a la del Comité de Basilea "el riesgo de pérdidas directas o indirectas resultado de las fallas en los sistemas, procesos internos inadecuados, errores humanos y eventos externos". Esta definición tiene un perfil operacional debido a que los procesos internos incluyen tanto al procedimiento en sí como a los procesos internos. En conclusión, existen básicamente cuatro dimensiones del riesgo operacional: el factor humano, los sistemas, los procedimientos y los eventos externos.

Identificación de riesgos

La impresión de que el RO sólo puede ocurrir en la parte operativa puede ser errónea. Este tipo de riesgos puede acontecer en cualquier lugar o momento en que se involucren los empleados, los sistemas o los procedimientos en el trabajo cotidiano o donde las instituciones financieras estén expuestas a riesgos y ataques externos.

Medición del riesgo operacional

La naturaleza de los métodos para la cuantificación y medición del riesgo operacional varía desde lo más simple hasta métodos de gran complejidad y entre modelos que consideran un solo indicador y modelos estadísticos muy sofisticados.

Métodos para medir el riesgo operacional

A continuación se describen brevemente los métodos existentes en la literatura para medir el RO (véanse, por ejemplo, Heinrich, 2006; Basilea II, 2001b):

1) Los métodos Top-Down de Indicador simple. Este método fue elegido por el Comité de Basilea como una primera aproximación al cálculo del riesgo operacional. Un solo indicador como el ingreso total de la institución o la volatilidad del ingreso o los gastos totales se puede considerar como el cargo total a cubrir por este riesgo.

2) Los métodos Bottom-Up que incluyen el juicio de un experto. La base para el análisis de un experto es un conjunto de escenarios. Los expertos identifican los riesgos y sus probabilidades de ocurrencia.

3) Medición interna. El Comité de Basilea propone el método de medición interna como un procedimiento más avanzado para calcular el costo de capital regulatorio.

4) Enfoque estadístico clásico. Análogamente a lo que ha ocurrido con los métodos de cuantificación para el riesgo de mercado y, más recientemente, el riesgo de crédito, también se ha avanzado en la investigación relativa a los métodos de cálculo para el riesgo operacional. Sin embargo, contrario a lo que sucede con el riesgo de mercado, es muy difícil encontrar un método estadístico ampliamente aceptado.

5) Modelos causales. Como alternativa a la estadística clásica surgen los modelos causales, que suponen dependencia entre eventos de riesgo; en otras palabras, cada evento representa una variable aleatoria (discreta o continua) con función de distribución condicional. Para los eventos que no cuenten con registros históricos o la calidad de los mismos no sea la requerida se recurre a la opinión o juicio de los expertos para determinar las probabilidades condicionales de ocurrencia. La herramienta para modelar esta causalidad es la RB, la cual se fundamenta en el teorema de Bayes y la topología de redes.

MARCO TEÓRICO

En este apartado se presenta la teoría que soporta el desarrollo del trabajo. Se inicia con una discusión sobre el valor en riesgo condicional (CVaR, por sus siglas en inglés) como medida de riesgo "coherente" en el sentido de Artzner et al. (1998). Posteriormente, se utiliza el enfoque bayesiano para la construcción de RB, destacando sus ventajas respecto al enfoque clásico en el estudio del RO.

Valor en riesgo condicional (CVaR)

De acuerdo con Panjer (2006), el CVaR o Expected Shortfall es una medida alternativa al valor en riesgo (VaR) que cuantifica las pérdidas que se pueden encontrar en las colas de las distribuciones. Se define como la pérdida esperada para los casos en donde la pérdida de valor del portafolio exceda el valor del VaR .

Si X denota la variable aleatoria de pérdida, el CVaR de X a un nivel de confianza de (1 - p) X 100%, expresado como CVaRp(X), es la pérdida esperada, dado que las pérdidas totales exceden el cuantil 100p de la distribución de X. Para distribuciones arbitrarias se puede escribir CVaRp(X) como:

donde F(x) es la función de distribución acumulada de X. Además, para distribuciones continuas, se puede usar la función de densidad para escribir lo anterior como:

Así, el CVaR se puede ver como el promedio de todos los valores VaR sobre el nivel de confianza p. Además, CVaR puede escribirse como:

donde e(xp) es la media de excesos de la función de pérdidas.4

El paradigma bayesiano

En el análisis estadístico existen dos paradigmas filosóficos, el frecuentista y el bayesiano. La diferencia fundamental se relaciona con la definición de probabilidad. Los frecuentistas señalan que la probabilidad de un evento es el límite de su frecuencia relativa en el largo plazo; mientras que los bayesianos sostienen que la probabilidad es subjetiva, un nivel de creencias que se actualiza con la incorporación de nueva información; la probabilidad subjetiva (creencias) fundamentada en una base de conocimientos constituye la probabilidad a priori, la probabilidad a posteriori representa la actualización de las creencias.

Un tomador de decisiones bayesiano aprende y revisa sus creencias con base en la nueva información que tenga disponible. Desde el punto de vista bayesiano, las probabilidades son interpretadas como niveles de creencias. Por tanto, el proceso de aprendizaje bayesiano consiste en estar revisando y actualizando probabilidades. El teorema de Bayes es el medio formal para poner en práctica lo anterior.5

Teorema de Bayes

El teorema de Bayes es una regla que puede ser utilizada para actualizar creencias con base en nueva información (por ejemplo, datos observados). Si se denota con E la evidencia y se supone que un experto cree que se puede asociar con una probabilidad P(E), el teorema de Bayes dice que después de observar los datos (D) las creencias sobre E son ajustadas de acuerdo con la siguiente expresión:

donde P(D|E) es la probabilidad condicional de los datos, dado que la evidencia a priori D es cierta, y P(D) es la probabilidad incondicional de los datos, P(D) > 0. También se puede expresar como:

P(D) = P(D|E)P(E) + P(D| EC)P(EC)

La probabilidad de E, antes de tener los datos P(E), es llamada probabilidad a priori, una vez actualizada, P(E|D), es denominada probabilidad a posteriori.

Se reescribe la forma continua del teorema de Bayes de la siguiente manera:

P(θ|y) ∞ L(θ|y)Π(θ) [4]

donde θ es un parámetro desconocido a estimar; y es un vector de observaciones registradas; Π(θ) es una distribución a priori que depende de uno o más parámetros, denominados hiper-parámetros; L(θ|y) es la función de verosimilitud para θ y P(θ|y) es la distribución a posteriori de θ (actualización de la a priori). Dos preguntas surgen de lo anterior, cómo traducir la información a priori en su forma analítica, Π(θ), y qué tan sensible es la inferencia a posteriori a la selección de la a priori, estas preguntas han sido un amplio tema de interés en la literatura bayesiana (véase Ferguson, 1973).

Inferencia bayesiana

La distribución a posteriori del parámetro o vector de parámetros θ, dada la información y, denotada por P(θ|y) es obtenida por medio de la aplicación del teorema de Bayes. Es una combinación de datos y de la distribución a priori, mientras que la distribución a posteriori contiene la información relevante sobre el parámetro desconocido

Redes bayesianas

Una red bayesiana es una gráfica que representa el dominio de las variables de decisión, las relaciones cuantitativas y cualitativas de éstas y sus medidas de probabilidad. Otro aspecto a destacar es la parte cuantitativa de las RBS, ya que permiten incorporar elementos subjetivos como lo son la opinión de expertos, así como probabilidades basadas en datos estadísticos. Cada nodo en una RB se asocia con un conjunto de tablas de probabilidades. Los nodos representan las variables de interés, las cuales pueden ser discretas o continuas. Una red causal de acuerdo con Pearl (2000) es una RB con la propiedad adicional de que los nodos "padres" son las causas dirigidas.

Teoría de las redes bayesianas

La definición matemática de una red bayesiana, de acuerdo con Jensen (1996), está dada por:

1) Un conjunto de variables conectadas por un conjunto de arcos dirigidos.

2) Cada variable tiene asociado un conjunto finito de estados mutuamente excluyentes.

3) Las variables, junto con los arcos dirigidos, forman una gráfica dirigida acíclica (GDA).

4) Para cada variable A con padres B1,...,Bn, existe una probabilidad asociada definida por P(A | B1,...,Bn). Nótese que si A no tiene nodos padres, la probabilidad P(A) es incondicional.

Sea X = {x1,x2,...,xn} una variable aleatoria con función de distribución conjunta definida por P(X) = P(x1,x2,...,xn), las redes bayesianas proporcionan una representación compacta de P(X) factorizando la distribución conjunta en una distribución condicional local para cada variable, dados sus nodos padres.

Sea pa(xI) el conjunto de valores que toman los nodos padres de la variable x, entonces la distribución conjunta total estará dada por:

P(x1,x2,...,xn) = π[xi|pa(xi)]

Algoritmos para cálculo de inferencia en redes bayesianas

Una red bayesiana es empleada básicamente para inferencia mediante el cálculo de las probabilidades condicionales, dada la información disponible hasta el momento para cada nodo (creencias). Existen dos clases de algoritmos para el proceso de inferencia, el primero genera una solución exacta y el segundo produce una solución aproximada con alta probabilidad. Entre los algoritmos de inferencia exacta se tienen, por ejemplo:polytree, clique tree, junction tree, algorithms variable elimination y method of Pear.

CONSTRUCCIÓN DE UNA RED BAYESIANA PARA EL PROCESO DE LIQUIDACIÓN DEL MERCADO DE VALORES EN MÉXICO

El primer paso para construir una RB es definir el dominio del problema especificando el propósito de la RB. A continuación se identifican las variables o nodos importantes en el dominio del problema. Posteriormente, se representa en forma gráfica la interrelación entre nodos o variables. El modelo resultante debe ser validado por los expertos en el tema. En caso de haber desacuerdo entre ellos se regresa a uno de los pasos anteriores hasta alcanzar el consenso. Los últimos tres pasos son: incorporar la opinión de los expertos (referida como la cuantificación de la red), crear escenarios factibles con la red (aplicaciones de redes) y ajustar las estimaciones en el tiempo (mantenimiento de la red).

Problemática

Los principales problemas a que se enfrenta un administrador de riesgo que emplea RB son: ¿cómo implementar una red bayesiana?, ¿cómo modelar su estructura?, ¿cómo cuantificarla?, ¿cómo utilizar datos subjetivos (de expertos) u objetivos (estadísticos) o ambos?, ¿qué instrumentos se deben utilizar para obtener mejores resultados? y ¿cómo validar el modelo? Las respuestas a estos cuestionamientos se abordarán en la aplicación del modelo bayesiano.

El objetivo principal de la aplicación consiste en elaborar una guía para implementar una RB para administrar el riesgo operacional del proceso de liquidación del mercado de valores mexicano. Asimismo, se pretende generar una medida consistente del capital económico necesario para hacer frente a pérdidas derivadas de eventos de riesgo operacional.

Alcances de la aplicación

El caso de estudio se enfoca en el análisis de los subprocesos de match, pre-liquidación, compensación y liquidación, los cuales forman parte integral del proceso completo de liquidación del INDEVAL. Una vez identificados los factores de riesgo asociados a cada subproceso, se definen los nodos que formaran parte de la red bayesiana, éstos son variables aleatorias que pueden ser discretas o continuas y que tienen asociadas distribuciones de probabilidad.

Para el caso de que se tengan datos históricos relacionados con los nodos (variables aleatorias) se les ajusta una función de distribución; en caso contrario, se recurre a los expertos para determinar las probabilidades de ocurrencia o el parámetro de alguna función de probabilidad conocida. Los datos disponibles son diarios y abarcan el periodo 2007-2010. El cálculo de la máxima pérdida esperada será para un día. Es importante mencionar que el INDEVAL tiene otros procesos sustantivos, como la custodia y el préstamo de valores; sin embargo, no son objeto de este trabajo.

En el siguiente apartado se analiza el flujo del proceso de liquidación del INDEVAL (sistema de liquidación de valores) que permite identificar los factores de riesgo asociados con la operación, que permitirán estar en condiciones de definir los nodos que formarán parte de la RB.

Sistema de liquidación de valores

El sistema de liquidación de valores tiene, como se había mencionado antes, cuatro subprocesos: match, pre-liquidación, compensación y liquidación. Una operación de liquidación contiene órdenes de cargo o abono en cuentas de títulos o efectivo. A estas órdenes se les conoce como acciones. En la gráfica 1 se resume el sistema de liquidación de valores del INDEVAL.

CONSTRUCCIÓN Y CUANTIFICACIÓN DEL MODELO

Para construir la red se requieren dos etapas: 1) creación de la estructura del modelo, la cual será el propósito de los siguientes dos puntos de este apartado, y 2) cuantificación de la red, que se abordará en el tercer punto del presente apartado.

Riesgo, mapeo de procesos e identificación de nodos

Para identificar los factores de riesgo el proceso general se divide en tres subprocesos: match, pre-liquidación y liquidación. En cada subproceso se definen actividades y los posibles riesgos asociados, así como los factores que provocan la ocurrencia de los riesgos. Por ejemplo, las actividades de captura son: solicitud de transacción, registro y transmisión de instrucciones. Estas actividades dependen del sistema front-office y del personal que opera el sistema, y entre los posibles riesgos están: un registro erróneo, falla en el sistema de transmisión o error en la última entrada. Los factores de riesgo serían el volumen de transacción, disponibilidad del sistema y el nivel de preparación del personal de captura. Una descripción completa de lo subprocesos, actividades y riesgos se presenta en el cuadro 1.

El mapeo de procesos y riesgos produce una lista de actividades, dependencias, riesgos, factores de riesgo e indicadores clave de riesgo, todos ellos candidatos para emplearse como nodos en la construcción de la red bayesiana.

Estructura de la red bayesiana

Los nodos seleccionados son conectados con arcos dirigidos (con flechas) para formar una estructura que muestra la dependencia o relación causal entre éstos.

La red del proceso de liquidación se divide en dos redes, una para modelar la frecuencia y la otra para la severidad, lo cual facilita su análisis. Una vez obtenidos los resultados, estos se "agregan" por separado mediante una simulación Monte Carlo para obtener la pérdida esperada en el proceso de liquidación.

Frecuencia

La red completa de la frecuencia se muestra en la gráfica 2, la cual se genera a partir de los elementos esenciales del proceso de liquidación, como se detalló en el mapeo de proceso y riesgos.

Severidad

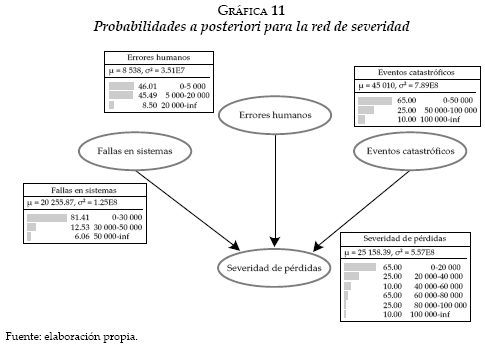

La red de severidad se muestra en la gráfica 3. Se integra por cuatro nodos, aunque requiere una cantidad importante de probabilidades. El nodo etiquetado como severidad de pérdida es la pérdida de dinero generado por una falla en la liquidación de una posición, los otros nodos se consideran variables informativas.

A continuación se describen las características de cada nodo de las redes de severidad y frecuencia respectivamente.

Cuantificación de la RB para el mercado de valores

Para cuantificar las redes bayesianas identificadas en la sección anterior se utilizaron tanto datos objetivos como subjetivos; sin embargo, los datos históricos disponibles son escasos o no son fácilmente codificables para incorporarse a la red. Por esta razón, se utilizarán preponderantemente datos subjetivos en la red de frecuencia. Por lo que respecta a la red de severidad, es cuantificada con datos estadísticos (objetivos). A continuación se describen las herramientas o técnicas que se emplearon para obtener, codificar y cuantificar los datos.

Análisis estadístico de la red de frecuencia

En este apartado se analiza cada nodo de la red de frecuencia, para el caso de nodos con información histórica disponible se ajustan6 diversas distribuciones hasta encontrar la mejor de acuerdo con la prueba estadística X2, posteriormente se calcularon las probabilidades requeridas; cuando no se cuenta con datos suficientes se obtiene la información de los expertos. El nodo etiquetado como volumen de transaction presenta la siguiente distribución de frecuencias y densidad Weibull ajustada.

De esta manera, se calcula la tabla de probabilidad para este nodo de la red de frecuencia, misma que constituye las probabilidades a priori.

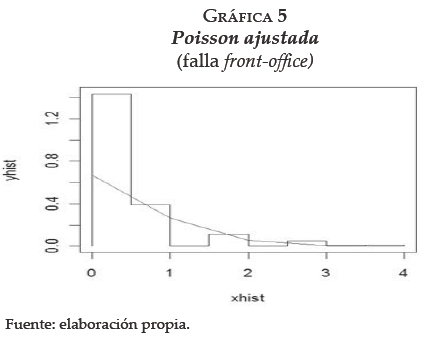

Respecto al nodo etiquetado como sistema front-office, son datos asociados a riesgos derivados de actividades en el primer nivel del proceso de liquidación, como son la captura por clientes y la toma de alguna posición, entre otros. En la gráfica 5 se muestra la distribución de frecuencias y la distribución ajustada Poisson con parámetro λ = 0.4.7

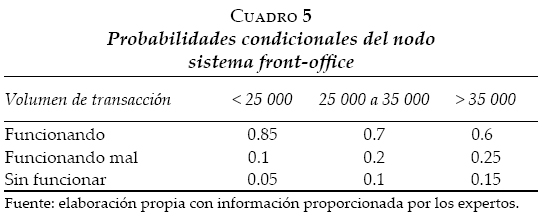

Lo anterior presenta la distribución del número de fallas en el sistemafront-office, los resultados muestran probabilidades pequeñas de que se tenga más de una falla al día; sin embargo, lo que nos interesa calcular son las probabilidades condicionales de que este sistema se encuentre funcionando, funcionando mal o sin funcionar. Por tanto, considerando los resultados previos y el conocimiento de los expertos se calcula la tabla de probabilidad condicional para este nodo de la red de frecuencia, misma que constituye las probabilidades a priori.

Dado que el volumen de transacción fue menor a 25 000 operaciones, existe una probabilidad de 85% de que el sistemafront-office funcione, 10% de que funcione incorrectamente y 5% de que no funcione. La interpretación es similar para las demás probabilidades condicionales.

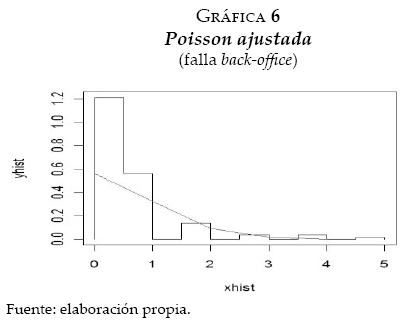

Referente al nodo etiquetado como falla del sistema back-office, en la gráfica siguiente se muestra su distribución de frecuencias y las probabilidades Poisson ajustadas.

El análisis anterior calcula la función de probabilidad del número de fallas diarias del sistema back-office, lo cual indica una probabilidad pequeña de que el sistema falle más de una vez. De acuerdo con la red de frecuencia, lo que interesa estimar son las probabilidades de que el sistema back-office falle en forma crítica o no crítica. Entonces, considerando los resultados previos y el conocimiento de los expertos sobre la criticidad de las fallas en el sistema del INDEVAL, se estiman las siguientes probabilidades a priori para el nodo falla back-office.

Concerniente al nodo etiquetado como inactividad del sistema back-office, en la gráfica siguiente se muestra su distribución de frecuencias y la función de densidad exponencial ajustada.8

Y se calculan las probabilidades asociadas a los estados de este nodo de la red de frecuencia, mismas que constituyen las probabilidades a priori.

Para los nodos restantes que conforman la red de frecuencia no existe información registrada en base de datos, en su lugar se obtuvieron las probabilidades asociadas a cada estado de cada nodo por medio del juicio y creencias de los expertos. El proceso inició con entrevistas a los responsables del registro de eventos de riesgo operacional, después se llevó a cabo una segunda revisión por parte de los involucrados en el proceso de liquidación para llegar a un consenso sobre la distribución de probabilidades a priori. El resultado de la dinámica anterior se muestra en los siguientes cuadros de probabilidades.

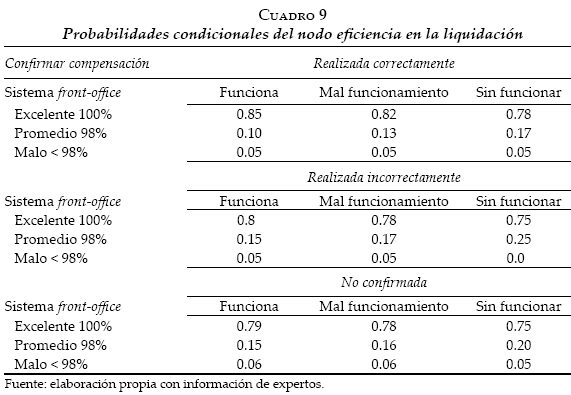

Existe una probabilidad condicional, dado que se realizó la confirmación de compensación correctamente y el sistemafront-office funciona correctamente, se tiene 85% de probabilidad de que se tenga una eficiencia en la liquidación de 100%; 10% de que esté entre 98 y 99 por ciento, y 5% de que sea menor a 98%. Las otras probabilidades condicionales se leen de manera similar. El siguiente nodo mide el impacto de las fallas potenciales del proceso de liquidación.

Existe una probabilidad condicional, dado que hay inactividad menor a 25 minutos del back-office y se presenta una falla crítica del mismo sistema. Se tiene 5% de probabilidad de que la criticidad sea baja, 10% de que la criticidad sea media y 85% de presentar una criticidad alta. Las otras probabilidades se leen de manera similar.

Existe una probabilidad de 49% de que se presente un evento externo de riesgo operacional, 39% de que existan dos eventos y 12% de presentar más de dos eventos externos de riesgo operacional.

Finalmente, el nodo objetivo fallas en la liquidaáón trabaja bajo el supuesto de una función de probabilidad de Poisson con parámetro λ = 0.6, este supuesto es consistente con la práctica financiera y estudios del riesgo operacional que muestran que el número de fallas usualmente siguen una distribución de Poisson o una binomial negativa; sin embargo, esta última es muy dispersa en procesos donde se incorpora la opinión de los expertos para la estimación de parámetros. Para estimar el valor del parámetro λ se recurrió a los expertos y se complementó con resultados del análisis del nodo fallas en el sistema front-office y del nodo fallas en el sistema back-office, los cuales son parte fundamental del proceso de liquidación. Asimismo, estos nodos se utilizarán para realizar un análisis de sensibilidad del modelo.

Análisis estadístico de la red de severidad

En este apartado se analiza cada nodo de la red de severidad. Para el caso de nodos con información histórica disponible se ajusta la mejor distribución de probabilidad de acuerdo con la prueba X2 y se calculan las posibilidades requeridas. Cuando no se cuenta con datos suficientes se obtiene la información de los expertos.

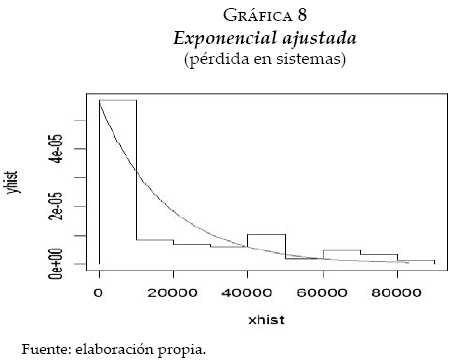

El nodo indicado como falla en sistemas presenta la siguiente distribución de frecuencias y densidad exponencial ajustada para las pérdidas ocasionadas por fallas en los sistemas.

Por tanto, se calcula la tabla de probabilidad para este nodo de la red de severidad misma que constituye las probabilidades a priori.

A partir del cuadro se ve que existe una probabilidad de 82% de que se pierdan menos de $30 000 por fallas en los sistemas; de 12% de que se pierdan entre 30 000 y 50 000 pesos, y de 6% de que la pérdida sea mayor a $50 000.

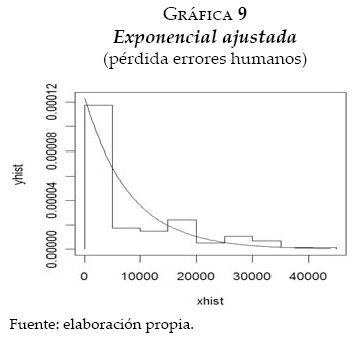

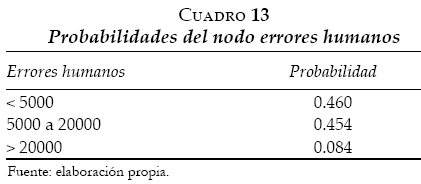

El nodo etiquetado como errores humanos presenta la siguiente distribución de frecuencia y densidad exponencial ajustada para pérdidas ocasionadas por errores humanos.

Y se calculan las probabilidades para este nodo de la red de severidad, mismas que constituyen las probabilidades a priori.

A partir del cuadro se observa que existe una probabilidad de 46% de que se pierdan menos de $5 000 por fallas en errores humanos; de 45% de que se pierdan entre 5 000 y 20 000 pesos, y de 9% de que la pérdida sea mayor a $20 000.

Para el nodo evento catastrófico no existe información registrada en bases de datos, en cambio se obtuvieron las posibilidades asociadas a cada estado por medio del juicio y creencias de los expertos.

De acuerdo con los expertos, existe una probabilidad de 5% de que se pierdan menos de $5 000 por eventos catastróficos; de 25% de que se pierdan entre 5 000 y 100 000 pesos, y de 70% de que la pérdida sea mayor a $100 000.

Por último, el nodo objetivo severidad de la pérdida representa la suma de las pérdidas asociadas con los nodos fallas en sistemas, errores humanos y eventos catastróficos. Para el cálculo de la tabla de probabilidades condicional se utilizó una función de distribución exponencial con parámetro igual al promedio de los nodos anteriores. El supuesto de distribución exponencial es consistente con las distribuciones exponenciales ajustadas para el caso de los nodos fallas en sistemas y errores humanos. En el siguiente apartado se generan las probabilidades a posteriori, para lo cual se utilizan técnicas de inferencia bayesiana.

Probabilidades a posteriori

Una vez analizados cada uno de los nodos (variables aleatorias continuas o discretas) de las redes de frecuencia y severidad y asignadas las correspondientes funciones de distribución de probabilidades se generan las probabilidades a posteriori, para lo cual se utilizan técnicas de inferencia para redes bayesianas. Entre los algoritmos de solución exacta está el denominado junction tree, mismo que se utilizará para realizar la inferencia, en virtud de que reduce a su mínima expresión las redes de frecuencia y severidad, evitando crear ciclos y, por lo tanto, optimizando el tiempo de procesamiento. Para una consulta detallada del algoritmo revisar Guo y Hsu (2002). Las probabilidades a posteriori para los nodos de la red de frecuencia que tienen al menos un padre9 se muestran en la gráfica 10.

Los resultados del nodo sistemafront-office muestran que existe una probabilidad de 71% de que las operaciones solicitadas mediante el sistema de liquidación de valores se registren y procesen sin problema alguno; de 20% de que se presente algún problema menor sin que impida su atención, y de 9% de que el sistema no funcione. Las probabilidades calculadas están condicionadas por el volumen de transacción operado.

En cuanto al nodo confirmar compensación, la probabilidad de que la instrucción de liquidación se confirme correctamente es de 89%, de que se confirme de manera incorrecta es de 1% y de que no sea confirmada es de 10%; condicionadas a que exista una instrucción de liquidación.

Por lo que respecta a la criticidad en las fallas del sistema de liquidación de valores capturado por el nodo criticidad de fallas, la probabilidad de que tengan un nivel bajo es de 5%, de que el nivel sea medio es de 22% y de que la falla tenga un nivel alto es de 73%; condicionadas a fallas o inactividad del back-office. El nivel de criticidad es una variable fundamental dentro del sistema, ya que si se presentan niveles altos se puede generar un riesgo sistémico, es decir, poner en riesgo todo el sistema de pagos a nivel nacional.

El nodo eficiencia en la liquidación tiene una probabilidad de 83% de que las operaciones se liquiden de manera apropiada, 12% aceptable (promedio) y 5% deficientemente (mal); las probabilidades están condicionadas al desempeño del sistema front-office y a la manera en que se confirma la compensación.

Finalmente, la distribución de probabilidades del nodo de interés Fallas en la liquidación muestra una probabilidad de 54.88% de que no presente ninguna falla, de 32.93% de que tenga una falla, de 9.88% de que existan dos fallas, de 1.98% de tres fallas y de 0.33% de que se presenten más de cuatro fallas; todas ellas condicionadas a factores de riesgo externos, criticidad de las fallas del sistema de liquidación y de la eficiencia en las liquidaciones.

Para el cálculo de las probabilidades del nodo de interés se utilizó una Poisson con parámetro λ = 0.6, este valor se seleccionó considerando los resultados del análisis de frecuencia de los nodos falla front-office y falla back-office, además de ser consistente con la evidencia empírica de que la frecuencia de eventos de riesgo operacional tienen un ajuste adecuado bajo esta distribución (véase Svetlozar et al., 2008).

Para el caso de la red de severidad se tienen las siguientes probabilidades a posteriori.

Las pérdidas originadas por errores humanos son de 8 538 pesos diarios en promedio; por lo que respecta a las pérdidas por eventos catastróficos, como manifestaciones, inundaciones entre otros, en promedio son de 45 010 pesos diarios. La razón de que se tenga una pérdida relativamente baja se relaciona con los altos niveles de seguridad y disponibilidad con que cuenta el sistema de liquidación de valores, el cual tiene una sede alterna en caso de presentarse este tipo de eventos.

En cuanto a fallas en los sistemas, en promedio se tiene una pérdida diaria de $20 255. La distribución de probabilidades del nodo de interés severidad de pérdida muestra una probabilidad de 59.9% de que la pérdida esté entre 0 y 20 000 pesos; de 21% de que esté entre 20 000 y 40000 pesos; de 9.2% de que esté entre 40 000 y 60 000 pesos; de 4.4% de que esté entre 60 000 y 80 000 pesos; de 2.3% de que esté entre 80 000 y 100 000 pesos, y de 3% de que la pérdida sea mayor a $100 000 en un día.

Para el cálculo de las probabilidades a posteriori del nodo de interés se utilizó una densidad exponencial con parámetro igual al promedio de las pérdidas por errores humanos, fallas en los sistemas y eventos catastróficos; la distribución exponencial es consistente con el ajuste de las funciones de probabilidad estimadas en el análisis estadístico de la red de severidad anteriormente presentado.

Análisis de sensibilidad

Con objetivo de medir la sensibilidad del modelo ante cambios en las probabilidades a priori, se sustituyeron las funciones de distribución de Poisson para los nodos sistema front-office y sistema back-office en la red bayesiana por las funciones de distribución exponencial con parámetros λ = 1.5 y λ = 1.2 respectivamente. A continuación se muestran las tablas de probabilidad condicional correspondientes.

Con la sustitución de las probabilidades a priori para los nodos sistemafront-office y sistema back-office, y utilizando el mismo algoritmo de inferencia bayesiana, se calcularon nuevamente las probabilidades a posteriori, obteniendo los siguientes resultados.

Comparando las probabilidades a posteriori originales (véase la gráfica 10) con las calculadas en esta sección (véase la gráfica 12), concluimos lo siguiente:

1) Debido al cambio en la función de distribución de probabilidades a priori del nodo sistema front-office, cambian las probabilidades a posteriori de los nodos sistema front-office y eficiencia liquidación.

2) El cambio en la función de probabilidad a priori del nodo sistema back-office no tiene efectos en las probabilidades a posteriori del nodo criticidad de fallas.

3) Los cambios en las probabilidades a priori de los nodos sistema front-office y sistema back-office no presentan ningún efecto en las probabilidades a posteriori del nodo objetivo fallas en la liquidación. Lo anterior muestra que la red bayesiana construida después de un determinado número de iteraciones converge a la misma distribución objetivo con distintas distribuciones apriori, a pesar de que nodos intermedios puedan presentar algún cambio en su distribución de probabilidad. Sin embargo, no podemos concluir que se mantenga la convergencia y resultados para cualquier distribución a priori.

CÁLCULO DEL VALOR EN RIESGO OPERACIONAL (OpVaR)

Una vez realizada la inferencia bayesiana para obtener las distribuciones de probabilidad a posteriori de la frecuencia y severidad de pérdidas, mediante un proceso de simulación Monte Carlo (10 000 simulaciones) se integran ambas distribuciones para generar la distribución de pérdidas potenciales (se utilizó una Poisson con parámetro λ = 0.6 para la frecuencia y una exponencial con parámetro r = 25 158 para la severidad) en el proceso de liquidación del mercado de valores.10

Para el cálculo del valor en riesgo operacional (OpVar) se ordenan descendentemente los valores obtenidos para las pérdidas esperadas y se calculan los percentiles correspondientes. El cuadro 17 muestra los resultados con niveles de confianza mayor a 98.9 por ciento.

En consecuencia, se tiene una máxima perdida esperada de 128 047 pesos diarios con un nivel de confianza de 99%. Para calcular el VaR condicional se obtiene el promedio de las pérdidas mayores a la máxima pérdida esperada y se suma al OpVaR calculado. Por tanto, el CVaR para el riesgo operacional del proceso de liquidación del mercado de valores en México es de 280 226 pesos diarios.

VALIDACIÓN DEL MODELO BAYESIANO

Para validar los resultados del modelo bayesiano se estiman con modelos clásicos la distribución de probabilidades para la frecuencia y la severidad. Posteriormente, mediante una simulación Monte Carlo, se integran ambas distribuciones para obtener la distribución de pérdidas esperadas. Por último, se calcula el riesgo operacional con la distribución de pérdidas estimada en forma clásica y se comparan resultados con los obtenidos con el modelo bayesiano.

Análisis clásico de frecuencia

Se considera el número de fallas que diariamente se presentan en el proceso de liquidación de valores del INDEVAL y se le ajusta una distribución de Poisson con parámetro λ = 0.6, según se muestra en la siguiente gráfica.

La prueba X2 tuvo los siguientes resultados: X2 = 10.86, g - 1 = 3 y p = 0.0043. El valor de X2 en tablas para un nivel confianzas de 99% y 3 grados de libertad es 11.34, lo que implica aceptar la hipótesis nula de que la muestra proviene de una Poisson con parámetro λ = 0.6.

Análisis clásico de severidad

Se considera el monto diario de pérdidas por eventos de riesgo operacional en el proceso de liquidación de valores y se le ajusta una distribución exponencial con parámetro r = 4.930874e-05, según se muestra en la siguiente gráfica.

Se realizó la prueba X2, con los siguientes resultados: X2 = 4.6377, g - 1 = 5 y p = 0.4617. El p-valor es mayor a 5%, por lo tanto se acepta que la muestra proviene de una exponencial con parámetro r = 4.930894e-05.

Cálculo del valor en riesgo operacional con el modelo clásico

Mediante una simulación Monte Carlo se "integran" las distribuciones clásicas de frecuencia y severidad para generar la distribución de pérdidas potenciales (se utilizó una Poisson con parámetro λ = 0.6 para la frecuencia y una exponencial con media 1/r = 20 280 para la severidad) en el proceso de liquidación del mercado de valores.11 Para el cálculo del OpVar se ordenan descendentemente los valores obtenidos para las pérdidas esperadas y se calculan los percentiles correspondientes. A continuación se muestran los resultados con niveles de confianza mayor a 98.9 por ciento.

Si se calcula el OpVaR con un nivel de confianza de 99% se tiene una máxima pérdida esperada de 100 511 pesos diarios con el modelo clásico. Por tanto, el cálculo del OpVaR para el riesgo operacional del proceso de liquidación del mercado de valores en México es de 223 767 pesos diarios. Los resultados anteriores muestran que el OpVaR calculado con el modelo bayesiano es mayor al calculado con el modelo clásico, lo cual se explica por la causalidad entre los distintos factores de riesgo, misma que no está considerada en el modelo clásico.

CONCLUSIONES

Hoy en día las instituciones financieras generan grandes cantidades de información provenientes de la interacción con sus clientes, el sector y sus procesos internos; sin embargo, a la interrelación de los individuos involucrados en los procesos y en los sistemas informáticos no se le había dado la importancia requerida, esta preocupación la retoma el Banco Internacional de Pagos y queda plasmada en Basilea II, donde se pide contar con metodologías sólidas para la medición y administración del riesgo operacional.

En congruencia con lo anterior, este trabajo proporciona los elementos teóricos necesarios y una guía práctica para identificar, medir, cuantificar y administrar el RO en el sector financiero con un enfoque bayesiano, el cual mostró en el desarrollo del trabajo que utiliza elementos más apegados a la realidad como son: probabilidades obtenidas de los expertos, cuando no existe información histórica; distribuciones de probabilidad específicas para cada factor de riesgo, que pueden ser discretas o continuas; actualización de datos que se incorporan al modelo, y la interrelación (causalidad) de los factores de riesgo mediante modelos de redes. Se mostró que las redes bayesianas son una opción viable para administrar el riesgo operacional en un ambiente de incertidumbre y de información escasa o de calidad cuestionable. Sin embargo, el utilizar información obtenida de los expertos puede generar sesgo o inconsistencia, por lo que es fundamental contar con herramientas eductivas12 sólidas y confiables, entre las que podemos mencionar la conferencia de búsqueda, el análisis de procesos de negocio y la técnica delphi, entre otras.

El capital requerido en riesgo operacional, calculado para el INDEVAL, se basa en el supuesto de interrelación entre factores de riesgo (causa-efecto), lo cual es consistente con la realidad; por ejemplo, cuando se analizó el nodo criticidad de fallas se dejó de manifiesto que es un evento dependiente de los nodos falla del sistema back-office e inactividad del sistema back-office. El cálculo del valor en riesgo operacional por el método de la estadística clásica no considera la interrelación o causalidad entre los distintos factores de riesgo, lo cual produce subestimación de la máxima pérdida esperada con respecto del capital requerido con el modelo bayesiano. En un escenario de pérdidas extremas, los resultados del modelo clásico afectarían la viabilidad operativa del sistema de liquidación de valores.

Por construcción, una red bayesiana incorpora información del mercado para calibrar el modelo; asimismo, es dinámica y requiere contar con información oportuna y confiable, por lo tanto es condición necesaria mantener una base de conocimientos que alimente de manera sistemática al modelo.

La máxima pérdida esperada por riesgo operacional calculada para el proceso de liquidación del INDEVAL es una cantidad relativamente menor, comparada con el volumen de transacciones operadas diariamente. No obstante, refleja los altos estándares de servicio y seguridad con los cuales opera el sistema de liquidación de valores, lo cual es congruente con la trascendencia sistémica de uno de los más importantes sistemas de pagos en México.

Las redes bayesianas están basadas en algoritmos eficientes de propagación de evidencias, que actualizan dinámicamente el modelo con datos reales. Para el caso de estudio objeto de este trabajo fue posible construir la RB y calcular el capital requerido para administrar el riesgo operacional combinando datos estadísticos y opiniones o juicios de los expertos del INDEVAL.

En este trabajo la cantidad de nodos que conforman las redes no demandan demasiados cálculos de probabilidades, por lo tanto el algoritmo junction tree utilizado es el más apropiado. Para el análisis de problemas de mayor complejidad se requiere más poder de procesamiento, por lo que se recomienda algoritmos de solución aproximada, como el método denominado Markov Chain Monte Carlo MCMC).

El OpVaR condicional calculado con el enfoque bayesiano es consistente en el sentido de Artzner, pero también resume las complejas relaciones causales entre los diferentes factores de riesgo que derivan en un evento de riesgo operacional. En resumen, debido a que la realidad es mucho más compleja que eventos independientes idénticamente distribuidos, el enfoque bayesiano es una alternativa que presenta ventajas sobre el enfoque clásico para modelar una realidad compleja y dinámica.

REFERENCIAS

Aquaro, V, Bardoscia, M., Belloti, R., Consiglio, A., De Carlo, F. y Ferri, G., 2009. A Bayesian Networks Approach to Operational Risk. Cornell University, arXiv:0906.3968. [ Links ]

Alexander, C., 2002. Operational Risk Measurement: Advanced Approaches. Reino Unido: International Capital Market Association Centre (ICMA Centre), Henley Business School, University of Reading. [ Links ]

Artzner, P., Delbaen, F., Eber, J. y Heath, D., 1998 Coherent Measures of Risk. Strans-bourg: Université Louis Pasteur. [ Links ]

Basilea II., 2001a. Consultative Document. Operational Risk. Basilea, Suiza: Comité de Supervisión Bancaria, Banco Internacional de Pagos. [ Links ]

Basilea II., 2001b. Working Paper on the Regulatory Treatment of Operational Risk. Basilea, Suiza: Comité de Supervisión Bancaria, Banco Internacional de Pagos. [ Links ]

Degen, M., Embrechts, P. y Lambrigger, D., 2007. The Quantitative Modeling of Operational Risk: Between g-and-h and EVT. Zurich, Suiza: Eidgenössische Technische Hochschule Zürich (ETH Zurich). [ Links ]

Embrechts, P., Furrer, H. y Kaufmann, O., 2003. Quantifying Regulatory Capital for Operational Risk, Derivatives Use. Trading and Regulation, 9(3), pp. 217-33. [ Links ]

Ferguson, T.S., 1973. A Bayesian Analysis of Some Nonparametric Problems. Annals of Statistics, 2, pp.615-29. [ Links ]

Guo, H. y Hsu, W., 2002. A Survey of Algorithms for Real-Time Bayesian Network Inference [pdf]. Join Workshop on Real Time Decision Support and Diagnosis Systems. Edmonton, Alberta, Canadá, 29 de julio: [ Links ]

Heinrich, G., 2006. Riesgo operacional, sistemas de pago y aplicación de Basilea II en América Latina: evolución más reciente. Boletín del CEMLA. Encuentro latinoamericano de Usuarios SWIFT, ELUS 2006 "Creciendo en Competitividad", Santiago de Chile, 3-5 de julio. [ Links ]

Jensen, F.V, 1996. An Introduction to Bayesian Networks. Springer-Verlag, Nueva York: LLC. [ Links ]

Kartik, A. y Reimer, K., 2007. Phase Transitions in Operational Risk. Physical Review E, 75(016111). [ Links ]

Leippold, M., 2003. The Quantification of Operational Risk. Social Science Research Network. Journal of Risk, 8(1). [ Links ]

Marcelo, C., 2004. Operational Risk Modelling and Analysis: Theory and Practice. Risk Books. [ Links ]

Moscadelli, M., 2004. The Modelling of Operational Risk: Experience with the analysis of the data collected by the Basel Committee. Banca d'Itaia, Banking Supervision Department, Italia. [ Links ]

Neil, M., Marquez, D. y Fenton, N., 2004. Bayesian Networks to Model Expected and Unexpected Operational Losses. Risk Analysis Journal, 25(4), pp. 963-72. [ Links ]

Panjer, H., 2006. Operational Risk Modeling Analytics. Estados Unidos de América (EE.UU.): Wiley-Interscience. [ Links ]

Pearl, J., 2000. Causality, Models, Reasoning, and Inference. Cambridge, MA: Cambridge University Press. [ Links ]

Reimer, K. y Neu, P., 2002. Adequate Capital and Stress Testing for Operational Risks, Physical Review E, 75. [ Links ]

Reimer, K. y Neu, P., 2003. Functional Correlation Approach to Operational Risk in Banking Organisations. EE.UU.: Kings College London-Dresdner Bank AG. [ Links ]

Svetlozar T., Hsu J., Biliana S. y Fabossi F., 2008. Bayesian Methods in Finance. The Frank J. Fabozzi Series, Wiley Finance. [ Links ]

Supatgiat, C., Kenyon, C. y Heusler, L., 2006. Cause-to-Effect Operational Risk Quantification and Management. IBM Zurich Research Laboratory. [ Links ]

Venegas-Martínez, F., 2006. Riesgos financieros y económicos. Productos derivados y decisiones económicas bajo incertidumbre. México: International Thomson Editors. [ Links ]

Zellner, A., 1971. An Introduction to Bayesian Inference in Econometrics. Nueva York: Wiley. [ Links ]

Los autores agradecen los valiosos comentarios de dos dictaminadores anónimos de la revista.

1 También conocido como riesgo operativo.

2 Cuando se haga referencia a expertos, son funcionarios del INDEVAL que tienen la experiencia y conocimiento sobre la operación y administración de las líneas de negocio vinculadas con el proceso de liquidación.

3 Usualmente, para medir la máxima pérdida esperada (o capital económico) por RO se utiliza el valor en riesgo condicional (CVaR, por sus siglas en inglés).

4 Para un análisis completo sobre la no coherencia del VaR se recomienda revisar Venegas-Martínez (2006).

5 Para una revisión del teorema de Bayes véase, por ejemplo, Zellner (1971).

6 Ajustar una distribución consiste en encontrar una función matemática que represente de manera correcta a una variable estadística. Pasos para el ajuste: 1) hipótesis sobre el modelo, 2) estimación de parámetros, 3) evaluación de la calidad de ajuste y 4) prueba estadística de la bondad de ajuste. Para realizar este trabajo se utilizó el lenguaje estadístico R primero se graficó la distribución de frecuencias de los datos reales para proponer un modelo de distribución, después se realizaron diferentes estimaciones para encontrar el mejor parámetro. Se realizó la prueba X2 para determinar estadísticamente la bondad del ajuste, un p-valor > 0.05 es indicador de un buen ajuste.

7 La distribución de Poisson tiene dos importantes propiedades, la primera está dada por medio del siguiente Teorema: si N1,...,Nn son variables de Poisson con parámetros λi,...,λn, entonces N=N1 +...+ Nn tiene una distribución de Poisson con parámetros λ1 +...+ λn. La segunda característica es particularmente útil en el modelado de eventos de riesgo operacional. Se supone que el número de pérdidas en un periodo de tiempo fijo sigue una distribución de Poissson, además se supone que las pérdidas pueden clasificarse en m distintos tipos.

8 La exponencial es la única función de distribución continua con una tasa de fallo constante, h(x) = 1/θ, y un exceso de pérdida esperada condicional, ed(x) = θ, también constante. Por tanto, el exceso de pérdida no depende del umbral establecido.

9 Los nodos que no tienen padre mantienen las probabilidades a priori.

10 Los resultados de la simulación están disponibles a los lectores mediante solicitud a los autores por correo electrónico.

11 Los resultados de la simulación están disponibles a los lectores mediante solicitud a los autores por correo electrónico.

12 Por técnicas eductivas nos referimos a técnicas heurísticas para obtener información de calidad de los expertos, que nos permitan establecer las probabilidades subjetivas o creencias sobre la probabilidad de ocurrencia de algún evento.