Servicios Personalizados

Revista

Articulo

Indicadores

-

Citado por SciELO

Citado por SciELO -

Accesos

Accesos

Links relacionados

-

Similares en

SciELO

Similares en

SciELO

Compartir

Acta zoológica mexicana

versión On-line ISSN 2448-8445versión impresa ISSN 0065-1737

Acta Zool. Mex vol.25 no.3 Xalapa dic. 2009

Ensayos

La evaluación científica y las revistas nacionales

Evaluation of research and national scientific journals

Javier LABORDE

Instituto de Ecología, A.C., Departamento de Ecología Funcional, km 2.5 carretera antigua a Coatepec 351, Congregación El Haya, Xalapa 91070, Veracruz, MÉXICO. javier.laborde@inecol.edu.mx

Recibido: 25/08/2009

Aceptado: 25/08/2009

In memoriam: a mi hermana la Güera, quien siempre trazó su propio camino...

RESUMEN

En los sistemas de evaluación de investigadores imperantes en México y Latinoamérica se les concede muy poco valor (o ninguno) a los artículos publicados en las revistas nacionales y por tanto, nuestros científicos publican sus investigaciones más relevantes en revistas de otros países, principalmente en revistas indizadas en el Citation Index (CI) de la compañía ISI con alto 'Factor de Impacto (FI)', ya que son las más apreciadas en nuestras evaluaciones. La situación anterior, priva literalmente a las revistas latinoamericanas de las mejores contribuciones de la región y con ello difícilmente ganarán la visibilidad internacional que las haría más atractivas para nuestros investigadores y evaluadores. De no romperse éste ciclo, nuestras revistas quedarán relegadas a desempeñar un papel secundario en el avance del conocimiento o de plano condenadas a desaparecer. En esta contribución sintetizo las principales limitantes del CI y del 'FI' de ISI como indicadores de 'buena ciencia', que distintos investigadores han señalado y describo alternativas e indicadores recientes que deberían al menos complementarlos y posiblemente reemplazarlos. Al final hago algunas reflexiones sobre las prácticas de evaluación actuales y propongo algunas medidas para romper el círculo vicioso en el que están atrapadas nuestras revistas. Mi objetivo es contribuir al debate para mejorar los indicadores empleados en nuestras evaluaciones y estimular la discusión de las profundas consecuencias que el uso de tales indicadores tiene sobre el desarrollo científico regional y el futuro de nuestras revistas.

Palabras clave: Análisis de citación, Factor de impacto, Indicadores bibliométricos, Índices de revistas, ISI.

ABSTRACT

Scientific papers published in Mexican and Latin American journals are usually assigned very low (or even null) value in the research evaluation systems that are currently prevalent in this region. Consequently, our scientists are publishing their most relevant research elsewhere, mainly in journals that are indexed in ISI's Citation Index (CI) and have a high Impact Factor (IF) because these journals are the most highly valued by our evaluators. Latin American journals literally are being deprived of the best contributions from the region, making it even more difficult to acquire the international visibility needed for our journals to become more attractive to our researchers and evaluators. If this cycle continues, our journals will be condemned to a secondary role in the advancement of science and may even disappear. Several scientists have exposed the main problems and limitations of ISI's CI and the IF as indicators of 'good science' and I review these here. I then briefly describe recently developed alternatives that should at least complement these indicators or possibly replace them in the evaluation of research. Finally, I reflect on current practices of research evaluation and propose some measures to break the vicious cycle in which our journals are trapped. My main objective is to contribute to the debate on the indicators employed in our evaluation systems and to stimulate the discussion of the far reaching consequences that the use of these indicators is having on the development of science in Latin America and on the future of our journals.

Keywords: Bibliometric indicators, Citation analysis, Impact factor, ISI, Journal indexes.

INTRODUCCIÓN

A un investigador o grupo de investigadores mexicanos (o latinoamericanos) que hoy día tengan un artículo científico interesante por publicar, no les conviene enviarlo a una revista mexicana (ni latinoamericana), debido al poco valor que se le otorga a nuestras revistas en las evaluaciones. En la actualidad se considera como reflejo de 'buena ciencia' la publicación en revistas internacionales de las denominadas de 'corriente principal'. Durante las últimas cinco décadas, se han considerado como revistas de corriente principal exclusivamente las que están indizadas en el Citation Index (CI) de la compañía ISI (por sus siglas en inglés: Institute for Scientific Information) ahora parte del consorcio transnacional Thomson Reuters. El investigador o grupo de investigadores en cuestión, podría enviar su artículo a una de las escazas revistas latinoamericanas incluidas en el CI; sin embargo, tales revistas tienen valores de 'Factor de Impacto' (FI) considerablemente inferiores a los alcanzados por revistas internacionales de temas similares, editadas principalmente en los EEUU y en Europa Occidental. Es la publicación en éstas últimas revistas a lo que se le da el mayor peso en nuestras evaluaciones, tanto en las que se nos hacen para ingresar, permanecer o ser promovidos en nuestras instituciones o en sistemas de estímulos y reconocimiento nacionales diversos (ej., el Sistema Nacional de Investigadores, SNI), así como en la solicitud de fondos para realizar investigación. Esta situación, priva literalmente a las revistas mexicanas y latinoamericanas de las mejores contribuciones de los investigadores de la región y con ello difícilmente ganarán la visibilidad internacional que las convertiría en más atractivas para nuestros investigadores y evaluadores. De no romperse éste círculo vicioso, las revistas nacionales poco a poco y de forma irremediable se verán reducidas a publicar estudios o pedazos de investigación, no publicables en las revistas internacionales del CI o tendrán que especializarse en publicar artículos de interés exclusivamente 'local' o 'regional'; calificativos que suelen enunciarse con un fuerte cariz de folklorismo y no de relevancia científica. De hecho, basándonos en lo acontecido durante los últimos lustros a escala mundial, nuestras revistas y las de otros países en vías de desarrollo parecen estar destinadas a desempeñar un papel secundario en el avance del conocimiento científico o de plano tienden a desaparecer.

A pesar de la enorme importancia que el Citation Index y el Factor de Impacto del ISI tienen en la ciencia, el conocimiento de su origen y características esenciales por parte de la comunidad de investigadores suele ser alarmantemente superficial. No falta el despistado o novato colega que hace poco se enteró de que el ISI no es, ni nunca ha sido una institución académica, sino una empresa privada con declarados fines de lucro que por definición debe anteponer los intereses de sus accionistas e inversionistas a los de la comunidad científica, a quien provee sus valiosos servicios y productos a un alto precio. Los numerosos empelados de ISI, profesionales en el manejo de información y bases de datos, en realidad no hacen investigación y por tanto la común interpretación de Institute como 'instituto académico' es errónea. Además, la letra 'S' en ISI se refiere al tipo de información que maneja la compañía y no al tipo de análisis que hacen de ella. De hecho, sus criterios y métodos de análisis no son muy distintos a los empleados en la elaboración de las listas de best sellers que hacen las empresas que venden libros, o de los top 10 (éxitos) del momento de las radiodifusoras y tiendas de música. El ISI recaba información de todos los artículos publicados por las revistas incluidas en su CI, generando una gigantesca base de datos de la que se obtienen estadísticas sobre el número de veces que los artículos y las revistas son citados. Quienes promueven este tipo de análisis, aseguran que el proceso de evaluación basado en tales estadísticas es objetivo. Sin embargo, es la interpretación de las estadísticas lo que debe regir en la evaluación y dicha interpretación descansa sobre el significado de la citación, es decir sobre las razones que motivaron al autor (o autores) a citar un determinado artículo o publicación, lo cual es bastante subjetivo (Smith 1981), tanto o más que la evaluación de nuestro trabajo por expertos en el tema (i.e. revisión por pares). Debido a que la subjetividad es menos aparente en los análisis cuantitativos de citación, es imprescindible comprender las características y entender las limitaciones de los indicadores numéricos derivados de dichos análisis (Adler et al. 2008). De lo contrario provocaremos consecuencias indeseables en las revistas, proyectos, disciplinas e instituciones científicas que están siendo tasadas mediante tales indicadores. Al respecto vale la pena transcribir lo dicho por el crítico y poeta Gabriel Zaid (2009) en su libro más reciente, pues ilustra nítidamente parte del problema:

"...La creación del CI provocó una revolución... Los refinados métodos estadísticos del beisbol, que permiten medir y comparar proezas deportivas, se aplicaron a la ciencia. El ISI, creado por Garfield en 1964, vende esta información y ha tenido una influencia semejante al comité organizador de las competencias olímpicas. Es un centro mundial de referencia y contabilidad que, por el hecho de existir, induce cambios en la forma de competir. Tanto los avances milagrosos como los refritos mediocres se miden hoy por lo que tienen en común: el número de citas que generan".

En esta contribución analizo los principales problemas y limitantes del CI y del FI–ISI como indicadores de calidad científica, que han sido señalados por numerosos investigadores. Relataré algunas polémicas relacionadas con el uso excesivo del FI–ISI en las evaluaciones y haré una breve presentación de alternativas recientes que podrían complementarlo o incluso sustituirlo. Para concluir, hago algunas reflexiones sobre el sistema de evaluación actual y describo los pasos que considero necesarios para romper el círculo vicioso en el que están atrapadas nuestras revistas. Mi principal interés es contribuir al debate que debería estarse dando más activamente en nuestras instituciones y comunidades científicas acerca de los indicadores empleados actualmente en nuestras evaluaciones, con el fin de mejorarlos. Asimismo, espero estimular la discusión de las profundas consecuencias que el uso de tales indicadores tiene sobre el desarrollo científico nacional y el futuro de nuestras revistas.

EL FACTOR DE IMPACTO (FI) Y EL CITATION INDEX (CI) DE ISI

El factor de impacto de una revista es un indicador numérico creado por el ISI, que se da a conocer cada año en el Journal of Citation Reports (JCR) durante el verano y donde se reporta el factor de impacto (FI–ISI) del año inmediato anterior de las revistas indizadas en el CI. Esta información se despliega hoy día en el Web of Knowledge (WoK) de ISI–Thomson Reuters, servicio de internet al que hay que estar suscrito para poder usarlo y cuyo costo no es accesible para la gran mayoría de universidades y centros de investigación mexicanos y latinoamericanos. El FI–ISI es una medida de la frecuencia con la cual el 'artículo promedio' de una revista ha sido citado en un periodo definido. El FI–ISI de una revista se obtiene al dividir el número de citaciones hechas en cierto año a los documentos publicados en los dos años anteriores por la revista, entre el número de documentos publicados por dicha revista en los mismos dos años. Según Thomson Reuters (2008a) un FI–ISI de 5.0 significa que en 'promedio', los artículos de dicha revista publicados dentro de los últimos tres años han sido citados cinco veces. Vale la pena resaltar que solamente se contabilizan las citas recibidas en el universo de revistas indizadas en el CI de la misma compañía y que actualmente incluye a poco más de 8 mil títulos. Excluidos quedan todos los libros y capítulos de libro científicos, así como revistas de excelente calidad que por diversos motivos –examinados adelante– no están indizadas en la base de datos administrada por ISI–Thomson Reuters.

El FI–ISI fue propuesto por primera vez en 1955 por Eugene Garfield, fundador y socio de la compañía ISI, quien además elaboró el primer CIen 1961 (Garfield 1955, 1963, 2006). Garfield y colaboradores fueron pioneros en la computarización y elaboración de bases de datos relacionales, de las denominadas fuentes secundarias o revistas de resúmenes (abstracts). Además se adelantaron a sus competidores al generar abstracts multidisciplinarios que incluían muchos campos o temas, principalmente de las ciencias naturales y posteriormente también de las ciencias sociales. Este producto denominado Current Contents, se convirtió en uno de los mayores éxitos comerciales de ISI y un gran apoyo para la ciencia; ya que como su nombre lo indica, ponía al investigador que tuviera acceso a dicho producto al día de lo que se estaba publicando sobre su tema y la institución se beneficiaba al adquirir un solo producto que cubría una gran cantidad de disciplinas. El ISI incorporó en su base de datos las referencias completas de todos los documentos publicados por la revista, es decir lo único que no incluía era el contenido mismo del artículo (texto, tablas y figuras). Gracias al frecuente contacto con los bibliotecarios de las universidades e institutos más prestigiosos de los EEUU, debido a las ventas del Current Contents, Garfield detectó que dichas instituciones sufrían año con año para decidir cuáles revistas renovar, cancelar o adquirir, ya que el presupuesto con el que contaban no podía cubrir el total de revistas que todos los investigadores de la institución demandaban. La inclusión de las referencias completas en la base de datos del ISI, le permitió a Garfield y colaboradores analizar y comparar las frecuencias de citación de las diferentes revistas para jerarquizarlas, mediante la fórmula del FI–ISI. Nace así el Jounal of Citation Reports, como un apéndice del Citation Index y sus primeros clientes fueron los responsables de decidir la lista de revistas que adquiría cada año la institución.

En realidad el CI fue concebido para buscar información, literalmente para rastrear artículos mediante las referencias, como una forma alternativa y complementaria a las consultas bibliográficas tradicionales basadas en índices ordenados por autor o por sujeto (i.e. por concepto o tema). Para ello, es indispensable contar primero con un artículo relevante que será el punto de inicio en la búsqueda. La pregunta fundamental que contesta el CI es ¿qué ha pasado desde la publicación de éste artículo en la literatura científica? En particular, ¿dónde y quiénes han citado dicho artículo? De esta forma se pueden construir extensas y especializadas bibliografías que difícilmente se hubieran logrado por otros métodos (Garfield 1955, 1963). No escapó a la atención de Garfield que el CI podría aplicarse a la evaluación de los científicos y su trabajo, sin embargo, él mismo puntualizó de manera enfática que esta aplicación solamente será legítima en la medida que uno empleé el CI como una herramienta de búsqueda, que facilita la localización de las opiniones de otros científicos sobre las publicaciones de un investigador. La idea del CI científico la tomó Garfield del abogado norteamericano Frank Shepard, quien en 1873 publicó el primer CI legal, en el que se enlistan los casos de cortes de los EEUU así como quién los cita, permitiendo reconstruir la historia de casos y estatutos determinados. Este índice llamado Shepards Citations, sigue siendo ampliamente utilizado por abogados para consultar los juicios y veredictos que preceden al caso que se esté litigando. Esta dependencia en los antecedentes o precedentes es también crucial para el avance de la ciencia y fue uno de los principales motivos que impulsaron a Garfield a elaborar el CI científico (Garfield op. cit.). Hasta donde tengo entendido, ningún abogado ni despacho de abogados emplean al CI legal (Shepard's Citations) como indicador de la calidad de su trabajo profesional; como contrapunto, llama poderosamente la atención que la comunidad científica y sus instituciones hayan adoptado al CI científico y sus derivados (i.e. FI–ISI) como indicadores de calidad.

Para determinar que tan sólido es el generalizado supuesto de que la inclusión en el CI es indicativa de una alta calidad académica, es muy importante conocer el proceso de selección y los criterios empleados para conformar el primer CI científico y sus ediciones subsecuentes, es decir hay que tener en cuenta el origen y evolución del CI del ISI. El primer CI fue el del año 1961 e incluía 613 revistas de diversas disciplinas científicas publicadas en 28 países. Este primer CI científico se publicó en 5 tomos que incluyeron 1.4 millones de citas a artículos publicados en cualquier fecha hasta 1961. Esta colosal cantidad de referencias pertenecían a cerca de 20 mil revistas que fueron citadas por las 613 del primer CI y ésta base de datos fue empleada por ISI para detectar las revistas que merecían incluirse en ediciones futuras del CI (Garfield 1963). En la década de los '90s el CI incluía 4,400 revistas (Garfield 1990) de un total de 70 mil publicadas mundialmente (Gibbs 1995). Para el año 2000 el acervo incluía alrededor de 5,700 revistas, de las cuales poco menos de 1,700 correspondían a las ciencias sociales (Adam 2002). En 2008 el CI incluyó en total 8,578 revistas para cada una de las cuales se proporcionó su FI–ISI en el JCR (6,598 revistas en el Science CI y 1,980 en el Social Sciences CI; ISI–WoK–JCR 2009). Aunque el ISI incluye entre sus criterios de selección de revistas, aspectos de calidad editorial y académica (Garfield 1979, 1990; Thomson Reuters 2009a), éstos pasan a segundo plano ante el número de veces que la revista es citada en el índice al cual pretende ingresar y para ello también se da preferencia a revistas cuyos editores tienen un alto número de citas en el CI. Este criterio auto–contenido y circular así como el 'efecto fundador' del CI inicial sobre ediciones subsecuentes, han tenido importantes consecuencias en el desarrollo científico internacional que requieren estudiarse más a fondo. Lo anterior, ha afectado diferencial y detrimentalmente a las revistas científicas editadas fuera de EEUU y Europa Occidental y aún más a las que no publican el total de sus documentos en inglés (Gibbs 1995; Cetto & Alonso 1999; Klein & Chiang 2004; Archambault & Lariviére 2009). Garfield se esmeró en satisfacer las necesidades de las bibliotecas científicas más grandes de los EEUU; sus relaciones y dependencia económica con ellas moldearon sus decisiones sobre el acervo del CI y la fórmula del FI–ISI, en vez de seleccionar a las mejores revistas sin importar el país de origen y lenguaje. Como consecuencia, el JCR durante las últimas décadas ha remodelado la ciencia internacional a favor de EEUU y el idioma inglés (Archambault & Lariviére 2009), repercutiendo desfavorablemente en la educación y difusión del conocimiento en nuestra región e idioma.

No creo que exista mucho desacuerdo en cuanto a los méritos y calidad de las revistas que forman parte del CI, el problema surge con aquellas que no han sido aceptadas en dicho índice. Contrario a lo que muchos científicos suponen, ésta crucial decisión no es tomada por expertos en el tema que basaron su veredicto en el análisis minucioso y académico de los documentos que publica la revista. La decisión es tomada por empleados del ISI y asesores editoriales de la compañía (Garfield 1979, 1990; Klein & Chiang 2004), cuyos nombres y currícula no están disponibles a la comunidad científica, y de quienes lo único que podemos asegurar (al menos para el caso de los empleados del ISI), es que no son investigadores activos expertos en el tema de la revista que solicita su inclusión en el CI. A pesar de numerosas y no tan recientes advertencias sobre los peligros de que en nuestro país se llegara a instaurar el despiadado y cuestionado sistema norteamericano del "publica o perece" (Cereijido 1994), no solamente ha llegado, sino que está inmerso hasta el tuétano en nuestros sistemas de evaluación, pero con el agravante de "publica en las revistas indicadas o perece". El problema es que la decisión de cuáles son las revistas indicadas no descansa en institución académica alguna, ni en un sistema de evaluación bien estructurado ni consensado entre los principales interesados, es decir; los científicos, sino en las decisiones nada transparentes de una empresa privada que durante las últimas cinco décadas se ha erigido en un poderoso monopolio.

LIMITANTES DEL FI–ISI COMO MÉTRICA DE EVALUACIÓN

Las numerosas críticas que se han hecho al empleo del FI–ISI en la evaluación científica, en general mencionan dos aspectos que hay que tomar en cuenta; el primero se refiere a problemas intrínsecos al cálculo o fórmula del indicador y el segundo a usos indebidos del mismo por los evaluadores. Expondré en ese orden las principales críticas que diferentes científicos han hecho sobre el uso del FI–ISI como indicador de calidad de las revistas, artículos, investigadores e incluso instituciones, describiendo las que considero más relevantes.

PROBLEMAS CON EL INDICADOR DE IMPACTO (FI–ISI)

Los creadores del FI–ISI dicen que este indicador representa un promedio. Sin embargo, ni siquiera se preocuparon por describir la distribución de frecuencias de los datos supuestamente representados por dicho promedio. Los análisis de la frecuencia de citación de los artículos que publica una determinada revista, de prácticamente cualquier disciplina, en cualquier periodo posterior a su publicación (a los 2, 5, 10 años, etc.), revelan que la distribución de frecuencia de las 'citas recibidas vs. tiempo', es de una "J" invertida muy asimétrica (Fig. 1). Muchos artículos no reciben cita alguna o reciben un número muy inferior al FI–ISI de la revista, mientras que muy pocos artículos reciben una enorme cantidad de citas y contribuyen de manera desproporcionada al valor del FI–ISI (Seglen 1997; Colquhoun 2003; Adler et al. 2008). Además, el supuesto 'promedio' es en realidad un cociente que no puede darnos información alguna sobre la dispersión de los datos y por tanto su uso con fines comparativos es incorrecto, ya que contando tan solo con este indicador es imposible establecer si el impacto (medido como frecuencia de citación) de una determinada revista es significativamente diferente al de otra revista.

Un artículo o documento de buena calidad recibirá un número ascendente de citas dentro de los dos años posteriores a su publicación, no mucho tiempo después alcanzará la cima de citación, para posteriormente descender con el paso del tiempo. Esta curva de citación 'idealizada' no tiene la misma forma en las distintas disciplinas o campos de la ciencia (Seglen 1997; Amin & Mabe 2003; Adler et al. 2008), lo cual imposibilita el uso del FI–ISI entre revistas de diferentes campos científicos (Fig. 2a). Garfield (2003) se decidió por el lapso de dos años en su fórmula del FI–ISI, con base en las disciplinas de biología molecular y bioquímica para las que él mismo determinó que 25% de las referencias incluidas en sus artículos correspondían al año de publicación y los dos previos. El fundador y chairman emeritus de ISI reconoce que al momento de crear su fórmula los investigadores de las disciplinas mencionadas eran los mejores clientes de su Current Contents, y por tanto de quienes mejor conocía sus necesidades. Los editores de la muy prestigiada y multidisciplinaria revista Nature señalan que las tasas de citación de sus artículos varían enormemente entre disciplinas. En 2004 el FI–ISI de Nature fue de 32.2, el 89% de las citas que contribuyeron con dicho valor fueron generadas por tan solo 25% de los cerca de 1,800 artículos publicados en 2002 y 2003 (Nature 2005). Muchos de los artículos sobre inmunología publicados en 2003 por Nature, habían recibido al 2005 entre 50 y 200 citas, una importante proporción de los que tratan sobre cáncer y biología molecular y celular tenían entre 50 y 150 citas, mientras que los de física, paleontología y climatología, típicamente habían recibido menos de 50 citas. Lo anterior obviamente obedece a diferencias en la dinámica de citación de las disciplinas y no a su calidad científica.

La curva de citación de los artículos originales y la de las revisiones son también muy diferentes (Fig. 2b). Las revisiones atraen un número considerablemente mayor de citas durante los primeros años, no porque tengan mayor calidad, sino porque son espléndidamente útiles para la elaboración y fundamentación de la introducción y discusión de los artículos originales. Las revistas que de manera exclusiva publican revisiones aparecen consistentemente entre las de mayor FI–ISI de su especialidad, dejando en clara desventaja a las revistas del mismo tema que únicamente publican artículos originales, así como a las que incluyen muy pocas revisiones al año. Consecuentemente, algunas revistas han aumentado la proporción de revisiones que publican cada año, maximizando así la posibilidad de incluir al menos una que sea ampliamente citada durante los próximos dos años. Los ensayos cortos del tipo short communications sobre temas candentes, suelen alcanzar muchas citas durante los primeros dos años y es por ello que en la actualidad son favorecidos por algunas revistas (Amin & Mabe 2003; Monastersky 2005; PLoS Medicine Eds. 2006; Rossner et al. 2007).

A las limitaciones señaladas en párrafos precedentes hay que agregar que la fórmula del FI–ISI, es decir el cociente, no está exento de problemas. Como en todo cociente, es esencial la definición rigurosa de los ítems contados arriba y debajo de la fracción, lo que no sucede con el FI–ISI (Seglen 1997; Amin & Mabe 2003; Adler et al. 2008). El denominador solamente incluye documentos definidos como 'citables' por ISI: artículos, revisiones y ensayos cortos o documentos similares, que son los que normalmente se citan en las referencias de los artículos. El numerador se calcula mediante procesos automatizados que buscan y cuentan entre las referencias de todos los documentos publicados por las miles de revistas del CI, las veces que una determinada revista fue citada. La información de cada revista (volumen y páginas) incluida en las referencias, no permite distinguir si se trata de un documento 'citable' o de una revisión de libro, nota editorial, carta al editor u otro tipo de documento 'no citable' (sensu ISI), que suelen publicar varias revistas. Por lo tanto, algunos documentos que se contabilizan en el numerador, no son contados en el denominador y esto puede ocasionar fuertes sesgos (Adam 2002; Rossner et al. 2007). Las revistas que solo publican documentos 'citables', tales como las que incluyen solo artículos originales, así como aquellas que incluyen un mínimo de documentos 'no citables', quedan en clara desventaja con las revistas que sí incluyen muchos documentos de este tipo. Aunque en circunstancias normales lo anterior difícilmente sería aprovechado por las revistas científicas, la feroz competencia desatada por el mismo JCR sería precisamente el detonante para que los interesados en la revista manipulen este cociente con el objeto de incrementar su FI–ISI (Monastersky 2005; PLoS Medicine Eds. 2006; Rossner et al. 2007; Archambault & Lariviére 2009). Por ejemplo, los editores de la revista podrían turnarse para publicar anualmente una sinopsis o comentario editorial acerca del contenido reciente de su revista, incluyendo en las referencias de este documento 'no–citable' (sensu ISI) numerosos artículos publicados en su propia revista durante los dos años anteriores.

El denominador de la fórmula del FI–ISI fue introducido para poder comparar revistas que difieren en el número de artículos que publican al año. Garfield (2006) menciona como ejemplo de lo bien que funciona su fórmula, el hecho de que en el año 2004 la revista con el mayor FI–ISI fue Annual Review of Immunology con FI = 52.4, a pesar de que solo publica alrededor de 30 artículos por año, mientras que la revista New England Journal of Medicine que anualmente publica unos 300 artículos, obtuvo el segundo lugar con un FI = 38.6. Las revistas Nature y Science tuvieron ese año un FI de 32.2 y 31.9, respectivamente y cada una de ellas publica más de 800 artículos al año. Así demostró que revistas pequeñas sí alcanzan valores altos de FI–ISI. Sin embargo, la demostración anterior es un tanto simplista y representa tan solo una fotografía que no revela la historia completa. En un análisis de la variación temporal del FI–ISI de cuatro mil revistas durante 12 años (1987–1998), Amin & Mabe (2003) encontraron que la oscilación anual del FI–ISI en revistas que publican menos de 35 artículos por año, es enorme (mayor al ± 40% anual) en comparación con revistas que publican más de 150 artículos al año (± 15%). La amplia variación en el FI–ISI de las revistas que publican pocos artículos, se debe exclusivamente al azar y no a inconsistencias en la calidad de sus contenidos, ya que estas revistas tienen menores probabilidades de incluir todos los años, al menos un artículo ampliamente citado durante los dos años posteriores a su publicación, en comparación con las que publican mucho más artículos anualmente (Amin & Mabe 2003; Adler et al. 2008).

Ejemplos de fluctuaciones temporales en el FI–ISI

En la categoría de 'Ecología' en la que el JCR agrupa a 116 revistas, la que alcanzó el mayor FI–ISI en 2007 fue el Bulletin of the American Museum of Natural History (FI= 16.385). Esta revista que desde 1881 publica monografías de zoología, paleontología y geología, suele incluir menos de 30 artículos por año (típicamente <15), y durante los últimos diez años registró valores de FI–ISI que oscilaron entre 1.0 y 3.0 (Fig. 3). Tan solo dos años antes (en 2005) su FI–ISI fue de 1.019 ocupando el puesto 69° en la categoría de 'Ecología'. El descomunal salto en 2007 se debe principalmente a uno solo de sus artículos publicado en 2006, en el que sus 19 autores proponen un nuevo arreglo del árbol filogenético de los anfibios, basado en análisis moleculares (secuenciaciones de ADN) y métodos cladísticos (Frost et al. 2006). Este artículo fue citado 121 veces en 2007, contribuyendo con 57% del valor del FI–ISI de ese año. La revista publicó 6 artículos en 2005 y 7 en 2006, por lo que el denominador de la fórmula del FI–ISI fue muy pequeño para el 2007. En 2008 el FI–ISI de esta revista (16.692) volvió a ser el más alto de 'Ecología' (ISI–WoK–JCR 2009), gracias a que el artículo mencionado siguió siendo muy citado y la revista solo publicó 6 artículos en 2007. Aunque el artículo de Frost et al. (2006) siga recibiendo más citas, éstas ya no serán contabilizadas para el FI–ISI del 2009, por lo que es casi seguro que el próximo año el FI de la revista descenderá a los valores que tenía antes del 2007, a menos que alguno de los artículos del 2007 o del 2008 reciban durante 2009 tantas citas como las recibidas por el de Frost et al. (2006). Las revistas TREE y Annual Review of Ecology, Evolution & Systematics han ocupado típicamente el I°y 2° lugar de la categoría 'Ecología' en la última década, periodo durante el cual han mostrado además un notable incremento en sus respectivos FI–ISI (Fig. 3), debido al auge reciente de la disciplina. Dicho auge se refleja en el aumento del número de documentos que anualmente publican las revistas especializadas en artículos originales de ecología, mismas que aumentaron en 30 a 40% o más el número de artículos anuales con respecto a lo que publicaban hace diez años. Ello no se tradujo en un aumento equivalente del FI–ISI de dichas revistas, debido al concurrente aumento del denominador en la fórmula de dicho indicador, como lo muestran las revistas Ecology y Journal of Animal Ecology (Fig. 3), situación que también se presentó con otras revistas que solo publican artículos originales del tema, tales como Journal of Ecology, Oikos, Oecologia, Ecological Applications, entre otras. Mientras tanto, las revistas especializadas en revisiones o en temas candentes de ecología no aumentaron su número de documentos anuales (denominador de la fórmula del FI–ISI) durante la última década o el aumento fue mínimo (<5%; en Ann. Rev. Ecol. y en TREE), capitalizando así el auge de la disciplina con aumento notable en sus respectivos FI–ISI. Lo anterior, demuestra que la variación temporal o constancia en el valor del FI–ISI de una determinada revista no se debe necesariamente al aumento, disminución o estancamiento de la calidad de los documentos que publica, sino a muchos otros factores de índole editorial o de popularidad del tema, ante los cuales el FI–ISIes extremadamente sensible.

DISTORSIONES EN EL EMPLEO DEL FI–ISI

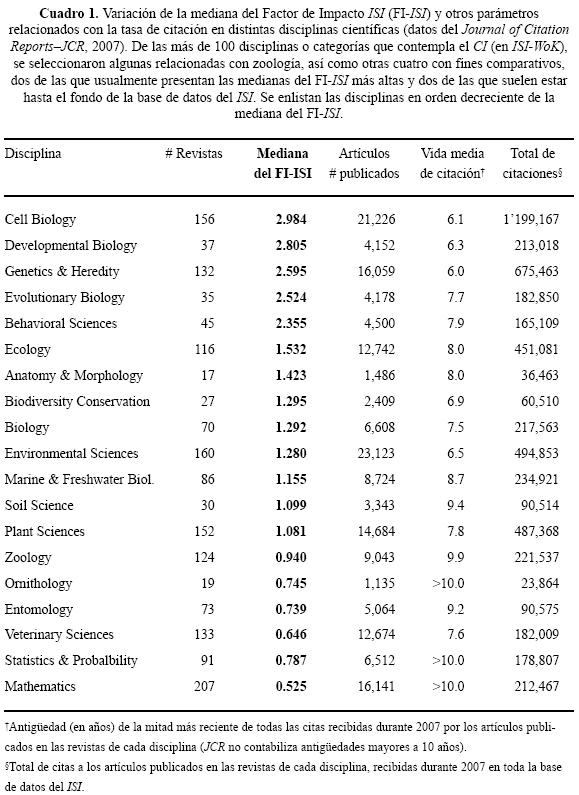

El empleo del FI–ISI sin contemplación alguna a las diferencias entre disciplinas nos lleva al absurdo de concluir que los matemáticos publican artículos de menor calidad que los biólogos celulares o moleculares. En el JCR del año 2007, las 156 revistas incluidas por ISI en la categoría 'Biología Celular' en comparación con las 207 revistas de 'Matemáticas', presentaron medianas del FI–ISImuy diferentes: 2.98 vs. 0.52, respectivamente. La cantidad de artículos publicados en cada especialidad (21,226 vs. 16,141), no explica cabalmente la enorme diferencia en las medianas. Pero sí lo hace el total de citas recibidas durante 2007 por las revistas de cada disciplina, que en el primer caso superó el millón de citas contra solo 212,467 en el segundo (Cuadro 1). Además, la antigüedad de las citas medida como los años requeridos para incluir a la mitad más reciente de todas las citas recibidas (vida media de citación) en cada una de estas disciplinas es muy distinta, siendo de 6.1 años en 'Biología Celular' y mayor a 10 años en 'Matemáticas' (JCR no calcula antigüedades mayores a 10 años). Estos factores que no están relacionados con la calidad de la ciencia que publican las diferentes disciplinas, sino con diferentes dinámicas de citación, son los que explican las tremendas diferencias en FI–ISI entre los campos y previenen cualquier comparación entre ellos.

Lo anterior no solo sucede entre campos de investigación disímiles, sino también al interior de un mismo campo entre sus diferentes sub–disciplinas. Por ejemplo, en una institución de investigación dedicada a la ecología, un ornitólogo que publicó en 2007 en una revista con FI = 1.0, podría ser alentado a incrementar el impacto y calidad de sus publicaciones, al mismo tiempo que un biólogo evolutivo que publicó en una revista con FI = 2.0, es felicitado por sus directivos. Sin embargo, la revista en la que publicó el ornitólogo está por encima de la mediana de las 19 revistas del JCR especializadas en 'Ornitología', que fue de 0.75 (Cuadro 1); existiendo solamente 6 revistas con un FI–ISI mayor a 1.0 en esta especialidad. Mientras que la mediana de las 35 revistas de 'Biología Evolutiva' del JCR es de 2.52, existiendo 22 revistas del tema (63%) que superan a la que publicó el artículo del biólogo evolutivo (Fig. 4), quien realmente no merecía la felicitación pues no publicó en las revistas de mayor impacto de su especialidad. Las diferencias del FI–ISI entre las revistas de 'Ornitología' y las de 'Biología Evolutiva' también se explican por diferencias en los patrones de citación de cada sub–disciplina (ca.24 mil vs. ca.183 mil citas recibidas y vida media de citación >10 vs. <8 años, respectivamente), y no por la calidad de sus artículos, y por tanto, el ornitólogo en cuestión bien merecería al menos una disculpa.

Uno de los análisis más lúcidos y contundentes sobre la problemática de emplear estadísticas de citación en la evaluación científica es el publicado recientemente por Adler, Ewing & Taylor (2008) en un reporte comisionado por tres organizaciones internacionales de matemáticas (IMU: Unión Matemática Internacional, por sus siglas en inglés; IMS: Instituto de Matemáticas y Estadística; y el ICIAM: Consejo Internacional de Matemáticas Industrial y Aplicada), quienes integraron un comité conjunto denominado: 'La evaluación cuantitativa de la investigación', presidido por los autores del reporte. Bajo las prácticas de evaluación actuales, muchas instituciones otorgan mayor valor a los artículos publicados en revistas con mayor FI–ISI, porque suponen recibirán más citas, sin embargo, los autores del reporte demuestran que ello difícilmente es cierto. Estos matemáticos argumentan que la pregunta ¿el artículo típico que publica una revista "X" tendrá un impacto distinto al que publica "Y"? no puede contestarse comparando promedios, sino mediante un análisis probabilístico básico. Como ejemplo, comparan tres revistas de matemáticas muy conocidas y que difieren en su FI: 0.43, 0.85 y 2.63 en 2005. Con base en la distribución de frecuencias real de las citas recibidas por los artículos de cada revista entre los años 2000 y 2004, determinaron cuántas veces un artículo seleccionado al azar de la revista con menor impacto (FI= 0.43) recibió el mismo o mayor número de citas que otro artículo seleccionado al azar de la revista con el doble de impacto (FI= 0.85) y encontraron que ello sucedió en 62% de los casos. Al comparar la revista de menor impacto (FI= 0.43) con la de mucho mayor impacto (FI= 2.63), encontraron que lo anterior sucedió en 32% de los casos, es decir, que en ésta última comparación, un tercio de las veces estaríamos equivocados al afirmar que los artículos publicados por la revista con menor FI reciben menos citas que los que publica la revista con un FI seis veces mayor. Este enorme margen de error se debe a la muy asimétrica distribución de las frecuencias de citación de los artículos de cada revista. Adler y colaboradores (2008) concluyen que si bien no es correcto afirmar que el FI–ISI no provee información de los artículos individuales de la revista, dicha información es sorprendentemente vaga y puede ser dramáticamente engañosa, y sentencian: "emplear solamente el FI–ISI para juzgar a una revista, es como basarse exclusivamente en el peso corporal de un paciente para evaluar su estado de salud ".

La suposición de que los artículos publicados en revistas con alto FI–ISI serán más citados que los publicados en revistas con menor FI–ISI, tampoco se cumple para la obra de un mismo investigador. Seglen (1997) demostró lo anterior al analizar los patrones de citación de investigadores productivos, quienes tenían más de 40 artículos publicados en revistas indizadas en el CI con 5 o más años de haber sido publicados, encontrando que el número real de citas recibidas por año y el FI–ISI de la revista en donde se publicó el artículo, tenían una correlación pobre o de plano inexistente. Entonces, la cantidad de citas que recibe un artículo depende de atributos que no están relacionados con el FI–ISIde la revista en donde fue publicado, sino con su contenido o aportación. A pesar de lo anterior, el FI–ISI generalmente se emplea en la evaluación de investigadores como si los puntos en la gráfica de la Figura 5, estuvieran alineados directamente sobre la diagonal y ello no es cierto. Los proponentes y defensores del empleo del FI–ISI como métrica de evaluación, son usualmente víctimas de la clásica confusión entre 'causa y efecto', ya que como señala Seglen (1997) el número de veces que son citados los artículos que publica una revista es lo que da el FI–ISI a la misma y no al revés: ¡la revista no genera las citas al artículo! La Figura 5 muestra el caso hipotético (basado en datos de Seglen 1997) de dos investigadores muy productivos que difieren en el impacto de sus publicaciones. El investigador 'A' ha publicado en revistas de mayor impacto (FI–ISI) y sus artículos han recibido más citas en comparación con el investigador 'B'; sin embargo, ello no significa que el primero sea mejor investigador que el segundo, ya que 'A' podría ser un inmunólogo y 'B' un geólogo, cada uno con enorme reputación entre sus respectivos colegas. Incluso al interior de un mismo campo, por ejemplo si ambos investigadores son zoólogos, tampoco podríamos afirmar que 'A' es mejor investigador que 'B' con base en la información de la esta figura, ya que 'A' podría ser experto en primates y 'B' en lombrices de tierra. Este último bien podría ser mejor investigador y escribir artículos de más calidad que el primatólogo, aunque los números que actualmente se emplean en nuestras evaluaciones digan lo contrario. La popularidad del tema de investigación también influye sobre el número de citas recibidas y por tanto en el valor de FI–ISI que alcanzan las revistas en las que publica cada especialista. Cuando sea necesario decidir quién de nuestros hipotéticos investigadores merece más crédito, lo mejor que podemos hacer y de hecho lo único sensato, es leer los documentos que produjo cada uno, no todos sino los 2 ó 3 que cada quien considere como sus contribuciones más relevantes.

Varias instituciones de investigación han desarrollado fórmulas o algoritmos cuantitativos basados en el FI–ISI de las revistas en las que publican sus investigadores, particularmente para determinar el mérito de su producción reciente. Con base en el puntaje alcanzado se decide si es tiempo de promover al interesado o quién merece recibir cierto apoyo presupuestal limitado. Algunas instituciones incluso emplean estos puntajes para asignar presupuestos anuales diferenciados a sus investigadores. Aspectos que tal vez no generen demasiados problemas en instituciones en las que todo su personal publica en revistas pertenecientes a una sola disciplina, pero que en instituciones más diversas resulta devastador, particularmente para aquellos científicos cuyo tema de investigación no se distingue por altas tasas de citación. El uso incorrecto del FI–ISI en la evaluación de investigadores o grupos de investigadores ya ha tenido consecuencias negativas sobre ciertas disciplinas o sub–disciplinas científicas, debido a que algunas instituciones han llegado a considerarlas como de menor calidad o relevancia con base en sus bajos valores de FI–ISI (Carvalho et al. 2008; Archambault & Lariviére 2009), error que por supuesto no podemos colgarle a Garfield ni a su compañía, sino a nuestra manía y la de los evaluadores de querer reducir algo tan complejo como la calidad y relevancia científica de una revista, artículo o investigador, a un simple número. La misma compañía Thomson Reuters ha insistido en no emplear el FI–ISI en comparaciones similares a las descritas anteriormente, señalando como regla básica para el uso correcto de su indicador, el que no se comparen 'peras con manzanas' (Pendlebury 2008), para lo cual es indispensable reconocer las diferencias en la dinámica de citación entre disciplinas y sub–disciplinas. Además, advierten que los análisis de citación deben complementar a la evaluación o revisión por pares, nunca reemplazarla. Al respecto, vale la pena reproducir lo dicho por Jim Testa, Director de Desarrollo Editorial de Thomson–Reuters en una entrevista que le hizo su propia compañía en junio del 2008 y que está desplegada en su portal de internet (Thomson Reuters 2008b): "El uso del FI–ISI para evaluar el trabajo de un investigador (en vez de evaluar la revista) es el error o mal–uso más común actualmente. Algunas instituciones 'suponen' una relación directa entre el trabajo de un investigador y las revistas en las que está publicando. Desafortunadamente no hay una correlación 1:1 entre dichas variables. Decir que debido a que un investigador está publicando en cierta revista, él o ella es más influyente o merece más crédito, no es necesariamente cierto. Existen muchas otras variables que deben ser consideradas".

A partir del año 2005, el portal de internet del JCR incluye herramientas muy útiles que permiten analizar las diferencias en los patrones de citación entre distintas categorías o disciplinas científicas (ver Cuadro 1), siempre y cuando el usuario esté adscrito a una institución que pueda pagar el oneroso costo del servicio incluido en el ISI–WoK de Thomson Reuters. Gracias a estas herramientas ahora es posible obtener diversas variables o parámetros que permiten determinar fácilmente cuáles revistas y especialidades sería inválido comparar mediante su FI–ISI. La preocupación de ésta compañía por el uso indebido de su factor de impacto, queda manifiesta en documentos recientes que dan instrucciones precisas sobre cómo emplear no solo este indicador, sino también sus más recientes indicadores bibliométricos (basados en estadísticas de citación), que ellos mismos recomiendan como complemento obligado al FI–ISI (ver su foro de discusión de internet: Preserving the integrity of the Impact Factor; Thomson 2008a). En particular el documento que Thomson Reuters produjo recientemente: Using bibliometrics for evaluating research (Pendlebury 2008), debería ser lectura obligada para todo aquel que forme parte de algún comité de evaluación, al que habría que agregar la lectura obligada del reporte de los matemáticos Adler, Ewing & Taylor (2008). Estos dos últimos documentos describen sintéticamente las principales limitantes del empleo de estadísticas de citación en la evaluación científica y considero de fundamental importancia que todo evaluador esté al tanto de sus recomendaciones, pero además como sujeto de evaluación, todo investigador debería también estar al tanto de ellas.

REPERCUSIONES POLÉMICAS POR EL ABUSO DEL FI–ISI Y DEL CI

Desde la década de los noventas varios investigadores y editores de revistas latinoamericanas han alertado sobre los peligros que para la ciencia, particularmente la de la región pero también para la del mundo, representa el uso excesivo y casi siempre exclusivo del FI–ISI como indicador de calidad científica en las evaluaciones de nuestras revistas, investigadores e instituciones (ver contribuciones de más de 40 autores en Cetto & Alonso 1999). Numerosos investigadores latinoamericanos han señalado sentirse atrapados en un círculo vicioso de omisión, ocasionado por barreras a la publicación de ciencia de calidad producida en la región, que no alcanza la visibilidad internacional que merece, dando lugar a lo que Gibbs (1995) denominó la 'ciencia oculta'. La problemática ha sido abordada en detalle en diversos medios latinoamericanos que sería demasiado largo enumerar aquí, sin embargo, quisiera destacar para México las reflexiones que hace Cereijido (2005) sobre la evaluación de los investigadores y su propuesta de emplear los indicadores numéricos como herramientas de diagnóstico, no de decisión o 'fiel de la balanza', así como la relatoría que hace Ibarrola (2004) de una reunión celebrada en el CINVESTAV con investigadores de diversas instituciones en donde es patente la gran preocupación sobre el tema y un descontento generalizado sobre los métodos de evaluación vigentes, particularmente con los indicadores de desempeño empleados. Esta situación ocurre también en la UNAM, como lo demuestran las entrevistas que Díaz–Barriga (1996) hizo a la comunidad de investigadores de nuestra máxima casa de estudios.

Por supuesto que la polémica no se restringe a nuestra región. Los autores y editores de revistas de países desarrollados, indizadas en el CI y especializadas en campos científicos emergentes o en proceso de consolidación, o de campos que cuentan con pocas revistas, han alertado también sobre la enorme desventaja en que se encuentran dichas revistas frente a las más generalistas que incluyen mayor diversidad de temas y alcanzan mayores FI–ISI (Statzner et al. 1995; Kokko & Sutherland 1999; Barot et al. 2007; Postma 2007). Si bien anteriormente, estos investigadores no hubieran dudado en enviar una contribución importante a la revista especializada que les garantizaría el arbitraje más estricto por parte de los investigadores que mejor conocen el campo, ahora se sienten forzados a enviar dicho artículo a las revistas generalistas con mayor FI–ISI que publican unos cuantos artículos sobre su tema, satisfaciendo así las exigencias de sus evaluadores, al mismo tiempo que privan a las revistas especializadas de los mejores trabajos de la disciplina.

En un comentario reciente publicado en la revista Nature por Lawrence (2003), investigador del Laboratorio de Biología Molecular de la Universidad de Cambridge, Inglaterra, quien ha editado la revista Development desde 1976 y ha sido miembro del consejo editorial de Cell y de EMBO Journal, hace un importante llamado a los autores, revisores y editores de las revistas científicas de todo el mundo para proteger la calidad de la investigación, misma que está siendo perjudicada por el excesivo énfasis que se le da al FI–ISI en nuestras evaluaciones. Muchos investigadores apoyaron lo dicho por Lawrence en comentarios posteriores publicados en la misma revista, que llevaban títulos tales como: "Retando la tiranía del factor de impacto" (Colquhoun 2003); "El sistema promueve deshonestidad" (Brookfield 2003); "Trastorno a la ciencia de países en vías de desarrollo" (Barcinski 2003); "El factor de impacto: una herramienta de la estéril cultura auditora" (Tuck 2003). En este debate un solo investigador; Lomnicki (2003), defendió el uso del FI–ISI en las evaluaciones, mencionando que este indicador premia y promueve la excelencia y aunque el sistema actual no sea amable, es efectivo. Además, opina que cualquier otro sistema sería menos benéfico particularmente para los países en vías de desarrollo. Para este último autor la evaluación de los científicos basada en el FI–ISI y otros índices numéricos es como la economía de mercado: "el sistema es erróneo e injusto pero otros sistemas serían mucho peores", siguiendo con su analogía menciona que "así como se han escrito miles de libros sobre los horrores del capitalismo, ahora hay artículos sobre los horrores de las evaluaciones derivadas de índices de citación". Lomnicki (2003) escribió esto antes de la crisis económica reciente y bien valdría la pena reflexionar acerca de si el inflado estatus del CI y del FI–ISI como indicadores de calidad científica, tendrán a la larga consecuencias similares a las que tuvieron los instrumentos financieros y estrategias bancarias que alimentaron la burbuja especulativa que precipitó la crisis económica global actual.

En algunas disciplinas particulares, la mayoría de sus investigadores están de acuerdo en que la popularidad del CI y del FI–ISI como indicadores de 'buena ciencia' no solo no les ayuda, sino que está perjudicando su trabajo; tal es el caso de la taxonomía sin la cual el estudio de la biodiversidad sería imposible (Valdecasas et al. 2000; Thorsten 2000, 2002; Van der Velde 2001; Carvahlo et al. , 2007, 2008; House of Lords UK 2008). Recientemente la Convención Internacional sobre Diversidad Biológica (CBD por sus siglas en inglés) produjo el documento: "Guía para la iniciativa taxonómica global" (CBD 2008), cuyo principal objetivo es el de establecer la estrategia para remover o superar el denominado "impedimento taxonómico"; que se refiere a la lenta descripción taxonómica de los seres vivos, debida entre otros factores a la monumental magnitud del problema (i.e. la enorme biodiversidad de nuestro planeta, y de nuestra región en particular) y a la alarmante escasez de taxónomos, de colecciones, de bibliotecas, de guías de campo y otros auxiliares en la identificación, así como al difícil acceso a la información taxonómica disponible; todo lo cual coincide con el aumento de la destrucción y alteración de los hábitats naturales por las actividades humanas. Aunque existe un fuerte e irresuelto debate acerca de los pasos a seguir para remover dicho impedimento, prácticamente todos coinciden en que los gobiernos mediante sus consejos nacionales de ciencia, así como las instituciones internacionales involucradas, deben urgente y sustancialmente incrementar el financiamiento a la investigación taxonómica. Mientras numerosos taxónomos insisten en señalar a los sistemas y criterios actuales de evaluación científica, como factores que han exacerbado el impedimento taxonómico, los académicos y funcionarios involucrados en las agencias que otorgan financiamiento a la investigación, niegan categóricamente haber perjudicado a alguna disciplina científica en particular, ya que en todo momento basaron sus decisiones en estándares e indicadores de calidad mundialmente reconocidos (i.e. el CIy el FI–ISI), asegurándose siempre de financiar a los mejores proyectos e investigadores. Es precisamente en este punto, de éste que parece un diálogo de sordos, donde radica el problema según los taxónomos, quienes coinciden en señalar que durante las últimas décadas, las facultades o departamentos de biología de universidades e institutos los han marginalizado, al dar preferencia particularmente a biólogos de las ciencias experimentales en boga quienes han acaparado los presupuestos y plazas nuevas (House of Lords UK 2008; Carvalho et al. 2007, 2008).

El portal de internet ScienceWatch.org del consorcio Thomson Reuters señaló en agosto del 2008 a la revista Zootaxa como una de las más destacadas en el campo Plant & Animal Science, debido a que ha tenido el incremento relativo más alto de su especialidad en citaciones (Thomson Reuters 2009b), ello a pesar que desde su ingreso al JCR en 2006 su FI–ISI ha sido inferior a 0.80. La revista fue fundada por zoólogos taxónomos en 2001 año en que publicó 20 artículos, actualmente publica poco más de mil artículos al año sobre la taxonomía de diversos grupos faunísticos. Desde su fundación hasta agosto de 2008 la revista ha publicado 8,141 nuevos taxa. El editor en jefe y fundador de Zootaxa, el zoólogo Zhi–Qiang Zhang, al ser interrogado por Thomson Reuters acerca de las razones por las que esta revista ha atraído tantos trabajos de tantos zoólogos en tan corta existencia, responde sin titubeos que su revista viene a llenar un vacío dejado, de hecho generado, por las revistas de corriente principal (i.e. las del JCR de ISI) que anteriormente publicaban trabajos taxonómicos. Particularmente durante los últimos 20 años, los editores de tales revistas aumentaron irracionalmente sus exigencias para la publicación de contribuciones taxonómicas en sus revistas, al mismo tiempo que perdieron interés en esta disciplina cuyos trabajos usualmente son muy poco citados o comienzan a ser citados hasta después de tres o más años de haberse publicado. Lamentablemente estos editores perdieron de vista la crucial y urgente necesidad de contar con descripciones básicas de los animales y su clasificación taxonómica. Dicha problemática motivó a numerosos zoólogos de varios países del mundo a diseñar una revista cuyas características fueran óptimas para el avance de la taxonomía, sin contemplaciones ni miramientos a los estándares o cánones internacionales que supuestamente definen a una revista como de 'corriente principal'. Entre las características originales de 'Zootaxa', destaca el hecho de que su comité editorial no está integrado por un reducido grupo de especialistas ampliamente citados en ISI, sino por un editor en jefe y literalmente cientos de editores repartidos por todo el mundo, quienes son reconocidos internacionalmente como especialistas en algún grupo taxonómico, y cuyo trabajo editorial hubiera sido imposible sin el Internet ni el correo electrónico (Zootaxa 2009). La revista es de acceso abierto (Open Access) y además no cobra derechos de página a sus autores, ni tiene un límite de páginas ni de artículos producidos al año, de hecho no publica una cantidad fija de números al año en fechas pre–establecidas. Como bien señala Zhi–Qiang, el rotundo éxito de Zootaxa, revela inequívocamente que la supuesta lentitud de los taxónomos en publicar sus trabajos, señalada por varios como una de las principales causales del impedimento taxonómico, no es del todo cierta, ya que lo que en realidad faltaba era el medio adecuado para publicar sus investigaciones (Thomson Reuters 2009b).

ALTERNATIVAS AL FI–ISI

En los últimos años se han desarrollado varias herramientas que nos permiten localizar y hacer conteos de las citaciones recibidas por un artículo, un investigador o grupo de ellos, una revista o una institución. Destaca entre ellas Google Scholar que además de ofrecer gratuitamente su información en Internet, está perfeccionando continuamente sus algoritmos para depurar los resultados obtenidos, mismos que incluyen citas en libros así como en revistas académicas disponibles en Internet aunque no estén indizadas en el CI. Un nuevo indicador numérico que cada día está siendo más popular es el h–index propuesto por Hirsch (2005), quien sugiere medir la productividad de un científico enfocándose en la parte alta de la cola de la distribución de las citaciones hechas a sus publicaciones. El h–index de un científico se define como la "n" mayor para la cual él o ella ha publicado "n" artículos, cada uno con al menos "n" citaciones. Es decir; un h–index = 15 significa que el investigador en cuestión tiene 15 publicaciones que han sido citadas 15 o más veces. La creciente popularidad de éste indicador en la evaluación de investigadores se debe a que supuestamente éste número simple, refleja muy bien el registro citatorio completo de cada investigador. Sin embargo, Adler, Ewing & Taylor (2008) indican que basta una inspección casual del h–index y sus variantes para demostrar que se trata de ingenuos intentos por comprehender registros de citación complejos. Si bien estos indicadores capturan una pequeña cantidad de información sobre la distribución de la citación de un científico, ellos pierden información crucial que es esencial para la evaluación de la investigación. Para ilustrar su punto nos piden imaginar a dos científicos cada uno con 10 artículos con 10 citaciones, pero uno de ellos con 90 artículos adicionales todos con 9 citaciones, u otro par de investigadores, uno con exactamente 10 artículos con 10 citaciones y otro también con 10 artículos pero con 100 citaciones cada uno; aunque nadie se atrevería a afirmar que los investigadores involucrados en cada comparación sean equivalentes, el h–index si lo haría.

El grupo Scimago de la Universidad de Granada, España y la compañía Elsevier con su base de datos Scopus que es competencia del ISI–WoK de Thomson Reuters, han puesto a disposición de la comunidad científica una nueva herramienta que permite comparar el impacto o visibilidad internacional de revistas científicas, denominado: Scimago Journal Ranking (SJR), que por primera vez en casi medio siglo de monopolio ofrece una alternativa robusta e interesante al JCR–ISI. El SJR–Elsevier se puede consultar desde cualquier conexión a Internet sin costo alguno, involucra un acervo de revistas de corriente principal más grande y representativo de la ciencia mundial (esforzándose por incluir las mejores revistas de diferentes países), y además incluye un algoritmo perfeccionado para calcular el factor de impacto de la revista (FI–SJR), que entre otras virtudes pondera la calidad de la fuente de cada cita (sensu Scimago 2008). En 2006 el acervo del JCR–ISI incluía 7,932 revistas y el SJR–Elsevier 13,201 (incluyendo todas las del JCR y poco más de 5 mil adicionales). Del acervo del JCR–ISI las revistas de Iberoamérica representaban el 1%, las de EEUU y Canadá el 44% y las de Europa el 48%. Mientras que en el SJR–Elsevier la representación de estas regiones es del 3%, 36% y 50%, respectivamente. De Iberoamérica el JCR solamente incluía 93 revistas y el SJR a 397 (Aguado–López et al. 2008). Habrá que seguir de cerca a este nuevo índice de revistas internacional y su indicador de impacto, así como sus repercusiones en la evaluación de investigadores y en la ciencia.

A mediados de 2008, posterior a la creación del SJR de Scimago y Elsevier, el portal de Internet de Thomson Reuters anunció la incorporación a su índice de 700 revistas científicas de países en vías de desarrollo, todas de excelentísima manufactura y calidad que han sido incorporadas a la base de datos del CI. Las 700 revistas estarán indizadas en el CI como revistas 'regionales', que según Thomson Reuters (2008c): "... se trata de revistas típicamente publicadas fuera de EEUU y el Reino Unido y su contenido comúnmente se centra en tópicos de interés regional que son presentados con una perspectiva regional" (sic). Entre estas revistas se incluyen 80 de Latinoamérica que hasta el 2008 no estaban en el CI, 18 de ellas mexicanas. En el caso de las mexicanas ya sabíamos que todas ellas eran de calidad internacional pues desde hace años han pertenecido al índice de revistas del CONACyT (ver más adelante), y ahora sin cambios notables en la calidad de sus contenidos ni en sus políticas ni comités editoriales, han sido aceptadas en el CI. Lo anterior llama fuertemente la atención, puesto que algunas de estas revistas habían recibido recientemente la negativa de ISI–Thomson Reuters para ingresar a su índice debido a que no reunían las características necesarias, pero la compañía cambió de parecer sospechosamente poco después de que apareció su primer y único competidor comercial en escena con un acervo de revistas más grande y representativo. En su portal de Internet Thomson Reuters (2008c) indica que la inclusión de estas 700 revistas fue resultado de un proceso de evaluación que les llevó dos años y medio, sin embargo no dan detalles claros acerca del proceso ni de los evaluadores involucrados; es decir, esta empresa no ha proporcionado una explicación convincente acerca del porqué fueron aceptadas tantas revistas de países en vías de desarrollo en su CI, así tan de pronto. De hecho en junio del 2009 Thomson Reuters (2009c) anunció la incorporación a su CI no solo de estas 700 sino de un total de 1,544 revistas regionales, entre ellas 185 de Latinoamérica, todas ellas con un estándar de calidad científica similar al de cualquier revista de su CI (Thomson Reuters dixit). Es un tanto increíble que una compañía comercial categorice a revistas científicas como de importancia regional sin conocimiento de las disciplinas. Por ejemplo en el caso que conozco mejor, las revistas mexicanas: Acta Botánica Mexicana, Boletín de la Sociedad Botánica de México y Revista Mexicana de Biodiversidad, ahora incluidas en el 'CI regional', no pueden catalogarse como regionales simplemente por contener el nombre de nuestro país en sus títulos. Al parecer Thomson Reuters no sabe que México es uno de los 17 países llamados 'mega–diversos' dada la extraordinaria diversidad biológica que albergan, que además tiene una singular biogeografía debido a que es la región en donde se encuentran y mezclan las provincias neártica y neotropical. Por tanto nuestro país es de gran importancia para el estudio de la biodiversidad planetaria. El supuesto enfoque regional de estas revistas está exclusivamente en la cabeza de los directivos y empleados de Thomson Reuters.

INICIATIVAS LATINOAMERICANAS

En Latinoamérica se han desarrollado varias alternativas encaminadas a incrementar la accesibilidad y visibilidad de las publicaciones de la región. Destaca entre ellas Latindex, producto de la cooperación de una red de instituciones coordinadas por la UNAM, que después de un exhaustivo inventario, generó un directorio de 17,623 publicaciones científicas seriadas de América Latina, el Caribe, España y Portugal. De este directorio y mediante un proceso de selección riguroso detallado en su portal de Internet, Latindex elaboró un catálogo de 3,897 revistas de la región cuya calidad editorial y arbitraje riguroso cumplen con normas internacionales (Latindex 2009). De este catálogo 719 revistas son de ciencias exactas y naturales, 1,193 de ciencias médicas y el resto de ciencias sociales, humanidades e ingenierías. Otra interesante iniciativa auspiciada por la Universidad Autónoma del Estado de México es RedALyC, en cuyo portal de Internet se incluyen 401 revistas de ciencias sociales y humanidades, así como 149 de ciencias exactas y naturales de Iberoamérica. Los contenidos de sus 550 revistas se ofrecen gratuitamente a texto completo (poco más de 114 mil artículos en formato PDF), con base en la filosofía del 'Acceso Abierto' (Open Access). Este portal incluye parámetros que contabilizan cuántas descargas de artículos PDF por mes o al año se realizan por revista o por artículo, indicando el porcentaje de descargas hechas desde servidores de México, Latinoamérica, EEUU o Europa, lo que nos permite sin mayor esfuerzo evaluar cuánto nos están leyendo y desde dónde. Próximamente incluirá también estadísticas de citación equivalentes al factor de impacto (RedALyC 2009). RedALyC incluye actualmente a 81 revistas mexicanas del índice del CONACyT (ver más adelante) que en conjunto suman 25,858 artículos disponibles a texto completo. Entre enero del 2007 y mayo del 2009 se realizaron 12.5 millones de descargas de estos artículos en formato PDF (poco más de 430 mil descargas por mes), 6.2 millones descargadas desde servidores de México y el resto desde otros países.

Iniciada por un grupo de instituciones brasileñas, la iniciativa SciELO: Scientific Electronic Library Online (Biblioteca Científica Electrónica en Línea), se ha consolidado recientemente y a la fecha incluye 628 revistas científicas de excelencia académica producidas principalmente en 6 países Latinoamericanos, España y Portugal. La inclusión de otros países, entre ellos México, está en proceso. El portal de SciELO también pone a disposición del mundo el contenido de sus revistas a texto completo (poco más de 200 mil artículos en PDF) sin costo alguno. Además, SciELO contiene procedimientos integrados para la medida del uso y el impacto de sus revistas (SciELO 2009), contribuyendo así a superar el fenómeno de la 'ciencia perdida u oculta' (sensu Gibbs 1995). Quisiera destacar que en Iberoamérica, los editores de numerosas revistas científicas han acordado colocar sus contenidos en acceso universal (Open Access), lo cual si bien es debido a que es la única salida que queda para aumentar su visibilidad, sirve de ejemplo a las comunidades científicas de Norteamérica y Europa, cuyas publicaciones están en manos de empresas con claros fines de lucro, que cobran caro a todo aquel que quiera tener acceso a la ciencia.

ÍNDICES DE REVISTAS NACIONALES, EL CASO DEL ÍNDICE DE CONACYT

En México, el CONACyT estableció desde 1993 el Índice de Revistas Mexicanas de Investigación Científica y Tecnológica (índice CONACyT) para identificar las revistas científicas nacionales que cumplen con los requisitos internacionales de excelencia. En el proceso de selección participan destacados académicos mexicanos de las diferentes áreas del conocimiento. En su primera convocatoria aceptó solamente a 27 revistas de las 127 que solicitaron su ingreso, dejando a 41 con ingreso condicionado. A la fecha el índice CONACyT incluye 109 revistas en total (CONACyT 2009a). Los investigadores mexicanos esperan con razón, que sus publicaciones en estas revistas sean tomadas en cuenta en sus evaluaciones institucionales, solicitudes de apoyo al CONACyT y a otras instituciones, y desde luego por el SNI (Bazdrech, en Cetto & Alonso 1999). Sin embargo, no todos los comités evaluadores consideran de calidad internacional a este índice ni a otros que no sean los de ISI–Thomson Reuters. De las siete áreas que integran al SNI, el Área II (Biología y Química) fue la primera en desconocer el índice CONACyT puesto que en 2003 modificó sus criterios internos exigiendo para el ingreso, permanencia o promoción de sus investigadores, que los artículos científicos a considerar en la evaluación debían "rigurosamente" estar publicados en revistas indizadas en el CI (CONACyT 2008).

En marzo del 2009 el CONACyT actualizó los requisitos de ingreso, promoción y permanencia de las siete áreas del SNI y en tres de ellas (Áreas II; III – Medicina y Ciencias de la Salud; VI – Biotecnología y Ciencias Agropecuarias) ahora se considera explícitamente no al CI sino al JCR de ISI, que es un subconjunto del primero. Las Áreas III, VI y V (Ciencias Sociales) reconocen explícitamente al índice CONACyT. El Área I (Físico–Matemáticas y Ciencias de la Tierra) indica que "...los artículos deben estar publicados en revistas indexadas de alto factor de impacto...", abriendo la posibilidad de que sea el FI–ISI u otros FI, como por ejemplo el FI–SJR de Scimago–Elsevier o el de SciELO, dejando a juicio de la comisión el decidir si la revista en donde publicó el evaluado tiene los elementos de calidad necesarios. El Área II sigue siendo la única que desconoce al índice CONACyT, sin embargo la redacción actual de sus criterios parece también abrir la posibilidad de considerar otros índices internacionales además del JCR–ISI, en los que se calcule el FI de cada revista, ya que literalmente menciona: "...rigurosamente las revistas deberán estar indexadas con factor de impacto como el JCR". Una modificación en los criterios de esta Área que merece destacarse es que a partir de ahora se consideran al mismo nivel que los artículos en revistas indexadas a las monografías científicas; a la letra el nuevo estatuto dice: "...según la disciplina podrán considerarse monografías (v.gr. fasículos de flora o fauna) en series de prestigio" (CONACyT 2009b). Si bien esta modificación es crucial y muy aplaudible, no podemos dejar de señalar que el SNI mexicano tardó demasiado (25 años) en reconocer este tipo de publicaciones que históricamente han probado su valía para el avance de la taxonomía (durante más de 250 años de existencia de la disciplina) y que durante varios lustros muchos taxónomos y biólogos mexicanos insistieron infructuosamente en que se reconocieran. Habrá que reflexionar a fondo acerca de las razones que nos llevaron a tan grave omisión y evaluar sus consecuencias fríamente con el fin de evitar errores similares en el futuro. No puedo dejar de señalar un revelador error cometido en la redacción de los nuevos requisitos del Área VI del SNI, en donde se define al ISI como el "International Scientific Index" (CONACyT 2009c) en vez de Institute for Scientific Information, equivocación que nítidamente muestra el grado de desconocimiento de lo que es el ISI por parte de numerosos investigadores.

Darle valor a las revistas indexadas en índices nacionales de calidad científica, con base en revisiones frecuentes realizadas por expertos en cada área, es en mi opinión señal inequívoca de madurez científica y México además ya tiene la suficiente masa crítica de investigadores con reconocimiento internacional para hacerlo. Ciertos vicios que pudieron presentarse en el pasado, por ejemplo el que el director de la institución o sociedad científica que edita la revista, favoreciera la publicación de sus propios investigadores o miembros para facilitar su promoción (vicio potencial del que no están exentos nuestros colegas de otras regiones, por cierto), son prácticamente imposibles de hacer bajo las normas actuales de ingreso y permanencia en el índice de CONACyT. Entre dichas normas se exige independencia entre la dirección de la institución y el comité editorial, este último debe estar integrado por investigadores reconocidos nacional e internacionalmente y debe además ser multi–institucional y multi–nacional. Al menos 60% del total de autores por cada número publicado deberán estar adscritos a dependencias distintas a la que edita la revista. El 60% de los árbitros deberán ser ajenos a la dependencia editora y todo artículo sometido por investigadores de dicha dependencia tiene que ser revisado por árbitros ajenos a la misma (CONACyT 2009a). Para todo ello se exigen pruebas documentales y la falla en producirlos es razón suficiente para sacar a la revista del índice.

Algo que tenemos que considerar a fondo al analizar la pertinencia de revistas científicas mexicanas, es que en algunas disciplinas como Física, Matemáticas, Fisiología Celular, Biología Molecular, etc., la principal justificación para la existencia de una revista nacional especializada en el tema, suele descansar en que los editores y quienes mayormente publican en ella son investigadores adscritos a instituciones mexicanas, quienes podrían justificadamente sentirse parte de una o varias escuelas de pensamiento distintivas, postura que históricamente nunca ha disminuido o inhibido la calidad de la ciencia de la disciplina, sino todo lo contrario. Mientras que en otras disciplinas, además de lo anterior, la existencia de la revista mexicana suele justificarse precisamente por el sujeto de estudio, tal es el caso de la Zoología, Botánica, Micología, Oceanografía, Geología, etc. En estas disciplinas además, los expertos internacionales que más saben del tema suelen estar concentrados en nuestras instituciones. Tal afirmación, lejos de ser chauvinista, es resultado del esfuerzo y dedicación sostenida durante décadas por parte de excelentes investigadores adscritos a instituciones mexicanas, quienes además han recibido numerosos reconocimientos nacionales e internacionales por ello.

Es imperativo determinar objetivamente si en México podemos producir revistas de calidad internacional tan buenas como cualquier otra de renombre, valorando la importancia de ello para el país y el avance del conocimiento. Para el desarrollo científico nacional y la renovación de cuadros de investigadores mexicanos, no es sano que simplemente nos dejemos llevar a la deriva hacia donde las revistas de 'corriente principal' (sensu ISI) nos arrastren. Si queremos tomar las riendas de la investigación científica en nuestro país nada mejor que mediante revistas científicas nacionales de excelente calidad, cosa que no lograremos si no reconocemos antes dichas revistas en nuestras evaluaciones, para lo cual es indispensable retomar el espíritu original de la creación del índice de revistas de CONACyT, sacando del mismo a toda revista que no dé el ancho pero asegurándonos simultáneamente de remover el impedimento de no reconocerlas, particularmente en nuestra Área II: Biología y Química. Con el ánimo de incitar a la reflexión y debate sobre estos pormenores vuelvo a citar a Zaid (2009):

"Los libros y artículos publicados en Nueva York (o en París) citan sobre todo libros y artículos publicados en Nueva York (o en París). Hay algo natural en que las metrópolis sean provincianas: el desarrollo de una conversación creadora, la animación que le da vida, tiene como centro una discusión local. Por el contrario, un signo claro de subdesarrollo son las publicaciones que no citan autores locales, para no verse provincianas. ... Para el subdesarrollo, las discusiones importantes son las que se siguen de lejos, como un espectáculo. Estar en la periferia consiste precisamente en no estar en sí mismos, en creer que la verdadera vida está en un centro remoto."

REFLEXIONES FINALES

En un estudio reciente, Holmgren & Schnitzer (2004) muestran que a pesar de que en términos absolutos el volumen de la producción científica Latinoamericana es pobre, no lo es en términos relativos. Del total de artículos producidos por investigadores adscritos a instituciones de todo el continente Americano y publicados en revistas indizadas en el CI del ISI entre 1990 y 2000, Latinoamérica únicamente contribuyó con 5.4%, Canadá con 10.3% y los EEUU con 84.2%. Sin embargo, en términos relativos a lo producido en 1990, Latinoamérica incrementó su producción científica ISI en 150% para el año 2000, superando por mucho al incremento relativo registrado en EEUU y Canadá que apenas se aproximó al 30% durante la misma década. Lo anterior es todavía más impresionante cuando se toma en cuenta la inversión en ciencia por región, pues para el 2000 Latinoamérica superó a EEUU y Canadá en la cantidad de artículos ISI producida por millón de dólares invertido y mientras en nuestra región la tendencia sigue a la alta, en EEUU y Canadá se ha estabilizado o va a la baja. En términos de 'costo–beneficio' que tanto gustan a los economistas y tomadores de decisiones, la inversión en ciencia en Latinoamérica es claramente más redituable. Es claro que para este notable incremento de la producción científica Latinoamericana, la exigencia de publicar en revistas indizadas en el CI fue fundamental. Sin embargo, la cuestión que queda por demostrar y está en pleno debate es si estas políticas han impactado favorablemente o no la calidad de la ciencia que se hace en nuestra región. Es particularmente debatible si la mayor visibilidad internacional que sí dan las revistas indizadas en el CI, se traduce automáticamente en una mayor calidad científica. Aunque algunos investigadores opinan que sí, muchos otros no estamos de acuerdo; el mayor éxito citatorio en las revistas de 'corriente principal' sensu ISI–Thomson Reuters y una mayor cantidad de artículos no implica una mayor calidad de la ciencia, ni mucho menos mayor pertinencia, no solo pertinencia social, sino pertinencia científica para el avance del conocimiento. Esta polémica es palpable en nuestras comunidades científicas, lo cual no debe asustarnos pues la polémica no es ajena a la ciencia, sino todo lo contrario. Es preocupante sin embargo, que sigamos empleando al CIy su FI–ISI tal y como se ha venido haciendo, simplemente porque no hay nada mejor a la mano, o porque se trata de un índice de revistas e indicador cuantitativo empleados en todo el mundo, o debido a que ya nos acostumbramos a ellos, etc. Razones que no sorprenden si provienen de la compañía propietaria del CI y del FI–ISI, o de auditores o funcionarios relacionados con la ciencia, pero que resultan completamente inaceptables cuando provienen de la comunidad científica.

Los científicos siempre hemos sometido nuestros proyectos de investigación, informes, publicaciones, currículum, etc. a la opinión de colegas imparciales y expertos en nuestra disciplina. La revisión de nuestros trabajos por 'pares' es parte integral del avance de la ciencia, sin embargo, los expertos de un tema o disciplina quienes saben mejor que nadie lo que requiere su campo, en ocasiones ya no son escuchados por otros científicos evaluadores quienes solamente quieren saber el FI–ISI de las revistas en las que están publicando y ello es absurdo. Los comités evaluadores que decidan no tomar en cuenta los nuevos índices internacionales y sus indicadores de citación o de uso de artículos, que no son producidos por ISI–Thomson Reuters, deberían dar explicaciones concretas y académicas acerca del porqué estos nuevos indicadores de 'buena ciencia internacional' no van a ser considerados y lo mismo debían hacer si desconocen al índice CONACyT.