Clasificación JEL: C01, C32, C53, E30, E31, E37.

Introducción

En el presente artículo se estudia las propiedades de sesgo y autocorrelación serial en los errores de proyección de inflación provenientes de la Encuesta de Expectativas Económicas (EEE) del Banco Central de Chile. Además se evalúa, en un ejercicio fuera de muestra, una manera muy sencilla de mejorar estas proyecciones. Nuestros resultados indican que las proyecciones de inflación provenientes de la EEE en promedio subestiman la inflación efectiva y además presentan un exceso de autocorrelación. El sesgo y el exceso de autocorrelación encontrados posibilitan mejorar las proyecciones de inflación mediante la incorporación de un buen predictor de los errores. En otras palabras, mostramos que al corregir las proyecciones de inflación, la proyección ajustada posee un menor sesgo y un menor error cuadrático medio (ECM) que la original. Estas diferencias son, en general, estadísticamente significativas a niveles de confianza usuales.

Aunque la estrategia dominante para evaluar dos metodologías predictivas corresponde a la comparación de sus ECM, la bibliografía del tema plantea otras maneras de evaluación predictiva que incluso pueden ser más útiles.1 En particular, es pertinente evaluar propiedades de sesgo y autocorrelación de los errores de predicción de una metodología dada y compararlas con las correspondientes a errores de predicción óptimos. Con pérdida cuadrática un error de predicción óptimo k periodos hacia adelante debería tener sesgo nulo y presentar una estructura de medias móviles de orden h -1, MA(h -1), que en otras palabras significa que la autocorrelación serial de orden h o superior debería ser 0. En particular se esperaría que un error de predicción óptimo un paso hacia adelante fuera un ruido blanco que no presentara autocorrelación serial.

Una desviación de esta pauta óptima abre la puerta para ajustar las proyecciones de manera conveniente. En efecto, si el error de predicción h periodos hacia adelante presentara una estructura de medias móviles de orden q > h -1, existiría información contenida al instante de construir la predicción, que podría en parte anticipar el comportamiento del error de predicción. En otras palabras el error de predicción, en teoría un ente impredecible, se-ría predecible. Consecuentemente, la proyección se podría ajustar para incorporar la predicción del error que se estaría cometiendo.

Öller y Barot (2000) señalan que evaluaciones de sesgo y autocorrelación han sido llamadas en la bibliografía "evaluaciones de eficiencia informacional débil" y se enmarcan dentro de una familia de pruebas estadísticas que evalúan la racionalidad de los agentes económicos.2 No obstante esta observación, una bibliografía reciente muestra que la existencia de sesgo y autocorrelación en los errores de predicción no forzosamente es síntoma de ineficiencia o irracionalidad en las predicciones. En efecto, la existencia de sesgo y autocorrelación puede ser el resultado de una estrategia óptima por parte de agentes que enfrentan funciones de pérdida asimétricas (véase por ejemplo Patton Timmermann, 2007; Capistrán, 2007, y Capistrán y Timmermann, 2008).

Es frecuente encontrar trabajos que cuestionan la calidad de las predicciones económicas de diversos agentes. Por ejemplo, Joutz y Stekler (2000), que analizan las predicciones de la Reserva Federal de Estados Unidos, encuentran que la serie de errores de los pronósticos de inflación muestra autocorrelación. No obstante ello, Joutz y Stekler no proponen métodos para corregir los pronósticos e incorporar la información contenida en la autocorrelación detectada. Más recientemente, Capistrán (2007) muestra que las predicciones de inflación de la Reserva Federal subestimaron la in flación efectiva de manera significativa en un determinado periodo muestral, y que la sobreestimaron en el periodo posterior. Además Capistrán señala que las proyecciones de la Reserva Federal parecen no haber incorporado toda la información disponible en las proyecciones de agentes privados.

Para el caso de la zona euro, Bowls et al (2007) analizan las predicciones económicas realizadas por una serie de analistas privados. Ellos encuentran, entre otras cosas, que para el periodo del primer trimestre de 1999 al último trimestre del 2006 los analistas han tendido a subestimar significativamente la inflación y a sobreestimar el crecimiento económico. Otro interesante artículo que analiza la calidad de proyecciones económicas es el de Loungani (2001). A diferencia de los trabajos citados líneas arriba, Loungani considera las proyecciones de crecimiento económico para una serie de países industrializados y en desarrollo para el periodo 1989-1998. Las proyecciones son obtenidas de Consensus Forecasts y muestran alguna prueba de sesgo en el caso de países en desarrollo, y pruebas de uso ineficiente de la información tanto para el grupo de países industrializados como para el grupo de países en desarrollo.

Como se ha señalado, hay múltiples estudios internacionales que evalúan las predicciones realizadas por analistas privados, bancos centrales u otras instituciones. Sin embargo, para el caso específico de Chile sólo existe un número pequeño de estudios de esta naturaleza. Entre ellos se destaca el trabajo de Chumacero (2001), quien evalúa las proyecciones de crecimiento económico de una serie de analistas privados y encuentra una fuerte prueba de sesgo en ellas. Por su parte Albagli et al evalúan los errores de predicción de inflación y crecimiento del Banco Central de Chile (BCC), analistas privados y otros bancos centrales. Sus resultados en materia de inflación muestran que, entre 2000 y 2002, los errores de predicción del BCC fueron bastante menores a los de los analistas privados.3

A diferencia de muchos trabajos que evalúan proyecciones de acuerdo con su eficiencia con pérdida cuadrática sólo en ejercicios dentro de muestra, aquí mostramos que la ineficiencia detectada en las proyecciones de la EEE puede ser utilizada para generar nuevas y más precisas predicciones en un ejercicio fuera de muestra.4 Si bien la introducción de mejoras a un conjunto de proyecciones comprobadas como ineficientes, a partir del mejor o más eficiente uso de la información disponible, es una idea con amplios precedentes en la bibliografía (véase por ejemplo Elliot y Timmermann, 2008), el uso de pruebas de exceso de autocorrelación para mejorar el error cuadrático medio (ECM) de las proyecciones en un ejercicio fuera de muestra es, a nuestro juicio, una contribución de este artículo. Esto es importante, pues el simple hallazgo de sesgo y exceso de autocorrelación, en un ejercicio dentro de muestra, no garantiza que este sesgo y exceso de autocorrelación pueda ser efectivamente aprovechado para mejorar las proyecciones en tiempo real. A nuestro en tender, el ejercicio fuera de muestra que aquí se realiza es eficaz en mostrar que el sesgo y el exceso de autocorrelación detectado puede ser efectivamente utilizado para mejorar la tarea predictiva.

El artículo se organiza como sigue: la sección I describe las propiedades relevantes de un error de predicción óptimo. La segunda sección describe la estrategia usada para comparar los sesgos y errores cuadrático medio de las proyecciones originales con las ajustadas. La sección III evalúa los errores de predicción de la EEE en términos de su sesgo y autocorrelación. La sección IV muestra las ganancias en términos de reducción de sesgo y ECM que se obtienen al corregir el sesgo y el exceso de autocorrelación de los errores de predicción. Esto último se hace en un ejercicio fuera de muestra. Al final se entrega un breve resumen y algunas reflexiones.

I. Error de predicción óptimo

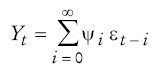

El segundo teorema de representación de Wold permite escribir a toda serie débilmente estacionaria y puramente no determinística como una combinación lineal infinita de innovaciones

en que los coeficientes en la sumatoria son de cuadrado sumable y el primer coeficiente es exactamente igual a 1.

Dado un conjunto de información denotado por

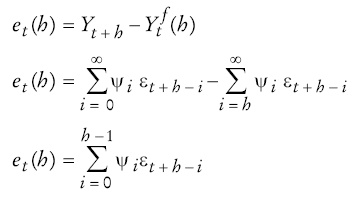

El error de predicción óptimo con pérdida cuadrática se define como la diferencia entre la serie original y el predictor óptimo. Este error, que denotamos por

Diversos artículos en la bibliografía han desarrollado propiedades de los errores de predicción óptimos usando un contexto similar al aquí presentado (véase por ejemplo Granger y Newbold, 1986). En particular nosotros estamos interesados en tres de estas propiedades, las que se pueden demostrar fácilmente a partir de las expresiones anteriores.

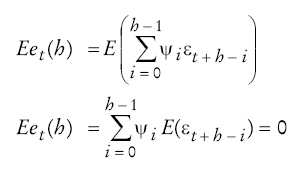

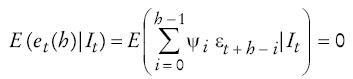

i) Los errores de predicción óptimos son insesgados. En efecto, para ello basta notar que

ii) Los errores de predicción

Luego, como queremos evaluar una condición para el caso l >h-1 tenemos, para i, j entre 0 y h -1, lo siguiente:

Por otro lado, tenemos que el otro índice satisface lo siguiente

Luego, si l >h-1 vemos que los subíndices t + h - i y t - l + h - j nunca pueden tomar el mismo valor. De esto se infiere que si l >h-1

iii) El error de predicción óptimo h pasos hacia adelante sigue un proceso

MA(h -1) y como tal, con pérdida

cuadrática y usando el conjunto de información

II. Evaluación de la capacidad predictiva

Para comparar la capacidad predictiva de dos métodos de predicción nos centraremos en evaluar las diferencias en error cuadrático medio y las diferencias en el sesgo de las proyecciones. El ECM de los errores de proyección y su sesgo se definen como sigue

en que e denota el error de predicción definido como el valor efectivo de la inflación menos su valor proyectado.

Un método de proyección será mejor que otro en la medida que tenga menor sesgo y menor ECM. Para evaluar estadísticamente las diferencias en sesgo y en ECM entre dos métodos, nos basaremos en el paradigma de evaluación de capacidad predictiva propuesto por Giacomini y White (2006). Si bien, en la práctica y con supuestos operacionales muy específicos este paradigma se puede reducir a uno muy similar al propuesto por Diebold y Mariano (1995) y West (1996), las diferencias conceptuales son muy grandes. En efecto, las pruebas propuestas por Giacomini y White (2006) están orientadas a evaluar un método de proyección y no un modelo de proyección. Esta diferencia, aunque sutil, es muy pertinente en este trabajo porque las observaciones obtenidas son proyecciones de inflación que no están forzosamente asociadas a modelos específicos.

La versión de las pruebas de Giacomini y White (2006) que empleamos en este trabajo usa un estadístico originalmente atribuido a Diebold y Mariano (1995) y West (1996) con las dos siguientes consideraciones: i) no se realiza ninguna corrección asociada a incertidumbre paramétrica, ya que no se desea evaluar un modelo con parámetros poblacionales sino que un método de proyección, y ii) en la es timación HAC de la varianza de las diferencias en los errores promedios de proyección no se selecciona los rezagos de acuerdo con el comportamiento óptimo de los errores de proyección, pues se considera que ellos pueden contener una estructura autorregresiva más compleja. Para todos los efectos prácticos se procede utilizando una estimación HAC de acuerdo con Gallant (1987) con selección automática de rezagos de acuerdo con Newey y West (1994).5

Formalmente se construye el siguiente estadístico con base en Giacomini y White (2006):

en que h representa el horizonte de proyección,

n(h) denota el número de proyecciones que

se tiene para ese determinado horizonte, ∆L es la pérdida

diferencial entre dos proyecciones y

Según la hipótesis nula de igualdad de habilidad predictiva, el estadístico

III. Análisis de los errores de predicción de la EEE

La Encuesta de Expectativas Económicas (EEE) recoge mensualmente las proyecciones de inflación de una treintena de analistas económicos. A partir de esta encuesta se obtiene información de predicciones de inflación a uno y tres meses hacia adelante para cada analista individualmente. El Banco Central de Chile posee una base de datos de acceso público en la que presenta series con la mediana de estas proyecciones. El análisis que sigue a continuación se basa precisamente en las propiedades de los errores de proyección asociadas a la mediana presentada por el Banco Central de Chile. El análisis considera al periodo entre febrero de 2000 y mayo de 2008. Las proyecciones de inflación se han considerado en variaciones a 12 meses.

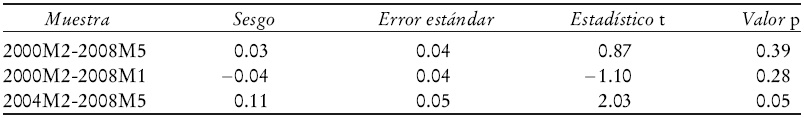

Los Cuadros 1-2 muestran que los errores de proyección tienen un sesgo estadística y económicamente significativo en la última mitad de la muestra analizada, que alcanza un valor de 11 y 47 puntos base en proyecciones a un mes y tres meses, respectivamente.

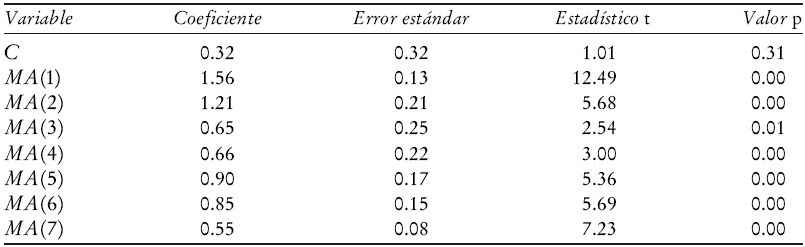

Los Cuadros 3 y 4 muestran que procesos MA(1) y MA(7) son buenas re-presentaciones estadísticas de la estructura de los errores de predicción uno y tres pasos hacia delante, respectivamente. Esto es un resultado coherente con la hipótesis de ineficiencia de las predicciones con pérdida cuadrática. En efecto, como se ha señalado, si las proyecciones fueran óptimas, los errores de predicción deberían poseer una estructura MA(0) y MA(2), respectivamente. En otras palabras, estamos en presencia de evidencia de un exceso de autocorrelación en los errores de predicción provenientes de la EEE.

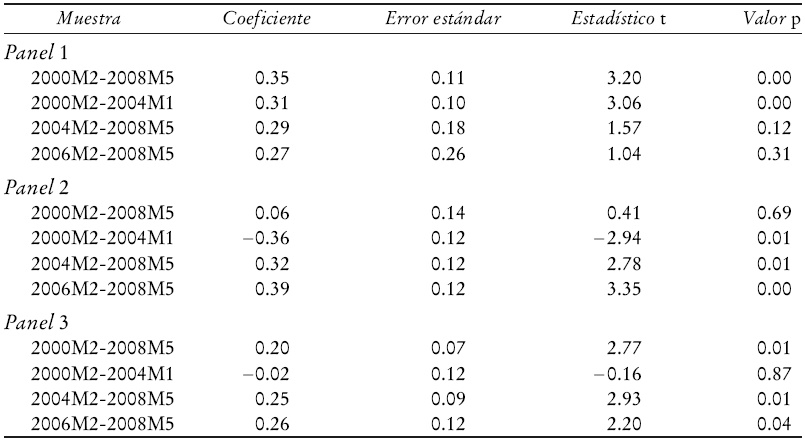

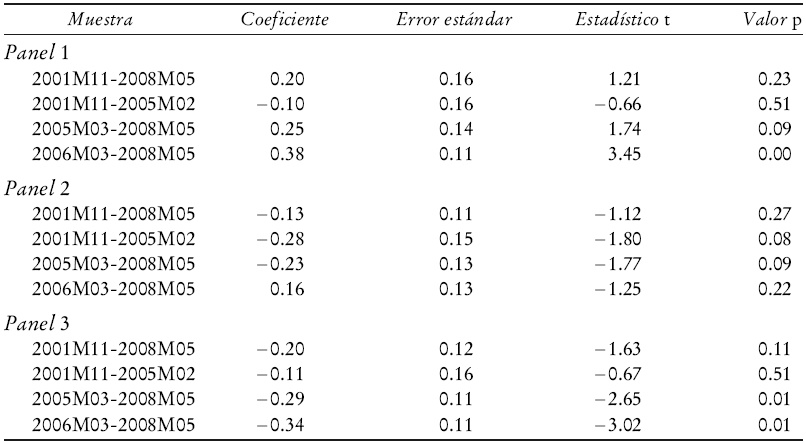

Congruente con lo anterior, el Cuadro 5 muestra que los errores de predicción un paso hacia adelante pueden ser satisfactoriamente predichos por una función que sólo incluye al primer rezago de esta variable. Esto es claramente incompatible con las propiedades 2 y 3 descritas líneas arriba de los errores de predicción óptimos. Recordemos que un error de predicción óptimo un paso hacia adelante, con pérdida cuadrática, es un ruido blanco y por tanto es impredecible. Similarmente el Cuadro 6 muestra un resultado análogo para los errores de predicción tres meses hacia adelante. Se observa que estos errores pueden ser satisfactoriamente predichos por una función lineal de errores de predicción que están en un conjunto de información ortogonal a los errores de proyección óptimos tres meses hacia adelante.

a Los distintos paneles en el cuadro muestran resultados asociados a los coeficientes

Cuadro 5 Predictibilidad de los errores de predicción. Proyección un mes hacia adelante.a

a los distintos paneles en el cuadro muestran resultado asociados a los coeficientes

Cuadro 6 Predictibilidad de los errores de predicción. Proyección tres meses hacia adelante.a

El panel 1 del Cuadro 5 muestra que el primer rezago de los errores de predicción un paso hacia adelante tiene capacidad para predecir los errores de predicción. Se observa que la capacidad predictiva es fuerte en la primera mitad de la muestra y decae en la segunda mitad. El panel 2 muestra que el tercer rezago de los errores de predicción un paso hacia adelante también tiene capacidad para predecir los errores. Es interesante que la relación entre el error de predicción y su tercer rezago cambia de signo alrededor de la mitad de la muestra. Esto ha ce que al analizar la muestra completa no se encuentre pruebas de predictibilidad; sin embargo al analizar la primera y segunda mitad de la muestra por separado se encuentra una sólida prueba de predictibilidad. El panel 3 muestra en tanto que la suma del primer y tercer rezago también es un buen predictor de los errores, sobre todo en la segunda mitad de la muestra. Estos resultados muestran que los errores de predicción un mes hacia adelante pueden predecirse por sus rezagos, lo que da cuenta de la no optimalidad de los errores de predicción un mes hacia adelante.

El panel 1 del Cuadro 6 muestra que el tercer rezago de los errores de predicción tres pasos hacia adelante tiene capacidad para predecir los errores de predicción en la segunda mitad del periodo muestral. Esta predictibilidad se intensifica aún más hacia el final de la muestra, como se observa en la cuarta fila del panel 1. El panel 2 muestra que el séptimo rezago de los errores de predicción tres pasos hacia adelante también tiene capacidad de predecir los errores. Esta predictibilidad se observa nítidamente al realizar regresiones dividiendo la muestra en dos partes iguales. En ambas submuestras se alcanza predictibilidad que es estadísticamente significativa a 10%. Finalmente el panel 3 muestra que la resta del tercer y séptimo rezago de los errores de predicción tres pasos hacia adelante también tiene capacidad para predecirlos hacia la segunda mitad de la muestra considerada. Esta capacidad se intensifica hacia la porción final del periodo muestral. Estos resultados muestran que los errores de predicción tres meses hacia adelante pueden predecirse por rezagos que forman parte del conjunto de información disponible al momento de realizarse las proyecciones, lo que muestra la no optimalidad de los errores de predicción tres meses hacia adelante.

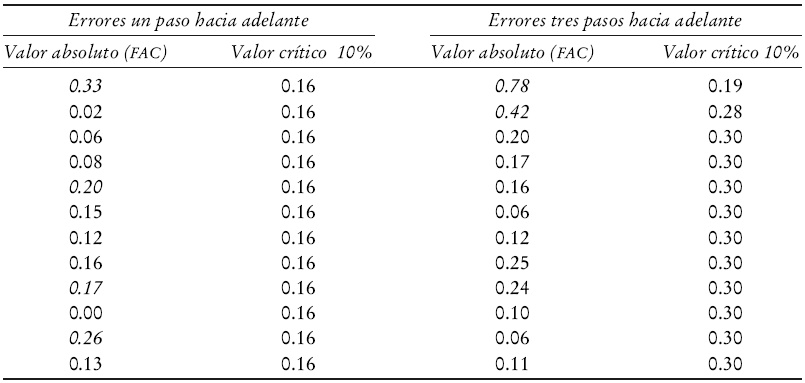

No obstante las pruebas presentadas en los Cuadros 1-6, el tradicional análisis de las funciones de autocorrelación (FAC) de los errores de predicción de la EEE muestra, en el Cuadro 7, resultados algo ambiguos respecto a este supuesto exceso de autocorrelación. Si bien la FAC de los errores de predicción un paso hacia adelante no es coherente con una estructura de ruido blanco, en estricto rigor los intervalos de confianza asintóticos para la FAC de los errores de predicción tres pasos hacia adelante no permiten rechazar la hipótesis de eficiencia de los errores, puesto que ellos son coherentes con una estructura de tipo MA(2). Incluso al reconstruir la FAC con la mitad más reciente de los datos tampoco se obtiene prueba en contra la estructura de tipo MA(2).

a Las cifras en cursivas son significativas estadísticamente a 10 por ciento.

Cuadro 7 Funciones de autocorrelación de los errores de predicción.a

¿Qué puede estar detrás de este resultado? Para intentar dar una res puesta debemos recordar la manera en que se construyen tradicionalmente los valores críticos en un correlograma. En la medida que el proceso generador de datos sea un proceso MA(q) gaussiano, la varianza de la autocorrelación estimada puede aproximarse por la siguiente expresión (véase Hamilton, 1994):

A partir de esta aproximación se construye el siguiente valor crítico:

Pensamos que es posible que la autocorrelación serial en exceso no se detecte usando valores críticos basados en el cálculo en (1), pues esta aproximación de la varianza es pobre en muestras pequeñas. En efecto, usando simulaciones de Monte Carlo evaluamos la potencia y el tamaño empírico de una prueba estadística basada en el valor crítico Vc para rechazar la hipótesis nula de que la función de autocorrelación sea coherente con la de un proceso MA(2).

Para ello construimos un proceso MA(2) calibrado a la serie de errores de proyección tres pasos hacia adelante, e igualmente construimos un proceso MA(7) también calibrado a la misma serie. Los pormenores de los procesos y del procedimiento numérico para calcular el tamaño y el poder de esta prueba se encuentra en el apéndice. El Cuadro 8 muestra los porcentajes de rechazo de la hipótesis nula de un MA(2) cuan do este es el verdadero proceso generador de datos.

El Cuadro 8 muestra que para los tamaños muestrales disponibles en el artículo, la prueba basada en el valor crítico Vc es más conservadora que lo deseado. En efecto, para el tamaño muestral de 79 observaciones la prueba rechaza incorrectamente la hipótesis nula en 8% de la ocasiones, cuando realmente está elaborada para rechazarla en 10% de las veces. La prueba es mucho más conservadora cuando dividimos la muestra en dos mitades. Para un tamaño muestral de 40 observaciones la prueba rechaza sólo 4% de las ocasiones.

El Cuadro 9 registra los porcentajes de rechazo de la hipótesis nula de un MA(2), cuando el verdadero proceso generador de datos es un MA(7). El Cuadro 9 muestra que una prueba basada en el valor crítico Vc tiene una potencia bajísima en una muestra pequeña. Así, al analizar la muestra completa de 79 observaciones, la prueba rechaza correctamente la hipótesis nula sólo en 62% de los casos. Al analizar la mitad de la muestra, esto es 40 observaciones, la prueba sólo rechaza 15% de las veces. La potencia de la prueba es notoriamente superior en la medida que el tamaño de muestra aumenta. En realidad la potencia es perfecta desde 500 observaciones hacia delante.

Estos resultados confirman que, para el tamaño de muestra disponible, es muy probable que un eventual exceso de autocorrelación pueda ser incorrectamente omitido al evaluar un correlograma con el valor crítico dado por Vc en proyecciones tres meses hacia adelante. Es interesante destacar que el valor numérico de la autocorrelación más alta en valor absoluto, de orden mayor que 2, crece hacia el final de la muestra. En efecto, de ser igual a 0.26 en la muestra completa, pasa a un valor de 0.27 en los últimos 40 datos, para ser luego 0.37 en los últimos 30 datos y ascender a 0.46 en los últimos 20 datos. Todo esto parece indicar que la hipótesis de exceso de autocorrelación hacia el final de la muestra tiene buenas posibilidades de ser cierta.

En resumen, la evidencia mostrada es clara en señalar que los errores de predicción de la EEE, un paso hacia adelante, presentan un sesgo y un exceso de autocorrelación que puede ser explotado para mejorar estas proyecciones. Con respecto a los errores de predicción tres pasos hacia adelante, la prueba es clara en relación con el sesgo presente en ellos, pero es algo ambigua en relación con el supuesto exceso de autocorrelación. Esto es así por-que dos de los ejercicios presentados hasta ahora son coherentes con la hipótesis de exceso de autocorrelación, mientras que un ejercicio no lo es.6

IV. Predicción de los errores de proyección

En esta sección se pretende explotar el sesgo y el exceso de autocorrelación que pueda

existir en los errores de predicción, con el objetivo de ajustar las

proyecciones originales de inflación sumándoles una adecuada predicción del

error que contienen las proyecciones. Formalmente se denota

Sea

entonces se obtiene que

en que

Para evaluar esta estrategia fuera de muestra, se procede de la siguiente manera: se divide la muestra total de errores de predicción en una ventana de estimación de tamaño R, y una de predicción de tamaño P = T +1 - R - (h -1) = T + 2 - R - h, en que T +1 denota el total de observaciones disponibles y h representa el horizonte de proyección pertinente. Con los primeros R datos disponibles se busca el mejor proceso AR(p) para los errores de proyección según el criterio del menor Akaike.8 Una vez especificado este proceso, se procede a la estimación y se genera una proyección h pasos hacia adelante para el error de proyección. Con esta predicción, se ajusta la proyección de inflación h pasos hacia adelante de acuerdo con la expresión (2). Posteriormente se procede a repetir este proceso descartando la primera observación y agregando la observación R +1 al proceso de selección y estimación del proceso Ar(p). En otras palabras, siempre se selecciona y se estima el modelo autorregresivo para los errores con base en una estrategia rodante con R observaciones. De esta manera se construyen P proyecciones de inflación ajustadas. Estas proyecciones ajustadas se comparan con las no ajustadas de acuerdo con las reducciones en sesgo y ECM. Un ejemplo en el que se muestra claramente como se construyen las proyecciones ajustadas tres meses hacia adelante se presenta en el apéndice.

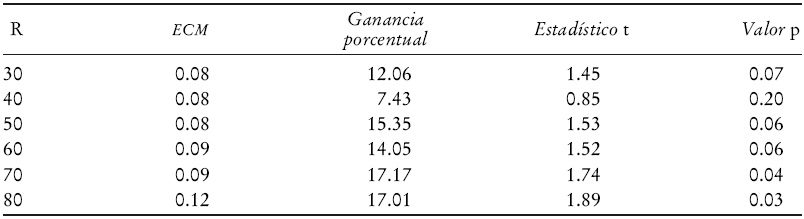

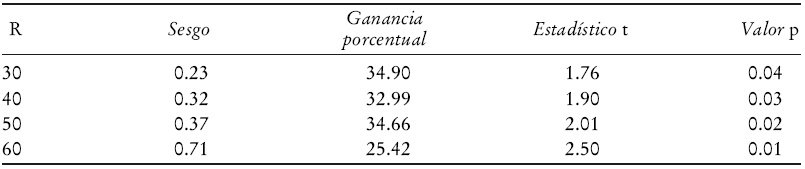

Debido a que los resultados pueden ser sensibles a la elección inicial del tamaño de la

ventana de estimación R, los Cuadros 10-13

registran las reducciones en ECM y en sesgo fuera de muestra obtenidas para

distintas elecciones de R. Finalmente cabe consignar que la

estimación de los procesos AR(p) se efectúa

con la siguiente versión de un estimador de Stein. Básicamente se estima por MCO

y luego se multiplica el vector MCO por un factor de reducción

a Número total de predicciones P = 100-R

Cuadro 10 Disminución del ECM en el error de predicción. Proyección un mes hacia adelante.a

El Cuadro 10 muestra la reducción en ECM que se obtiene al corregir las proyecciones un mes hacia adelante con base en el sesgo y exceso de autocorrelación que presentan los errores de proyección originales. Se observa que independientemente del tamaño de la ventana de estimación (R) siempre se obtiene una reducción en el ECM fuera de muestra. Esta reducción oscila entre 7.43 y 17.17% y en la mayoría de los casos es estadísticamente significativa a 10 o a 5%. Notemos que la significación estadística sube con el tamaño de observaciones usada para la primera estimación. Presumiblemente esto ocurre pues a finales del periodo de análisis se obtiene la principal reducción en el error de las proyecciones, tal como lo muestra la Gráfica 1.

El Cuadro 11 confirma que luego del ajuste propuesto el sesgo de las proyecciones siempre disminuye. Las reducciones en sesgo oscilan desde 10.87 hasta 27%. Cuando el número de observaciones usado para estimar los procesos es superior a 50 se observa que estas reducciones de sesgo son además estadísticamente significativas con una confianza de 95 por ciento.

a Número total de predicciones es P= 100 - R.

Cuadro 11 Disminución del sesgo en el error de predicción. Proyección tres meses hacia adelante.a

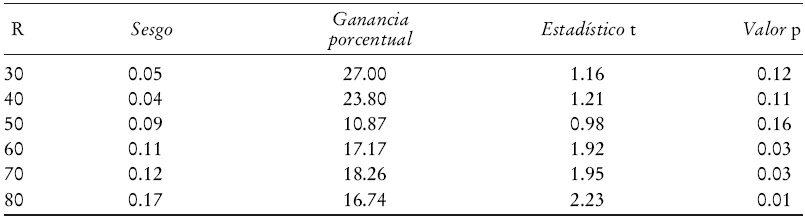

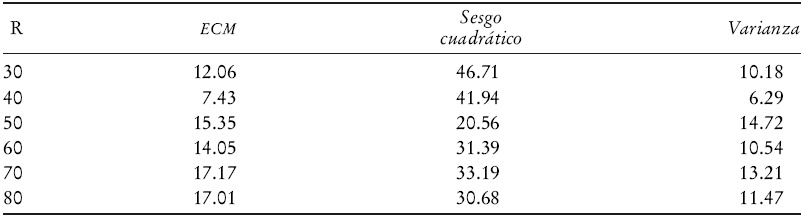

El Cuadro 12 es análogo al 10 pero ahora se considera a los errores de proyección tres meses hacia adelante. Se observa nuevamente que la corrección por sesgo y autocorrelación reduce el ECM fuera de muestra en al menos 16.87%. Además esta reducción es estadísticamente significativa a niveles de confianza usuales cuando el tamaño de la ventana de estimación considera al menos 40 observaciones. Se supone que esto ocurre pues es hacia finales del periodo de análisis que se obtiene la principal reducción en el error de las proyecciones, como lo muestra la Gráfica 2.

a Número total de predicciones es P = 79 - R - 2.

Cuadro 12 Disminución del ECM en el error de predicción. Proyección tres meses hacia adelante.a

El Cuadro 13 es análogo al 11 pero ahora se considera los errores de proyección tres meses hacia adelante. Se observa nuevamente que la corrección propuesta reduce el sesgo fuera de muestra en al menos 25.42%. Además, esta reducción es estadísticamente significativa a niveles de confianza usuales. En resumen, tanto en el caso de los errores de proyección un mes hacia adelante como en el caso de los errores de proyección tres meses hacia adelante, las reducciones de ECM y de sesgo obtenidas son importantes y muchas veces, además, estadísticamente significativas.

a Número total de predicciones es P = 79 - R - 2.

Cuadro 13 Disminución del sesgo en el error de predicción. Proyección tres meses hacia adelante.a

En un contexto en que diversos estudios empíricos, como el de Stock y Watson (2004), documentan lo difícil que resulta superar fuera de muestra al promedio simple de los pronosticadores, las ganancias de ECM presentadas en este trabajo pueden resultar llamativas. Al respecto, debe señalarse que los factores que principalmente inciden en las reducciones del ECM son cuatro: grado del exceso de autocorrelación que posean los errores originales, grado de sesgo de los errores, el tamaño de los errores originales y la tecnología de predicción de los errores que se cometerán en el futuro.

En particular, el hecho que las reducciones de ECM aquí presentadas sean importantes, aparentemente se basa en los tres primeros puntos mencionados en el párrafo anterior: el exceso de autocorrelación, el sesgo y el gran tamaño de los errores que han cometido los analistas en la proyección de la inflación desde que ésta comienza a alejarse del rango de tolerancia que tiene establecido el Banco Central de Chile.

La Gráfica 2 muestra que las importantes reducciones en los errores al ajustar por sesgo y autocorrelación parten en el segundo semestre del 2007. Esto coincide con el aumento de la inflación en Chile que sube de 3.23% en junio del 2007 a 9.48% en julio del 2008. Este proceso alcista ha sorprendido en apariencia a los analistas, quienes misteriosamente no han podido corregir de manera adecuada sus proyecciones.

Esto puede observarse en la Gráfica 3, que registra las ganancias obtenidas al ajustar por sesgo y autocorrelación. La curva corresponde a la diferencia entre el cuadrado de los errores de predicción originales y los ajustados. Valores positivos de la curva indican que el ajuste propuesto reduce el ECM. Valores negativos indican que el ajuste aumenta el ECM. Esta gráfica muestra que previo al alza de la inflación en Chile, el ajuste propuesto no era de gran ayuda. Sólo después del proceso alcista de la inflación este ajuste resulta realmente beneficioso.10

Resulta interesante también analizar si las ganancias en ECM aquí mostradas se deben fundamentalmente a reducciones en el sesgo o en la varianza de las proyecciones.11 Para esto es importante recordar que el ECM se puede escribir como la suma del sesgo de predicción al cuadrado y de la varianza del error de predicción:

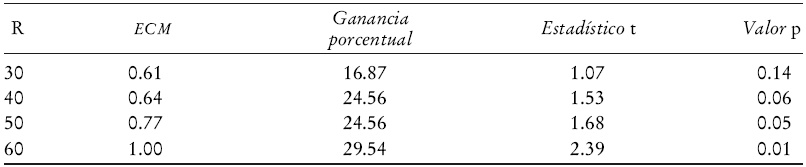

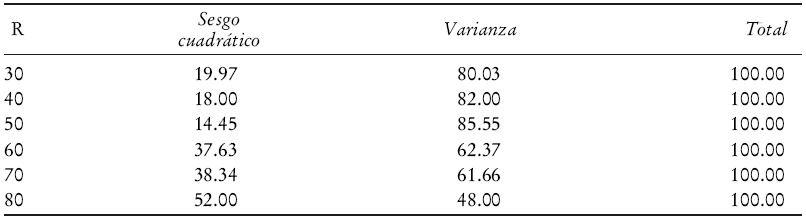

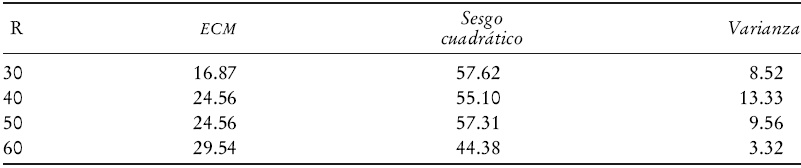

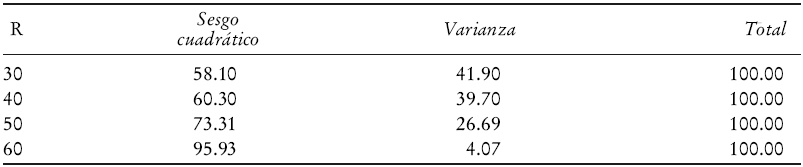

Los Cuadros 14-17 muestran dos resultados interesantes: i) se observa que las reducciones porcentuales en el sesgo cuadrático son siempre bastante mayores que las reducciones porcentuales en varianza, y ii) no obstante el primer punto, las reducciones en ECM de las proyecciones un mes hacia adelante son explicadas fundamentalmente por una reducción en la varianza del error de predicción y minoritariamente por una reducción en su sesgo cuadrático.12 Lo contrario ocurre con las proyecciones tres meses hacia adelante. En este caso las reducciones en ECM se explican fundamentalmente por la disminución del sesgo cuadrático y en menor medida por disminuciones en la varianza del error de predicción. La aparente paradoja entre los puntos i) y ii) mencionados en este párrafo se explica al constatar que en las proyecciones un mes hacia delante el sesgo encontrado es pequeño en magnitud. De esta manera, y aunque nuestra corrección reduzca en forma importante el sesgo, al ser éste pequeño desde un principio, su participación en las reducciones del ECM es moderada.

Cuadro 14 Disminución porcentual del ECM, sesgo cuadrático y varianza del error de predicción. Proyección un mes hacia adelante.

Cuadro 15 Participación porcentual del sesgo cuadrático y la varianza en la reducción del ECM. Proyección un mes hacia adelante.

Cuadro 16 Disminución porcentual del ECM, sesgo cuadrático y varianza del error de predicción. Proyección tres meses hacia adelante.

Cuadro 17 Participación porcentual del sesgo cuadrático y la varianza en la reducción del ECM. Proyección tres meses hacia adelante.

Finalmente se desea destacar que la tecnología de proyección de errores utilizada en el artículo es en extremo básica. Es posible pensar que con otro tipo de metodologías que incluyan un preprueba para determinar la conveniencia o no de ajustar, puedan generarse resultados aún mejores.

Conclusiones

En este trabajo hemos mostrado que la mediana de las proyecciones de inflación provenientes de la EEE ha presentado un problema de sesgo y de exceso de autocorrelación que ha sido particularmente notorio en el último periodo muestral. En un ejercicio fuera de muestra se observa que una fácil corrección de este sesgo y autocorrelación en exceso permite mejorar la calidad de estas proyecciones en términos de disminuir su ECM y su sesgo. Para los fines de este trabajo se ha instrumenta do un sistema de selección de modelos autorregresivo automático y extremadamente sencillo, pues se reduce a buscar el mejor modelo autorregresivo con base en el criterio de Akaike. Esto da pie para pensar que en el uso en tiempo real de esta estrategia, incluso mejores resultados podrían ser obtenidos si la identificación de la estructura autorregresiva de los errores fuera realizada con criterios más amplios.

A diferencia de muchos trabajos que evalúan proyecciones de acuerdo con el sesgo o exceso de autocorrelación en sus errores, aquí hemos mostrado que la ineficiencia detectada en las proyecciones de la EEE puede ser utilizada para generar nuevas y más precisas predicciones en un ejercicio fuera de muestra. Esto es importante, pues un hallazgo sencillo de sesgo o de exceso de autocorrelación dentro de muestra, no garantiza que estas ineficiencias puedan ser efectivamente aprovechadas para mejorar las proyecciones en tiempo real. A nuestro entender, el ejercicio fuera de muestra que aquí se realiza es eficaz en mostrar que el sesgo y exceso de autocorrelación detectado puede ser efectivamente utilizado para mejorar la tarea predictiva.

nueva página del texto (beta)

nueva página del texto (beta)