Introducción

Durante las últimas décadas, las necesidades de equidad, democracia y justicia se han instalado como demandas transversales en América Latina. Esto ha tensionado de forma directa el rol de la escuela en la formación de jóvenes capaces de participar activamente de los desafíos sociales (Unesco, 2016). A pesar de que la formación ciudadana corresponde a todos las disciplinas del aprendizaje escolar, las ciencias sociales son un área privilegiada en este propósito (Hahn, 2020; Ross, 2017; Levstik y Tyson, 2008).

Desafortunadamente, las evidencias en la literatura demuestran que la enseñanza de las ciencias sociales, más que favorecer el desarrollo de la formación ciudadana, resulta lejana para las y los estudiantes1 y basada en la reproducción de contenidos (Monte-Sano y Quince, 2021; Torrez y Claunch-Lebsack, 2014). Existe amplia discordancia entre los discursos de los docentes que declaran promover el aprendizaje crítico y reflexivo y la observación de sus prácticas en el aula, que revela un enfoque centrado en el profesor.

En evaluación, este enfoque se caracteriza por procedimientos centrados en el uso de la memoria y desalineados de los propósitos de aprendizaje, los cuales normalmente están basados en instrumentos de respuesta cerrada que no favorecen el desarrollo de habilidades (Smith, Breakstone y Wineburg, 2018; Torrez y Claunch-Lebsack, 2014). Por ejemplo, un estudio desarrollado con 25% de la población docente de la región de Murcia, España, indica que el 97% del profesorado de Historia y Geografía declaró que la evaluación a través de exámenes es la práctica más extendida y utilizada en el subsector (Alfageme-Gonzalez, Monteagudo y Miralles, 2016). Mientras que Grant (2017) es enfático en señalar que este tipo de evaluaciones a menudo carece de validez al focalizarse en listar personajes, lugares o eventos.

Debido a lo anterior, la literatura destaca la necesidad de estudiar empíricamente evidencias de validez de los instrumentos de evaluación diseñados para retroalimentar el aprendizaje en el aula de ciencias sociales (Smith, 2018; Smith, Breakstone y Wineburg, 2018). Esta investigación propone un instrumento de este tipo, particularmente para la evaluación del pensamiento social.

Evidencias de validez sobre las puntuaciones e instrumentos de evaluación en ciencias sociales

Entendiendo que la validez es un argumento derivado de evidencias que sostienen el uso e interpretación de las puntuaciones de un test (Kane, 2020), es posible recolectar evidencias sobre el contenido, los procesos de respuesta, la estructura interna, la relación con otras variables y las consecuencias de uso de un instrumento (American Educational Research Association, American Psychological Association y National Council on Measurement in Education, 2014). Algunos estudios se han concentrado en analizar este tipo de evidencias para las puntuaciones de instrumentos de evaluación que pretenden medir y retroalimentar algunas de las habilidades del pensamiento histórico o geográfico, que conforman el pensamiento social.

Debido a su extendido uso, los análisis han abordado principalmente instrumentos de respuesta múltiple. Smith (2017) y Reich (2011) examinaron evidencias sobre los procesos de respuesta de test estandarizados nacionales a través de procesos de pensamiento en voz alta, reconociendo que este tipo de instrumentos activaba constructos irrelevantes, tales como rememoración, comprensión de lectura y estrategias de respuesta a los test. A raíz de lo anterior, otras investigaciones analizaron evidencias de validez de instrumentos diseñados particularmente para evaluar el constructo de pensamiento histórico a través de preguntas de opción múltiple. Estos trabajos concluyen que, a diferencia de los test estandarizados nacionales, los de opción múltiple logran evocar habilidades de pensamiento histórico, aunque siguen movilizando constructos irrelevantes en las respuestas de los estudiantes (Smith, 2018; Smith, Breakstone y Wineburg, 2018; Reisman, 2012).

En respuesta a lo anterior, otros estudios han analizado formas alternativas para evaluar el pensamiento histórico, el pensamiento geográfico o algunas de sus habilidades de forma particular. Estos trabajos se han dedicado a recopilar evidencias sobre procedimientos evaluativos basados en desempeño durante la implementación de intervenciones pedagógicas que miden logros del estudiantado utilizando rúbricas (Huijgen, Holthuis, Van Boxtel, Van De Grift et al., 2019; Ercikan y Seixas, 2015; Monte-Sano y De La Paz, 2012).

En esta línea de investigación es posible reconocer las preguntas basadas en documentos, donde se entregan fuentes de información a los estudiantes para que luego elaboren un ensayo para demostrar su dominio del pensamiento histórico. Esta perspectiva ha sido valorada en países como Estados Unidos debido a la autenticidad de su medición, generando incluso test estandarizados (College Board, 2017). Sin embargo, las escasas investigaciones cuestionan su fiabilidad y su validez (p. ej., índices de consistencia interna entre .4 y .53; y consistencia entre jueces entre .67 y .71; Wainer, 2011; Grant, Gradwell y Cimbricz, 2004). De La Paz y Wissinger (2015) señalan que hay diferencias estadísticamente significativas (F (1, 101) = 6.206, MSE = 12.542, p = .01) en las puntuaciones de estas tareas dependiendo del género textual que solicitan y del nivel de conocimiento histórico de quienes responden; así como de la longitud de los escritos (F (1, 101) = 5.46, MSE = 24147.39, p = .02). De La Paz, Ferretti, Wissinger, Yee et al. (2012) reconocen mejores puntuaciones en habilidades de pensamiento histórico en los buenos escritores que en aquellos menos aventajados (F (3, 87) = 13.59, MSE = 4.48, p = .000). Este tipo de evidencias supone desafíos importantes para estos instrumentos estandarizados.

El reciente estudio de Supianto, Kumaidi y Suryono (2021) presenta mejores coeficientes de fiabilidad (.9) y evidencias positivas sobre el contenido y la estructura interna de las puntuaciones de un instrumento de estas características, pero a pesar de que también promueve la autenticidad de las evaluaciones, se limita a evaluar conocimiento histórico.

Los esfuerzos descritos coinciden con el interés por avanzar en una evaluación auténtica del aprendizaje de las ciencias sociales (Pearcy, 2017). Sin embargo, además de las dificultades presentadas, la mayoría se centra en evaluar el pensamiento histórico usando eventos del pasado, sin reconocer que los propósitos de aprendizaje se relacionan más bien con desarrollar habilidades de orden superior para comprender el mundo sociocultural desde las distintas disciplinas (Monte-Sano y Quince, 2021; Pearcy, 2017). Este artículo propone un instrumento para evaluar ese tipo de aprendizaje, considerando los desafíos ya descritos respecto de la medición del aprendizaje en el aula de ciencias sociales.

¿Qué se debe aprender en el aula de ciencias sociales?

Existen dos perspectivas que han caracterizado los aprendizajes en ciencias sociales. Por una parte, diversos autores han destacado que aprender una ciencia social, como historia o geografía, implica alfabetizarse en ella mediante el uso de un lenguaje académico y una forma de pensamiento disciplinar específico (Monte-Sano y De La Paz, 2012). Esta corriente ha generado una amplia producción teórica y empírica y su producción ha estado centrada en el desarrollo del pensamiento histórico (Henríquez, Carmona, Quinteros y Garrido, 2018; De la Paz, Monte-Sano, Felton, Croningeret et al., 2017; Monte-Sano y De La Paz, 2012). Su propósito principal se centra en promover el pensamiento de una disciplina en particular, más que una integración disciplinar.

En otra perspectiva se encuentran los estudios sociales, que plantean que la enseñanza y el aprendizaje de las ciencias sociales debe abordarse integradamente. Su fin principal es formar ciudadanos capaces de analizar críticamente la complejidad de la realidad social (McGlinn y Mason, 2017; Saye, 2017; Ross, 2017; Gerwin, 2003). Esto se materializa en la propuesta de los Estándares Curriculares para los Estudios Sociales (National Council for the Social Studies, 2013) de Estados Unidos. Allí se definen cuatro dimensiones de estándares relacionadas con el cuestionamiento de la sociedad, el análisis desde conceptos de las disciplinas, la interpretación de fuentes, y la comunicación y toma de decisiones sobre problemáticas sociales. Sin embargo, aunque el documento reconoce habilidades integradoras de las disciplinas, no se identifica un constructo general que permita visibilizar el aprendizaje que los estándares esperan desarrollar.

Desde ese desafío, la corriente iberoamericana ha defendido que el propósito principal de la enseñanza en el área es el desarrollo del pensamiento social. Este permite a las personas actuar como ciudadanos críticos de su realidad (Gutiérrez y Pagés, 2018; Murillo y Martínez, 2014; Pagés, 2002). Este pensamiento de orden superior permitiría que los estudiantes conciban la realidad como una síntesis compleja, que contextualicen la información social en sus múltiples dimensiones y que comprendan su realidad desde una perspectiva crítica y participativa (Gutiérrez y Pagés, 2018; Pagés, 2002; Pipkin y Sofía, 2005). Para promover este pensamiento, Pagés y Santisteban (2011) enfatizan en la necesidad de situar al estudiantado frente a problemas sociales relevantes y así abordar el aprendizaje de la complejidad social desde lo cotidiano.

Hacia una propuesta interdisciplinaria del aprendizaje en ciencias sociales

Según Gutiérrez y Pagés (2018), el pensamiento social se organiza en cuatro dimensiones denominadas “descripción del conocimiento social (CS)”, “explicación y justificación del CS”, “interpretación del CS” y “argumentación del CS”. Cada una está constituida por la integración de diversas habilidades disciplinares. De esta forma, al describir un problema social se espera que los estudiantes lo contextualicen en términos temporales, espaciales y desde el reconocimiento de agentes y dimensiones; cuando explican un problema, deberían desarrollar una cadena con diversas causas y consecuencias. Además, se busca que el alumnado interprete críticamente la evidencia disponible y que pueda definir una posición y plantear propuestas de solución frente a las problemáticas (Gutiérrez y Pagés, 2018; Murillo y Martínez, 2014).

Los contenidos descritos en cada una de las dimensiones del pensamiento social derivan, en su mayoría, de investigaciones sobre el pensamiento histórico, y una menor cantidad, de otras disciplinas o se posicionan en la perspectiva de los estudios sociales. Sin embargo, la complejidad que implica la integración de las disciplinas, la segmentación de evidencias y la falta de acuerdos respecto de qué se debe evaluar (Saye, 2017) son desafíos relevantes para la evaluación en el aula. Esta investigación busca reportar evidencias de validez de las puntuaciones de un instrumento diseñado para evaluar el pensamiento social de los estudiantes al egresar del sistema escolar, con el fin de guiar la retroalimentación del aprendizaje y aportar antecedentes que permitan avanzar en la consolidación del constructo en la evaluación de aula.

¿Cómo se describen las dimensiones del pensamiento social?

En la actualidad no existen instrumentos que permitan evaluar el pensamiento social como un constructo en sí mismo. No obstante, existe evidencia segmentada en diversos estudios respecto de las habilidades que lo componen en las diversas disciplinas (Monte-Sano y De La Paz, 2012; Reisman y Wineburg, 2008; Siegfried, Krueger, Collins, Frank et al., 2010).

La evidencia sobre habilidades específicas del pensamiento histórico, geográfico o económico aporta antecedentes sobre las dimensiones que componen el constructo de pensamiento social. A continuación, se describe esa evidencia para cada una de las dimensiones que, hipotéticamente, conforman el constructo de pensamiento social que se investiga en esta propuesta.

La dimensión contextualización de las problemáticas sociales (Huijgen, Van Boxtel, Van de Grift y Holthuis, 2017; Huijgen, Van de Grift, Van Boxtel y Holthuis, 2018; Huijgen et al., 2019; Reisman y Wineburg, 2008) representa aquello que hacen las personas cuando describen los problemas sociales y los sitúan en un marco temporal y espacial (Smith, 2014; Reagan, 2008; Miralles, Gómez y Monteagudo, 2012). Algunos autores presentan este proceso como parte de la explicación (Lee, 2009), pero otros lo reconocen como una habilidad en sí misma. Esta permitiría reconocer la complejidad de las interacciones entre los personajes, actores y entidades sociales (Huijgen et al., 2017 y 2018) en los ámbitos políticos, sociales, económicos y culturales (Ortuño, Ponce y Serrano, 2016; Siegfried et al., 2010).

La explicación de los problemas sociales se manifiesta cuando las personas argumentan por qué suceden los problemas y qué consecuencias tienen (Lee, 2009). Esto implica determinar las causas, motivaciones, hechos y consecuencias de los problemas sociales (Kemp, 2011). Las causas a las que se alude son diversas (Stoel, Van Drie y Van Boxtel, 2015; Miralles, Gómez y Monteagudo, 2012) y manifiestan distintos cambios y continuidades relacionadas con la problemática (Seixas, 2017). De igual forma, las personas empatizan, es decir, reconocen las motivaciones, incentivos o intereses de los agentes o actores sociales para explicar los problemas según sus contextos (Bartelds, Savenije y Van Boxtel, 2020; Henríquez et al., 2018; Siegfried et al., 2010; Smith, 2014). Finalmente, al determinar las causas de los problemas, los estudiantes juzgan procesos o eventos desde su significancia histórica (Barton, 2005; Seixas, 2017; VanSledrigfit y Limón, 2006) y utilizan metaconceptos y abstracciones en sus explicaciones (Siegfried et al., 2010; Van Drie y Van Boxtel, 2008).

La interpretación de las fuentes sobre problemas sociales implica que las personas se aproximan críticamente a las evidencias de información a través de la identificación de perspectivas y la diferenciación de hechos y puntos de vista (Reisman, Brimesk y Hollywood, 2019). Esto también implica incorporar evidencias para fundamentar una posición, corroborando y reformulando las fuentes y reconociendo sus autorías (Breakstone, Smith y Wineburg, 2013; Henríquez et al., 2018; McGrew, Breakstone, Ortega, Smith et al., 2018; Seixas, 2017).

Finalmente, la dimensión argumentación de propuestas permite fundamentar una posición respecto de un problema social (National Council for the Social Studies, 2013; Ross, 2019; Seixas, 2017) y elaborar propuestas o alternativas de decisión pertinentes (Gerwin, 2003). Estas ideas deberían reconocer contextos locales, regionales y globales (National Council for the Social Studies, 2013), riesgos, el principio de escasez (Siegfried et al., 2010), críticas a la desigualdad (Pedrozo, 2011) y promoción del bienestar común de la sociedad (Niepel, Mustafić, Greiff y Roberts, 2015); también deberían estar basadas en un enfoque de derechos, democrático, en perspectiva de equidad y una ética centrada en el bien común (Levy, 2018; Ross, 2019; Seixas, 2017). Asimismo, las propuestas requieren ser concretas, lo que implica reconocer en ellas el rol que los actores sociales desempeñan en su implementación (Evans y Saxe, 1996).

La propuesta planteada a continuación presenta un instrumento que pretende evaluar el pensamiento social en el aula, junto a las evidencias psicométricas sobre la validez de sus puntuaciones.

Método

Desde un enfoque cuantitativo y en la perspectiva de un análisis psicométrico, se describe la construcción y el proceso de recolección de evidencias de validez (American Educational Research Association, American Psychological Association y National Council on Measurement in Education, 2014) de las puntuaciones de un instrumento diseñado para evaluar el pensamiento social de los estudiantes egresados de la educación secundaria. En una primera etapa se describe el diseño del instrumento y, en la segunda, se presenta el proceso de recolección de evidencias de validez.

El estudio espera reportar evidencias favorables respecto del contenido, fiabilidad entre jueces y consistencia interna de las puntuaciones, además de evidencias sobre la estructura interna de cuatro dimensiones que componen el constructo, con el fin de retroalimentar el pensamiento social. Asimismo, se espera observar relaciones positivas entre las puntuaciones del instrumento y el rendimiento académico de las y los estudiantes en el contexto escolar; aunque no se espera observar relaciones con el género.

Etapa 1. Diseño del instrumento

El instrumento se diseñó siguiendo el modelo del Bear Assessment System (BAS) (Wilson, 2005), a través de las siguientes etapas: a) definir los cuatro mapas de constructo para cada una de las dimensiones de pensamiento social (contextualización, explicación, interpretación y argumentación de propuestas); b) diseñar la tarea de desempeño; c) diseñar la rúbrica; y d) implementar el modelo de medición para recopilar evidencias de validez.

Esta primera versión del instrumento fue desarrollada por un equipo de especialistas en didáctica de las ciencias sociales, a partir de una propuesta teórica (Gutiérrez y Pagés, 2018; Pagés, 2002) y de evidencia empírica sobre las habilidades de las dimensiones y de las habilidades que lo componen. El contenido de las cuatro primeras etapas fue analizado a través del juicio de expertos, en este caso, tres especialistas externos al equipo de investigación. El modelo de medición fue implementado por el equipo de autoras.

Etapa 2. Recopilación de evidencias de validez empíricas

Muestra

El instrumento fue aplicado a una muestra por conveniencia de 175 estudiantes egresados de educación media en Chile, durante la primera semana de clases en una universidad pública y selectiva. Todos estudiaban carreras de pedagogía, donde 74% fueron mujeres y 36% varones, con una edad entre 17 y 20 años, y de diversos contextos socioeconómicos. En ese sentido, los resultados no esperan ser representativos de la población de egresados de educación secundaria chilena.

Aplicación y corrección

Tras un proceso de capacitación, los aplicadores siguieron un protocolo estandarizado para la implementación del instrumento utilizando la plataforma Moodle (versión 3.7). Al inicio de la aplicación, se leyó y firmó el consentimiento informado por parte de los participantes. Posteriormente, los estudiantes contaron con 90 minutos para responder el instrumento descrito más adelante.

La revisión se realizó con cinco correctores capacitados, quienes corrigieron en forma simultánea después de un periodo de calibración. Un 30% de los discursos fueron corregidos por dos jueces independientes.

Análisis de evidencias de validez

Para analizar las puntuaciones se exploró su fiabilidad, evidencias de validez en términos de su estructura interna y su relación con otras variables. La mayoría de los análisis fueron realizados a través del programa Rstudio versión 3.6.0, aunque el análisis de ítems se realizó con el software Berkeley Assessment System Sofware (BASS) (Fisher y Wilson, 2019).

Fiabilidad del instrumento

Después de constatar una distribución aproximadamente normal del puntaje total del instrumento, se realizó un análisis de fiabilidad, a partir de un examen de consistencia interna a través de alfa de Cronbach (Raykov, 1998) para cada una de las dimensiones del instrumento. Adicionalmente, se hizo la estimación de la fiabilidad a través del indicador expected a-posteriori (EAP), debido a su mayor pertinencia en el contexto de los análisis de teoría de respuesta al ítem (IRT, por sus siglas en inglés) (Adams, 2005).

Finalmente, el análisis de kappa de Cohen (Embretson, 2010) se utilizó para analizar la fiabilidad entre jueces en el 30% (N = 52) de los casos con doble corrección.

Análisis de ítems

Después de analizar la estructura de la matriz de correlaciones se analizó el comportamiento empírico de los ítems que componen las cuatro dimensiones del pensamiento social. Se llevó a cabo un análisis IRT con base en un modelo de crédito parcial por la naturaleza politómica de las categorías de respuesta del instrumento (Wilson, 2005). Una vez realizada la comparación de los modelos multidimensional y unidimensional, se analizó la dificultad de los ítems y el indicador rho de Spearman de cada dimensión. Adicionalmente, se elaboró un mapa de Wright con el fin de reconocer la relación entre la dificultad de los ítems y la probabilidad de los sujetos de responder en los distintos niveles de logro (Wilson, 2005).

Análisis factorial

Con el fin de analizar la estructura interna del instrumento con mayor profundidad, se aplicó un análisis factorial confirmatorio (AFC). El ajuste del modelo fue estudiado por medio de los índices RMSEA, CFI, TLI, SRMS (Hooper, Coughlan y Mullen, 2008). Para el AFC se exploró un modelo de uno y cuatro factores; mientras que el unidimensional representa la hipótesis nula, y el de cuatro dimensiones corresponde a la hipótesis propuesta por el modelo teórico.

Relación con género y rendimiento académico de los estudiantes

Después de examinar la estructura interna del instrumento, se implementó un modelo estructural para estudiar la relación entre las dimensiones del pensamiento social y algunas variables relevantes, como el ranking de notas (calificaciones) de educación secundaria y el género de los estudiantes. El ranking de notas utilizado en el proceso nacional de admisión fue considerado como un proxi del rendimiento académico de los estudiantes, ya que, a diferencia de las calificaciones en sí y de la Prueba de Selección Universitaria, dicho ranking de educación secundaria considera el desempeño de los estudiantes en relación con su contextos educativos y oportunidades de aprendizaje (Larroucau, Ríos y Mizala, 2015). El género, por su parte, fue incorporado debido a la evidencia respecto de la brecha favorable a niñas y mujeres jóvenes en las habilidades de escritura académica y lengua (Cervini, Dari y Quiroz, 2015; Contreras-Salinas, Olavarría Aranguren, Celedón Bulnes y Molina Gutiérrez, 2020). Una relación positiva entre ser mujer y tener un mayor desarrollo del pensamiento social no constituiría evidencia a favor de la validez del instrumento.

Se analizó la relación de las puntuaciones del instrumento con género y el ranking de notas a través de un modelo de ecuaciones estructurales (Schreiber, Nora, Stage, Barlow et al., 2006). Para estudiar el ajuste del modelo, se utilizaron los índices RMSEA, CFI, TLI, SRMS (Hooper, Coughlan y Mullen, 2008).

Resultados

Las evidencias presentadas a continuación aportan antecedentes a favor y de mejora respecto de la validez de las puntuaciones del instrumento diseñado para evaluar el pensamiento social de los estudiantes desde una perspectiva interdisciplinaria del aprendizaje de las ciencias sociales. Los resultados se presentan en dos secciones: en primer lugar, se describe el diseño del instrumento respecto de los tres primeros elementos del modelo BAS y luego se presentan los resultados del cuarto elemento, el análisis psicométrico.

Etapa 1. Diseño del instrumento

El instrumento consistió en un problema socialmente relevante (Pagés y Santisteban, 2011) presentado en una carpeta de fuentes de información de diversa naturaleza (noticias, extractos de libros de historia, gráficos, etc.) y una consigna de instrucciones que solicitaban la elaboración de un discurso escrito usando el computador. Para evaluar el discurso hecho por los estudiantes, se confeccionó una rúbrica analítica con 18 criterios relacionados con el constructo y graduados entre 0 a 3 (anexo 1).

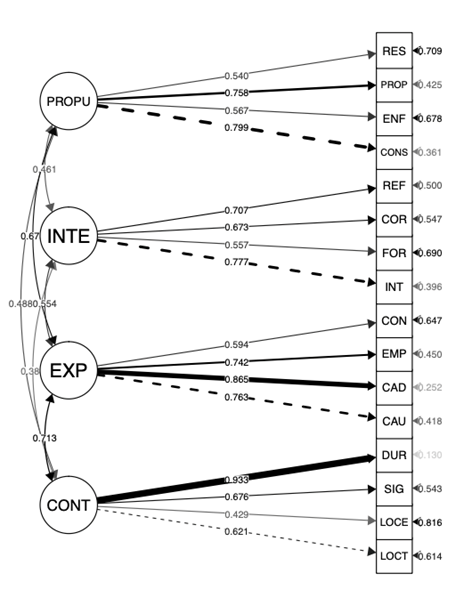

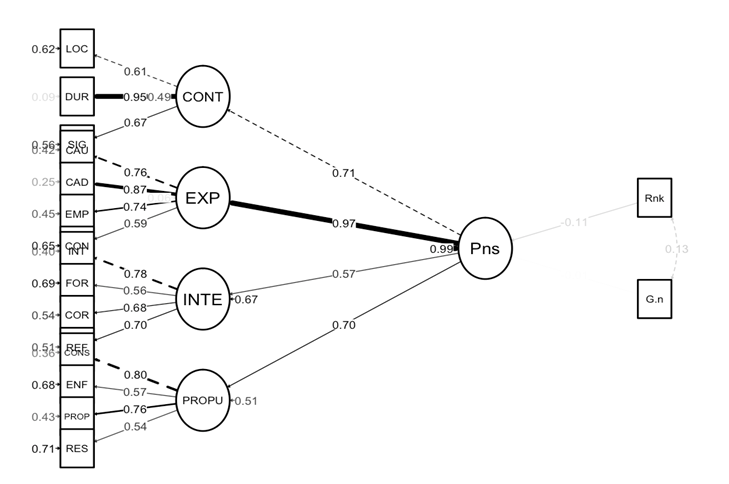

El instrumento consta de tres partes: en la primera, los estudiantes leen el contexto y el problema socialmente relevante presentado (Figura 1). Posteriormente, deben leer diferentes fuentes de relacionadas con el problema y extraer información considerada relevante. Finalmente, el instrumento pide a los estudiantes escribir su discurso a través de una breve consigna que orienta sobre los elementos que debe considerar el discurso y el tiempo para desarrollarlo (Figura 2).

Fuente: instrumento diseñado para esta investigación.

Figura 1 Planteamiento del problema socialmente relevante

Fuente: instrumento diseñado para esta investigación.

Figura 2 Instrucciones para desarrollo de la tarea

Las respuestas de los estudiantes demostraron cumplir con la idea de elaboración de un discurso, con 30 líneas en promedio y basados en la estructura indicada en las instrucciones. En la Figura 3 se presenta un extracto de la respuesta de un estudiante.

Fuente: Respuesta de un estudiante participante en esta investigación.

Figura 3 Extracto de respuesta

Cada uno de los discursos fue evaluado con la rúbrica analítica (anexo 1). En la dimensión contextualización fue evaluada la localización tanto temporal como espacial, actores y ámbitos. En la explicación se evaluó multicausalidad, cadena causal, empatía, conceptualización, significancia histórica y duración. Para la interpretación de fuentes los criterios fueron perspectiva, corroboración, forma de la fuente y referenciación. Y para el caso de la argumentación de propuestas, los criterios fueron acción de los agentes, propuesta, enfoque de derechos y posicionamiento.

Tanto el diseño de la tarea como los criterios de la rúbrica fueron analizados en su contenido por tres especialistas en didáctica de las ciencias sociales, reunidos en sesiones de discusión grupal. Ellos coincidieron respecto de la capacidad del instrumento de evaluar el pensamiento social y discriminar usando los criterios propuestos.

Etapa 2. Recopilación de evidencias de validez empíricas

Consistencia del instrumento

Los estadísticos descriptivos del instrumento muestran que los puntajes totales de los estudiantes van desde 5 hasta 87% de logro. La consistencia interna del instrumento es aceptable, aunque los resultados son mejores en su estimación a través del método EAP para todas las dimensiones (Tabla 1) que utilizando alfa de Cronbach (Tabla 2); este último análisis permite identificar que la dimensión contextualización presenta una fiabilidad menor a la óptima que requiere ser revisada a la luz de las demás evidencias.

Tabla 1 Fiabilidad EAP

| Contextualización | Explicación | Interpretación de fuentes |

Argumentación de propuesta |

|---|---|---|---|

| 0.86 | 0.89 | 0.80 | 0.82 |

Fuente: elaboración propia.

Tabla 2 Fiabilidad por alfa de Cronbach

| Contextualización | Explicación | Interpretación de fuentes |

Argumentación de propuesta |

|---|---|---|---|

| 0.61 | 0.86 | 0.80 | 0.78 |

N=175.

Fuente: elaboración propia.

La confiabilidad entre jueces presenta resultados favorables. Para los 51 casos evaluados por doble juez, el índice de acuerdo total alcanza el 92%. Adicionalmente, se observa un kappa de Cohen donde todos los ítems superan 0.81, aunque uno de ellos (significancia histórica) presenta una estimación de 0.73, en un intervalo de confianza que va desde 0.56 a 0.90 (Tabla 3). Esto alerta sobre la necesidad de revisar el ítem a la luz de otras evidencias.

Evidencias de validez sobre la estructura interna del instrumento

Al analizar la matriz de correlaciones entre dimensiones (Tabla 4), se identificaron relaciones moderadas entre las del instrumento, excepto por la alta correlación (0.8) entre las dimensiones contextualización y explicación. Sobre esos antecedentes, se continuó el análisis de la estructura interna del instrumento de evaluación, a través de dos tipos de análisis: de ítems y AFC.

Tabla 4 Correlaciones entre dimensiones*

| Contextualización | Explicación | Interpretación de fuentes |

Argumentación de propuestas |

|

|---|---|---|---|---|

| Contextualización | 1 | |||

| Explicación | 0.80 | 1 | ||

| Interpretación

de fuentes |

0.46 | 0.40 | 1 | |

| Propuestas | 0.40 | 0.52 | 0.34 | 1 |

* p = 0 para todas las correlaciones, indica que las correlaciones son estadísticamente significativas.

Fuente: elaboración propia.

Análisis de ítems

Con el fin de analizar la estructura interna del instrumento, se comparó el modelo teórico de cuatro dimensiones con el unidimensional, usando el modelo IRT (Wilson, 2005).

El análisis rechaza la hipótesis planteada por el modelo unidimensional, lo que permitió considerar el teórico de cuatro dimensiones, observándose diferencias estadísticamente significativas entre ambos modelos (p = 0, χ² = 253, gl = 9), con una ventaja en todos los índices de ajuste por parte del modelo multidimensional (Tabla 5). En ese sentido, fue posible sostener que el pensamiento social es un constructo compuesto por cuatro dimensiones.

Tabla 5 Comparación del modelo unidimensional y multidimensional*

| Modelo | loglike | Deviance | Npars | Nobs | AIC | BIC | SRMR | pmaxX2 |

|---|---|---|---|---|---|---|---|---|

| Multidimensional (4 dimensiones) |

-2982 | 5 963 | 82 | 175 | 6 127 | 6 387 | 0.089 | 1.2e-12 |

| Unidimensional | -3108 | 6 216 | 73 | 175 | 6 362 | 6 593 | 0.124 | 5.8e-07 |

* p = 0, χ² = 253, gl = 9.

Fuente: elaboración propia.

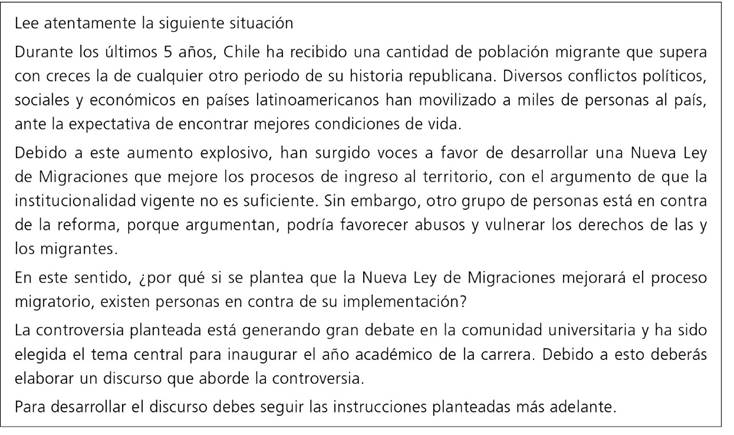

Al profundizar en el análisis del modelo IRT multidimensional desde los mapas de Wright de cada dimensión (Figura 4) y la estimación de rho de Spearman fue posible identificar que la distribución de las dificultades de los ítems se comporta de acuerdo con la hipótesis planteada. Los estudiantes y los ítems se distribuyen en todo el espacio de respuesta de cada dimensión. En las cuatro dimensiones, el índice de relación entre la hipótesis y los resultados es alta (rho de Spearman > 0.71). En la dimensión de interpretación de fuentes el nivel de correlación es aún mayor (rho de Spearman > 0.91). En ese sentido, la mayoría de los ítems en cada dimensión se distribuye en forma coherente con la hipótesis planteada, y las categorías de logro esperadas en los ítems coinciden con la dificultad empírica presentada. Sin embargo, la dimensión contextualización presentó dificultades respecto de su hipótesis inicial. El ítem localización geográfica (GEOL) omitió la representación de uno de los niveles de logro, debido a que ninguno de los estudiantes demostró su desempeño en el nivel 0. Adicionalmente, es posible reconocer que casi todos los ítems demuestran niveles de ajuste apropiados (0.75> infit >1.33), excepto los correspondientes a significancia histórica (infit >1.33) y conceptualización (infit >1.33), ambos estadísticamente significativos (p ≤ 0.05). El primero de ellos presentó dificultades en el nivel 1 y el segundo en el nivel 2 de la rúbrica de evaluación.

Sobre la dificultad de los ítems, el más fácil de lograr fue el de empatía (-1.78), mientras que el más difícil fue acción de los agentes (1.81). Esto implica que para alcanzar los distintos niveles del ítem empatía no es necesario tener un nivel de pensamiento social muy alto, mientras que para lograr los niveles del ítem acción de los agentes se requiere un alto desarrollo de la habilidad.

Análisis factorial confirmatorio

En el caso de la estructura factorial también se probó un modelo unidimensional y otro de cuatro factores (Gutiérrez y Pagés, 2018). En ambos casos el análisis demuestra que el índice chi cuadrado no es significativo (p = 0.000) y que por tanto se rechaza la hipótesis nula de una incorrecta especificación de los modelos. Adicionalmente, al analizar el ajuste de ambos modelos fue posible identificar que los índices de bondad de ajuste RMSEA, CFI, TFI y SMRM se encuentran fuera de los rangos esperados (Tabla 6). Estos antecedentes, junto al examen de las cargas factoriales del modelo teórico, la fiabilidad de las dimensiones, la correlación entre dimensiones y la representación de la matriz de correlaciones entre ítems podrían sugerir que el modelo teórico inicial no está logrando diferenciar entre las dimensiones contextualización y explicación.2

Tabla 6 Índices de ajuste. Modelo factorial confirmatorio*

| Modelo unidimensional |

Modelo 4 dimensiones |

Modelo 3 dimensiones |

Modelo 4 dimensiones modificado |

|||

|---|---|---|---|---|---|---|

| Modelo con relación entre factores |

RMSEA | < 0.08 -0.06 | 0.139 | 0.108 | 0.109 | 0.080 |

| CFI | > 0.95 | 0.673 | 0.812 | 0.804 | 0.900 | |

| TLI | > 0.95 | 0.629 | 0.777 | 0.772 | 0.877 | |

| SRMR | < 0.08 | 0.104 | 0.080 | 0.082 | 0.072 | |

*N=175.

Fuente: elaboración propia.

Profundizando en los resultados, se observó que algunos de los criterios de la dimensión explicación estaban describiendo la temporalidad del problema, más que dando cuenta de las causas que lo generan. Por esto se exploró un nuevo modelo de cuatro dimensiones “modificado”. La nueva hipótesis implicó reconstruir la dimensión contextualización manteniendo los criterios de localización temporal y localización geográfica, pero incorporando los criterios de significancia histórica y de duración (originalmente de la dimensión explicación). Se testeó este modelo debido a que la revisión de la rúbrica permitió identificar que ambos criterios no estaban permitiendo indagar las explicaciones de los estudiantes, sino más bien elementos contextuales que describían los problemas en sus relatos. A partir de dicha reagrupación, el modelo de cuatro dimensiones modificado (Figura 5) permitió identificar una mejora considerable en los índices de ajuste (ver tabla 6), aunque todavía sin lograr niveles de ajuste óptimos.

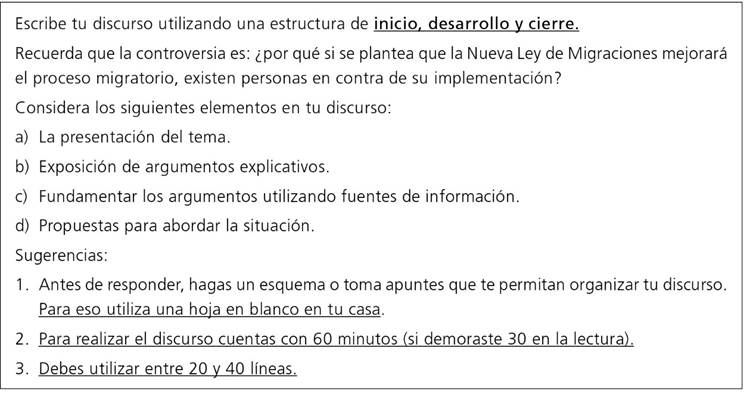

Evidencias de validez sobre relación con el género y el rendimiento académico

Contando con cierta evidencia respecto de la estructura multidimensional del modelo ajustado, se realizó un análisis basado en el modelo de ecuaciones estructurales, para relacionar las dimensiones del pensamiento social con el género de los estudiantes y el ranking de notas de la educación secundaria de los estudiantes. Se hipotetizaba una relación estadísticamente significativa y positiva de los puntajes de las dimensiones del pensamiento social con el ranking de notas y una relación no estadísticamente significativa con el género. En ese sentido, se esperaba que alumnos de rendimiento escolar relativamente superior tuvieran mejor desempeño en el instrumento diseñado. Al mismo tiempo, se esperaba que las mujeres tuvieran mejores puntuaciones que los varones.

Los índices de ajuste del modelo se consideran aceptables (χ² = 212,48, p = 0.000, gl = 114) (Tabla 7), aunque dos de ellos están levemente por debajo de los parámetros esperados.

Tabla 7 Índices de ajuste Modelo de Ecuaciones Estructurales*

| Modelo probado | |||

|---|---|---|---|

| Índices de ajuste | RMSEA | < 0.08 -0.06 | 0.071 |

| CFI | > 0.95 | 0.897 | |

| TLI | > 0.95 | 0.878 | |

| SRMR | < 0.08 | 0.071 | |

*N = 175. Método de estimación oblicua.

Fuente: elaboración propia.

Respecto del modelo estructural (Figura 6), es posible inferir que la relación entre el pensamiento social y el puntaje ranking de notas (Rkg) de los estudiantes no es estadísticamente significativa (p > 0.05). Tampoco existe evidencia de una relación estadísticamente significativa entre los puntajes del constructo y el género (G.n) de los estudiantes (p > 0.05).

Discusión y conclusiones

La enseñanza de las ciencias sociales se enfrenta hoy a importantes obstáculos, debido en gran medida a que las prácticas de enseñanza y evaluación del profesorado continúan centradas en el desarrollo de aprendizajes reproductores de información (Torrez y Claunch-Lebsack, 2014). Ante estos obstáculos, la investigación ha avanzado en dos perspectivas: la disciplinaria y la interdisciplinaria del aprendizaje desde los estudios sociales.

La perspectiva interdisciplinaria de los estudios sociales se ha propuesto avanzar en promover el pensamiento social en los estudiantes desde la integración de habilidades de las ciencias sociales (Gutiérrez y Pagés, 2018). Sin embargo, las investgaciones sobre el qué y cómo medir y evaluar el aprendizaje de las ciencias sociales siguen centrándose en una perspectiva disciplinaria (pensamiento histórico, por ejemplo) de forma específica y continúan presentando desafíos sobre la validez y fiabilidad de las puntuaciones (Smith, Breakstone y Wineburg, 2018; Wainer, 2011; Grant, Gradwell y Cimbricz, 2004).

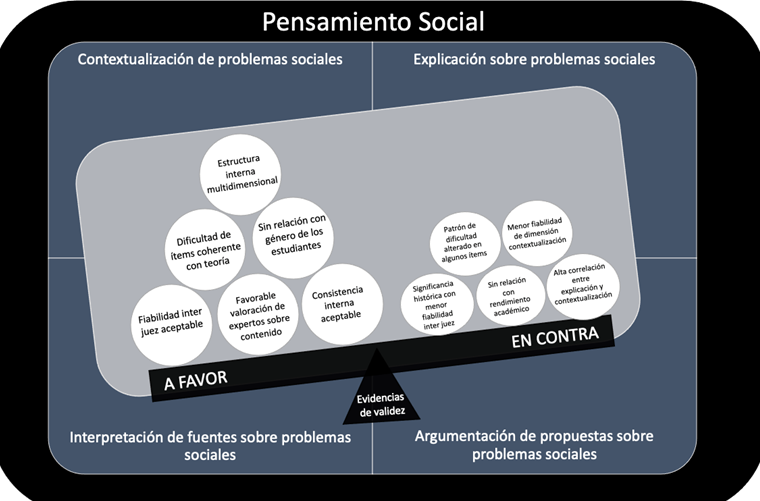

Este estudio informa sobre el diseño de un instrumento de evaluación capaz de medir y retroalimentar el aprendizaje en el aula según los especialistas siguiendo las tres primeras etapas del método BAS (Wilson, 2005). Además, presenta evidencias sobre la validez de sus puntuaciones, aportando antecedentes para el desarrollo de evaluaciones de desempeño capaces de orientar a los estudiantes de manera integrada respecto de sus habilidades para contextualizar, explicar, interpretar y argumentar sobre problemas sociales. Esto se hace a partir de las puntuaciones asignadas a las respuestas del instrumento por medio de un modelo IRT, tal como se describe en la cuarta y última etapa del método de BAS. Los hallazgos a favor del argumento sobre validez de las puntuaciones para la evaluación en aula (Kane, 2020) permiten avanzar hacia la consolidación de un referente evaluativo más coherente con los propósitos de la enseñanza de las ciencias sociales (Pearcy, 2017; Torrez y Claunch-Lebsack, 2013). La Figura 7 sintetiza esos principales logros, pero también presenta las evidencias débiles, con el fin de orientar su mejora.

Fuente: elaboración propia.

Figura 7 Evidencias a favor y en contra de la validez de las puntuaciones del instrumento

Las evidencias sustentan un constructo multidimensional, con grados aceptables de consistencia y fiabilidad entre jueces, que logra identificar niveles de logro coherentes con las hipótesis definidas, y relaciones plausibles con otras variables. Sin embargo, a pesar de que las evidencias son positivas a la luz de hallazgos previos (Wainer, 2011; Grant, Gradwell y Cimbricz, 2004), existen desafíos que deben ser atendidos.

La propuesta diseñada para evaluar el pensamiento social

El instrumento consiste en una situación de desempeño escrita basada en un problema socialmente relevante. El ensayo elaborado por el estudiante es analizado a través de una rúbrica que permite identificar las habilidades de pensamiento social mediante 18 criterios derivados de cuatro dimensiones: la contextualización, la explicación, la interpretación de las fuentes y la argumentación de propuestas (Gutiérrez y Pagés, 2018; Pipkin y Sofía, 2005). El análisis de expertos evaluó positivamente las posibilidades del instrumento y la rúbrica de medir el pensamiento social con el fin de retroalimentar su aprendizaje en el aula de ciencias sociales.

Confiabilidad aceptable con posibilidades de mejora

A diferencia de los resultados de fiabilidad presentados por Wainer (2011), se observa que el instrumento presenta puntuaciones estables, tanto en su consistencia interna como en el acuerdo de los jueces. Esto indicaría que los resultados son consistentes y que no dependen de quién utilice el instrumento. Además, el modelo multidimensional presenta una fiabilidad aceptable para cada una de las dimensiones. Se observa, sin embargo, menor nivel de fiabilidad para la correspondiente a contextualización, lo que podría estar relacionado con que esta dimensión requiere movilizar otras habilidades como la escritura o la lectura, más que en las otras (De La Paz et al., 2012).

Por otra parte, se debe precisar la descripción de los niveles de logro del ítem significancia histórica, ya que presenta niveles de acuerdo entre jueces menores al resto de los ítems. Aunque los resultados respecto de confiabilidad son más altos que aquellos de otras mediciones (Wainer, 2011), es posible reconocer posibilidades de mejora. Por ejemplo, el nivel dos de la rúbrica en este ítem indica que se incorporan eventos o procesos históricos que “no tienen un rol clave en la explicación”. Esta falta de precisión en la descripción podría estar dando espacio a interpretaciones particulares de los jueces, lo que podría explicar la falta de acuerdo y diferencias entre puntuaciones.

Un constructo multidimensional y el desafío de la dimensión contextualización

Los análisis realizados reconocen la estructura multidimensional del pensamiento social, pero también sugieren posibilidades de mejora. La dimensión contextualización se relaciona de forma estrecha con la de explicación, lo que podría implicar que los ítems que las componen no están diferenciando la intencionalidad de ambos factores por separado (contextualizar y explicar, respectivamente).

La dimensión contextualización pretende reconocer cómo los estudiantes describen los antecedentes del problema social, considerando su marco temporal y espacial, junto con los ámbitos y actores en que se manifiesta el problema (Gutiérrez y Pagés, 2018); mientras que la correspondiente a explicación busca reconocer las causas y consecuencias que los estudiantes despliegan para explicar los problemas sociales, reconociendo las motivaciones de los actores, la nominalización de los procesos y el reconocimiento de ciertos eventos históricos. A pesar de que algunos autores (Lee, 2009) plantean que las habilidades de explicación podrían contener las de contextualización, los análisis demuestran que el modelo que unifica ambas dimensiones no logra mejores índices de ajuste que el modelo de cuatro. Es por esto que próximas investigaciones deberían profundizar en la examinación de estas dimensiones.

Sin embargo, el análisis realizado podría aportar antecedentes relevantes para diferenciar ambas dimensiones. Por ejemplo, los ítems agentes (de la dimensión contextualización) y empatía (de explicación) requieren ser precisados. Cuando la rúbrica aborda el ítem agentes indica en el nivel máximo que “incorpora actores, agrupaciones y/o instituciones relacionadas de forma directa e indirecta en la descripción de la problemática, que intervienen y toman decisiones sobre la problemática”. No obstante, esta descripción se relaciona directamente con la habilidad de empatía, ya que implica reconocer las motivaciones y posiciones de los actores para desarrollar una determinada acción social. Esto último es también parte de las explicaciones que realizan los estudiantes sobre los problemas sociales. En ese sentido, una próxima versión del instrumento debería diferenciar con mayor claridad el ítem agentes del de empatía.

Ítems por mejorar: localización geográfica y conceptualización

Se identificaron otras problemáticas en algunos ítems de las dimensiones contextualización y explicación. Como se comentó previamente, el puntaje 0 del ítem localización geográfica no fue identificado en ninguno de los discursos de los estudiantes. Esto implica la necesidad de reconfigurar dicha descripción, debido a que posiblemente está representando niveles poco plausibles para la edad de los estudiantes.

En el caso del ítem conceptualización se reconocen problemas en el patrón de dificultad de los ítems. Entre las posibles causas se puede reconocer que la rúbrica no diferencia entre los niveles dos y tres la utilización de los denominados metaconceptos o conceptos de segundo orden que proponen Van Drie yVan Boxtel (2008), lo que podría estar interfiriendo en la distribución de la dificultad de ambos niveles de logro.

Coherencia entre la construcción teórica y la evidencia empírica

A pesar de que se observaron algunas necesidades de mejora, es posible reconocer logros relevantes al definir los criterios para evaluar el pensamiento social. Además de la consistencia interna y la confiabilidad entre jueces que se reporta, es relevante mencionar que la evidencia apoya la conceptualización del pensamiento social como un constructo multidimensional.

Adicionalmente, se identifica que la mayoría de los ítems presentan una distribución de la dificultad coherente con la hipótesis diseñada. Esto implica que los niveles de logro que se esperaban fueran de menor dificultad efectivamente así se presentaron. Lo mismo sucede con los niveles de logro de mayor dificultad. Es decir, se observan evidencias a favor de las puntuaciones del instrumento.

La inexistente relación entre pensamiento social, género y rendimiento académico

En el análisis fue posible identificar que el género no tiene una relación estadísticamente significativa con las puntuaciones del test. Si bien este es un antecedente relevante, es importante corroborar estas conclusiones en otros estudios, debido a la amplia literatura disponible con respecto a las brechas de género que favorecen a las mujeres en el área de la lengua y las humanidades (Cervini, Dari y Quiroz, 2015; Contreras-Salinas et al., 2020).

Adicionalmente, la inexistencia de relaciones estadísticamente significativas entre las puntuaciones del instrumento y las calificaciones de los estudiantes en la escuela podrían explicarse por las dinámicas reproductivas y memorísticas del aprendizaje que están ampliamente documentadas en el sistema escolar de diversos países (Torrez y Claunch-Lebsack, 2013). Es sabido que esas prácticas evaluativas “premian” en sus calificaciones a estudiantes capaces de responder a esa dinámica, más que a aquellos que logran demostrar un pensamiento más complejo (Pearcy, 2017). En ese sentido, los hallazgos subrayan la importancia de continuar explorando la potencialidad del pensamiento social para promover aprendizajes significativos.

Desafíos y proyecciones

Los principales desafíos para el desarrollo del instrumento se encuentran en lograr una estimación más precisa de las dimensiones contextualización y explicación. Sin embargo, también es necesario alcanzar conclusiones más definitivas respecto de la relación de las puntuaciones de pensamiento social con otras variables relevantes, tales como el nivel sociocultural de los estudiantes. Además, se deben analizar muestras que permitan realizar inferencias generalizables a la población escolar.

En el futuro se espera avanzar hacia modelos de medición con mejores índices de ajuste y que permitan explorar vínculos con otras variables exógenas. En especial, se debería analizar la relación entre el pensamiento social y la formación ciudadana de los estudiantes, además de poder diferenciar estos aprendizajes de habilidades mediadoras como la lecto-escritura académica. Adicionalmente, es necesario avanzar en investigaciones que permitan explorar nuevas evidencias de validez del instrumento, tales como sus consecuencias y usos en contextos de aula (American Educational Research Association, American Psychological Association y National Council on Measurement in Education, 2014).

Este estudio abre nuevos caminos y entrega posibles directrices que orientan al desarrollo de procesos evaluativos auténticos que permitan retroalimentar el aprendizaje de las ciencias sociales en el aula. Esto podría permitir impulsar el aprendizaje en un subsector que, aunque privilegiado para formar ciudadanía, ha subutilizado su potencialidad.

nueva página del texto (beta)

nueva página del texto (beta)